Заранее хочу отметить, что тот кто знает как обучается персептрон — в этой статье вряд ли найдет что-то новое. Вы можете смело пропускать ее. Почему я решил это написать — я хотел бы написать цикл статей, связанных с нейронными сетями и применением TensorFlow.js, ввиду этого я не мог опустить общие теоретические выдержки. Поэтому прошу отнестись с большим терпением и пониманием к конечной задумке.

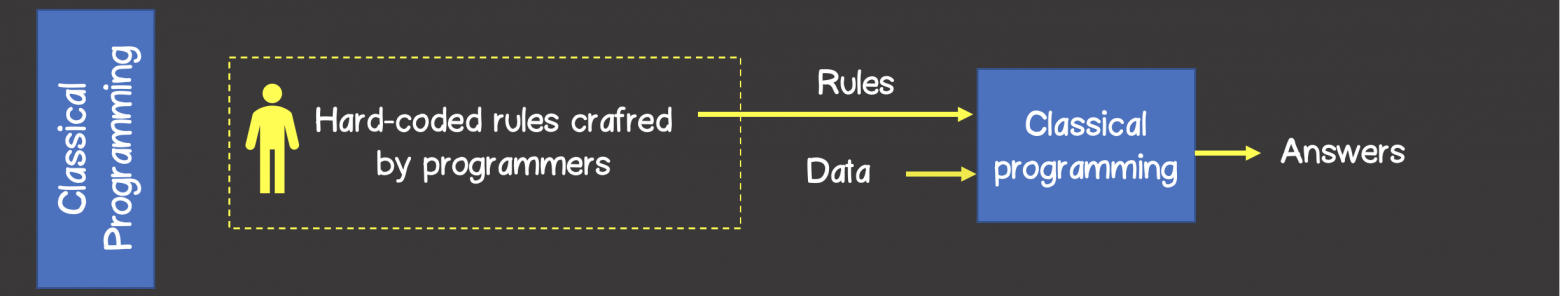

При классическом программировании разработчик описывает на конкретном языке программирования определённый жестко заданный набор правил, который был определен на основании его знаний в конкретной предметной области и который в первом приближении описывает процессы, происходящие в человеческом мозге при решении аналогичной задачи.

Например, может быть запрограммирована стратегия игры в крестики-нолики, шахмат и другое (рисунок 1).

Рисунок 1 – Классический подход решения задач

В то время как алгоритмы машинного обучения могут определять набор правил для решения задач без участия разработчика, а только на базе наличия тренировочного набора данных.

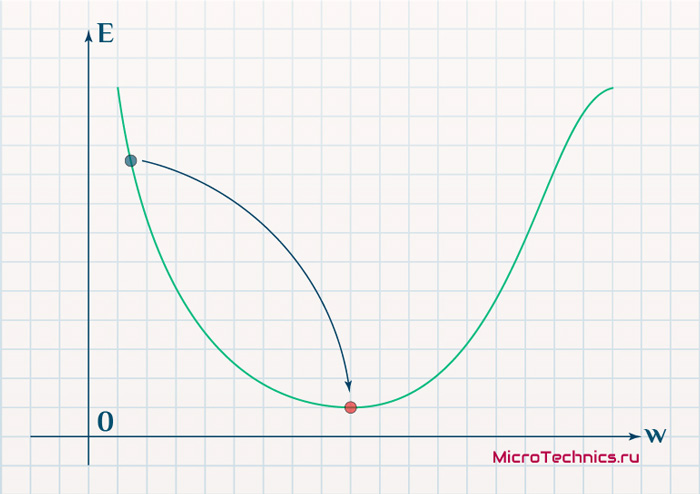

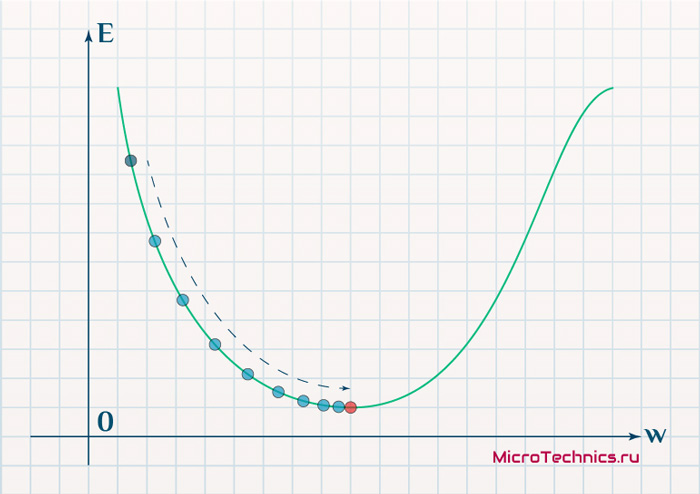

Тренировочный набор — это какой-то набор входных данных ассоциированный с набором ожидаемых результатов (ответами, выходными данными). На каждом шаге обучения, модель за счет изменения внутреннего состояния, будет оптимизировать и уменьшать ошибку между фактическим выходным результатом модели и ожидаемым результатом (рисунок 2).

Рисунок 2 – Машинное обучение

Нейронные сети

Долгое время учёные, вдохновляясь процессами происходящими в нашем мозге, пытались сделать реверс-инжиниринг центральной нервной системы и попробовать сымитировать работу человеческого мозга. Благодаря этому родилось целое направление в машинном обучении — нейронные сети.

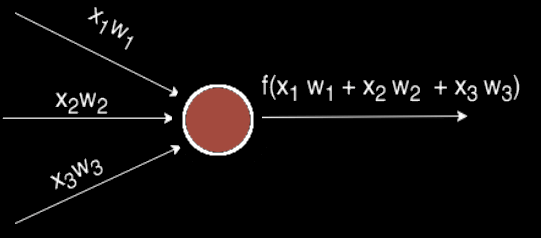

На рисунке 3 вы можете увидеть сходство между устройством биологического нейрона и математическим представлением нейрона, используемого в машинном обучении.

Рисунок 3 – Математическое представление нейрона

В биологическом нейроне, нейрон получает электрические сигналы от дендритов, модулирующих электрические сигналы с разной силой, которые могут возбуждать нейрон при достижении некоторого порогового значения, что в свою очередь приведёт к передаче электрического сигнала другим нейронам через синапсы.

Персептрон

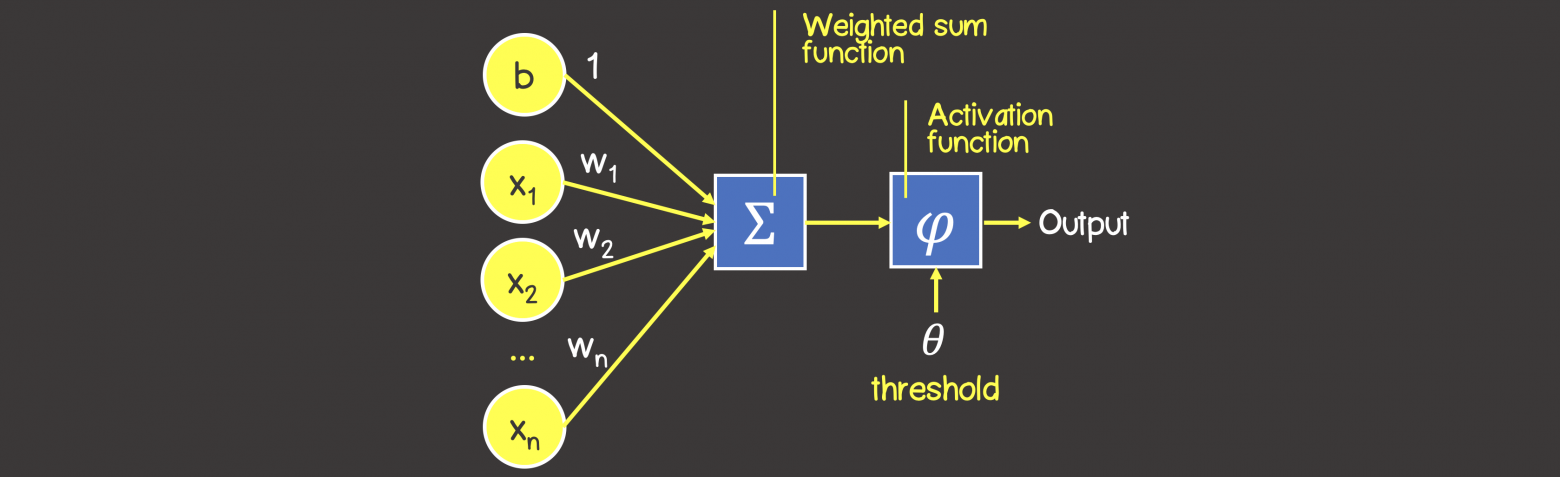

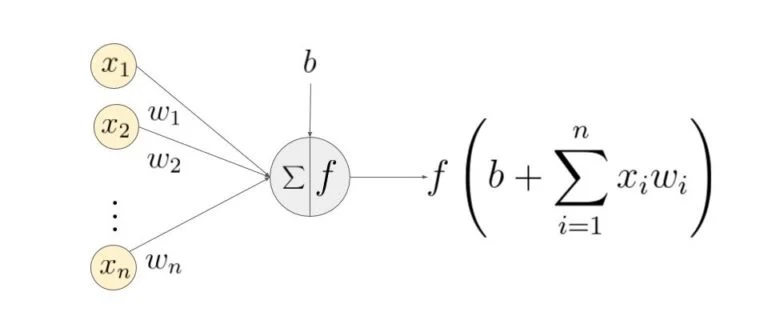

Математическая модель нейронной сети, состоящего из одного нейрона, который выполняет две последовательные операции (рисунок 4):

- вычисляет сумму входных сигналов с учетом их весов (проводимости или сопротивления) связи

- применяет активационную функцию к общей сумме воздействия входных сигналов.

Рисунок 4 – Математическая модель персептрона

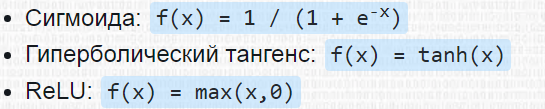

В качестве активационной функции может использоваться любая дифференцируемая функция, наиболее часто используемые приведены в таблице 1. Выбор активационной функции ложиться на плечи инженера, и обычно этот выбор основан или на уже имеющемся опыте решения похожих задач, ну или просто методом подбора.

Заметка

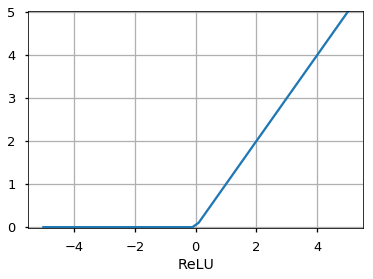

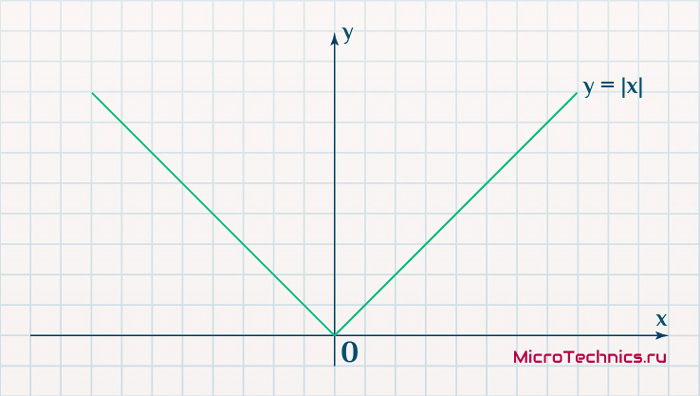

Однако есть рекомендация – что если нужна нелинейность в нейронной сети, то в качестве активационной функции лучше всего подходит ReLU функция, которая имеет лучшие показатели сходимости модели во время процесса обучения.

Таблица 1 — Распространенные активационные функции

Процесс обучения персептрона

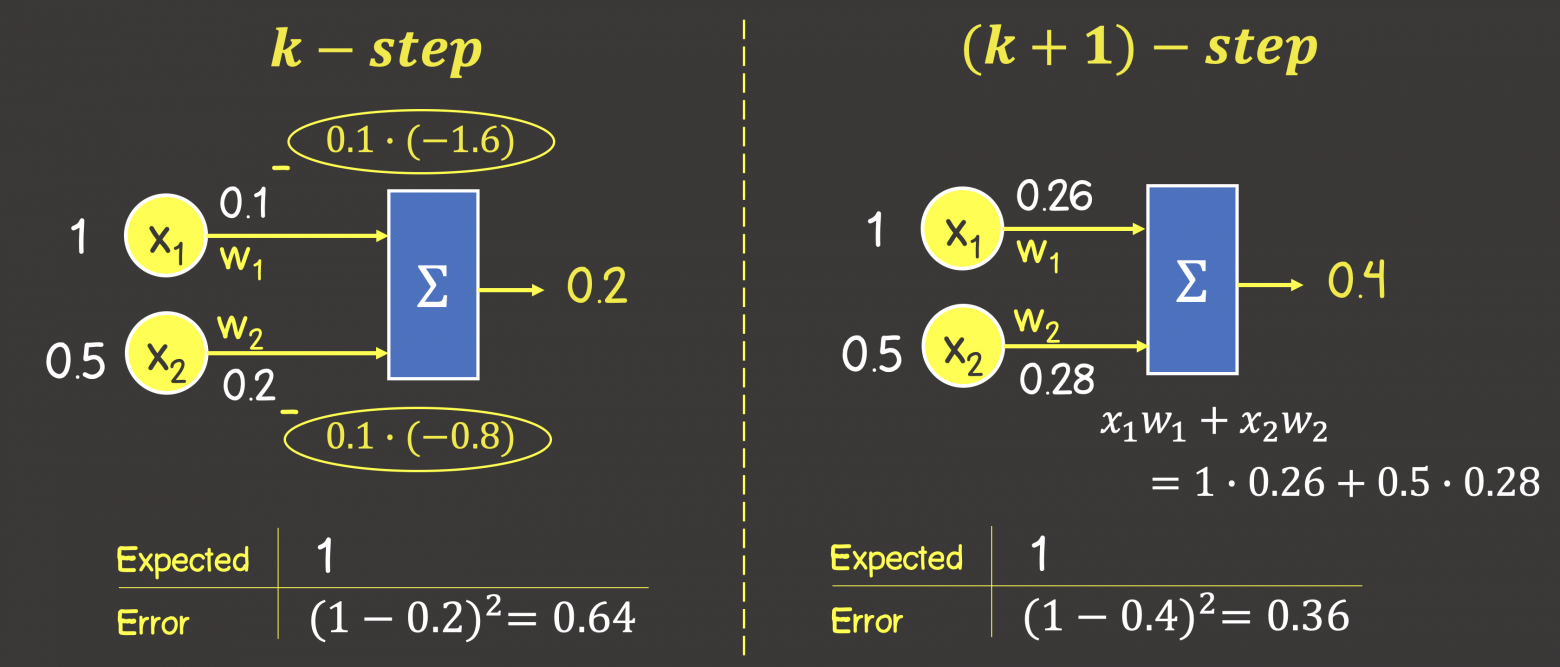

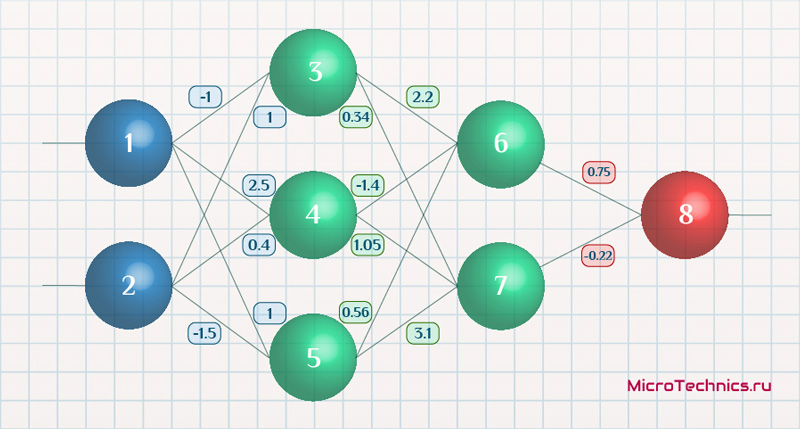

Процесс обучения состоит из несколько шагов. Для большей наглядности, рассмотрим некую вымышленную задачу, которую мы будем решать нейронной сетью, состоящей из одного нейрона с линейной активационной функции (это по сути персептрон без активационной функции вовсе), также для упрощения задачи – исключим в нейроне узел смещения b (рисунок 5).

Рисунок 5 – Обучающий набор данных и состояние нейронной сети на предыдущем шаге обучения

На данном этапе мы имеем нейронную сеть в некотором состоянии с определенными весами соединений, которые были вычислены на предыдущем этапе обучения модели или если это первая итерация обучения – то значения весов соединений выбраны в произвольном порядке.

Итак, представим, что мы имеем некоторый набор тренировочных данных, значения каждого элемента из набора представлены вектором входных данных (input data), содержащих 2 параметра (feature) . Под

в модели в зависимости от рассматриваемой предметной области может подразумеваться все что угодно: количество комнат в доме, расстояние дома от моря, ну или мы просто пытаемся обучить нейронную сеть логической операции И, или ИЛИ.

Каждый вектор входных данных в тренировочном наборе сопоставлен с вектором ожидаемого результата (expected output). В данном случае вектор выходных данных содержит только один параметр, которые опять же в зависимости от выбранной предметной области может означать все что угодно – цена дома, результат выполнения логической операции И или ИЛИ.

ШАГ 1 — Прямое распространение ошибки (feedforward process)

На данном шаге мы вычисляем сумму входных сигналов с учетом веса каждой связи и применяем активационную функцию (в нашем случае активационной функции нет). Сделаем вычисления для первого элемента в обучающем наборе:

Рисунок 6 – Прямое распространение ошибки

Обратите внимание, что написанная формула выше – это упрощенное математическое уравнение для частного случая операций над тензорами.

Тензор – это по сути контейнер данных, который может иметь N осей и произвольное число элементов вдоль каждой из осей. Большинство с тензорами знакомы с математики – векторы (тензор с одной осью), матрицы (тензор с двумя осями – строки, колонки).

Формулу можно написать в следующем виде, где вы увидите знакомые матрицы (тензоры) и их перемножение, а также поймете о каком упрощении шла речь выше:

ШАГ 2 — Расчет функции ошибки

Функция ошибка – это метрика, отражающая расхождение между ожидаемыми и полученными выходными данными. Обычно используют следующие функции ошибки:

— среднеквадратичная ошибка (Mean Squared Error, MSE) – данная функция ошибки особенно чувствительна к выбросам в тренировочном наборе, так как используется квадрат от разности фактического и ожидаемого значений (выброс — значение, которое сильно удалено от других значений в наборе данных, которые могут иногда появляться в следствии ошибок данных, таких как смешивание данных с разными единицами измерения или плохие показания датчиков):

— среднеквадратичное отклонение (Root MSE) – по сути это тоже самое что, среднеквадратичная ошибка в контексте нейронных сетей, но может отражать реальную физическую единицу измерения, например, если в нейронной сети выходным параметров нейронной сети является цена дома выраженной в долларах, то единица измерения среднеквадратичной ошибки будет доллар квадратный (), а для среднеквадратичного отклонения это доллар ($), что естественно немного упрощает задачу анализа человеком:

— среднее отклонение (Mean Absolute Error, MAE) -в отличии от двух выше указанных значений, является не столь чувствительной к выбросам:

— перекрестная энтропия (Cross entropy) – использует для задач классификации:

где

– число экземпляров в тренировочном наборе

– число классов при решении задач классификации

— ожидаемое выходное значение

– фактическое выходное значение обучаемой модели

Для нашего конкретного случая воспользуемся MSE:

ШАГ 3 — Обратное распространение ошибки (backpropagation)

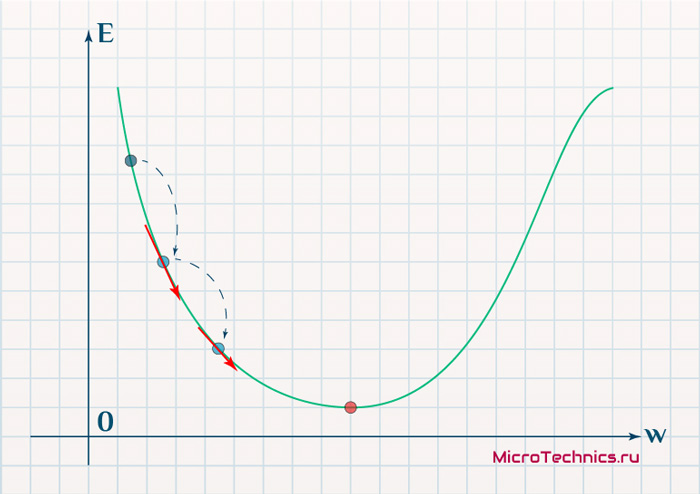

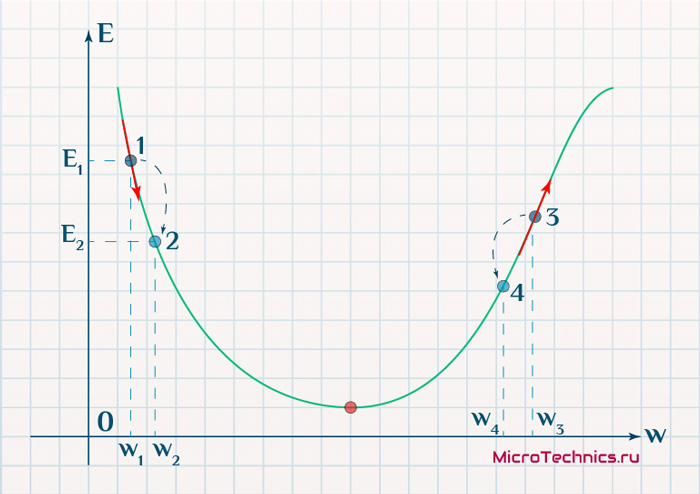

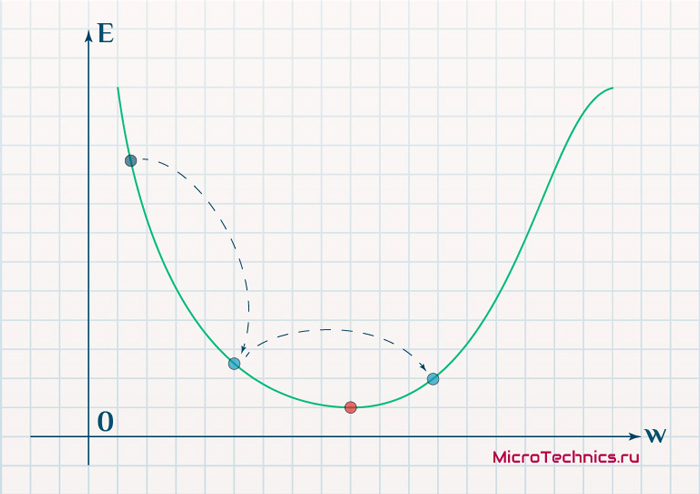

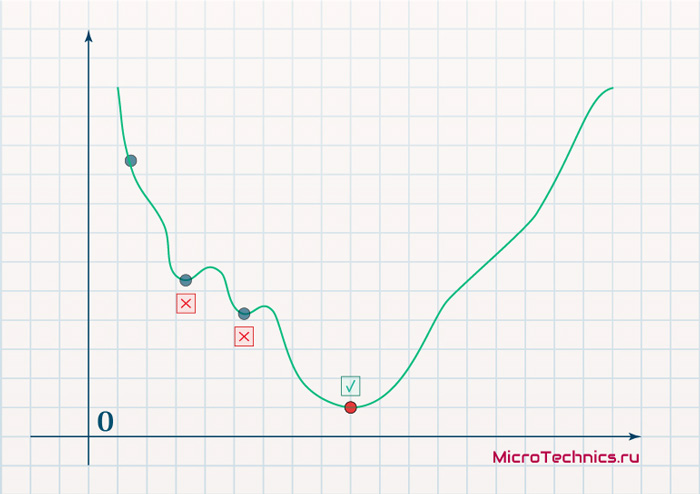

Цель обучения нейронной сети проста – это минимизация функции ошибки:

Одним способом найти минимум функции – это на каждом очередном шаге обучения модифицировать веса соединений в направлении противоположным вектору-градиенту – метод градиентного спуска, и это математически выглядит так:

где – k -ая итерация обучения нейронной сети;

– шаг обучения (learning rate) и задается инженером, обычно это может быть 0.1; 0.01 (о том как шаг обучения влияет на процесс сходимости обучения отметить чуть позже)

– градиент функции-ошибки

Для нахождения градиента, используем частные производные по настраиваемым аргументам :

В нашем конкретном случае с учетом всех упрощений, функция ошибки принимает вид:

Памятка формул производных

Напомним некоторые формулы производных, которые пригодятся для вычисления частных производных

Найдем следующие частные производные:

Тогда процесс обратного распространения ошибки – движение по модели от выхода по направлению к входу с модификацией весов модели в направлении обратном вектору градиента. Задавая обучающий шаг 0.1 (learning rate) имеем (рисунок 7):

Рисунок 7 – Обратное распространение ошибки

Таким образом мы завершили k+1 шаг обучения, чтобы убедиться, что ошибка снизилась, а выход от модели с новыми весами стал ближе к ожидаемому выполним процесс прямого распространения ошибки по модели с новыми весами (см. ШАГ 1):

Как видим, выходное значение увеличилось на 0.2 единица в верном направлении к ожидаемому результату – единице (1). Ошибка тогда составит:

Как видим, на предыдущем шаге обучения ошибка составила 0.64, а с новыми весами – 0.36, следовательно мы настроили модель в верном направлении.

Следующая часть статьи:

Машинное обучение. Нейронные сети (часть 2): Моделирование OR; XOR с помощью TensorFlow.js

Машинное обучение. Нейронные сети (часть 3) — Convolutional Network под микроскопом. Изучение АПИ Tensorflow.js

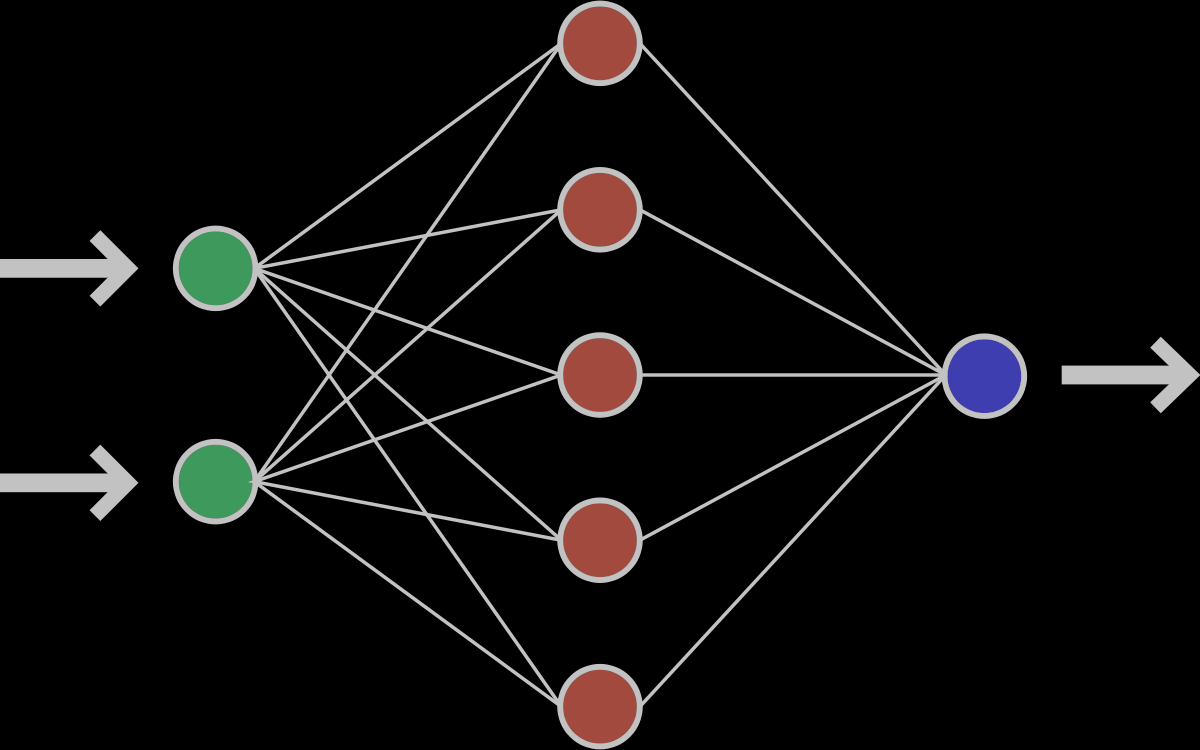

В этой статье мы узнаем о нейронных сетях прямого распространения, также известных как сети с глубокой прямой связью или многослойные персептроны. Они составляют основу многих важных нейронных сетей, используемых в последнее время, таких как сверточные нейронные сетиએ (широко используемые в приложениях компьютерного зрения), рекуррентные нейронные сетиએ (широко используемые для понимания естественного языка и последовательного обучения) и так далее. Мы постараемся понять важные концепции, используя интуитивно понятную игрушку и не будем вдаваясь в математику. Если вы хотите погрузиться в глубокое обучение, но не обладаете достаточным опытом в области статистики и машинного обучения, то эта статья станет идеальной отправной точкой.

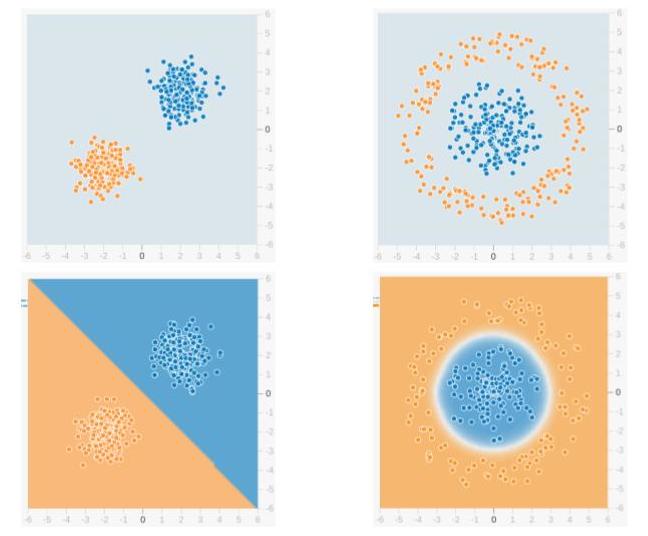

Мы будем использовать сеть прямого распространения для решения задачи двоичной классификации. В машинном обучении классификация — это тип метода контролируемого обучения, в котором задача состоит в том, чтобы разделить образцы данных на заранее определенные группы с помощью функции принятия решений. Когда есть только две группы, это называется двоичной классификацией. На приведенном ниже рисунке показан пример. Точки синего цвета принадлежат одной группе (или классу), а оранжевые точки — другой. Воображаемые линии, разделяющие группы, называются границами принятия решений. Функция принятия решения извлекается из набора помеченных образцов, который называется обучающими данными, а процесс обучения функции принятия решения называется обучением.

В приведенном примере верхняя строка показывает два разных распределения данных, а нижняя строка показывает границу решения. На левом изображении показан пример данных, которые можно разделить линейно. Это означает, что линейная граница (например, прямой линии) достаточно, чтобы разделить данные на группы. С другой стороны, изображение справа показывает пример данных, которые нельзя разделить линейно. Граница решения в этом случае должна быть круговой или многоугольной, как показано на рисунке.

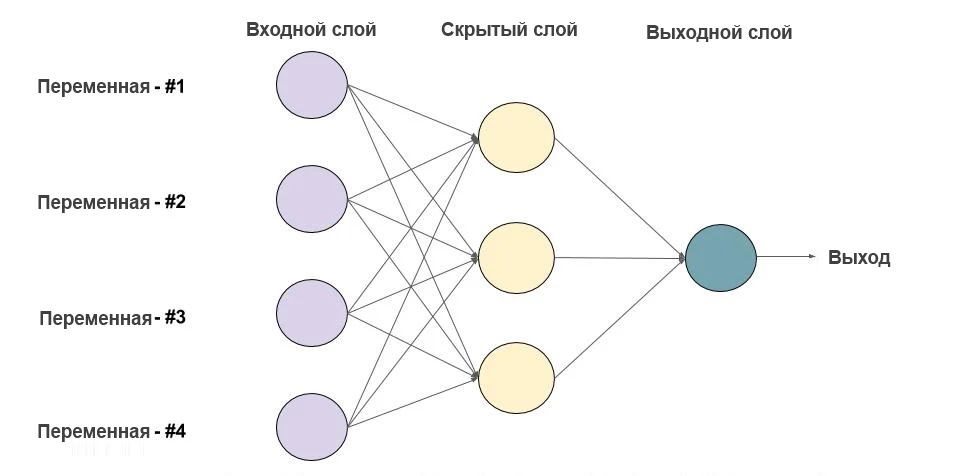

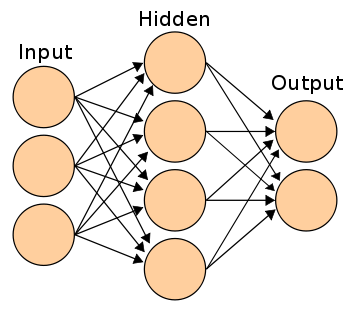

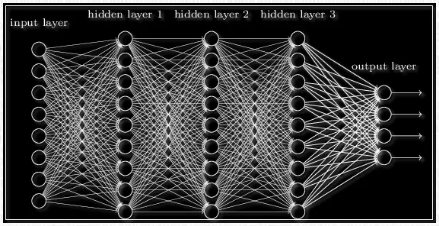

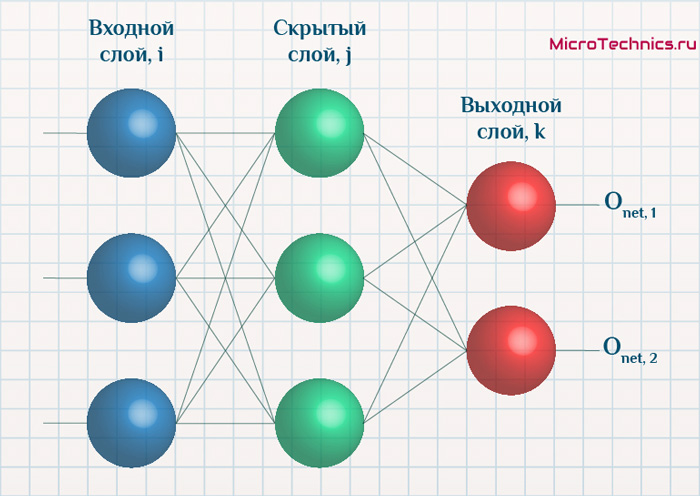

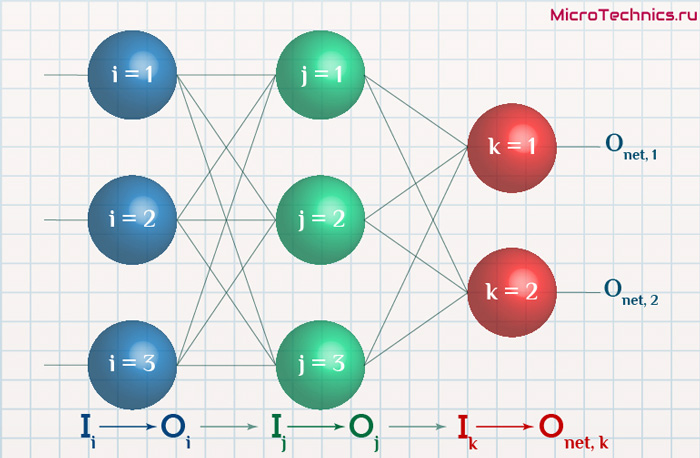

1. Что есть нейронная сеть?

Ниже приведен пример нейронной сети прямого распространения. Это направленный ациклический граф, что означает, что в сети нет обратных связей или петель. У него есть входной слой, выходной слой и скрытый слой. Как правило, может быть несколько скрытых слоев. Каждый узел в слое — нейрон, который можно рассматривать как основной процессор нейронной сети.

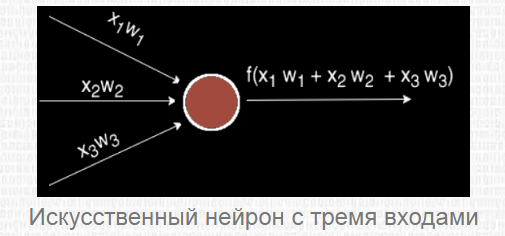

1.1. Что есть нейрон?

Искусственный нейрон — это основная единица нейронной сети. Принципиальная схема нейрона приведена ниже.

Как видно выше, он работает в два этапа: вычисляет взвешенную сумму своих входных данных, а затем применяет функцию активации для нормализации суммы. Функции активации могут быть линейными или нелинейными. Также, есть веса, связанные с каждым входом нейрона. Это параметры, которые сеть должна приобрести на этапе обучения.

1.2. Функции активации

Функция активацииએ используется как орган принятия решений на выходе нейрона. Нейрон изучает линейные или нелинейные границы принятия решений на основе функции активации. Он также оказывает нормализующее влияние на выход нейронов, что предотвращает выход нейронов после нескольких слоев, чтобы стать очень большим, за счет каскадного эффекта. Есть три наиболее часто используемых функции активации.

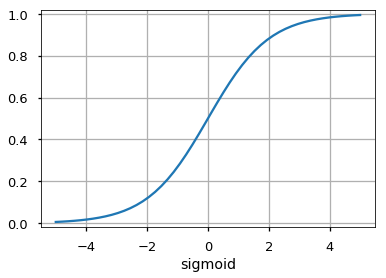

Сигмоидаએ

Он отображает входные данные (ось x) на значения от 0 до 1.

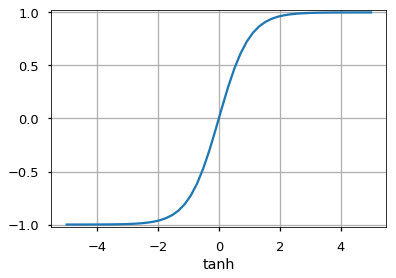

Tanh

Похожа на сигмовидную функцию, но отображает входные данные в значения от -1 до 1.

Rectified Linear Unit (ReLU)

Он позволяет проходить через него только положительным значениям. Отрицательные значения отображаются на ноль.

Функция активацииએ может быть другой, например, функция Unit Step, leaky ReLU, Noisy ReLU, Exponential LU и т.д., которые имеют свои плюсы и минусы.

1.3. Входной слой

Это первый слой нейронной сети. Он используется для передачи и приёма входных данных или функций в сеть.

1.4. Выходной слой

Это слой, который выдает прогнозы. Функция активации, используемая на этом уровне, различается для разных задач. Для задачи двоичной классификации мы хотим, чтобы на выходе было либо 0, либо 1. Таким образом, используется сигмовидная функция активации. Для задачи мультиклассовой классификации используется Softmaxએ (воспринимайте это как обобщение сигмоида на несколько классов). Для задачи регрессии, когда результат не является предопределенной категорией, мы можем просто использовать линейную единицу.

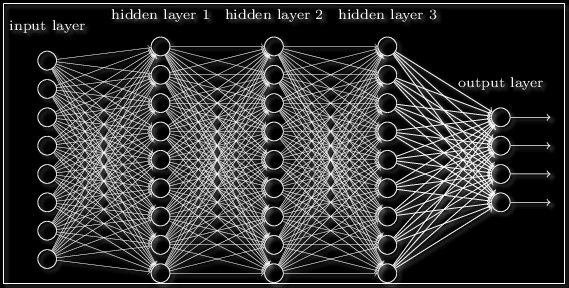

1.5. Скрытый слой

Сеть прямого распространения применяет к входу ряд функций. Имея несколько скрытых слоев, мы можем вычислять сложные функции, каскадируя более простые функции. Предположим, мы хотим вычислить седьмую степень числа, но хотим, чтобы вещи были простыми (поскольку их легко понять и реализовать). Вы можете использовать более простые степени, такие как квадрат и куб, для вычисления функций более высокого порядка. Точно так же вы можете вычислять очень сложные функции с помощью этого каскадного эффекта. Наиболее широко используемый скрытый блок — это тот, где функция активацииએ использует выпрямленный линейный блок (ReLU). Выбор скрытых слоёв — очень активная область исследований в машинном обучении. Тип скрытого слоя отличает разные типы нейронных сетей, такие как CNNએ, RNNએ и т.д. Количество скрытых слоев называется глубиной нейронной сети. Вы можете задать вопрос: сколько слоев в сети делают ее глубокой? На это нет правильного ответа. В общем случае, более глубокие сети могут научиться более сложным функциям.

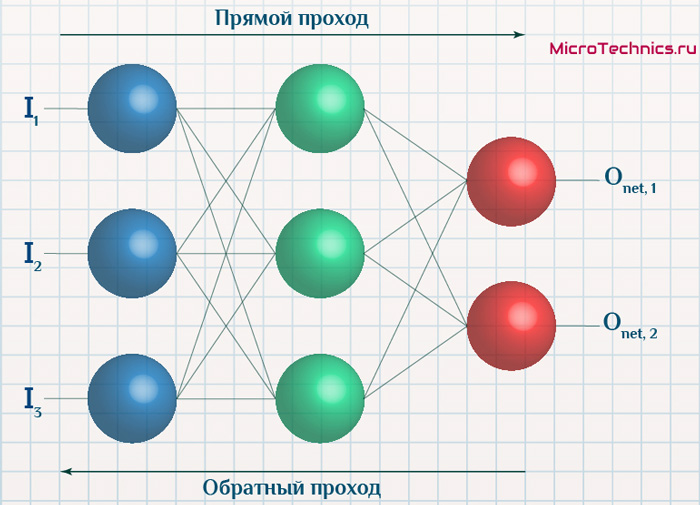

1.6. Как сеть учится?

Обучающие образцы передаются по сети, и выходные данные, полученные от сети, сравниваются с фактическими выходными данными. Эта ошибка используется для изменения веса нейронов таким образом, чтобы ошибка постепенно уменьшалась. Это делается с помощью алгоритма обратного распространения ошибки, также называемого обратным распространением. Итеративная передача пакетов данных по сети и обновление весов для уменьшения ошибки называется стохастический градиентный спускએ (SGD). Величина, на которую изменяются веса, определяется параметром, называемым «Скорость обучения». Подробности SGD и backprop будут описаны в отдельном посте.

2.Зачем использовать скрытые слои?

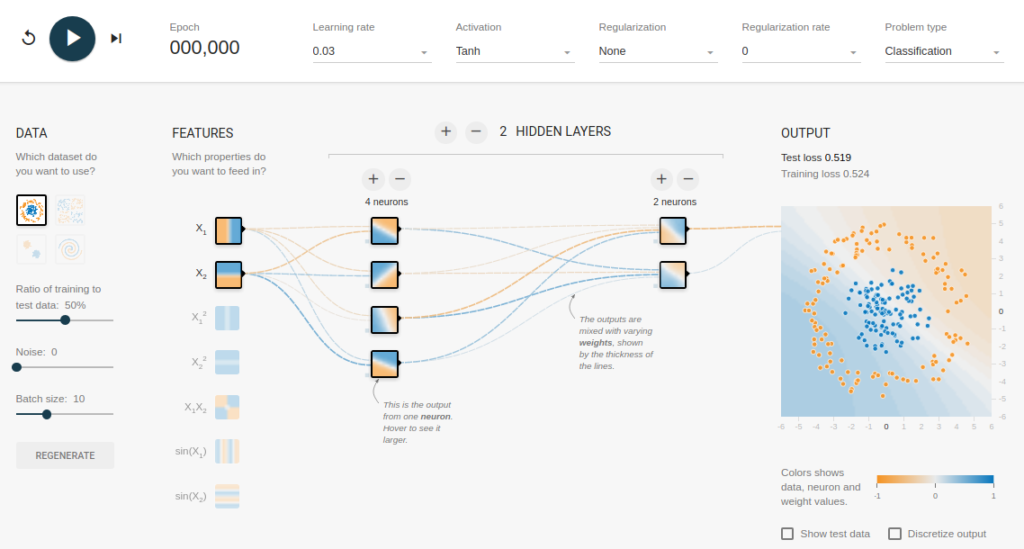

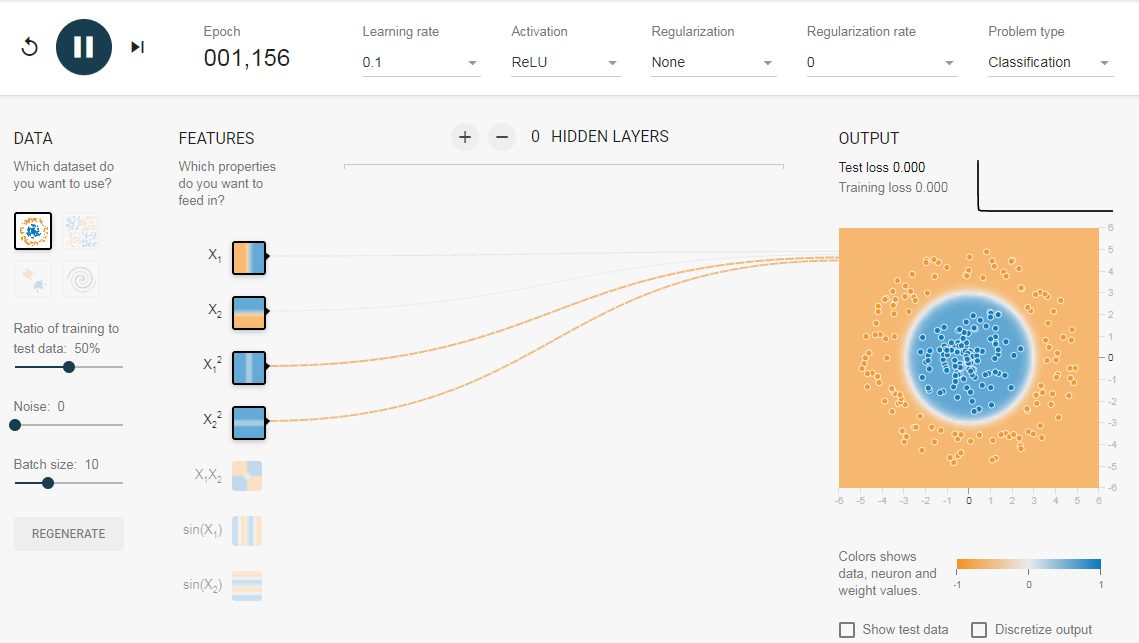

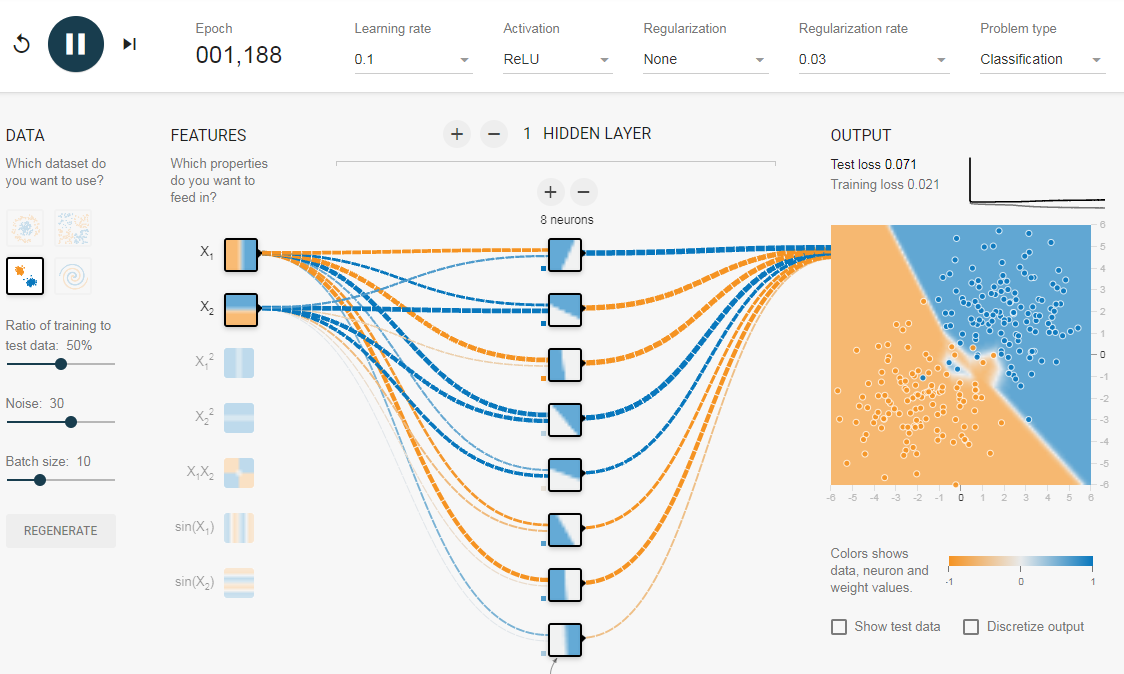

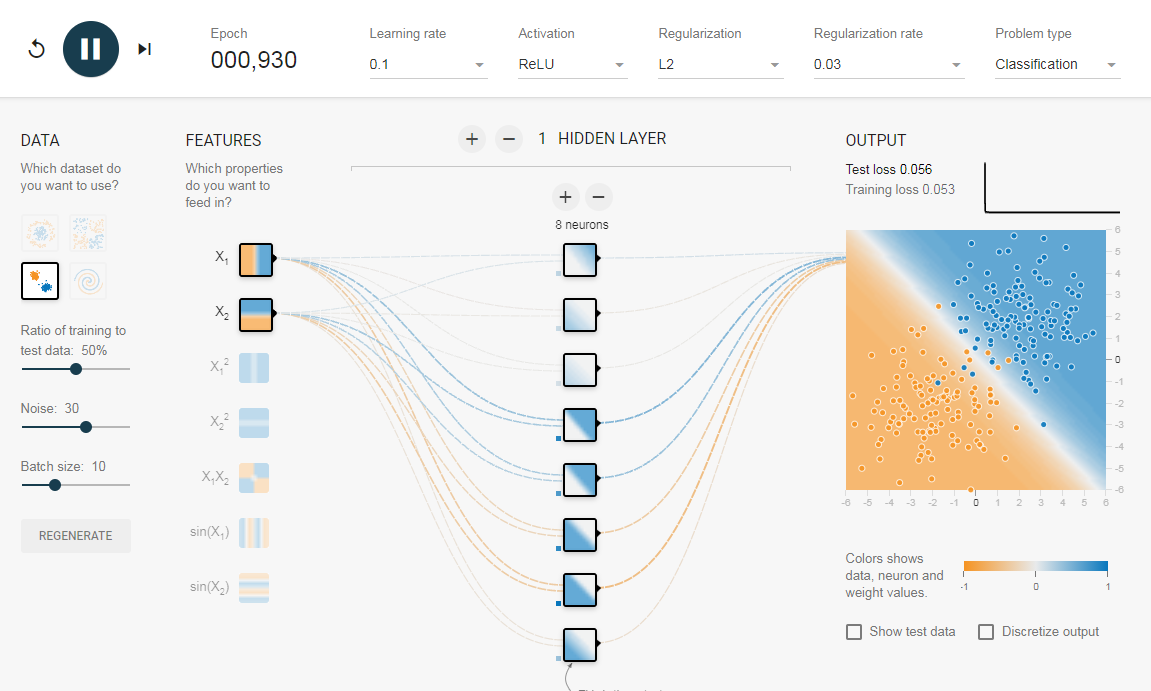

Чтобы понять значение скрытых слоев, мы попытаемся решить проблему двоичной классификации без скрытых слоев. Для этого мы будем использовать интерактивную платформу от Google, plays.tensorflow.org, которая представляет собой веб-приложение, где вы можете создавать простые нейронные сети с прямой связью и видеть эффекты обучения в реальном времени. Вы можете поиграть, изменив количество скрытых слоев, количество нейронов в скрытом слое, тип функции активации, тип данных, скорость обучения, параметры регуляризации и т.д. Выше приведен снимок экрана веб-страницы.

На приведенной выше странице вы можете выбрать данные и нажать кнопку воспроизведения, чтобы начать обучение.

Он покажет вам изученную границу решения и кривые потерь в правом верхнем углу.

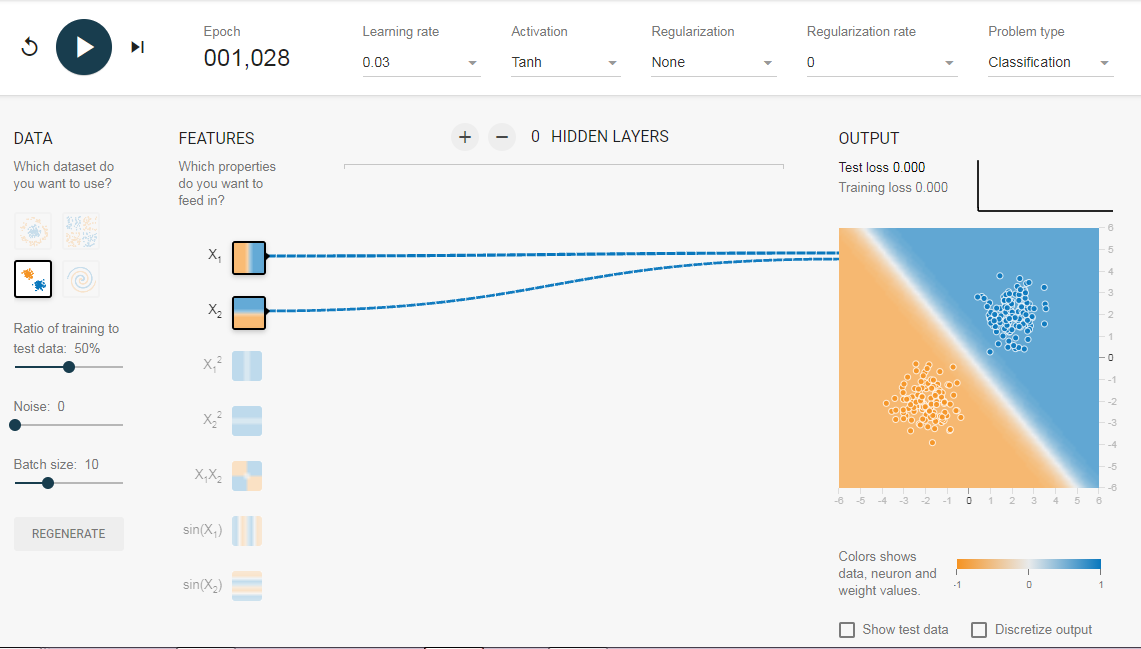

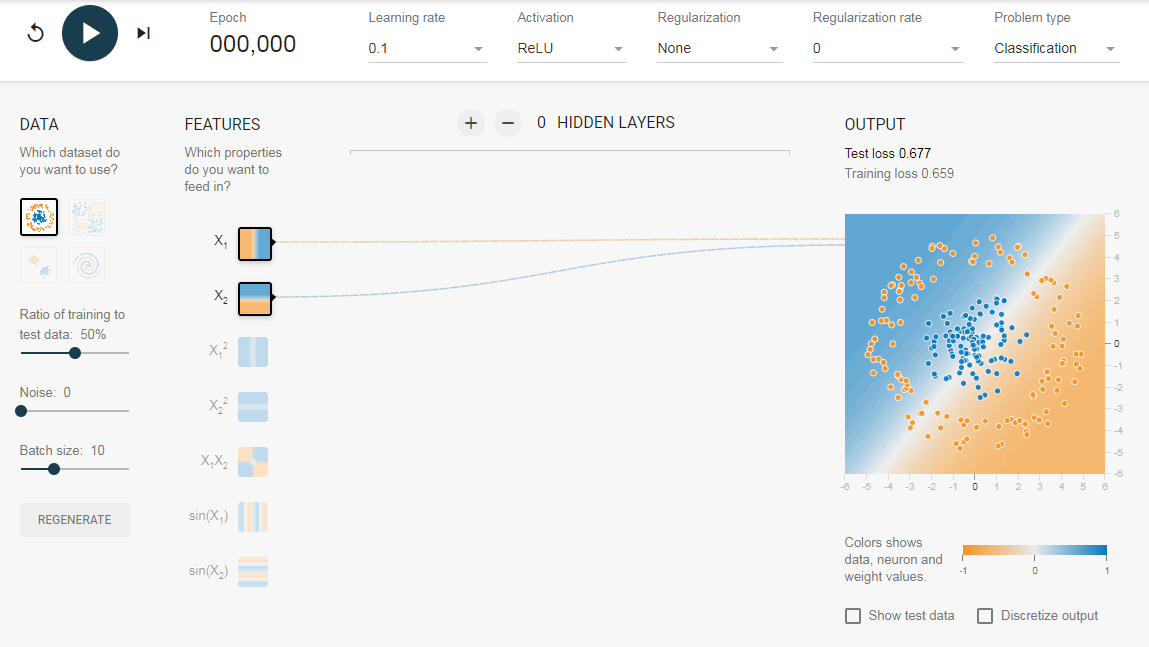

2.1. Без скрытого слоя

Нам нужна сеть без скрытого слоя, который я создал по этой ссылке. Здесь нет скрытых слоев, поэтому он становится простым нейроном, способным изучать линейную границу принятия решения. Мы можем выбрать тип данных в верхнем левом углу. В случае линейно разделяемых данных (3-й тип), он сможет получить (когда вы нажмете кнопку воспроизведения) линейную границу, как показано ниже.

Однако, если вы выберете первые данные, вы не сможете для них узнать границу кругового решения.

Поскольку данные находятся в круговой области, можно сказать, что использование квадратов значений функций в качестве входных данных может помочь. Оказывается, после обучения нейрон сможет найти круговую границу принятия решения.

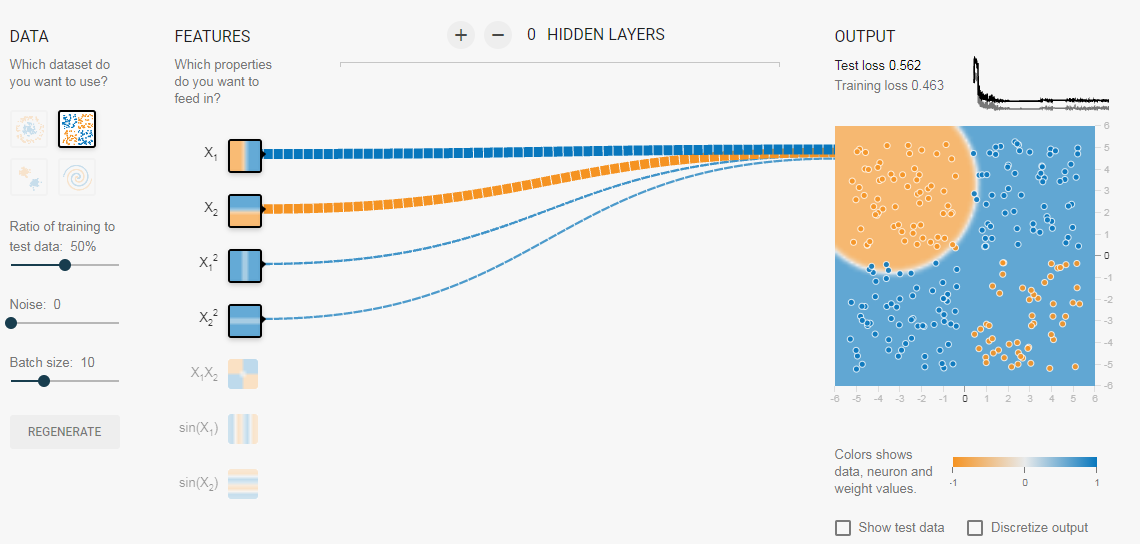

Теперь, если вы выберете 2-е данные, та же конфигурация не сможет узнать соответствующую границу решения.

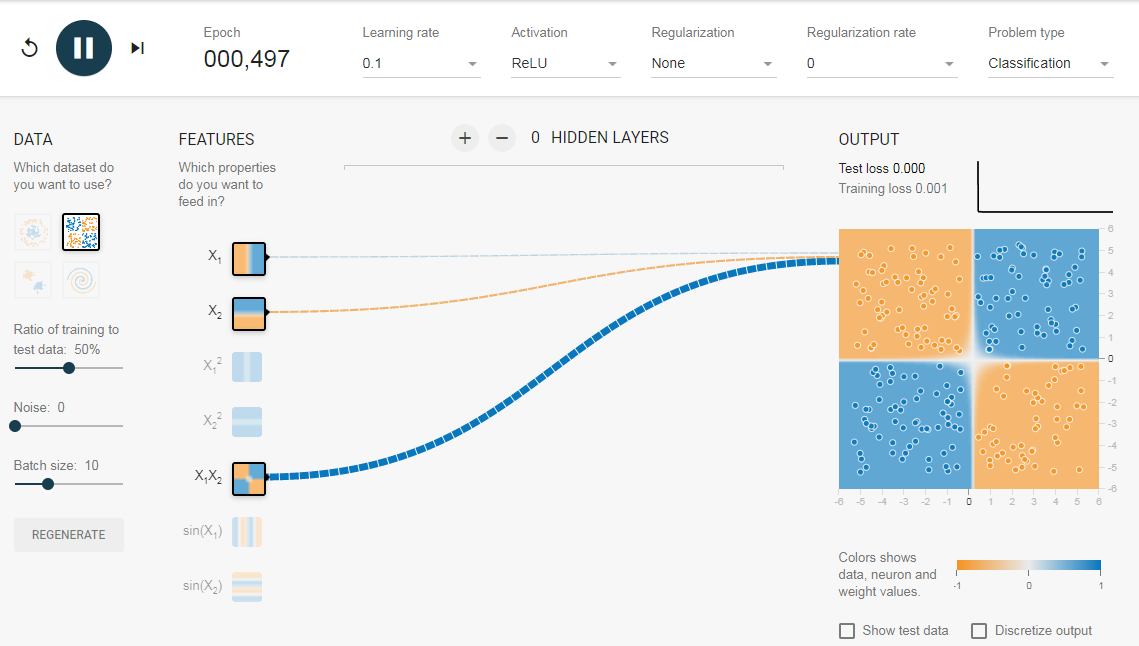

Опять же интуитивно кажется, что граница решения — это коническое сечение (например, парабола или гипербола). Итак, если мы включим продукт функции (например, X_1 X_2), нейрон сможет узнать желаемую границу принятия решения.

Описанные эксперименты показали:

- Используя один нейрон, мы можем узнать только линейную границу решения.

- Нам пришлось придумать преобразования функций (например, квадрат функций или продукт функций) путем визуализации данных. Этот шаг может быть сложным для данных, которые нелегко визуализировать.

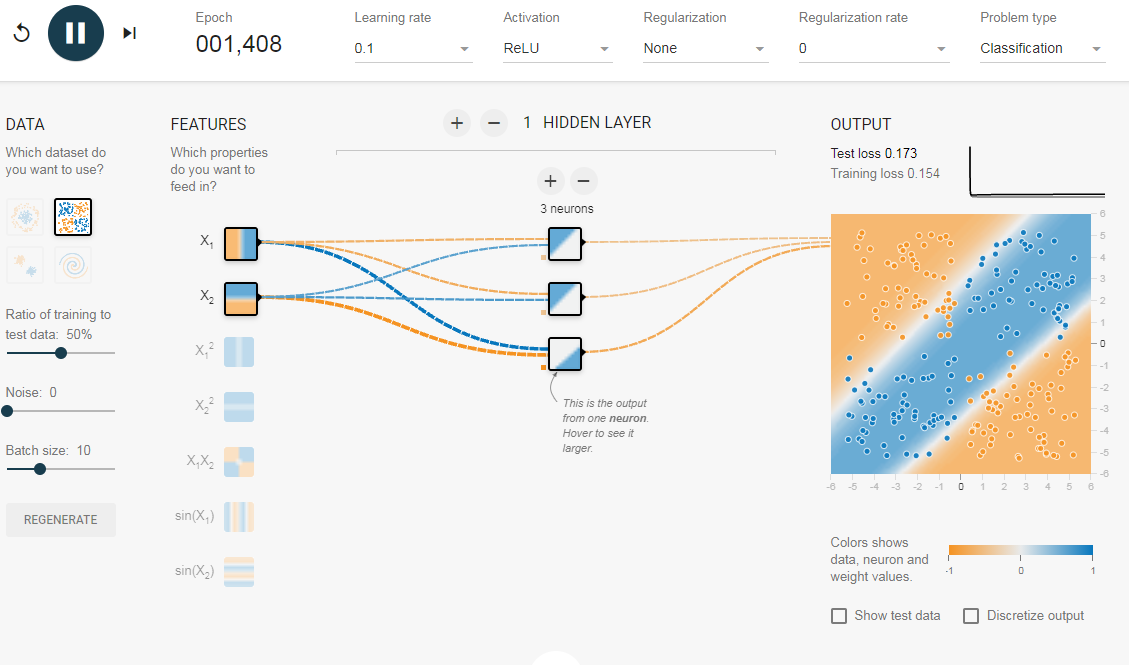

2.2. Добавление скрытого слоя

Добавив скрытый слой, как показано в этой ссылке, мы можем избавиться от этой функции проектирования и получить единую сеть, которая может изучить все три границы принятия решений. Нейронная сеть с одним скрытым слоем с нелинейными функциями активации считается универсальным аппроксиматором функций, теорема Цыбенкоએ (т.е. способной к обучению любой функции). Однако количество единиц в скрытом слое не фиксировано. Результат добавления скрытого слоя всего с 3 нейронами показан ниже:

3. Регуляризация

Как мы видели в предыдущем разделе, многослойная сеть может изучать нелинейные границы принятия решений. Однако, если в данных есть шум (что часто бывает), сеть может попытаться изучить нелинейность, вносимую шумом, пытаясь подогнать зашумленные выборки. В таких случаях зашумленные образцы следует рассматривать как выбросы. В этой ссылке я добавил немного шума к линейно разделяемым данным. Также, чтобы продемонстрировать идею, я увеличил количество скрытых нейронов.

На приведенном выше рисунке можно увидеть, что граница принятия решения очень старается приспособить зашумленные выборки, чтобы уменьшить ошибку. Но, как видите, это ошибочно из-за шумных сэмплов. Другими словами, сеть будет неустойчивой при наличии шума. Это явление называется переобучением. В таких случаях, ошибка обучающих данных может уменьшиться, но сеть плохо работает с невидимыми данными. Это видно по кривым потерь в правом верхнем углу.

Потери в обучении уменьшаются, но потери в тестах увеличиваются. Также, можно видеть, что некоторые веса стали очень большими (очень толстые соединения или вы можете увидеть веса, если наведете курсор на соединения). Это можно исправить, наложив некоторые ограничения на значения весов (например, не позволяя весам становиться очень высокими). Это называется регуляризацией. Мы накладываем ограничения на остальные параметры сети. В некотором смысле мы не полностью доверяем обучающим данным и хотим, чтобы сеть усвоила «хорошие» границы принятия решений. Я добавил регуляризацию L2 в приведенную выше конфигурацию по этой ссылке, и результат показан ниже.

После включения регуляризации L2 граница принятия решения, изученная сетью, становится более гладкой и аналогичной случаю, когда не было шума. Эффект регуляризации также можно увидеть из кривых потерь и значений весов.

В следующем посте, если он случится мы узнаем, как реализовать нейронную сеть прямого распространения в Keras для решения нескольких проблема классификации и узнайте ещё больше о сетях прямого распространения.

Использованы материалы Understanding Feedforward Neural Networks

Нейросети кажутся людям чем-то очень сложным и запутанным, однако это вовсе не так. Простую нейросеть можно написать менее чем за час с нуля. В нашей статье мы создадим нейронную сеть прямого распространения (также называемую многослойным перцептроном), используя лишь массивы, циклы и условные операторы, а значит этот код легко можно будет перенести на любой язык программирования, предоставляющий эти возможности. А если язык предоставляет библиотеку для матричных и векторных вычислений (как, например, numpy в языке Python, то написание займёт ещё меньше времени).

Что такое нейросеть?

Согласно Википедии, искусственная нейронная сеть (ИНС) — математическая модель, а также её программное или аппаратное воплощение, построенная по принципу организации и функционирования биологических нейронных сетей — сетей нервных клеток живого организма.

Более простыми словами, это некий чёрный ящик, который превращает входные данные в выходные, или, говоря более математическим языком, является отображением пространства входных признаков X в пространство выходных признаков Y: X → Y. То есть мы хотим найти какую-то функцию F, которая сможет выполнять это преобразование. Для начала этой информации нам будет достаточно. Для более подробного ознакомления рекомендуем ознакомиться с этой статьёй на хабре.

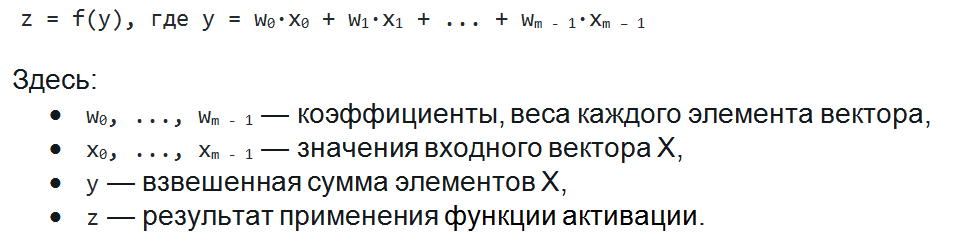

Коротко об искусственном нейроне

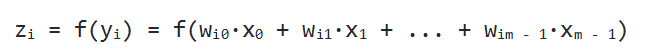

Чаще всего в подобных статьях начинают расписывать про устройство биологического нейрона, связь с его искусственной моделью и прочую лирику. Мы же этого делать не будем, а сразу перейдём к сути. Искусственный нейрон — это всего лишь взвешенная сумма значений входного вектора элементов, которая передаётся на нелинейную функцию активации f: z = f(y), где y = w0·x0 + w1·x1 + ... + wm - 1·xm - 1. Здесь w0, ..., wm - 1 — коэффициенты, веса каждого элемента вектора, x0, ..., xm - 1 — значения входного вектора X, y — взвешенная сумма элементов X, а z — результат применения функции активации. Мы вернёмся к функции активации немного позднее, а пока давайте придумаем, как вместо одного выходного значения получить n.

Искусственный нейрон с тремя входами

Нейронный слой

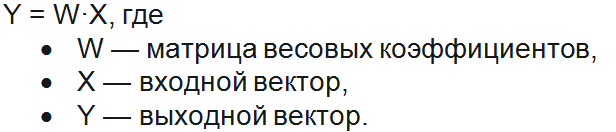

Один нейрон способен входной вектор превратить в одну точку, однако по условию мы хотим получить несколько точек, так как выходной вектор Y может иметь произвольную размерность, определяемую лишь конкретной ситуацией (один выход для XOR, 10 выходов для определения принадлежности к одному из 10 классов и т.д.). Как же нам получить n точек, преобразуя элементы входного вектора X? Оказывается, всё довольно просто: для того, чтобы получить n выходных значений, необходимо использовать не один нейрон, а n. Тогда для каждого из элементов выходного вектора Y будет использовано ровно n различных взвешенных сумм от вектора X. То есть мы получаем, что zi = f(yi) = f(wi0·x0 + wi1·x1 + ... + wim - 1·xm - 1)

Если внимательно посмотреть, то оказывается, что написанная выше формула является определением умножения матрицы на вектор. И действительно, если взять матрицу W размера n на m и умножить её на вектор X размерности m, то получится другой вектор размерности n, то есть ровно то, что нам и нужно. Таким образом, получение выходного вектора по входному для n нейронов можно записать в более удобной матричной форме: Y = W·X, где W — матрица весовых коэффициентов, X — входной вектор и Y — выходной вектор. Однако полученный вектор является неактивированным состоянием (промежуточным, невыходным) всех нейронов, а чтобы получить выходное значение,, необходимо каждое неактивированное значение подать на вход функции активации. Результат её применения и будет выходным значением слоя.

Пример нейронной сети с двумя входами, пятью нейронами в скрытом слое и одним выходом

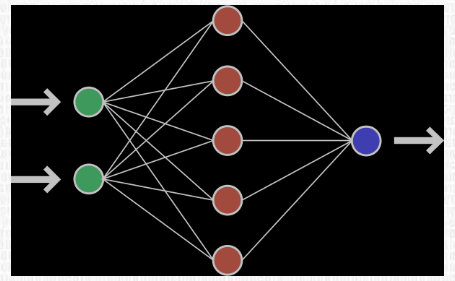

Забегая вперёд скажем о том, что нередко используют последовательность нейронных слоёв для более глубокого обучения сети и большей формализации данных. Поэтому для получения итогового выходного вектора необходимо проделать описанную выше операцию несколько раз подряд от одного слоя к другому. Тогда для первого слоя входным вектором будет X, а для всех последующих входом будет являться выход предыдущего слоя. К примеру, сеть с 3 скрытыми слоями может выглядеть так:

Пример многослойной нейронной сети

Функция активации

Функция активации — это функция, которая добавляет в сеть нелинейность, благодаря чему нейроны могут довольно точно имитировать любую функцию. Наиболее распространёнными функциями активации являются:

- Сигмоида:

f(x) = 1 / (1 + e-x) - Гиперболический тангенс:

f(x) = tanh(x) - ReLU:

f(x) = max(x,0)

У каждой из них есть свои особенности, но об этом лучше почитать в другой статье.

Хватит бла бла, давайте писать код

Теперь нам достаточно знаний, чтобы написать код получения результата нейронной сети. Мы будем писать код на языке C#, однако, уверяем, код будет практически идентичным для других языков программирования. Давайте разберёмся, что нам потребуется для реализации сети прямого распространения:

- Вектор (входные, выходные);

- Матрица (каждый слой содержит матрицу весовых коэффициентов);

- Нейросеть.

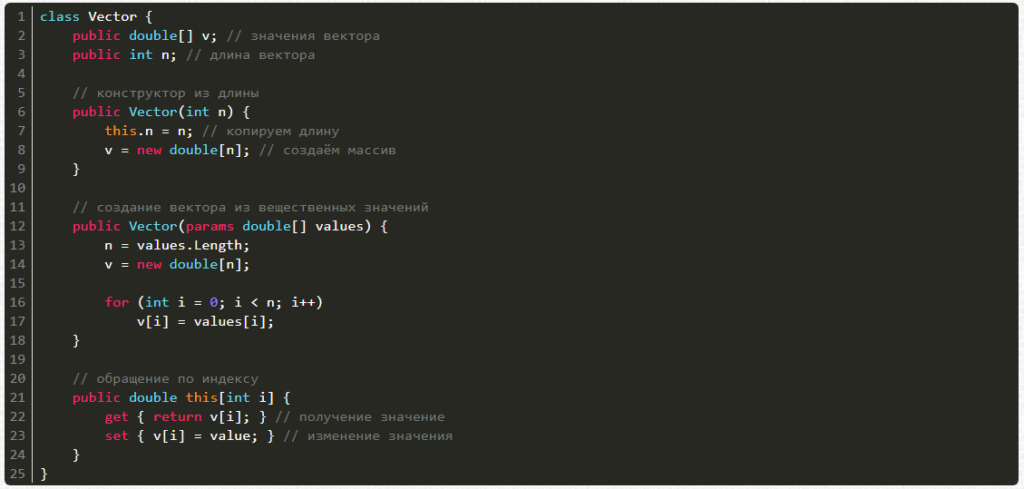

1. Вектор:

- Вектор можно создавать из количества элементов (длины);

- Вектор можно создавать из перечисления вещественных чисел;

- Можно получать значения по индексу i.

- Можно изменять значения по индексу i.

Напишем же это:

class Vector {

public double[] v; // значения вектора

public int n; // длина вектора

// конструктор из длины

public Vector(int n) {

this.n = n; // копируем длину

v = new double[n]; // создаём массив

}

// создание вектора из вещественных значений

public Vector(params double[] values) {

n = values.Length;

v = new double[n];

for (int i = 0; i < n; i++)

v[i] = values[i];

}

// обращение по индексу

public double this[int i] {

get { return v[i]; } // получение значение

set { v[i] = value; } // изменение значения

}

}

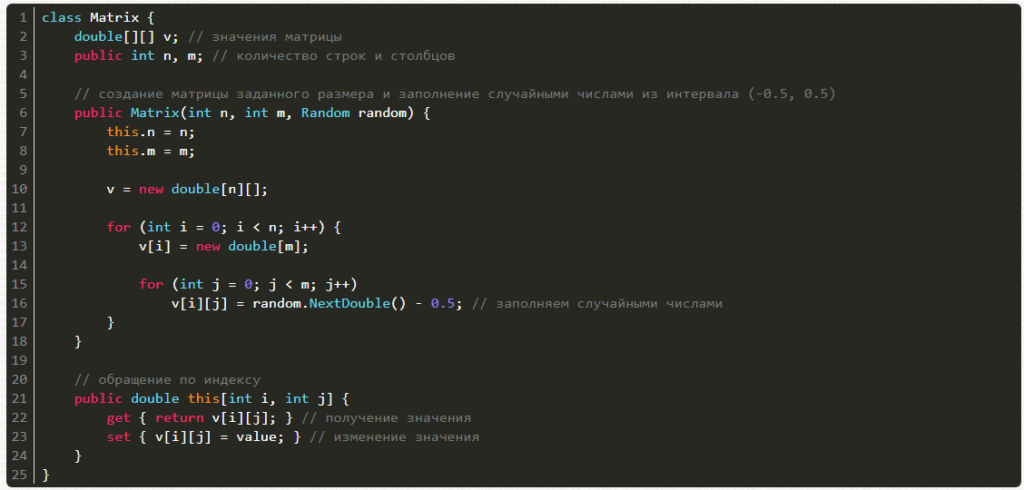

2. Матрица:

- Матрицу можно создавать из числа строк, столбцов и генератора случайных чисел для заполнения случайными значениями;

- Можно получать значения по индексам i и j;

- Можно изменять значения по индексам i и j;

Напишем же это:

class Matrix {

double[][] v; // значения матрицы

public int n, m; // количество строк и столбцов

// создание матрицы заданного размера и заполнение случайными числами из интервала (-0.5, 0.5)

public Matrix(int n, int m, Random random) {

this.n = n;

this.m = m;

v = new double[n][];

for (int i = 0; i < n; i++) {

v[i] = new double[m];

for (int j = 0; j < m; j++)

v[i][j] = random.NextDouble() - 0.5; // заполняем случайными числами

}

}

// обращение по индексу

public double this[int i, int j] {

get { return v[i][j]; } // получение значения

set { v[i][j] = value; } // изменение значения

}

}

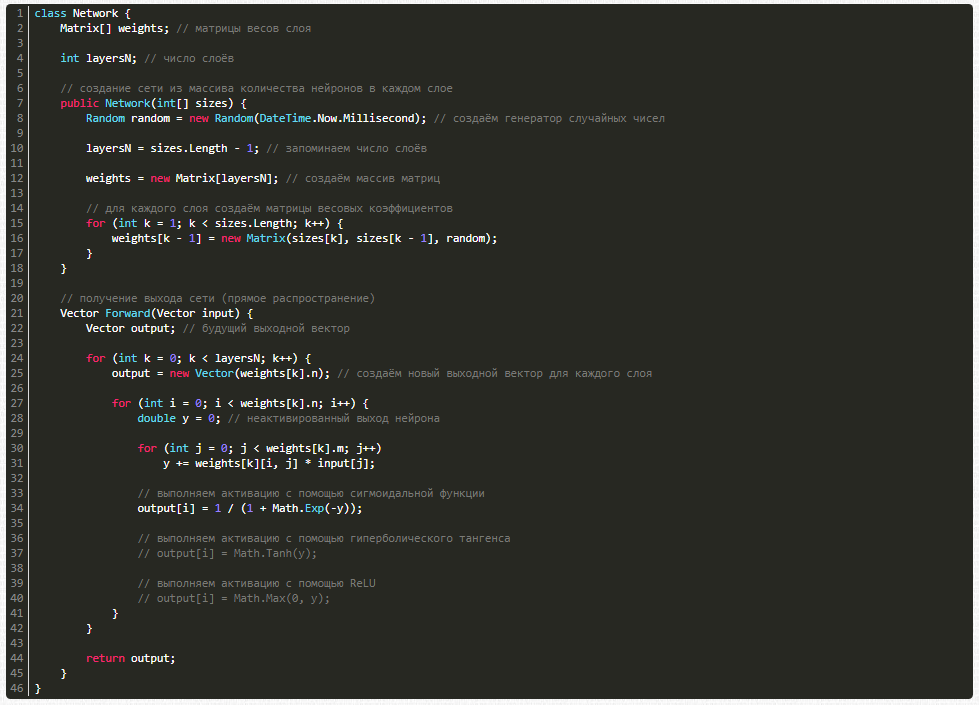

3. Сама нейросеть:

class Network {

Matrix[] weights; // матрицы весов слоя

int layersN; // число слоёв

// создание сети из массива количества нейронов в каждом слое

public Network(int[] sizes) {

Random random = new Random(DateTime.Now.Millisecond); // создаём генератор случайных чисел

layersN = sizes.Length - 1; // запоминаем число слоёв

weights = new Matrix[layersN]; // создаём массив матриц

// для каждого слоя создаём матрицы весовых коэффициентов

for (int k = 1; k < sizes.Length; k++) {

weights[k - 1] = new Matrix(sizes[k], sizes[k - 1], random);

}

}

// получение выхода сети (прямое распространение)

Vector Forward(Vector input) {

Vector output; // будущий выходной вектор

for (int k = 0; k < layersN; k++) {

output = new Vector(weights[k].n); // создаём новый выходной вектор для каждого слоя

for (int i = 0; i < weights[k].n; i++) {

double y = 0; // неактивированный выход нейрона

for (int j = 0; j < weights[k].m; j++)

y += weights[k][i, j] * input[j];

// выполняем активацию с помощью сигмоидальной функции

output[i] = 1 / (1 + Math.Exp(-y));

// выполняем активацию с помощью гиперболического тангенса

// output[i] = Math.Tanh(y);

// выполняем активацию с помощью ReLU

// output[i] = Math.Max(0, y);

}

}

return output;

}

}

Сеть есть, но её ответы случайны. Как обучать?

На данный момент мы имеем случайную (необученную) нейронную сеть, которая может по входному вектору input выдать случайный ответ, однако нам требуется ответы, удовлетворяющие конкретной задаче. Чтобы добиться этого нашу сеть необходимо обучить. Для этого нам необходима база тренировочных примеров, то есть множество пар векторов X — Y, на которых будет обучаться сеть. Обучать нейросеть мы будем с помощью алгоритма обратного распространения ошибки. Если кратко, то он работает следующим образом:

- Подать на вход сети обучающий пример (один входной вектор)

- Распространить сигнал по сети вперёд (получить выход сети)

- Вычислить ошибку (разница получившегося и ожидаемого векторов)

- Распространить ошибку на предыдущие слои

- Обновить весовые коэффициенты для уменьшения ошибки

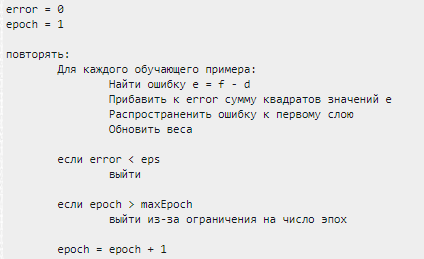

Сам же алгоритм обучения выглядит так:

error = 0 epoch = 1 повторять: Для каждого обучающего примера: Найти ошибку e = f - d Прибавить к error сумму квадратов значений e Распространенить ошибку к первому слою Обновить веса если error < eps выйти если epoch > maxEpoch выйти из-за ограничения на число эпох epoch = epoch + 1

Обучаем нейронную сеть

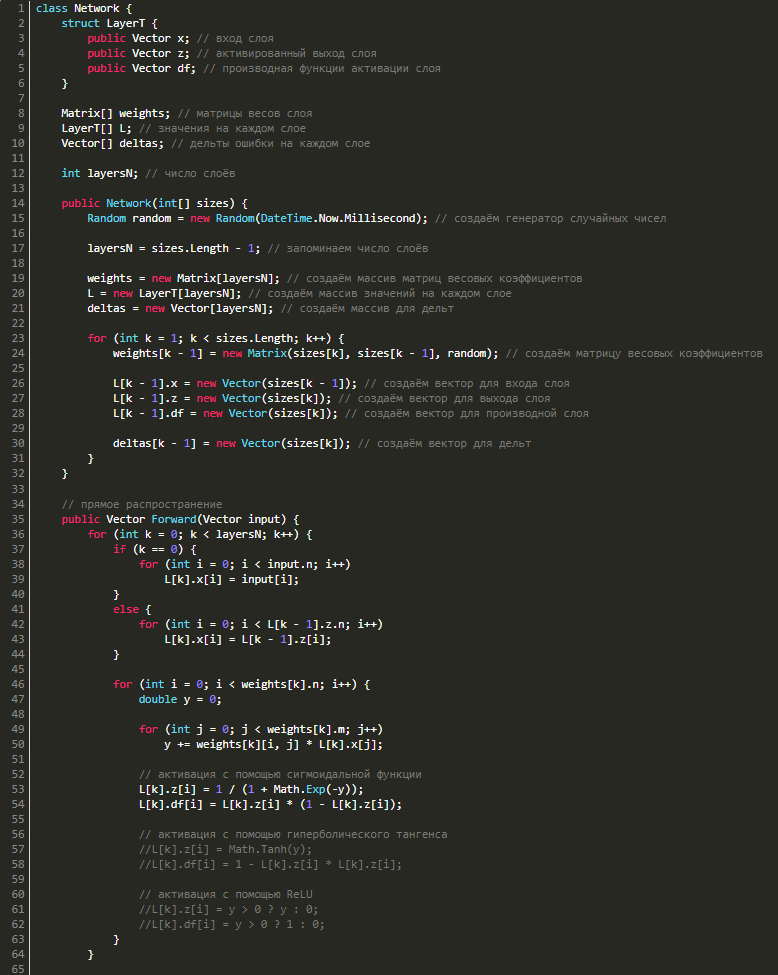

Для обратного распространения ошибки нам потребуется знать значения входов, выходов и значения производных функции активации сети на каждом из слоёв, поэтому создадим структуру LayerT, в которой будет 3 вектора: x — вход слоя, z — выход слоя, df — производная функции активации. Также для каждого слоя потребуются векторы дельт, поэтому добавим в наш класс ещё и их. С учётом вышесказанного наш класс станет выглядеть так:

class Network {

struct LayerT {

public Vector x; // вход слоя

public Vector z; // активированный выход слоя

public Vector df; // производная функции активации слоя

}

Matrix[] weights; // матрицы весов слоя

LayerT[] L; // значения на каждом слое

Vector[] deltas; // дельты ошибки на каждом слое

int layersN; // число слоёв

public Network(int[] sizes) {

Random random = new Random(DateTime.Now.Millisecond); // создаём генератор случайных чисел

layersN = sizes.Length - 1; // запоминаем число слоёв

weights = new Matrix[layersN]; // создаём массив матриц весовых коэффициентов

L = new LayerT[layersN]; // создаём массив значений на каждом слое

deltas = new Vector[layersN]; // создаём массив для дельт

for (int k = 1; k < sizes.Length; k++) {

weights[k - 1] = new Matrix(sizes[k], sizes[k - 1], random); // создаём матрицу весовых коэффициентов

L[k - 1].x = new Vector(sizes[k - 1]); // создаём вектор для входа слоя

L[k - 1].z = new Vector(sizes[k]); // создаём вектор для выхода слоя

L[k - 1].df = new Vector(sizes[k]); // создаём вектор для производной слоя

deltas[k - 1] = new Vector(sizes[k]); // создаём вектор для дельт

}

}

// прямое распространение

public Vector Forward(Vector input) {

for (int k = 0; k < layersN; k++) {

if (k == 0) {

for (int i = 0; i < input.n; i++)

L[k].x[i] = input[i];

}

else {

for (int i = 0; i < L[k - 1].z.n; i++)

L[k].x[i] = L[k - 1].z[i];

}

for (int i = 0; i < weights[k].n; i++) {

double y = 0;

for (int j = 0; j < weights[k].m; j++)

y += weights[k][i, j] * L[k].x[j];

// активация с помощью сигмоидальной функции

L[k].z[i] = 1 / (1 + Math.Exp(-y));

L[k].df[i] = L[k].z[i] * (1 - L[k].z[i]);

// активация с помощью гиперболического тангенса

//L[k].z[i] = Math.Tanh(y);

//L[k].df[i] = 1 - L[k].z[i] * L[k].z[i];

// активация с помощью ReLU

//L[k].z[i] = y > 0 ? y : 0;

//L[k].df[i] = y > 0 ? 1 : 0;

}

}

return L[layersN - 1].z; // возвращаем результат

}

}

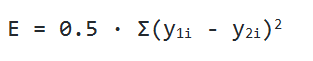

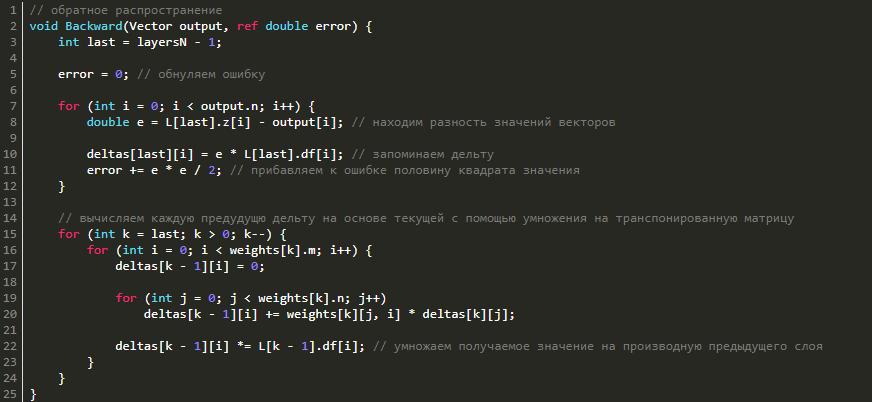

Обратное распространение ошибки

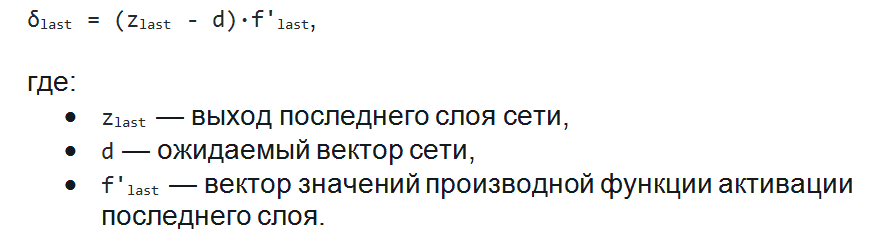

Перейдём к обратному распространению ошибки. В качестве функции оценки сети E(W) возьмём среднее квадратичное отклонение: E = 0.5 · Σ(y1i - y2i)2. Чтобы найти значение ошибки E, нам нужно найти сумму квадратов разности значений вектора, который выдала сеть в качестве ответа, и вектора, который мы ожидаем увидеть при обучении. Также нам потребуется найти дельту для каждого слоя, причём для последнего слоя она будет равна вектору разности полученного и ожидаемого векторов, умноженному (покомпонентно) на вектор значений производных последнего слоя: δlast = (zlast - d)·f'last, где zlast — выход последнего слоя сети, d — ожидаемый вектор сети, f'last — вектор значений производной функции активации последнего слоя.

Теперь, зная дельту последнего слоя, мы можем найти дельты всех предыдущих слоёв. Для этого нужно умножить транспонированную матрицы текущего слоя на дельту текущего слоя и затем умножить полученный вектор на вектор производных функции активации предыдущего слоя: δk-1 = WTk·δk·f'k.

Что ж, давайте реализуем это в коде:

// обратное распространение

void Backward(Vector output, ref double error) {

int last = layersN - 1;

error = 0; // обнуляем ошибку

for (int i = 0; i < output.n; i++) {

double e = L[last].z[i] - output[i]; // находим разность значений векторов

deltas[last][i] = e * L[last].df[i]; // запоминаем дельту

error += e * e / 2; // прибавляем к ошибке половину квадрата значения

}

// вычисляем каждую предудущю дельту на основе текущей с помощью умножения на транспонированную матрицу

for (int k = last; k > 0; k--) {

for (int i = 0; i < weights[k].m; i++) {

deltas[k - 1][i] = 0;

for (int j = 0; j < weights[k].n; j++)

deltas[k - 1][i] += weights[k][j, i] * deltas[k][j];

deltas[k - 1][i] *= L[k - 1].df[i]; // умножаем получаемое значение на производную предыдущего слоя

}

}

}

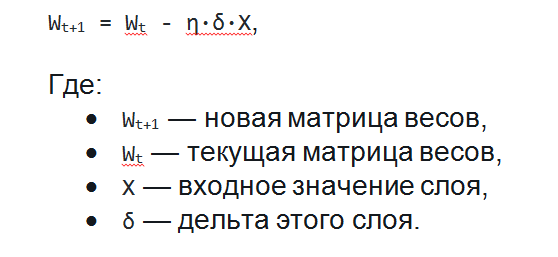

Изменение весов

Для того, чтобы уменьшить ошибку сети нужно изменить весовые коэффициенты каждого слоя. Как же именно нужно менять весовые коэффициенты матриц на каждом слое? Оказывается, всё довольно просто. Для этого используется метод градиентного спуска, а значит нам необходимо вычислить градиент по весам и сделать шаг в отрицательную сторону от этого градиента. На этапе прямого распространения мы зачем-то запоминали входные сигналы, а при обратном распространении ошибки мы вычисляли дельты в каждом слое. Именно их мы и будем сейчас использовать для нахождения градиента! Градиент по весам равен перемножению входного вектора и вектора дельт (не покомпонентно). Поэтому, чтобы обновить весовые коэффициенты и уменьшить тем самым ошибку сети нужно всего лишь вычесть из матрицы весов результат перемножения дельт и входных векторов, умноженный на скорость обучения. Это можно записать в таком виде: Wt+1 = Wt - η·δ·X, где Wt+1 — новая матрица весов, Wt — текущая матрица весов, X — входное значение слоя, δ — дельта этого слоя. Почему именно так с математической точки зрения хорошо описано в этой статье.

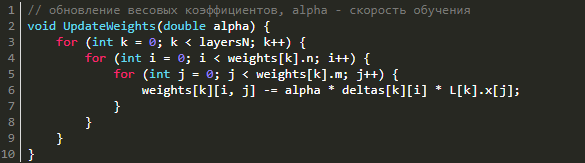

// обновление весовых коэффициентов, alpha - скорость обучения

void UpdateWeights(double alpha) {

for (int k = 0; k < layersN; k++) {

for (int i = 0; i < weights[k].n; i++) {

for (int j = 0; j < weights[k].m; j++) {

weights[k][i, j] -= alpha * deltas[k][i] * L[k].x[j];

}

}

}

}

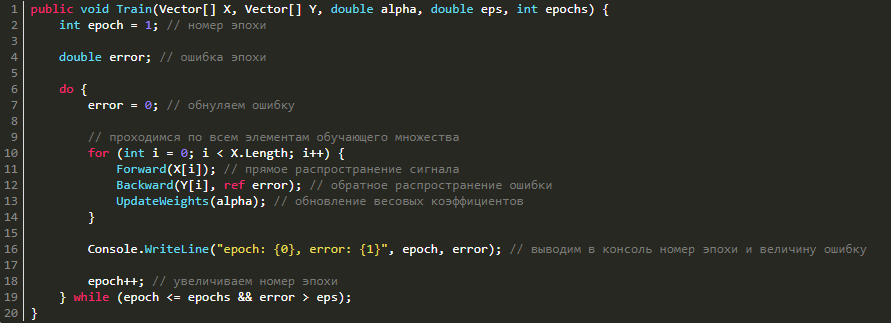

Обучение сети

Теперь, имея методы прямого распространения сигнала, обратного распространения ошибки и изменения весовых коэффициентов, нам остаётся лишь соединить всё вместе в один метод обучения.

public void Train(Vector[] X, Vector[] Y, double alpha, double eps, int epochs) {

int epoch = 1; // номер эпохи

double error; // ошибка эпохи

do {

error = 0; // обнуляем ошибку

// проходимся по всем элементам обучающего множества

for (int i = 0; i < X.Length; i++) {

Forward(X[i]); // прямое распространение сигнала

Backward(Y[i], ref error); // обратное распространение ошибки

UpdateWeights(alpha); // обновление весовых коэффициентов

}

Console.WriteLine("epoch: {0}, error: {1}", epoch, error); // выводим в консоль номер эпохи и величину ошибку

epoch++; // увеличиваем номер эпохи

} while (epoch <= epochs && error > eps);

}

Сеть готова. Давайте же её чему-нибудь научим!

Тренируем нейросеть на функции XOR

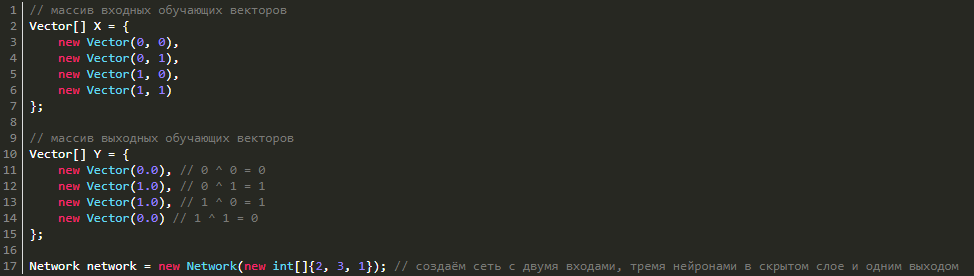

Почему функция XOR так интересна? Просто потому, что её невозможно получить одним нейроном: 0 ^ 0 = 0, 0 ^ 1 = 1, 1 ^ 0 = 1, 1 ^ 1 = 0. Однако она легко получается увеличением числа нейронов. Мы же попробуем выполнить обучение сети с 3 нейронами в скрытом слое и 1 выходным (так как выход у нас всего один). Для этого нам необходимо создать массив векторов X и Y с обучающими данными и саму нейросеть:

// массив входных обучающих векторов

Vector[] X = {

new Vector(0, 0),

new Vector(0, 1),

new Vector(1, 0),

new Vector(1, 1)

};

// массив выходных обучающих векторов

Vector[] Y = {

new Vector(0.0), // 0 ^ 0 = 0

new Vector(1.0), // 0 ^ 1 = 1

new Vector(1.0), // 1 ^ 0 = 1

new Vector(0.0) // 1 ^ 1 = 0

};

Network network = new Network(new int[]{2, 3, 1}); // создаём сеть с двумя входами, тремя нейронами в скрытом слое и одним выходом

После чего запустим обучение со следующими параметрами: скорость обучения — 0.5, число эпох — 100000, величина ошибки — 1e-7:

network.Train(X, Y, 0.5, 1e-7, 100000); // запускаем обучение сети

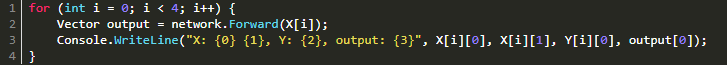

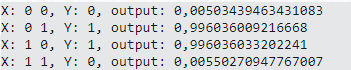

После обучения посмотрим на результаты выполнив прямой проход для всех элементов:

for (int i = 0; i < 4; i++) {

Vector output = network.Forward(X[i]);

Console.WriteLine("X: {0} {1}, Y: {2}, output: {3}", X[i][0], X[i][1], Y[i][0], output[0]);

}

В результате вывод может быть таким:

X: 0 0, Y: 0, output: 0,00503439463431083 X: 0 1, Y: 1, output: 0,996036009216668 X: 1 0, Y: 1, output: 0,996036033202241 X: 1 1, Y: 0, output: 0,00550270947767007

Проверять результаты на тренировочной же выборке довольно скучно, ведь как никак на ней мы сеть обучали, но, увы, для XOR проблемы ничего другого не остаётся. В качестве более серьёзного примера рекомендуем выполнить задачу распознавания картинок с рукописными цифрами MNIST. Это база содержит 60000 картинок написанных от руки цифр размером 28 на 28 пикселей и используется как один из основных датасетов для начала изучения машинного обучения. Не смотря на простоту нашей сети, при грамотном выборе параметров (число нейронов, число слоёв, скорость обучения, число эпох…) можно получить точность распознавания до 98%! Проверить свою сеть вы можете, поучаствовав в соревновании на сайте Kaggle. Нашей команде удалось достичь точности в 98.171%! А вы сможете больше?

В заключение

Мы написали с вами нейронную сеть прямого распространения и даже обучили её функции XOR. При этом мы позаботились об универсальности, благодаря чему нейросеть может быть обучена на любых данных, главное только подготовить два массива обучающих векторов X и Y, подобрать параметры обучения и запустить само обучение, после чего наблюдать за процессом. Важно помнить, что при использовании сигмоидальной функции активации, выходные значения сети не будут превышать 1, а значит, для обучения данным, которые значительно больше 1 необходимо отнормировать их, то есть привести к отрезку [0, 1].

Возможно, будет интересно: Свёрточная нейронная сеть с нуля. Часть 0. Введение.

Рассказывает Per Harald Borgen

В этот раз я решил изучить нейронные сети. Базовые навыки в этом вопросе я смог получить за лето и осень 2015 года. Под базовыми навыками я имею в виду, что могу сам создать простую нейронную сеть с нуля. Примеры можете найти в моих репозиториях на GitHub. В этой статье я дам несколько разъяснений и поделюсь ресурсами, которые могут пригодиться вам для изучения.

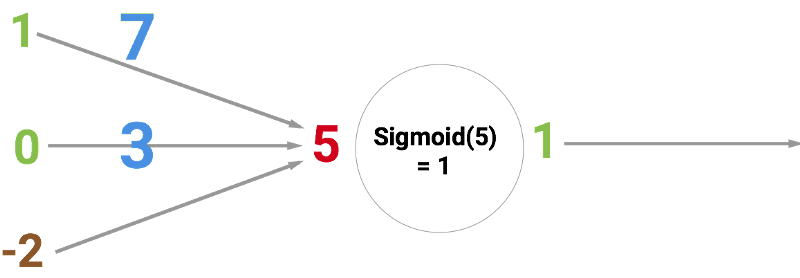

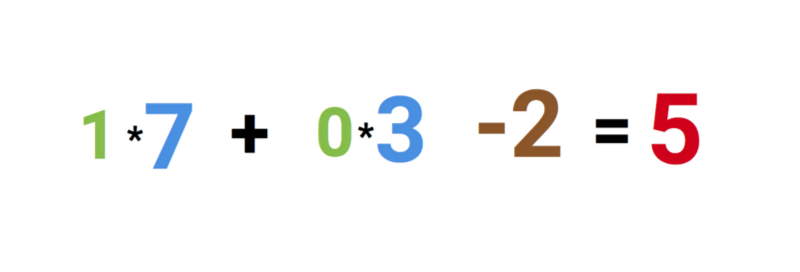

Шаг 1. Нейроны и метод прямого распространения

Так что же такое «нейронная сеть»? Давайте подождём с этим и сперва разберёмся с одним нейроном.

Нейрон похож на функцию: он принимает на вход несколько значений и возвращает одно.

Круг ниже обозначает искусственный нейрон. Он получает 5 и возвращает 1. Ввод — это сумма трёх соединённых с нейроном синапсов (три стрелки слева).

В левой части картинки мы видим 2 входных значения (зелёного цвета) и смещение (выделено коричневым цветом).

Входные данные могут быть численными представлениями двух разных свойств. Например, при создании спам-фильтра они могли бы означать наличие более чем одного слова, написанного ЗАГЛАВНЫМИ БУКВАМИ, и наличие слова «виагра».

Входные значения умножаются на свои так называемые «веса», 7 и 3 (выделено синим).

Теперь мы складываем полученные значения со смещением и получаем число, в нашем случае 5 (выделено красным). Это — ввод нашего искусственного нейрона.

Потом нейрон производит какое-то вычисление и выдает выходное значение. Мы получили 1, т.к. округлённое значение сигмоиды в точке 5 равно 1 (более подробно об этой функции поговорим позже).

Если бы это был спам-фильтр, факт вывода 1 означал бы то, что текст был помечен нейроном как спам.

Иллюстрация нейронной сети с Википедии.

Если вы объедините эти нейроны, то получите прямо распространяющуюся нейронную сеть — процесс идёт от ввода к выводу, через нейроны, соединённые синапсами, как на картинке слева.

Я очень рекомендую посмотреть серию видео от Welch Labs для улучшения понимания процесса.

Шаг 2. Сигмоида

После того, как вы посмотрели уроки от Welch Labs, хорошей идеей было бы ознакомиться с четвертой неделей курса по машинному обучению от Coursera, посвящённой нейронным сетям — она поможет разобраться в принципах их работы. Курс сильно углубляется в математику и основан на Octave, а я предпочитаю Python. Из-за этого я пропустил упражнения и почерпнул все необходимые знания из видео.

Сигмоида просто-напросто отображает ваше значение (по горизонтальной оси) на отрезок от 0 до 1.

Первоочередной задачей для меня стало изучение сигмоиды, так как она фигурировала во многих аспектах нейронных сетей. Что-то о ней я уже знал из третьей недели вышеупомянутого курса, поэтому я пересмотрел видео оттуда.

Но на одних видео далеко не уедешь. Для полного понимания я решил закодить её самостоятельно. Поэтому я начал писать реализацию алгоритма логистической регрессии (который использует сигмоиду).

Это заняло целый день, и вряд ли результат получился удовлетворительным. Но это неважно, ведь я разобрался, как всё работает. Код можно увидеть здесь.

Вам необязательно делать это самим, поскольку тут требуются специальные знания — главное, чтобы вы поняли, как устроена сигмоида.

Шаг 3. Метод обратного распространения ошибки

Понять принцип работы нейронной сети от ввода до вывода не так уж и сложно. Гораздо сложнее понять, как нейронная сеть обучается на наборах данных. Использованный мной принцип называется методом обратного распространения ошибки.

Вкратце: вы оцениваете, насколько сеть ошиблась, и изменяете вес входных значений (синие числа на первой картинке).

Процесс идёт от конца к началу, так как мы начинаем с конца сети (смотрим, насколько отклоняется от истины догадка сети) и двигаемся назад, изменяя по пути веса, пока не дойдём до ввода. Для вычисления всего этого вручную потребуются знания матанализа. Khan Academy предоставляет хорошие курсы по матанализу, но я изучал его в университете. Также можно не заморачиваться и воспользоваться библиотеками, которые посчитают весь матан за вас.

Скриншот из руководства Мэтта Мазура по методу обратного распространения ошибки.

Вот три источника, которые помогли мне разобраться в этом методе:

- A Step by Step Backpropagation Example от Matt Mazur;

- Hacker’s guide to Neural Networks от Andrej Karpathy;

- Using neural nets to recognize handwritten digits от Michael Nielsen.

В процессе прочтения первых двух статей вам обязательно нужно кодить самим, это поможет вам в дальнейшем. Да и вообще, в нейронных сетях нельзя как следует разобраться, если пренебречь практикой. Третья статья тоже классная, но это скорее энциклопедия, поскольку она размером с целую книгу. Она содержит подробные объяснения всех важных принципов работы нейронных сетей. Эти статьи также помогут вам изучить такие понятия, как функция стоимости и градиентный спуск.

Шаг 4. Создание своей нейронной сети

При прочтении различных статей и руководств вы так или иначе будете писать маленькие нейронные сети. Рекомендую именно так и делать, поскольку это — очень эффективный метод обучения.

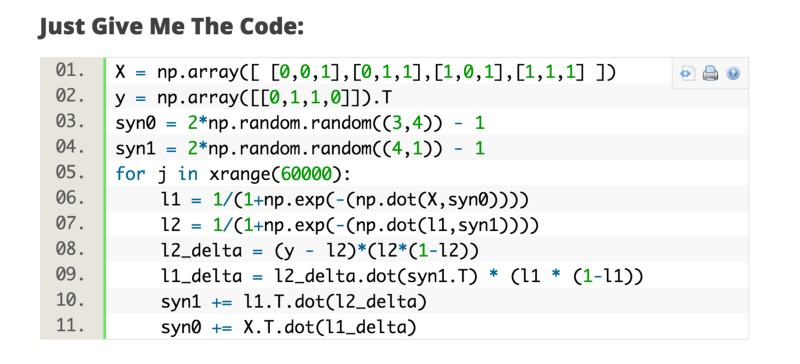

Ещё одной полезной статьёй оказалась A Neural Network in 11 lines of Python от IAmTrask. В ней содержится удивительное количество знаний, сжатых до 11 строк кода.

Скриншот руководства от IAmTrask

После прочтения этой статьи вам следует написать реализацию всех примеров самостоятельно. Это поможет вам закрыть дыры в знаниях, а когда у вас получится, вы почувствуете, будто обрели суперсилу.

Поскольку в примерах частенько встречаются реализации, использующие векторные вычисления, я рекомендую пройти курс по линейной алгебре от Coursera.

После этого можно ознакомиться с руководством Wild ML от Denny Britz, в котором разбираются нейронные сети посложнее.

Скриншот из руководства WildML

Теперь вы можете попробовать написать свою собственную нейронную сеть или поэкспериментировать с уже написанными. Очень забавно найти интересующий вас набор данных и проверить различные предположения при помощи ваших сетей.

Для поиска хороших наборов данных можете посетить мой сайт Datasets.co и выбрать там подходящий.

Так или иначе, теперь вам лучше начать свои эксперименты, чем слушать мои советы. Лично я сейчас изучаю Python-библиотеки для программирования нейронных сетей, такие как Theano, Lasagne и nolearn.

Удачи!

Перевод статьи «Learning How To Code Neural Networks»

- Подробная прямая нейронная сеть и алгоритм BP

- 1. Понятие нейронной сети

- 1.1 Базовая единица искусственной нейронной сети -> Персептрон

- 1.1.1 Объяснение модели персептрона

- 1.1.2 Функция потерь модели персептрона

- 1.1.3 Метод оптимизации функции потерь персептрона и описание алгоритма потока

- 1.1.3.1 Метод оптимизации

- 1.1.3.2 Описание алгоритма

- 1.2 Глубокая нейронная сеть (DNN) и алгоритм прямого распространения

- 1.2.1 Введение в глубокие нейронные сети

- 1.2.2 Алгоритм прямого распространения

- 1.3 Алгоритм обратного распространения BP (обратное распространение)

- 1.3.1 Проблемы, которые необходимо решить путем обратного распространения

- 1.3.2 Основная идея алгоритма обратного распространения

- 1.3.3 Процесс алгоритма обратного распространения DNN

- 1.3.4 Мышление на основе алгоритма обратного распространения DNN

- 1.1 Базовая единица искусственной нейронной сети -> Персептрон

- Во-вторых, практика кодирования прямой нейронной сети на основе TensorFlow

- 2.1 Функции библиотеки TensorFlow участвуют

- 2.2 Подгонка нелинейной регрессии данных

- 2.3 Использование Keras для моделирования непрерывных переменных

- 2.4 Задача мультиклассификации, многоузловой выходной слой

- 1. Понятие нейронной сети

Подробная прямая нейронная сеть и алгоритм BP

1. Понятие нейронной сети

1.1 Базовая единица искусственной нейронной сети -> Персептрон

1.1.1 Объяснение модели персептрона

- Прежде всего, нам необходимо прояснить, что для SVM с функциями ядра или многослойных нейронных сетей с несколькими скрытыми слоями + функциями активации или других моделей, которые могут иметь дело с нелинейной разделимостью, персептроны часто называют нейронами, но Это также можно рассматривать как двухслойную нейронную сеть (То есть только входной слой и выходной слой, нет скрытого слоя ), хотя он может иметь дело только с линейно разделимыми проблемами, он все еще является краеугольным камнем нашего изучения нейронных сетей и глубокого обучения.

- Соответствующие символы на рисунке имеют следующие значения:

- Вход (x1, …, xn)

- Смещение b и синаптические веса (w1, …, wn), обратите внимание, что мы нажимаем ниже, чтобы использовать

θ

i

Вместо wi для вывода формулы. - Комбинированная функция c (·)

- Функция активации а (·)

- Выход у

- На математическом языке, если у нас есть m выборок, каждая выборка соответствует n-мерным элементам и выводу двоичной категории следующим образом:

(

x

1

(

0

)

,

x

2

(

0

)

,

.

.

.

x

n

(

0

)

,

y

0

)

,

(

x

1

(

1

)

,

x

2

(

1

)

,

.

.

.

x

n

(

1

)

,

y

1

)

,

.

.

.

(

x

1

(

m

)

,

x

2

(

m

)

,

.

.

.

x

n

(

m

)

,

y

m

)

- Наша цель — найти гиперплоскость, а именно:

θ

0

+

θ

1

x

1

+

.

.

.

+

θ

n

x

n

=

0

Когда элементы выборки каждой категории приводятся в уравнение, они либо больше 0, либо меньше 0, так что выборки разделяются с обеих сторон гиперплоскости, так что они линейно разделимы. Как правило, если выборка линейно разделима, такая гиперплоскость будет иметь несколько решений, которые не являются уникальными. - Чтобы упростить модель, мы добавляем x0 = 1, делая уравнение гиперплоскости сокращенным

∑

i

=

0

n

θ

i

x

i

=

0

Следующая записываемая векторная форма

θ

∙

x

=

0

среди них

θ

И X оба n * 1 векторов,

∙

Для внутреннего продукта мы будем использовать его для представления гиперплоскости ниже. - Следовательно, модель персептрона может быть определена как

y

=

s

i

g

n

(

θ

∙

x

)

Где знак — это функция активации, которая является функцией знака, также известной как функция шага.

s

i

g

n

(

x

)

=

{

−

1

x

<

0

1

x

≥

0

- В многослойных нейронных сетях мы можем использовать другие функции активации, а именно:

1.1.2 Функция потерь модели персептрона

- Основываясь на приведенном выше анализе, мы будем

θ

∙

x

>

0

Выходное значение категории выборки принимается за 1, а выборка категории менее 0 принимается за -1, поэтому преимущество его определения состоит в том, что нам удобно определять функцию потерь. Из-за вышеупомянутого соглашения правильно классифицированные образцы удовлетворяют:

y

θ

∙

x

>

0

И неправильный образец классификации удовлетворяет

y

θ

∙

x

<

0

, Следовательно, метод оптимизации функции потерь состоит в том, чтобы сделать сумму расстояний до гиперплоскости всех выборок, которые неправильно классифицированы, равными наименьшему (то есть, чтобы неправильно классифицированные выборки постепенно исчезали). - из-за

y

θ

∙

x

<

0

Таким образом, для каждого неправильно классифицированного образца i расстояние до гиперплоскости равно:

−

y

(

i

)

θ

∙

x

(

i

)

/

|

|

θ

|

|

2

- среди них,

|

|

θ

|

|

2

Является ли норма L2. (Если формула расстояния здесь не понята, вы можете самостоятельно проверить расстояние от точки до прямой линии или изучить соответствующие главы машинного обучения) - Далее мы предполагаем, что множество всех ошибочно классифицированных точек равно M, тогда сумма расстояний всех ошибочно классифицированных выборок до гиперплоскости равна:

−

∑

x

i

∈

M

y

(

i

)

θ

∙

x

(

i

)

/

|

|

θ

|

|

2

Таким образом, мы получили функцию потерь предварительной модели персептрона.

- Кроме того, нам также нужно упростить его, мы можем заметить, что как числитель, так и знаменатель имеют

θ

(Т.е. числитель и знаменатель имеют одинаковое увеличение), когда числитель

θ

При увеличении в N раз норма L2 его знаменателя также увеличится в N раз. Поскольку мы изучаем проблему максимизации, мы можем зафиксировать числитель или знаменатель равным 1, затем решить вопрос минимизации оставшегося числителя или обратной величины знаменателя и затем использовать его в качестве функции потерь. Это может упростить нашу функцию потерь и облегчить решение последующих проблем.Примечание. В модели персептрона используется числитель удержания, а фиксированный знаменатель равен 1.То есть функция потерь конечного персептрона равна:

J

(

θ

)

=

−

∑

x

i

∈

M

y

(

i

)

θ

∙

x

(

i

)

В дополнение к нам также необходимо обратить внимание наДля SVM он использует фиксированный числитель 1, а затем решает

1

|

|

θ

|

|

2

Проблема максимизации (Почему проблема максимизации, а не проблема минимизации, это связано с идеей оптимизации SVM, и я не буду ее здесь приводить.)

1.1.3 Метод оптимизации функции потерь персептрона и описание алгоритма потока

1.1.3.1 Метод оптимизации

- После приведенных выше рассуждений, мы получаем функцию потери перцептрона,

J

(

θ

)

=

−

∑

x

i

∈

M

y

(

i

)

θ

∙

x

(

i

)

, Где M — множество всех ошибочно классифицированных точек, и это выпуклая функция, может использовать метод градиентного спуска или квазиньютоновского метода, обычно используемый SGD (случайный градиентный спуск), что означает, что каждый раз необходимо использовать только одну ошибочно классифицированную точку Обновите градиент. Из-за ограничения в нашей функции потерь, только выборки из неправильно классифицированного набора М могут участвовать в оптимизации функции потерь. Следовательно, BGD (пакетный градиентный спуск) нельзя использовать, только SGD или MSGD (небольшой пакетный градиентный спуск). - Функция потери

θ

Частная производная вектора:

∂

∂

θ

J

(

θ

)

=

−

∑

x

i

∈

M

y

(

i

)

x

(

i

)

θ

Формула градиентного спуска:

θ

=

θ

+

α

∑

x

i

∈

M

y

(

i

)

x

(

i

)

- Поскольку мы используем стохастический градиентный спуск, для вычисления градиента за один раз используется только одна неправильно классифицированная выборка. Предполагая, что i-я выборка используется для обновления градиента, упрощенная

θ

Итерационная формула градиентного спуска:

θ

=

θ

+

α

y

(

i

)

x

(

i

)

- Где α — размер шага,

y

(

i

)

Чтобы вывести 1 или -1 для выборки, x (i) является вектором (n + 1) x 1.

1.1.3.2 Описание алгоритма

- Здесь мы подведем итоги вышеприведенного обсуждения и сходимся в алгоритм алгоритма.

- Алгоритм ввода

- Входными данными алгоритма являются m выборок, каждая выборка соответствует n-мерным элементам и выводу двоичной категории 1 или -1 следующим образом:

(

x

1

(

0

)

,

x

2

(

0

)

,

.

.

.

x

n

(

0

)

,

y

0

)

,

(

x

1

(

1

)

,

x

2

(

1

)

,

.

.

.

x

n

(

1

)

,

y

1

)

,

.

.

.

(

x

1

(

m

)

,

x

2

(

m

)

,

.

.

.

x

n

(

m

)

,

y

m

)

- Входными данными алгоритма являются m выборок, каждая выборка соответствует n-мерным элементам и выводу двоичной категории 1 или -1 следующим образом:

- Вывод:

- Модельный коэффициент θ вектора разделяющей гиперплоскости

- Процесс выполнения алгоритма:

- Определить все х0 до 1. Выберите начальное значение вектора θ и начальное значение шага α. Вектор θ может быть установлен на вектор 0, а размер шага установлен на 1. Следует отметить, что, поскольку решение персептрона не является уникальным, два используемых начальных значения будут влиять на конечный результат итерации вектора θ.

- Выберите ошибочно классифицированную точку в тренировочном наборе

(

x

1

(

i

)

,

x

2

(

i

)

,

.

.

.

x

n

(

i

)

,

y

i

)

Выражается в векторах т.е.

(

x

(

i

)

,

y

(

i

)

)

, Этот пункт должен удовлетворять:

y

(

i

)

θ

∙

x

(

i

)

<

0

- Выполните итерацию стохастического градиентного спуска на векторе:

θ

=

θ

+

α

y

(

i

)

x

(

i

)

- Проверьте, есть ли в обучающем наборе все еще неправильно классифицированные точки, в противном случае алгоритм завершается, и вектор θ в это время является окончательным результатом. Если это так, перейдите к шагу 2.

- Наконец, также необходимо упомянуть, что когда алгоритм фактически был реализован в прошлом, мы использовали двойную форму алгоритма персептрона для решения параметров и оптимизации модели, поскольку она может оптимизировать скорость выполнения алгоритма. Читатели могут учиться самостоятельно. Мы все еще сосредоточены на следующем объяснении знаний, связанных с нейронными сетями.

1.2 Глубокая нейронная сеть (DNN) и алгоритм прямого распространения

1.2.1 Введение в глубокие нейронные сети

- С помощью персептрона его можно использовать только для задач двоичной классификации, но он не может решить нелинейные задачи.Нейронные сети сделали много расширений, главным образом отраженных в следующих аспектах:

- Добавлены скрытые слои. Скрытые слои могут иметь несколько слоев, чтобы усилить выразительные возможности модели, поэтому ее сложность также значительно возросла.

- На входном слое имеется более одного нейрона с несколькими выходами. Кроме того, существует полная связь между верхним уровнем и следующим уровнем, и нет связи между нейронами в одном и том же слое, и они не зависят друг от друга. Таким образом, модель может гибко применяться для классификации и регрессии (обычно разница заключается только в функции активации последнего прохода структуры. Если требуется регрессия и требуется непрерывное значение, не используйте стандартизированную функцию сжатия, такую как Sigmoid)

- Функция активации была расширена, чтобы заменить Sign (z) функцией Sigmod или другими функциями активации, tanx, softmax, ReLU и т. Д. Так выглядит следующая картина:

- DNN можно понимать как нейронную сеть с несколькими скрытыми слоями. Кроме того, его иногда называют многослойным персептроном (Multi-Layer Perceptron, MLP). Внутренний уровень нейронной сети делится на три категории: входной слой, скрытый слой и выходной слой. Как показано выше, в целом, первый слой является входным слоем, последний слой является выходным слоем, а все средние слои являются скрытыми слоями. Слои полностью связаны, то есть любой нейрон в слое i должен быть связан с любым нейроном в слое i + 1. Хотя DNN выглядит сложным, маленькая локальная модель остается такой же, как персептрон, то есть линейная зависимость

z

=

∑

w

i

x

i

+

b

Добавьте функцию активации σ (z). Однако с увеличением количества слоев количество линейных соотношений W и смещения b также увеличивается. Определение следующее: -

Сначала давайте взглянем на определение коэффициента линейной зависимости w. На следующем рисунке в качестве примера показан трехслойный DNN. Линейный коэффициент четвертого нейрона во втором слое ко второму нейрону в третьем слое определяется как

w

24

3

Верхний индекс 3 представляет количество слоев, в которых расположен линейный коэффициент w, а нижний индекс соответствует выходному индексу третьего уровня 2 и входному индексу второго уровня 4. Вы можете спросить, почему нет

w

42

3

Вместо

w

24

3

Какой? Это главным образом для облегчения модели для операций матричного представления, если это

w

42

3

И каждый раз, когда выполняется матричная операция

w

T

x

+

b

Нужно транспонировать. Если выходной индекс помещен вперед, вес W не должен быть перемещен в линейной операции. То есть линейные коэффициенты k-го нейрона в слое l-1 до j-го нейрона в слое l определяются как

w

j

k

l

Где входной слой не имеет параметра w.

-

Давайте посмотрим на определение смещения б. На примере этого трехслойного DNN смещение, соответствующее третьему нейрону во втором слое, определяется как

b

3

2

Среди них верхний индекс 2 представляет количество слоев, а нижний индекс 3 представляет индекс нейронов, в которых находится смещение. Таким же образом, смещение первого нейрона в третьем должно быть выражено как

b

1

3

Аналогично, входной слой не имеет параметра смещения b.

1.2.2 Алгоритм прямого распространения

-

Выше мы ввели определение коэффициента линейной зависимости w и смещения b каждого слоя DNN. Предполагая, что выбранная нами функция активации σ (z), выходное значение скрытого слоя и выходного слоя равно a, а затем для трехслойного DNN на следующем рисунке, используя ту же идею, что и персептрон, мы можем использовать выходные данные предыдущего слоя для вычисления Выход первого уровня — это так называемый алгоритм прямого распространения DNN.

- Для вывода второго слоя

a

1

2

,

a

2

2

,

a

3

2

,У нас есть:

a

1

2

=

σ

(

z

1

2

)

=

σ

(

w

11

2

x

1

+

w

12

2

x

2

+

w

13

2

x

3

+

b

1

2

)

a

2

2

=

σ

(

z

2

2

)

=

σ

(

w

21

2

x

1

+

w

22

2

x

2

+

w

23

2

x

3

+

b

2

2

)

a

3

2

=

σ

(

z

3

2

)

=

σ

(

w

31

2

x

1

+

w

32

2

x

2

+

w

33

2

x

3

+

b

3

2

)

- Для вывода третьего слоя

a

1

3

,У нас есть:

a

1

3

=

σ

(

z

1

3

)

=

σ

(

w

11

3

a

1

2

+

w

12

3

a

2

2

+

w

13

3

a

3

2

+

b

1

3

)

- Обобщая вышеприведенный пример, предполагая, что в слое l-1 имеется m нейронов, для вывода j-го нейрона в слое l

a

j

l

,У нас есть:

a

j

l

=

σ

(

z

j

l

)

=

σ

(

∑

k

=

1

m

w

j

k

l

a

k

l

−

1

+

b

j

l

)

- Среди них, если

l

= 2, тогда a_k ^ 1 для входного слоя

x

k

。 - Далее, ключевой момент — матричная запись, потому что алгебраический метод означает, что выходные данные являются сложными, а матричный метод означает, что выходные данные просты. предполагать

l

-1 слой имеет в общей сложности m нейронов, в то время как слой 1 имеет в общей сложности n нейронов, тогда

l

Линейный коэффициент w слоя образует матрицу Wl n × m, первый

l

Смещение b слоя формирует вектор n × 1

b

l

, Раздел

l

Выход a слоя -1 формирует вектор m × 1

a

l

−

1

, Раздел

l

Неактивный линейный выход z слоя формирует вектор n × 1

z

l

, Раздел

l

Выход a слоя формирует вектор n × 1

a

l

, Выражается матричным методом, первым

l

Выход слоя:

a

l

=

σ

(

z

l

)

=

σ

(

W

l

a

l

−

1

+

b

l

)

- Это выражено очень кратко, поэтому последующее обсуждение будет выведено на основе этого матричного метода.

- Описание алгоритма потока:

- Вход: общее количество слоев L, матрица W, соответствующая всем скрытым слоям и выходным слоям, вектор смещения b, вектор входных значений x

- Выход: выходной слой

a

L

- Обработать:

- Initialize

a

1

=x - for

l

=2 to

L

Расчет:

a

l

=

σ

(

z

l

)

=

σ

(

W

l

a

l

−

1

+

b

l

)

- Конечный результат — выход

a

L

- Initialize

- DNN алгоритм прямого распространения, как получить параметры, соответствующие большой матрице W и вектору смещения b? Как получить оптимальную матрицу W и вектор смещения b? Это должно быть решено алгоритмом обратного распространения DNN. Предпосылка понимания алгоритма обратного распространения состоит в том, чтобы понять модель DNN и алгоритм прямого распространения. Далее идет легендарный алгоритм БП.

1.3 Алгоритм обратного распространения BP (обратное распространение)

1.3.1 Проблемы, которые необходимо решить путем обратного распространения

- Прежде, чем понять алгоритм обратного распространения DNN, мы должны сначала знать проблему, которую должен решить алгоритм обратного распространения DNN, то есть, когда нам нужен этот алгоритм обратного распространения?

- Возвращаясь к нашей общей проблеме контролируемого обучения, предположим, что у нас есть m обучающих образцов:

{

(

x

1

,

y

1

)

,

(

x

2

,

y

2

)

,

.

.

.

,

(

x

m

,

y

m

)

}

Где x — входной вектор, а размерность объекта — n_in, а y — выходной вектор, а размерность объекта — n_out. Нам нужно использовать эти m образцов для обучения модели, когда есть новый тестовый образец (

x

t

e

s

t

?) Когда мы придем, мы можем предсказать

y

t

e

s

t

Векторный вывод. - Если мы примем модель DNN, у нас будет n_in нейронов на входном слое и n_out нейронов на выходном слое. Плюс несколько скрытых слоев, содержащих несколько нейронов. В настоящее время нам нужно найти соответствующую матрицу линейных коэффициентов W и вектор смещения b для всех скрытых слоев и выходных слоев, чтобы выходной сигнал, рассчитанный по всем входным сигналам обучающей выборки, был как можно ближе к выходным данным выборки или близко к ним. Как найти подходящие параметры?

- Вы можете подумать, что вы можете использовать подходящую функцию потерь для измерения выходных потерь обучающей выборки, а затем оптимизировать эту функцию потерь, чтобы минимизировать экстремальное значение. Соответствующий ряд матриц W линейного коэффициента, вектор смещения b является нашей Окончательные результаты. В DNN процесс оптимизации экстремума функции потерь обычно повторяется шаг за шагом по методу градиентного спуска.Конечно, можно использовать и другие итерационные методы, такие как метод Ньютона и квазиньютоновский метод.

- Процесс итеративной оптимизации функции потерь DNN путем градиентного спуска для нахождения минимального значения является нашим алгоритмом обратного распространения.

1.3.2 Основная идея алгоритма обратного распространения

- Перед выполнением алгоритма обратного распространения DNN нам нужно выбрать функцию потерь, чтобы измерить потери между вычисленным выходным значением обучающей выборки и фактическим выходным значением обучающей выборки. Вы можете спросить: как рассчитывается результат на основе обучающей выборки? Эти выходные данные выбираются случайным образом из ряда W, b и вычисляются с использованием алгоритма прямого распространения в нашем предыдущем разделе. То есть с помощью ряда расчетов:

a

l

=

σ

(

z

l

)

=

σ

(

W

l

a

l

−

1

+

b

l

)

, Рассчитать соответствующий L-й слой выходного слоя

a

L

Это выходной сигнал, рассчитанный по алгоритму прямого распространения. — В отличие от функции потерь, существует множество функций потерь, которые DNN может выбрать. Чтобы сосредоточиться на алгоритме, здесь мы используем наиболее распространенную среднеквадратичную ошибку для измерения потерь. То есть для каждого образца мы ожидаем минимизировать следующую формулу:

J

(

W

,

b

,

x

,

y

)

=

1

2

|

|

a

L

−

y

|

|

2

2

- среди них,

a

L

И у — векторы с размерностью объекта n_out, и

|

|

S

|

|

2

Является ли L2 нормой S. - С функцией потерь, теперь мы начинаем использовать градиентный спуск, чтобы итеративно решить W, b для каждого слоя.

- Первый — это L-й слой выходного слоя. Обратите внимание, что W, b в выходном слое удовлетворяет следующей формуле:

a

L

=

σ

(

z

L

)

=

σ

(

W

L

a

L

−

1

+

b

L

)

- Таким образом, для параметров выходного слоя наша функция потерь становится:

J

(

W

,

b

,

x

,

y

)

=

1

2

|

|

a

L

−

y

|

|

2

2

=

1

2

|

|

σ

(

W

L

a

L

−

1

+

b

L

)

−

y

|

|

2

2

- Решить градиент W, b таким образом просто:

∂

J

(

W

,

b

,

x

,

y

)

∂

W

L

=

∂

J

(

W

,

b

,

x

,

y

)

∂

z

L

∂

z

L

∂

W

L

=

(

a

L

−

y

)

⊙

σ

′

(

z

L

)

(

a

L

−

1

)

T

∂

J

(

W

,

b

,

x

,

y

)

∂

b

L

=

∂

J

(

W

,

b

,

x

,

y

)

∂

z

L

∂

z

L

∂

b

L

=

(

a

L

−

y

)

⊙

σ

′

(

z

L

)

- Обратите внимание, что в приведенной выше формуле есть символ

⊙

, Который представляет произведение Адамара, для двух векторов одного измерения

A

(

a

1

,

a

2

,

.

.

.

a

n

)

T

с участием

B

(

b

1

,

b

2

,

.

.

.

b

n

)

T

, Затем

A

⊙

B

=

(

a

1

b

1

,

a

2

b

2

,

.

.

.

a

n

b

n

)

T

- Мы заметили, что при решении W, b в выходном слое, есть общая часть

∂

J

(

W

,

b

,

x

,

y

)

∂

z

L

Таким образом, мы можем относиться к публичной части как

z

L

Сначала рассчитайте его и запишите как:

δ

L

=

∂

J

(

W

,

b

,

x

,

y

)

∂

z

L

=

(

a

L

−

y

)

⊙

σ

′

(

z

L

)

- Теперь, когда мы наконец рассчитали градиент выходного слоя, как рассчитать градиент верхнего слоя L − 1 и верхнего и верхнего слоя L − 2? Здесь нам нужно повторить шаг за шагом, отметив, что для неактивного вывода слоя l

z

l

Его градиент может быть выражен как:

δ

l

=

∂

J

(

W

,

b

,

x

,

y

)

∂

z

l

=

∂

J

(

W

,

b

,

x

,

y

)

∂

z

L

∂

z

L

∂

z

L

−

1

∂

z

L

−

1

∂

z

L

−

2

.

.

.

∂

z

l

+

1

∂

z

l

- Если мы можем рассчитать первое

l

Многослойные

δ

l

Тогда слой

W

l

,

b

l

Это легко рассчитать? y Поскольку согласно алгоритму прямого распространения, мы имеем:

z

l

=

W

l

a

l

−

1

+

b

l

- Таким образом, согласно приведенной выше формуле мы можем легко вычислить первое

l

Многослойные

W

l

,

b

l

Градиент выглядит следующим образом:

∂

J

(

W

,

b

,

x

,

y

)

∂

W

l

=

∂

J

(

W

,

b

,

x

,

y

)

∂

z

l

∂

z

l

∂

W

l

=

δ

l

(

a

l

−

1

)

T

∂

J

(

W

,

b

,

x

,

y

)

∂

b

l

=

∂

J

(

W

,

b

,

x

,

y

)

∂

z

l

∂

z

l

∂

b

l

=

δ

l

- Тогда ключ к проблеме сейчас заключается в том, чтобы попросить

δ

l

Слишком. Здесь мы используем математическую индукцию, слой L

δ

L

Мы нашли выше, предполагая, что первое

l

+1

δ

l

+

1

Уже

через

нищенство

Вне

Приходить

от

,

который

какой

я

Мы

Такие как

какие

нищенство

Вне

Первый

l

Пол

из

А как насчет δ ^ l $? Мы заметили: (цепное правило)

δ

l

=

∂

J

(

W

,

b

,

x

,

y

)

∂

z

l

=

∂

J

(

W

,

b

,

x

,

y

)

∂

z

l

+

1

∂

z

l

+

1

∂

z

l

=

δ

l

+

1

∂

z

l

+

1

∂

z

l

- Видимо, рекурсивно по индукции

δ

l

+

1

с участием

δ

l

Ключ должен решить

∂

z

l

+

1

∂

z

l

- Пока

z

l

+

1

с участием

z

l

Отношения на самом деле очень легко найти:

z

l

+

1

=

W

l

+

1

a

l

+

b

l

+

1

=

W

l

+

1

σ

(

z

l

)

+

b

l

+

1

- Это легко найти:

∂

z

l

+

1

∂

z

l

=

(

W

l

+

1

)

T

⊙

(

σ

′

(

z

l

)

,

.

.

,

σ

′

(

z

l

)

)

⏟

n

l

+

1

- Доведите вышеупомянутое до вершины

δ

l

+

1

с участием

δ

l

Мы получили:

δ

l

=

δ

l

+

1

∂

z

l

+

1

∂

z

l

=

(

W

l

+

1

)

T

δ

l

+

1

⊙

σ

′

(

z

l

)

- Теперь мы получили

δ

l

Для рекурсивных отношений требуется только определенный уровень

δ

l

, Решить

W

l

,

b

l