Evaluation metrics¶

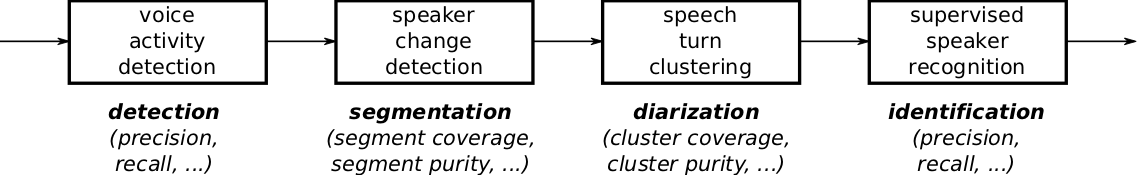

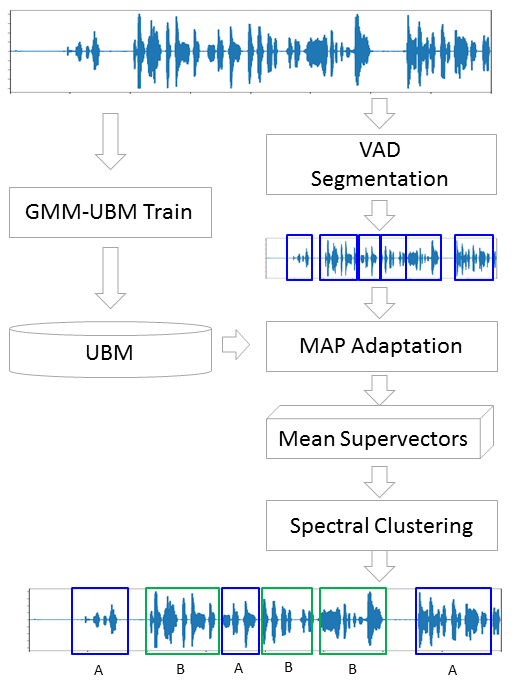

Here is a typical speaker diarization pipeline:

The first step is usually dedicated to speech activity detection, where the objective is to get rid of all non-speech regions.

Then, speaker change detection aims at segmenting speech regions into homogeneous segments.

The subsequent clustering step tries to group those speech segments according to the identity of the speaker.

Finally, an optional supervised classification step may be applied to actually identity every speaker cluster in a supervised way.

Looking at the final performance of the system is usually not enough for diagnostic purposes.

In particular, it is often necessary to evaluate the performance of each module separately to identify their strenght and weakness, or to estimate the influence of their errors on the complete pipeline.

Here, we provide the list of metrics that were implemented in pyannote.metrics with that very goal in mind.

Because manual annotations cannot be precise at the audio sample level, it is common in speaker diarization research to remove from evaluation a 500ms collar around each speaker turn boundary (250ms before and after).

Most of the metrics available in pyannote.metrics support a collar parameter, which defaults to 0.

Moreover, though audio files can always be processed entirely (from beginning to end), there are cases where reference annotations are only available for some regions of the audio files.

All metrics support the provision of an evaluation map that indicate which part of the audio file should be evaluated.

Detection¶

The two primary metrics for evaluating speech activity detection modules are detection error rate and detection cost function.

Detection error rate (not to be confused with diarization error rate) is defined as:

[text{detection error rate} = frac{text{false alarm} + text{missed detection}}{text{total}}]

where (text{false alarm}) is the duration of non-speech incorrectly classified as speech, (text{missed detection}) is the duration of speech incorrectly classified as non-speech, and (text{total}) is the total duration of speech in the reference.

Alternately, speech activity module output may be evaluated in terms of detection cost function, which is defined as:

[text{detection cost function} = 0.25 times text{false alarm rate} + 0.75 times text{miss rate}]

where (text{false alarm rate}) is the proportion of non-speech incorrectly classified as speech and (text{miss rate}) is the proportion of speech incorrectly classified as non-speech.

Additionally, detection may be evaluated in terms of accuracy (proportion of the input signal correctly classified), precision (proportion of detected speech that is speech), and recall (proporton of speech that is detected).

-

class

pyannote.metrics.detection.DetectionAccuracy(collar=0.0, skip_overlap=False, **kwargs)[source]¶ -

Detection accuracy

This metric can be used to evaluate binary classification tasks such as

speech activity detection, for instance. Inputs are expected to only

contain segments corresponding to the positive class (e.g. speech regions).

Gaps in the inputs considered as the negative class (e.g. non-speech

regions).It is computed as (tp + tn) / total, where tp is the duration of true

positive (e.g. speech classified as speech), tn is the duration of true

negative (e.g. non-speech classified as non-speech), and total is the total

duration of the input signal.- Parameters:

-

-

collar (float, optional) – Duration (in seconds) of collars removed from evaluation around

boundaries of reference segments (one half before, one half after). -

skip_overlap (bool, optional) – Set to True to not evaluate overlap regions.

Defaults to False (i.e. keep overlap regions).

-

-

compute_components(reference, hypothesis, uem=None, **kwargs)[source]¶ -

Compute metric components

- Parameters:

-

-

reference (type depends on the metric) – Manual reference

-

hypothesis (same as reference) – Evaluated hypothesis

-

- Returns:

-

components – Dictionary where keys are component names and values are component

values - Return type:

-

dict

-

compute_metric(detail)[source]¶ -

Compute metric value from computed components

- Parameters:

-

components (dict) – Dictionary where keys are components names and values are component

values - Returns:

-

value – Metric value

- Return type:

-

type depends on the metric

-

class

pyannote.metrics.detection.DetectionCostFunction(collar=0.0, skip_overlap=False, fa_weight=0.25, miss_weight=0.75, **kwargs)[source]¶ -

Detection cost function.

This metric can be used to evaluate binary classification tasks such as

speech activity detection. Inputs are expected to only contain segments

corresponding to the positive class (e.g. speech regions). Gaps in the

inputs considered as the negative class (e.g. non-speech regions).Detection cost function (DCF), as defined by NIST for OpenSAT 2019, is

0.25*far + 0.75*missr, where far is the false alarm rate

(i.e., the proportion of non-speech incorrectly classified as speech)

and missr is the miss rate (i.e., the proportion of speech incorrectly

classified as non-speech.- Parameters:

-

-

collar (float, optional) – Duration (in seconds) of collars removed from evaluation around

boundaries of reference segments (one half before, one half after).

Defaults to 0.0. -

skip_overlap (bool, optional) – Set to True to not evaluate overlap regions.

Defaults to False (i.e. keep overlap regions). -

fa_weight (float, optional) – Weight for false alarm rate.

Defaults to 0.25. -

miss_weight (float, optional) – Weight for miss rate.

Defaults to 0.75. -

kwargs – Keyword arguments passed to

pyannote.metrics.base.BaseMetric.

-

References

“OpenSAT19 Evaluation Plan v2.” https://www.nist.gov/system/files/documents/2018/11/05/opensat19_evaluation_plan_v2_11-5-18.pdf

-

compute_components(reference, hypothesis, uem=None, **kwargs)[source]¶ -

Compute metric components

- Parameters:

-

-

reference (type depends on the metric) – Manual reference

-

hypothesis (same as reference) – Evaluated hypothesis

-

- Returns:

-

components – Dictionary where keys are component names and values are component

values - Return type:

-

dict

-

compute_metric(components)[source]¶ -

Compute metric value from computed components

- Parameters:

-

components (dict) – Dictionary where keys are components names and values are component

values - Returns:

-

value – Metric value

- Return type:

-

type depends on the metric

-

class

pyannote.metrics.detection.DetectionErrorRate(collar=0.0, skip_overlap=False, **kwargs)[source]¶ -

Detection error rate

This metric can be used to evaluate binary classification tasks such as

speech activity detection, for instance. Inputs are expected to only

contain segments corresponding to the positive class (e.g. speech regions).

Gaps in the inputs considered as the negative class (e.g. non-speech

regions).It is computed as (fa + miss) / total, where fa is the duration of false

alarm (e.g. non-speech classified as speech), miss is the duration of

missed detection (e.g. speech classified as non-speech), and total is the

total duration of the positive class in the reference.- Parameters:

-

-

collar (float, optional) – Duration (in seconds) of collars removed from evaluation around

boundaries of reference segments (one half before, one half after). -

skip_overlap (bool, optional) – Set to True to not evaluate overlap regions.

Defaults to False (i.e. keep overlap regions).

-

-

compute_components(reference, hypothesis, uem=None, **kwargs)[source]¶ -

Compute metric components

- Parameters:

-

-

reference (type depends on the metric) – Manual reference

-

hypothesis (same as reference) – Evaluated hypothesis

-

- Returns:

-

components – Dictionary where keys are component names and values are component

values - Return type:

-

dict

-

compute_metric(detail)[source]¶ -

Compute metric value from computed components

- Parameters:

-

components (dict) – Dictionary where keys are components names and values are component

values - Returns:

-

value – Metric value

- Return type:

-

type depends on the metric

-

class

pyannote.metrics.detection.DetectionPrecision(collar=0.0, skip_overlap=False, **kwargs)[source]¶ -

Detection precision

This metric can be used to evaluate binary classification tasks such as

speech activity detection, for instance. Inputs are expected to only

contain segments corresponding to the positive class (e.g. speech regions).

Gaps in the inputs considered as the negative class (e.g. non-speech

regions).It is computed as tp / (tp + fp), where tp is the duration of true positive

(e.g. speech classified as speech), and fp is the duration of false

positive (e.g. non-speech classified as speech).- Parameters:

-

-

collar (float, optional) – Duration (in seconds) of collars removed from evaluation around

boundaries of reference segments (one half before, one half after). -

skip_overlap (bool, optional) – Set to True to not evaluate overlap regions.

Defaults to False (i.e. keep overlap regions).

-

-

compute_components(reference, hypothesis, uem=None, **kwargs)[source]¶ -

Compute metric components

- Parameters:

-

-

reference (type depends on the metric) – Manual reference

-

hypothesis (same as reference) – Evaluated hypothesis

-

- Returns:

-

components – Dictionary where keys are component names and values are component

values - Return type:

-

dict

-

compute_metric(detail)[source]¶ -

Compute metric value from computed components

- Parameters:

-

components (dict) – Dictionary where keys are components names and values are component

values - Returns:

-

value – Metric value

- Return type:

-

type depends on the metric

-

class

pyannote.metrics.detection.DetectionPrecisionRecallFMeasure(collar=0.0, skip_overlap=False, beta=1.0, **kwargs)[source]¶ -

Compute detection precision and recall, and return their F-score

- Parameters:

-

-

collar (float, optional) – Duration (in seconds) of collars removed from evaluation around

boundaries of reference segments (one half before, one half after). -

skip_overlap (bool, optional) – Set to True to not evaluate overlap regions.

Defaults to False (i.e. keep overlap regions). -

beta (float, optional) – When beta > 1, greater importance is given to recall.

When beta < 1, greater importance is given to precision.

Defaults to 1.

-

See also

pyannote.metrics.detection.DetectionPrecision,pyannote.metrics.detection.DetectionRecall,pyannote.metrics.base.f_measure-

compute_components(reference, hypothesis, uem=None, **kwargs)[source]¶ -

Compute metric components

- Parameters:

-

-

reference (type depends on the metric) – Manual reference

-

hypothesis (same as reference) – Evaluated hypothesis

-

- Returns:

-

components – Dictionary where keys are component names and values are component

values - Return type:

-

dict

-

compute_metric(detail)[source]¶ -

Compute metric value from computed components

- Parameters:

-

components (dict) – Dictionary where keys are components names and values are component

values - Returns:

-

value – Metric value

- Return type:

-

type depends on the metric

-

class

pyannote.metrics.detection.DetectionRecall(collar=0.0, skip_overlap=False, **kwargs)[source]¶ -

Detection recall

This metric can be used to evaluate binary classification tasks such as

speech activity detection, for instance. Inputs are expected to only

contain segments corresponding to the positive class (e.g. speech regions).

Gaps in the inputs considered as the negative class (e.g. non-speech

regions).It is computed as tp / (tp + fn), where tp is the duration of true positive

(e.g. speech classified as speech), and fn is the duration of false

negative (e.g. speech classified as non-speech).- Parameters:

-

-

collar (float, optional) – Duration (in seconds) of collars removed from evaluation around

boundaries of reference segments (one half before, one half after). -

skip_overlap (bool, optional) – Set to True to not evaluate overlap regions.

Defaults to False (i.e. keep overlap regions).

-

-

compute_components(reference, hypothesis, uem=None, **kwargs)[source]¶ -

Compute metric components

- Parameters:

-

-

reference (type depends on the metric) – Manual reference

-

hypothesis (same as reference) – Evaluated hypothesis

-

- Returns:

-

components – Dictionary where keys are component names and values are component

values - Return type:

-

dict

-

compute_metric(detail)[source]¶ -

Compute metric value from computed components

- Parameters:

-

components (dict) – Dictionary where keys are components names and values are component

values - Returns:

-

value – Metric value

- Return type:

-

type depends on the metric

Segmentation¶

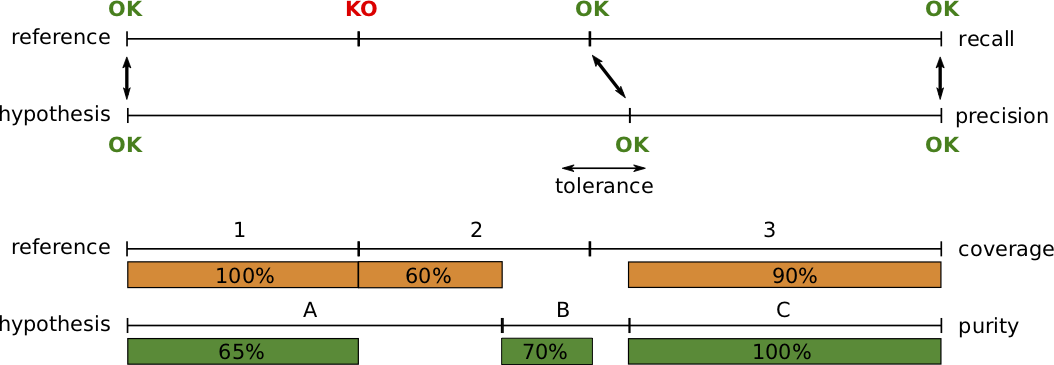

Change detection modules can be evaluated using two pairs of dual metrics: precision and recall, or purity and coverage.

Precision and recall are standard metrics based on the number of correctly detected speaker boundaries. Recall is 75% because 3 out of 4 reference boundaries were correctly detected, and precision is 100% because all hypothesized boundaries are correct.

The main weakness of that pair of metrics (and their combination into a f-score) is that it is very sensitive to the tolerance parameter, i.e. the maximum distance between two boundaries for them to be matched. From one segmentation paper to another, authors may used very different values, thus making the approaches difficult to compare.

Instead, we think that segment-wise purity and coverage should be used instead.

They have several advantages over precision and recall, including the fact that they do not depend on any tolerance parameter, and that they directly relate to the cluster-wise purity and coverage used for evaluating speaker diarization.

Segment-wise coverage is computed for each segment in the reference as the ratio of the duration of the intersection with the most co-occurring hypothesis segment and the duration of the reference segment.

For instance, coverage for reference segment 1 is 100% because it is entirely covered by hypothesis segment A.

Purity is the dual metric that indicates how pure hypothesis segments are. For instance, segment A is only 65% pure because it is covered at 65% by segment 1 and 35% by segment 2.

The final values are duration-weighted average over each segment.

-

class

pyannote.metrics.segmentation.SegmentationCoverage(tolerance=0.5, **kwargs)[source]¶ -

Segmentation coverage

- Parameters:

-

tolerance (float, optional) – When provided, preprocess reference by filling intra-label gaps shorter

than tolerance (in seconds).

-

compute_components(reference, hypothesis, **kwargs)[source]¶ -

Compute metric components

- Parameters:

-

-

reference (type depends on the metric) – Manual reference

-

hypothesis (same as reference) – Evaluated hypothesis

-

- Returns:

-

components – Dictionary where keys are component names and values are component

values - Return type:

-

dict

-

compute_metric(detail)[source]¶ -

Compute metric value from computed components

- Parameters:

-

components (dict) – Dictionary where keys are components names and values are component

values - Returns:

-

value – Metric value

- Return type:

-

type depends on the metric

-

class

pyannote.metrics.segmentation.SegmentationPrecision(tolerance=0.0, **kwargs)[source]¶ -

Segmentation precision

>>> from pyannote.core import Timeline, Segment >>> from pyannote.metrics.segmentation import SegmentationPrecision >>> precision = SegmentationPrecision()

>>> reference = Timeline() >>> reference.add(Segment(0, 1)) >>> reference.add(Segment(1, 2)) >>> reference.add(Segment(2, 4))

>>> hypothesis = Timeline() >>> hypothesis.add(Segment(0, 1)) >>> hypothesis.add(Segment(1, 2)) >>> hypothesis.add(Segment(2, 3)) >>> hypothesis.add(Segment(3, 4)) >>> precision(reference, hypothesis) 0.6666666666666666

>>> hypothesis = Timeline() >>> hypothesis.add(Segment(0, 4)) >>> precision(reference, hypothesis) 1.0

-

compute_components(reference, hypothesis, **kwargs)[source]¶ -

Compute metric components

- Parameters:

-

-

reference (type depends on the metric) – Manual reference

-

hypothesis (same as reference) – Evaluated hypothesis

-

- Returns:

-

components – Dictionary where keys are component names and values are component

values - Return type:

-

dict

-

compute_metric(detail)[source]¶ -

Compute metric value from computed components

- Parameters:

-

components (dict) – Dictionary where keys are components names and values are component

values - Returns:

-

value – Metric value

- Return type:

-

type depends on the metric

-

-

class

pyannote.metrics.segmentation.SegmentationPurity(tolerance=0.5, **kwargs)[source]¶ -

Segmentation purity

- Parameters:

-

tolerance (float, optional) – When provided, preprocess reference by filling intra-label gaps shorter

than tolerance (in seconds).

-

compute_components(reference, hypothesis, **kwargs)[source]¶ -

Compute metric components

- Parameters:

-

-

reference (type depends on the metric) – Manual reference

-

hypothesis (same as reference) – Evaluated hypothesis

-

- Returns:

-

components – Dictionary where keys are component names and values are component

values - Return type:

-

dict

-

class

pyannote.metrics.segmentation.SegmentationPurityCoverageFMeasure(tolerance=0.5, beta=1, **kwargs)[source]¶ -

Compute segmentation purity and coverage, and return their F-score.

- Parameters:

-

-

tolerance (float, optional) – When provided, preprocess reference by filling intra-label gaps shorter

than tolerance (in seconds). -

beta (float, optional) – When beta > 1, greater importance is given to coverage.

When beta < 1, greater importance is given to purity.

Defaults to 1.

-

See also

pyannote.metrics.segmentation.SegmentationPurity,pyannote.metrics.segmentation.SegmentationCoverage,pyannote.metrics.base.f_measure-

compute_components(reference, hypothesis, **kwargs)[source]¶ -

Compute metric components

- Parameters:

-

-

reference (type depends on the metric) – Manual reference

-

hypothesis (same as reference) – Evaluated hypothesis

-

- Returns:

-

components – Dictionary where keys are component names and values are component

values - Return type:

-

dict

-

compute_metric(detail)[source]¶ -

Compute metric value from computed components

- Parameters:

-

components (dict) – Dictionary where keys are components names and values are component

values - Returns:

-

value – Metric value

- Return type:

-

type depends on the metric

-

class

pyannote.metrics.segmentation.SegmentationRecall(tolerance=0.0, **kwargs)[source]¶ -

Segmentation recall

>>> from pyannote.core import Timeline, Segment >>> from pyannote.metrics.segmentation import SegmentationRecall >>> recall = SegmentationRecall()

>>> reference = Timeline() >>> reference.add(Segment(0, 1)) >>> reference.add(Segment(1, 2)) >>> reference.add(Segment(2, 4))

>>> hypothesis = Timeline() >>> hypothesis.add(Segment(0, 1)) >>> hypothesis.add(Segment(1, 2)) >>> hypothesis.add(Segment(2, 3)) >>> hypothesis.add(Segment(3, 4)) >>> recall(reference, hypothesis) 1.0

>>> hypothesis = Timeline() >>> hypothesis.add(Segment(0, 4)) >>> recall(reference, hypothesis) 0.0

-

compute_components(reference, hypothesis, **kwargs)[source]¶ -

Compute metric components

- Parameters:

-

-

reference (type depends on the metric) – Manual reference

-

hypothesis (same as reference) – Evaluated hypothesis

-

- Returns:

-

components – Dictionary where keys are component names and values are component

values - Return type:

-

dict

-

Diarization¶

Diarization error rate (DER) is the emph{de facto} standard metric for evaluating and comparing speaker diarization systems.

It is defined as follows:

[text{DER} = frac{text{false alarm} + text{missed detection} + text{confusion}}{text{total}}]

where (text{false alarm}) is the duration of non-speech incorrectly classified as speech, (text{missed detection}) is the duration of

speech incorrectly classified as non-speech, (text{confusion}) is the duration of speaker confusion, and (text{total}) is the sum over all speakers of their reference speech duration.

Note that this metric does take overlapping speech into account, potentially leading to increased missed detection in case the speaker diarization system does not include an overlapping speech detection module.

Optimal vs. greedy¶

Two implementations of the diarization error rate are available (optimal and greedy), depending on how the one-to-one mapping between reference and hypothesized speakers is computed.

The optimal version uses the Hungarian algorithm to compute the mapping that minimize the confusion term, while the greedy version operates in a greedy manner, mapping reference and hypothesized speakers iteratively, by decreasing value of their cooccurrence duration.

In practice, the greedy version is much faster than the optimal one, especially for files with a large number of speakers – though it may slightly over-estimate the value of the diarization error rate.

Purity and coverage¶

While the diarization error rate provides a convenient way to compare different diarization approaches, it is usually not enough to understand the type of errors commited by the system.

Purity and coverage are two dual evaluation metrics that provide additional insight on the behavior of the system.

[begin{split} text{purity} & = & frac{displaystyle sum_{text{cluster}} max_{text{speaker}} |text{cluster} cap text{speaker}| }{displaystyle sum_{text{cluster}} |text{cluster}|} \

text{coverage} & = & frac{displaystyle sum_{text{speaker}} max_{text{cluster}} |text{speaker} cap text{cluster}| }{displaystyle sum_{text{speaker}} |text{speaker}|} \end{split}]

where (|text{speaker}|) (respectively (|text{cluster}|)) is the speech duration of this particular reference speaker (resp. hypothesized cluster), and (|text{speaker} cap text{cluster}|) is the duration of their intersection.

Over-segmented results (e.g. too many speaker clusters) tend to lead to high purity and low coverage, while under-segmented results (e.g. when two speakers are merged into one large cluster) lead to low purity and higher coverage.

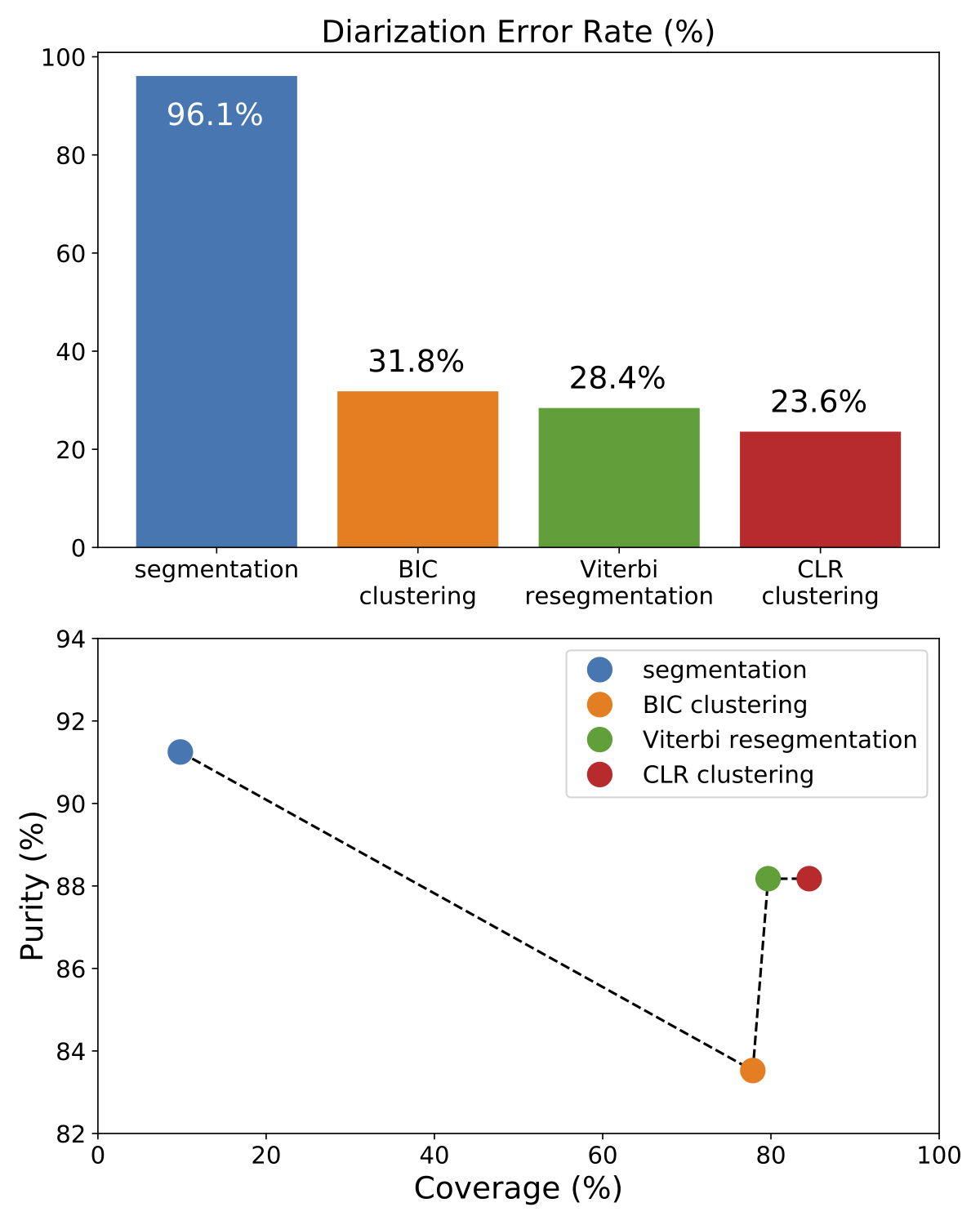

Use case¶

This figure depicts the evolution of a multi-stage speaker diarization system applied on the ETAPE dataset.

It is roughly made of four consecutive modules (segmentation, BIC clustering, Viterbi resegmentation, and CLR clustering).

From the upper part of the figure (DER as a function of the module), it is clear that each module improves the output of the previous one.

Yet, the lower part of the figure clarifies the role of each module.

BIC clustering tends to increase the size of the speaker clusters, at the expense of purity (-7%).

Viterbi resegmentation addresses this limitation and greatly improves cluster purity (+5%), with very little impact on the actual cluster coverage (+2%).

Finally, CLR clustering brings an additional +5% coverage improvement.

Metrics for diarization

-

class

pyannote.metrics.diarization.DiarizationCompleteness(collar=0.0, skip_overlap=False, **kwargs)[source]¶ -

Cluster completeness

- Parameters:

-

-

collar (float, optional) – Duration (in seconds) of collars removed from evaluation around

boundaries of reference segments. -

skip_overlap (bool, optional) – Set to True to not evaluate overlap regions.

Defaults to False (i.e. keep overlap regions).

-

-

compute_components(reference, hypothesis, uem=None, **kwargs)[source]¶ -

Compute metric components

- Parameters:

-

-

reference (type depends on the metric) – Manual reference

-

hypothesis (same as reference) – Evaluated hypothesis

-

- Returns:

-

components – Dictionary where keys are component names and values are component

values - Return type:

-

dict

-

class

pyannote.metrics.diarization.DiarizationCoverage(collar=0.0, skip_overlap=False, weighted=True, **kwargs)[source]¶ -

Cluster coverage

A hypothesized annotation has perfect coverage if all segments from a

given reference label are clustered in the same cluster.- Parameters:

-

-

weighted (bool, optional) – When True (default), each cluster is weighted by its overall duration.

-

collar (float, optional) – Duration (in seconds) of collars removed from evaluation around

boundaries of reference segments. -

skip_overlap (bool, optional) – Set to True to not evaluate overlap regions.

Defaults to False (i.e. keep overlap regions).

-

-

compute_components(reference, hypothesis, uem=None, **kwargs)[source]¶ -

Compute metric components

- Parameters:

-

-

reference (type depends on the metric) – Manual reference

-

hypothesis (same as reference) – Evaluated hypothesis

-

- Returns:

-

components – Dictionary where keys are component names and values are component

values - Return type:

-

dict

-

class

pyannote.metrics.diarization.DiarizationErrorRate(collar=0.0, skip_overlap=False, **kwargs)[source]¶ -

Diarization error rate

First, the optimal mapping between reference and hypothesis labels

is obtained using the Hungarian algorithm. Then, the actual diarization

error rate is computed as the identification error rate with each hypothesis

label translated into the corresponding reference label.- Parameters:

-

-

collar (float, optional) – Duration (in seconds) of collars removed from evaluation around

boundaries of reference segments. -

skip_overlap (bool, optional) – Set to True to not evaluate overlap regions.

Defaults to False (i.e. keep overlap regions). -

Usage –

-

—— –

-

Diarization error rate between reference and hypothesis annotations (*) –

>>> metric = DiarizationErrorRate() >>> reference = Annotation(...) >>> hypothesis = Annotation(...) >>> value = metric(reference, hypothesis)

-

Compute global diarization error rate and confidence interval (*) –

over multiple documents

>>> for reference, hypothesis in ... ... metric(reference, hypothesis) >>> global_value = abs(metric) >>> mean, (lower, upper) = metric.confidence_interval()

-

Get diarization error rate detailed components (*) –

>>> components = metric(reference, hypothesis, detailed=True) #doctest +SKIP

-

Get accumulated components (*) –

>>> components = metric[:] >>> metric['confusion']

-

See also

pyannote.metric.base.BaseMetric-

details on accumulation

pyannote.metric.identification.IdentificationErrorRate-

identification error rate

-

compute_components(reference, hypothesis, uem=None, **kwargs)[source]¶ -

- Parameters:

-

-

collar (float, optional) – Override self.collar

-

skip_overlap (bool, optional) – Override self.skip_overlap

-

See also

pyannote.metric.diarization.DiarizationErrorRate,two()

-

optimal_mapping(reference, hypothesis, uem=None)[source]¶ -

Optimal label mapping

- Parameters:

-

-

reference (Annotation) –

-

hypothesis (Annotation) – Reference and hypothesis diarization

-

uem (Timeline) – Evaluation map

-

- Returns:

-

mapping – Mapping between hypothesis (key) and reference (value) labels

- Return type:

-

dict

-

class

pyannote.metrics.diarization.DiarizationHomogeneity(collar=0.0, skip_overlap=False, **kwargs)[source]¶ -

Cluster homogeneity

- Parameters:

-

-

collar (float, optional) – Duration (in seconds) of collars removed from evaluation around

boundaries of reference segments. -

skip_overlap (bool, optional) – Set to True to not evaluate overlap regions.

Defaults to False (i.e. keep overlap regions).

-

-

compute_components(reference, hypothesis, uem=None, **kwargs)[source]¶ -

Compute metric components

- Parameters:

-

-

reference (type depends on the metric) – Manual reference

-

hypothesis (same as reference) – Evaluated hypothesis

-

- Returns:

-

components – Dictionary where keys are component names and values are component

values - Return type:

-

dict

-

compute_metric(detail)[source]¶ -

Compute metric value from computed components

- Parameters:

-

components (dict) – Dictionary where keys are components names and values are component

values - Returns:

-

value – Metric value

- Return type:

-

type depends on the metric

-

class

pyannote.metrics.diarization.DiarizationPurity(collar=0.0, skip_overlap=False, weighted=True, **kwargs)[source]¶ -

Cluster purity

A hypothesized annotation has perfect purity if all of its labels overlap

only segments which are members of a single reference label.- Parameters:

-

-

weighted (bool, optional) – When True (default), each cluster is weighted by its overall duration.

-

collar (float, optional) – Duration (in seconds) of collars removed from evaluation around

boundaries of reference segments. -

skip_overlap (bool, optional) – Set to True to not evaluate overlap regions.

Defaults to False (i.e. keep overlap regions).

-

-

compute_components(reference, hypothesis, uem=None, **kwargs)[source]¶ -

Compute metric components

- Parameters:

-

-

reference (type depends on the metric) – Manual reference

-

hypothesis (same as reference) – Evaluated hypothesis

-

- Returns:

-

components – Dictionary where keys are component names and values are component

values - Return type:

-

dict

-

compute_metric(detail)[source]¶ -

Compute metric value from computed components

- Parameters:

-

components (dict) – Dictionary where keys are components names and values are component

values - Returns:

-

value – Metric value

- Return type:

-

type depends on the metric

-

class

pyannote.metrics.diarization.DiarizationPurityCoverageFMeasure(collar=0.0, skip_overlap=False, weighted=True, beta=1.0, **kwargs)[source]¶ -

Compute diarization purity and coverage, and return their F-score.

- Parameters:

-

-

weighted (bool, optional) – When True (default), each cluster/class is weighted by its overall

duration. -

collar (float, optional) – Duration (in seconds) of collars removed from evaluation around

boundaries of reference segments. -

skip_overlap (bool, optional) – Set to True to not evaluate overlap regions.

Defaults to False (i.e. keep overlap regions). -

beta (float, optional) – When beta > 1, greater importance is given to coverage.

When beta < 1, greater importance is given to purity.

Defaults to 1.

-

See also

pyannote.metrics.diarization.DiarizationPurity,pyannote.metrics.diarization.DiarizationCoverage,pyannote.metrics.base.f_measure-

compute_components(reference, hypothesis, uem=None, **kwargs)[source]¶ -

Compute metric components

- Parameters:

-

-

reference (type depends on the metric) – Manual reference

-

hypothesis (same as reference) – Evaluated hypothesis

-

- Returns:

-

components – Dictionary where keys are component names and values are component

values - Return type:

-

dict

-

compute_metric(detail)[source]¶ -

Compute metric value from computed components

- Parameters:

-

components (dict) – Dictionary where keys are components names and values are component

values - Returns:

-

value – Metric value

- Return type:

-

type depends on the metric

-

class

pyannote.metrics.diarization.GreedyDiarizationErrorRate(collar=0.0, skip_overlap=False, **kwargs)[source]¶ -

Greedy diarization error rate

First, the greedy mapping between reference and hypothesis labels is

obtained. Then, the actual diarization error rate is computed as the

identification error rate with each hypothesis label translated into the

corresponding reference label.- Parameters:

-

-

collar (float, optional) – Duration (in seconds) of collars removed from evaluation around

boundaries of reference segments. -

skip_overlap (bool, optional) – Set to True to not evaluate overlap regions.

Defaults to False (i.e. keep overlap regions). -

Usage –

-

—— –

-

Greedy diarization error rate between reference and hypothesis annotations (*) –

>>> metric = GreedyDiarizationErrorRate() >>> reference = Annotation(...) >>> hypothesis = Annotation(...) >>> value = metric(reference, hypothesis)

-

Compute global greedy diarization error rate and confidence interval (*) –

over multiple documents

>>> for reference, hypothesis in ... ... metric(reference, hypothesis) >>> global_value = abs(metric) >>> mean, (lower, upper) = metric.confidence_interval()

-

Get greedy diarization error rate detailed components (*) –

>>> components = metric(reference, hypothesis, detailed=True) #doctest +SKIP

-

Get accumulated components (*) –

>>> components = metric[:] >>> metric['confusion']

-

See also

pyannote.metric.base.BaseMetric-

details on accumulation

-

compute_components(reference, hypothesis, uem=None, **kwargs)[source]¶ -

- Parameters:

-

-

collar (float, optional) – Override self.collar

-

skip_overlap (bool, optional) – Override self.skip_overlap

-

See also

pyannote.metric.diarization.DiarizationErrorRate,two()

-

greedy_mapping(reference, hypothesis, uem=None)[source]¶ -

Greedy label mapping

- Parameters:

-

-

reference (Annotation) –

-

hypothesis (Annotation) – Reference and hypothesis diarization

-

uem (Timeline) – Evaluation map

-

- Returns:

-

mapping – Mapping between hypothesis (key) and reference (value) labels

- Return type:

-

dict

-

class

pyannote.metrics.diarization.JaccardErrorRate(collar=0.0, skip_overlap=False, **kwargs)[source]¶ -

Jaccard error rate

Second DIHARD Challenge Evaluation Plan. Version 1.1

N. Ryant, K. Church, C. Cieri, A. Cristia, J. Du, S. Ganapathy, M. Liberman

https://coml.lscp.ens.fr/dihard/2019/second_dihard_eval_plan_v1.1.pdf“The Jaccard error rate is based on the Jaccard index, a similarity measure

used to evaluate the output of image segmentation systems. An optimal

mapping between reference and system speakers is determined and for each

pair the Jaccard index is computed. The Jaccard error rate is then defined

as 1 minus the average of these scores. While similar to DER, it weights

every speaker’s contribution equally, regardless of how much speech they

actually produced.More concretely, assume we have N reference speakers and M system speakers.

An optimal mapping between speakers is determined using the Hungarian

algorithm so that each reference speaker is paired with at most one system

speaker and each system speaker with at most one reference speaker. Then,

for each reference speaker ref the speaker-specific Jaccard error rate

JERref is computed as JERref = (FA + MISS) / TOTAL where-

TOTAL is the duration of the union of reference and system speaker

segments; if the reference speaker was not paired with a system

speaker, it is the duration of all reference speaker segments

* FA is the total system speaker time not attributed to the reference

speaker; if the reference speaker was not paired with a system speaker,

it is 0

* MISS is the total reference speaker time not attributed to the system

speaker; if the reference speaker was not paired with a system speaker,

it is equal to TOTALThe Jaccard error rate then is the average of the speaker specific Jaccard

error rates.JER and DER are highly correlated with JER typically being higher,

especially in recordings where one or more speakers is particularly

dominant. Where it tends to track DER is in outliers where the diarization

is especially bad, resulting in one or more unmapped system speakers whose

speech is not then penalized. In these cases, where DER can easily exceed

500%, JER will never exceed 100% and may be far lower if the reference

speakers are handled correctly.”- Parameters:

-

-

collar (float, optional) – Duration (in seconds) of collars removed from evaluation around

boundaries of reference segments. -

skip_overlap (bool, optional) – Set to True to not evaluate overlap regions.

Defaults to False (i.e. keep overlap regions). -

Usage –

-

—— –

-

metric = JaccardErrorRate() (>>>) –

-

reference = Annotation(..) # doctest (>>>) –

-

hypothesis = Annotation(..) # doctest (>>>) –

-

jer = metric(reference, hypothesis) # doctest (>>>) –

-

-

compute_components(reference, hypothesis, uem=None, **kwargs)[source]¶ -

- Parameters:

-

-

collar (float, optional) – Override self.collar

-

skip_overlap (bool, optional) – Override self.skip_overlap

-

See also

pyannote.metric.diarization.DiarizationErrorRate,two()

-

compute_metric(detail)[source]¶ -

Compute metric value from computed components

- Parameters:

-

components (dict) – Dictionary where keys are components names and values are component

values - Returns:

-

value – Metric value

- Return type:

-

type depends on the metric

-

-

class

pyannote.metrics.matcher.LabelMatcher[source]¶ -

ID matcher base class.

All ID matcher classes must inherit from this class and implement

.match() – ie return True if two IDs match and False

otherwise.-

match(rlabel, hlabel)[source]¶ -

- Parameters:

-

-

rlabel – Reference label

-

hlabel – Hypothesis label

-

- Returns:

-

match – True if labels match, False otherwise.

- Return type:

-

bool

-

Identification¶

In case prior speaker models are available, the speech turn clustering module may be followed by a supervised speaker recognition module for cluster-wise supervised classification.

pyannote.metrics also provides a collection of evaluation metrics for this identification task. This includes precision, recall, and identification error rate (IER):

[text{IER} = frac{text{false alarm} + text{missed detection} + text{confusion}}{text{total}}]

which is similar to the diarization error rate (DER) introduced previously, except that the (texttt{confusion}) term is computed directly by comparing reference and hypothesis labels, and does not rely on a prior one-to-one matching.

-

class

pyannote.metrics.identification.IdentificationErrorRate(confusion=1.0, miss=1.0, false_alarm=1.0, collar=0.0, skip_overlap=False, **kwargs)[source]¶ -

Identification error rate

ier = (wc x confusion + wf x false_alarm + wm x miss) / total- where

-

-

confusion is the total confusion duration in seconds

-

false_alarm is the total hypothesis duration where there are

-

miss is

-

total is the total duration of all tracks

-

wc, wf and wm are optional weights (default to 1)

-

- Parameters:

-

-

collar (float, optional) – Duration (in seconds) of collars removed from evaluation around

boundaries of reference segments. -

skip_overlap (bool, optional) – Set to True to not evaluate overlap regions.

Defaults to False (i.e. keep overlap regions). -

miss, false_alarm (confusion,) – Optional weights for confusion, miss and false alarm respectively.

Default to 1. (no weight)

-

-

compute_components(reference, hypothesis, uem=None, collar=None, skip_overlap=None, **kwargs)[source]¶ -

- Parameters:

-

-

collar (float, optional) – Override self.collar

-

skip_overlap (bool, optional) – Override self.skip_overlap

-

See also

pyannote.metric.diarization.DiarizationErrorRate,two()

-

compute_metric(detail)[source]¶ -

Compute metric value from computed components

- Parameters:

-

components (dict) – Dictionary where keys are components names and values are component

values - Returns:

-

value – Metric value

- Return type:

-

type depends on the metric

-

class

pyannote.metrics.identification.IdentificationPrecision(collar=0.0, skip_overlap=False, **kwargs)[source]¶ -

Identification Precision

- Parameters:

-

-

collar (float, optional) – Duration (in seconds) of collars removed from evaluation around

boundaries of reference segments. -

skip_overlap (bool, optional) – Set to True to not evaluate overlap regions.

Defaults to False (i.e. keep overlap regions).

-

-

compute_components(reference, hypothesis, uem=None, **kwargs)[source]¶ -

Compute metric components

- Parameters:

-

-

reference (type depends on the metric) – Manual reference

-

hypothesis (same as reference) – Evaluated hypothesis

-

- Returns:

-

components – Dictionary where keys are component names and values are component

values - Return type:

-

dict

-

class

pyannote.metrics.identification.IdentificationRecall(collar=0.0, skip_overlap=False, **kwargs)[source]¶ -

Identification Recall

- Parameters:

-

-

collar (float, optional) – Duration (in seconds) of collars removed from evaluation around

boundaries of reference segments. -

skip_overlap (bool, optional) – Set to True to not evaluate overlap regions.

Defaults to False (i.e. keep overlap regions).

-

-

compute_components(reference, hypothesis, uem=None, **kwargs)[source]¶ -

Compute metric components

- Parameters:

-

-

reference (type depends on the metric) – Manual reference

-

hypothesis (same as reference) – Evaluated hypothesis

-

- Returns:

-

components – Dictionary where keys are component names and values are component

values - Return type:

-

dict

Error analysis¶

-

class

pyannote.metrics.errors.identification.IdentificationErrorAnalysis(collar=0.0, skip_overlap=False)[source]¶ -

- Parameters:

-

-

collar (float, optional) – Duration (in seconds) of collars removed from evaluation around

boundaries of reference segments. -

skip_overlap (bool, optional) – Set to True to not evaluate overlap regions.

Defaults to False (i.e. keep overlap regions).

-

-

difference(reference, hypothesis, uem=None, uemified=False)[source]¶ -

Get error analysis as Annotation

Labels are (status, reference_label, hypothesis_label) tuples.

status is either ‘correct’, ‘confusion’, ‘missed detection’ or

‘false alarm’.

reference_label is None in case of ‘false alarm’.

hypothesis_label is None in case of ‘missed detection’.- Parameters:

-

uemified (bool, optional) – Returns “uemified” version of reference and hypothesis.

Defaults to False. - Returns:

-

errors

- Return type:

-

Annotation

Plots¶

-

pyannote.metrics.plot.binary_classification.plot_det_curve(y_true, scores, save_to, distances=False, dpi=150)[source]¶ -

DET curve

- This function will create (and overwrite) the following files:

-

-

{save_to}.det.png

-

{save_to}.det.eps

-

{save_to}.det.txt

-

- Parameters:

-

-

y_true ((n_samples, ) array-like) – Boolean reference.

-

scores ((n_samples, ) array-like) – Predicted score.

-

save_to (str) – Files path prefix.

-

distances (boolean, optional) – When True, indicate that scores are actually distances

-

dpi (int, optional) – Resolution of .png file. Defaults to 150.

-

- Returns:

-

eer – Equal error rate

- Return type:

-

float

-

pyannote.metrics.plot.binary_classification.plot_distributions(y_true, scores, save_to, xlim=None, nbins=100, ymax=3.0, dpi=150)[source]¶ -

Scores distributions

- This function will create (and overwrite) the following files:

-

-

{save_to}.scores.png

-

{save_to}.scores.eps

-

- Parameters:

-

-

y_true ((n_samples, ) array-like) – Boolean reference.

-

scores ((n_samples, ) array-like) – Predicted score.

-

save_to (str) – Files path prefix

-

-

pyannote.metrics.plot.binary_classification.plot_precision_recall_curve(y_true, scores, save_to, distances=False, dpi=150)[source]¶ -

Precision/recall curve

- This function will create (and overwrite) the following files:

-

-

{save_to}.precision_recall.png

-

{save_to}.precision_recall.eps

-

{save_to}.precision_recall.txt

-

- Parameters:

-

-

y_true ((n_samples, ) array-like) – Boolean reference.

-

scores ((n_samples, ) array-like) – Predicted score.

-

save_to (str) – Files path prefix.

-

distances (boolean, optional) – When True, indicate that scores are actually distances

-

dpi (int, optional) – Resolution of .png file. Defaults to 150.

-

- Returns:

-

auc – Area under precision/recall curve

- Return type:

-

float

- Авторы

- Резюме

- Файлы

- Ключевые слова

- Литература

Рогов А.А.

1

Петров Е.А.

1

1 Петрозаводский государственный университет

В последнее время возрос интерес к задаче разделения дикторов на фонограмме – известной как «who spoke when». Решение данной задачи востребовано в таких областях, как распознавание речи и поиск дикторов на аудиозаписи. В статье представлен обзор свободно распространяемого программного обеспечения, применяемого для решения задач разделения дикторов на фонограмме. Рассмотрен критерий оценки эффективности работы систем разделения дикторов – Diarization Error Rate, предложенный национальным институтом стандартов и технологий США. Проведено тестирование систем разделения дикторов на нескольких фонограммах: шесть из корпуса NIST2008-ENG и одна сторонняя фонограмма, подготовлена в соответствии с рекомендациями NIST. Тестирование проводилось в условиях отсутствия информации о количестве дикторов на аудиозаписи и об их личности. Результаты тестирования представлены в статье. Оценка качества работы систем осуществлялась с помощью сценария, предоставляемого NIST. В ходе тестирования лучшие результаты показала система LIUM. Представлены результаты тестирования работы LIUM с применением различного количества акустических признаков MFCC от 13 до 19.

фонограмма

речь

сегмент

кластеризация

диктор

LUIM

AudioSeg

ELIS

DiarTK

DER

1. Кудашев О.Ю. Система разделения дикторов на основе вероятностного линейного дискриминантного анализа. дис. … канд. техн. наук. – СПб.: Санкт-Петербургский нац. исслед. ун-т. Информационных технологий механики и оптики, 2014. – 158 с.

2. Gravier G., Betser M., Ben M. audioseg: Audio Segmentation Toolkit, release 1.2., IRISA, january 2010.

3. Rouvier M., Dupuy G., Gay P., Khoury E., Mer lin T., Meignier S. An Open-source State-of-the-art Toolbox for Broadcast News Diarization, Interspeech, Lyon (France), 25-29 Aug. 2013.

4. Vandecatseye A., Martens J.P. A fast, accurate and stream-based speaker segmentation and clustering algorithm, Proceeding Eurospeech (Geneva), 941–944.

5. Vijayasenan D., Valente F., Bourlard H. An Information Theoretic Combination of MFCC and TDOA Features for Speaker Diarization, in: IEEE Transactions on Audio Speech and Language Processing, 19(2), 2011.

6. Vijayasenan D., Valente F. DiarTk: An open source toolkit for research in multistream speaker diarization and its application to meetings recordings, in Proceedings of Interspeech, Portland, Oregon (USA), 2012.

7. Meignier S., Merlin T. LIUM SpkDiarization: an open source toolkit for diarization, in CMU SPUD Workshop, Dallas, Texas (USA), March 2010.

8. EAST: The ELIS Audio Segmentation Tool | DSSP – ELIS – UGent [Электронный ресурс]. – Режим доступа:http://dssp.elis.ugent.be/download/audio-segmentation-software (дата обращения:05.04.2015).

9. HTK Speech Recognition Toolkit. [Электронный ресурс]. – Режим доступа: http://htk.eng.cam.ac.uk/download.shtml (дата обращения:05.04.2015).

10. InriaForge: AudioSeg: Project Home.[Электронный ресурс]. – Режим доступа: https://gforge.inria.fr/projects/audioseg/ (дата обращения:05.04.2015).

11. InriaForge: SPro: Project Home. [Электронный ресурс]. – Режим доступа: http://gforge.inria.fr/projects/spro (дата обращения:05.04.2015).

12. LIUM Speaker Diarization Wiki. Download. [Электронный ресурс]. – Режим доступа: http://www-lium.univ-lemans.fr/diarization/doku.php/download (дата обращения:05.04.2015).

13. LIUM Speaker Diarization Wiki. [Электронный ресурс]. – Режим доступа: http://www-lium.univ-lemans.fr/diarization/doku.php. (дата обращения:05.04.2015).

14. NIST, «The 2009 (RT-09) Rich Transcription Meeting Recognition Evaluation Plan» [Электронный ресурс]. – Режим доступа: http://www.itl.nist.gov/iad/mig/tests/rt/2009/docs/rt09-meeting-eval-plan-v2.pdf (дата обращения:05.04.2015).

15. NIST Rich Transcription Evaluation Project. [Электронный ресурс]. – Режим доступа: http://www.itl.nist.gov/iad/mig/tests/rt/. (дата обращения:05.04.2015).

16. Speaker Diarization Toolkit. Idiap Research Institute. [Электронный ресурс]. – Режим доступа: http://www.idiap.ch/scientific-research/resources/speaker-diarization-toolkit (дата обращения:05.04.2015).

17. md-eval-v21.pl [Электронный ресурс]. – Режим доступа: http://www.itl.nist.gov/iad/mig/tests/rt/2006-spring/code/md-eval-v21.pl (дата обращения:05.04.2015).

Среди множества различных задач по обработке речи можно выделить отдельное направление – задачу разделения дикторов на фонограмме. В зарубежных источниках она формулируется как «who spoke when» [5]. Она состоит в выделении речевых сегментов фонограммы и кластеризации выделенных сегментов по принадлежности к одному диктору. Решение данной задачи востребовано в различных областях человеческой деятельности. Например, в системах аннотирования, которые добавляют к речевым аудиофайлам различные метаданные, такие как временная разметка границ фраз, информация о говорящем и др. В системах автоматического распознавания речи сегментация речи дикторов используется для адаптации моделей к речи пользователя, что повышает точность распознавания речи.

Уже более десяти лет идет активное исследование в области разделения дикторов на фонограмме. Как показывают исследования, подходы и методы, используемые для решения данной задачи, сильно зависят от области применения, условий постановки и решения задачи. Одними из наиболее сложных условий для решения данной задачи являются частая смена дикторов, отсутствие какой-либо априорной информации о количестве дикторов на фонограмме и отсутствие информации о личности дикторов, образцах их голоса и даже пола. Существует большое количество публикаций в российских и зарубежных научных журналах, в которых представлены различные методы и алгоритмы применяемые для решения задач разделения дикторов на фонограмме в разных условиях. Однако в публикациях отсутствует полная информация о представленных алгоритмах, а также не указываются ссылки на разработанные авторами программные продукты. В связи с этим зачастую невозможно быстро воспользоваться наработками, выполненными другими исследователями, для оценки работоспособности разработанных и представленных ими методов на собственных данных, а также для дальнейшего использования их в собственных исследованиях.

Целью данной статьи является создание обзора свободно распространяемых программных продуктов и библиотек, предназначенных для организации систем разделения дикторов, а также проведение апробирования рассмотренных систем на реальных данных.

LIUM

Первым рассмотрим продукт LIUM_SpkDiarization [13]. Он разработан на основе более раннего проекта mClust, написанного на языке C++ в 2005 году [3]. Первая публичная версия LIUM была представлена в 2010 году на конференции 2010 Sphinx Workshop [7]. В отличие от своего предшественника проект LIUM был перенесен на JAVA платформу для минимизации различных проблем при переходе от одной операционной системы к другой и для большей совместимости с различными библиотеками. LIUM_SpkDiarization распространяется как единый JAR архив, который может быть запущен без необходимости использования сторонних приложений [13]. Он включает в себя полный набор инструментов для быстрого создания простых систем разделения дикторов на основе аудиофайлов. На официальном сайте проекта [13] говорится, что данный набор утилит позволяет производить расчет MFCC признаков, содержит детекторы речевой активности и различные методы сегментации и кластеризации речи.

Для создания более сложных систем разделения дикторов можно воспользоваться исходными кодами системы LIUM, которые можно скачать с официального сайта проекта [12] и доработать их для решения поставленной задачи. LIUM является свободно распространяемым программным продуктом и распространяется по лицензии GPL. Единственное условие, которое выдвигают разработчики, – это указывать в публикациях ссылку на проект LIUM, если в работе использовались библиотеки или исходные коды LIUM. С официального сайта проекта [12] можно скачать BASH сценарий, который реализует простую систему разделения дикторов на фонограмме, созданную на основе LIUM. Данная система диаризации дикторов позволяет обрабатывать файлы в формате Wave или Sphere (16 kHz/16 bit PCM моно).

AudioSeg

AudioSeg [10] – набор утилит, распространяемых по лицензии GPL, разработанный в 2005 году, последняя версия пакета вышла в 2012 году [2]. Он включает в себя инструменты для реализации различных компонентов системы разделения диктора на фонограмме. Данный набор утилит написан на языке C и распространяется в виде исходных кодов. Программное обеспечение можно скачать с сайта разработчиков [10], после чего его необходимо скомпилировать на Вашем компьютере. Кроме исходных кодов программ, разработчики предоставляют программные библиотеки для языка C. На основе данных библиотек можно реализовать компоненты системы разделения дикторов, однако функционал этих библиотек ограничен. Например, такие функции, предоставляемые audioseg, как обнаружение тишины и Витерби декодирование, не включены в С библиотеки.

При работе с аудиофайлами система использует акустические признаки MFCC, однако в набор утилит Audioseg не входят инструменты для построения акустических признаков на основе аудиофайла. Для этого используется сторонняя свободно распространяемая утилита Spro версии 4.0 или выше, которую необходимо скачать с сайта разработчиков [11] и скомпилировать. Более подробную информацию о процессе установки системы Audioseg можно найти в официальной документации проекта [2]. Утилиты, входящие в пакет AudioSeg, позволяют обрабатывать аудиофайлы в формате Wave (16 kHz/16 bit PCM моно) а также (A-Law или Mu-Law 8 bit моно).

ELIS

ELIST [8] – утилита, которая позволяет производить сегментацию дикторов на аудиозаписях WAVE формата 16 kHz/16 bit моно или стерео. Данное программное обеспечение разработано в университете Гента в Бельгии. Оно распространяется в виде уже скомпилированной утилиты под 64-битную платформу Windows и Linux.

Для того чтобы получить утилиту, необходимо написать письмо разработчикам, в ответ вам вышлют файл с лицензионным соглашением который требуется заполнить, распечатать, подписать и отправить скан-копию подписанного файла разработчикам, после чего вам вышлют архив с программой. По условиям лицензии в случае использования утилиты необходимо ссылаться на публикацию разработчиков [4]. Утилита настраивается через конфигурационный файл, который содержит очень ограниченный набор настроек. Например, в него входят такие параметры, как минимальная длительность речевого сегмента и минимальная длительность неречевого сегмента.

DiarTK

DiarTK [6] набор утилит, позволяющий производить сегментацию речи дикторов на аудиозаписях, последняя версия вышла в 2012 году. Набор утилит DiarTK написан на языке C++ и распространяется по лицензии GPL, его можно скачать с сайта разработчиков [16]. Он распространяется в виде архива с исходным кодом, который необходимо скомпилировать на вашем компьютере. DiarTK использует функции из пакета утилит MathLab, поэтому необходимо чтобы MathLab был установлен на компьютере. Вместе с программным обеспечением пользователю предоставляются три примера готовых систем разделения дикторов, созданных на основе набора утилит DiarTk.

При работе с аудиофайлами система использует акустические признаки, MFCC, а также может дополнительно использовать такие признаки как Time Delay of Arrivals(TDOA) и Frequency Domain Linear Prediction (FDLP)/Modulation Spectrum(MS). Однако в пакете утилит DiarTk отсутствуют инструменты для генерации этих признаков. Система предполагает использование готовых файлов с признаками в стандарте HTK. Для генерации файлов HTK стандарта можно воспользоваться свободно распространяемым набором утилит [9]. В работе [6] представлено более детальное описание алгоритмов и методов решения задачи разделения дикторов используемых DiarTk.

Критерий оценки систем разделения дикторов на фонограмме

Для оценки эффективности работы систем разделения дикторов на фонограмме существует несколько методик. Одна из существующих методик разработана национальным институтом стандартов и технологий США (National Institute of Standards and Technology, NIST). Она описывается в проекте «Rich Transcription Evaluation Project» [15], одной из задач которого является задача «Metadata Extraction Speaker Diarization Task».

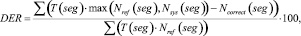

В соответствии с этой методикой мерой оценки эффективности систем разделения дикторов на фонограмме выступает величина DER (Diarization Error Rate) (1), которая рассчитывается по формуле

где T(seg) – длительность речевого сегмента seg; Nref(seg) – количество дикторов, голос которых присутствует на речевом сегменте seg в соответствии с эталонной разметкой; Nsys(seg) – количество дикторов, голос которых присутствует на речевом сегменте seg в соответствии с результатом работы оцениваемой системы; Ncorrect(seg) – количество верно отнесенных к речевому сегменту seg дикторов.

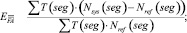

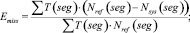

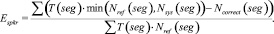

Величина DER является суммой трех ошибок: ошибка ложного детектирования речи EFA (2), ошибка ложного пропуска речи Emiss (3) и ошибка разделения дикторов Espkr (4). Автор работы [1] отмечает, что первые два вида ошибок относятся к оценке качества работы систем детектирования речевой активности, третья составляющая используется именно для сравнения систем разделения дикторов. Следует отметить, что, кроме представленной выше методики существуют и другие способы оценки систем диаризации, эффективность которых еще исследуется.

Подготовка и проведение экспериментов

Суть экспериментов заключается в тестировании свободно распространяемых систем разделения дикторов на реальных данных и оценке качества их работы с помощью критерия DER. В качестве тестовых данных для экспериментов использовались шесть аудиофайлов из корпуса NIST2008-ENG: ENG_fabrl.wav, ENG_fadxy.wav, ENG_fafgm.wav, ENG_fafrk.wav, ENG_fagru.wav, ENG_faicw.wav. Формат файлов Wav 16 бит, частота дискретизации 11,025 кГц, для каждого файла имеется текстовый файл с эталонной разметкой в формате RTTM. В связи с тем, что часть систем разделения дикторов требуют использовать файлы с частотой дискретизации 16 кГц, с помощью утилиты ffmpeg исходные аудиофайлы были перекодированы в файлы с частотой дискретизации 16 кГц. В список файлов для тестирования был добавлен еще один аудиофайл формата Wav, для которого в соответствии с рекомендациями NIST [14] был создан специальный файл ключевой разметки.

Для оценки качества работы систем разделения дикторов использовался сценарий на языке Perl md-eval-v21.pl [17], который предоставляется NIST. Он позволяет рассчитывать значения DER на основе двух файлов в формате RTTM, файла эталонной разметки и файла разметки, которую формирует система разделения дикторов. Каждая из рассматриваемых систем разделения дикторов сохраняет результаты своей работы в текстовых файлах своего собственного формата, поэтому были написаны Python сценарии перевода файлов в файлы, соответствующие формату RTTM.

На основе алгоритмов, предложенных автором диссертационной работы [1], разработано платное программное обеспечение, осуществляющее разделение дикторов на фонограмме. После того как мы обратились к автору работы [1], он предоставил нам результаты тестирования своей системы на 6 аудиофайлах корпуса NIST2008-ENG, для сравнения результатов работы свободно распространяемых систем.

Нами было проведено тестирование систем разделения дикторов на файлах из корпуса NIST2008-ENG. Система разделения дикторов на основе LIUM по неустановленным причинам не смогла обработать два аудиофайла: ENG_fadxy.wav, ENG_fagru.wav. В ходе выполнения процесс разделения дикторов зависал и переставал отвечать. Система ELIS некорректно обработала файл, взятый не из корпуса. Произвести тестирование системы DiarTK не удалось. При запуске тестирования она зависала или завершалась с ошибкой. Было написано письмо разработчикам системы с просьбой более подробно описать алгоритм запуска системы и алгоритм подготовки исходных данных для тестирования. Авторы не ответили.

Результаты тестирования представлены в табл. 1. В ней отображены средние значения ошибок для соответствующей системы. Отдельно в табл. 2 вынесены результаты тестирования систем на аудиофайле, взятом не из корпуса.

Таблица 1

Результаты тестирования систем на файлах из корпуса NIST2008-ENG

|

Система |

EFA |

Emiss |

Espkr |

DER |

|

LIUM |

40 |

0,05 |

11,8 |

51,85 |

|

AudioSeg |

47,51 |

0,32 |

41,1 |

88,93 |

|

ELIS |

29,78 |

2,37 |

36,5 |

68,65 |

|

система [1][6] |

8,56 |

39,1 |

2,17 |

49,83 |

Таблица 2

Результаты тестирования систем на файле, взятом не из корпуса

|

Система |

EFA |

Emiss |

Espkr |

DER |

|

LIUM |

18,1 |

0 |

30,6 |

48,7 |

|

AudioSeg |

18,1 |

0 |

82 |

100,1 |

Из табл. 1 и 2 видно, что наименьшую ошибку из протестированных систем дала система разделения дикторов на основе LIUM. По умолчанию система разделения дикторов на основе LIUM использует в качестве акустических признаков 13 MFCC, были проведены опыты с применением различного количества признаков от 13 до 19. В табл. 3 представлены результаты работы системы со стандартным количеством признаков MFCC и результаты, давшие минимальную ошибку.

Таблица 3

Результаты тестирования LIUM с различным количеством MFCC

|

Файл |

MFCC |

EFA |

Emiss |

Espkr |

DER |

|

ENG_fafrk |

13 |

27,7 |

0 |

9,0 |

36,7 |

|

ENG_fafrk |

16 |

27,7 |

0 |

11,6 |

39,3 |

|

ENG_fabrl |

13 |

46,3 |

0 |

23,0 |

69,3 |

|

ENG_fabrl |

14 |

46,3 |

0 |

23,5 |

69,8 |

|

ENG_fafgm |

13 |

33,1 |

0 |

8,7 |

41,8 |

|

ENG_fafgm |

16 |

33,1 |

0 |

6,3 |

39,4 |

|

ENG_faicw |

13 |

52,9 |

0 |

6,5 |

59,4 |

|

ENG_faicw |

17,18,19 |

52,9 |

0 |

3,8 |

56,7 |

|

Файл не из корпуса |

13 |

18,1 |

0 |

30,6 |

48,7 |

|

Файл не из корпуса |

19 |

18,1 |

0 |

19,9 |

38 |

Выводы

Рассмотрены и представлены свободно распространяемые программные продукты для организации систем разделения дикторов. В ходе тестирования наилучшие результаты показали система разделения дикторов, созданная на основе алгоритмов [1], а также система разделения дикторов на основе LIUM. Однако, учитывая, что тестирование систем проводилось с использованием настроек по умолчанию, однозначно выделить наиболее удачные системы разделения дикторов нельзя. Заметим, что суммарная длительность аудиоданных, на которых проводилось тестирование, была недостаточной для окончательных выводов о работоспособности систем – всего 30 минут. Обычно тесты систем проводятся на аудиоданных суммарной длительностью более нескольких часов.

Работа выполнена при финансовой поддержке Программы стратегического развития ПетрГУ в рамках реализации комплекса мероприятий по развитию научно-исследовательской деятельности.

Рецензенты:

Колесников Г.Н., д.т.н., профессор, зав. кафедрой общетехнических дисциплин, Институт лесных, инженерных и строительных наук, Петрозаводский государственный университет, г. Петрозаводск;

Печников А.А., д.т.н., доцент, ведущий научный сотрудник, Институт прикладных математических исследований, Карельский научный центр РАН, г. Петрозаводск.

Библиографическая ссылка

Рогов А.А., Петров Е.А. АНАЛИЗ СУЩЕСТВУЮЩИХ СВОБОДНО РАСПРОСТРАНЯЕМЫХ СИСТЕМ РАЗДЕЛЕНИЯ ДИКТОРОВ НА ФОНОГРАММЕ // Фундаментальные исследования. – 2015. – № 6-1.

– С. 67-72;

URL: https://fundamental-research.ru/ru/article/view?id=38395 (дата обращения: 09.02.2023).

Предлагаем вашему вниманию журналы, издающиеся в издательстве «Академия Естествознания»

(Высокий импакт-фактор РИНЦ, тематика журналов охватывает все научные направления)

Время прочтения

11 мин

Просмотры 8.8K

Привет, Хабр. Я бы хотел рассказать об одном из подходов в решении задачи диаризации дикторов и показать, как этот метод можно реализовать на языке python. Чтобы не отпугивать читателя, я не буду приводить сложные математические формулы (отчасти потому что я и сам «не настоящий сварщик»), а постараюсь изложить всё простым языком и рассказать всё так, чтобы понял разработчик, никогда прежде не сталкивавшийся с машинным обучением.

Готовясь написать эту статью, я выбирал между двумя вариантами изложения: для тех, кто уже знаком с Data Science и тех, кто просто хорошо программирует. В итоге я выбрал второй вариант, решив, что это будет неплохой демонстрацией возможностей DS.

Постановка задачи

Как говорит нам Википедия, диаризация — это процесс разделения входящего аудиопотока на однородные сегменты в соответствии с принадлежностью аудиопотока тому или иному говорящему. Иными словами, запись нужно разделить на кусочки и пронумеровать: вот в этих местах говорит один человек, а вот в этих другой. С точки зрения машинного обучения, подобного рода задачи принадлежат к классу обучения без учителя и называются кластеризацией. О том, какие методы кластеризации существуют можно почитать например здесь или здесь, я же рассажу только о тех, которые нам пригодятся — это Гауссова Смесь Распределений (Gaussian Mixture Model) и Спектральная Кластеризация (Spectral Clustering). Но о них чуть позже.

Начнём с самого начала.

Подготовка окружения

Спойлер

Не был уверен, стоит ли оставлять этот раздел — не хотелось превращать статью в совсем уж туториал. Но в итоге оставил. Кому не нужно, тот пропустит, а тем, кто будет делать всё с нуля, этот шаг облегчит старт.

Вообще говоря, помимо R, язык python является основным при решении задач Data Science, и если вы еще не пробовали программировать на нём, то я очень рекомендую это сделать, потому что python позволяет сделать многие вещи изящно, буквально в несколько строк (кстати, есть даже такой мем).

Существуют две отдельно развивающиеся ветки питона — версии 2 и 3. В моих примерах я использовал версию 3.6, но при желании их легко можно портировать на версию 2.7. Любую из этих веток удобно разворачивать вместе с инсталятором Анаконда, установив который вы сразу же получите интерактивную оболочку для разработки — IPython.

Помимо самой среды разработки понадобятся дополнительные библиотеки: librosa (для работы с аудио и извлечением признаков), webrtcvad (для сегментации) и pickle (для записи обученных моделей в файл). Все они устанавливаются простой командой в Anaconda Prompt

pip install [library]Feature Extraction

Начнём с извлечения признаков — данных, с которыми будут работать модели машинного обучения. В принципе, звуковой сигнал сам по себе — это уже данные, а именно упорядоченный массив значений амплитуды звука, к которому добавляется заголовок, содержащий количество каналов, частоту дискретизации и прочую информацию. Но анализировать эти данные напрямую мы не сможем, поскольку они не содержат таких вещей, глядя на которые, наша модель может сказать — ага, вот эти куски принадлежат одному и тому же человеку.

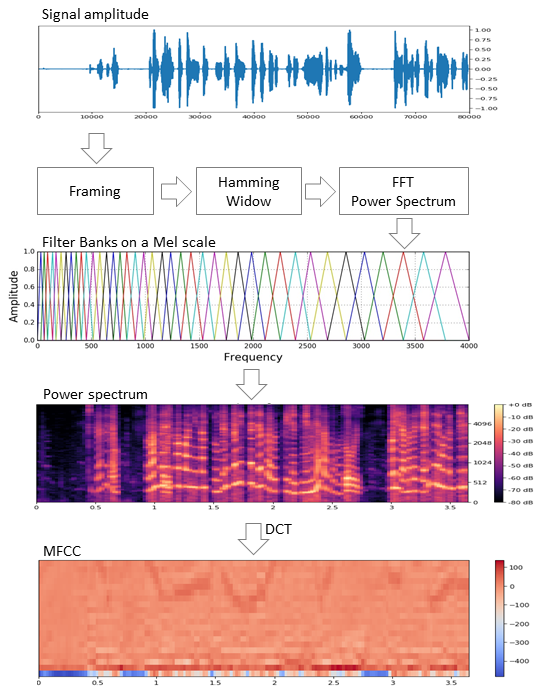

В задачах обработки речи существует несколько подходов к извлечению признаков. Одним из них является получение мел-частотных кепстральных коэффициентов (Mel Frequency Cepstral Coefficients). О них здесь уже писали, поэтому я лишь слегка напомню.

Исходный сигнал нарезают на фреймы длиной 16-40 мс. Далее, применив к фрейму окно Хемминга, делают быстрое преобразование Фурье и получают спектральную плотность мощности. Затем специальной «гребёнкой» фильтров, расположенных равномерно по мел-шкале делают мел-спектрограмму, к которой применяют дискретное косинусное преобразование (DCT) — широко используемый алгоритм сжатия данных. Полученные таким образом коэффициенты представляют из себя некую сжатую характеристику фрейма, при этом, поскольку фильтры, которые мы применяли, расположены были в мел-шкале, коэффициенты несут больше информации в диапазоне восприятия человеческого уха. Как правило, используют от 13 до 25 MFCC на фрейм. Поскольку помимо самого спектра индивидуальность голоса формируется скоростью и ускорениями, MFCC комбинируют с первой и второй производными.

Вообще, MFCC — это самый распространённый вариант работы с речью, но помимо них существуют и другие признаки — LPC (Linear Predictive Coding) и PLP (Perceptual Linear Prediction), а еще иногда можно встретить LFCC, где вместо мел-шкалы используется линейная.

Посмотрим, как извлечь MFCC в python.

import numpy as np

import librosa

mfcc=librosa.feature.mfcc(y=y, sr=sr,

hop_length=int(hop_seconds*sr),

n_fft=int(window_seconds*sr),

n_mfcc=n_mfcc)

mfcc_delta=librosa.feature.delta(mfcc)

mfcc_delta2=librosa.feature.delta(mfcc, order=2)

stacked=np.vstack((mfcc, mfcc_delta, mfcc_delta2))

features=stacked.T #librosa возвращает где MFCC идут в ряд, а для модели нужно будет в столбец.

Как видим, делается это действительно всего в несколько строк. Теперь перейдём к первому алгоритму кластеризации.

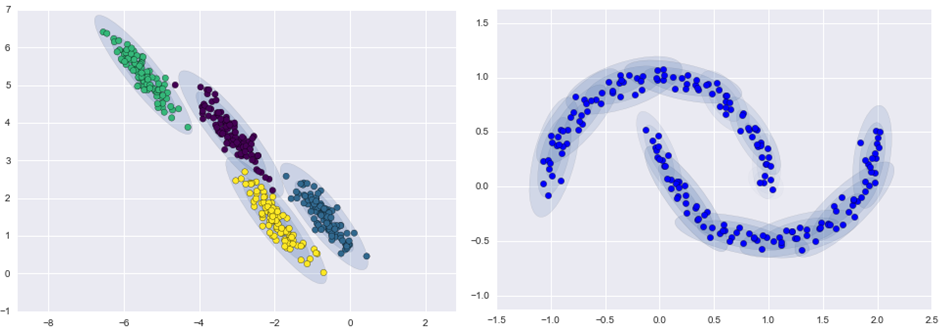

Gaussian Mixture Model

Модель смеси Гауссовых распределений предполагает что наши данные — это смесь многомерных распределений Гаусса с определёнными параметрами.

При желании можно легко найти и детальное описание модели и как работает EM-алгоритм, обучающий эту модель, я же обещал не наводить тоску сложными формулами и поэтому покажу красивые примеры из этой статьи.

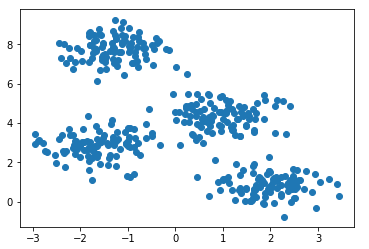

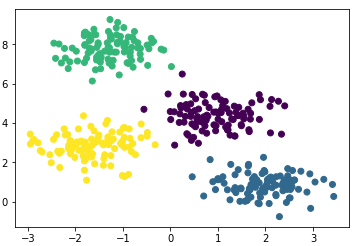

Сгенерируем четыре кластера и нарисуем их.

from sklearn.datasets.samples_generator import make_blobs

X, y_true=make_blobs(n_samples=400, centers=4,

cluster_std=0.60, random_state=0)

plt.scatter(X[:, 0], X[:, 1]);

Создадим модель, обучим на наших данных и снова отрисуем точки но уже с учётом предсказанной моделью принадлежности к кластерам.

from sklearn.mixture import GaussianMixture

gmm = GaussianMixture(n_components=4)

gmm.fit(X)

labels=gmm.predict(X)

plt.scatter(X[:, 0], X[:, 1], c=labels, s=40, cmap='viridis');

Модель неплохо справилась с искусственными данными. В принципе, регулируя число компонент смеси и тип матрицы ковариаций (число степеней свободы гауссиан), можно описывать достаточно сложные данные.

Итак, мы знаем как делать параметризацию данных и умеем обучать модель смеси гауссовых распределений. Теперь можно было бы попробовать сделать кластеризацию в лоб — обучая GMM на извлеченных из диалога MFCC. И, наверное, в каком-то идеальном сферически-вакуумном диалоге, в котором каждый диктор будет укладываться в свою гауссиану, мы получим хороший результат. Понятное дело, что в реальности такого никогда не будет. На самом деле с помощью GMM моделируют не диалог, а каждого человека в диалоге — т. е. представляют, что голос каждого диктора в извлечённых признаках описывается своим набором гауссиан.

Подытоживая, мы потихоньку подбираемся к основной теме.

Сегментация

Традиционно процесс диаризации состоит из трёх последовательных блоков — обнаружение речи (Voice Activity Detection), сегментация и кластеризация (есть модели, в которых последние два шага совмещены, см. LIA E-HMM).

В первом шаге происходит отделение речи от различного рода шумов. Алгоритм VAD определяет является ли поданный на него кусок аудиозаписи речью, или это, например, звучит сирена или кто-то чихнул. Понятное дело, что для того, чтобы такой алгоритм был качественным необходимо обучение с учителем. А это в свою очередь означает, что необходимо размечать данные — иными словами создавать базу данных с записями речи и всевозможных шумов. Мы поступим лениво — возьмём готовый VAD, который работает не идеально, но для начала нам хватит.

Второй блок нарезает данные с речью на сегменты с одним активным говорящим. Классическим подходом в этом плане является алгоритм определения смены диктора на основе байесовского информационного критерия — BIC. Суть этого метода заключается в следующем — скользящим окном проходятся по аудиозаписи и в каждой точке прохода отвечают на вопрос: «Как данные в этом месте лучше описываются — одним распределением или двумя?». Для ответа на этот вопрос вычисляется параметр , исходя из знака которого принимается решение о смене диктора. Проблема в том, что этот метод будет работать не очень хорошо в случае частой смены диктора, да еще в присутствии шумов (которые очень характерны для записи телефонного разговора).

Небольшое пояснение

В оригинале я работал с записями телефонных разговоров кол-центра средней продолжительностью около 4-х минут. По понятным причинам эти записи я выложить не могу, поэтому для демонстрации я взял запись интервью с одной радиостанции. В случае с длинным интервью этот метод возможно дал бы приемлемый результат, но на моих данных он не сработал.

В условиях, когда дикторы друг друга не перебивают, и их голоса не накладываются друг на друга, VAD, который мы будем использовать, более менее справляется с задачей сегментации, поэтому первые два шага у нас будут выглядеть следующим образом.

#читаем сигнал

y_, sr = librosa.load('data/2018-08-26-beseda-1616.mp3', sr=SR)

#первым шагом делаем pre-emphasis: усиление высоких частот

pre_emphasis = 0.97

y = np.append(y[0], y[1:] - pre_emphasis * y[:-1])

#все что ниже фактически взято с гитхаба webrtcvad с небольшими изменениями

vad = webrtcvad.Vad(2) # агрессивность VAD

audio = np.int16(y/np.max(np.abs(y)) * 32767)

frames = frame_generator(10, audio, sr)

frames = list(frames)

segments = vad_collector(sr, 50, 200, vad, frames)