RSS

Use the vmkfstools command to check or repair a virtual disk if it gets corrupted.

-x|--fix [check|repair]

For example,

vmkfstools -x check /vmfs/volumes/my_datastore/my_disk.vmdk

check-circle-line

exclamation-circle-line

close-line

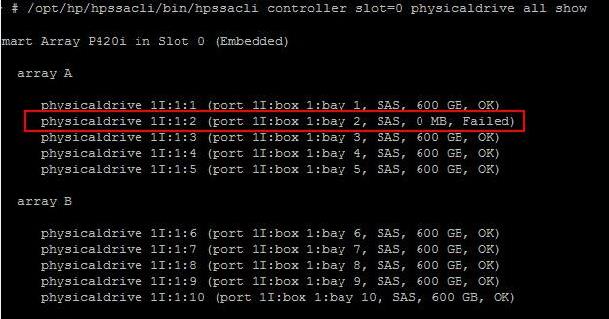

You would have come across a lot of instances of hard disk failures of your physical servers. It is necessary to identify the exact disk which is failed on the server. It can be easliy checked using hardware managenet tools like HP system Management, HP ILO or even in Hardware status tab of ESXi host from vSphere Client. This post talks about the checking the status of disk failures for esxi host command line utilities. In this post, i am going to discuss about the HP hardware’s and how to check the disk failures from command line in Hp hardware’s. This post will guide you step by step procedure to verify the disk status in ESXi host using HPSSACLI utility which is part of HP ESXi Utilities Offline bundle for VMware ESXi 5.x.

HP ESXi Utilities Offline bundle for VMware ESXi 5.x will be available as part of HP customized ESXi installer image but if it is not a HP customized ESXi image then you may need to download and install HP ESXi Utilities Offline bundle for VMware ESXi 5.x.This ZIP file contains 3 different utilities HPONCFG , HPBOOTCFG and HPSSACLI utilities for remote online configuration of servers.

- HPONCFG — Command line utility used for obtaining and setting ProLiant iLO configurations.

- HPBOOTCFG — Command line utility used for configuring ProLiant server boot order.

- HPSSACLI – Command line utility used for configuration and diagnostics of ProLiant server SmartArrays.

You can download and install HP ESXi utilities offline bundle for ESXi 5.X using below command

esxcli software vib install -f -v /tmp/hp-esxi5.5uX-bundle-1.7-13.zip

You can even directly donwload HPSSACLI utility and Upload the VIB file into your ESXi host and execute the below command to install the HPACUCLI utility.

esxcli software vib install -f -v /tmp/hpssacli-1.60.17.0-5.5.0.vib

Once it is installed. Browse towards the directory /opt/hp/hpssacli/bin and verify the installation.

Check the Disk Failure Status:

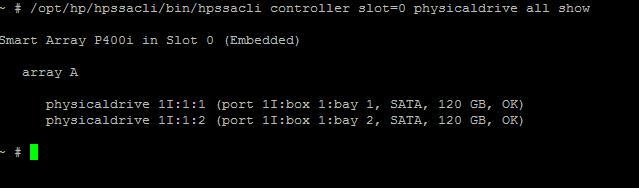

Type the below command to check the status of Disks in your ESXi host. It displays the status of the Disk in All Arrays under the Controller.

/opt/hp/hpssacli/bin/hpssacli controller slot=0 physicaldrive all show

17 Replies

-

Is this on a SAN/NAS or a local disk on the ESXi Server?

Was this post helpful?

thumb_up

thumb_down

-

Jaguar

This person is a verified professional.

Verify your account

to enable IT peers to see that you are a professional.habanero

What’s running this ESXi Host?

Was this post helpful?

thumb_up

thumb_down

-

ACTS360 is an IT service provider.

poblano

This is on a local RAID array on the ESXi server.

Was this post helpful?

thumb_up

thumb_down

-

ACTS360 is an IT service provider.

poblano

ESXi is running on a dell power edge 2950 server.

Was this post helpful?

thumb_up

thumb_down

-

Replicate your data and replace your array. As far as I know, VMFS does it’s own housekeeping and there is no way to force a disk check on the VMFS level. An NTFS chkdisk will only be so effective. Because, as you said, it’s sitting on top of VMFS.

Whenever you suspect a bad block on disk in a production environment, it’s always better to replace first ask questions later.

And I would also advise to stay away from RAID 5 if that is what you are using currently:

RAID 5 vs RAID 10 Opens a new window

Was this post helpful?

thumb_up

thumb_down

-

ACTS360 is an IT service provider.

poblano

Wow….that seems very drastic…can I just replace a drive? Is there a way to tell which drive in the array has the bad block?

Was this post helpful?

thumb_up

thumb_down

-

Is the hardware under any type of warranty? If so, you can probably get it replaced on that error by talking to a support person. I’ve done it — as far as seeing which one is bad, you will need to go into the RAID controller software.

Was this post helpful?

thumb_up

thumb_down

-

ACTS360 is an IT service provider.

poblano

Yes, the server is under warranty. Ok, I’ll see if Dell will replace the drive. Thanks

Was this post helpful?

thumb_up

thumb_down

-

Wow….that seems very drastic…can I just replace a drive? Is there a way to tell which drive in the array has the bad block?

Doesn’t the server tell you where the error is when it tells you that there is an error?

Was this post helpful?

thumb_up

thumb_down

-

-

Scott does make a point. Can you not see from the health status in vCenter which disk? You still may need the OMSA to rebuild your array and it’s nice to have available.

Was this post helpful?

thumb_up

thumb_down

-

-

Jaguar

This person is a verified professional.

Verify your account

to enable IT peers to see that you are a professional.habanero

Scott Alan Miller wrote:

Josh@Acts360 wrote:

Wow….that seems very drastic…can I just replace a drive? Is there a way to tell which drive in the array has the bad block?

Doesn’t the server tell you where the error is when it tells you that there is an error?

ESXi should be able to tell you (Though I’ve got the «Dell customized» version of ESXi installed, you can get it of vmware’s site.

attach_file

Attachment

vcenterstorage.PNG

112 KB

Was this post helpful?

thumb_up

thumb_down

-

Yeah, Jaguar nailed it. You should, at minimum, be able to see the state of your storage in vCenter. At that point you can identify the drive. Having OMSA on your host just makes it easier to perform some of your functions, like storage configurations and changes, without having to reboot and go through the bios to get to it.

Was this post helpful?

thumb_up

thumb_down

-

ACTS360 is an IT service provider.

poblano

No Vcenter all I have is the free stuff. I can see some information listed. It actually shows that there is no problem with the system… I also have an ISCSI device connected so maybe that device is the one throwing the errors.

Oh, looks like that is it…I just looked and the event logs and I see the hard disk is disk 1 which points to the ISCSI disk. I updated the firmware on this device (which is a Synology disk station 1010+) and this fixed the issue with this device.

Log Name: System

Source: disk

Date: 9/17/2010 9:11:31 AM

Event ID: 51

Task Category: None

Level: Warning

Keywords: Classic

User: N/A

Computer: FBLDC.fbdomain.local

Description:

An error was detected on device DeviceHarddisk1DR4 during a paging operation.

Event Xml:

<Event xmlns=»http://schemas.microsoft.com/win/2004/08/events/event Opens a new window«>

<System>

<Provider Name=»disk» />

<EventID Qualifiers=»32772″>51</EventID>

<Level>3</Level>

<Task>0</Task>

<Keywords>0x80000000000000</Keywords>

<TimeCreated SystemTime=»2010-09-17T13:11:31.421Z» />

<EventRecordID>177451</EventRecordID>

<Channel>System</Channel>

<Computer>FBLDC.fbdomain.local</Computer>

<Security />

</System>

<EventData>

<Data>DeviceHarddisk1DR4</Data>

<Binary>030080000100000000000000330004802D0100000E0000C0000000000000000000000000000000006262170000000000FFFFFFFF010000005800002100000000BB20101242032040001000003C0000000000000000000000789BF70C80FAFFFF0000000000000000909B010A80FAFFFF0000000000000000E807640000000000880000000000006407E8000000080000000000000000000000000000000000000000000000000000</Binary>

</EventData>

</Event>attach_file

Attachment

VMWare.png

9.18 KB

Was this post helpful?

thumb_up

thumb_down

-

ACTS360 is an IT service provider.

poblano

Turns out that if I had just looked at the event log closer I would have noticed that the drive that the event refered to was pointing to my ISCSI, which was offline…

Was this post helpful?

thumb_up

thumb_down

-

Jaguar

This person is a verified professional.

Verify your account

to enable IT peers to see that you are a professional.habanero

should have said it was an iSCSI

Glad you got it fixed.

Was this post helpful?

thumb_up

thumb_down

The procedure below documents the commands necessary to run a check of the system partitions of ESXi. The below image shows the output of fdisk -l and the partitions which will be checked are circled. The 2 partitions consisting of 49136 blocks are the Hypervisor1 and Hypervisor2 partitions. These are mounted by ESXi as /bootbank and /altbootbank and store the firmware which ESXi boots with. A system backup file state.tgz (local.tgz for ESXi Embedded) is also stored on these partitions.

ESXi will read /bootbank when booting and then will backup it’s configuration once per hour. The last partition consisting of 552944 blocks is Hypervisor3 and is mounted as /store by ESXi. This partition is used to store items like download files for the VI client, VMware Tools ISOs for VMs, and configuration and system files for the vCenter Server agent and the HA agent.

The last partition circle first below will only exist with ESXi Installable. This partition is mounted as /scratch and is where ESXi will place the userworld swap file. This partition will correspond to the location set by the Advanced Setting: ScratchConfig.ConfiguredScratchLocation.

While not necessary for this procedure, you can use the commands esxcfg-vmhbadevs and ls to link the partitions shown by fdisk to the mounts ESXi has made to determine which partition is /altbootbank and which is /bootbank.

~ # esxcfg-vmhbadevs -f

[2009-03-19 01:19:03 ‘StorageInfo’ warning] Skipping dir: /vmfs/volumes/0451af74-f19fbb7e-e274-97e1e6858ec4. Cannot open volume: /vmfs/volumes/0451af74-f19fbb7e-e274-97e1e6858ec4

vmhba1:0:0:8 /vmfs/devices/disks/vmhba1:0:0:8 e0a264ee-3bc421b8-cdd5-3a5cb7c2a09f

vmhba1:0:0:2 /vmfs/devices/disks/vmhba1:0:0:2 488fb202-34873070-edd2-00096b63ac0a

vmhba1:0:0:5 /vmfs/devices/disks/vmhba1:0:0:5 9820ef76-fed75a33-f596-a0e3aa642c3a

~ # ls -l | grep vmfs

l——— 0 root root 1984 Jan 1 1970 altbootbank -> /vmfs/volumes/0451af74-f19fbb7e-e274-97e1e6858ec4

l——— 0 root root 1984 Jan 1 1970 bootbank -> /vmfs/volumes/9820ef76-fed75a33-f596-a0e3aa642c3a

l——— 0 root root 1984 Jan 1 1970 scratch -> /vmfs/volumes/488fb202-34873070-edd2-00096b63ac0a

l——— 0 root root 1984 Jan 1 1970 store -> /vmfs/volumes/e0a264ee-3bc421b8-cdd5-3a5cb7c2a09f

drwxr-xr-x 1 root root 512 Jan 9 02:35 vmfs

Once you have identified the partitions to check you can use the dosfsck command to check a partition. The command has a number of options, but you must at least specify the disk to check. The first example also includes the -v option with provides verbose output. The -a option will automatically try to correct any issues.

dosfsck -v /dev/disks/vmhba1:0:0:5 dosfsck 2.11 (12 Mar 2005) dosfsck 2.11, 12 Mar 2005, FAT32, LFN Checking we can access the last sector of the filesystem Boot sector contents: System ID "mkdosfs" Media byte 0xf8 (hard disk) 512 bytes per logical sector 1024 bytes per cluster 2 reserved sectors First FAT starts at byte 1024 (sector 2) 2 FATs, 16 bit entries 98304 bytes per FAT (= 192 sectors) Root directory starts at byte 197632 (sector 386) 512 root directory entries Data area starts at byte 214016 (sector 418) 48927 data clusters (50101248 bytes) 32 sectors/track, 64 heads 0 hidden sectors 98272 sectors total Checking for unused clusters. /dev/disks/vmhba1:0:0:5: 10 files, 37485/48927 clusters

You can also use the -V option to run a verification pass of a partition or the -t option to test for bad sectors (this also requires the -a (automatically repair) or -r (interactively repair) options).

dosfsck -t -r /dev/disks/vmhba1:0:0:2 dosfsck 2.11, 12 Mar 2005, FAT32, LFN Seek to 2147491840:Success dosfsck -V /dev/disks/vmhba1:0:0:2 dosfsck 2.11, 12 Mar 2005, FAT32, LFN Starting check/repair pass. Starting verification pass. /dev/disks/vmhba1:0:0:2: 8 files, 16390/65515 clusters

All the options for the command dosfsck are shown below.

dosfsck usage: dosfsck [-aAflrtvVwy] [-d path -d ...] [-u path -u ...] device -a automatically repair the file system -A toggle Atari file system format -d path drop that file -f salvage unused chains to files -l list path names -n no-op, check non-interactively without changing -r interactively repair the file system -t test for bad clusters -u path try to undelete that (non-directory) file -v verbose mode -V perform a verification pass -w write changes to disk immediately -y same as -a, for compat with other *fsck

-

Bits & Bytes

-

Virtualized Computing

You should upgrade or use an alternative browser.

ESXi chkdsk equivalent?

-

Thread starterZarathustra[H]

-

Start dateOct 4, 2012

-

#1

- Joined

- Oct 29, 2000

- Messages

- 35,491

Had an odd issue on my ESXi 5.1 server yesterday.

I had 4 guests running (Ubuntu 12.04 headless server, pfSense, Windows XP and Windows Vista.)

Suddenly performance became terrible. The client became mostly unresponsive, but would respond in fits and starts. I was able to reboot my Ubuntu guest, and upon boot it was complaining about read errors from /sda, which is just a standard vmware image file on my datastore. (an SSD where all my guest images are stored)

Uh oh, I thought, I must have a failing drive. At this point I had lost the ability to control the server via the Vsphere client and decided to reboot the server by either plugging in a keyboard locally and forcing a restart or just cutting power to it, and starting it back up again.

When the server started back up again, everything worked like normal again. There were no signs of the drive read issues I had had prior to the reboot. All of my guests, except my Vista guest, booted back up normally again.

My Vista guest on the other hand was borked.

The Vista boot loaded could not find an OS to boot, and booting from the Vista CD to do a repair did not help either. It’s like the Vista partition inside the Vmware image file just decided to empty itself.

So, not sure what caused all this, but I suspect a drive problem.

Is there a good way to run some sort of disk diagnostic on datastores within ESXi? How do I go about doing that?

Thanks,

Matt

-

#2

- Joined

- Nov 23, 2006

- Messages

- 9,157

-

#3

- Joined

- Oct 29, 2000

- Messages

- 35,491

Can you boot a linux cd and run a disk utility from it?

I could.

What file system does ESXi format it’s local drugstores in?

-

#4

- Joined

- Jun 1, 2002

- Messages

- 1,715

as a backup i would consider migrating the VM data ASAP and then doing HDD Tests with the Company Software you could use ESXtop to see if the drive is acting abnormally but i would also caution that if the drive is going bad and is causing data corruption the first key is to get those vms safe asap…

-

#5

- Joined

- Nov 9, 2005

- Messages

- 2,917

-

#6

- Joined

- Oct 11, 2001

- Messages

- 33,319

Run:

voma -m vmfs -f check -d /vmfs/volumes/NAA_OF_YOUR_DATASTORE:YOUR_PARTITION_NUMBER

Paste output here.

esxcfg-scsidevs -m will identify the naa -> datastorename mappings.

-

#7

- Joined

- Oct 29, 2000

- Messages

- 35,491

5.1?Run:

voma -m vmfs -f check -d /vmfs/volumes/NAA_OF_YOUR_DATASTORE:YOUR_PARTITION_NUMBERPaste output here.

esxcfg-scsidevs -m will identify the naa -> datastorename mappings.

Thank you.

I’ll try this.

While I am rather experienced in unix-like consoles, ESXi seems to have changed a lot, and I haven’t had the opportunity to play around in there yet.

-

#8

- Joined

- Jun 1, 2002

- Messages

- 1,715

-

#9

- Joined

- Oct 29, 2000

- Messages

- 35,491

5.1?Run:

voma -m vmfs -f check -d /vmfs/volumes/NAA_OF_YOUR_DATASTORE:YOUR_PARTITION_NUMBERPaste output here.

esxcfg-scsidevs -m will identify the naa -> datastorename mappings.

Question,

Do I have to enter Maintenance mode, or shut down my guests on the drive in order to do this, or can I run it with everything on?

-

#10

- Joined

- Jun 1, 2002

- Messages

- 1,715

VOMA is a new customer facing metadata consistency checker tool, which is run from the CLI of ESXi 5.1 hosts. It checks both the Logical Volume Manager (LVM) and VMFS for issues. It works on both VMFS-3 & VMFS-5 datastores. It runs in a check-only (read-only) mode and will not change any of the metadata. There are a number of very important guidelines around using the tool. For instance, VMFS volumes must not have any running VMs if you want to run VOMA. VOMA will check for this and will report back if there are any local and/or remote running VMs. The VMFS volumes can be mounted or unmounted when you run VOMA, but you should not analyze the VMFS volume if it is in use by other hosts.

If you find yourself in the unfortunately position that you suspect that you may have data corruption on your VMFS volume, prepare to do a restore from backup, or look to engage with a 3rd party data recovery organization if you do not have backups. VMware support will be able to help in diagnosing the severity of any suspected corruption issues, but they are under no obligation to recover your data.

I’m sure you will agree that this is indeed a very nice tool to have at your disposal.

See http://cormachogan.com/2012/09/04/vsphere-5-1-storage-enhancements-part-1-vmfs-5/

-

#11

- Joined

- Oct 11, 2001

- Messages

- 33,319

Zarathustra[H];1039205238 said:

Question,Do I have to enter Maintenance mode, or shut down my guests on the drive in order to do this, or can I run it with everything on?

All guests shut down > not. You’ll get a LOT of spurious messages if they’re up and running, but I know to discount those.

-

#12

- Joined

- Oct 11, 2001

- Messages

- 33,319

VOMA vSphere On-disk Metadata AnalyzerVOMA is a new customer facing metadata consistency checker tool, which is run from the CLI of ESXi 5.1 hosts. It checks both the Logical Volume Manager (LVM) and VMFS for issues. It works on both VMFS-3 & VMFS-5 datastores. It runs in a check-only (read-only) mode and will not change any of the metadata. There are a number of very important guidelines around using the tool. For instance, VMFS volumes must not have any running VMs if you want to run VOMA. VOMA will check for this and will report back if there are any local and/or remote running VMs. The VMFS volumes can be mounted or unmounted when you run VOMA, but you should not analyze the VMFS volume if it is in use by other hosts.

If you find yourself in the unfortunately position that you suspect that you may have data corruption on your VMFS volume, prepare to do a restore from backup, or look to engage with a 3rd party data recovery organization if you do not have backups. VMware support will be able to help in diagnosing the severity of any suspected corruption issues, but they are under no obligation to recover your data.

Im sure you will agree that this is indeed a very nice tool to have at your disposal.

See http://cormachogan.com/2012/09/04/vsphere-5-1-storage-enhancements-part-1-vmfs-5/

Forgot — we added the flag to only allow if quiesced.

-

#13

- Joined

- Oct 29, 2000

- Messages

- 35,491

Didn’t even need to look up NAA’s.

ESXi was kind enough to add a symlink with the configured datastore name in /vmfs/volumes pointing to it.

I am getting an error message when running this command though:

# voma -m vmfs -f check -d /vmfs/volumes/505d81bc-9505cd49-2010-6805ca018ab0

Checking if device is actively used by other hosts

ERROR: Failed to check for heartbeating hosts on device'/vmfs/volumes/505d81bc-9505cd49-2010-6805ca018ab0'Advice?

I have two drives in the system, and get the same error on both…

Thanks,

Matt

-

#14

- Joined

- Oct 29, 2000

- Messages

- 35,491

Zarathustra[H];1039268053 said:

Awesome.Didn’t even need to look up NAA’s.

ESXi was kind enough to add a symlink with the configured datastore name in /vmfs/volumes pointing to it.

I am getting an error message when running this command though:

# voma -m vmfs -f check -d /vmfs/volumes/505d81bc-9505cd49-2010-6805ca018ab0 Checking if device is actively used by other hosts ERROR: Failed to check for heartbeating hosts on device'/vmfs/volumes/505d81bc-9505cd49-2010-6805ca018ab0'Advice?

I have two drives in the system, and get the same error on both…

Thanks,

Matt

FWIW, Rebooting the server or entering maintenance mode does not appear to ahve any effect.

I get the same error message no matter what.

-

#15

- Joined

- Oct 11, 2001

- Messages

- 33,319

edit:

Oh, you’re running it on the uuid. You have to run it on /vmfs/devices/disks/naa:1

-

Bits & Bytes

-

Virtualized Computing

Обновлено 04.09.2016

Как мониторить SMART дисков, SSD в RAID на ESXI 5.5-01

Всем привет сегодня хочу поделиться своим опытом в мониторинге S.M.A.R.T дисков, SSD в RAID на ESXI 5.5. Немного скучной теории но без нее ни куда. Современные жесткие диски довольно “умные” устройства и, кроме основных присущих им как устройствам хранения и обработки данных свойств, поддерживают технологию самотестирования, анализа состояния, и накопления статистических данных об ухудшении собственных характеристик S.M.A.R.T. (Self-Monitoring Analysis and Reporting Technology). Основы S.M.A.R.T. были разработаны в 1995 г. совместными усилиями ведущих производителями жестких дисков (HDD). В последующие годы стандарты S.M.A.R.T дорабатывались в соответствии с изменениями технологий и оборудования ( SMART II и SMART III) и продолжают совершенствоваться в настоящее время.

Жесткий диск, начиная с момента его изготовления, постоянно отслеживает определенные параметры своего состояния и отражает их в специальных характеристиках — атрибутах (Attribute), сохраняющихся в постоянном запоминающем устройстве , как правило, в специально выделенной части дисковой поверхности, доступной только внутренней микропрограмме накопителя — служебной зоне. Данные атрибутов могут быть прочитаны, в соответствии со спецификацией ATA (AT Attachment ) по командам поддержки SMART (SMART READ DATA и еще более десятка команд), которые передаются в накопитель специальным программным обеспечением, как например, утилитами от производителей оборудования или универсальными программами тестирования и мониторинга состояния HDD (udisks, smartctl, GSmartControl, gnome-disks и т.п.). Современные стандарты ATA включают в себя поддержку протокола SCT (SMART Command Transport), обеспечивающего считывание журналов статистики устройства. Журнал статистики устройства — это доступный только для чтения журнал SMART, передаваемый накопителем при получении команд READ LOG EXT, READ LOG DMA EXT или SMART READ LOG.

Атрибут представляет собой характеристику определенного состояния жесткого диска, которая изменяется в процессе эксплуатации, принимая числовое значение от максимального, установленного в момент изготовления данного устройства, до минимального, при достижении которого, работоспособность накопителя не гарантируется. Все атрибуты идентифицируются своим цифровым номером, большинство из которых одинаково интерпретируется жесткими дисками разных моделей. Некоторые из них могут использоваться только конкретным производителем оборудования, и поддерживаться отдельными моделями накопителей. Так, например, атрибут с идентификатором 7, характеризующий количество ошибок установки головок на требуемую дорожку поверхности диска Seek_Error_Rate не имеет смысла для твердотельных дисков ( SSD ) и, соответственно, не поддерживается ими, а атрибут с идентификатором 9,характеризующий суммарное время работы накопителя за весь срок эксплуатации и обозначаемый как Power_On_Hours,поддерживается как SSD, так и традиционными HDD.

Атрибуты состоят из нескольких полей, ( наиболее часто обозначаемых как Val, Worst, Tresh, RAW), каждое из которых является определенным показателем, характеризующим техническое состояние накопителя на данный момент времени. Программы считывания S.M.A.R.T. выводят содержимое атрибутов, как правило, в виде нескольких колонок :

- ID# — числовой идентификатор атрибута

- Attribute — название атрибута

- Flags — флаги атрибутов, задаваемые производителем HDD. Характеризуют тип атрибута ( большинство программ интерпретируют флаги в виде символов k,c,r,s,o,p или аббревиатур, например, EC – Event Count, счетчик событий ).Pre-Failure (PF, 01h) — при достижении порогового значения данного типа атрибутов диск требует замены. Иногда данный бит флагов обозначают какLife Critical (CR) или Pre-Failure warranty (PW)

Online test (OC, 02h)– атрибут обновляет значение при выполнении off-line/on-line встроенных тестов SMART;

Perfomance Related (PE или PR , 04h)– атрибут характеризует производительность ;

Error Rate (ER , 08h )– атрибут отражает счетчики ошибок оборудования;

Event Counts (EC, 10h ) – атрибут представляет собой счетчик событий;

Self Preserving (SP, 20h ) – самосохраняющися атрибут;

Некоторые из программ могут интерпретировать флаги в виде текстовых описаний, близких по смыслу к рассмотренным выше. Один атрибут может иметь несколько установленных в единицу значений флагов, например, атрибут с идентификатором 05 отражающий количество переназначенных из-за сбоев секторов из резервной области, имеет установленные флаги SP+EC+OC – самосохраняющийся, счетчик событий, обновляется при автономном и интерактивном режиме накопителя. - Value — текущее значение атрибута

- Threshold — минимальное пороговое значения атрибута

- Worst — самое худшее значение атрибута за все время работы накопителя

- Raw — абсолютное значение атрибута

- Type — некоторые из программ в данном необязательном поле отображают информацию из флажков атрибутов или признаки их критичности (Criticalили Pre-Fail , отражающих ухудшение характеристик оборудования, и Old-age для атрибутов, отражающих выработку ресурса);Для анализа состояния накопителя, пожалуй самым важным значением атрибута является Value — условное число (обычно от 0 до 100 или до 253), заданное производителем. Значение Value изначально установлено на максимум при производстве накопителя и уменьшается в случае ухудшения его параметров. Для каждого атрибута существует пороговое значение, при достижения которого, производитель не гарантирует его работоспособность — поле Threshold. Если значение Value приближается или становится меньше значения Threshold, — накопитель пора менять.Перечень атрибутов и их значения жестко не стандартизированы и некоторые из них могут определяться изготовителем накопителя, но основная часть интерпретируются одинаково. Например, атрибут с идентификатором 05 (Reallocated sector count) будет характеризовать число забракованных и переназначенных из резервной области секторов диска, как для устройств производства компании Seagate Technology, так и для устройств производства Western Digital . Набор поддерживаемых атрибутов зависит от модели накопителя и может значительно отличаться по составу для разных моделей.

Если значение Value приближается или становится меньше значения Threshold, — накопитель пора менять

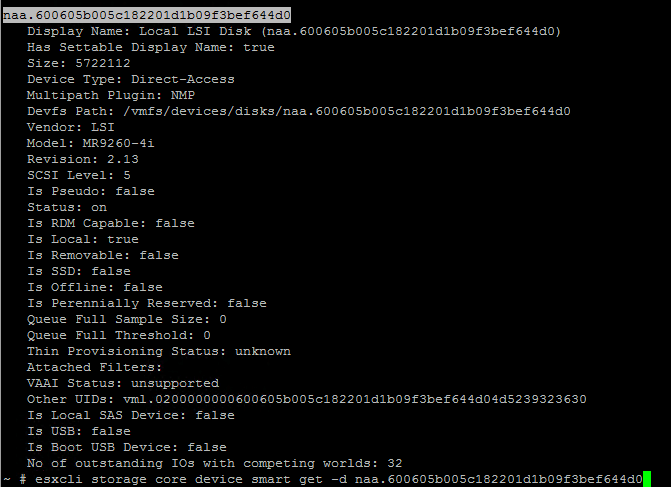

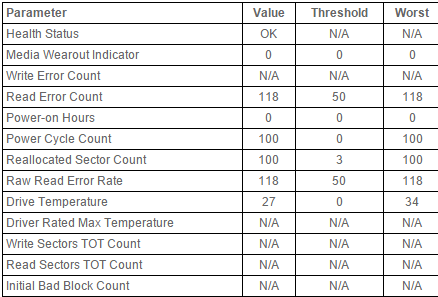

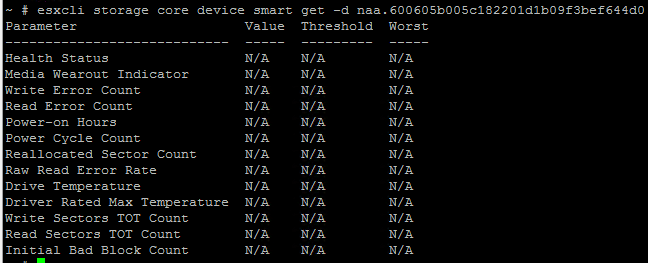

В нашем эксперименте будут 3 производителя контроллеров Adaptec, LSI, HP Smart Array. В ESXI есть отличная команда выводящая SMART дисков и SSD. Сначала посмотрим список ваших дисков и LUN.

esxcli storage core device list

Как мониторить SMART дисков, SSD в RAID на ESXI 5.5-001

Выводим SMART отдельного диска или LUN.

esxcli storage core device smart get -d имя

Если у вас отдельные диски на всех контроллерах Adaptec, LSI, HP Smart Array вы получите такую картину

Как мониторить SMART дисков, SSD в RAID на ESXI 5.5-02

Жирным выделены метрики, которые могут оказаться полезными. Параметр Reallocated Sector Count не должен сильно увеличиваться со временем для исправных дисков. Когда дисковая подсистема получает ошибку read/write/verification для сектора, она перемещает его данные в специально зарезервированную область (spare area), а данный счетчик увеличивается.

Media Wearout Indicator — это уровень «жизни» вашего SSD-диска (для новых дисков он должен отображаться как 100). По мере прохождения циклов перезаписи диск «изнашивается» и данный счетчик уменьшается, соответственно, когда он перейдет в значение 0 — его жизнь формально закончится, исходя из рассчитанного для него ресурса. Кстати, этот счетчик может временно уменьшаться при интенсивных нагрузках диска, а потом восстанавливаться со временем, если средняя нагрузка на диск снизилась.

Если у вас LUN с СХД или RAID LUN то нихера в консоли не получите этой командой.

Как мониторить SMART дисков, SSD в RAID на ESXI 5.5-04

И вопрос как мониторить SMART в RAID ESXI 5.5, очень просто каждый вендор делает свой CIM пакет, вот как его поставить для каждого вендора. (Adaptec, LSI, HP Smart Array). Так же можно мониторить Operation Manager 5.8.

Расшифровка атрибутов S.M.A.R.T

- Идентификаторы атрибутов указаны в десятичной системе счисления, а в скобках они же – в шестнадцатеричной.

- 001 ( 1h ) Raw Read Error Rate — абсолютное значение ошибок считывания. Существует некоторые отличия в формировании значения данного атрибута разными производителями. Из практики могу сказать, что накопители Seagate могут иметь гигантское значение RAW этого атрибута, реально будучи в хорошем состоянии, а накопители Western Digital могут иметь его нулевым, имея критические показатели по другим характеристикам. Некоторые модели вообще не поддерживают данный атрибут.

- 002 ( 02h ) Throughput Performance — усредненная производительность жесткого диска. Редко встречающийся атрибут.

- 003 ( 3h ) Spin Up Time — Среднее время раскрутки шпинделя диска от 0 RPM до рабочей скорости. Для SSD дисков не поддерживается.

- 004 ( 4h ) Start/Stop Count — Количество циклов запуск/останов шпинделя.

- 005 ( 5h ) Reallocated Sector Count — Количество переназначенных ( перераспределенных) секторов . Современные накопители имеют резервную область поверхности для использования ее объема в случае ухудшения характеристик блоков из основной зоны. Если микропрограмма накопителя обнаруживает ошибки с записи/чтения какого-либо блока рабочей поверхности, то запускается механизм, обеспечивающий переадресацию обращений к дефектному блоку ( сектору ), на блок из резервной части. Он автоматически перемещает его данные в резервную область, а данный блок помечается как «переназначенный». Часто этот процесс называют «remapping», или «automatic defect reassignment». Процедура переназначения сбойных секторов на резервные, выполняется автоматически внутренней микропрограммой накопителя, и для пользователя (операционной системы) она невидима. Сам факт переназначения и количество переназначенных секторов доступны только из журналов SMART. Поле абсолютного значения атрибута Raw Valueсодержит общее количество переназначенных секторов. Нормализованное значение Value отражает процент допустимого количества дефектных блоков. При исчерпании резервной области, переназначение становится невозможным и диск подлежит замене. Даже некритическое, но большое значение этого поля, может привести к снижению скорости обмена данными, поскольку накопитель выполняет дополнительные операции установки головок на дорожки резервной области, которая обычно находится в конце рабочей поверхности диска.

- 007 ( 7h ) Seek Error Rate — Частота появления ошибок позиционирования блока магнитных головок (БМГ) . Дисковые накопители контролирует правильность установки головок на требуемую дорожку поверхности. В случае, когда установка выполнилась неверно, фиксируется ошибка и операция повторяется. На практике, большое количество ошибок позиционирования может быть вызвано не только проблемами оборудования, но и влиянием внешних факторов – не соответствующим температурным режимом или вибрацией.

- 008 ( 8h ) Seek Time Performance — средняя скорость позиционирования магнитных головок. Если значение атрибута уменьшается (замедление позиционирования), то велика вероятность проблем с механической частью привода головок.

- 009 (09h) Power-On Hours (POH) Количество рабочих часов — количество часов, когда диск находился во включенном состоянии за весь срок с момента производства, в виде целочисленного значения в часах. Иногда встречаются модели накопителей, в которых внутреннее значение данного атрибута сохраняется в виде количества рабочих минут или секунд, а не часов. Достижение порогового значения данного атрибута означает выработку ресурса, заданного производителем ( MTBF — Mean Time Between Failures

- 010 ( 0Ah ) Spin Retry Count — Количество повторных попыток старта шпинделя. После включения питания, накопитель раскручивает диски и контролирует достижение рабочей скорости вращения, заданной производителем для данной модели . Если за отведенное контрольное время рабочая скорость не достигнута, увеличивается значение данного атрибута и выполняется повторная раскрутка двигателя.

- 011 ( 0B ) Recalibration Retries — атрибут отражает количество повторных рекалибровок, в случае, если первая попытка была неудачной. Если значение атрибута увеличивается, то велика вероятность проблем с механической частью накопителя. Кроме того, увеличение абсолютного значения данного атрибута может быть вызвано тем, что процедура рекалибровки используется внутренней микропрограммой накопителя для коррекции других типов ошибок.

- 012 ( 0Ch ) Device Power Cycle Count — абсолютное значение Raw Value указывает на количество циклов включения/выключения питания накопителя за весь период эксплуатации. Нормализованное значение Value обычно не изменяется и равно 100.

- 013 ( 0Dh ) — Soft Read Error Rate — Количество программных сбоев — совокупное количество программных сбоев. Нормализованное значение: начиная со 100, отображает процент оставшегося допустимого нарастающего количества программных сбоев.

- 100 ( 64h ) Erase/Program Cycles — количество циклов стирания –записи перепрограммируемой памяти (flash) для SSD-дисков. Количество таких циклов ограниченно и зависит от микросхем постоянной перезаписываемой памяти, используемых в данной модели SSD.

- 103 ( 67h ) Translation Table Rebuild — количество событий, связанных с разрушением внутренних таблиц транслятора и его перестроением.

- 170 ( AAh )Reserved Block Count — количество доступных резервных блоков для переназначения сбойных секторов (см. атрибут E8h).

- 171 ( ABh ) Program Fail Count — ошибки записи в перепрограммируемую память SSD

- 172 ( ACh ) Erase Fail Count – ошибки стирания flash-памяти SSD. Процесс записи в перезаписываемую постоянную память состоит из двух частей — стирания и записи. Процедура стирания всегда выполняется перед записью данных.

- 173 ( ADh ) Wear Leveller Worst Case Erase Count — максимально допустимое количество операций стирания для единичного блока SSD-диска.

- 174 ( AEh) Unexpected Power Loss — непредвиденное отключение питания для SSD . Также этот показатель называется «Количество аварийных выключений» в терминологии жестких дисков с магнитными носителями. Абсолютное значение Raw Value: совокупное количество нештатных выключений за весь срок использования устройства.

- 175 ( AFh ) Program Fail Count– данный атрибут используется в SSD-накопителях производства Intel и отображает информацию о сбоях защиты от отключения питания SSD-дисков. Результаты последнего теста в виде количества микросекунд до разряда конденсатора, фиксируется на максимальном значении. Также записывается количество минут после последнего теста и общее количество тестов за весь срок использования устройства. Необработанное значение Raw Value:Байты 0—1: Результаты последнего теста в виде количества микросекунд до разряда конденсатора, фиксируется на максимальном значении. Результат теста должен быть в диапазоне 25 — 5 000 000, более низкое значение указывает на определенный код ошибки. Байты 2—3: количество минут после последнего текста, фиксируется на максимальном значении. Байты 4—5: количество тестов за весь срок использования устройства, не увеличивается при циклах включения и отключения, фиксируется на максимальном значении. Значение Value устанавливается равным 1 при сбое теста, или 11 при тестировании конденсатора в недопустимых температурных условиях; в противном случае устанавливается равным 100.

- 183 ( B7h ) SATA Downshifts — Количество снижений скорости SATA Необработанное значение: количество случаев, когда из-за ошибок для интерфейса SATA была выбрана пониженная скорость передачи данных ( с 6 Гб/с до 3Гб/с или 1,5Гб/с или с 3Гб/с. До 1.5Гб/с. Очень часто данный атрибут характеризует недостаточное качество электропитания, окисление контактов интерфейсного кабеля, или его неисправность.

- 184 ( B8h ) End-to-End error Количество обнаруженных сквозных ошибок кэш-памяти ( disk cache). Абсолютное значение: количество обнаруженных и исправленных оборудованием сквозных ошибок.

- 187 ( BBh ) Reported Uncorrectable Errors Количество невосстановимых ошибок. Необработанное значение Raw Value: количество ошибок, которые не удалось исправить с помощью внутренних подпрограмм накопителя.

- 188 ( BCh ) Command Timeout — количество команд, прерванных по таймауту.

- 189 ( BDh ) High Fly Writes — количество событий, связанных с ошибками, зафиксированными монитором контроля высоты полета Fly Height Monitor, когда головки записи находятся в положении, не гарантирующем нормальное выполнение операции. Если высота полета головки над магнитной поверхностью, даже на короткое время превысит оптимальную, то записанные ею данные, в дальнейшем, могут не прочитаться. Современные накопители используют специально разработанную технологию контроля высоты полета головок, позволяющую не выполнять запись данных при неоптимальной высоте. В счетчик данного атрибута добавляется единица, а запись выполняется после установки нормальной высоты полета. Повышенное значение данного атрибута может быть вызвано внешними ударами или вибрациями, ненормальной температурой, ухудшением характеристик магнитной поверхности или головки.

- 190 ( BEh ) Airflow Temperature температура воздушного потока (корпус). Значение Raw Value: статистические данные по температуре корпуса .Байты 0—1: текущая температура корпуса в градусах по Цельсию; байт 2: недавняя минимальная температура корпуса в градусах по Цельсию; байт 3: недавняя максимальная температура корпуса в градусах по Цельсию; байты 4—5: счетчик превышений температуры. Количество случаев, когда зафиксированная температура превышала максимальную допустимую рабочую температуру накопителя.

- 191 ( BFh ) G-sense error rate — количество ошибок, возникающих в результате ударных нагрузок. Атрибут хранит показания встроенного акселерометра, который фиксирует все удары, толчки, падения и даже неаккуратную установку диска в корпус компьютера. Обычно довольно точно характеризует условия эксплуатации ноутбуков — большое значение атрибута говорит о резких толчках и падениях при работе устройства.

- 192 ( C0h ) Emergency Retract Cycle Count Количество аварийных выключений (количество нештатных выключений) — совокупное количество событий аварийного (нештатного) отключения питания за весь срок использования устройства. Для SSD дисков под «нештатным выключением» понимается отключение питания устройства без предварительной выдачи команды STANDBY IMMEDIATE.

- 194 ( C2h ) HDA Temperature — температура самого накопителя (HDA — Hard Disk Assembly). В данном атрибуте хранятся показания встроенного температурного датчика, которым обычно служит одна из магнитных головок (как правило — нижняя ). У SSD дисков термодатчик размещается внутри корпуса на печатной плате. Данные, записанные в полях атрибута отображают текущую, минимальную и максимальную температуру. Поле Worst показывает наихудшую, достигнутую за время работы накопителя, температуру (можно установить факт перегрева и его степень), Raw Value — текущую температуру. Некоторые модели накопителей могут поддерживать атрибут 205 ( CDh ) Thermal asperity rate (TAR), фиксирующий количество опасных перепадов температуры.

- 195 ( C3h ) Hardware ECC Recovered — количество ошибок считывания, исправленных оборудованием накопителя с применением кода коррекции ошибок. Подобные ошибки не требуют повторного считывания сектора, и не приводят к потере скорости обмена данными, но большое их количество говорит об ухудшении параметров тракта считывания.

- 196 ( C4h ) Reallocation Event Count — Число событий переназначения сбойных секторов. В поле raw value данного атрибута хранится общее число попыток переноса данных из нестабильных секторов в резервную область. Учитываются как успешные, так и неуспешные попытки.

- 197 ( C5 ) Current Pending Sector Count — Текущее количество нестабильных секторов. Поле raw value этого атрибута показывает общее количество секторов, которые накопитель в данный момент считает кандидатами на переназначение в резервную область . Если в дальнейшем какой-то из этих секторов будет прочитан успешно, то он исключается из списка кандидатов. Если же чтение сектора будет сопровождаться ошибками, то накопитель попытается восстановить данные и перенести их в резервную область, а сам сектор пометить как переназначенный (remapped).

- 198 ( C6 ) Uncorrectable Sector Count — Счетчик некорректируемых ошибок, т.е , счетчик ошибок, которые не были исправлены внутренними средствами коррекции оборудования накопителя. Это означает, что такие ошибки проявляются как классические сбойные блоки файловой системы ( Bad Block ). Причиной подобных сбоев диска, может быть неисправность отдельных элементов или отсутствие свободных секторов в резервной области диска, когда возникла необходимость переназначения.

- 199 ( C7h ) UltraDMA CRC Error Rate — Количество ошибок при передаче данных в режиме прямого доступа к памяти, обнаруженных средствами циклического избыточного кода (англ. Cyclic redundancy check, CRC). Аппаратные средства контроля передачи данных из накопителя в оперативную память обнаружили ошибку контрольной суммы и исправили ее “на лету”, если ошибка исправимая. В данном случае алгоритм обычной работы диска не изменяется. В случае же неисправимой ошибки, процедура ее обработки выполняется системой. Обычно, данный атрибут содержит счетчик любых видов ошибок CRC. Нередко этот тип ошибки связан не столько с оборудованием накопителя, сколько с неисправным интерфейсным кабелем, окислившимися контактами, некачественным электропитанием, разгоном частоты шины PCI, перегревом микросхем чипсета материнской платы и т.п.

- 200 ( C8h ) Write Error Rate (Multi Zone Error Rate) — ошибки записи данных.

- 232 ( E8h ) Total Count of Write Sectors Для SSD-дисков — количество записанных секторов. Значение Raw Value увеличивается на 1 на каждые 65 536 секторов (32 МБ), записываемых системой. Для SSD Intel — Intel SSD Available Reserved Space — процент доступной резервной области, используемой для переназначения дефектных блоков.

- 233 ( E9h ) Power-On Hours — Время работы накопителя. Для SSD-дисков этот атрибут интерпретируется как Remaining Life — указатель износа носителя. Количество циклов работы носителя NAND. Линейно снижается от 100 до 1 по мере увеличения среднего количества циклов стирания от 0 до максимального. Нормализованное значение перестанет уменьшаться после достижения 1, но, по всей вероятности, устройство выдержит значительный дополнительный износ.

- 241 ( F1h) Total LBAs Written — Общее количество записанных секторов LBA. Значение Raw Value : совокупное количество секторов, записанных системой. Значение увеличивается на 1 на каждые 65 536 секторов (32 МБ), записываемых системой.

- 242 ( F2h ) Total LBAs Read — Общее количество прочитанных секторов LBA. Значение Raw Value увеличивается на 1 на каждые 65 536 секторов (32 МБ), прочитываемых системой.

- 254 ( FEh ) Free Fall Event Count — количество событий ускорения свободного падения диска за время эксплуатации ( сколько раз диск падал ).

Оценка технического состояния жесткого диска по данным S.M.A.R.T

Набор атрибутов поддерживаемых конкретной моделью жесткого диска, даже если он минимален, позволяет с высокой достоверностью определить техническое состояние и перспективы эксплуатации устройства. Можно определить время нахождения во включенном состоянии по значению атрибута 9, а в совокупности со значением атрибута 12 — количество включений /выключений электропитания, и следовательно, – круглосуточный или периодический режим эксплуатации. Интенсивность использования, температурный режим, негативные внешние воздействия – все эти факты легко отслеживаются по абсолютным значениям соответствующих атрибутов. Подобным же образом, можно оценить и уровень износа оборудования, качество поверхности и тракта записи/чтения.

Минимально информативный контроль состояния дисков может выполняться даже на уровне BIOS. В случае достижения критического значения любого атрибута, характеризующего работоспособность, при включенном мониторинге состояния S.M.A.R.T в настройках BIOS, загрузка операционной системы приостанавливается и на экран выводится сообщение:

Primary Master Hard Disk: S.M.A.R.T status BAD!, Backup and Replace.

Press F1 to ResumeТаким образом, без установки или запуска дополнительного программного обеспечения, имеется возможность вовремя определить факт критического состояния накопителя средствами Базовой Системы Ввода-Вывода (BIOS) при включении компьютера.

Техническое состояние жесткого диска, не достигшее критического порога, характеризуется абсолютным значением атрибутов, отражающих счетчики сбоев, обнаруженных и исправленных оборудованием накопителя.

- 001 ( 1 ) Raw Read Error Rate — абсолютное значение ошибок считывания. Существует некоторые отличия в формировании значения данного атрибута разными производителями. На практике, накопители Seagate могут иметь гигантское значение RAW этого атрибута, реально будучи в хорошем состоянии, а накопители Western Digital могут иметь его нулевым, имея критические показатели по другим характеристикам. Некоторые модели вообще могут не поддерживать данный атрибут.

- 005 ( 5 ) Reallocated Sector Count — Количество переназначенных секторов. Ненулевое значение данного счетчика говорит о том, что были обнаружены дефектные блоки, данные которых перенесены в резервную область.

- 196 ( C4 ) Reallocation Event Count — Число событий переназначения сбойных секторов. В поле raw value данного атрибута хранится общее число попыток переноса данных из нестабильных секторов в резервную область. Учитываются как успешные, так и неуспешные попытки.

- 197 ( C5 ) Current Pending Sector Count — Текущее количество нестабильных секторов. Поле raw value этого атрибута показывает общее количество секторов, которые накопитель в данный момент считает кандидатами на переназначение в резервную область (remap). Если в дальнейшем какой-то из этих секторов будет прочитан успешно, то он исключается из списка кандидатов. Если же чтение сектора будет сопровождаться ошибками, то накопитель попытается восстановить данные и перенести их в резервную область, а сам сектор пометить как переназначенный (remapped). Если значение атрибутов 5,196,197 увеличивается за короткий промежуток времени ( дни, или даже часы), то это является настораживающим признаком – либо ухудшаются технические параметры самого накопителя, либо сказывается влияние внешних воздействий.

- 007 ( 07h ) Seek Error Rate — Частота появления ошибок позиционирования блока магнитных головок (БМГ). Большое значение говорит о проблемах механизма позиционирования, хотя может быть вызвано и внешними факторами, такими как перегрев или повышенная вибрация.

- 008 ( 08h ) Seek Time Performance — средняя скорость позиционирования магнитных головок. Если значение атрибута уменьшается (замедление позиционирования), то велика вероятность проблем с механической частью привода головок.

- 199 ( C7 ) UltraDMA CRC Error Count — Счетчик ошибок, возникших при передаче данных в режиме UltraDMA. Рост абсолютного значения указывает на проблемы при передаче данных контроллером диска в оперативную память. Чаще всего, вызвано плохим кабелем и нестабильным электропитание

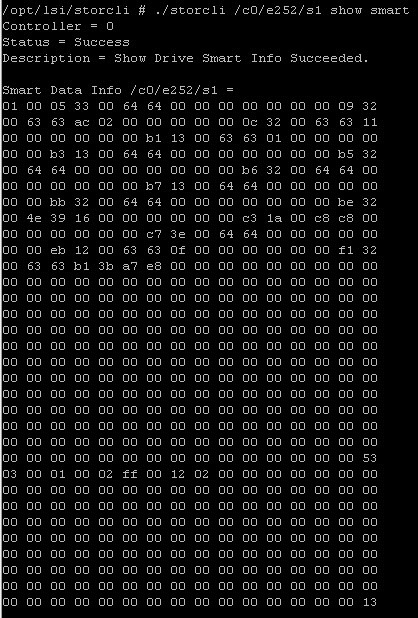

Обновление 11.12.2015

Недавно на тестирование попал RAID контроллер LSI 9361-8i, моделька свежая со всеми наворотами, но сейчас не об этом. Я так же на него установил Vmware ESXI 5.5 и захотел посмотреть дает ли контроллер S.M.A.R.T. Стандартными командами, он не отдал значения, пришлось установить storcli, после чего введя команду

./storcli /c0/e252/s1 show smart

Я получил smart дисков, но в таком не читабельном виде, что просто ужас 🙂 Как вам оно. Принципе если бы было описание полей или строк, все было бы куда более терпимо. Ну не понимаю я почему столько граблей, чтобы элементарно вытащить smart дисков. Как появится информация, что означает каждое поле отпишусь сюда.

Обновление 12.05.2016

Товарищи, хочу вас обрадовать, что появилась шикарная утилита, способная в Windows показывать smart состояние дисков, находящихся в рейде. Называется она Hard Disk Sentinel

Переходим на сайт производителя hdsentinel.com

Скачиваем либо установщик, либо portble версию. Запускаем HDSentinel.exe

В системном три у вас появятся значки состояния ваших жестких дисков.

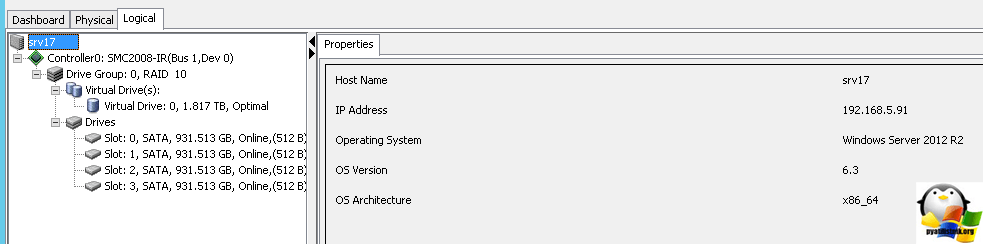

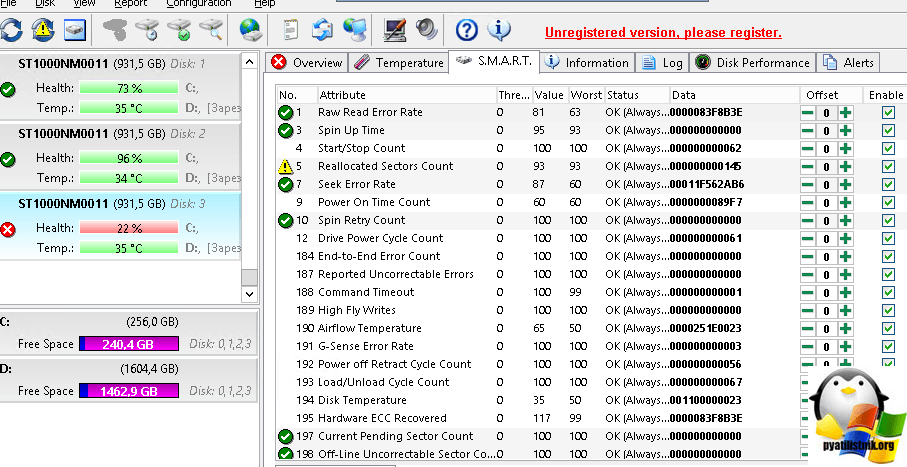

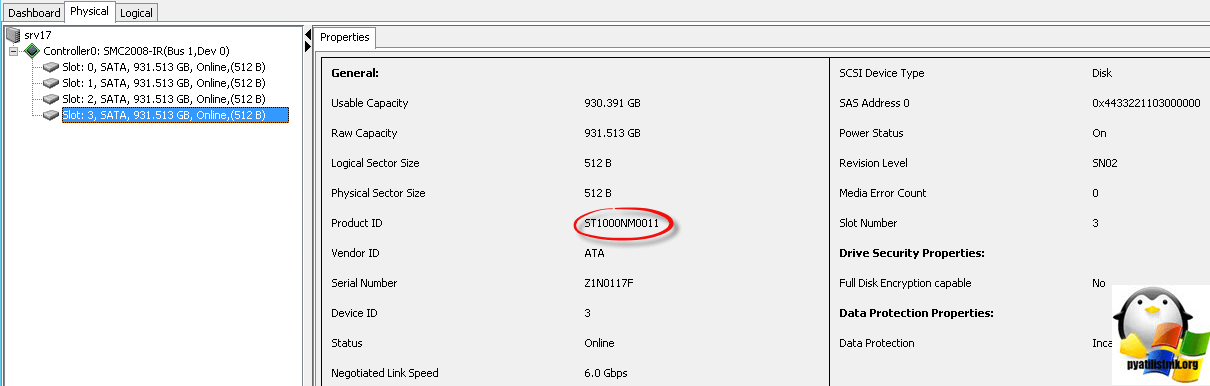

Для примера покажу свой контроллер SMC2008-IR, как видите у меня там 4 диска в 10 рейде.

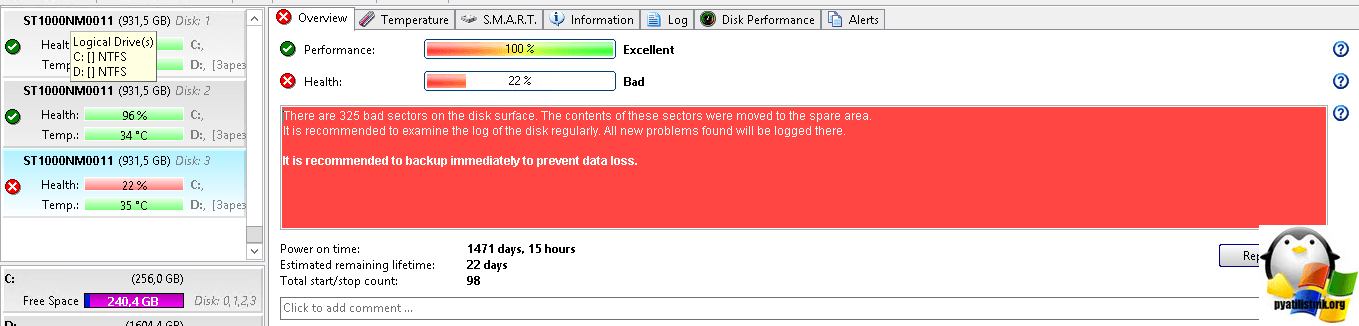

Как видим, у моего 4 диска появились bad sectors

Переходим на вкладку S.M.A.R.T и видим, большинство счетчиков.

Для примера я в LSI утилите ProductID, так же его видит и HDSentinel

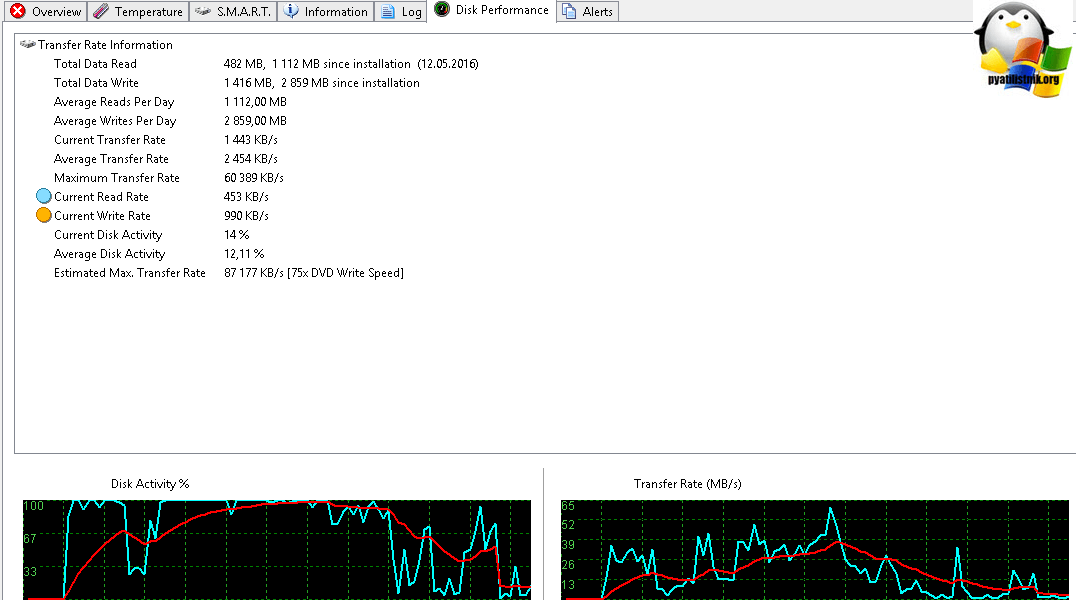

еще HDSentinel удобно отображает загрузку диска в реальном времени.

Можно в сети установить серверную версию, но она платная. Для linux платформ, так же есть своя сборка.

Материал сайта pyatilistnik.org

should have said it was an iSCSI

should have said it was an iSCSI

![[H]ard|Forum](https://hardforum.com/styles/hardforum/xenforo/logo_dark.png)