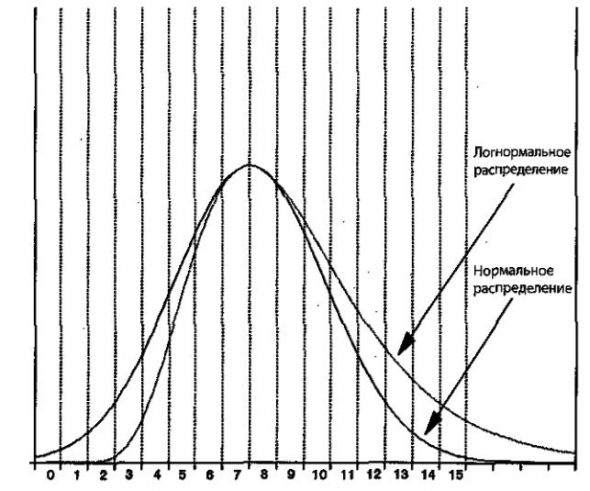

9The lognormal distribution fares slightly better than the normal distribution by having more probability in the tails — that is, having higher values of integrals ∫baP(x)dx for a – b ranges covering larger x values.

From: Philosophy of Complex Systems, 2011

Advanced Math and Statistics

Robert Kissell, Jim Poserina, in Optimal Sports Math, Statistics, and Fantasy, 2017

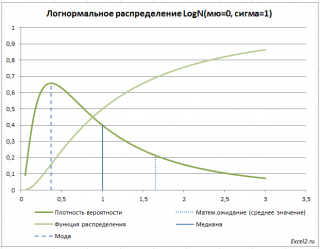

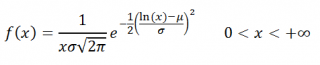

Log-Normal Distribution

A log-normal distribution is a continuous distribution of random variable y whose natural logarithm is normally distributed. For example, if random variable y=exp{y} has log-normal distribution then x=log(y) has normal distribution. Log-normal distributions are most often used in finance to model stock prices, index values, asset returns, as well as exchange rates, derivatives, etc.

Log-Normal Distribution Statistics1

| Notation | lnN(μ,σ2) |

| −∞<μ<∞ | |

| Parameter | σ2>0 |

| Distribution | x>0 |

| 12πσxexp{−(ln(x)−μ)22σ2} | |

| Cdf | 12[1+erf(ln(x−μ)σ)] |

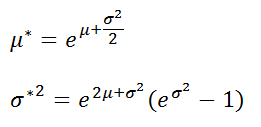

| Mean | e(μ+12σ2) |

| Variance | (eσ2−1)e2μ+σ2 |

| Skewness | (eσ2+2)(eσ2−1) |

| Kurtosis | e4σ2+2e3σ2+3e2σ2−6 |

where erf is the Gaussian error function.

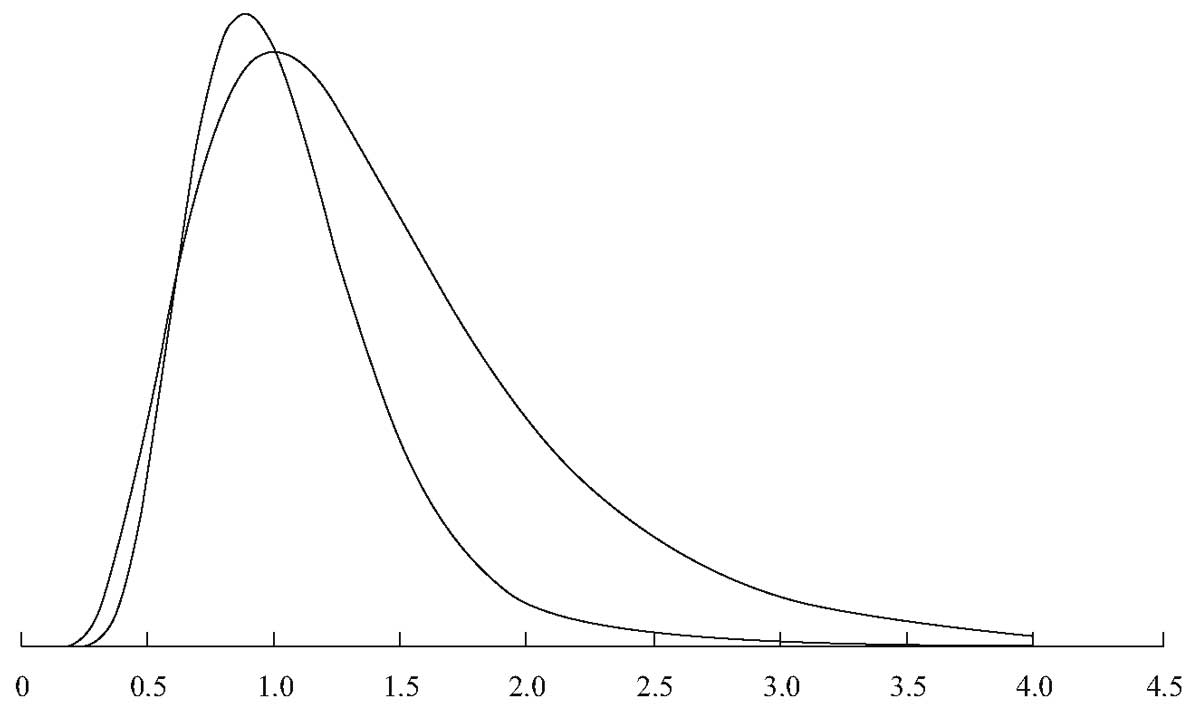

Log-Normal Distribution Graph

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/B9780128051634000049

Cumulative exposure model

Debasis Kundu, Ayon Ganguly, in Analysis of Step-Stress Models, 2017

2.6.2 Log-normal distribution

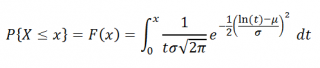

The log-normal distribution has been used quite extensively in analyzing lifetime data. If X has a normal distribution then eX has a log-normal distribution. Therefore, a log-normal distribution with the scale parameter 0<λ<∞ and the shape parameter σ > 0 has the following CDF:

F(t;λ,σ)=0ift<0Φln(t)−ln(λ)σift≥0.

The corresponding PDF and hazard function become

f(t;λ,σ)=0ift<01σtϕln(t)−ln(λ)σift≥0,

and

h(t;λ,σ)=ϕln(t)−ln(λ)σσtΦ−ln(t)+ln(λ)σ;t>0,

respectively. The PDF and the hazard function of a log-normal distribution are always unimodal functions. The PDF of a log-normal distribution is very similar to the PDFs of gamma, Weibull or generalized exponential distributions when the shape parameters of gamma, Weibull and generalized exponential distributions are greater than one. It has been shown by Kundu and Manglick [85, 86] and Kundu et al. [87] that it is very difficult to discriminate between log-normal and gamma, log-normal and Weibull and log-normal and generalized exponential distributions. For different properties of a log-normal distribution and for its various applications, one is referred to Johnson et al. [59].

Alhadeed [88] considered in his PhD thesis the analysis of the log-normal step-stress model, see also Alhadeed and Yang [34], when the complete data are available. Balakrishnan et al. [55] considered the same problem when the data are Type-I censored. It is assumed that the lifetime distribution of the experimental units at the two different stress levels follow log-normal distributions with different scale parameters, λ1 and λ2, but the same shape parameter σ. Based on the CEM assumption, the CDF of the lifetime of an experimental unit from a simple step-stress model can be written as

(2.40)F(t)=0ift<0Φln(t)−ln(λ1)σif0≤t<τ1Φlnt+τ1λ2λ1−τ1−ln(λ2)σifτ1≤t<∞.

Hence, the PDF corresponding to Eq. (2.40) becomes

(2.41)f(t)=0ift<01σtϕln(t)−ln(λ1)σif0≤t<τ11σt+λ2λ1τ1−τ1ϕlnt+τ1λ2λ1−τ1−ln(λ2)σifτ1≤t<∞.

In this case it is more convenient to work with the log-transformation of the data than the original data. Now if a random variable T has the PDF (2.41), then Y=ln(T) has the PDF

fY(y)=0ift<01σϕy−μ1σif0<t<lnτ1eyσey+eμ2−μ1τ1−τ1ϕlney+τ1eμ2−μ1−τ1−μ2σiflnτ1≤y<∞.

Here μ1=lnλ1 and μ2=lnλ2. Therefore, if we denote the log of the observed lifetimes as yi:n=ln(ti:n) for i = 1, …, n, then the log-likelihood function based on the complete observations {y1:n, …, yn:n} is

(2.42)l(μ1,μ2,σ)=−n2ln(π)−nlnσ−12∑i=1n1yi:n−μ1σ2−∑i=n1+1nln(eyi:n+τ1eμ2−μ1−τ1)−12∑i=n1+1nln(eyi:n+τ1eμ2−μ1−τ1)−μ2σ2.

Here it is assumed that 1 ≤ n1 ≤ n − 1 and n ≥ 3; otherwise it is known that the MLEs of σ, μ1, and μ2 do not exist. Therefore, the conditional MLEs of the unknown parameters conditioning on 1 ≤ N1 ≤ n − 1 can be obtained by maximizing Eq. (2.42) with respect to the unknown parameters. In this case the normal equations become

(2.43)l.μ1=∑i=n1+1nτ1eμ2−μ1eyi:n+τ1eμ2−μ1−τ1+1σ2∑i=1n1(yi:n−μ1)+1σ2∑i=n1+1n(ln(eyi:n+τ1eμ2−μ1−τ1)−μ2)τ1eμ2−μ1eyi:n+τ1eμ2−μ1=0,

(2.44)l.μ2=−1σ2∑i=n1+1n(ln(eyi:n+τ1eμ2−μ1−τ1)−μ2)τ1eμ2−μ1eyi:n+τ1eμ2−μ1−1−∑i=n1+1nτ1eμ2−μ1eyi:n+τ1eμ2−μ1−τ1=0,

(2.45)l.σ=−nσ+1σ3∑i=1n1(yi:n−μ1)2+1σ3∑i=n1+1n(ln(eyi:n+τ1eμ2−μ1−τ1)−μ2)2=0.

Clearly, Eqs. (2.43)–(2.45) cannot be solved explicitly. One needs to use the Newton-Raphson type iterative algorithm to solve Eqs. (2.43)–(2.45) numerically. Some initial guesses of the parameters are needed to start the iteration. If μ1 and μ2 are known, the MLE of σ2 can be obtained from Eq. (2.45) as

(2.46)σ^2(μ1,μ2)=1n∑i=1n1(yi:n−μ1)2+∑i=n1+1n(ln(eyi:n+τ1eμ2−μ1−τ1)−μ2)2.

We can obtain the profile log-likelihood function of μ1 and μ2 by using Eq. (2.46) in Eq. (2.42). The profile log-likelihood function of μ1 and μ2 without the additive constants can be written as

(2.47)p(μ1,μ2)=−n2ln∑i=1n1(yi:n−μ1)2+∑i=n1+1n(ln(eyi:n+τ1eμ2−μ1−τ1)−μ2)2−∑i=n1+1nln(eyi:n+τ1eμ2−μ1−τ1).

A contour plot of p(μ1, μ2) as in Eq. (2.47) may provide good starting values of μ1 and μ2. Once we obtain the starting values of μ1 and μ2, the starting value of σ can be easily obtained from Eq. (2.46). Although we have presented the results here for the complete sample, similar results can be developed for different censoring schemes. Balakrishnan et al. [55] performed an extensive simulation study to compare the performances of different confidence intervals. It is observed that the biased corrected bootstrap method works very well in this case. Most of the results have been extended by Lin and Chou [56] for the multiple step-stress model.

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/B9780128097137000028

The particle size distribution

Miroslaw Jonasz, Georges R. Fournier, in Light Scattering by Particles in Water, 2007

5.8.5.6 The log-normal function

Like the power-law distribution discussed in section 5.8.5.3, the log-normal probability distribution has applications in diverse areas, ranging from business (Shimizu and Crow 1988) to oceanography (Campbell 1995). Limpert et al. 2001 review applications of the log-normal distribution in various sciences. The log-normal distribution is generally the result of a process, which can be mathematically characterized by a product of many random variables, for example the process of fragmentation. Indeed, a fragmentation process with the probability of fragmentation independent of the particle size leads to the log-normal function (Shimizu and Crow 1988, Middleton 1970) as originally found by Kolmogorov in 1941 (cited by Tenchov and Yanev 1986). If the probability of fragmentation is proportional to the particle size, the Weibull distribution (section 5.8.5.10) results. However, the difference between a log-normal distribution and a Weibull distribution may be made quite small by the appropriate selection of the distribution parameters (Tenchov and Yanev 1986). Thus, it may be difficult to discern at the measurement precision characteristic of the particle size analysis techniques applicable to aquatic particles. Aitchinson and Brown (1957, Section 10.2) summarize applications of the log-normal distribution in the approximation of the PSD. Crow (1988) discusses applications of the log-normal distribution to model the size distribution of atmospheric particles. Heintzenberg (1994) discusses the properties of the log-normal distribution as applicable to PSD approximations and calculations.

The use of log-normal distributions for approximating the PSD has important advantages:

- (1)

-

there is no need to “break” the power-law approximation to reflect changes in the log-log slope of the size distribution;

- (2)

-

the log-normal approximation assumes finite values for all particle diameters, except in the limit B2 > 0, when the log-normal function becomes a power-law function;

- (3)

-

mass and area distributions resulting from the log-normal distribution are also log-normal (Kerker 1969);

- (4)

-

the power-law function is a limiting case of the log-normal function, so it is naturally included as an approximation of the size distribution.

We should also mention certain pitfalls of choosing the log-normal distribution after Halley and Inchausti (2002), who cite comments by Mandelbrot (1997) (incidentally these problems also relate to other “long-tailed” distributions):

- (1)

-

extreme sensitivity of all moments of the distribution to even small departures from log-normality, which makes the calculation of moments from the parameters of a fitted log-normal distribution unreliable

- (2)

-

slow convergence of the approximate values of the moments to their asymptotic value. This feature is due to an extremely “long tail” of the log-normal distribution at the large-size end of the particle size scale. We have experienced this problem ourselves (Jonasz and Fournier 1996) when trying to evaluate correlations between the total particle surface and volume and the peak diameter of the distribution as fitted to several hundred size distributions of marine particles.

The log-normal size distribution of the zero-th order can be expressed as follows (e.g., Ross 1978, Casperson 1977):

(5.169)n(D)=nmaxexp[−(lnD−lnDpeak)22σ2]

where nmax is expressed as follows:

(5.170)nmax=Ntot2πσDpeakexpσ22

Ntot is the total number of particles [equal to unity in the case of n(D) being the probability distribution], Dpeak is the particle diameter corresponding to the peak of the size distribution, and σ is the standard deviation of lnD, i.e., the geometric standard deviation of D.

The width parameter, σ, is related to the ratio of the maximum and minimum diameters, Dmax and Dmin, of the full-width-at-half-maximum of the log-normal n(D) through the following equation (Jonasz and Fournier 1996):

(5.171)DmaxDmin=exp(2fσ)

where

(5.172)f=2ln2Dmin=Dpeakexp(−fσ)Dmin=Dpeakexp(fσ)

In contrast to the power-law distribution, the log-normal size distribution yields a finite total number of particles, Ntot, total particle cross-sectional area, Atot, and volume, Vtot (Heintzenberg 1994):

(5.173)Atot=π[12Dpeakexp(2σ2)]2Ntot×exp{−12σ2[(lnDmaxexp(2σ2))−lnDmax]2}

and

(5.174)Vtot=43π[12Dpeakexp(3σ2)]3Ntot×exp{−12σ2[(lnDmaxexp(3σ2))−lnDmax]2}

Equations (5.173) and (5.174) apply to the –1-th order generalized log-normalparticle size distribution (see, e.g., Casperson 1977), not to the zero-th ordermostly discussed in this section.

Note that successful applications of these formulas, as also pointed out by Heintzenberg (1994), require that the parameters of the log-normal distribution be evaluated for a particle size range that contributes significantly to the total projected area and volume.

The log-normal function was postulated to approximate the size distribution of marine particles in samples of seawater from several GEOSECS stations in the Atlantic and Pacific, at depths ranging from 286 to 5474 m (Lambert et al. 1981). The particles were collected on 0.4 μm Nuclepore filters and analyzed with a scanning electron microscope. Portions of the filters were coated with carbon and examined using a scanning electron microscope equipped with an X-ray elemental analysis accessory, which enabled the determination of species-specific PSDs. A total of between 100 and 500 particles were analyzed for each sample in a diameter range of 0.2 to 10 μm. The diameter of a particle is taken to be the diameter of a circle with an area equal to that of the particle. The peak diameter was between 1 and 2.5 μm, and the width parameter σ of the size distribution was found to be in a range of 0.5 to 0.7. The quality of the log-normal approximation could in some cases be significantly improved by eliminating the extreme data points in the tails of the distribution. This might be due to the presence in the size distribution of other modes, due to particle populations marginally overlapping in size with the main particle size range.

The log-normal function was also found to approximate well the size distributions of non-spherical clay particles (Jonasz 1987b) measured using a Coulter counter, model ZBI with a 100 μm aperture, and using an HIAC particle counter, model 320 with a CMH-150 particle size sensor.

The cell size distributions reported in the literature frequently appear to be log-normal at visual inspection (see Table A.5 for sources of the relevant PSD data). Interestingly, mathematical models of cell growth and evolution of isolated cell populations do not lead to a log-normal distribution of cell sizes (e.g., Tyson and Hannsgen 1985). However, the agreement between the models and the experimental data is questionable. In fact, Tyson and Hannsgen note that cell size distributions with log-normal size distribution have been reported (ibid. Scherbaum and Rasch 1957, Collins and Richmond 1962). Analysis of the biomass spectrum in aquatic ecosystems composed of organism groups linked via a prey–predator relationship led to the log-normal function as a natural descriptor of the contribution of an organism to the total ecosystem biomas spectrum (Thiebaux and Dickie 1993, Boudreau et al. 1991). The derivation of the log-normal form of the size distributions of the individual organism groups was based on the fact that the production, P (w), is proportional to a power, b, of the body mass, W (allometric relationship):

(5.175)P(W)=aWb

The observation of (1) a persistent curvature of the size distribution of marine particles, when plotted in a log-log scale, (2) the multimodal appearance of many such size distributions, as well as (3) previous suggestions in the literature that complex size distributions of geological material can be well modeled by a sum of log-normal functions (van Andel 1973) led us to develop an automated algorithm of the decomposition of a marine PSD into a sum of log-normal components (Jonasz and Fournier 1999, 1996). In that work, we postulated that the size distribution of marine particles is essentially a linear combination of a cascade of log-normal components, according to the following equation:

(5.176)n(D)=∑1kmaxnk(D)

where index k numbers the log-normal components nk(D). Each of these components is approximated with a zero-th order log-normal distribution function:

(5.177)nk(D)=nmax,kexp[−(lnD−lnDpeak,k)22σk2]

where nmax, k is the maximum value of the component, Dpeak,k [μm] is the peak diameter, and σk is the width parameter. By taking the logarithm of both sides of (5.177) and performing simple algebraic transformations, one obtains (we omit the component index for simplicity):

(5.178)logn(D)=B0+B1logD+B2(logD)2

where:

(5.179)B0=lognmax−(logDpeak)2ln102σ2B1=logDpeakln10σ2B2=−ln102σ2

Note that (5.178) reduces to a power law when B2 vanishes. Equations (5.179) can be solved for nmax, Dpeak, and σ to yield:

(5.180)lognmax=B0−B124B2logDpeak=−B12Bσ2=−ln102B2

We consider only those functions defined by (5.177) which fulfill the condition of B2 < 0. This ensures that the extremum of the function is a maximum. According to the assumption about the size distribution being a cascade of log-normal components, each log-normal component dominates in a particular size interval. Thus, if that size interval is somehow identified, one could determine the parameters of the respective log-normal component, for example, by using the least-squares fitting procedure for the log-log transformed original data.

In the algorithm of Jonasz and Fournier (1996) for fitting a sum of log-normal functions to PSD data, the size interval dominated by a particular log-normal function is identified by repeatedly scanning the size distribution with a window whose width is systematically varied. During each scan set with a fixed window width, the log-normal function is fitted to the data from within the window. Since the number of data points in a size distribution is usually quite moderate, the quality of the log-normal fit for all realistic window widths and locations can be assessed. Once a log-normal component is found, it is subtracted from the PSD data, and the modified data serve as the input for the next round of scans with this window width. If the PSD value (data point) from which a component value at that particle size has been subtracted falls below a preset limit, that data point is removed from the set. Thus, normally the number of data points decreases during this procedure which is terminated if there is no sufficient data left or, less likely, if no components have been found. For each of the next set of scans, the window width is incremented by unity, until the maximum allowed window width. Each set of scans may result in a set of log-normal components which approximate the original data with a specific accuracy. The algorithm is completed by selecting a set of log-normal fits based on either the minimum of the approximation error or other criterion set by the user, for example, the approximation error and the number of components.

Important comments are in order here. First, although the PSD may be better approximated with several, “interpretable” components, the extent of this interpretability is limited by the number of degrees of freedom of the data set, because each log-normal component reduces the number of degrees of freedom by 3. Second, each new component increases the number of parameters required for the description of the data set. From the purely numerical perspective, this seems to be counterproductive—we noted earlier that one goal of the approximation is to reduce the number of parameters. Indeed, given a sufficiently large number of components one simply exchanges the original data (the primary set of parameters) by an equally numerous set of the fit parameters. However, once the “interpretability” aspect is acknowledged, the advantage of that exchange should become clear, as there is usually little interpretability in the original data set. We also discuss this aspect of the PSD analysis later in this section.

Sample results are shown in Figure 5.34 and Figure 5.35. Log-normal components identified by the algorithm just described range in shape from the power-law-like function to Gaussian-normal-like function. Note that the failure to account for the instrumental error (see section 5.7.1.6) in evaluating the γ2 results in the γ2 value in excess of 200 per degree of freedom (!) in the case of data shown in Figure 5.35. that include very high particle count values.

Figure 5.34. A log-normal approximation of the size distribution of Figure 5.31: log n (D) = 4.41 − 2.50 log D − 1.02 (log D)2 (γ2 per degree of freedom = 0.24). The fit parameters were obtained via the logarithmic transform. All weights were set to unity. The γ2 was calculated by assuming only the counting error.

Figure 5.35. A multi-component log-normal approximation (thick black curve) of a PSD measured in the Northwest Atlantic waters (•, unpublished data: courtesy of K. Kranck and T. Milligan, file KRAATL86.P08 in Jonasz 1992). The approximation coefficients from equation (5.178) : first component (thin solid curve) B01 = 4.05, B11 = −1.16, B21 = −2.12, second component (dashed curve) B02 = −17.04, B12 = 22.52, B22 = −7.75, third component (gray solid curve) B03 = 4.97, B13 = 7.04, B23 = 7.30, fourth component (gray dashed curve) B04 = −4.27, B14 = −9.60, B24 = −4.81. The first log-normal component removes the greatest amount of the approximation error. Each of the following components removes a progressively smaller amount of that error (χ2 per degree of freedom = 0. 021). The fit parameters were obtained via the logarithmic transform. All fitting weights were set to unity. The χ2 was calculated by assuming both the counting and instrumental errors.

The statistics of and correlations between the parameters of 853 log-normal components of the 412 PSDs determined using the Coulter technique by different researchers in different areas and seasons are shown in Table 5.10. The average values of coefficients B0, B1, and B2 represent a geometrically averaged component characteristics, i.e., navg(D) such that navg(D) = [n1(D) n2(D) … nm(D)]1/m. The average values of nmax, Dpeak, and σ do not have simple meanings and are given here for the sake of completeness only. The two sets of averages do not yield the same function of the diameter, D, because they are related via non-linear functions (5.179) and (5.180). The average error of approximation of the size distribution with the sum of log-normal components was 0.057±0.030. The number of components per size distribution varied from 1 to 6, with an average of 2.18 ± 1.22. The value of 1 standard deviation (SD) is shown following the ± sign.

Table 5.10. Correlations, expressed using r2, between the parameters of log-normal components of marine particle size distributions measured with a Coulter counter (Jonasz and Fournier 1996—412 size distributions measured by various authors in various seasons and areas of the world ocean).

| Parameter | ln nmax | ln Dpeak | σ |

|---|---|---|---|

| ln nmax | 1.000 | 0.873 | 0.478 |

| ln Dpeak | 0.873 | 1.000 | 0.760 |

| σ | 0.478 | 0.760 | 1.000 |

| Parameter | B0 | B1 | B2 |

| B0 | 1.000 | 0.963 | 0.840 |

| B1 | 0.963 | 1.000 | 0.942 |

| B2 | 0.840 | 0.942 | 1.000 |

The correlations between the coefficients, B0,B1, and B2 are greater than those between the parameters nmax, D ak, and a because of the smoothing effect of the logarithmic transform.

Significant correlations exist between the Dpeak and nmax, as well as between Dpeak and the width parameter, σ, of the component, as can be seen in Figure 5.36 and Figure 5.37. The equations of the approximating lines (see also the correlation coefficients in Table 5.10) shown in these two figures are respectively:

Figure 5.36. Relationship between σ and Dpeak for 853 log-normal components of 412 particle size distributions (Jonasz and Fournier 1996) measured in various waters and seasons by several researchers (as compiled by Jonasz 1992). Approximation line equation: σ = (0.626 ± 0.186) – (0.111 ± 0.002) ln Dpeak, with 1 SD shown following each ± sign (r2 = 0.760).

Figure 5.37. Relationship between nmax and Dpeak for 853 log-normal components of 412 particle size distributions (Jonasz and Fournier 1996) measured in various waters and seasons by several researchers (as compiled by Jonasz 1992). The range of nmax is limited to keep the number of decades on the nmax-axis manageable. The data points not shown conform to the general trend. Approximation line equation: ln nmax = (8.070 ± 2.799) – (2.446 ±0.032) lnDpeak, with 1 SD shown following each ± sign (r2 = 0.873).

(5.181)lnnmax=(8.070±2.799)−(2.446±0.032)lnDpeak

and

(5.182)σ=(0.626±0.186)−(0.111±0.002)lnDpeak

where the value of 1 SD of the respective parameter is shown following each ± sign.

The log-normal components, which range in shape from the power-law-like function to Gaussian-normal-like function, may be interpreted as the size distributions of the various classes of marine particles, for example, populations of various phytoplankton species. Indeed, Jonasz and Fournier (1996) found two “standard” components (Figure 5.38 and Table 5.11) in 412 size distributions measured in various seasons and regions of the world ocean by different researchers. Bradtke (2004) who used the algorithm just described to analyze 970 PSDs measured with a Coulter counter in the coastal waters of the Baltic Sea (Gdansk Bay) also noted the existence of several “standard” components and linked other transitional components to the occurrences of phytoplankton species.

Figure 5.38. “Standard” components (Table 5.11) of the marine particle size distribution identified by Jonasz and Fournier (1996), who analyzed 412 particle size distributions measured in various seasons and regions of the world ocean by different researchers (as compiled by Jonasz 1992): first component (solid black curve) B01 = 4.038, B11 = −0.9511, B21 = −2.542, second component (dashed curve) B02 = −8.447, B12 = −7.55, B22 = −8.595, compared with the size distribution from Figure 5.35 (symbols) and its retrieved components (gray solid lines).

Table 5.11. Parameters of two “standard” components of the marine size particle distribution (Jonasz and Fournier 1996).

| Parameter | Component 1 | Component 2 |

|---|---|---|

| nmax [μm−1 cm−1 | 13400 | 3.28 |

| Dpeak[μm] | 0.65 | 10.5 |

| σ | 0.673 | 0.366 |

| B0 | 4.038 | -8.447 |

| B1 | -0.9511 | 17.55 |

| B2 | -2.542 | -8.595 |

Although “standard” components of the marine size distribution can be generated by other techniques, for example, by the method of characteristic vectors (see section 5.8.5.11), these components lack the physical and biological interpretation possible for the log-normal components. The existence of “standard” components as identified by Bradtke (2004) as well as Jonasz and Fournier (1996) with this algorithm is remarkable, as the decomposition algorithm approaches the task from a purely numerical perspective. It would have certainly been desirable to enhance it so that such “standard” log-normal components attributable to various particle species would be searched for rather than arbitrary log-normal functions whose sum happens to minimize the approximation error of the PSD.

This approach would be particularly attractive from the biological point of view, given the use of log-normal functions to represent ecosystems in natural waters (Thiebaux and Dickie 1993, Boudreau et al. 1991). However, intraspecies variability of the PSDs “characteristic” for a particle species (see examples in section 5.8.4.4.) may make such a decomposition difficult especially when the differences between the approximation errors of a size distribution with various component sets are relatively small.

Jonasz and Fournier (1996) found that only about 5% of the components of the marine size distribution could be well approximated with a power law, which is represented with a straight line on a plot of log n (D) vs. log D. Interestingly, this conclusion does not rule out the first-order representation of the PSD of marine particles by a power-law function in a large range of particle diameter. Such a function would simply be an envelope of the sum of log-normal components.

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/B9780123887511500053

Other related models

Debasis Kundu, Ayon Ganguly, in Analysis of Step-Stress Models, 2017

Log-normal distribution

The classical inferential issues of the TRVM under the assumption that T has a log-normal distribution with the PDF

fT(t)=1σt2πe−12lnt−μσ21(0,∞)(t),

where μ∈R and σ > 0, was addressed by Bai et al. [115]. The authors also assumed that the data are Type-I censored. Under the log-normal distribution, the PDF of T~ is given by

fT~(t)=1σt2πe−12lnt−μσ2if0<t≤τ1βστ1+β(t−τ1)2πe−12ln(τ1+β(t−τ1))−μσ2ift>τ10otherwise.

Given a Type-I censored data t1:n<⋯<tn1:n<τ1<tn1+1:n<⋯<tn1+n2:n<η, the log-likelihood function can be written as

l(μ,σ2,β)=−n1+n22lnσ2−∑i=n1+1n1+n2lnτ1+β(ti:n−τ1)−12σ2∑i=1n1lnti:n−μ2−12σ2∑i=n1+1n1+n2ln(τ1+β(ti:n−τ1))−μ2+(n−n1−n2)ln1−Φln(τ1+β(η−τ1))−μσ,

where Φ(⋅) is the CDF of the standard normal distribution. The MLEs of μ, σ2, and β can be found by maximizing the log-likelihood function with respect to the parameters. Note that in this case the MLEs of the unknown parameters do not exist in explicit form and one needs to use a numerical technique to maximize the log-likelihood function. The asymptotic variance of the MLEs and the confidence intervals of the unknown parameters can be obtained using the observed Fisher information matrix.

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/B978012809713700003X

AFM and Development of (Bio)Fouling-Resistant Membranes

Nidal Hilal, … Huabing Yin, in Atomic Force Microscopy in Process Engineering, 2009

Pore Size and Pore Size Distribution

Pore size and PSD of each membrane were determined from AFM-determined topography. The lognormal distribution was chosen to represent the pore size data for each of the membranes. This was found to give a good fit to the PSD. All of these distributions were fitted to lognormal distributions given by frequencies (%f):

(5.1)%f=%fmaxexp[-12σ2ln(dpX0)2]

where dp is the measured pore size, σ the standard deviation of the measurements, %fmax the maximum frequency and χ0 the modal value of dp.

Mean pore sizes and PSDs of initial membranes determined from AFM images are shown in Table 5.3. This table shows that with a mean pore size of 0.535±0.082 μm, the PVDF membrane has slightly larger pores than the PES membrane (mean pore size 0.470±0.188 μm). PSDs are detailed in Figure 5.3, along with fits described by equation (5.1). The measured pore sizes are larger than the nominal pore size of 0.22 μm as specified by the manufacturers. The AFM data confirm that the pore sizes of studied membranes are of approximately the same size. The topographical images give a clear perception of a notable difference in the surface morphology of the membranes used for the modification. A quantification of the surface parameters (Table 5.3) provides an insight into morphological particularities of these membranes which influence both the membrane separating properties and the process of modification by graft copolymerisation.

Table 5.3. Parameters of Pore Size and PSD Obtained from AFM Images for Initial PES and PVDF Membranes.

| Pore size (μm) | PSD parameters | |||||

|---|---|---|---|---|---|---|

| Membrane | Mean | Minimum | Maximum | X0 (μm) | %fmax | σ |

| PES | 0.470±0.188 | 0.219 | 0.948 | 0.353±0.028 | 19.8±2.2 | 0.56±0.08 |

The two membranes under study have notably different PSDs. It can be noted here that PVDF has a narrower PSD with pore sizes from 0.336 to 0.68 μm compared with a PSD ranging from 0.219 to 0.948 μm in PES membranes. Moreover, these membranes significantly differ in surface roughness, with the PES membrane being smoother than the PVDF membrane. Regarding the AFM images, one might notice that the smoother surface allows for better contrast in pore observation, but more importantly the surface roughness is expected to have an influence on the graft copolymerisation.

The rate of membrane modification was higher in the case of PES membrane than PVDF membrane [19]. It is impossible to associate the difference only with the contribution of surface morphology. It is well known that polysulphone and PES are intrinsically photo-active, undergoing bond cleavage with UV irradiation to produce free radicals even without the use of photo-initiators. PVDF is less photo-reactive than PES and produces less surface free radicals than PES. However, higher density of free radicals at the surface of more photo-reactive PES membranes also results in a higher probability of termination of chain growth and formation of cross-linked structures. These processes restricting an increase in the DM are competitive with respect to the chain growth. Since competitive processes, which enhance and decrease the amount of grafted polymer, occur simultaneously in the case of the photo-reactive polymer, the influence of surface morphology on graft copolymerisation should not be discarded. For the relatively rough surfaces, such as PVDF membrane, the decrease in UV-irradiation effectiveness and steric hindrance for polymer growth in narrow valleys are possible effects that may decrease the modification to some degree.

Before detailed discussion of the quantitative characteristics of surface morphology, it is worth noting that the chosen lognormal pattern for PDS described by equation (5.1) gave a correlation coefficient of at least 0.95 for all fitted curves. The most probable pore sizes estimated from fitted curves were very close to the mean pore diameter calculated from corresponding sets of pore sizes for the initial and modified membranes (Tables 5.4 and 5.5).

Table 5.4. AFM Measurements of Pore Size and PSD of Initial and Modified PES Membranes with qDMAEMA.

| Mean pore | PSD parameters | |||

|---|---|---|---|---|

| DM (μg/cm2) | size (μm) | X0 (μm) | %fmax | σ |

| 0 | 0.470±0.188 | 0.353±0.028 | 19.8±2.2 | 0.56±0.08 |

| 202 | 0.337±0.098 | 0.278±0.010 | 41.4±4.4 | 0.32±0.04 |

| 367 | 0.293±0.072 | 0.281± 0.003 | 51.3±2.0 | 0.26±0.01 |

| 510 | 0.100±0.083 | 0.075±0.004 | 26.9±2.9 | 0.40±0.05 |

Table 5.5. AFM Measurements of Pore Size and PSD of Initial and Modified PVDF Membranes with qDMAEMA.

| Mean pore | PSD parameters | |||

|---|---|---|---|---|

| DM (μg/cm2) | size (μm) | X0 (μm) | %fmax | σ |

| 0 | 0.535±0.082 | 0.555±0.003 | 51.2±1.7 | 0.14±0.01 |

| 224 | 0.445±0.083 | 0.439±0.018 | 35.1±4.1 | 0.28±0.02 |

| 346 | 0.334±0.079 | 0.297±0.013 | 44.3±5.7 | 0.30±0.01 |

According to Figure 5.5(a), the initial PES membrane has a very wide PSD with a σ value of 0.56 μm. However, grafting of poly-qDMAEMA resulted in narrowing of the PSD and shifting the whole curve towards smaller pore sizes. As a result, mean pore size is gradually decreasing with the increase in the amount of poly-qDMAEMA grafted to the membrane surface. Significant improvement of the PSD was observed even for the modified PES membranes with the smallest DM (Table 5.4).

Figure 5.5. PSDs of initial (a) and modified with qDMAEMA (b)–(d) PES membranes; (b) DM = 202 μg cm−2, (c) DM = 367 μg cm−2 and (d) DM = 510 μg cm−2.

Narrowing of the PSD occurred mostly due to the disappearance of large pores (larger than 0.6 μm). Taking into consideration that substantial narrowing of large pores demands higher quantities of grafted polymer compared to smaller pores, it can be assumed that higher rates of polymer growth initiated at the walls of larger pores. As mentioned earlier, at the entrance of narrower pores, higher density of free radicals results in chain termination and consequently lower rate of polymer grafting. With time, when the PSD becomes more uniform, free radicals are eventually distributed across the membrane surface. This leads to a gradual decrease of all surface pores with PSD shifting to smaller sizes. With DM higher than 202 μm cm−2, slight fluctuation in the width of PSD (σ) was observed.

It can be seen from Table 5.5 that similar behaviour is observed regarding changes in the surface morphology of the PVDF membrane as for the PES membrane. However, the unmodified PVDF membrane has a more uniform PSD than the PES membrane. With a mean pore size approximately 0.54 μm, PSD of this membrane is characterised by a low value of σ, ∼0.14 μm, compared with ∼0.56 μm for PES membranes. Although modification of PVDF membrane with grafted qDMAEMA also led to PSD shifting towards lower pore sizes, PSD was wider for the modified membranes compared with initial membrane.

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/B9781856175173000055

Statistical analysis of univariate data

Milan Meloun, Jiří Militký, in Statistical Data Analysis, 2011

Problem 3.11 Robust bi-quadratic sample estimates from five distributions

Apply robust analysis to five samples of size n = 50 from normal, rectangular, exponential, Laplace and log-normal distributions with the use of bi-quadratic estimates.

Data: from Problem 3.9

Program: ADSTAT or QC-EXPERT: Basic Statistics: One sample analysis.

Solution: Robust estimates μ^M, variances Dμ^M and the limits of the 95% confidence interval of the mean are listed in Table 3.6. For the symmetric distributions N, R and L the robust analysis gives accurate estimates quite near to the true values, and the confidence interval is narrow. Worse results were achieved with the asymmetric skewed distributions: for the exponential and log-normal distributions the 95% confidence interval does not contain theoretical value μ.

Table 3.6. Robust analysis of samples from five distributions with the use of bi-quadratic estimates

| Population distribution Χ(μ;σ2) | μ^M | Dμ^M | LL | LU |

|---|---|---|---|---|

| Normal N(0; 1) | − 0.0458 | 1.039 | − 0.349 | 0.257 |

| Rectangular R(0.5; 0.083) | 0.488 | 0.089 | 0.399 | 0.577 |

| Exponential E(1; 1) | 0.762 | 0.442 | 0.561 | 0.964 |

| Laplace L(0;2) | − 0.124 | 1.464 | − 0.490 | 0.242 |

| Log-normal LN(2.71; 47.21) | 1.375 | 2.378 | 0.893 | 1.858 |

Conclusion: The robust M-estimates of this type are not suitable for analysis of skewed distributions.

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/B9780857091093500030

Continuous Probability Distributions

S. Sinharay, in International Encyclopedia of Education (Third Edition), 2010

Lognormal Distribution

If a random variable V has a normal distribution with mean μ and variance σ2, then eV has a lognormal distribution with parameters μ and σ2. In other words, if a variable has a lognormal distribution, then its logarithm has a normal distribution. The pdf of the distribution is given by

fx;μ,σ2=1xσ2πe−12logx−μσ2

where x and σ are both positive. If X follows a lognormal distribution with parameters μ and σ2, then Y = ea Xb follows a lognormal distribution with parameters a + bμ and b2σ2.

The expectation and variance of the lognormal distribution are given by

Ex=eμ+σ22,Vx=e2μ+σ2eσ2−1.

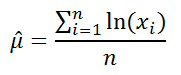

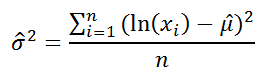

Using its relationships to the normal distribution, the parameters of the lognormal distribution from a sample x1, x2,…, xn of draws from the distribution can be estimated as

μˆ=1n∑log(x1),σˆ=1n−1∑(logxi−μˆ)2.

The easiest way to generate random numbers from a lognormal distribution with parameters μ and σ2 is to generate random numbers from a normal distribution with mean μ and variance σ2 and then exponentiate them.

In some applications of Bayesian methods to IRT models, the prior distribution on the slope parameters is sometimes assumed to be a lognormal distribution. For example, the PARSCALE software program, which is used to fit IRT models by several operational testing programs, assumes a lognormal distribution as the prior distribution for the slope parameters (see e.g., du Toit, 2003).

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/B9780080448947017206

Introduction

Mark A. Pinsky, Samuel Karlin, in An Introduction to Stochastic Modeling (Fourth Edition), 2011

1.4.1 The Normal Distribution

The normal distribution with parameters μ and σ2 > 0 is given by the familiar bell-shaped probability density function

(1.32)ϕ(x;μ,σ2)=12πσe−(x−μ)2/2σ2 −∞<x<∞.

The density function is symmetric about the point μ, and the parameter σ2 is the variance of the distribution. The case μ = 0 and σ2 = 1 is referred to as the standard normal distribution. If X is normally distributed with mean μ and variance σ2, then Z = (X − μ)/σ has a standard normal distribution. By this means, probability statements about arbitrary normal random variables can be reduced to equivalent statements about standard normal random variables. The standard normal density and distribution functions are given respectively by

(1.33)φ(ξ)=12πe−ξ2/2, −∞<ξ<∞,

and

(1.34)Φ(x)=∫−∞xφ(ξ)dξ, −∞<x<∞.

The central limit theorem explains in part the wide prevalence of the normal distribution in nature. A simple form of this aptly named result concerns the partial sums Sn = ξ1 + · ·· + ξn of independent and identically distributed summands ξ1, ξ2…. having finite means μ = E[ξk] and finite variances σ2 = Var[ξk]. In this case, the central limit theorem asserts that

(1.35)limn→∞ Pr{Sn−nμσn≤x}=Φ(x) for all x.

The precise statement of the theorem’s conclusion is given by equation (1.35). Intuition is sometimes enhanced by the looser statement that, for large n, the sum Sn is approximately normally distributed with mean nμ and variance nσ2.

In practical terms we expect the normal distribution to arise whenever the numerical outcome of an experiment results from numerous small additive effects, all operating independently, and where no single or small group of effects is dominant.

The Lognormal Distribution

If the natural logarithm of a nonnegative random variable V is normally distributed, then V is said to have a lognormal distribution. Conversely, if X is normally distributed with mean μ and variance σ2, then V = eX defines a lognormally distributed random variable. The change-of-variable formula (1.15) applies to give the density function for V to be

(1.36)fV(v)=12πσvexp{−12(In v−μσ)2}, v≥0.

The mean and variance are, respectively,

(1.37)E[V]=exp{μ+12σ2},Var[V]=exp{2(μ+12σ2)}[exp{σ2}−1].

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/B9780123814166000010

PARAMETER ESTIMATION

Sheldon M. Ross, in Introduction to Probability and Statistics for Engineers and Scientists (Fourth Edition), 2009

EXAMPLE 7.2f

Kolmogorov’s law of fragmentation states that the size of an individual particle in a large collection of particles resulting from the fragmentation of a mineral compound will have an approximate lognormal distribution, where a random variable X is said to have a lognormal distribution if log(X) has a normal distribution. The law, which was first noted empirically and then later given a theoretical basis by Kolmogorov, has been applied to a variety of engineering studies. For instance, it has been used in the analysis of the size of randomly chosen gold particles from a collection of gold sand. A less obvious application of the law has been to a study of the stress release in earthquake fault zones (see Lomnitz, C., „Global Tectonics and Earthquake Risk,” Developments in Geotectonics, Elsevier, Amsterdam, 1979).

Suppose that a sample of 10 grains of metallic sand taken from a large sand pile have respective lengths (in millimeters):

2.2, 3.4, 1.6, 0.8, 2.7, 3.3, 1.6, 2.8, 2.5, 1.9

Estimate the percentage of sand grains in the entire pile whose length is between 2 and 3 mm.

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/B9780123704832000126

Confidence Intervals in the One-Sample Case

Rand Wilcox, in Introduction to Robust Estimation and Hypothesis Testing (Third Edition), 2012

4.1 Problems when Working with Means

It helps to first describe problems associated with Student’s t. When testing hypotheses or computing confidence intervals for μ, it is assumed that

(4.1)T=n(X¯−μ)s

has a Student’s t-distribution with ν = n − 1 degrees of freedom. This implies that E (T) = 0, and that T has a symmetric distribution. From basic principles, this assumption is correct when observations are randomly sampled from a normal distribution. However, at least three practical problems can arise. First, there are problems with power and the length of the confidence interval. As indicated in Chapters 1 and 2Chapter 1Chapter 2, the standard error of the sample mean, σ/n, becomes inflated when sampling from a heavy-tailed distribution, so power can be poor relative to methods based on other measures of location, and the length of confidence intervals, based on Eq. (4.1), become relatively long – even when σ is known. (For a detailed analysis of how heavy-tailed distributions affect the probability coverage of the t-test, see Benjamini, 1983.) Second, the actual probability of a type I error can be substantially higher or lower than the nominal α level. When sampling from a symmetric distribution, generally the actual level of Student’s t-test will be less than the nominal level (Efron, 1969). When sampling from a symmetric, heavy-tailed distribution the actual probability of type I error can be substantially lower than the nominal α level, and this further contributes to low power and relatively long confidence intervals. From theoretical results reported by Basu and DasGupta (1995), problems with low power can arise even when n is large. When sampling from a skewed distribution with relatively light tails, the actual probability coverage can be substantially less than the nominal 1 − α level resulting in inaccurate conclusions and this problem becomes exacerbated as we move toward (skewed) heavy-tailed distributions. Third, when sampling from a skewed distribution, T also has a skewed distribution, it is no longer true that E (T) = 0, and the distribution of T can deviate enough from a Student’s t-distribution so that practical problems arise. These problems can be ignored if the sample size is sufficiently large, but given data it is difficult knowing just how large n has to be. When sampling from a lognormal distribution, it is known that n > 160 is required (Westfall & Young, 1993). As we move away from the lognormal distribution toward skewed distributions where outliers are more common, n > 300 might be required. Problems with controlling the probability of a type I error are particularly serious when testing one-sided hypotheses. And this has practical implications when testing two-sided hypotheses because it means that a biased hypothesis testing method is being used, as will be illustrated.

Problems with low power were illustrated in Chapter 1, so further comments are omitted. The second problem, that probability coverage and type I error probabilities are affected by departures from normality, is illustrated with a class of distributions obtained by transforming a standard normal distribution in a particular way. Suppose Z has a standard normal distribution, and for some constant h ≥ 0, let

X=Zexph Z22.

Then X has what is called an h distribution. When h = 0, X = Z, so X is standard normal. As h gets large, the tails of the distribution of X get heavier, and the distribution is symmetric about 0. (More details about the h distribution are described in Section 4.2)

Suppose sampling is from an h distribution with h = 1, which has very heavy tails. Then with n = 20 and α = 0.05, the actual probability of a type I error, when using Student’s t to test H0 : μ = 0, is approximately .018 (based on simulations with 10,000 replications). Increasing n to 100, the actual probability of a type I error is approximately .019. A reasonable suggestion for dealing with this problem is to inspect the empirical distribution to determine whether the tails are relatively light. This might be done in various ways, but there is no known empirical rule that reliably indicates whether the type I error probability will be substantially lower than the nominal level when attention is restricted to using Student’s t-test.

To illustrate the third problem, and provide another illustration of the second, consider what happens when sampling from a skewed distribution with relatively light tails. In particular, suppose X has a lognormal distribution, meaning that for some normal random variable, Y, X = exp(Y). This distribution is light-tailed in the sense that the expected proportion of values declared an outlier, using the MAD-Median rule used to define the MOM estimator in Section 3.7, is relatively small.1

For convenience, assume Y is standard normal in which case E(X)=e, where e = exp(1) ≈ 2.71828, and the standard deviation is approximately σ = 2.16. Then Eq. (4.1) assumes that T=n(X¯−e)/s has a Student’s t-distribution with n − 1 degrees of freedom. The left panel of Figure 4.1 shows a (kernel density) estimate of the actual distribution of T when n = 20; the symmetric distribution is the distribution of T under normality. As is evident, the actual distribution is skewed to the left, and its mean is not equal to 0. Simulations indicate that E (T) = −0.54, approximately. The right panel shows an estimate of the probability density function when n = 100. The distribution is more symmetric compared to n = 20, but it is clearly skewed to the left.

Figure 4.1. Nonnormality can seriously affect Students t. The left panel shows an approximation of the actual distribution of Students t when sampling from a lognormal distribution and n = 20 and the right panel is when n = 100.

Let μ0 be some specified constant. The standard approach to testing H0: μ ≤ μ0 is to evaluate T with μ = μ0 and reject H0 if T > t1 − α, where t1 − α is the 1 − α quantile of Student’s t-distribution with ν = n − 1 degrees of freedom, and α is the desired probability of a type I error. If H0:μ≤e is tested when X has a lognormal distribution, H0 should not be rejected, and the probability of a type I error should be as close as possible to the nominal level, α. If α = 0.05 and n = 20, the actual probability of a type I error is approximately .008 (Westfall & Young, 1993, p. 40). As indicated in Figure 4.1, the reason is that T has a distribution that is skewed to the left. In particular, the right tail is much lighter than the assumed Student’s t-distribution, and this results in a type I error probability that is substantially smaller than the nominal 0.05 level. Simultaneously, the left tail, below the point −1.73, the 0.95 quantile of Student’s t-distribution with 19 degrees of freedom, is too thick. Consequently, when testing H0:μ≥e at the 0.05 level, the actual probability of rejecting is .153. Increasing n to 160, the actual probability of a type I error is .022 and .109 for the one-sided hypotheses being considered. And when observations are sampled from a heavy-tailed distribution, control over the probability of a type I error deteriorates.

Generally, as we move toward a skewed distribution with heavy tails, the problems illustrated by Figure 4.1 become exacerbated. As an example, suppose sampling is from a squared lognormal distribution that has mean exp(2). (i.e., if X has a lognormal distribution, E(X2) = exp(2).) Figure 4.2 shows plots of T values based on sample sizes of 20 and 100. (Again, the symmetric distributions are the distributions of T under normality.)

Figure 4.2. The same as Figure 4.1, only now sampling is from a squared lognormal distribution. This illustrates that as we move toward heavy-tailed distributions, problems with nonnormality are exacerbated.

Of course, the seriousness of a type I error depends on the situation. Presumably there are instances where an investigator does not want the probability of a type I error to exceed .1, otherwise the common choice of α = 0.05 would be replaced by α = 0.1 in order to increase power. Thus, assuming Eq. (4.1) has a Student’s t-distribution might be unsatisfactory when testing hypotheses, and the probability coverage of the usual two-sided confidence interval, X¯±t1−α/2s/n might be unsatisfactory as well. Bradley (1978) argues that if a researcher makes a distinction between α = 0.05 and α = 0.1, the actual probability of a type I error should not exceed .075, the idea being that otherwise it is closer to .1 than .05, and he argues that it should not drop below .025. He goes on to suggest that ideally, at least in many situations, the actual probability of a type I error should be between .045 and .055 when α = 0.05.

It is noted that when testing H0: μ < μ0, and when a distribution is skewed to the right, improved control over the probability of a type I error can be achieved using a method derived by Chen (1995). However, even for this special case, problems with controlling the probability of a type I error remain in some situations, and power problems plague any method based on means. (A generalization of this method to some robust measure of location might have some practical value, but this has not been established as yet.) Banik and Kibria (2010) compared numerous methods for computing a (two-sided) confidence interval for the mean. In terms of probability coverage, none of the methods were completely satisfactory when the sample size is small. For n ≥ 50, Chen’s method performed reasonably well among the distributions considered, including situations where sampling is from a lognormal distribution. But the lognormal distribution is relatively light-tailed. How well Chen’s method performs when sampling from a skewed, heavy-tailed distribution, or even a symmetric, heavy-tailed distribution (such as the contaminated normal), appears to be unknown.

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/B9780123869838000044

9The lognormal distribution fares slightly better than the normal distribution by having more probability in the tails — that is, having higher values of integrals ∫baP(x)dx for a – b ranges covering larger x values.

From: Philosophy of Complex Systems, 2011

Advanced Math and Statistics

Robert Kissell, Jim Poserina, in Optimal Sports Math, Statistics, and Fantasy, 2017

Log-Normal Distribution

A log-normal distribution is a continuous distribution of random variable y whose natural logarithm is normally distributed. For example, if random variable y=exp{y} has log-normal distribution then x=log(y) has normal distribution. Log-normal distributions are most often used in finance to model stock prices, index values, asset returns, as well as exchange rates, derivatives, etc.

Log-Normal Distribution Statistics1

| Notation | lnN(μ,σ2) |

| −∞<μ<∞ | |

| Parameter | σ2>0 |

| Distribution | x>0 |

| 12πσxexp{−(ln(x)−μ)22σ2} | |

| Cdf | 12[1+erf(ln(x−μ)σ)] |

| Mean | e(μ+12σ2) |

| Variance | (eσ2−1)e2μ+σ2 |

| Skewness | (eσ2+2)(eσ2−1) |

| Kurtosis | e4σ2+2e3σ2+3e2σ2−6 |

where erf is the Gaussian error function.

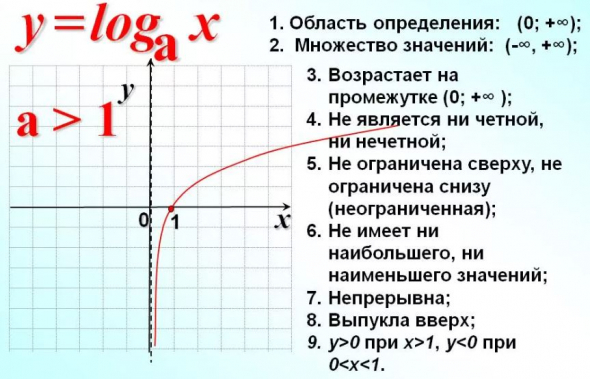

Log-Normal Distribution Graph

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/B9780128051634000049

Cumulative exposure model

Debasis Kundu, Ayon Ganguly, in Analysis of Step-Stress Models, 2017

2.6.2 Log-normal distribution

The log-normal distribution has been used quite extensively in analyzing lifetime data. If X has a normal distribution then eX has a log-normal distribution. Therefore, a log-normal distribution with the scale parameter 0<λ<∞ and the shape parameter σ > 0 has the following CDF:

F(t;λ,σ)=0ift<0Φln(t)−ln(λ)σift≥0.

The corresponding PDF and hazard function become

f(t;λ,σ)=0ift<01σtϕln(t)−ln(λ)σift≥0,

and

h(t;λ,σ)=ϕln(t)−ln(λ)σσtΦ−ln(t)+ln(λ)σ;t>0,

respectively. The PDF and the hazard function of a log-normal distribution are always unimodal functions. The PDF of a log-normal distribution is very similar to the PDFs of gamma, Weibull or generalized exponential distributions when the shape parameters of gamma, Weibull and generalized exponential distributions are greater than one. It has been shown by Kundu and Manglick [85, 86] and Kundu et al. [87] that it is very difficult to discriminate between log-normal and gamma, log-normal and Weibull and log-normal and generalized exponential distributions. For different properties of a log-normal distribution and for its various applications, one is referred to Johnson et al. [59].

Alhadeed [88] considered in his PhD thesis the analysis of the log-normal step-stress model, see also Alhadeed and Yang [34], when the complete data are available. Balakrishnan et al. [55] considered the same problem when the data are Type-I censored. It is assumed that the lifetime distribution of the experimental units at the two different stress levels follow log-normal distributions with different scale parameters, λ1 and λ2, but the same shape parameter σ. Based on the CEM assumption, the CDF of the lifetime of an experimental unit from a simple step-stress model can be written as

(2.40)F(t)=0ift<0Φln(t)−ln(λ1)σif0≤t<τ1Φlnt+τ1λ2λ1−τ1−ln(λ2)σifτ1≤t<∞.

Hence, the PDF corresponding to Eq. (2.40) becomes

(2.41)f(t)=0ift<01σtϕln(t)−ln(λ1)σif0≤t<τ11σt+λ2λ1τ1−τ1ϕlnt+τ1λ2λ1−τ1−ln(λ2)σifτ1≤t<∞.

In this case it is more convenient to work with the log-transformation of the data than the original data. Now if a random variable T has the PDF (2.41), then Y=ln(T) has the PDF

fY(y)=0ift<01σϕy−μ1σif0<t<lnτ1eyσey+eμ2−μ1τ1−τ1ϕlney+τ1eμ2−μ1−τ1−μ2σiflnτ1≤y<∞.

Here μ1=lnλ1 and μ2=lnλ2. Therefore, if we denote the log of the observed lifetimes as yi:n=ln(ti:n) for i = 1, …, n, then the log-likelihood function based on the complete observations {y1:n, …, yn:n} is

(2.42)l(μ1,μ2,σ)=−n2ln(π)−nlnσ−12∑i=1n1yi:n−μ1σ2−∑i=n1+1nln(eyi:n+τ1eμ2−μ1−τ1)−12∑i=n1+1nln(eyi:n+τ1eμ2−μ1−τ1)−μ2σ2.

Here it is assumed that 1 ≤ n1 ≤ n − 1 and n ≥ 3; otherwise it is known that the MLEs of σ, μ1, and μ2 do not exist. Therefore, the conditional MLEs of the unknown parameters conditioning on 1 ≤ N1 ≤ n − 1 can be obtained by maximizing Eq. (2.42) with respect to the unknown parameters. In this case the normal equations become

(2.43)l.μ1=∑i=n1+1nτ1eμ2−μ1eyi:n+τ1eμ2−μ1−τ1+1σ2∑i=1n1(yi:n−μ1)+1σ2∑i=n1+1n(ln(eyi:n+τ1eμ2−μ1−τ1)−μ2)τ1eμ2−μ1eyi:n+τ1eμ2−μ1=0,

(2.44)l.μ2=−1σ2∑i=n1+1n(ln(eyi:n+τ1eμ2−μ1−τ1)−μ2)τ1eμ2−μ1eyi:n+τ1eμ2−μ1−1−∑i=n1+1nτ1eμ2−μ1eyi:n+τ1eμ2−μ1−τ1=0,

(2.45)l.σ=−nσ+1σ3∑i=1n1(yi:n−μ1)2+1σ3∑i=n1+1n(ln(eyi:n+τ1eμ2−μ1−τ1)−μ2)2=0.

Clearly, Eqs. (2.43)–(2.45) cannot be solved explicitly. One needs to use the Newton-Raphson type iterative algorithm to solve Eqs. (2.43)–(2.45) numerically. Some initial guesses of the parameters are needed to start the iteration. If μ1 and μ2 are known, the MLE of σ2 can be obtained from Eq. (2.45) as

(2.46)σ^2(μ1,μ2)=1n∑i=1n1(yi:n−μ1)2+∑i=n1+1n(ln(eyi:n+τ1eμ2−μ1−τ1)−μ2)2.

We can obtain the profile log-likelihood function of μ1 and μ2 by using Eq. (2.46) in Eq. (2.42). The profile log-likelihood function of μ1 and μ2 without the additive constants can be written as

(2.47)p(μ1,μ2)=−n2ln∑i=1n1(yi:n−μ1)2+∑i=n1+1n(ln(eyi:n+τ1eμ2−μ1−τ1)−μ2)2−∑i=n1+1nln(eyi:n+τ1eμ2−μ1−τ1).

A contour plot of p(μ1, μ2) as in Eq. (2.47) may provide good starting values of μ1 and μ2. Once we obtain the starting values of μ1 and μ2, the starting value of σ can be easily obtained from Eq. (2.46). Although we have presented the results here for the complete sample, similar results can be developed for different censoring schemes. Balakrishnan et al. [55] performed an extensive simulation study to compare the performances of different confidence intervals. It is observed that the biased corrected bootstrap method works very well in this case. Most of the results have been extended by Lin and Chou [56] for the multiple step-stress model.

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/B9780128097137000028

The particle size distribution

Miroslaw Jonasz, Georges R. Fournier, in Light Scattering by Particles in Water, 2007

5.8.5.6 The log-normal function

Like the power-law distribution discussed in section 5.8.5.3, the log-normal probability distribution has applications in diverse areas, ranging from business (Shimizu and Crow 1988) to oceanography (Campbell 1995). Limpert et al. 2001 review applications of the log-normal distribution in various sciences. The log-normal distribution is generally the result of a process, which can be mathematically characterized by a product of many random variables, for example the process of fragmentation. Indeed, a fragmentation process with the probability of fragmentation independent of the particle size leads to the log-normal function (Shimizu and Crow 1988, Middleton 1970) as originally found by Kolmogorov in 1941 (cited by Tenchov and Yanev 1986). If the probability of fragmentation is proportional to the particle size, the Weibull distribution (section 5.8.5.10) results. However, the difference between a log-normal distribution and a Weibull distribution may be made quite small by the appropriate selection of the distribution parameters (Tenchov and Yanev 1986). Thus, it may be difficult to discern at the measurement precision characteristic of the particle size analysis techniques applicable to aquatic particles. Aitchinson and Brown (1957, Section 10.2) summarize applications of the log-normal distribution in the approximation of the PSD. Crow (1988) discusses applications of the log-normal distribution to model the size distribution of atmospheric particles. Heintzenberg (1994) discusses the properties of the log-normal distribution as applicable to PSD approximations and calculations.

The use of log-normal distributions for approximating the PSD has important advantages:

- (1)

-

there is no need to “break” the power-law approximation to reflect changes in the log-log slope of the size distribution;

- (2)

-

the log-normal approximation assumes finite values for all particle diameters, except in the limit B2 > 0, when the log-normal function becomes a power-law function;

- (3)

-

mass and area distributions resulting from the log-normal distribution are also log-normal (Kerker 1969);

- (4)

-

the power-law function is a limiting case of the log-normal function, so it is naturally included as an approximation of the size distribution.

We should also mention certain pitfalls of choosing the log-normal distribution after Halley and Inchausti (2002), who cite comments by Mandelbrot (1997) (incidentally these problems also relate to other “long-tailed” distributions):

- (1)

-

extreme sensitivity of all moments of the distribution to even small departures from log-normality, which makes the calculation of moments from the parameters of a fitted log-normal distribution unreliable

- (2)

-

slow convergence of the approximate values of the moments to their asymptotic value. This feature is due to an extremely “long tail” of the log-normal distribution at the large-size end of the particle size scale. We have experienced this problem ourselves (Jonasz and Fournier 1996) when trying to evaluate correlations between the total particle surface and volume and the peak diameter of the distribution as fitted to several hundred size distributions of marine particles.

The log-normal size distribution of the zero-th order can be expressed as follows (e.g., Ross 1978, Casperson 1977):

(5.169)n(D)=nmaxexp[−(lnD−lnDpeak)22σ2]

where nmax is expressed as follows:

(5.170)nmax=Ntot2πσDpeakexpσ22

Ntot is the total number of particles [equal to unity in the case of n(D) being the probability distribution], Dpeak is the particle diameter corresponding to the peak of the size distribution, and σ is the standard deviation of lnD, i.e., the geometric standard deviation of D.

The width parameter, σ, is related to the ratio of the maximum and minimum diameters, Dmax and Dmin, of the full-width-at-half-maximum of the log-normal n(D) through the following equation (Jonasz and Fournier 1996):

(5.171)DmaxDmin=exp(2fσ)

where

(5.172)f=2ln2Dmin=Dpeakexp(−fσ)Dmin=Dpeakexp(fσ)

In contrast to the power-law distribution, the log-normal size distribution yields a finite total number of particles, Ntot, total particle cross-sectional area, Atot, and volume, Vtot (Heintzenberg 1994):

(5.173)Atot=π[12Dpeakexp(2σ2)]2Ntot×exp{−12σ2[(lnDmaxexp(2σ2))−lnDmax]2}

and

(5.174)Vtot=43π[12Dpeakexp(3σ2)]3Ntot×exp{−12σ2[(lnDmaxexp(3σ2))−lnDmax]2}

Equations (5.173) and (5.174) apply to the –1-th order generalized log-normalparticle size distribution (see, e.g., Casperson 1977), not to the zero-th ordermostly discussed in this section.

Note that successful applications of these formulas, as also pointed out by Heintzenberg (1994), require that the parameters of the log-normal distribution be evaluated for a particle size range that contributes significantly to the total projected area and volume.

The log-normal function was postulated to approximate the size distribution of marine particles in samples of seawater from several GEOSECS stations in the Atlantic and Pacific, at depths ranging from 286 to 5474 m (Lambert et al. 1981). The particles were collected on 0.4 μm Nuclepore filters and analyzed with a scanning electron microscope. Portions of the filters were coated with carbon and examined using a scanning electron microscope equipped with an X-ray elemental analysis accessory, which enabled the determination of species-specific PSDs. A total of between 100 and 500 particles were analyzed for each sample in a diameter range of 0.2 to 10 μm. The diameter of a particle is taken to be the diameter of a circle with an area equal to that of the particle. The peak diameter was between 1 and 2.5 μm, and the width parameter σ of the size distribution was found to be in a range of 0.5 to 0.7. The quality of the log-normal approximation could in some cases be significantly improved by eliminating the extreme data points in the tails of the distribution. This might be due to the presence in the size distribution of other modes, due to particle populations marginally overlapping in size with the main particle size range.

The log-normal function was also found to approximate well the size distributions of non-spherical clay particles (Jonasz 1987b) measured using a Coulter counter, model ZBI with a 100 μm aperture, and using an HIAC particle counter, model 320 with a CMH-150 particle size sensor.

The cell size distributions reported in the literature frequently appear to be log-normal at visual inspection (see Table A.5 for sources of the relevant PSD data). Interestingly, mathematical models of cell growth and evolution of isolated cell populations do not lead to a log-normal distribution of cell sizes (e.g., Tyson and Hannsgen 1985). However, the agreement between the models and the experimental data is questionable. In fact, Tyson and Hannsgen note that cell size distributions with log-normal size distribution have been reported (ibid. Scherbaum and Rasch 1957, Collins and Richmond 1962). Analysis of the biomass spectrum in aquatic ecosystems composed of organism groups linked via a prey–predator relationship led to the log-normal function as a natural descriptor of the contribution of an organism to the total ecosystem biomas spectrum (Thiebaux and Dickie 1993, Boudreau et al. 1991). The derivation of the log-normal form of the size distributions of the individual organism groups was based on the fact that the production, P (w), is proportional to a power, b, of the body mass, W (allometric relationship):

(5.175)P(W)=aWb

The observation of (1) a persistent curvature of the size distribution of marine particles, when plotted in a log-log scale, (2) the multimodal appearance of many such size distributions, as well as (3) previous suggestions in the literature that complex size distributions of geological material can be well modeled by a sum of log-normal functions (van Andel 1973) led us to develop an automated algorithm of the decomposition of a marine PSD into a sum of log-normal components (Jonasz and Fournier 1999, 1996). In that work, we postulated that the size distribution of marine particles is essentially a linear combination of a cascade of log-normal components, according to the following equation:

(5.176)n(D)=∑1kmaxnk(D)

where index k numbers the log-normal components nk(D). Each of these components is approximated with a zero-th order log-normal distribution function:

(5.177)nk(D)=nmax,kexp[−(lnD−lnDpeak,k)22σk2]

where nmax, k is the maximum value of the component, Dpeak,k [μm] is the peak diameter, and σk is the width parameter. By taking the logarithm of both sides of (5.177) and performing simple algebraic transformations, one obtains (we omit the component index for simplicity):

(5.178)logn(D)=B0+B1logD+B2(logD)2

where:

(5.179)B0=lognmax−(logDpeak)2ln102σ2B1=logDpeakln10σ2B2=−ln102σ2

Note that (5.178) reduces to a power law when B2 vanishes. Equations (5.179) can be solved for nmax, Dpeak, and σ to yield:

(5.180)lognmax=B0−B124B2logDpeak=−B12Bσ2=−ln102B2

We consider only those functions defined by (5.177) which fulfill the condition of B2 < 0. This ensures that the extremum of the function is a maximum. According to the assumption about the size distribution being a cascade of log-normal components, each log-normal component dominates in a particular size interval. Thus, if that size interval is somehow identified, one could determine the parameters of the respective log-normal component, for example, by using the least-squares fitting procedure for the log-log transformed original data.

In the algorithm of Jonasz and Fournier (1996) for fitting a sum of log-normal functions to PSD data, the size interval dominated by a particular log-normal function is identified by repeatedly scanning the size distribution with a window whose width is systematically varied. During each scan set with a fixed window width, the log-normal function is fitted to the data from within the window. Since the number of data points in a size distribution is usually quite moderate, the quality of the log-normal fit for all realistic window widths and locations can be assessed. Once a log-normal component is found, it is subtracted from the PSD data, and the modified data serve as the input for the next round of scans with this window width. If the PSD value (data point) from which a component value at that particle size has been subtracted falls below a preset limit, that data point is removed from the set. Thus, normally the number of data points decreases during this procedure which is terminated if there is no sufficient data left or, less likely, if no components have been found. For each of the next set of scans, the window width is incremented by unity, until the maximum allowed window width. Each set of scans may result in a set of log-normal components which approximate the original data with a specific accuracy. The algorithm is completed by selecting a set of log-normal fits based on either the minimum of the approximation error or other criterion set by the user, for example, the approximation error and the number of components.

Important comments are in order here. First, although the PSD may be better approximated with several, “interpretable” components, the extent of this interpretability is limited by the number of degrees of freedom of the data set, because each log-normal component reduces the number of degrees of freedom by 3. Second, each new component increases the number of parameters required for the description of the data set. From the purely numerical perspective, this seems to be counterproductive—we noted earlier that one goal of the approximation is to reduce the number of parameters. Indeed, given a sufficiently large number of components one simply exchanges the original data (the primary set of parameters) by an equally numerous set of the fit parameters. However, once the “interpretability” aspect is acknowledged, the advantage of that exchange should become clear, as there is usually little interpretability in the original data set. We also discuss this aspect of the PSD analysis later in this section.

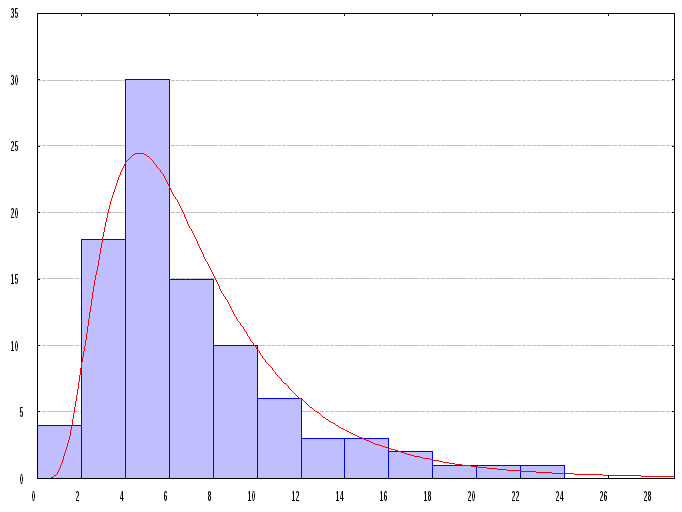

Sample results are shown in Figure 5.34 and Figure 5.35. Log-normal components identified by the algorithm just described range in shape from the power-law-like function to Gaussian-normal-like function. Note that the failure to account for the instrumental error (see section 5.7.1.6) in evaluating the γ2 results in the γ2 value in excess of 200 per degree of freedom (!) in the case of data shown in Figure 5.35. that include very high particle count values.

Figure 5.34. A log-normal approximation of the size distribution of Figure 5.31: log n (D) = 4.41 − 2.50 log D − 1.02 (log D)2 (γ2 per degree of freedom = 0.24). The fit parameters were obtained via the logarithmic transform. All weights were set to unity. The γ2 was calculated by assuming only the counting error.

Figure 5.35. A multi-component log-normal approximation (thick black curve) of a PSD measured in the Northwest Atlantic waters (•, unpublished data: courtesy of K. Kranck and T. Milligan, file KRAATL86.P08 in Jonasz 1992). The approximation coefficients from equation (5.178) : first component (thin solid curve) B01 = 4.05, B11 = −1.16, B21 = −2.12, second component (dashed curve) B02 = −17.04, B12 = 22.52, B22 = −7.75, third component (gray solid curve) B03 = 4.97, B13 = 7.04, B23 = 7.30, fourth component (gray dashed curve) B04 = −4.27, B14 = −9.60, B24 = −4.81. The first log-normal component removes the greatest amount of the approximation error. Each of the following components removes a progressively smaller amount of that error (χ2 per degree of freedom = 0. 021). The fit parameters were obtained via the logarithmic transform. All fitting weights were set to unity. The χ2 was calculated by assuming both the counting and instrumental errors.

The statistics of and correlations between the parameters of 853 log-normal components of the 412 PSDs determined using the Coulter technique by different researchers in different areas and seasons are shown in Table 5.10. The average values of coefficients B0, B1, and B2 represent a geometrically averaged component characteristics, i.e., navg(D) such that navg(D) = [n1(D) n2(D) … nm(D)]1/m. The average values of nmax, Dpeak, and σ do not have simple meanings and are given here for the sake of completeness only. The two sets of averages do not yield the same function of the diameter, D, because they are related via non-linear functions (5.179) and (5.180). The average error of approximation of the size distribution with the sum of log-normal components was 0.057±0.030. The number of components per size distribution varied from 1 to 6, with an average of 2.18 ± 1.22. The value of 1 standard deviation (SD) is shown following the ± sign.

Table 5.10. Correlations, expressed using r2, between the parameters of log-normal components of marine particle size distributions measured with a Coulter counter (Jonasz and Fournier 1996—412 size distributions measured by various authors in various seasons and areas of the world ocean).

| Parameter | ln nmax | ln Dpeak | σ |

|---|---|---|---|

| ln nmax | 1.000 | 0.873 | 0.478 |

| ln Dpeak | 0.873 | 1.000 | 0.760 |

| σ | 0.478 | 0.760 | 1.000 |

| Parameter | B0 | B1 | B2 |

| B0 | 1.000 | 0.963 | 0.840 |

| B1 | 0.963 | 1.000 | 0.942 |

| B2 | 0.840 | 0.942 | 1.000 |

The correlations between the coefficients, B0,B1, and B2 are greater than those between the parameters nmax, D ak, and a because of the smoothing effect of the logarithmic transform.

Significant correlations exist between the Dpeak and nmax, as well as between Dpeak and the width parameter, σ, of the component, as can be seen in Figure 5.36 and Figure 5.37. The equations of the approximating lines (see also the correlation coefficients in Table 5.10) shown in these two figures are respectively:

Figure 5.36. Relationship between σ and Dpeak for 853 log-normal components of 412 particle size distributions (Jonasz and Fournier 1996) measured in various waters and seasons by several researchers (as compiled by Jonasz 1992). Approximation line equation: σ = (0.626 ± 0.186) – (0.111 ± 0.002) ln Dpeak, with 1 SD shown following each ± sign (r2 = 0.760).

Figure 5.37. Relationship between nmax and Dpeak for 853 log-normal components of 412 particle size distributions (Jonasz and Fournier 1996) measured in various waters and seasons by several researchers (as compiled by Jonasz 1992). The range of nmax is limited to keep the number of decades on the nmax-axis manageable. The data points not shown conform to the general trend. Approximation line equation: ln nmax = (8.070 ± 2.799) – (2.446 ±0.032) lnDpeak, with 1 SD shown following each ± sign (r2 = 0.873).

(5.181)lnnmax=(8.070±2.799)−(2.446±0.032)lnDpeak

and

(5.182)σ=(0.626±0.186)−(0.111±0.002)lnDpeak

where the value of 1 SD of the respective parameter is shown following each ± sign.

The log-normal components, which range in shape from the power-law-like function to Gaussian-normal-like function, may be interpreted as the size distributions of the various classes of marine particles, for example, populations of various phytoplankton species. Indeed, Jonasz and Fournier (1996) found two “standard” components (Figure 5.38 and Table 5.11) in 412 size distributions measured in various seasons and regions of the world ocean by different researchers. Bradtke (2004) who used the algorithm just described to analyze 970 PSDs measured with a Coulter counter in the coastal waters of the Baltic Sea (Gdansk Bay) also noted the existence of several “standard” components and linked other transitional components to the occurrences of phytoplankton species.

Figure 5.38. “Standard” components (Table 5.11) of the marine particle size distribution identified by Jonasz and Fournier (1996), who analyzed 412 particle size distributions measured in various seasons and regions of the world ocean by different researchers (as compiled by Jonasz 1992): first component (solid black curve) B01 = 4.038, B11 = −0.9511, B21 = −2.542, second component (dashed curve) B02 = −8.447, B12 = −7.55, B22 = −8.595, compared with the size distribution from Figure 5.35 (symbols) and its retrieved components (gray solid lines).

Table 5.11. Parameters of two “standard” components of the marine size particle distribution (Jonasz and Fournier 1996).

| Parameter | Component 1 | Component 2 |

|---|---|---|

| nmax [μm−1 cm−1 | 13400 | 3.28 |

| Dpeak[μm] | 0.65 | 10.5 |

| σ | 0.673 | 0.366 |

| B0 | 4.038 | -8.447 |

| B1 | -0.9511 | 17.55 |

| B2 | -2.542 | -8.595 |

Although “standard” components of the marine size distribution can be generated by other techniques, for example, by the method of characteristic vectors (see section 5.8.5.11), these components lack the physical and biological interpretation possible for the log-normal components. The existence of “standard” components as identified by Bradtke (2004) as well as Jonasz and Fournier (1996) with this algorithm is remarkable, as the decomposition algorithm approaches the task from a purely numerical perspective. It would have certainly been desirable to enhance it so that such “standard” log-normal components attributable to various particle species would be searched for rather than arbitrary log-normal functions whose sum happens to minimize the approximation error of the PSD.