������������� ������� ��������� ��������� ���������� (man-��)

m_pullup (9)

BSD mandoc

NAME

mbuf - memory management in the kernel IPC subsystem

SYNOPSIS

#include <sys/param.h>

#include <sys/systm.h>

#include <sys/mbuf.h>

Mbuf allocation macros

MGET (struct mbuf *mbuf int how short type);

MGETHDR (struct mbuf *mbuf int how short type);

MCLGET (struct mbuf *mbuf int how);

Fo MEXTADD

Fa struct mbuf *mbuf

Fa caddr_t buf

Fa u_int size

Fa void (*free)(void *opt_args)

Fa void *opt_args

Fa short flags

Fa int type

Fc Fn MEXTFREE struct mbuf *mbuf

MFREE (struct mbuf *mbuf struct mbuf *successor);

Mbuf utility macros

mtod (struct mbuf *mbuf type);

M_ALIGN (struct mbuf *mbuf u_int len);

MH_ALIGN (struct mbuf *mbuf u_int len);

int

M_LEADINGSPACE (struct mbuf *mbuf);

int

M_TRAILINGSPACE (struct mbuf *mbuf);

M_MOVE_PKTHDR (struct mbuf *to struct mbuf *from);

M_PREPEND (struct mbuf *mbuf int len int how);

MCHTYPE (struct mbuf *mbuf u_int type);

int

M_WRITABLE (struct mbuf *mbuf);

Mbuf allocation functions

struct mbuf *

m_get (int how int type);

struct mbuf *

m_getm (struct mbuf *orig int len int how int type);

struct mbuf *

m_getcl (int how short type int flags);

struct mbuf *

m_getclr (int how int type);

struct mbuf *

m_gethdr (int how int type);

struct mbuf *

m_free (struct mbuf *mbuf);

void

m_freem (struct mbuf *mbuf);

Mbuf utility functions

void

m_adj (struct mbuf *mbuf int len);

void

m_align (struct mbuf *mbuf int len);

int

m_append (struct mbuf *mbuf int len c_caddr_t cp);

struct mbuf *

m_prepend (struct mbuf *mbuf int len int how);

struct mbuf *

m_copyup (struct mbuf *mbuf int len int dstoff);

struct mbuf *

m_pullup (struct mbuf *mbuf int len);

struct mbuf *

m_pulldown (struct mbuf *mbuf int offset int len int *offsetp);

struct mbuf *

m_copym (struct mbuf *mbuf int offset int len int how);

struct mbuf *

m_copypacket (struct mbuf *mbuf int how);

struct mbuf *

m_dup (struct mbuf *mbuf int how);

void

m_copydata (const struct mbuf *mbuf int offset int len caddr_t buf);

void

m_copyback (struct mbuf *mbuf int offset int len caddr_t buf);

struct mbuf *

Fo m_devget

Fa char *buf

Fa int len

Fa int offset

Fa struct ifnet *ifp

Fa void (*copy)(char *from, caddr_t to, u_int len)

Fc Ft void

m_cat (struct mbuf *m struct mbuf *n);

u_int

m_fixhdr (struct mbuf *mbuf);

void

m_dup_pkthdr (struct mbuf *to struct mbuf *from);

void

m_move_pkthdr (struct mbuf *to struct mbuf *from);

u_int

m_length (struct mbuf *mbuf struct mbuf **last);

struct mbuf *

m_split (struct mbuf *mbuf int len int how);

int

m_apply (struct mbuf *mbuf int off int len int (*f)(void *arg, void *data, u_int len) void *arg);

struct mbuf *

m_getptr (struct mbuf *mbuf int loc int *off);

struct mbuf *

m_defrag (struct mbuf *m0 int how);

struct mbuf *

m_unshare (struct mbuf *m0 int how);

DESCRIPTION

An

Vt mbuf

is a basic unit of memory management in the kernel IPC subsystem.

Network packets and socket buffers are stored in

Vt mbufs .

A network packet may span multiple

Vt mbufs

arranged into a

Vt mbuf chain

(linked list),

which allows adding or trimming

network headers with little overhead.

While a developer should not bother with

Vt mbuf

internals without serious

reason in order to avoid incompatibilities with future changes, it

is useful to understand the general structure of an

Vt mbuf .

An

Vt mbuf

consists of a variable-sized header and a small internal

buffer for data.

The total size of an

Vt mbuf ,

MSIZE

is a constant defined in

In sys/param.h .

The

Vt mbuf

header includes:

- m_next

-

(Vt struct mbuf

)

A pointer to the next

Vt mbufin the

Vt mbuf chain . - m_nextpkt

-

(Vt struct mbuf

)

A pointer to the next

Vt mbuf chainin the queue.

- m_data

-

(Vt caddr_t

)

A pointer to data attached to this

Vt mbuf . - m_len

-

(Vt int

)

The length of the data.

- m_type

-

(Vt short

)

The type of the data.

- m_flags

-

(Vt int

)

The

Vt mbufflags.

The

Vt mbuf

flag bits are defined as follows:

/* mbuf flags */ #define M_EXT 0x0001 /* has associated external storage */ #define M_PKTHDR 0x0002 /* start of record */ #define M_EOR 0x0004 /* end of record */ #define M_RDONLY 0x0008 /* associated data marked read-only */ #define M_PROTO1 0x0010 /* protocol-specific */ #define M_PROTO2 0x0020 /* protocol-specific */ #define M_PROTO3 0x0040 /* protocol-specific */ #define M_PROTO4 0x0080 /* protocol-specific */ #define M_PROTO5 0x0100 /* protocol-specific */ #define M_PROTO6 0x4000 /* protocol-specific (avoid M_BCAST conflict) */ #define M_FREELIST 0x8000 /* mbuf is on the free list */ /* mbuf pkthdr flags (also stored in m_flags) */ #define M_BCAST 0x0200 /* send/received as link-level broadcast */ #define M_MCAST 0x0400 /* send/received as link-level multicast */ #define M_FRAG 0x0800 /* packet is fragment of larger packet */ #define M_FIRSTFRAG 0x1000 /* packet is first fragment */ #define M_LASTFRAG 0x2000 /* packet is last fragment */

The available

Vt mbuf

types are defined as follows:

/* mbuf types */ #define MT_DATA 1 /* dynamic (data) allocation */ #define MT_HEADER MT_DATA /* packet header */ #define MT_SONAME 8 /* socket name */ #define MT_CONTROL 14 /* extra-data protocol message */ #define MT_OOBDATA 15 /* expedited data */

If the

M_PKTHDR

flag is set, a

Vt struct pkthdr Va m_pkthdr

is added to the

Vt mbuf

header.

It contains a pointer to the interface

the packet has been received from

(Vt struct ifnet *rcvif

)

and the total packet length

(Vt int len

)

Optionally, it may also contain an attached list of packet tags

(Vt struct m_tag

)

See

mbuf_tags9

for details.

Fields used in offloading checksum calculation to the hardware are kept in

m_pkthdr

as well.

See

Sx HARDWARE-ASSISTED CHECKSUM CALCULATION

for details.

If small enough, data is stored in the internal data buffer of an

Vt mbuf .

If the data is sufficiently large, another

Vt mbuf

may be added to the

Vt mbuf chain ,

or external storage may be associated with the

Vt mbuf .

MHLEN

bytes of data can fit into an

Vt mbuf

with the

M_PKTHDR

flag set,

MLEN

bytes can otherwise.

If external storage is being associated with an

Vt mbuf ,

the

m_ext

header is added at the cost of losing the internal data buffer.

It includes a pointer to external storage, the size of the storage,

a pointer to a function used for freeing the storage,

a pointer to an optional argument that can be passed to the function,

and a pointer to a reference counter.

An

Vt mbuf

using external storage has the

M_EXT

flag set.

The system supplies a macro for allocating the desired external storage

buffer,

MEXTADD

The allocation and management of the reference counter is handled by the

subsystem.

The system also supplies a default type of external storage buffer called an

Vt mbuf cluster .

Vt Mbuf clusters

can be allocated and configured with the use of the

MCLGET

macro.

Each

Vt mbuf cluster

is

MCLBYTES

in size, where MCLBYTES is a machine-dependent constant.

The system defines an advisory macro

MINCLSIZE

which is the smallest amount of data to put into an

Vt mbuf cluster .

It is equal to the sum of

MLEN

and

MHLEN

It is typically preferable to store data into the data region of an

Vt mbuf ,

if size permits, as opposed to allocating a separate

Vt mbuf cluster

to hold the same data.

Macros and Functions

There are numerous predefined macros and functions that provide the

developer with common utilities.

- Fn mtod mbuf type

-

Convert an

Fa mbufpointer to a data pointer.

The macro expands to the data pointer cast to the pointer of the specified

Fa type .Note

It is advisable to ensure that there is enough contiguous data in

Fa mbuf .See

m_pullup ();for details.

- Fn MGET mbuf how type

-

Allocate an

Vt mbufand initialize it to contain internal data.

Fa mbufwill point to the allocated

Vt mbufon success, or be set to

NULLon failure.

The

Fa howargument is to be set to

M_TRYWAITor

M_DONTWAITIt specifies whether the caller is willing to block if necessary.

If

Fa howis set to

M_TRYWAITa failed allocation will result in the caller being put

to sleep for a designated

kern.ipc.mbuf_wait

(sysctl8tunable)

number of ticks.

A number of other functions and macros related to

Vt mbufshave the same argument because they may

at some point need to allocate new

Vt mbufs .Programmers should be careful not to confuse the

Vt mbufallocation flag

M_DONTWAITwith the

malloc(9)allocation flag,

M_NOWAITThey are not the same.

- Fn MGETHDR mbuf how type

-

Allocate an

Vt mbufand initialize it to contain a packet header

and internal data.

See

MGET ();for details.

- Fn MCLGET mbuf how

-

Allocate and attach an

Vt mbuf clusterto

Fa mbuf .If the macro fails, the

M_EXTflag will not be set in

Fa mbuf . - Fn M_ALIGN mbuf len

-

Set the pointer

Fa mbuf->m_datato place an object of the size

Fa lenat the end of the internal data area of

Fa mbuf ,long word aligned.

Applicable only if

Fa mbufis newly allocated with

MGET ();or

m_get (.); - Fn MH_ALIGN mbuf len

-

Serves the same purpose as

M_ALIGN ();does, but only for

Fa mbufnewly allocated with

MGETHDR ();or

m_gethdr (,);or initialized by

m_dup_pkthdr ();or

m_move_pkthdr (.); - Fn m_align mbuf len

-

Services the same purpose as

M_ALIGN ();but handles any type of mbuf.

- Fn M_LEADINGSPACE mbuf

-

Returns the number of bytes available before the beginning

of data in

Fa mbuf . - Fn M_TRAILINGSPACE mbuf

-

Returns the number of bytes available after the end of data in

Fa mbuf . - Fn M_PREPEND mbuf len how

-

This macro operates on an

Vt mbuf chain .It is an optimized wrapper for

m_prepend ();that can make use of possible empty space before data

(e.g. left after trimming of a link-layer header).

The new

Vt mbuf chainpointer or

NULLis in

Fa mbufafter the call.

- Fn M_MOVE_PKTHDR to from

-

Using this macro is equivalent to calling

m_move_pkthdr (to from .); - Fn M_WRITABLE mbuf

-

This macro will evaluate true if

Fa mbufis not marked

M_RDONLYand if either

Fa mbufdoes not contain external storage or,

if it does,

then if the reference count of the storage is not greater than 1.

The

M_RDONLYflag can be set in

Fa mbuf->m_flags .This can be achieved during setup of the external storage,

by passing the

M_RDONLYbit as a

Fa flagsargument to the

MEXTADD ();macro, or can be directly set in individual

Vt mbufs . - Fn MCHTYPE mbuf type

-

Change the type of

Fa mbufto

Fa type .This is a relatively expensive operation and should be avoided.

The functions are:

- Fn m_get how type

-

A function version of

MGET ();for non-critical paths.

- Fn m_getm orig len how type

-

Allocate

Fa lenbytes worth of

Vt mbufsand

Vt mbuf clustersif necessary and append the resulting allocated

Vt mbuf chainto the

Vt mbuf chainFa orig ,

if it is

non- NULLIf the allocation fails at any point,

free whatever was allocated and return

NULLIf

Fa origis

non- NULLit will not be freed.

It is possible to use

m_getm ();to either append

Fa lenbytes to an existing

Vt mbufor

Vt mbuf chain(for example, one which may be sitting in a pre-allocated ring)

or to simply perform an all-or-nothing

Vt mbufand

Vt mbuf clusterallocation.

- Fn m_gethdr how type

-

A function version of

MGETHDR ();for non-critical paths.

- Fn m_getcl how type flags

-

Fetch an

Vt mbufwith a

Vt mbuf clusterattached to it.

If one of the allocations fails, the entire allocation fails.

This routine is the preferred way of fetching both the

Vt mbufand

Vt mbuf clustertogether, as it avoids having to unlock/relock between allocations.

Returns

NULLon failure.

- Fn m_getclr how type

-

Allocate an

Vt mbufand zero out the data region.

- Fn m_free mbuf

-

Frees

Vt mbuf .Returns

m_nextof the freed

Vt mbuf .

The functions below operate on

Vt mbuf chains .

- Fn m_freem mbuf

-

Free an entire

Vt mbuf chain ,including any external storage.

- Fn m_adj mbuf len

-

Trim

Fa lenbytes from the head of an

Vt mbuf chainif

Fa lenis positive, from the tail otherwise.

- Fn m_append mbuf len cp

-

Append

Vt lenbytes of data

Vt cpto the

Vt mbuf chain .Extend the mbuf chain if the new data does not fit in

existing space. - Fn m_prepend mbuf len how

-

Allocate a new

Vt mbufand prepend it to the

Vt mbuf chain ,handle

M_PKTHDRproperly.

NoteIt does not allocate any

Vt mbuf clusters ,so

Fa lenmust be less than

MLENor

MHLENdepending on the

M_PKTHDRflag setting.

- Fn m_copyup mbuf len dstoff

-

Similar to

m_pullup ();but copies

Fa lenbytes of data into a new mbuf at

Fa dstoffbytes into the mbuf.

The

Fa dstoffargument aligns the data and leaves room for a link layer header.

Returns the new

Vt mbuf chainon success,

and frees the

Vt mbuf chainand returns

NULLon failure.

NoteThe function does not allocate

Vt mbuf clusters ,so

Fa len + dstoffmust be less than

MHLEN - Fn m_pullup mbuf len

-

Arrange that the first

Fa lenbytes of an

Vt mbuf chainare contiguous and lay in the data area of

Fa mbuf ,so they are accessible with

mtod (mbuf type .);It is important to remember that this may involve

reallocating some mbufs and moving data so all pointers

referencing data within the old mbuf chain

must be recalculated or made invalid.

Return the new

Vt mbuf chainon success,

NULLon failure

(the

Vt mbuf chainis freed in this case).

NoteIt does not allocate any

Vt mbuf clusters ,so

Fa lenmust be less than

MHLEN - Fn m_pulldown mbuf offset len offsetp

-

Arrange that

Fa lenbytes between

Fa offsetand

Fa offset + lenin the

Vt mbuf chainare contiguous and lay in the data area of

Fa mbuf ,so they are accessible with

mtod (mbuf type .);Fa len must be smaller than, or equal to, the size of an

Vt mbuf cluster .

Return a pointer to an intermediate

Vt mbufin the chain containing the requested region;

the offset in the data region of the

Vt mbuf chainto the data contained in the returned mbuf is stored in

Fa *offsetp .If

Fa offpis NULL, the region may be accessed using

mtod (mbuf type .);If

Fa offpis non-NULL, the region may be accessed using

mtod (mbuf uint8_t + *offsetp .);The region of the mbuf chain between its beginning and

Fa offis not modified, therefore it is safe to hold pointers to data within

this region before calling

m_pulldown (.); - Fn m_copym mbuf offset len how

-

Make a copy of an

Vt mbuf chainstarting

Fa offsetbytes from the beginning, continuing for

Fa lenbytes.

If

Fa lenis

M_COPYALLcopy to the end of the

Vt mbuf chain .Note

The copy is read-only, because the

Vt mbuf clustersare not copied, only their reference counts are incremented.

- Fn m_copypacket mbuf how

-

Copy an entire packet including header, which must be present.

This is an optimized version of the common case

m_copym (mbuf 0 M_COPYALL how .);Note

the copy is read-only, because the

Vt mbuf clustersare not copied, only their reference counts are incremented.

- Fn m_dup mbuf how

-

Copy a packet header

Vt mbuf chaininto a completely new

Vt mbuf chain ,including copying any

Vt mbuf clusters .Use this instead of

m_copypacket ();when you need a writable copy of an

Vt mbuf chain . - Fn m_copydata mbuf offset len buf

-

Copy data from an

Vt mbuf chainstarting

Fa offbytes from the beginning, continuing for

Fa lenbytes, into the indicated buffer

Fa buf . - Fn m_copyback mbuf offset len buf

-

Copy

Fa lenbytes from the buffer

Fa bufback into the indicated

Vt mbuf chain ,starting at

Fa offsetbytes from the beginning of the

Vt mbuf chain ,extending the

Vt mbuf chainif necessary.

NoteIt does not allocate any

Vt mbuf clusters ,just adds

Vt mbufsto the

Vt mbuf chain .It is safe to set

Fa offsetbeyond the current

Vt mbuf chainend: zeroed

Vt mbufswill be allocated to fill the space.

- Fn m_length mbuf last

-

Return the length of the

Vt mbuf chain ,and optionally a pointer to the last

Vt mbuf . - Fn m_dup_pkthdr to from how

-

Upon the function’s completion, the

Vt mbufFa to

will contain an identical copy of

Fa from->m_pkthdrand the per-packet attributes found in the

Vt mbuf chainFa from .

The

Vt mbufFa from

must have the flag

M_PKTHDRinitially set, and

Fa tomust be empty on entry.

- Fn m_move_pkthdr to from

-

Move

m_pkthdrand the per-packet attributes from the

Vt mbuf chainFa from

to the

Vt mbufFa to .

The

Vt mbufFa from

must have the flag

M_PKTHDRinitially set, and

Fa tomust be empty on entry.

Upon the function’s completion,

Fa fromwill have the flag

M_PKTHDRand the per-packet attributes cleared.

- Fn m_fixhdr mbuf

-

Set the packet-header length to the length of the

Vt mbuf chain . - Fn m_devget buf len offset ifp copy

-

Copy data from a device local memory pointed to by

Fa bufto an

Vt mbuf chain .The copy is done using a specified copy routine

Fa copy ,or

bcopy ();if

Fa copyis

NULL - Fn m_cat m n

-

Concatenate

Fa nto

Fa m .Both

Vt mbuf chainsmust be of the same type.

Fa Nis still valid after the function returned.

NoteIt does not handle

M_PKTHDRand friends.

- Fn m_split mbuf len how

-

Partition an

Vt mbuf chainin two pieces, returning the tail:

all but the first

Fa lenbytes.

In case of failure, it returns

NULLand attempts to restore the

Vt mbuf chainto its original state.

- Fn m_apply mbuf off len f arg

-

Apply a function to an

Vt mbuf chain ,at offset

Fa off ,for length

Fa lenbytes.

Typically used to avoid calls to

m_pullup ();which would otherwise be unnecessary or undesirable.

Fa argis a convenience argument which is passed to the callback function

Fa f .Each time

f ();is called, it will be passed

Fa arg ,a pointer to the

Fa datain the current mbuf, and the length

Fa lenof the data in this mbuf to which the function should be applied.

The function should return zero to indicate success;

otherwise, if an error is indicated, then

m_apply ();will return the error and stop iterating through the

Vt mbuf chain . - Fn m_getptr mbuf loc off

-

Return a pointer to the mbuf containing the data located at

Fa locbytes from the beginning of the

Vt mbuf chain .The corresponding offset into the mbuf will be stored in

Fa *off . - Fn m_defrag m0 how

-

Defragment an mbuf chain, returning the shortest possible

chain of mbufs and clusters.

If allocation fails and this can not be completed,

NULLwill be returned and the original chain will be unchanged.

Upon success, the original chain will be freed and the new

chain will be returned.

Fa howshould be either

M_TRYWAITor

M_DONTWAITdepending on the caller’s preference.

This function is especially useful in network drivers, where

certain long mbuf chains must be shortened before being added

to TX descriptor lists. - Fn m_unshare m0 how

-

Create a version of the specified mbuf chain whose

contents can be safely modified without affecting other users.

If allocation fails and this operation can not be completed,

NULLwill be returned.

The original mbuf chain is always reclaimed and the reference

count of any shared mbuf clusters is decremented.

Fa howshould be either

M_TRYWAITor

M_DONTWAITdepending on the caller’s preference.

As a side-effect of this process the returned

mbuf chain may be compacted.This function is especially useful in the transmit path of

network code, when data must be encrypted or otherwise

altered prior to transmission.

HARDWARE-ASSISTED CHECKSUM CALCULATION

This section currently applies to TCP/IP only.

In order to save the host CPU resources, computing checksums is

offloaded to the network interface hardware if possible.

The

m_pkthdr

member of the leading

Vt mbuf

of a packet contains two fields used for that purpose,

Vt int Va csum_flags

and

Vt int Va csum_data .

The meaning of those fields depends on the direction a packet flows in,

and on whether the packet is fragmented.

Henceforth,

csum_flags

or

csum_data

of a packet

will denote the corresponding field of the

m_pkthdr

member of the leading

Vt mbuf

in the

Vt mbuf chain

containing the packet.

On output, checksum offloading is attempted after the outgoing

interface has been determined for a packet.

The interface-specific field

ifnet.if_data.ifi_hwassist

(see

ifnet(9))

is consulted for the capabilities of the interface to assist in

computing checksums.

The

csum_flags

field of the packet header is set to indicate which actions the interface

is supposed to perform on it.

The actions unsupported by the network interface are done in the

software prior to passing the packet down to the interface driver;

such actions will never be requested through

csum_flags

The flags demanding a particular action from an interface are as follows:

- CSUM_IP

-

The IP header checksum is to be computed and stored in the

corresponding field of the packet.

The hardware is expected to know the format of an IP header

to determine the offset of the IP checksum field. - CSUM_TCP

-

The TCP checksum is to be computed.

(See below.) - CSUM_UDP

-

The UDP checksum is to be computed.

(See below.)

Should a TCP or UDP checksum be offloaded to the hardware,

the field

csum_data

will contain the byte offset of the checksum field relative to the

end of the IP header.

In this case, the checksum field will be initially

set by the TCP/IP module to the checksum of the pseudo header

defined by the TCP and UDP specifications.

For outbound packets which have been fragmented

by the host CPU, the following will also be true,

regardless of the checksum flag settings:

-

all fragments will have the flag

M_FRAGset in their

m_flagsfield;

-

the first and the last fragments in the chain will have

M_FIRSTFRAGor

M_LASTFRAGset in their

m_flagscorrespondingly;

-

the first fragment in the chain will have the total number

of fragments contained in its

csum_datafield.

The last rule for fragmented packets takes precedence over the one

for a TCP or UDP checksum.

Nevertheless, offloading a TCP or UDP checksum is possible for a

fragmented packet if the flag

CSUM_IP_FRAGS

is set in the field

ifnet.if_data.ifi_hwassist

associated with the network interface.

However, in this case the interface is expected to figure out

the location of the checksum field within the sequence of fragments

by itself because

csum_data

contains a fragment count instead of a checksum offset value.

On input, an interface indicates the actions it has performed

on a packet by setting one or more of the following flags in

csum_flags

associated with the packet:

- CSUM_IP_CHECKED

- The IP header checksum has been computed.

- CSUM_IP_VALID

-

The IP header has a valid checksum.

This flag can appear only in combination with

CSUM_IP_CHECKED - CSUM_DATA_VALID

-

The checksum of the data portion of the IP packet has been computed

and stored in the field

csum_datain network byte order.

- CSUM_PSEUDO_HDR

-

Can be set only along with

CSUM_DATA_VALIDto indicate that the IP data checksum found in

csum_dataallows for the pseudo header defined by the TCP and UDP specifications.

Otherwise the checksum of the pseudo header must be calculated by

the host CPU and added to

csum_datato obtain the final checksum to be used for TCP or UDP validation purposes.

If a particular network interface just indicates success or

failure of TCP or UDP checksum validation without returning

the exact value of the checksum to the host CPU, its driver can mark

CSUM_DATA_VALID

and

CSUM_PSEUDO_HDR

in

csum_flags

and set

csum_data

to

0xFFFF

hexadecimal to indicate a valid checksum.

It is a peculiarity of the algorithm used that the Internet checksum

calculated over any valid packet will be

0xFFFF

as long as the original checksum field is included.

For inbound packets which are IP fragments, all

csum_data

fields will be summed during reassembly to obtain the final checksum

value passed to an upper layer in the

csum_data

field of the reassembled packet.

The

csum_flags

fields of all fragments will be consolidated using logical AND

to obtain the final value for

csum_flags

Thus, in order to successfully

offload checksum computation for fragmented data,

all fragments should have the same value of

csum_flags

STRESS TESTING

When running a kernel compiled with the option

MBUF_STRESS_TEST

the following

sysctl(8)

-controlled options may be used to create

various failure/extreme cases for testing of network drivers

and other parts of the kernel that rely on

Vt mbufs .

- net.inet.ip.mbuf_frag_size

-

Causes

ip_output ();to fragment outgoing

Vt mbuf chainsinto fragments of the specified size.

Setting this variable to 1 is an excellent way to

test the long

Vt mbuf chainhandling ability of network drivers.

- kern.ipc.m_defragrandomfailures

-

Causes the function

m_defrag ();to randomly fail, returning

NULLAny piece of code which uses

m_defrag ();should be tested with this feature.

RETURN VALUES

See above.

SEE ALSO

ifnet(9),

mbuf_tags9

HISTORY

Vt Mbufs

appeared in an early version of

BSD .

Besides being used for network packets, they were used

to store various dynamic structures, such as routing table

entries, interface addresses, protocol control blocks, etc.

In more recent

Fx use of

Vt mbufs

is almost entirely limited to packet storage, with

uma(9)

zones being used directly to store other network-related memory.

Historically, the

Vt mbuf

allocator has been a special-purpose memory allocator able to run in

interrupt contexts and allocating from a special kernel address space map.

As of

Fx 5.3 ,

the

Vt mbuf

allocator is a wrapper around

uma(9),

allowing caching of

Vt mbufs ,

clusters, and

Vt mbuf

+ cluster pairs in per-CPU caches, as well as bringing other benefits of

slab allocation.

AUTHORS

The original

manual page was written by Yar Tikhiy.

The

uma(9)

Vt mbuf

allocator was written by Bosko Milekic.

Index

- NAME

- SYNOPSIS

-

- Mbuf allocation macros

- Mbuf utility macros

- Mbuf allocation functions

- Mbuf utility functions

- DESCRIPTION

-

- Macros and Functions

- HARDWARE-ASSISTED CHECKSUM CALCULATION

- STRESS TESTING

- RETURN VALUES

- SEE ALSO

- HISTORY

- AUTHORS

|

Header pointers needs to be reinitialized in icmp_error after m_pullup calls:

Date: Thu Sep 28 15:06:28 2017 -0700

Reinitialize mtod derived protocol header pointers in icmp_error after calling m_pullup

diff --git a/sys/netinet/ip_icmp.c b/sys/netinet/ip_icmp.c

index 5983b3386af..4f466236864 100644

--- a/sys/netinet/ip_icmp.c

+++ b/sys/netinet/ip_icmp.c

@@ -237,6 +237,12 @@ icmp_error(struct mbuf *n, int type, int code, uint32_t dest, int mtu)

if (n->m_len < oiphlen + sizeof(struct tcphdr) &&

((n = m_pullup(n, oiphlen + sizeof(struct tcphdr))) == NULL))

goto freeit;

+

+ /*

+ * Reinitialize pointers derived from mbuf data pointer,

+ * after calling m_pullup

+ */

+ oip = mtod(n, struct ip *);

th = (struct tcphdr *)((caddr_t)oip + oiphlen);

tcphlen = th->th_off << 2;

if (tcphlen < sizeof(struct tcphdr))

@@ -248,6 +254,14 @@ icmp_error(struct mbuf *n, int type, int code, uint32_t dest, int mtu)

if (n->m_len < oiphlen + tcphlen &&

((n = m_pullup(n, oiphlen + tcphlen)) == NULL))

goto freeit;

+

+ /*

+ * Reinitialize pointers derived from mbuf data pointer,

+ * after calling m_pullup

+ */

+ oip = mtod(n, struct ip *);

+ th = (struct tcphdr *)((caddr_t)oip + oiphlen);

+

icmpelen = max(tcphlen, min(V_icmp_quotelen,

ntohs(oip->ip_len) - oiphlen));

} else if (oip->ip_p == IPPROTO_SCTP) {

@@ -262,6 +276,12 @@ icmp_error(struct mbuf *n, int type, int code, uint32_t dest, int mtu)

if (n->m_len < oiphlen + sizeof(struct sctphdr) &&

(n = m_pullup(n, oiphlen + sizeof(struct sctphdr))) == NULL)

goto freeit;

+

+ /*

+ * Reinitialize pointers derived from mbuf data pointer,

+ * after calling m_pullup

+ */

+ oip = mtod(n, struct ip *);

icmpelen = max(sizeof(struct sctphdr),

min(V_icmp_quotelen, ntohs(oip->ip_len) - oiphlen));

sh = (struct sctphdr *)((caddr_t)oip + oiphlen);

@@ -272,7 +292,15 @@ icmp_error(struct mbuf *n, int type, int code, uint32_t dest, int mtu)

if (n->m_len < oiphlen + sizeof(struct sctphdr) + 8 &&

(n = m_pullup(n, oiphlen + sizeof(struct sctphdr) + 8)) == NULL)

goto freeit;

+

+ /*

+ * Reinitialize pointers derived from mbuf data pointer,

+ * after calling m_pullup

+ */

+ oip = mtod(n, struct ip *);

+ sh = (struct sctphdr *)((caddr_t)oip + oiphlen);

ch = (struct sctp_chunkhdr *)(sh + 1);

+

if (ch->chunk_type == SCTP_INITIATION) {

icmpelen = max(sizeof(struct sctphdr) + 8,

min(V_icmp_quotelen, ntohs(oip->ip_len) - oiphlen));

A commit references this bug: Author: ae Date: Fri Sep 29 06:24:45 UTC 2017 New revision: 324098 URL: https://svnweb.freebsd.org/changeset/base/324098 Log: Some mbuf related fixes in icmp_error() * check mbuf length before doing mtod() and accessing to IP header; * update oip pointer and all depending pointers after m_pullup(); * remove extra checks and extra parentheses, wrap long lines; PR: 222670 Reported by: Prabhakar Lakhera MFC after: 1 week Changes: head/sys/netinet/ip_icmp.c

A commit references this bug:

Author: ae

Date: Mon Oct 9 08:50:04 UTC 2017

New revision: 324426

URL: https://svnweb.freebsd.org/changeset/base/324426

Log:

MFC r324098:

Some mbuf related fixes in icmp_error()

* check mbuf length before doing mtod() and accessing to IP header;

* update oip pointer and all depending pointers after m_pullup();

* remove extra checks and extra parentheses, wrap long lines;

PR: 222670

Changes:

_U stable/11/

stable/11/sys/netinet/ip_icmp.c

|

NAME¶

mbuf — memory

management in the kernel IPC subsystem

SYNOPSIS¶

#include

<sys/param.h>

#include <sys/systm.h>

#include <sys/mbuf.h>

Mbuf allocation macros¶

MGET(struct

mbuf *mbuf, int

how, short

type);

MGETHDR(struct

mbuf *mbuf, int

how, short

type);

int

MCLGET(struct

mbuf *mbuf, int

how);

MEXTADD(struct mbuf

*mbuf, caddr_t buf, u_int

size, void (*free)(void *opt_arg1, void

*opt_arg2), void *opt_arg1, void

*opt_arg2, short flags, int

type);

Mbuf utility macros¶

mtod(struct

mbuf *mbuf,

type);

M_ALIGN(struct

mbuf *mbuf, u_int

len);

MH_ALIGN(struct

mbuf *mbuf, u_int

len);

int

M_LEADINGSPACE(struct

mbuf *mbuf);

int

M_TRAILINGSPACE(struct

mbuf *mbuf);

M_MOVE_PKTHDR(struct

mbuf *to, struct mbuf

*from);

M_PREPEND(struct

mbuf *mbuf, int

len, int how);

MCHTYPE(struct

mbuf *mbuf, short

type);

int

M_WRITABLE(struct

mbuf *mbuf);

Mbuf allocation functions¶

struct mbuf *

m_get(int

how, short

type);

struct mbuf *

m_get2(int

size, int how,

short type,

int flags);

struct mbuf *

m_getm(struct

mbuf *orig, int

len, int how,

short type);

struct mbuf *

m_getjcl(int

how, short type,

int flags,

int size);

struct mbuf *

m_getcl(int

how, short type,

int flags);

struct mbuf *

m_getclr(int

how, short

type);

struct mbuf *

m_gethdr(int

how, short

type);

struct mbuf *

m_free(struct

mbuf *mbuf);

void

m_freem(struct

mbuf *mbuf);

Mbuf utility functions¶

void

m_adj(struct

mbuf *mbuf, int

len);

void

m_align(struct

mbuf *mbuf, int

len);

int

m_append(struct

mbuf *mbuf, int

len, c_caddr_t

cp);

struct mbuf *

m_prepend(struct

mbuf *mbuf, int

len, int how);

struct mbuf *

m_copyup(struct

mbuf *mbuf, int

len, int

dstoff);

struct mbuf *

m_pullup(struct

mbuf *mbuf, int

len);

struct mbuf *

m_pulldown(struct

mbuf *mbuf, int

offset, int len,

int *offsetp);

struct mbuf *

m_copym(struct

mbuf *mbuf, int

offset, int len,

int how);

struct mbuf *

m_copypacket(struct

mbuf *mbuf, int

how);

struct mbuf *

m_dup(struct

mbuf *mbuf, int

how);

void

m_copydata(const

struct mbuf *mbuf, int

offset, int len,

caddr_t buf);

void

m_copyback(struct

mbuf *mbuf, int

offset, int len,

caddr_t buf);

struct mbuf *

m_devget(char *buf,

int len, int offset,

struct ifnet *ifp, void (*copy)(char

*from, caddr_t to, u_int len));

void

m_cat(struct

mbuf *m, struct mbuf

*n);

void

m_catpkt(struct

mbuf *m, struct mbuf

*n);

u_int

m_fixhdr(struct

mbuf *mbuf);

void

m_dup_pkthdr(struct

mbuf *to, struct mbuf

*from);

void

m_move_pkthdr(struct

mbuf *to, struct mbuf

*from);

u_int

m_length(struct

mbuf *mbuf, struct mbuf

**last);

struct mbuf *

m_split(struct

mbuf *mbuf, int

len, int how);

int

m_apply(struct

mbuf *mbuf, int

off, int len,

int (*f)(void *arg, void *data,

u_int len), void

*arg);

struct mbuf *

m_getptr(struct

mbuf *mbuf, int

loc, int *off);

struct mbuf *

m_defrag(struct

mbuf *m0, int

how);

struct mbuf *

m_collapse(struct

mbuf *m0, int how,

int maxfrags);

struct mbuf *

m_unshare(struct

mbuf *m0, int

how);

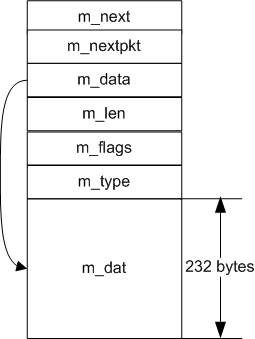

DESCRIPTION¶

An mbuf is a basic unit of memory management

in the kernel IPC subsystem. Network packets and socket buffers are stored

in mbufs. A network packet may span multiple

mbufs arranged into a mbuf chain

(linked list), which allows adding or trimming network headers with little

overhead.

While a developer should not bother with

mbuf internals without serious reason in order to

avoid incompatibilities with future changes, it is useful to understand the

general structure of an mbuf.

An mbuf consists of a variable-sized header

and a small internal buffer for data. The total size of an

mbuf, MSIZE, is a constant

defined in <sys/param.h>.

The mbuf header includes:

- m_next

- (struct mbuf *) A pointer to the next

mbuf in the mbuf chain. - m_nextpkt

- (struct mbuf *) A pointer to the next

mbuf chain in the queue. - m_data

- (caddr_t) A pointer to data attached to this

mbuf. - m_len

- (int) The length of the data.

- m_type

- (short) The type of the data.

- m_flags

- (int) The mbuf flags.

The mbuf flag bits are defined as

follows:

/* mbuf flags */ #define M_EXT 0x00000001 /* has associated external storage */ #define M_PKTHDR 0x00000002 /* start of record */ #define M_EOR 0x00000004 /* end of record */ #define M_RDONLY 0x00000008 /* associated data marked read-only */ #define M_PROTO1 0x00001000 /* protocol-specific */ #define M_PROTO2 0x00002000 /* protocol-specific */ #define M_PROTO3 0x00004000 /* protocol-specific */ #define M_PROTO4 0x00008000 /* protocol-specific */ #define M_PROTO5 0x00010000 /* protocol-specific */ #define M_PROTO6 0x00020000 /* protocol-specific */ #define M_PROTO7 0x00040000 /* protocol-specific */ #define M_PROTO8 0x00080000 /* protocol-specific */ #define M_PROTO9 0x00100000 /* protocol-specific */ #define M_PROTO10 0x00200000 /* protocol-specific */ #define M_PROTO11 0x00400000 /* protocol-specific */ #define M_PROTO12 0x00800000 /* protocol-specific */ /* mbuf pkthdr flags (also stored in m_flags) */ #define M_BCAST 0x00000010 /* send/received as link-level broadcast */ #define M_MCAST 0x00000020 /* send/received as link-level multicast */

The available mbuf types are defined as

follows:

/* mbuf types */ #define MT_DATA 1 /* dynamic (data) allocation */ #define MT_HEADER MT_DATA /* packet header */ #define MT_SONAME 8 /* socket name */ #define MT_CONTROL 14 /* extra-data protocol message */ #define MT_OOBDATA 15 /* expedited data */

The available external buffer types are defined as follows:

/* external buffer types */ #define EXT_CLUSTER 1 /* mbuf cluster */ #define EXT_SFBUF 2 /* sendfile(2)'s sf_bufs */ #define EXT_JUMBOP 3 /* jumbo cluster 4096 bytes */ #define EXT_JUMBO9 4 /* jumbo cluster 9216 bytes */ #define EXT_JUMBO16 5 /* jumbo cluster 16184 bytes */ #define EXT_PACKET 6 /* mbuf+cluster from packet zone */ #define EXT_MBUF 7 /* external mbuf reference (M_IOVEC) */ #define EXT_NET_DRV 252 /* custom ext_buf provided by net driver(s) */ #define EXT_MOD_TYPE 253 /* custom module's ext_buf type */ #define EXT_DISPOSABLE 254 /* can throw this buffer away w/page flipping */ #define EXT_EXTREF 255 /* has externally maintained ref_cnt ptr */

If the M_PKTHDR flag is set, a

struct pkthdr m_pkthdr is added

to the mbuf header. It contains a pointer to the

interface the packet has been received from (struct

ifnet *rcvif), and the total packet length

(int len). Optionally, it may

also contain an attached list of packet tags (struct

m_tag). See mbuf_tags(9) for details. Fields used in

offloading checksum calculation to the hardware are kept in

m_pkthdr as well. See

HARDWARE-ASSISTED

CHECKSUM CALCULATION for details.

If small enough, data is stored in the internal data buffer of an

mbuf. If the data is sufficiently large, another

mbuf may be added to the mbuf

chain, or external storage may be associated with the

mbuf. MHLEN bytes of data can

fit into an mbuf with the

M_PKTHDR flag set, MLEN

bytes can otherwise.

If external storage is being associated with an

mbuf, the m_ext header is added

at the cost of losing the internal data buffer. It includes a pointer to

external storage, the size of the storage, a pointer to a function used for

freeing the storage, a pointer to an optional argument that can be passed to

the function, and a pointer to a reference counter. An

mbuf using external storage has the

M_EXT flag set.

The system supplies a macro for allocating the desired external

storage buffer, MEXTADD.

The allocation and management of the reference counter is handled

by the subsystem.

The system also supplies a default type of external storage buffer

called an mbuf cluster. Mbuf

clusters can be allocated and configured with the use of the

MCLGET macro. Each mbuf

cluster is MCLBYTES in size, where MCLBYTES is

a machine-dependent constant. The system defines an advisory macro

MINCLSIZE, which is the smallest amount of data to

put into an mbuf cluster. It is equal to

MHLEN plus one. It is typically preferable to store

data into the data region of an mbuf, if size permits,

as opposed to allocating a separate mbuf cluster to

hold the same data.

Macros and Functions¶

There are numerous predefined macros and functions that provide

the developer with common utilities.

mtod(mbuf,

type)- Convert an mbuf pointer to a data pointer. The macro

expands to the data pointer cast to the specified

type. Note: It is advisable to

ensure that there is enough contiguous data in mbuf.

See

m_pullup()

for details. MGET(mbuf,

how, type)- Allocate an mbuf and initialize it to contain

internal data. mbuf will point to the allocated

mbuf on success, or be set to

NULLon failure. The how

argument is to be set toM_WAITOKor

M_NOWAIT. It specifies whether the caller is

willing to block if necessary. A number of other functions and macros

related to mbufs have the same argument because they

may at some point need to allocate new mbufs. MGETHDR(mbuf,

how, type)- Allocate an mbuf and initialize it to contain a

packet header and internal data. SeeMGET() for

details. MEXTADD(mbuf,

buf, size,

free, opt_arg1,

opt_arg2, flags,

type)- Associate externally managed data with mbuf. Any

internal data contained in the mbuf will be discarded, and the

M_EXTflag will be set. The

buf and size arguments are the

address and length, respectively, of the data. The

free argument points to a function which will be

called to free the data when the mbuf is freed; it is only used if

type isEXT_EXTREF. The

opt_arg1 and opt_arg2

arguments will be passed unmodified to free. The

flags argument specifies additional

mbuf flags; it is not necessary to specify

M_EXT. Finally, the type

argument specifies the type of external data, which controls how it will

be disposed of when the mbuf is freed. In most

cases, the correct value isEXT_EXTREF. MCLGET(mbuf,

how)- Allocate and attach an mbuf cluster to

mbuf. On success, a non-zero value returned;

otherwise, 0. Historically, consumers would check for success by testing

theM_EXTflag on the mbuf, but this is now

discouraged to avoid unnecessary awareness of the implementation of

external storage in protocol stacks and device drivers. M_ALIGN(mbuf,

len)- Set the pointer mbuf->m_data to place an object

of the size len at the end of the internal data area

of mbuf, long word aligned. Applicable only if

mbuf is newly allocated with

MGET() orm_get(). MH_ALIGN(mbuf,

len)- Serves the same purpose as

M_ALIGN() does, but

only for mbuf newly allocated with

MGETHDR() orm_gethdr(),

or initialized by

m_dup_pkthdr()

or

m_move_pkthdr(). m_align(mbuf,

len)- Services the same purpose as

M_ALIGN() but handles

any type of mbuf. M_LEADINGSPACE(mbuf)- Returns the number of bytes available before the beginning of data in

mbuf. M_TRAILINGSPACE(mbuf)- Returns the number of bytes available after the end of data in

mbuf. M_PREPEND(mbuf,

len, how)- This macro operates on an mbuf chain. It is an

optimized wrapper form_prepend() that can make

use of possible empty space before data (e.g. left after trimming of a

link-layer header). The new mbuf chain pointer or

NULLis in mbuf after the

call. M_MOVE_PKTHDR(to,

from)- Using this macro is equivalent to calling

m_move_pkthdr(to,

from). M_WRITABLE(mbuf)- This macro will evaluate true if mbuf is not marked

M_RDONLYand if either mbuf

does not contain external storage or, if it does, then if the reference

count of the storage is not greater than 1. The

M_RDONLYflag can be set in

mbuf->m_flags. This can be achieved during setup

of the external storage, by passing theM_RDONLY

bit as a flags argument to the

MEXTADD() macro, or can be directly set in

individual mbufs. MCHTYPE(mbuf,

type)- Change the type of mbuf to

type. This is a relatively expensive operation and

should be avoided.

The functions are:

m_get(how,

type)- A function version of

MGET()

for non-critical paths. m_get2(size,

how, type,

flags)- Allocate an mbuf with enough space to hold specified

amount of data. m_getm(orig,

len, how,

type)- Allocate len bytes worth of

mbufs and mbuf clusters if

necessary and append the resulting allocated mbuf

chain to the mbuf chain

orig, if it is

non-NULL. If the

allocation fails at any point, free whatever was allocated and return

NULL. If orig is

non-NULL, it will not be

freed. It is possible to usem_getm() to either

append len bytes to an existing

mbuf or mbuf chain (for

example, one which may be sitting in a pre-allocated ring) or to simply

perform an all-or-nothing mbuf and

mbuf cluster allocation. m_gethdr(how,

type)- A function version of

MGETHDR() for non-critical

paths. m_getcl(how,

type, flags)- Fetch an mbuf with a mbuf

cluster attached to it. If one of the allocations fails, the entire

allocation fails. This routine is the preferred way of fetching both the

mbuf and mbuf cluster

together, as it avoids having to unlock/relock between allocations.

ReturnsNULLon failure. m_getjcl(how,

type, flags,

size)- This is like

m_getcl() but it the size of the

cluster allocated will be large enough for size

bytes. m_getclr(how,

type)- Allocate an mbuf and zero out the data region.

m_free(mbuf)- Frees mbuf. Returns m_next of

the freed mbuf.

The functions below operate on mbuf

chains.

m_freem(mbuf)- Free an entire mbuf chain, including any external

storage. m_adj(mbuf,

len)- Trim len bytes from the head of an

mbuf chain if len is positive,

from the tail otherwise. m_append(mbuf,

len, cp)- Append len bytes of data cp to

the mbuf chain. Extend the mbuf chain if the new

data does not fit in existing space. m_prepend(mbuf,

len, how)- Allocate a new mbuf and prepend it to the

mbuf chain, handleM_PKTHDR

properly. Note: It does not allocate any

mbuf clusters, so len must be

less thanMLENorMHLEN,

depending on theM_PKTHDRflag setting. m_copyup(mbuf,

len, dstoff)- Similar to

m_pullup() but copies

len bytes of data into a new mbuf at

dstoff bytes into the mbuf. The

dstoff argument aligns the data and leaves room for

a link layer header. Returns the new mbuf chain on

success, and frees the mbuf chain and returns

NULLon failure. Note: The

function does not allocate mbuf clusters, so

len + dstoff must be less than

MHLEN. m_pullup(mbuf,

len)- Arrange that the first len bytes of an

mbuf chain are contiguous and lay in the data area

of mbuf, so they are accessible with

mtod(mbuf,

type). It is important to remember that this may

involve reallocating some mbufs and moving data so all pointers

referencing data within the old mbuf chain must be recalculated or made

invalid. Return the new mbuf chain on success,

NULLon failure (the mbuf

chain is freed in this case). Note: It does not

allocate any mbuf clusters, so

len must be less than or equal to

MHLEN. m_pulldown(mbuf,

offset, len,

offsetp)- Arrange that len bytes between

offset and offset + len in the

mbuf chain are contiguous and lay in the data area

of mbuf, so they are accessible with

mtod(mbuf,

type). len must be smaller

than, or equal to, the size of an mbuf cluster.

Return a pointer to an intermediate mbuf in the

chain containing the requested region; the offset in the data region of

the mbuf chain to the data contained in the returned

mbuf is stored in *offsetp. If

offsetp is NULL, the region may be accessed using

mtod(mbuf,

type). If offsetp is non-NULL,

the region may be accessed using

mtod(mbuf,

uint8_t) + *offsetp. The region of the mbuf chain

between its beginning and offset is not modified,

therefore it is safe to hold pointers to data within this region before

callingm_pulldown(). m_copym(mbuf,

offset, len,

how)- Make a copy of an mbuf chain starting

offset bytes from the beginning, continuing for

len bytes. If len is

M_COPYALL, copy to the end of the

mbuf chain. Note: The copy is

read-only, because the mbuf clusters are not copied,

only their reference counts are incremented. m_copypacket(mbuf,

how)- Copy an entire packet including header, which must be present. This is an

optimized version of the common case

m_copym(mbuf,

0, M_COPYALL,

how). Note: the copy is read-only,

because the mbuf clusters are not copied, only their

reference counts are incremented. m_dup(mbuf,

how)- Copy a packet header mbuf chain into a completely

new mbuf chain, including copying any

mbuf clusters. Use this instead of

m_copypacket() when you need a writable copy of an

mbuf chain. m_copydata(mbuf,

offset, len,

buf)- Copy data from an mbuf chain starting

off bytes from the beginning, continuing for

len bytes, into the indicated buffer

buf. m_copyback(mbuf,

offset, len,

buf)- Copy len bytes from the buffer

buf back into the indicated mbuf

chain, starting at offset bytes from the

beginning of the mbuf chain, extending the

mbuf chain if necessary. Note: It

does not allocate any mbuf clusters, just adds

mbufs to the mbuf chain. It is

safe to set offset beyond the current

mbuf chain end: zeroed mbufs

will be allocated to fill the space. m_length(mbuf,

last)- Return the length of the mbuf chain, and optionally

a pointer to the last mbuf. m_dup_pkthdr(to,

from, how)- Upon the function’s completion, the mbuf

to will contain an identical copy of

from->m_pkthdr and the per-packet attributes

found in the mbuf chain from.

The mbuf from must have the

flagM_PKTHDRinitially set, and

to must be empty on entry. m_move_pkthdr(to,

from)- Move m_pkthdr and the per-packet attributes from the

mbuf chain from to the

mbuf to. The

mbuf from must have the flag

M_PKTHDRinitially set, and

to must be empty on entry. Upon the function’s

completion, from will have the flag

M_PKTHDRand the per-packet attributes

cleared. m_fixhdr(mbuf)- Set the packet-header length to the length of the mbuf

chain. m_devget(buf,

len, offset,

ifp, copy)- Copy data from a device local memory pointed to by

buf to an mbuf chain. The copy

is done using a specified copy routine copy, or

bcopy()

if copy isNULL. m_cat(m,

n)- Concatenate n to m. Both

mbuf chains must be of the same type.

n is not guaranteed to be valid after

m_cat() returns.m_cat()

does not update any packet header fields or free mbuf tags. m_catpkt(m,

n)- A variant of

m_cat() that operates on packets.

Both m and n must contain

packet headers. n is not guaranteed to be valid

afterm_catpkt() returns. m_split(mbuf,

len, how)- Partition an mbuf chain in two pieces, returning the

tail: all but the first len bytes. In case of

failure, it returnsNULLand attempts to restore

the mbuf chain to its original state. m_apply(mbuf,

off, len,

f, arg)- Apply a function to an mbuf chain, at offset

off, for length len bytes.

Typically used to avoid calls tom_pullup() which

would otherwise be unnecessary or undesirable. arg

is a convenience argument which is passed to the callback function

f.Each time

f() is

called, it will be passed arg, a pointer to the

data in the current mbuf, and the length

len of the data in this mbuf to which the function

should be applied.The function should return zero to indicate

success; otherwise, if an error is indicated, then

m_apply()

will return the error and stop iterating through the

mbuf chain. m_getptr(mbuf,

loc, off)- Return a pointer to the mbuf containing the data located at

loc bytes from the beginning of the

mbuf chain. The corresponding offset into the mbuf

will be stored in *off. m_defrag(m0,

how)- Defragment an mbuf chain, returning the shortest possible chain of mbufs

and clusters. If allocation fails and this can not be completed,

NULLwill be returned and the original chain will

be unchanged. Upon success, the original chain will be freed and the new

chain will be returned. how should be either

M_WAITOKorM_NOWAIT,

depending on the caller’s preference.This function is especially useful in network drivers, where

certain long mbuf chains must be shortened before being added to TX

descriptor lists. m_collapse(m0,

how, maxfrags)- Defragment an mbuf chain, returning a chain of at most

maxfrags mbufs and clusters. If allocation fails or

the chain cannot be collapsed as requested,NULL

will be returned, with the original chain possibly modified. As with

m_defrag(),

how should be one of

M_WAITOKorM_NOWAIT. m_unshare(m0,

how)- Create a version of the specified mbuf chain whose contents can be safely

modified without affecting other users. If allocation fails and this

operation can not be completed,NULLwill be

returned. The original mbuf chain is always reclaimed and the reference

count of any shared mbuf clusters is decremented.

how should be either

M_WAITOKorM_NOWAIT,

depending on the caller’s preference. As a side-effect of this process the

returned mbuf chain may be compacted.This function is especially useful in the transmit path of

network code, when data must be encrypted or otherwise altered prior to

transmission.

HARDWARE-ASSISTED CHECKSUM CALCULATION¶

This section currently applies to TCP/IP only. In order to save

the host CPU resources, computing checksums is offloaded to the network

interface hardware if possible. The m_pkthdr member of

the leading mbuf of a packet contains two fields used

for that purpose, int csum_flags

and int csum_data. The meaning

of those fields depends on the direction a packet flows in, and on whether

the packet is fragmented. Henceforth, csum_flags or

csum_data of a packet will denote the corresponding

field of the m_pkthdr member of the leading

mbuf in the mbuf chain

containing the packet.

On output, checksum offloading is attempted after the outgoing

interface has been determined for a packet. The interface-specific field

ifnet.if_data.ifi_hwassist (see

ifnet(9)) is consulted for the capabilities of the

interface to assist in computing checksums. The

csum_flags field of the packet header is set to

indicate which actions the interface is supposed to perform on it. The

actions unsupported by the network interface are done in the software prior

to passing the packet down to the interface driver; such actions will never

be requested through csum_flags.

The flags demanding a particular action from an interface are as

follows:

CSUM_IP- The IP header checksum is to be computed and stored in the corresponding

field of the packet. The hardware is expected to know the format of an IP

header to determine the offset of the IP checksum field. CSUM_TCP- The TCP checksum is to be computed. (See below.)

CSUM_UDP- The UDP checksum is to be computed. (See below.)

Should a TCP or UDP checksum be offloaded to the hardware, the

field csum_data will contain the byte offset of the

checksum field relative to the end of the IP header. In this case, the

checksum field will be initially set by the TCP/IP module to the checksum of

the pseudo header defined by the TCP and UDP specifications.

On input, an interface indicates the actions it has performed on a

packet by setting one or more of the following flags in

csum_flags associated with the packet:

CSUM_IP_CHECKED- The IP header checksum has been computed.

CSUM_IP_VALID- The IP header has a valid checksum. This flag can appear only in

combination withCSUM_IP_CHECKED. CSUM_DATA_VALID- The checksum of the data portion of the IP packet has been computed and

stored in the field csum_data in network byte

order. CSUM_PSEUDO_HDR- Can be set only along with

CSUM_DATA_VALIDto

indicate that the IP data checksum found in

csum_data allows for the pseudo header defined by

the TCP and UDP specifications. Otherwise the checksum of the pseudo

header must be calculated by the host CPU and added to

csum_data to obtain the final checksum to be used

for TCP or UDP validation purposes.

If a particular network interface just indicates success or

failure of TCP or UDP checksum validation without returning the exact value

of the checksum to the host CPU, its driver can mark

CSUM_DATA_VALID and

CSUM_PSEUDO_HDR in csum_flags,

and set csum_data to 0xFFFF

hexadecimal to indicate a valid checksum. It is a peculiarity of the

algorithm used that the Internet checksum calculated over any valid packet

will be 0xFFFF as long as the original checksum

field is included.

STRESS TESTING¶

When running a kernel compiled with the option

MBUF_STRESS_TEST, the following

sysctl(8)-controlled options may be used to create various

failure/extreme cases for testing of network drivers and other parts of the

kernel that rely on mbufs.

- net.inet.ip.mbuf_frag_size

- Causes

ip_output()

to fragment outgoing mbuf chains into fragments of

the specified size. Setting this variable to 1 is an excellent way to test

the long mbuf chain handling ability of network

drivers. - kern.ipc.m_defragrandomfailures

- Causes the function

m_defrag()

to randomly fail, returningNULL. Any piece of

code which usesm_defrag() should be tested with

this feature.

RETURN VALUES¶

See above.

SEE ALSO¶

ifnet(9), mbuf_tags(9)

HISTORY¶

Mbufs appeared in an early version of

BSD. Besides being used for network packets, they

were used to store various dynamic structures, such as routing table

entries, interface addresses, protocol control blocks, etc. In more recent

FreeBSD use of mbufs is almost

entirely limited to packet storage, with uma(9) zones

being used directly to store other network-related memory.

Historically, the mbuf allocator has been a

special-purpose memory allocator able to run in interrupt contexts and

allocating from a special kernel address space map. As of

FreeBSD 5.3, the mbuf

allocator is a wrapper around uma(9), allowing caching of

mbufs, clusters, and mbuf +

cluster pairs in per-CPU caches, as well as bringing other benefits of slab

allocation.

The original mbuf manual page was written

by Yar Tikhiy. The uma(9)

mbuf allocator was written by

Bosko Milekic.

Эта статья будет полезна системным администраторам и программистам, работающим в ядре FreeBSD. Осмыслив изложенное здесь, можно понять, почему же бывает паника по kmem, что такое состояние

keglim

/

zoneli

, как читать непонятные циферки в выводе

vmstat -m

/

vmstat -z

, и что же такое эти самые

mbuf

и

nmbclusters

. Программистам, приступающим к работе не в сетевой подсистеме, всё равно будет интересно узнать о дополнительных интерфейсах, помимо привычных

malloc()

/

free()

, и отличиях этих стандартных функций.

Поскольку эта статья — введение в комплекс связанных обширных тем, она предполагает наличие некоторых базовых понятий (например, чем виртуальная память отличается от физической), и не углубляется в некоторые специфичные вещи (типа packet secondary zone), особенно появившиеся не так давно.

| Операционная система делает три вещи — управляет оборудованием, распределяет память и мешает работе программиста. Причем ни с первым, ни со вторым она обычно не справляется.

(с) фольклор |

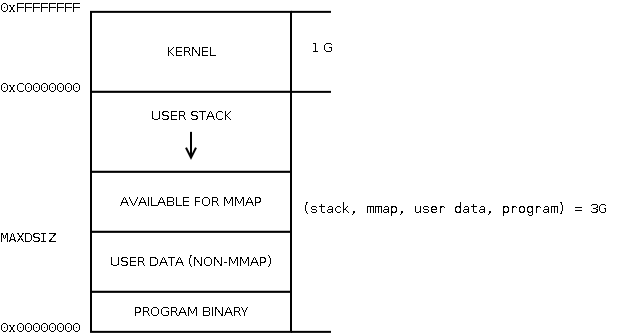

Виртуальная память и адресное пространство

Рассмотрим традиционное распределение виртуальной памяти процесса на i386 (рисовано по картинке Matthew Dillon псевдографикой):

То, что относится к процессу, нас не интересует, а интересует сейчас та часть, которая KERNEL. Эта часть, которая при параметрах компиляции по умолчанию на i386 составляет 1 Гб — общая для всех процессов на машине, и при этом присутствует (отображается) в адресном пространстве каждого из них. Представим себе, что у нас работает 10 процессов на машине архитектуры i386 с 40 Гб физической памяти (Нет, это не опечатка. Представьте). Тогда каждый процесс мог бы использовать полные доступные ему 2^32 = 4 Гб виртуальной памяти, и все 10 поместились бы в 40 Гб физической? Нет, потому что каждому доступно только 3 Гб адресного пространства — и если они съедят доступную им память по полной, и то же самое сделает ядро, будет всего 31 Гб в сумме.

Откуда эти цифры берутся? Один элемент таблицы страниц, то есть описывающий 1 страницу памяти, занимает 4 байта на i386. Размер страницы — 4 Кб. Один уровень таблицы страниц занимает опять же 1 страницу, т.е. 4 Кб — это 1024 записи, итого охватывающих 4 Мб виртуальной памяти (далее используется следующий уровень таблицы страниц). Вот об этих страницах каталогов, охватывающих по 4 Мб, и идёт речь в

KVA_PAGES

. В случае PAE цифры другие, там один элемент 8 байт, а 1 уровень каталога страниц занимает 4 страницы, охватывая 2 Мб виртуальной памяти — поэтому цифры

KVA_PAGES

умножаются на 2. Подробнее можно посмотреть в файлах

pmap.h

,

param.h

,

vmparam.h

в

/sys/i386/include/

(или аналоге для другой архитектуры), в районе определений с зубодробительными именами типа

VADDR(KPTDI+NKPDE-1, NPTEPG-1)

.

Этот подход, когда память ядра находится в том же адресном пространстве процесса, не уникален для FreeBSD, и применяется во всех современных ОС, разве что граница по умолчанию может варьироваться (в Windows NT было 2 Гб). Её можно задать при компиляции ядра, например,

options KVA_PAGES=384

выделит ядру 1.5 Гб, оставив процессам всего 2.5; задается в единицах по 4 Мб и должно быть кратно 16 Мб (т.е. 256, 260, 264 и т.д.). Отсюда понятно, что если в ядре есть большой потребитель памяти, типа

mdconfig -t malloc

или ZFS, то адресного пространства ядра может запросто не хватить, даже если на машине еще есть гора свободной памяти. На amd64, понятное дело, ядру отвели 512 Гб пространства (это же просто виртуальные адреса, чего с ними мелочиться), так что проблем по этой причине там уже не возникнет.

Но это всего лишь виртуальные адреса, а дальше у нас реальная память. Почти вся принадлежащая ядру память не подлежит вытеснению в swap (представьте, например, что при обработке прерывания от сетевухи понадобилась лежащая в свопе ядерная память, а своп где-то на сетевом диске), но некоторые исключения всё-таки есть, типа буферов анонимных пайпов (это которые

sort | head

, например). Кроме того, память приложений, которой было сказано

mlock()

, также является запрещенной к свопингу (см.

memorylocked

в

ulimit

). Вся память, которая не может быть отправлена в своп, видна в

top

как Wired. Память же ядра, которая нас будет интересовать дальше, называется kmem. К сожалению, по указанным выше причинам, нельзя сказать, что

WIRED == KMEM

. Иными словами, kmem — память тоже виртуальная. Собственно, kmem — не единственный регион памяти ядра (есть и другие

vm_map

, размеры которых управляются, например,

kern.ipc.maxpipekva

,

kern.nbuf

,

kern.nswbuf

и др.). Просто именно из этого региона выделяется память для UMA и

malloc()

, о которых речь будет идти дальше. Размер kmem считается по такой формуле:

vm.kmem_size = min(max(max(VM_KMEM_SIZE, Physical_memory / VM_KMEM_SIZE_SCALE), VM_KMEM_SIZE_MIN), VM_KMEM_SIZE_MAX)

Выглядит страшно, но смысл очень простой. Рассмотрим как пример какой-нибудь Первопень™, стоящий на подоконнике, c 80 Мб ОЗУ:

vm.kvm_size: 1073737728 1 Гб минус 1 страница: полный размер памяти ядра vm.kvm_free: 947908608 совсем нераспределенных адресов памяти ядра vm.kmem_size_scale: 3 vm.kmem_size_max: 335544320 320 Мб: константа для автотюнинга vm.kmem_size_min: 0 vm.kmem_size: 25165824 24 Мб: выбранный при загрузке макс. размер kmem vm.kmem_map_size: 15175680 занято в kmem vm.kmem_map_free: 9539584 свободно в kmem

Первые два параметра, хотя и называются KVM (kernel virtual memory), обозначают kernel virtual address space (KVA). Считаются они так:

kvm_size = VM_MAX_KERNEL_ADDRESS — KERNBASE; kvm_free = VM_MAX_KERNEL_ADDRESS — kernel_vm_end;

Большими буквами в коде BSD-стиля принято обозначать константы, задаваемые только при компиляции (а также макросы) — это те самые размеры в 1 Гб, рассмотренные выше. В переменной

kernel_vm_end

ядро хранит конец используемой части KVM (расширяется при необходимости). Теперь о вычислении

vm.kmem_size

на примере. Сначала доступная память машины делится на

vm.kmem_size_scale

, получаем 24 Мб. Далее, kmem не может быть больше

vm.kmem_size_max

и меньше

vm.kmem_size_min

. В примере

vm.kmem_size_min

нулевой, в этом случае используется константа VM_KMEM_SIZE на этапе компиляции (она составляет 12 Мб для всех платформ). Разумеется, настройки

vm.kmem_size_min

и

vm.kmem_size_max

предназначены для автоподбора (одно и то же ядро/loader.conf может грузиться на разном железе), поэтому

vm.kmem_size

может быть задан явно, в этом случае он перекроет собой

vm.kmem_size_max

. Хотя и здесь предусмотрена страховка — он не может быть больше двух размеров физической памяти. Ближайшая машина с amd64 рапортует, что на ней

vm.kmem_size_scale

равен 1, и

kmem_size

равен почти что всем 4 Гб ОЗУ (хотя занято в нем куда меньше).

Подробнее о виртуальной памяти в современных ОС можно почитать на http://www.intuit.ru/department/os/osintro/ (первые главы).

Slab-аллокатор UMA и ядерный malloc

Почему такое внимание было уделено kmem, в отличие от остальных регионов памяти ядра? Потому что именно он используется для привычного

malloc()

и нового slab-аллокатора UMA. Зачем был нужен новый? Рассмотрим, как выглядела память в какой-то момент времени работы при традиционных аллокаторах:

...->|<-- 40 байт -->|<-- 97 байт -->|<-- 50 байт -->|<-- 20 байт -->|<-- 80 байт --->|<-- 250 байт -->|<-...

занято дырка занято занято дырка занято

Здесь в какой-то момент времени было 6 объектов, потом 2 освободилось. Теперь, если где-либо делается запрос

malloc(100)

, то аллокатор будет вынужден не только оставить неиспользованными дыры от старых объектов суммой 177 байт, но и последовательно перебрать все эти свободные области только затем, чтобы увидеть, что запрашиваемые 100 байт туда не влезут. А теперь представьте, что на машину непрерывно прибывают со скоростью 100 Мбит/с пакеты самого разного размера? Память под них очень быстро станет фрагментированной, с большими потерями и затратами времени на поиск.

Конечно, с этим довольно быстро стали бороться — деревья и другие приемы вместо линейного поиска, округления размеров, разные пулы для объектов сильно отличающихся размеров, и т.д. Но основным средством оставались всяческие кэши в разных подсистемах, фактически, собственные небольшие аллокаторы — чтоб поменьше обращаться к системному. А когда прикладные программисты (имеются в виду в том числе подсистемы-потребители в ядре) начинают писать свои аллокаторы памяти, это плохо. И не тем, что свой аллокатор скорее всего будет похуже, а тем, что не учитывались интересы других подсистем — много памяти висело в зарезервированных пулах (сейчас не используем, а другим бы эта память пригодилась), паттерны нагрузки тоже не учитывали соседей.

Наиболее продвинутым решением, которое используется в общем случае и сейчас — когда slab-аллокаторы использовать нельзя — являются аллокаторы, выделяющие память блоками с округлением до 2^n байт. То есть, для

malloc(50)

будет выделен кусок в 64 байт, а для

malloc(97)

— кусок в 128 байт. Блоки группируются между собой в пулах по размеру, что позволяет избежать проблем с фрагментацией и поисков — ценой потерь памяти, могущих достигать 50%. Стандартный

malloc(9)

ядра, появившийся еще в 4.4BSD, был сделан именно так. Рассмотрим его интерфейс подробнее.

MALLOC_DEFINE(M_NETGRAPH_HOOK, "netgraph_hook", "netgraph hook structures"); hook = malloc(sizeof(*hook), M_NETGRAPH_HOOK, M_NOWAIT | M_ZERO); free(hook, M_NETGRAPH_HOOK);

Если ваш тип malloc используется где-то еще за пределами одного файла, то кроме

MALLOC_DEFINE(M_FOO, «foo», «foo module mem»)

потребуется еще

MALLOC_DECLARE(M_FOO)

— см. определение этих макросов:

#define MALLOC_DEFINE(type, shortdesc, longdesc)

struct malloc_type type[1] = {

...

#define MALLOC_DECLARE(type)

extern struct malloc_type type[1]

(в старом коде был еще макрос

MALLOC()

в дополнение к функции, сразу приводивший типы, не так давно его отовсюду выпилили)

Как видно, по сравнению с привычными

malloc()

/

free()

в прикладных приложениях, здесь указывается еще один аргумент: тип malloc, определяемый где-нибудь в начале макросом

MALLOC_DEFINE()

; а для самого

malloc()

еще и флаги. Что это за тип? Он предназначен для ведения статистики. Аллокатор отслеживает, сколько для каждого типа сейчас выделено объектов, байт, и каких размеров блоков. Системный администратор может запустить команду

vmstat -m

и увидеть такую информацию:

- Type: название подсистемы из MALLOC_DEFINE

- InUse: сколько сейчас выделено объектов для этой подсистемы

- MemUse: сколько эта подсистема заняла памяти (выводится всегда в килобайтах с округлением вниз)

- Requests: сколько всего было запросов на выделение объектов для этой подсистемы с момента загрузки

- Size(s): размеры блоков, используемые для объектов этой подсистемы

Например:

$ vmstat -m

Type InUse MemUse HighUse Requests Size(s)

sigio 2 1K — 4 32

filedesc 92 31K — 256346 16,32,64,128,256,512,1024,2048,4096

kenv 93 7K — 94 16,32,64,128,4096

kqueue 4 6K — 298093 128,1024,4096

proc-args 47 3K — 881443 16,32,64,128,256

devbuf 233 5541K — 376 16,32,64,128,256,512,1024,2048,4096

CAM dev queue 1 1K — 1 64

Здесь нужно отметить, что округления блоков идут до 2^n только размера страницы, дальше идет округление до целого числа страниц. То есть на запрос в 10 Кб будет выделено 12 Кб, а не 16.

Остается рассмотреть только флаги вызова

malloc()

.

M_ZERO

понятен из названия — выделяемая память будет сразу заполнена нулями. Более важны два других взаимоисключающих флага, один из которых обязательно должен быть указан:

- M_NOWAIT — выделить память из доступного сейчас подмножества. Если её сейчас там не хватает, malloc() вернет NULL. Ситуация очень вероятная, поэтому её надо всегда обрабатывать (в отличие от поведения malloc() в юзерленде). Этот флаг обязателен при вызове из контекста прерывания — то есть, например, при обработке пакета в сети.

- M_WAITOK — если сейчас памяти не хватает, вызвавший тред останавливается и ждет, когда она появится. Поэтому этот флаг нельзя использовать в контексте прерывания, но можно, например, в контексте syscall — то есть по запросу от пользовательского процесса. С этим флагом malloc() никогда не вернет NULL, а всегда выдаст память (может ждать и очень долго) — если памяти не хватает совсем, система говорит panic: kmem_malloc(размер): kmem_map too small

Следует обратить внимание, что эта паника, как правило, возникает не в той подсистеме, которая всю память сожрала. Типичный пример из жизни: небольшой роутер падает в такую панику в UFS с запросом в 16384 байта — это какой-то процесс хочет прочитать что-то с диска, и для блока с диска вызывается

malloc(16384, …, M_WAITOK)

— памяти в kmem больше нет, всё, сохраняется корка. После ребута делаем

vmstat -m -M /var/crash/vmcore.1

и видим, что всю память сожрал NAT на базе

libalias

— просто он с

M_NOWAIT

обламывался в получении еще памяти, а система пока жила.

Еще в конце 80-х начались исследования специальных аллокаторов, предназначенных для отдельных подсистем. Они показывали результаты лучше общего аллокатора, но страдали от указанных в начале этого раздела недостатков — плохое взаимодействие с другими подсистемами. Самый важный полученный в ислледованиях вывод: «…a customized segregated-storage allocator — one that has a priori knowledge of the most common allocation sizes — is usually optimal in both space and time».

И вот в 1994 году, опираясь на этот вывод, Jeff Bonwick из Sun Microsystems придумал (и реализовал в Solaris) так называемый Slab Allocator (название отсылает к плитке шоколада, которая делится на дольки). Суть идеи: каждая подсистема, которая использует много объектов одинакового типа (а значит, одинакового размера), вместо заведения своих собственных кэшей регистрируется в slab-аллокаторе. А тот сам управляет размером кэшей, исходя из общего количества свободной памяти. Почему кэшей? Потому что аллокатор при регистрации принимает функции конструктора и деструктора объекта, и возвращает при аллокации уже инициализированный объект. Он может инициализировать некоторое их количество заранее, да и при

free()

объект может быть лишь частично деинициализирован, просто возвращаясь в кэш и будучи немедленно готовым к следующей аллокации.