Содержание

- Name already in use

- machine_learning_from_scratch / algorithm / 2.linearRegressionGradientDescent.md

- Users who have contributed to this file

- Name already in use

- machine-learning-articles / about-loss-and-loss-functions.md

Name already in use

machine_learning_from_scratch / algorithm / 2.linearRegressionGradientDescent.md

- Go to file T

- Go to line L

- Copy path

- Copy permalink

1 contributor

Users who have contributed to this file

Copy raw contents

Copy raw contents

Linear Regression with Gradient Descent

Here I will introduce the gradient descent algorithm and its application to solve linear regression problems with OLS loss function, then I will extend it to some other loss functions such as L1-norm loss function.

As previously show in linear regression, we can solve linear regression with derivatives. But many complex functions do not have an analytical solution, or they are hard and complex to solve through a mathematics way. Then comes for Gradient Descent, which can be used to solve minimize or maximize problems.

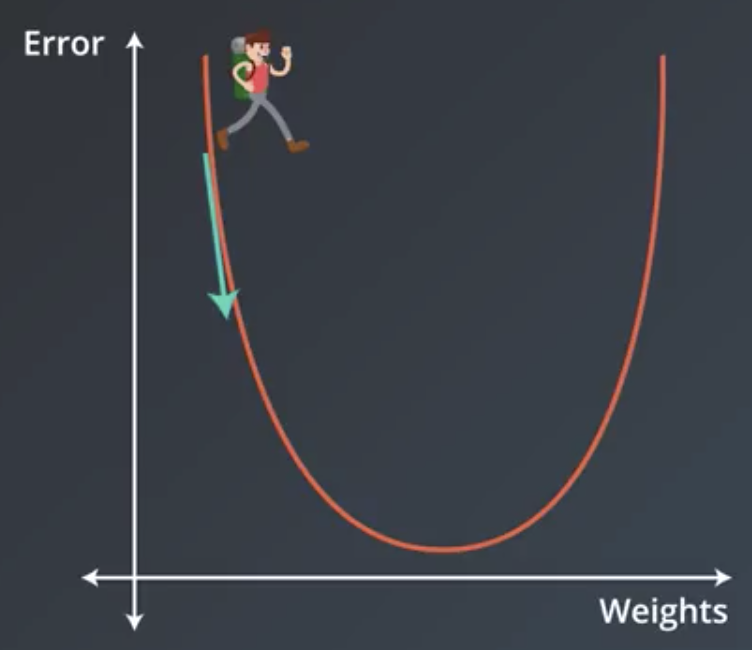

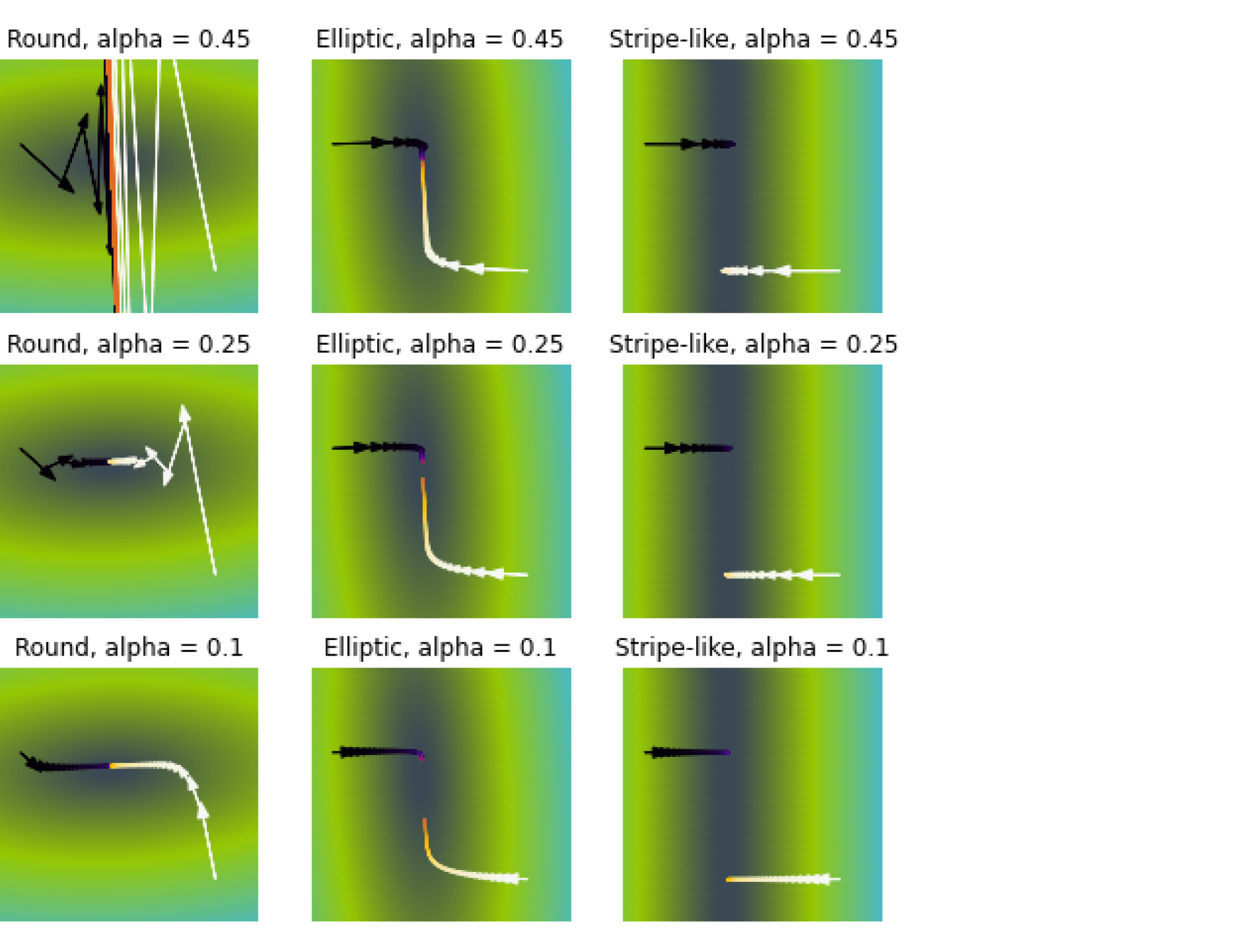

How gradient descent works?

We have previously in the linear regression part shown that gradient is the derivatives of a vector or matrix. Here we will go over how gradient descent works in low-dimensional examples.

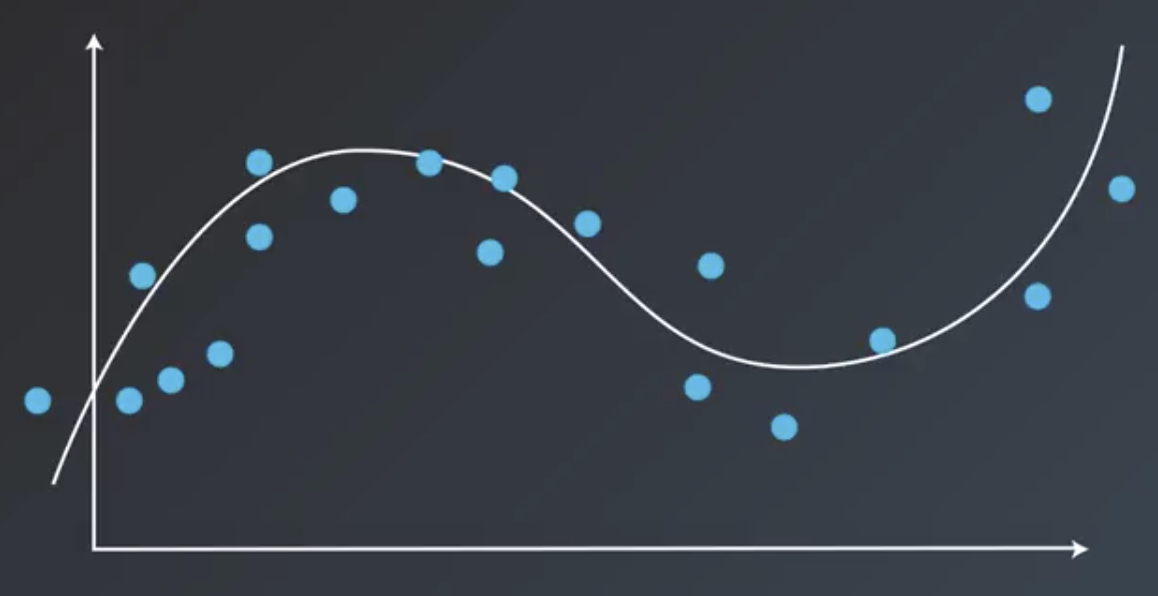

If we have a function like with its curve as figure below.

We have two points on the curve, one on the left and the other on the right. We firstly take a look at the point A, with a coordinate , with very basic math knowledge we will get the tangent line at A is

as indicated by the red line. And the point B with coordinate

on the right, similarly we have its tangent line with function

as indicated by the blue line.

The derivitives (gradient) at point A keeps the same for the curve and the tangent line, then we have derivative (gradient, maybe also can be called slope) at A and B are and

, respectively.

The gradient have orientations, in the example above, the orientation of gradient at A is tend to negative infinity and the orientation of gradient at B is tend to posive infinity. How can we get to the minimum value in the above example? It is obviously shown that we should tend positive at point A, in the opposite orientation of the gradient at point A. Similarly, we should tend negative at point B which is also in the opposite orientation of the gradient at point B.

It is similar at high-dimensional parameter spaces.

Gradient descent for OLS linear regression

Updating paramters at the negative orientation of the gradient is gradient descent methods. For example, if the loss function is , then formula below is used for the gradient descent:

In the formula, is the learning rate, indicating how long should we update the parameters through the negative gradient direction.

We have previously stated the OLS loss function in linear regression, following is the formula:

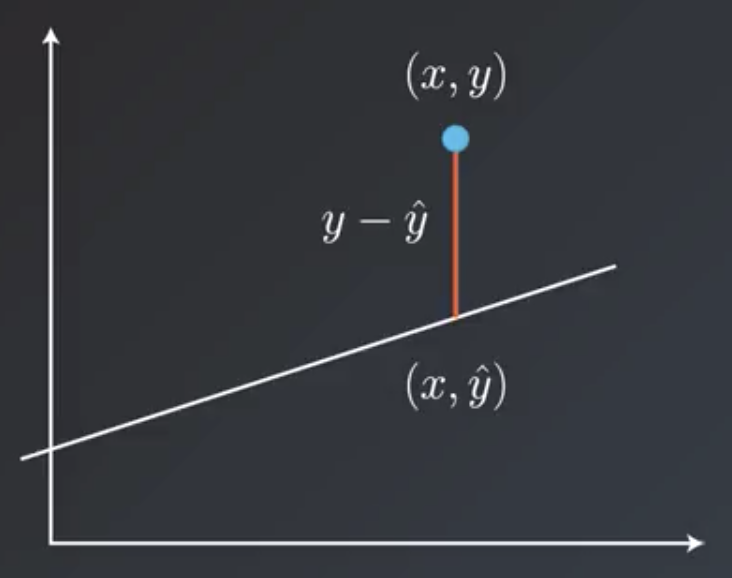

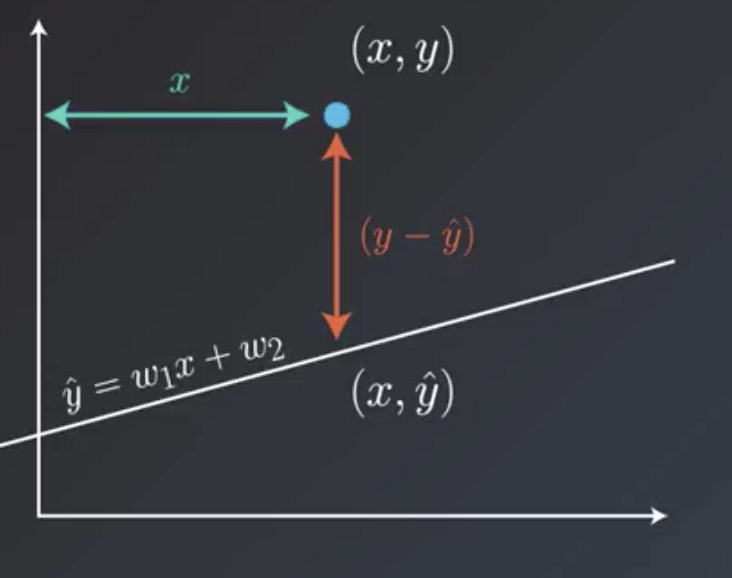

We will first introduce how to do this on only one input sample, then the loss on sample will be

Then the derivative of the loss function for one parameter can be calculated as:

Then we can vectorize it for all parameters as:

Update rule above is only for one sample, here then for all the samples we will have:

It is the same to skip the sample size, which only affect the choose of learning rate:

Then by setting learning rate , we could could be running on the linear regression using gradient descent.

Python solution of linear regression using gradient descent

We will have two extra functions, one for calculating the loss, and one for calculate the gradient. Loss is used to eary stop the iteration and gradient is used for updating parameters.

Advantages and disadvantages of gradient descent

It is easy to understand how gradient descent works, and it is also easy to implementation. It will be very difficult to come out the analytical solution when we have more parameters or the loss function is much complex.

However for linear regression, gradient descent will not always get to the optimized paramaters because of different setting of learning rate and epoches to train. And it takes much longer for gradient descent to reach some parameters that could train the input data «well». And maybe the gradient descent will «never» get to the global minimum.

Gradient descent to solve linear regression with mean absolute error (MAE) loss function

Except for the Ordinary Least Square (OLS) loss function, we could also construct the mean absolute error (MAE) as the loss function, its formula can be expressed as:

Linear regression using MAE loss function is hard to get get the analytical solution. But it is extremely easy using gradient descent alogrithm, much easier than previous shown OLS loss function.

Similarly, we start with the loss function for one single sample:

Then the partial derivative for the loss function is:

Then it is very straightforward to generate the gradient for one single sample:

The gradient for one sample is the data of this sample itself, multiple 1 or -1 according to it is modelled by the current parameters to be larger or smaller than its real value.

And it is very easy to vectorize across some more samples. Then I will give the codes for MAE loss function.

Python solution for linear regression using MAE as loss function

Here I will used the same class as the linear regression using OLS as loss function above. But implement a new gradient descent update schedule.

Now, we have been familar with gradient descent algorithm and how it can be applied to optimization problems. Then we will further introduce gradient descent to solove logistic regression, and regularization.

Источник

Name already in use

machine-learning-articles / about-loss-and-loss-functions.md

- Go to file T

- Go to line L

- Copy path

- Copy permalink

Copy raw contents

Copy raw contents

When you’re training supervised machine learning models, you often hear about a loss function that is minimized; that must be chosen, and so on.

The term cost function is also used equivalently.

But what is loss? And what is a loss function?

I’ll answer these two questions in this blog, which focuses on this optimization aspect of machine learning. We’ll first cover the high-level supervised learning process, to set the stage. This includes the role of training, validation and testing data when training supervised models.

Once we’re up to speed with those, we’ll introduce loss. We answer the question what is loss? However, we don’t forget what is a loss function? We’ll even look into some commonly used loss functions.

The high-level supervised learning process

Before we can actually introduce the concept of loss, we’ll have to take a look at the high-level supervised machine learning process. All supervised training approaches fall under this process, which means that it is equal for deep neural networks such as MLPs or ConvNets, but also for SVMs.

Let’s take a look at this training process, which is cyclical in nature.

We start with our features and targets, which are also called your dataset. This dataset is split into three parts before the training process starts: training data, validation data and testing data. The training data is used during the training process; more specificially, to generate predictions during the forward pass. However, after each training cycle, the predictive performance of the model must be tested. This is what the validation data is used for — it helps during model optimization.

Then there is testing data left. Assume that the validation data, which is essentially a statistical sample, does not fully match the population it describes in statistical terms. That is, the sample does not represent it fully and by consequence the mean and variance of the sample are (hopefully) slightly different than the actual population mean and variance. Hence, a little bias is introduced into the model every time you’ll optimize it with your validation data. While it may thus still work very well in terms of predictive power, it may be the case that it will lose its power to generalize. In that case, it would no longer work for data it has never seen before, e.g. data from a different sample. The testing data is used to test the model once the entire training process has finished (i.e., only after the last cycle), and allows us to tell something about the generalization power of our machine learning model.

The training data is fed into the machine learning model in what is called the forward pass. The origin of this name is really easy: the data is simply fed to the network, which means that it passes through it in a forward fashion. The end result is a set of predictions, one per sample. This means that when my training set consists of 1000 feature vectors (or rows with features) that are accompanied by 1000 targets, I will have 1000 predictions after my forward pass.

You do however want to know how well the model performs with respect to the targets originally set. A well-performing model would be interesting for production usage, whereas an ill-performing model must be optimized before it can be actually used.

This is where the concept of loss enters the equation.

Most generally speaking, the loss allows us to compare between some actual targets and predicted targets. It does so by imposing a «cost» (or, using a different term, a «loss») on each prediction if it deviates from the actual targets.

It’s relatively easy to compute the loss conceptually: we agree on some cost for our machine learning predictions, compare the 1000 targets with the 1000 predictions and compute the 1000 costs, then add everything together and present the global loss.

Our goal when training a machine learning model?

To minimize the loss.

The reason why is simple: the lower the loss, the more the set of targets and the set of predictions resemble each other.

And the more they resemble each other, the better the machine learning model performs.

As you can see in the machine learning process depicted above, arrows are flowing backwards towards the machine learning model. Their goal: to optimize the internals of your model only slightly, so that it will perform better during the next cycle (or iteration, or epoch, as they are also called).

When loss is computed, the model must be improved. This is done by propagating the error backwards to the model structure, such as the model’s weights. This closes the learning cycle between feeding data forward, generating predictions, and improving it — by adapting the weights, the model likely improves (sometimes much, sometimes slightly) and hence learning takes place.

Depending on the model type used, there are many ways for optimizing the model, i.e. propagating the error backwards. In neural networks, often, a combination of gradient descent based methods and backpropagation is used: gradient descent like optimizers for computing the gradient or the direction in which to optimize, backpropagation for the actual error propagation.

In other model types, such as Support Vector Machines, we do not actually propagate the error backward, strictly speaking. However, we use methods such as quadratic optimization to find the mathematical optimum, which given linear separability of your data (whether in regular space or kernel space) must exist. However, visualizing it as «adapting the weights by computing some error» benefits understanding. Next up — the loss functions we can actually use for computing the error! 😄

Here, we’ll cover a wide array of loss functions: some of them for regression, others for classification.

Loss functions for regression

There are two main types of supervised learning problems: classification and regression. In the first, your aim is to classify a sample into the correct bucket, e.g. into one of the buckets ‘diabetes’ or ‘no diabetes’. In the latter case, however, you don’t classify but rather estimate some real valued number. What you’re trying to do is regress a mathematical function from some input data, and hence it’s called regression. For regression problems, there are many loss functions available.

Mean Absolute Error (L1 Loss)

Mean Absolute Error (MAE) is one of them. This is what it looks like:

Don’t worry about the maths, we’ll introduce the MAE intuitively now.

That weird E-like sign you see in the formula is what is called a Sigma sign, and it sums up what’s behind it: |Ei |, in our case, where Ei is the error (the difference between prediction and actual value) and the | signs mean that you’re taking the absolute value, or convert -3 into 3 and 3 remains 3.

The summation, in this case, means that we sum all the errors, for all the n samples that were used for training the model. We therefore, after doing so, end up with a very large number. We divide this number by n , or the number of samples used, to find the mean, or the average Absolute Error: the Mean Absolute Error or MAE.

It’s very well possible to use the MAE in a multitude of regression scenarios (Rich, n.d.). However, if your average error is very small, it may be better to use the Mean Squared Error that we will introduce next.

What’s more, and this is important: when you use the MAE in optimizations that use gradient descent, you’ll face the fact that the gradients are continuously large (Grover, 2019). Since this also occurs when the loss is low (and hence, you would only need to move a tiny bit), this is bad for learning — it’s easy to overshoot the minimum continously, finding a suboptimal model. Consider Huber loss (more below) if you face this problem. If you face larger errors and don’t care (yet?) about this issue with gradients, or if you’re here to learn, let’s move on to Mean Squared Error!

Mean Squared Error

Another loss function used often in regression is Mean Squared Error (MSE). It sounds really difficult, especially when you look at the formula (Binieli, 2018):

. but fear not. It’s actually really easy to understand what MSE is and what it does!

We’ll break the formula above into three parts, which allows us to understand each element and subsequently how they work together to produce the MSE.

The primary part of the MSE is the middle part, being the Sigma symbol or the summation sign. What it does is really simple: it counts from i to n, and on every count executes what’s written behind it. In this case, that’s the third part — the square of (Yi — Y’i).

In our case, i starts at 1 and n is not yet defined. Rather, n is the number of samples in our training set and hence the number of predictions that has been made. In the scenario sketched above, n would be 1000.

Then, the third part. It’s actually mathematical notation for what we already intuitively learnt earlier: it’s the difference between the actual target for the sample ( Yi ) and the predicted target ( Y’i ), the latter of which is removed from the first.

With one minor difference: the end result of this computation is squared. This property introduces some mathematical benefits during optimization (Rich, n.d.). Particularly, the MSE is continuously differentiable whereas the MAE is not (at x = 0). This means that optimizing the MSE is easier than optimizing the MAE.

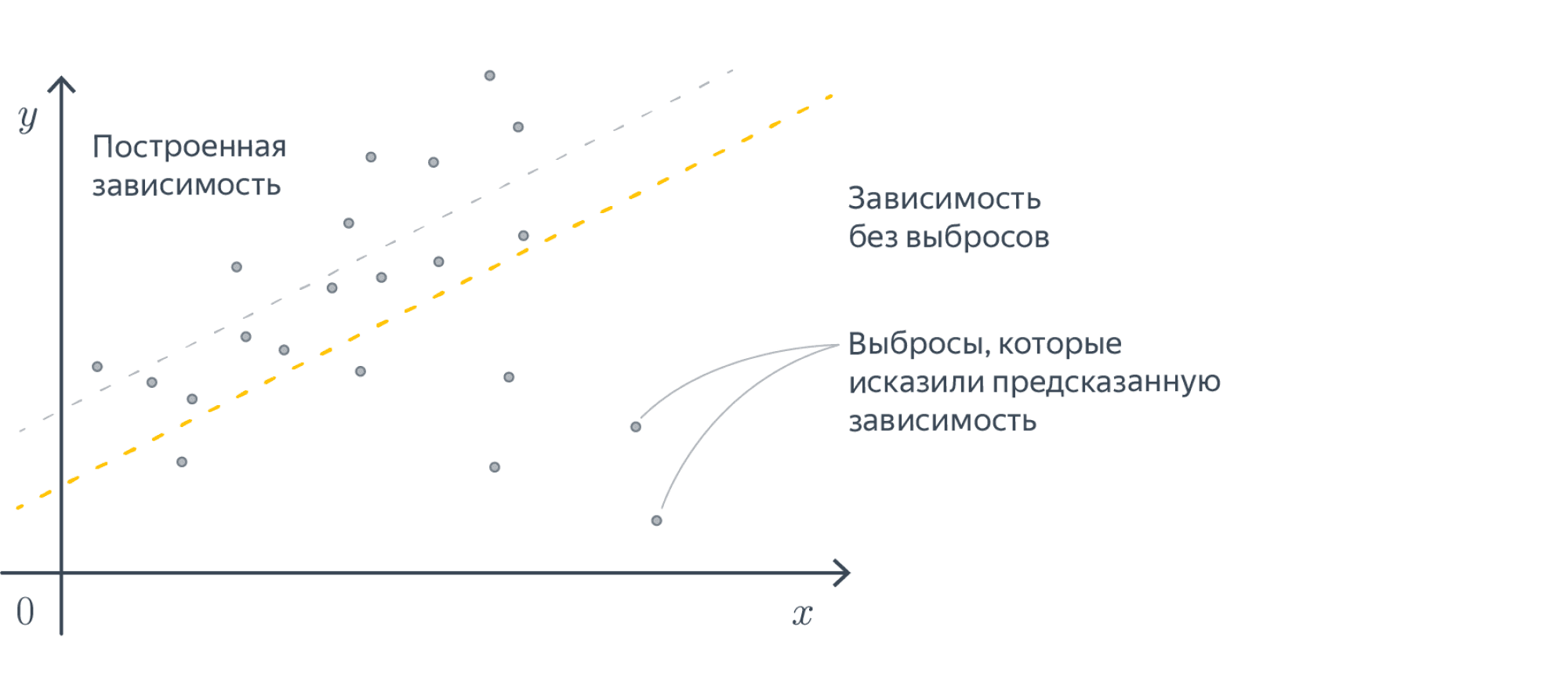

Additionally, large errors introduce a much larger cost than smaller errors (because the differences are squared and larger errors produce much larger squares than smaller errors). This is both good and bad at the same time (Rich, n.d.). This is a good property when your errors are small, because optimization is then advanced (Quora, n.d.). However, using MSE rather than e.g. MAE will open your ML model up to outliers, which will severely disturb training (by means of introducing large errors).

Although the conclusion may be rather unsatisfactory, choosing between MAE and MSE is thus often heavily dependent on the dataset you’re using, introducing the need for some a priori inspection before starting your training process.

Finally, when we have the sum of the squared errors, we divide it by n — producing the mean squared error.

Mean Absolute Percentage Error

The Mean Absolute Percentage Error, or MAPE, really looks like the MAE, even though the formula looks somewhat different:

When using the MAPE, we don’t compute the absolute error, but rather, the mean error percentage with respect to the actual values. That is, suppose that my prediction is 12 while the actual target is 10, the MAPE for this prediction is [latex]| (10 — 12 ) / 10 | = 0.2[/latex].

Similar to the MAE, we sum the error over all the samples, but subsequently face a different computation: [latex]100% / n[/latex]. This looks difficult, but we can once again separate this computation into more easily understandable parts. More specifically, we can write it as a multiplication of [latex]100%[/latex] and [latex]1 / n[/latex] instead. When multiplying the latter with the sum, you’ll find the same result as dividing it by n , which we did with the MAE. That’s great.

The only thing left now is multiplying the whole with 100%. Why do we do that? Simple: because our computed error is a ratio and not a percentage. Like the example above, in which our error was 0.2, we don’t want to find the ratio, but the percentage instead. [latex]0.2 times 100%[/latex] is . unsurprisingly . [latex]20%[/latex]! Hence, we multiply the mean ratio error with the percentage to find the MAPE! 🙂

Why use MAPE if you can also use MAE?

Very good question.

Firstly, it is a very intuitive value. Contrary to the absolute error, we have a sense of how well-performing the model is or how bad it performs when we can express the error in terms of a percentage. An error of 100 may seem large, but if the actual target is 1000000 while the estimate is 1000100, well, you get the point.

Secondly, it allows us to compare the performance of regression models on different datasets (Watson, 2019). Suppose that our goal is to train a regression model on the NASDAQ ETF and the Dutch AEX ETF. Since their absolute values are quite different, using MAE won’t help us much in comparing the performance of our model. MAPE, on the other hand, demonstrates the error in terms of a percentage — and a percentage is a percentage, whether you apply it to NASDAQ or to AEX. This way, it’s possible to compare model performance across statistically varying datasets.

Root Mean Squared Error (L2 Loss)

Remember the MSE?

There’s also something called the RMSE, or the Root Mean Squared Error or Root Mean Squared Deviation (RMSD). It goes like this:

Simple, hey? It’s just the MSE but then its square root value.

How does this help us?

The errors of the MSE are squared — hey, what’s in a name.

The RMSE or RMSD errors are root squares of the square — and hence are back at the scale of the original targets (Dragos, 2018). This gives you much better intuition for the error in terms of the targets.

«Log-cosh is the logarithm of the hyperbolic cosine of the prediction error.» (Grover, 2019).

Well, how’s that for a starter.

This is the mathematical formula:

And this the plot:

Okay, now let’s introduce some intuitive explanation.

The TensorFlow docs write this about Logcosh loss:

log(cosh(x)) is approximately equal to (x ** 2) / 2 for small x and to abs(x) — log(2) for large x . This means that ‘logcosh’ works mostly like the mean squared error, but will not be so strongly affected by the occasional wildly incorrect prediction.

Well, that’s great. It seems to be an improvement over MSE, or L2 loss. Recall that MSE is an improvement over MAE (L1 Loss) if your data set contains quite large errors, as it captures these better. However, this also means that it is much more sensitive to errors than the MAE. Logcosh helps against this problem:

- For relatively small errors (even with the relatively small but larger errors, which is why MSE can be better for your ML problem than MAE) it outputs approximately equal to [latex]x^2 / 2[/latex] — which is pretty equal to the [latex]x^2[/latex] output of the MSE.

- For larger errors, i.e. outliers, where MSE would produce extremely large errors ([latex](10^6)^2 = 10^12[/latex]), the Logcosh approaches [latex]|x| — log(2)[/latex]. It’s like (as well as unlike) the MAE, but then somewhat corrected by the log .

Hence: indeed, if you have both larger errors that must be detected as well as outliers, which you perhaps cannot remove from your dataset, consider using Logcosh! It’s available in many frameworks like TensorFlow as we saw above, but also in Keras.

Let’s move on to Huber loss, which we already hinted about in the section about the MAE:

When interpreting the formula, we see two parts:

- [latex]1/2 times (t-p)^2[/latex], when [latex]|t-p| leq delta[/latex]. This sounds very complicated, but we can break it into parts easily.

- [latex]|t-p|[/latex] is the absolute error: the difference between target [latex]t[/latex] and prediction [latex]p[/latex].

- We square it and divide it by two.

- We however only do so when the absolute error is smaller than or equal to some [latex]delta[/latex], also called delta, which you can configure! We’ll see next why this is nice.

- When the absolute error is larger than [latex]delta[/latex], we compute the error as follows: [latex]delta times |t-p| — (delta^2 / 2)[/latex].

- Let’s break this apart again. We multiply the delta with the absolute error and remove half of delta square.

What is the effect of all this mathematical juggling?

Look at the visualization above.

For relatively small deltas (in our case, with [latex]delta = 0.25[/latex], you’ll see that the loss function becomes relatively flat. It takes quite a long time before loss increases, even when predictions are getting larger and larger.

For larger deltas, the slope of the function increases. As you can see, the larger the delta, the slower the increase of this slope: eventually, for really large [latex]delta[/latex] the slope of the loss tends to converge to some maximum.

If you look closely, you’ll notice the following:

- With small [latex]delta[/latex], the loss becomes relatively insensitive to larger errors and outliers. This might be good if you have them, but bad if on average your errors are small.

- With large [latex]delta[/latex], the loss becomes increasingly sensitive to larger errors and outliers. That might be good if your errors are small, but you’ll face trouble when your dataset contains outliers.

Hey, haven’t we seen that before?

Yep: in our discussions about the MAE (insensitivity to larger errors) and the MSE (fixes this, but facing sensitivity to outliers).

Grover (2019) writes about this nicely:

Huber loss approaches MAE when 𝛿

That’s what this [latex]delta[/latex] is for! You are now in control about the ‘degree’ of MAE vs MSE-ness you’ll introduce in your loss function. When you face large errors due to outliers, you can try again with a lower [latex]delta[/latex]; if your errors are too small to be picked up by your Huber loss, you can increase the delta instead.

And there’s another thing, which we also mentioned when discussing the MAE: it produces large gradients when you optimize your model by means of gradient descent, even when your errors are small (Grover, 2019). This is bad for model performance, as you will likely overshoot the mathematical optimum for your model. You don’t face this problem with MSE, as it tends to decrease towards the actual minimum (Grover, 2019). If you switch to Huber loss from MAE, you might find it to be an additional benefit.

Here’s why: Huber loss, like MSE, decreases as well when it approaches the mathematical optimum (Grover, 2019). This means that you can combine the best of both worlds: the insensitivity to larger errors from MAE with the sensitivity of the MSE and its suitability for gradient descent. Hooray for Huber loss! And like always, it’s also available when you train models with Keras.

Then why isn’t this the perfect loss function?

Because the benefit of the [latex]delta[/latex] is also becoming your bottleneck (Grover, 2019). As you have to configure them manually (or perhaps using some automated tooling), you’ll have to spend time and resources on finding the most optimum [latex]delta[/latex] for your dataset. This is an iterative problem that, in the extreme case, may become impractical at best and costly at worst. However, in most cases, it’s best just to experiment — perhaps, you’ll find better results!

Loss functions for classification

Loss functions are also applied in classifiers. I already discussed in another post what classification is all about, so I’m going to repeat it here:

Suppose that you work in the field of separating non-ripe tomatoes from the ripe ones. It’s an important job, one can argue, because we don’t want to sell customers tomatoes they can’t process into dinner. It’s the perfect job to illustrate what a human classifier would do.

Humans have a perfect eye to spot tomatoes that are not ripe or that have any other defect, such as being rotten. They derive certain characteristics for those tomatoes, e.g. based on color, smell and shape:

— If it’s green, it’s likely to be unripe (or: not sellable);

— If it smells, it is likely to be unsellable;

— The same goes for when it’s white or when fungus is visible on top of it.

If none of those occur, it’s likely that the tomato can be sold. We now have two classes: sellable tomatoes and non-sellable tomatoes. Human classifiers decide about which class an object (a tomato) belongs to.

The same principle occurs again in machine learning and deep learning.

Only then, we replace the human with a machine learning model. We’re then using machine learning for classification, or for deciding about some “model input” to “which class” it belongs.

We’ll now cover loss functions that are used for classification.

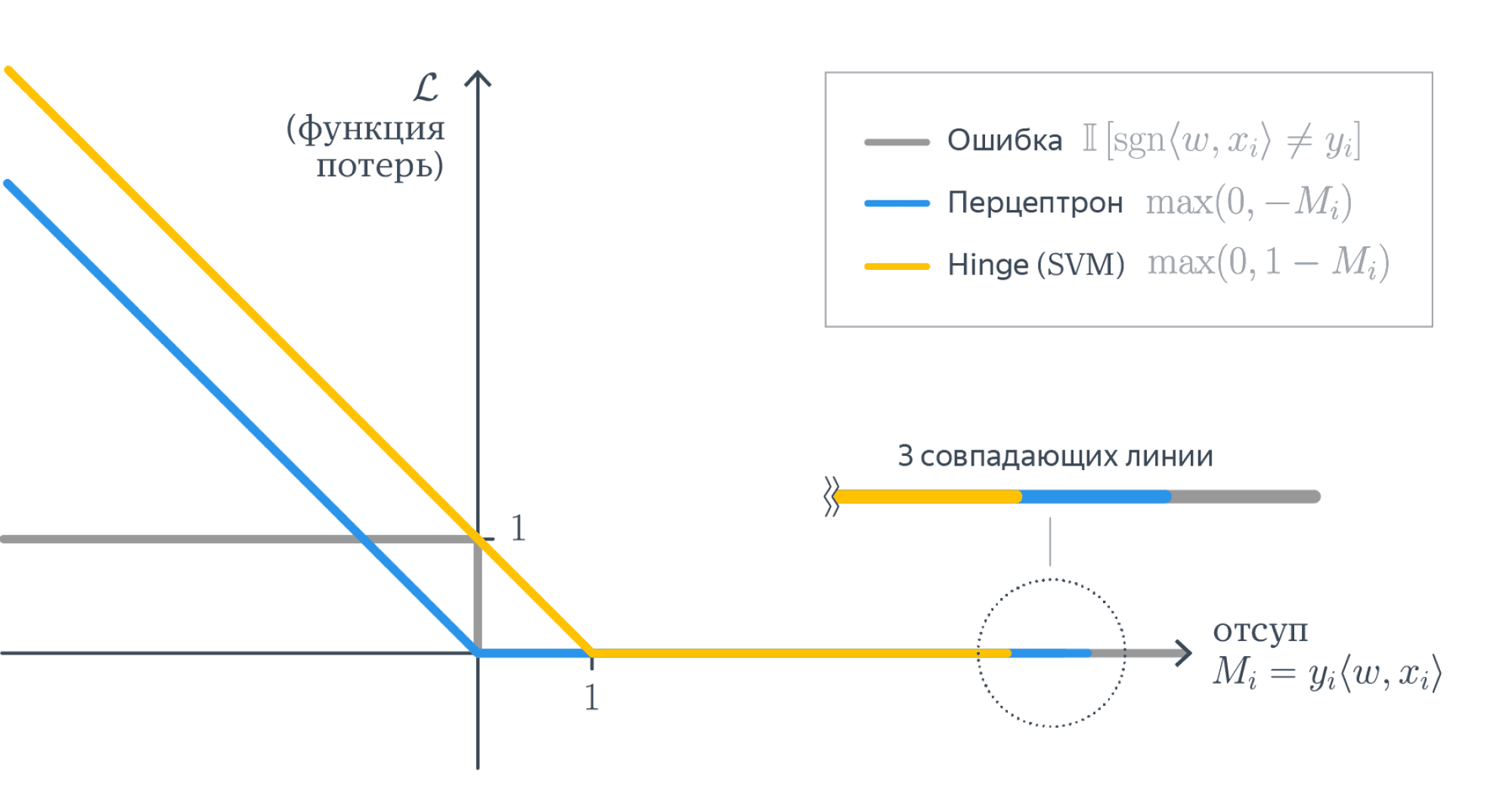

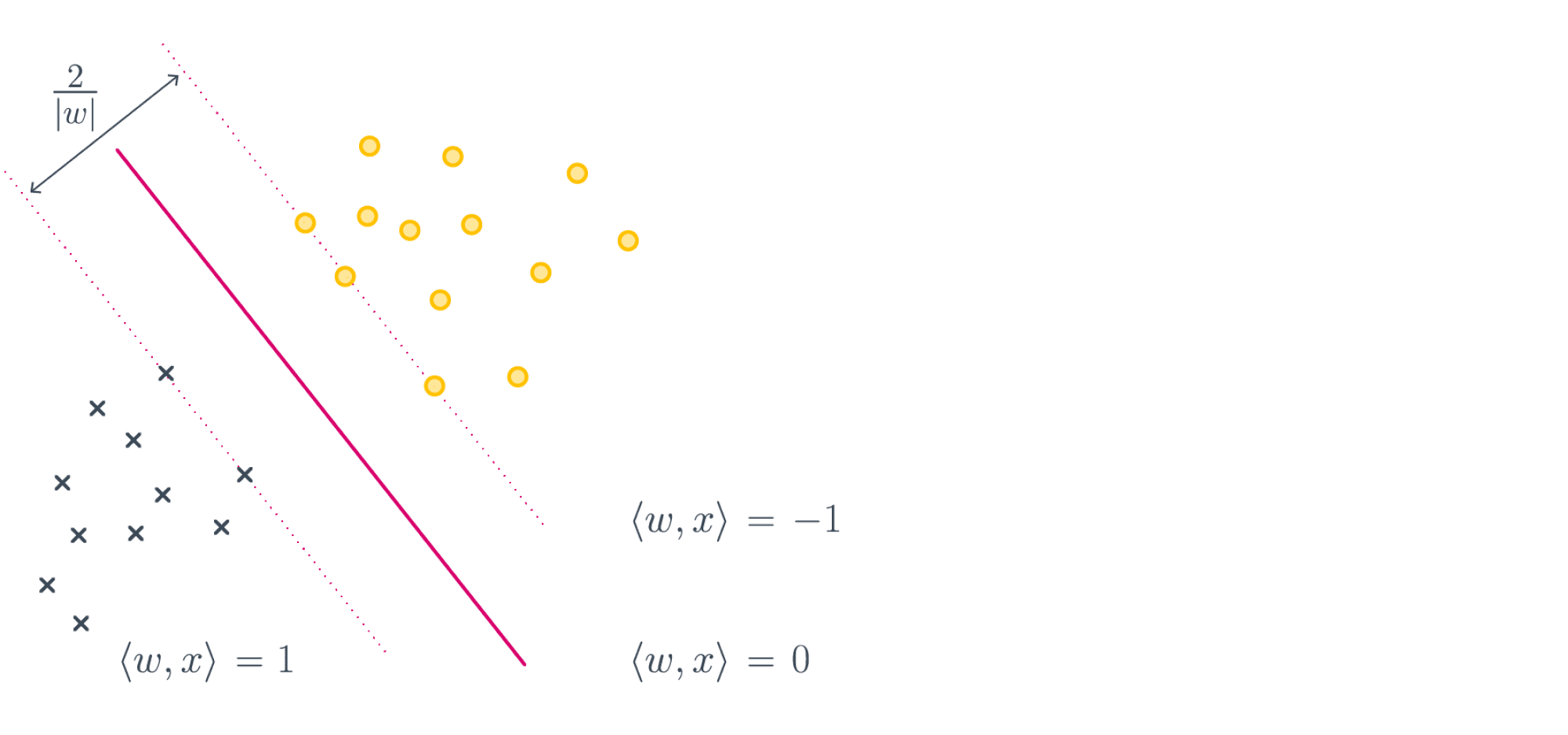

The hinge loss is defined as follows (Wikipedia, 2011):

It simply takes the maximum of either 0 or the computation [latex] 1 — t times y[/latex], where t is the machine learning output value (being between -1 and +1) and y is the true target (-1 or +1).

When the target equals the prediction, the computation [latex]t times y[/latex] is always one: [latex]1 times 1 = -1 times -1 = 1)[/latex]. Essentially, because then [latex]1 — t times y = 1 — 1 = 1[/latex], the max function takes the maximum [latex]max(0, 0)[/latex], which of course is 0.

That is: when the actual target meets the prediction, the loss is zero. Negative loss doesn’t exist. When the target != the prediction, the loss value increases.

For t = 1 , or [latex]1[/latex] is your target, hinge loss looks like this:

Let’s now consider three scenarios which can occur, given our target [latex]t = 1[/latex] (Kompella, 2017; Wikipedia, 2011):

- The prediction is correct, which occurs when [latex]y geq 1.0[/latex].

- The prediction is very incorrect, which occurs when [latex]y

The squared hinge loss is like the hinge formula displayed above, but then the [latex]max()[/latex] function output is squared.

This helps achieving two things:

- Firstly, it makes the loss value more sensitive to outliers, just as we saw with MSE vs MAE. Large errors will add to the loss more significantly than smaller errors. Note that simiarly, this may also mean that you’ll need to inspect your dataset for the presence of such outliers first.

- Secondly, squared hinge loss is differentiable whereas hinge loss is not (Tay, n.d.). The way the hinge loss is defined makes it not differentiable at the ‘boundary’ point of the chart — also see this perfect answer that illustrates it. Squared hinge loss, on the other hand, is differentiable, simply because of the square and the mathematical benefits it introduces during differentiation. This makes it easier for us to use a hinge-like loss in gradient based optimization — we’ll simply take squared hinge.

Categorical / multiclass hinge

Both normal hinge and squared hinge loss work only for binary classification problems in which the actual target value is either +1 or -1. Although that’s perfectly fine for when you have such problems (e.g. the diabetes yes/no problem that we looked at previously), there are many other problems which cannot be solved in a binary fashion.

(Note that one approach to create a multiclass classifier, especially with SVMs, is to create many binary ones, feeding the data to each of them and counting classes, eventually taking the most-chosen class as output — it goes without saying that this is not very efficient.)

However, in neural networks and hence gradient based optimization problems, we’re not interested in doing that. It would mean that we have to train many networks, which significantly impacts the time performance of our ML training problem. Instead, we can use the multiclass hinge that has been introduced by researchers Weston and Watkins (Wikipedia, 2011):

What this means in plain English is this:

For all [latex]y[/latex] (output) values unequal to [latex]t[/latex], compute the loss. Eventually, sum them together to find the multiclass hinge loss.

Note that this does not mean that you sum over all possible values for y (which would be all real-valued numbers except [latex]t[/latex]), but instead, you compute the sum over all the outputs generated by your ML model during the forward pass. That is, all the predictions. Only for those where [latex]y neq t[/latex], you compute the loss. This is obvious from an efficiency point of view: where [latex]y = t[/latex], loss is always zero, so no [latex]max[/latex] operation needs to be computed to find zero after all.

Keras implements the multiclass hinge loss as categorical hinge loss, requiring to change your targets into categorical format (one-hot encoded format) first by means of to_categorical .

A loss function that’s used quite often in today’s neural networks is binary crossentropy. As you can guess, it’s a loss function for binary classification problems, i.e. where there exist two classes. Primarily, it can be used where the output of the neural network is somewhere between 0 and 1, e.g. by means of the Sigmoid layer.

This is its formula:

It can be visualized in this way:

And, like before, let’s now explain it in more intuitive ways.

The [latex]t[/latex] in the formula is the target (0 or 1) and the [latex]p[/latex] is the prediction (a real-valued number between 0 and 1, for example 0.12326).

When you input both into the formula, loss will be computed related to the target and the prediction. In the visualization above, where the target is 1, it becomes clear that loss is 0. However, when moving to the left, loss tends to increase (ML Cheatsheet documentation, n.d.). What’s more, it increases increasingly fast. Hence, it not only tends to punish wrong predictions, but also wrong predictions that are extremely confident (i.e., if the model is very confident that it’s 0 while it’s 1, it gets punished much harder than when it thinks it’s somewhere in between, e.g. 0.5). This latter property makes the binary cross entropy a valued loss function in classification problems.

When the target is 0, you can see that the loss is mirrored — which is exactly what we want:

Now what if you have no binary classification problem, but instead a multiclass one?

Thus: one where your output can belong to one of > 2 classes.

The CNN that we created with Keras using the MNIST dataset is a good example of this problem. As you can find in the blog (see the link), we used a different loss function there — categorical crossentropy. It’s still crossentropy, but then adapted to multiclass problems.

This is the formula with which we compute categorical crossentropy. Put very simply, we sum over all the classes that we have in our system, compute the target of the observation and the prediction of the observation and compute the observation target with the natural log of the observation prediction.

It took me some time to understand what was meant with a prediction, though, but thanks to Peltarion (n.d.), I got it.

The answer lies in the fact that the crossentropy is categorical and that hence categorical data is used, with one-hot encoding.

Suppose that we have dataset that presents what the odds are of getting diabetes after five years, just like the Pima Indians dataset we used before. However, this time another class is added, being «Possibly diabetic», rendering us three classes for one’s condition after five years given current measurements:

- 0: no diabetes

- 1: possibly diabetic

- 2: diabetic

That dataset would look like this:

| Features | Target |

| 1 | |

| 2 | |

| 2 | |

| …and so on | …and so on |

However, categorical crossentropy cannot simply use integers as targets, because its formula doesn’t support this. Instead, we must apply one-hot encoding, which transforms the integer targets into categorial vectors, which are just vectors that displays all categories and whether it’s some class or not:

That’s what we always do with to_categorical in Keras.

Our dataset then looks as follows:

| Features | Target |

| [latex][0, 1, 0][/latex] | |

| [latex][0, 0, 1][/latex] | |

| [latex][1, 0, 0][/latex] | |

| [latex][1, 0, 0][/latex] | |

| [latex][0, 0, 1][/latex] | |

| …and so on | …and so on |

Now, we can explain with is meant with an observation.

Let’s look at the formula again and recall that we iterate over all the possible output classes — once for every prediction made, with some true target:

Now suppose that our trained model outputs for the set of features [latex]< . >[/latex] or a very similar one that has target [latex][0, 1, 0][/latex] a probability distribution of [latex][0.25, 0.50, 0.25][/latex] — that’s what these models do, they pick no class, but instead compute the probability that it’s a particular class in the categorical vector.

Computing the loss, for [latex]c = 1[/latex], what is the target value? It’s 0: in [latex]textbf = [0, 1, 0][/latex], the target value for class 0 is 0.

What is the prediction? Well, following the same logic, the prediction is 0.25.

We call these two observations with respect to the total prediction. By looking at all observations, merging them together, we can find the loss value for the entire prediction.

We multiply the target value with the log. But wait! We multiply the log with — so the loss value for this target is 0.

It doesn’t surprise you that this happens for all targets except for one — where the target value is 1: in the prediction above, that would be for the second one.

Note that when the sum is complete, you’ll multiply it with -1 to find the true categorical crossentropy loss.

Hence, loss is driven by the actual target observation of your sample instead of all the non-targets. The structure of the formula however allows us to perform multiclass machine learning training with crossentropy. There we go, we learnt another loss function 🙂

Sparse categorical crossentropy

But what if we don’t want to convert our integer targets into categorical format? We can use sparse categorical crossentropy instead (Lin, 2019).

It performs in pretty much similar ways to regular categorical crossentropy loss, but instead allows you to use integer targets! That’s nice.

| Features | Target |

| 1 | |

| 2 | |

| 2 | |

| …and so on | …and so on |

Sometimes, machine learning problems involve the comparison between two probability distributions. An example comparison is the situation below, in which the question is how much the uniform distribution differs from the Binomial(10, 0.2) distribution.

When you wish to compare two probability distributions, you can use the Kullback-Leibler divergence, a.k.a. KL divergence (Wikipedia, 2004):

begin KL (P || Q) = sum p(X) log ( p(X) div q(X) ) end

KL divergence is an adaptation of entropy, which is a common metric in the field of information theory (Wikipedia, 2004; Wikipedia, 2001; Count Bayesie, 2017). While intuitively, entropy tells you something about «the quantity of your information», KL divergence tells you something about «the change of quantity when distributions are changed».

Your goal in machine learning problems is to ensure that [latex]change approx 0[/latex].

Is KL divergence used in practice? Yes! Generative machine learning models work by drawing a sample from encoded, latent space, which effectively represents a latent probability distribution. In other scenarios, you might wish to perform multiclass classification with neural networks that use Softmax activation in their output layer, effectively generating a probability distribution across the classes. And so on. In those cases, you can use KL divergence loss during training. It compares the probability distribution represented by your training data with the probability distribution generated during your forward pass, and computes the divergence (the difference, although when you swap distributions, the value changes due to non-symmetry of KL divergence — hence it’s not entirely the difference) between the two probability distributions. This is your loss value. Minimizing the loss value thus essentially steers your neural network towards the probability distribution represented in your training set, which is what you want.

In this blog, we’ve looked at the concept of loss functions, also known as cost functions. We showed why they are necessary by means of illustrating the high-level machine learning process and (at a high level) what happens during optimization. Additionally, we covered a wide range of loss functions, some of them for classification, others for regression. Although we introduced some maths, we also tried to explain them intuitively.

I hope you’ve learnt something from my blog! If you have any questions, remarks, comments or other forms of feedback, please feel free to leave a comment below! 👇 I’d also appreciate a comment telling me if you learnt something and if so, what you learnt. I’ll gladly improve my blog if mistakes are made. Thanks and happy engineering! 😎

Chollet, F. (2017). Deep Learning with Python. New York, NY: Manning Publications.

Источник

Linear Regression with Gradient Descent

Here I will introduce the gradient descent algorithm and its application to solve linear regression problems with OLS loss function, then

I will extend it to some other loss functions such as L1-norm loss function.

Gradient Descent

As previously show in linear regression, we can solve linear regression with derivatives. But many complex functions do not have an analytical solution, or they are hard and complex to solve through a mathematics way. Then comes for Gradient Descent, which can be used to solve minimize or maximize problems.

How gradient descent works?

We have previously in the linear regression part shown that gradient is the derivatives of a vector or matrix. Here we will go over how gradient descent works in low-dimensional examples.

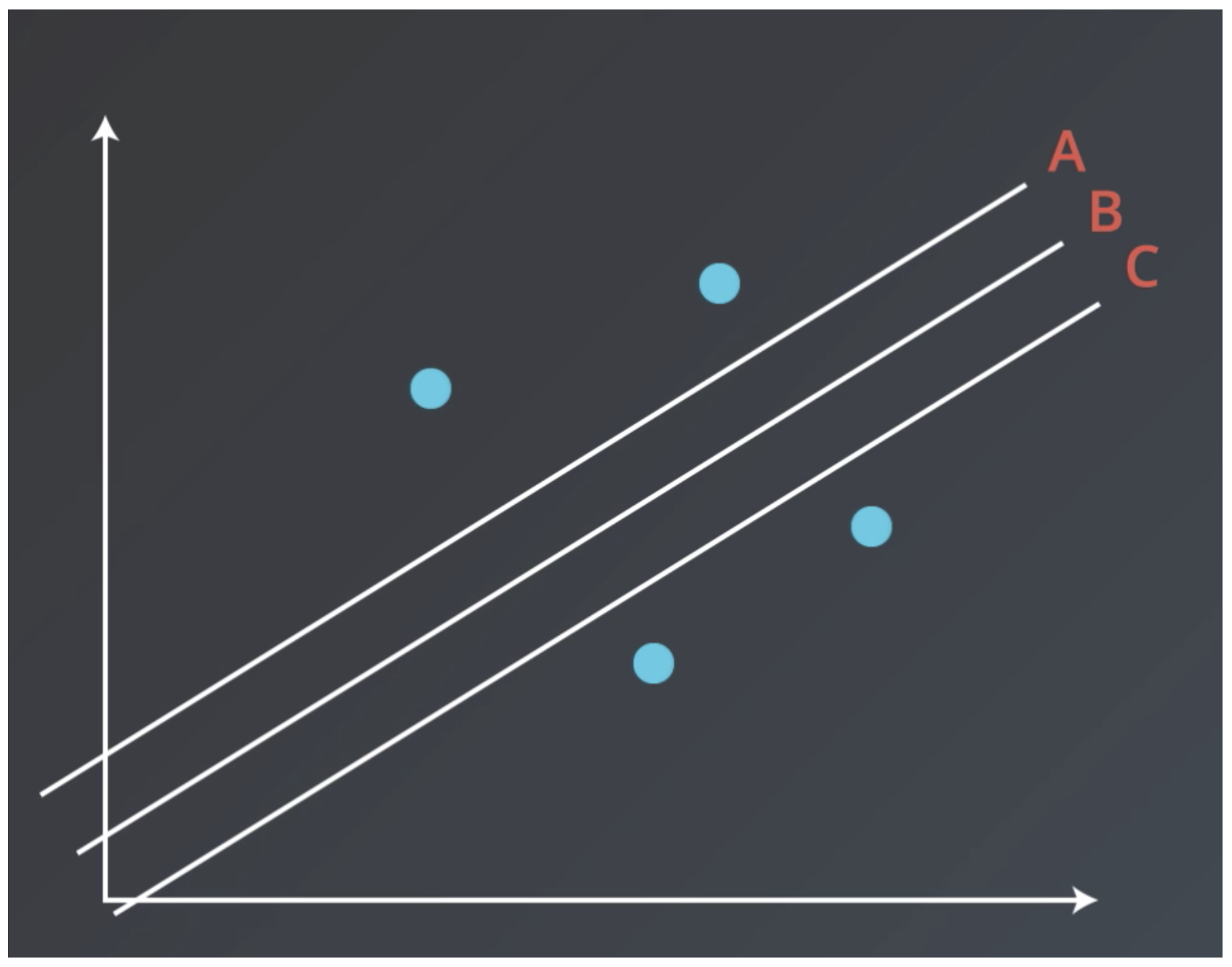

If we have a function like with its curve as figure below.

We have two points on the curve, one on the left and the other on the right. We firstly take a look at the point A, with a coordinate , with very basic math knowledge we will get the tangent line at A is

as indicated by the red line. And the point B with coordinate

on the right, similarly we have its tangent line with function

as indicated by the blue line.

The derivitives (gradient) at point A keeps the same for the curve and the tangent line, then we have derivative (gradient, maybe also can be called slope) at A and B are and

, respectively.

The gradient have orientations, in the example above, the orientation of gradient at A is tend to negative infinity and the orientation of gradient at B is tend to posive infinity. How can we get to the minimum value in the above example? It is obviously shown that we should tend positive at point A, in the opposite orientation of the gradient at point A. Similarly, we should tend negative at point B which is also in the opposite orientation of the gradient at point B.

It is similar at high-dimensional parameter spaces.

Gradient descent for OLS linear regression

Updating paramters at the negative orientation of the gradient is gradient descent methods. For example, if the loss function is , then formula below is used for the gradient descent:

In the formula, is the learning rate, indicating how long should we update the parameters through the negative gradient direction.

We have previously stated the OLS loss function in linear regression, following is the formula:

We will first introduce how to do this on only one input sample, then the loss on sample will be

Then the derivative of the loss function for one parameter can be calculated as:

Then we can vectorize it for all parameters as:

Update rule above is only for one sample, here then for all the samples we will have:

It is the same to skip the sample size, which only affect the choose of learning rate:

Then by setting learning rate , we could could be running on the linear regression using gradient descent.

Python solution of linear regression using gradient descent

We will have two extra functions, one for calculating the loss, and one for calculate the gradient. Loss is used to eary stop the iteration and gradient is used for updating parameters.

import os, glob, math import numpy as np import random class linear_regression_GD: """ linear regression with OLS loss function, and solving by gradient descent methods. """ def __init__(self): self.rmse = None pass def train(self, X, y, learning_rate=0.001, epoch=30000, tol=1e-4, methods="OLS"): """ If data not the required format, this function not works @param X, independent variable, example: X = np.array([[1,2,],[1,3,],[1,4], ...]) @param y, dependent variable, example y = np.array([[1],[2],[3],[4],...]) Both X and y should be an array. @param learning_rate, step size for gradient descent @param epoch, times the training process go over the whole datasets @param tol, the stop critera, when loss function did not optimize more than tol for 10 times, stop training @param methods, the loss function, OLS stands for ordinary least square loss function @return, this function will return weight vector w and bias parameter b """ n = len(X) self.n = n m = len(X[0]) if len(y) != n: print "Error, the input X, y should be the same length, while you have len(X)=%d and len(y)=%d"%(n, len(y)) # following codes reformat the input X = np.array(X) y = np.array(y) if len(y.shape) != 1: y = y.reshape(n) # add a 1 column for the bias variable X = np.column_stack((X, np.ones(n))) self.X = X self.y = y # get the parameter w and b, first initize theta = np.random.randn(m+1) num = 0 loss1 = self.getLoss(theta) for i in xrange(epoch): theta -= learning_rate * self.getGradient(theta) loss2 = self.getLoss(theta, methods) if abs(loss2-loss1) < tol: num += 1 else: num = 0 loss1 = loss2 self.epoch = i #if num >= 10: # break self.w = theta[:-1] self.b = theta[-1] return theta def getLoss(self, theta, methods="OLS"): """ @param theta, the parameters for the linear model @return the loss of this model with given parameters """ if methods == "OLS": # divide self.n first to avoid float overflow to some extent. return np.sum(np.square((self.X.dot(theta) - self.y)/self.n) * self.n) else: print 'Error, methods now can only be "OLS"' def getGradient(self, theta): """ Get the gradient of the loss function using parameter theta """ delta = np.sum(self.X.T * (self.X.dot(theta)-self.y), axis=1) return delta def predict(self, X, y=None): """ @param X, independent variable. Example: X = np.array([[1,2,],[1,3,],[1,4], ...]) @param y, dependent variable, example y = np.array([[1],[2],[3],[4],...]) @return, return the predicted dependent variables for input X, or if y is specified, also calculate the RMSE (root mean square error) """ n = len(X) X = np.array(X) y_pred = X.dot(self.w) + self.b self.y_pred = y_pred if y != None: if n != len(y): print "Error, the input X, y should be the same length, while you have len(X)=%d and len(y)=%d"%(n, len(y)) y = np.array(y) y_pred = y_pred.reshape(n) if len(y.shape) != 1: y = y.reshape(n) self.rmse = np.sqrt(np.sum(np.square(y-y_pred))) / n return self.y_pred

Codes can be also fetched at linear regression with gradient descent.

Advantages and disadvantages of gradient descent

It is easy to understand how gradient descent works, and it is also easy to implementation. It will be very difficult to come out the analytical solution when we have more parameters or the loss function is much complex.

However for linear regression, gradient descent will not always get to the optimized paramaters because of different setting of learning rate and epoches to train. And it takes much longer for gradient descent to reach some parameters that could train the input data «well». And maybe the gradient descent will «never» get to the global minimum.

Gradient descent to solve linear regression with mean absolute error (MAE) loss function

Except for the Ordinary Least Square (OLS) loss function, we could also construct the mean absolute error (MAE) as the loss function, its formula can be expressed as:

Linear regression using MAE loss function is hard to get get the analytical solution. But it is extremely easy using gradient descent alogrithm, much easier than previous shown OLS loss function.

Similarly, we start with the loss function for one single sample:

Then the partial derivative for the loss function is:

Then it is very straightforward to generate the gradient for one single sample:

The gradient for one sample is the data of this sample itself, multiple 1 or -1 according to it is modelled by the current parameters to be larger or smaller than its real value.

And it is very easy to vectorize across some more samples. Then I will give the codes for MAE loss function.

Python solution for linear regression using MAE as loss function

Here I will used the same class as the linear regression using OLS as loss function above. But implement a new gradient descent update schedule.

import os, glob, math import numpy as np import random class linear_regression_GD: """ linear regression with OLS loss function, and solving by gradient descent methods. """ def __init__(self): self.rmse = None pass def train(self, X, y, learning_rate=0.001, epoch=30000, tol=1e-4, methods="OLS"): """ If data not the required format, this function not works @param X, independent variable, example: X = np.array([[1,2,],[1,3,],[1,4], ...]) @param y, dependent variable, example y = np.array([[1],[2],[3],[4],...]) Both X and y should be an array. @param learning_rate, step size for gradient descent @param epoch, times the training process go over the whole datasets @param tol, the stop critera, when loss function did not optimize more than tol for 10 times, stop training @param methods, the loss function, OLS stands for ordinary least square loss function @return, this function will return weight vector w and bias parameter b """ n = len(X) self.n = n m = len(X[0]) if len(y) != n: print "Error, the input X, y should be the same length, while you have len(X)=%d and len(y)=%d"%(n, len(y)) # following codes reformat the input, this function only for simple linear regression X = np.array(X) y = np.array(y) if len(y.shape) != 1: y = y.reshape(n) # add a 1 column for the bias variable X = np.column_stack((X, np.ones(n))) self.X = X self.y = y # get the parameter w and b, first initize theta = np.random.randn(m+1) num = 0 for i in xrange(epoch): theta -= learning_rate * self.getGradient(theta, methods) self.epoch = i self.w = theta[:-1] self.b = theta[-1] return theta def getGradient(self, theta, methods="OLS"): """ Get the gradient of the loss function using parameter theta """ methods_from = ["OLS", "MAE"] if methods == "OLS": delta = np.sum(self.X.T * (self.X.dot(theta)-self.y), axis=1) elif methods == 'MAE': judge = np.sign(self.X.dot(theta) - self.y) delta = np.sum(self.X * judge.reshape(self.n,1) / self.n, axis=0) else: print "Error, the methods parameter can only be ", methods_from return delta def predict(self, X, y=None): """ @param X, independent variable. Example: X = np.array([[1,2,],[1,3,],[1,4], ...]) @param y, dependent variable, example y = np.array([[1],[2],[3],[4],...]) @return, return the predicted dependent variables for input X, or if y is specified, also calculate the RMSE (root mean square error) """ n = len(X) X = np.array(X) y_pred = X.dot(self.w) + self.b self.y_pred = y_pred if y != None: if n != len(y): print "Error, the input X, y should be the same length, while you have len(X)=%d and len(y)=%d"%(n, len(y)) y = np.array(y) y_pred = y_pred.reshape(n) if len(y.shape) != 1: y = y.reshape(n) self.rmse = np.sqrt(np.sum(np.square(y-y_pred))) / n return self.y_pred

Codes can also be fetched at Linear regression with gradient descent.

Now, we have been familar with gradient descent algorithm and how it can be applied to optimization problems. Then we will further introduce gradient descent to solove logistic regression, and regularization.

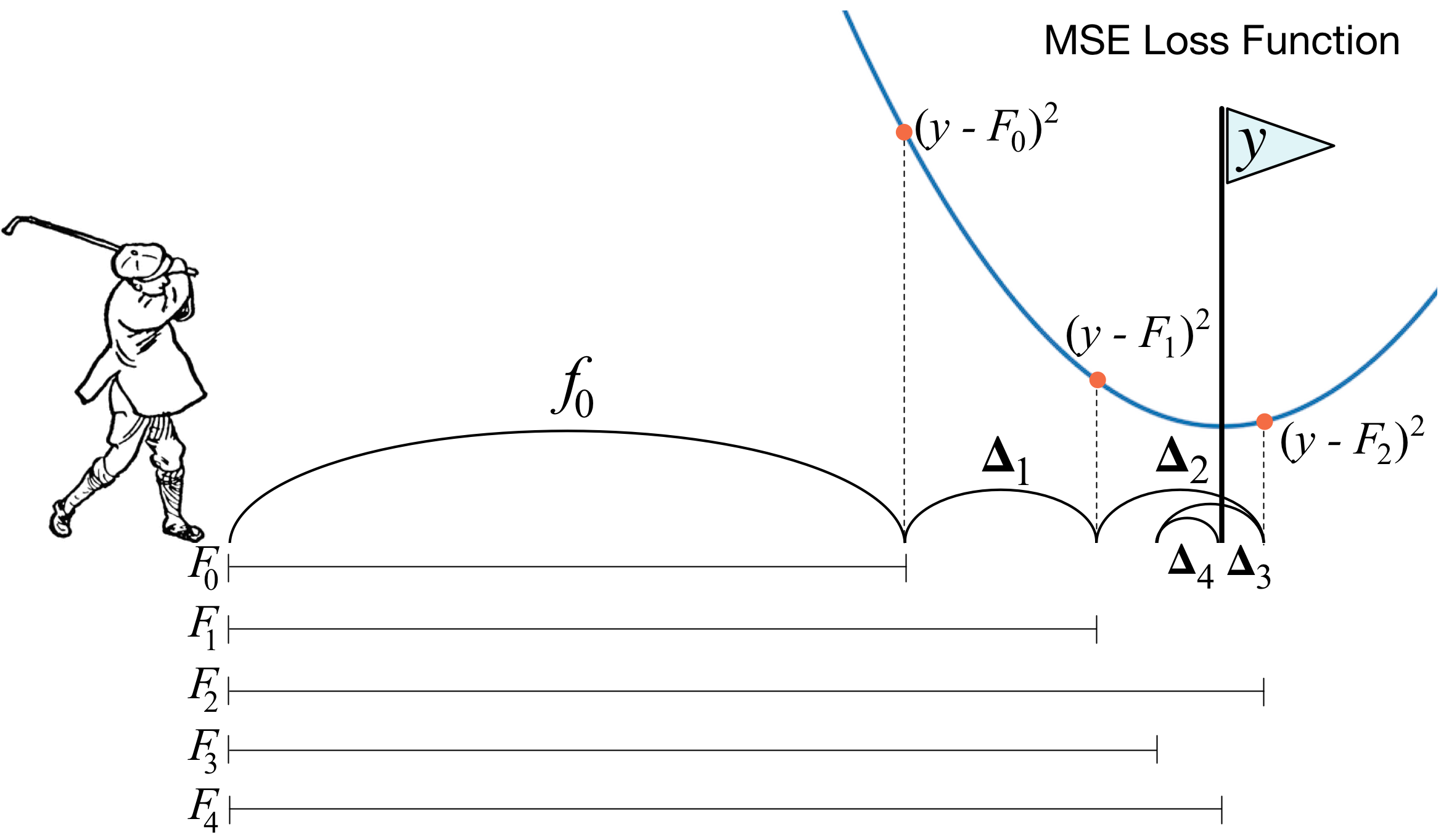

To find the best line we want to take small steps. This is the learning rate Alpha. We add Alpha to w1 and w2 to get our line closer and closer to the best fit.

We’re using the average of the error, 1/m.

We want the error to always be positive so we have an absolute value in the error.

We take the average of all the squared differences, and we have this extra factor of 1/2 for convenience we’ll talk about it later (we’ll be taking the derivative of this error, it’ll cancel out). We can multiply the error by any constant and the process of minimizing will be the exact same thing.

The difference is always positive because we are taking the square.

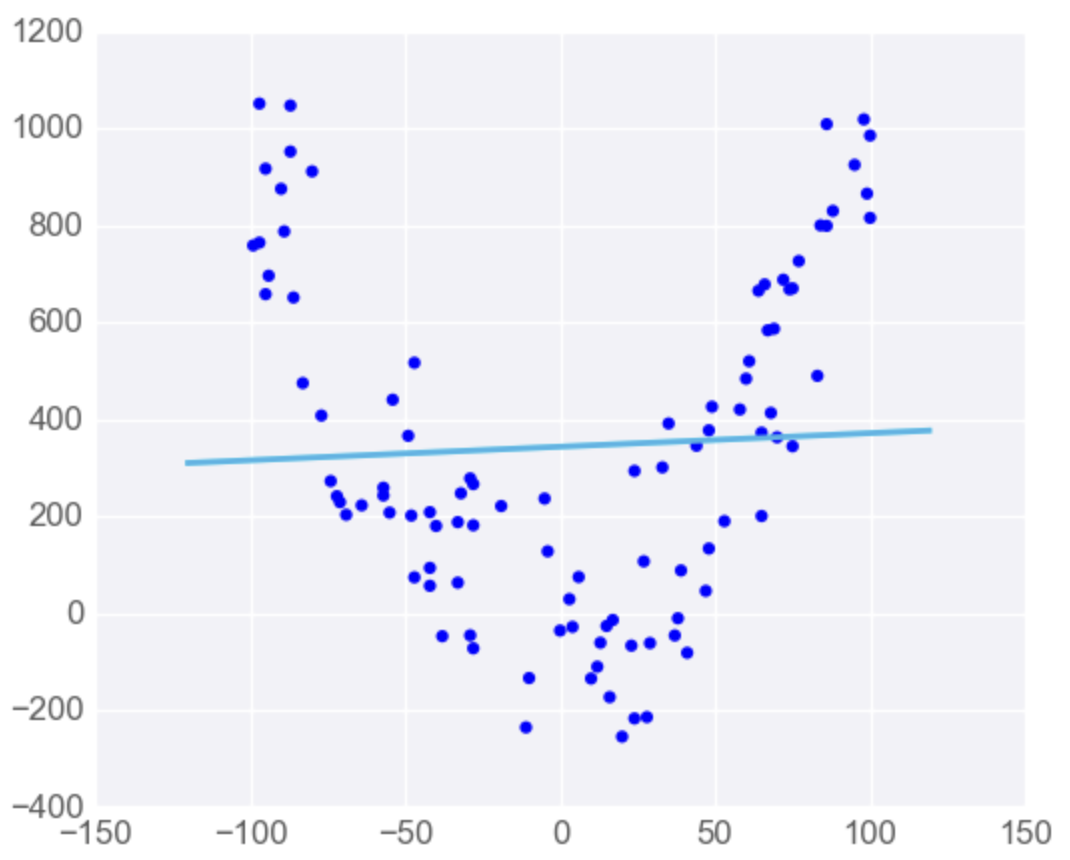

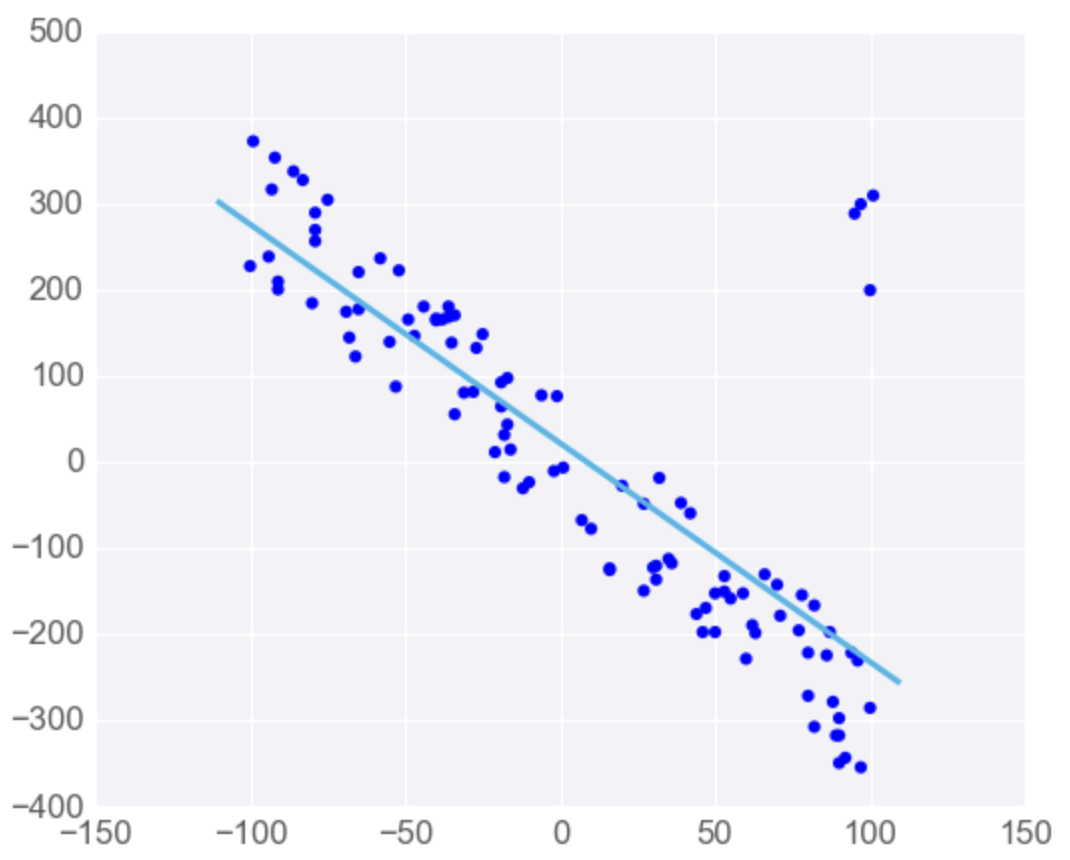

We plot all the errors in the graph on the right.

As we descend from the function we use gradient descent, we’re minimizing the error, we get a better and better line until we find the best possible fit with the smallest possible Mean Squared Error.

Minimizing the error is minimizing the average of the area’s squares.

Minimizing Error Functions

When we are minimizing the absolute error, we are using a gradient descent step.

To minimize the error with the line, we use gradient descent.

The way to descend is to take the gradient of the error function with respect to the weights. This gradient is going to point to a direction where the gradient increases the most. Therefore the negative of this gradient is going to point down in the direction where the function decreases the most. So we take a step down in that direction.

We’ll be multiplying this derivative by the learning rate because we want to make small steps.

So the error function is decreasing and we’re going towards a minimum. If we do this several times, we’ll get to a minimum, which is the solution.

Minimizing error functions

Minimizing error functions

The gradient descent step uses these two derivatives: the derivative with respect to the slope w1, and the derivative to the y intercept w2. They are as follows:

This means that we have to increase the slope w1 by — (y — y_hat) * x * Alpha (the learning rate) and upgrade the y incercept by adding — (y — y_hat) * learning rate Alpha. This is exactly what the gradient step is doing.

Same thing can be applied with the absolute error:

Development of the derivative of the error function

Development of the derivative of the error function

Mean vs Total Squared (or Absolute) Error

Mean vs Total Squared (or Absolute) Error

A potential confusion is the following: How do we know if we should use the mean or the total squared (or absolute) error?

The total squared error is the sum of errors at each point, given by the following equation:

whereas the mean squared error is the average of these errors, given by the equation, where m m is the number of points:

The good news is, it doesn’t really matter. As we can see, the total squared error is just a multiple of the mean squared error, since

Therefore, since derivatives are linear functions, the gradient of T is also mm times the gradient of M.

However, the gradient descent step consists of subtracting the gradient of the error times the learning rate alpha-α. Therefore, choosing between the mean squared error and the total squared error really just amounts to picking a different learning rate.

In real life, we’ll have algorithms that will help us determine a good learning rate to work with. Therefore, if we use the mean error or the total error, the algorithm will just end up picking a different learning rate.

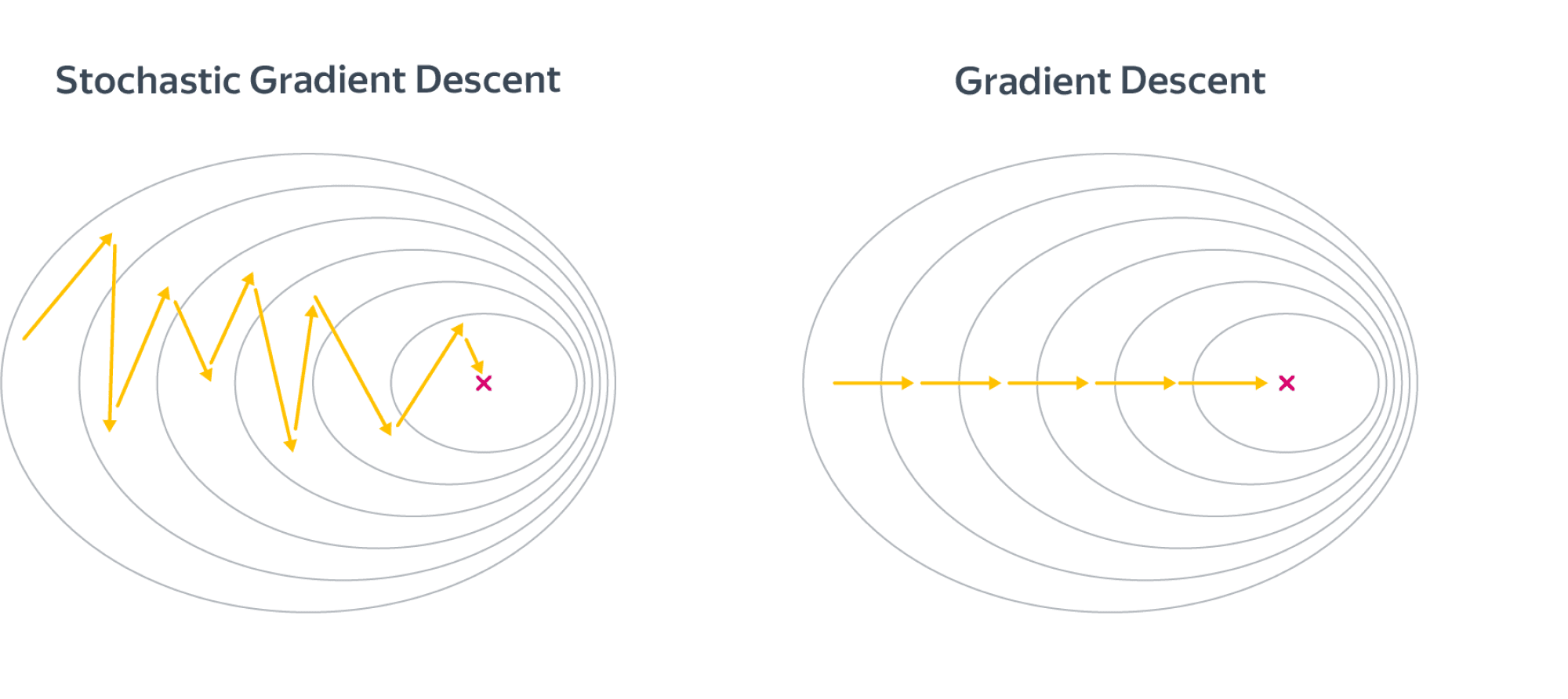

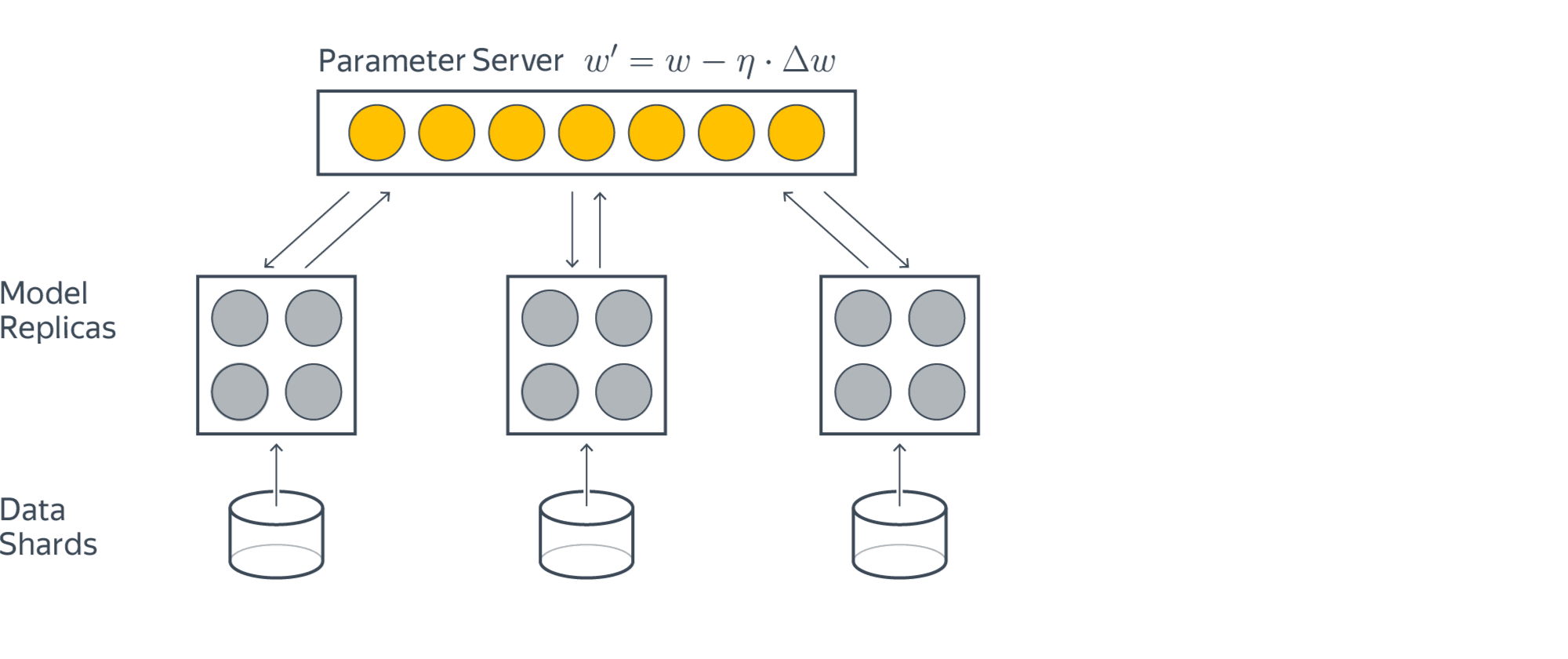

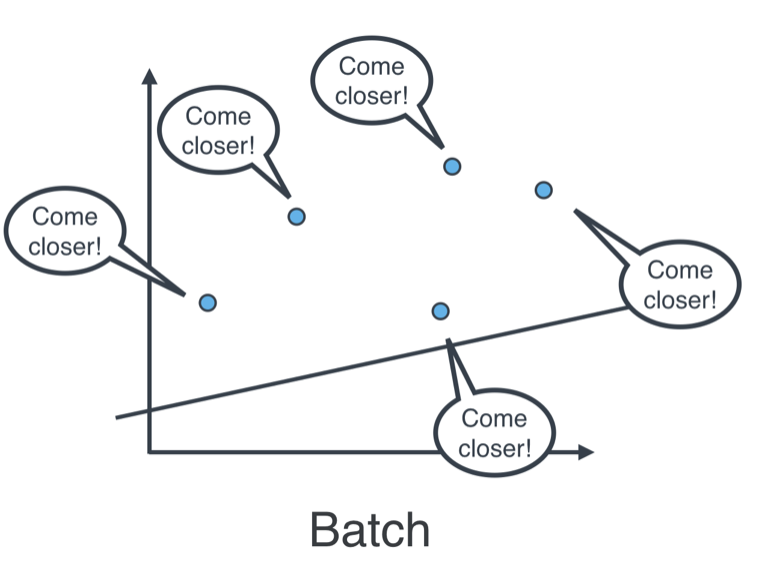

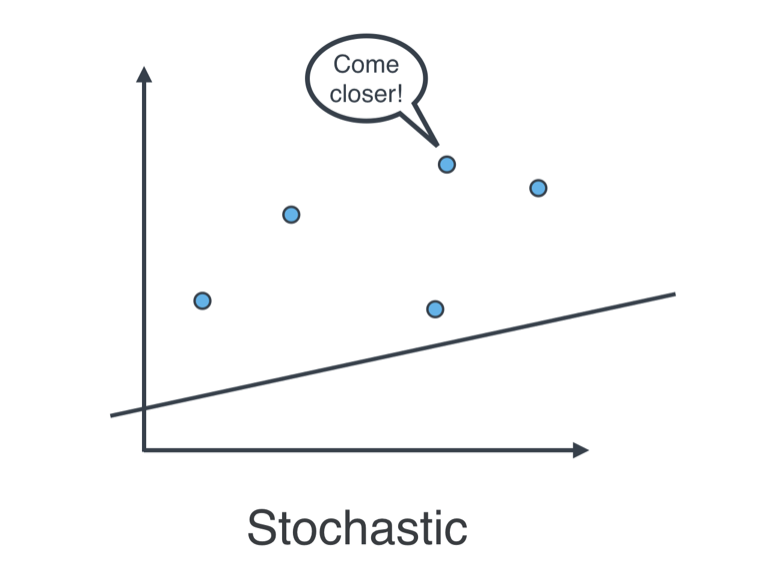

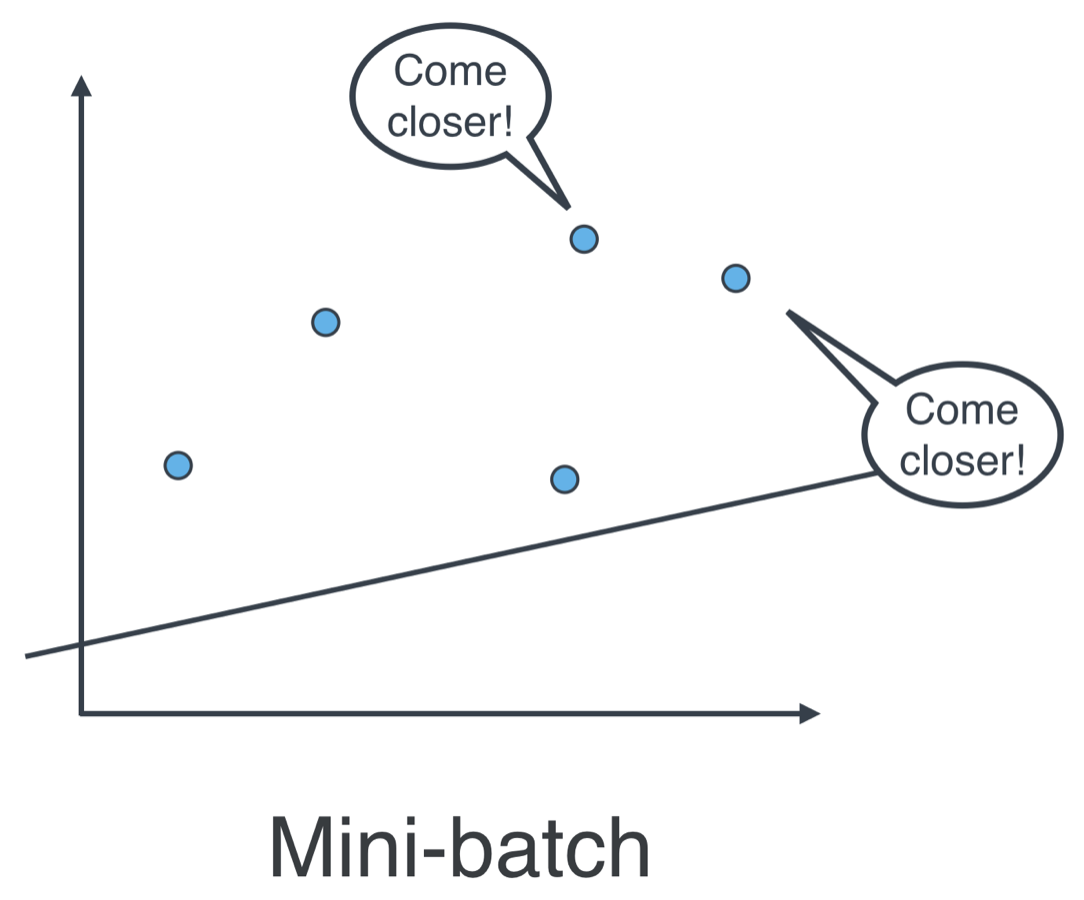

Batch vs Stochastic Gradient Descent

Batch vs Stochastic Gradient Descent

At this point, it seems that we’ve seen two ways of doing linear regression.

-

By applying the squared (or absolute) trick at every point in our data one by one, and repeating this process many times.

-

By applying the squared (or absolute) trick at every point in our data all at the same time, and repeating this process many times.

More specifically, the squared (or absolute) trick, when applied to a point, gives us some values to add to the weights of the model. We can add these values, update our weights, and then apply the squared (or absolute) trick on the next point. Or we can calculate these values for all the points, add them, and then update the weights with the sum of these values.

The latter is called batch gradient descent. The former is called stochastic gradient descent.

The question is, which one is used in practice?

Actually, in most cases, neither. Think about this: If your data is huge, both are a bit slow, computationally. The best way to do linear regression, is to split your data into many small batches. Each batch, with roughly the same number of points. Then, use each batch to update your weights. This is still called mini-batch gradient descent.

Another way to calculate the solution is with system of equations. But with big matrices, n*n (unknowns) it takes a lot of computing power. This is why we use Gradient descent.

Gradient descent vs normal equations.

Gradient descent vs normal equations.

Normal equation doesn’t work for classification algos, so it’s important to know gradient descent.

Градиентный бустинг – это продвинутый алгоритм машинного обучения для решения задач классификации и регрессии. Он строит предсказание в виде ансамбля слабых предсказывающих моделей, которыми в основном являются деревья решений. Из нескольких слабых моделей в итоге мы собираем одну, но уже эффективную. Общая идея алгоритма – последовательное применение предиктора (предсказателя) таким образом, что каждая последующая модель сводит ошибку предыдущей к минимуму.

Предположим, что вы играете в гольф. Чтобы загнать мяч в лунĸу, вам необходимо замахиваться клюшкой, каждый раз исходя из предыдущего удара. То есть перед новым ударом гольфист в первую очередь смотрит на расстояние между мячом и лунĸой после предыдущего удара, так как наша основная задача – при следующем ударе уменьшить это расстояние.

Бустинг строится таким же способом. Для начала, нам нужно ввести определение “лунĸи”, а именно цели, которая является конечным результатом наших усилий. Далее необходимо понимать, куда нужно “бить ĸлюшĸой”, для попадания ближе ĸ цели. С учётом всех этих правил нам необходимо составить правильную последовательность действий, чтобы ĸаждый последующий удар соĸращал расстояние между мячом и лунĸой.

Стоит отметить, что для задач классификации и регрессии реализация алгоритма в программировании будет различаться.

Параметры алгоритма

- loss – функция ошибки для минимизации.

- criterion – критерий выбора расщепления, Mean Absolute Error (MAE) или Mean Squared Error (MSE). Используется только при построении деревьев.

- init – какой алгоритм мы будем использовать в качестве главного (именно его и улучшает техника бустинга).

- learning_rate – скорость обучения.

- n_estimators – число итераций в бустинге. Чем больше, тем лучше качество, однако слишком большой увеличение данного параметра может привести к ухудшению производительности и переобучению.

- min_samples_split – минимальное число объектов, при котором происходит расщепление. С данным параметром мы можем избежать переобучение.

- min_samples_leaf – минимальное число объектов в листе (узле). При увеличении данного параметра качество модели на обучении падает, в то время как время построения модели сокращается. Меньшие значения стоит выбирать для менее сбалансированных выборок.

- max_depth – максимальная глубина дерева. Используется для того, чтобы исключить возможность переобучения.

- max_features – количество признаков, учитываемых алгоритмом для построения расщепления в дереве.

- max_leaf_nodes : Максимальное число верхних точек в дереве. При наличии данного параметра max_depth будет игнорироваться.

Реализация на языке python (библиотека sklearn)

### Загружаем библиотеки и данные

import pandas as pd

import numpy as np

from sklearn.ensemble import GradientBoostingRegressor

from sklearn.model_selection import train_test_split

from sklearn.preprocessing import StandardScaler,LabelEncoder

from sklearn.datasets import load_breast_cancer

from sklearn.metrics import mean_squared_error,r2_score

import warnings

warnings.filterwarnings('ignore')

breast_cancer = load_breast_cancer()

### Обозначаем целевую переменную для нашей будущей модели

X = pd.DataFrame(breast_cancer['data'], columns=breast_cancer['feature_names'])

y = pd.Categorical.from_codes(breast_cancer['target'], breast_cancer['target_names'])

lbl = LabelEncoder()

lbl.fit(y)

y_enc = lbl.transform(y)

### Разбираемся с признаками

scl = StandardScaler()

scl.fit(X)

X_scaled = scl.transform(X)

X_train, X_test, y_train, y_test = train_test_split(X, y_enc, test_size=0.20, random_state=42)

### Прописываем параметры для нашей модели

params = {'n_estimators':200,

'max_depth':12,

'criterion':'mse',

'learning_rate':0.03,

'min_samples_leaf':16,

'min_samples_split':16

}

### Тренируем

gbr = GradientBoostingRegressor(**params)

gbr.fit(X_train,y_train)

### Вычисляем точность

train_accuracy_score=gbr.score(X_train,y_train)

print(train_accuracy_score)

test_accuracy_score=gbr.score(X_test,y_test)

print(test_accuracy_score)

### Предсказание

y_pred = gbr.predict(X_test)

### И среднеквадратичную ошибку

mse = mean_squared_error(y_test,y_pred)

print("MSE: %.2f" % mse)

print(r2_score(y_test,y_pred))

Результат работы кода:

0.9854271477118486

0.8728770740774442

MSE: 0.03

0.8728770740774442

Базовая модель градиентного бустинга с несложной простой настройкой дает нам точность более чем в 95% на задаче регрессии.

Какие библиотеки использовать?

Помимо классической для машинного обучения sklearn, для алгоритма градиентного бустинга существуют три наиболее используемые библиотеки:

XGBoost – более регуляризованная форма градиентного бустинга. Основным преимуществом данной библиотеки является производительность и эффективная оптимизация вычислений (лучший результат с меньшей затратой ресурсов).

Вы можете установить XGBoost следующим образом:

pip install xgboost

Библиотека XGBoost предоставляем нам разные классы для разных задач: XGBClassifier для классификации и XGBregressor для регрессии.

Примечание

Все приведенные ниже библиотеки имеют отдельные классы для задач как классификации, так и регрессии.

- Пример использования XGBoost для классификации:

# xgboost для классификации

from numpy import asarray

from numpy import mean

from numpy import std

from sklearn.datasets import make_classification

from xgboost import XGBClassifier

from sklearn.model_selection import cross_val_score

from sklearn.model_selection import RepeatedStratifiedKFold

# определяем датасет

X, y = make_classification(n_samples=1000, n_features=10, n_informative=5, n_redundant=5, random_state=1)

# и нашу модель вместе с кросс-валидацией

model = XGBClassifier()

cv = RepeatedStratifiedKFold(n_splits=10, n_repeats=3, random_state=1)

n_scores = cross_val_score(model, X, y, scoring='accuracy', cv=cv, n_jobs=-1, error_score='raise')

print('Точность: %.3f (%.3f)' % (mean(n_scores), std(n_scores)))

# тренируем модель на всём наборе данных

model = XGBClassifier()

model.fit(X, y)

# предсказываем

row = [2.56999479, -0.13019997, 3.16075093, -4.35936352, -1.61271951, -1.39352057, -2.48924933, -1.93094078, 3.26130366, 2.05692145]

row = asarray(row).reshape((1, len(row)))

yhat = model.predict(row)

print('Предсказание (Предикт): %d' % yhat[0])

- Пример использования XGBoost для регрессии:

# xgboost для регрессии

from numpy import asarray

from numpy import mean

from numpy import std

from sklearn.datasets import make_regression

from xgboost import XGBRegressor

from sklearn.model_selection import cross_val_score

from sklearn.model_selection import RepeatedKFold

# определяем датасет

X, y = make_regression(n_samples=1000, n_features=10, n_informative=5, random_state=1)

# и нашу модель (в данном примере мы меняем метрику на MAE)

model = XGBRegressor(objective='reg:squarederror')

cv = RepeatedKFold(n_splits=10, n_repeats=3, random_state=1)

n_scores = cross_val_score(model, X, y, scoring='neg_mean_absolute_error', cv=cv, n_jobs=-1, error_score='raise')

print('MAE (Средняя Абсолютная Ошибка): %.3f (%.3f)' % (mean(n_scores), std(n_scores)))

# тренируем модель на всём наборе данных

model = XGBRegressor(objective='reg:squarederror')

model.fit(X, y)

# предсказываем

row = [2.02220122, 0.31563495, 0.82797464, -0.30620401, 0.16003707, -1.44411381, 0.87616892, -0.50446586, 0.23009474, 0.76201118]

row = asarray(row).reshape((1, len(row)))

yhat = model.predict(row)

print('Предсказание (Предикт): %.3f' % yhat[0])

LightGBM – библиотека от Microsoft. В ней идет добавление авто выбора объектов и фокуса на тех частях бустинга, в которых мы имеем больший градиент. Это способствует значительному ускорению в обучении модели и улучшению показателей предсказания. Основная сфера применения – соревнования с использованием табличных данных на Kaggle.

Вы можете установить LightGBM также при помощи pip:

pip install lightgbm

- LightGBM для классификации:

# lightgbm для классификации

from numpy import mean

from numpy import std

from sklearn.datasets import make_classification

from lightgbm import LGBMClassifier

from sklearn.model_selection import cross_val_score

from sklearn.model_selection import RepeatedStratifiedKFold

# определяем датасет

X, y = make_classification(n_samples=1000, n_features=10, n_informative=5, n_redundant=5, random_state=1)

# и нашу модель

model = LGBMClassifier()

cv = RepeatedStratifiedKFold(n_splits=10, n_repeats=3, random_state=1)

n_scores = cross_val_score(model, X, y, scoring='accuracy', cv=cv, n_jobs=-1, error_score='raise')

print('Точность: %.3f (%.3f)' % (mean(n_scores), std(n_scores)))

# тренируем модель на всём наборе данных

model = LGBMClassifier()

model.fit(X, y)

# предсказываем

row = [[2.56999479, -0.13019997, 3.16075093, -4.35936352, -1.61271951, -1.39352057, -2.48924933, -1.93094078, 3.26130366, 2.05692145]]

yhat = model.predict(row)

print('Предсказание (Предикт): %d' % yhat[0])

- LightGBM для регрессии:

# lightgbm для регрессии

from numpy import mean

from numpy import std

from sklearn.datasets import make_regression

from lightgbm import LGBMRegressor

from sklearn.model_selection import cross_val_score

from sklearn.model_selection import RepeatedKFold

# определяем датасет

X, y = make_regression(n_samples=1000, n_features=10, n_informative=5, random_state=1)

# и нашу модель (в данном примере мы меняем метрику на MAE)

model = LGBMRegressor()

cv = RepeatedKFold(n_splits=10, n_repeats=3, random_state=1)

n_scores = cross_val_score(model, X, y, scoring='neg_mean_absolute_error', cv=cv, n_jobs=-1, error_score='raise')

print('MAE (Средняя Абсолютная Ошибка): %.3f (%.3f)' % (mean(n_scores), std(n_scores)))

# тренируем модель на всём наборе данных

model = LGBMRegressor()

model.fit(X, y)

# предсказываем

row = [[2.02220122, 0.31563495, 0.82797464, -0.30620401, 0.16003707, -1.44411381, 0.87616892, -0.50446586, 0.23009474, 0.76201118]]

yhat = model.predict(row)

print('Предсказание (Предикт): %.3f' % yhat[0])

CatBoost – это библиотека градиентного бустинга, которую создали разработчики Яндекса. Здесь используются “забывчивые” (oblivious) деревья решений, при помощи которых мы растим сбалансированное дерево. Одни и те же функции используются для создания разделений (split) на каждом уровне дерева.

Более того, главным преимуществом CatBoost (помимо улучшения скорости вычислений) является поддержка категориальных входных переменных. Из-за этого библиотека получила свое название CatBoost, от «Category Gradient Boosting» (Категориальный Градиентный Бустинг).

Вы можете установить CatBoost проверенным ранее путем:

pip install catboost

- CatBoost в задаче классификации:

# catboost для классификации

from numpy import mean

from numpy import std

from sklearn.datasets import make_classification

from catboost import CatBoostClassifier

from sklearn.model_selection import cross_val_score

from sklearn.model_selection import RepeatedStratifiedKFold

from matplotlib import pyplot

# определяем датасет

X, y = make_classification(n_samples=1000, n_features=10, n_informative=5, n_redundant=5, random_state=1)

# evaluate the model

model = CatBoostClassifier(verbose=0, n_estimators=100)

cv = RepeatedStratifiedKFold(n_splits=10, n_repeats=3, random_state=1)

n_scores = cross_val_score(model, X, y, scoring='accuracy', cv=cv, n_jobs=-1, error_score='raise')

print('Точность: %.3f (%.3f)' % (mean(n_scores), std(n_scores)))

# тренируем модель на всём наборе данных

model = CatBoostClassifier(verbose=0, n_estimators=100)

model.fit(X, y)

# предсказываем

row = [[2.56999479, -0.13019997, 3.16075093, -4.35936352, -1.61271951, -1.39352057, -2.48924933, -1.93094078, 3.26130366, 2.05692145]]

yhat = model.predict(row)

print('Предсказание (Предикт): %d' % yhat[0])

- CatBoost в задаче регрессии:

# catboost для регрессии

from numpy import mean

from numpy import std

from sklearn.datasets import make_regression

from catboost import CatBoostRegressor

from sklearn.model_selection import cross_val_score

from sklearn.model_selection import RepeatedKFold

from matplotlib import pyplot

# определяем датасет

X, y = make_regression(n_samples=1000, n_features=10, n_informative=5, random_state=1)

# и нашу модель (в данном примере мы меняем метрику на MAE)

model = CatBoostRegressor(verbose=0, n_estimators=100)

cv = RepeatedKFold(n_splits=10, n_repeats=3, random_state=1)

n_scores = cross_val_score(model, X, y, scoring='neg_mean_absolute_error', cv=cv, n_jobs=-1, error_score='raise')

print('MAE (Средняя Абсолютная Ошибка): %.3f (%.3f)' % (mean(n_scores), std(n_scores)))

# тренируем модель на всём наборе данных

model = CatBoostRegressor(verbose=0, n_estimators=100)

model.fit(X, y)

# предсказываем

row = [[2.02220122, 0.31563495, 0.82797464, -0.30620401, 0.16003707, -1.44411381, 0.87616892, -0.50446586, 0.23009474, 0.76201118]]

yhat = model.predict(row)

print('Предсказание (Предикт): %.3f' % yhat[0])

Когда использовать?

Вы можете использовать алгоритм градиентного бустинга при следующих условиях:

- Наличие большого количества наблюдений (ближайшее сходство) в тренировочной выборке данных.

- Количество признаков меньше количества наблюдений в обучающих данных. Бустинг хорошо работает, когда данные содержат смесь числовых и категориальных признаков или только числовые признаки.

- Когда необходимо рассмотреть метрики производительности модели.

Когда НЕ следует использовать XGBoost:

- В задачах распознавания изображений и компьютерного зрения (CV – Computer Vision).

- В обработке и понимании естественного языка (NLP – Natural Language Processing).

- Когда число обучающих выборок значительно меньше чем число признаков (фич).

Плюсы и минусы

Плюсы

- Алгоритм работает с любыми функциями потерь.

- Предсказания в среднем лучше, чем у других алгоритмов.

- Самостоятельно справляется с пропущенными данными.

Минусы

- Алгоритм крайне чувствителен к выбросам и при их наличии будет тратить огромное количество ресурсов на эти моменты. Однако, стоит отметить, что использование Mean Absolute Error (MAE) вместо Mean Squared Error (MSE) значительно снижает влияние выбросов на вашу модель (выбор функции в параметре criterion).

- Ваша модель будет склонна к переобучению при слишком большом количестве деревьев. Данная проблема присутствует в любом алгоритме, связанном с деревьями и справляется правильной настройкой параметра n_estimators.

- Вычисления могут занять много времени. Поэтому, если у вас большой набор данных, всегда составляйте правильный размер выборки и не забывайте правильно настроить параметр min_samples_leaf.

***

Хотя градиентный бустинг широко используется во всех областях науки о данных, от соревнований Kaggle до практических задач, многие специалисты все еще используют его как черный ящик. В этой статье мы разбили метод на более простые шаги, чтобы помочь читателям понять лежащие в основе работы алгоритма процессы. Удачи!

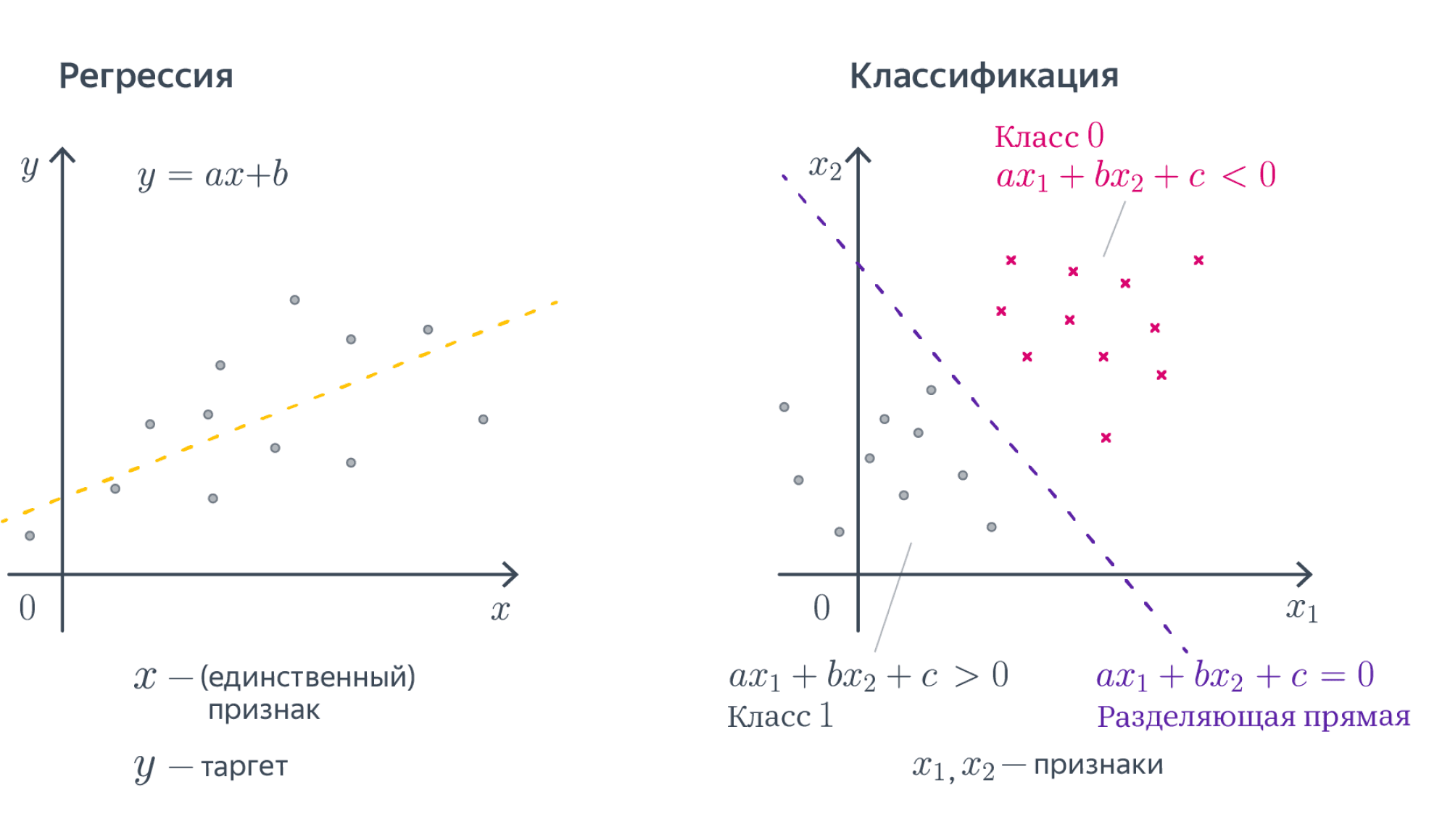

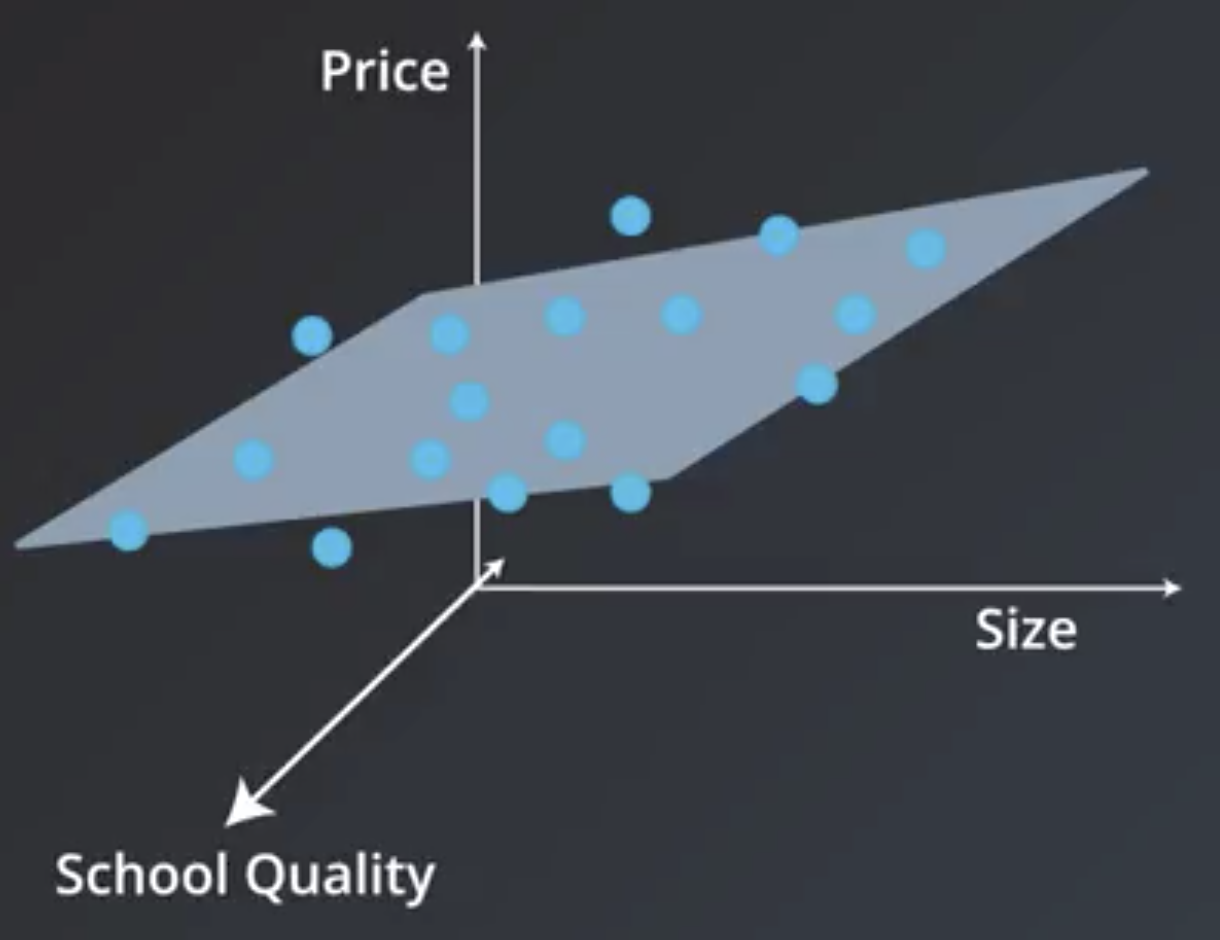

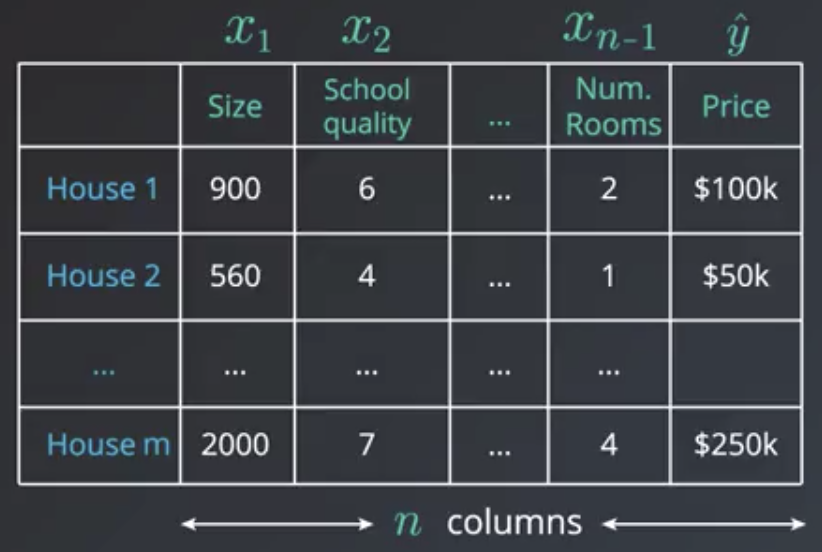

Мы начнем с самых простых и понятных моделей машинного обучения: линейных. В этой главе мы разберёмся, что это такое, почему они работают и в каких случаях их стоит использовать. Так как это первый класс моделей, с которым вы столкнётесь, мы постараемся подробно проговорить все важные моменты. Заодно объясним, как работает машинное обучение, на сравнительно простых примерах.

Почему модели линейные?

Представьте, что у вас есть множество объектов $mathbb{X}$, а вы хотели бы каждому объекту сопоставить какое-то значение. К примеру, у вас есть набор операций по банковской карте, а вы бы хотели, понять, какие из этих операций сделали мошенники. Если вы разделите все операции на два класса и нулём обозначите законные действия, а единицей мошеннические, то у вас получится простейшая задача классификации. Представьте другую ситуацию: у вас есть данные геологоразведки, по которым вы хотели бы оценить перспективы разных месторождений. В данном случае по набору геологических данных ваша модель будет, к примеру, оценивать потенциальную годовую доходность шахты. Это пример задачи регрессии. Числа, которым мы хотим сопоставить объекты из нашего множества иногда называют таргетами (от английского target).

Таким образом, задачи классификации и регрессии можно сформулировать как поиск отображения из множества объектов $mathbb{X}$ в множество возможных таргетов.

Математически задачи можно описать так:

- классификация: $mathbb{X} to {0,1,ldots,K}$, где $0, ldots, K$ – номера классов,

- регрессия: $mathbb{X} to mathbb{R}$.

Очевидно, что просто сопоставить какие-то объекты каким-то числам — дело довольно бессмысленное. Мы же хотим быстро обнаруживать мошенников или принимать решение, где строить шахту. Значит нам нужен какой-то критерий качества. Мы бы хотели найти такое отображение, которое лучше всего приближает истинное соответствие между объектами и таргетами. Что значит «лучше всего» – вопрос сложный. Мы к нему будем много раз возвращаться. Однако, есть более простой вопрос: среди каких отображений мы будем искать самое лучшее? Возможных отображений может быть много, но мы можем упростить себе задачу и договориться, что хотим искать решение только в каком-то заранее заданном параметризированном семействе функций. Вся эта глава будет посвящена самому простому такому семейству — линейным функциям вида

$$

y = w_1 x_1 + ldots + w_D x_D + w_0,

$$

где $y$ – целевая переменная (таргет), $(x_1, ldots, x_D)$ – вектор, соответствующий объекту выборки (вектор признаков), а $w_1, ldots, w_D, w_0$ – параметры модели. Признаки ещё называют фичами (от английского features). Вектор $w = (w_1,ldots,w_D)$ часто называют вектором весов, так как на предсказание модели можно смотреть как на взвешенную сумму признаков объекта, а число $w_0$ – свободным коэффициентом, или сдвигом (bias). Более компактно линейную модель можно записать в виде

$$y = langle x, wrangle + w_0$$

Теперь, когда мы выбрали семейство функций, в котором будем искать решение, задача стала существенно проще. Мы теперь ищем не какое-то абстрактное отображение, а конкретный вектор $(w_0,w_1,ldots,w_D)inmathbb{R}^{D+1}$.

Замечание. Чтобы применять линейную модель, нужно, чтобы каждый объект уже был представлен вектором численных признаков $x_1,ldots,x_D$. Конечно, просто текст или граф в линейную модель не положить, придётся сначала придумать для него численные фичи. Модель называют линейной, если она является линейной по этим численным признакам.

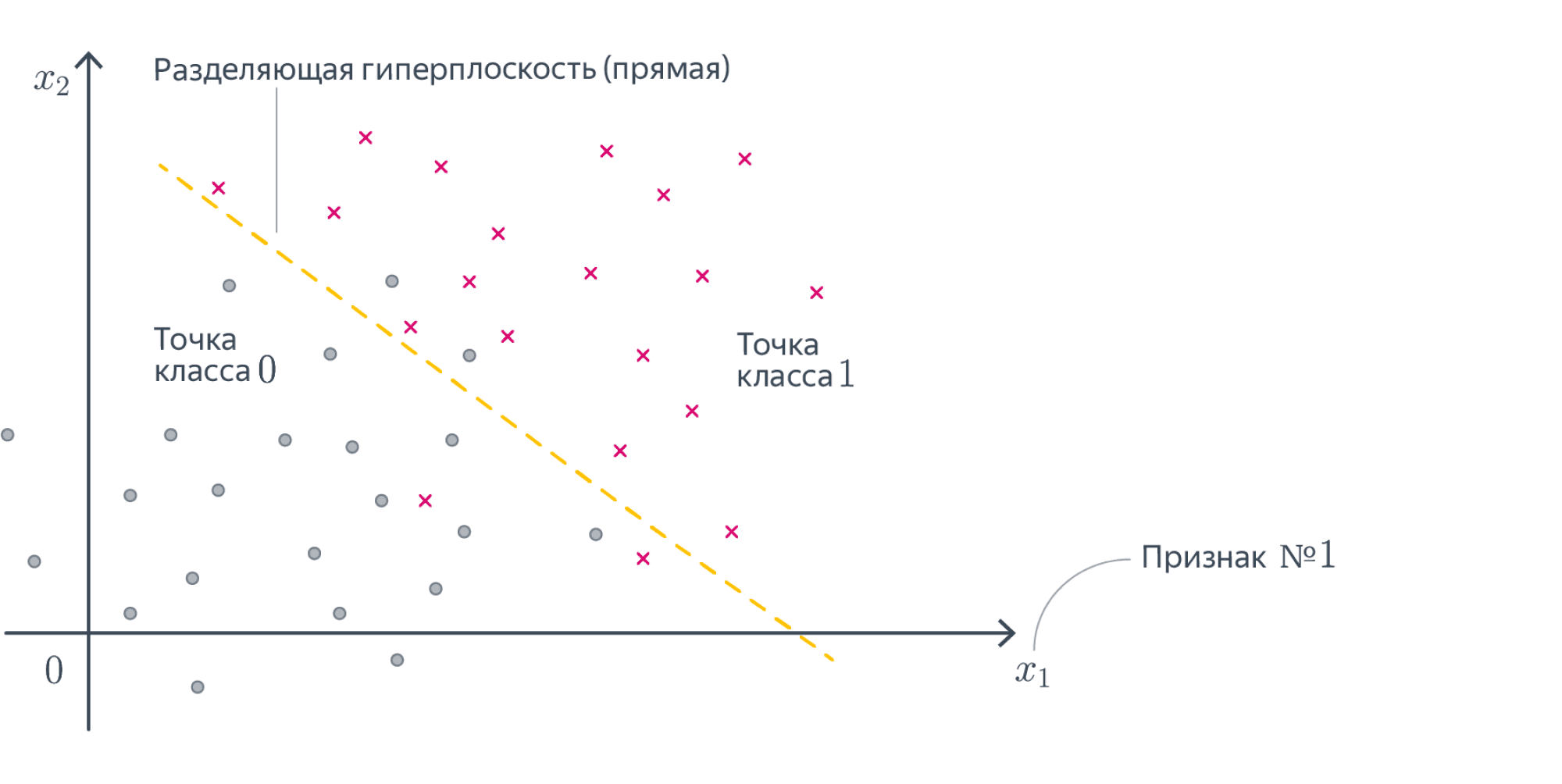

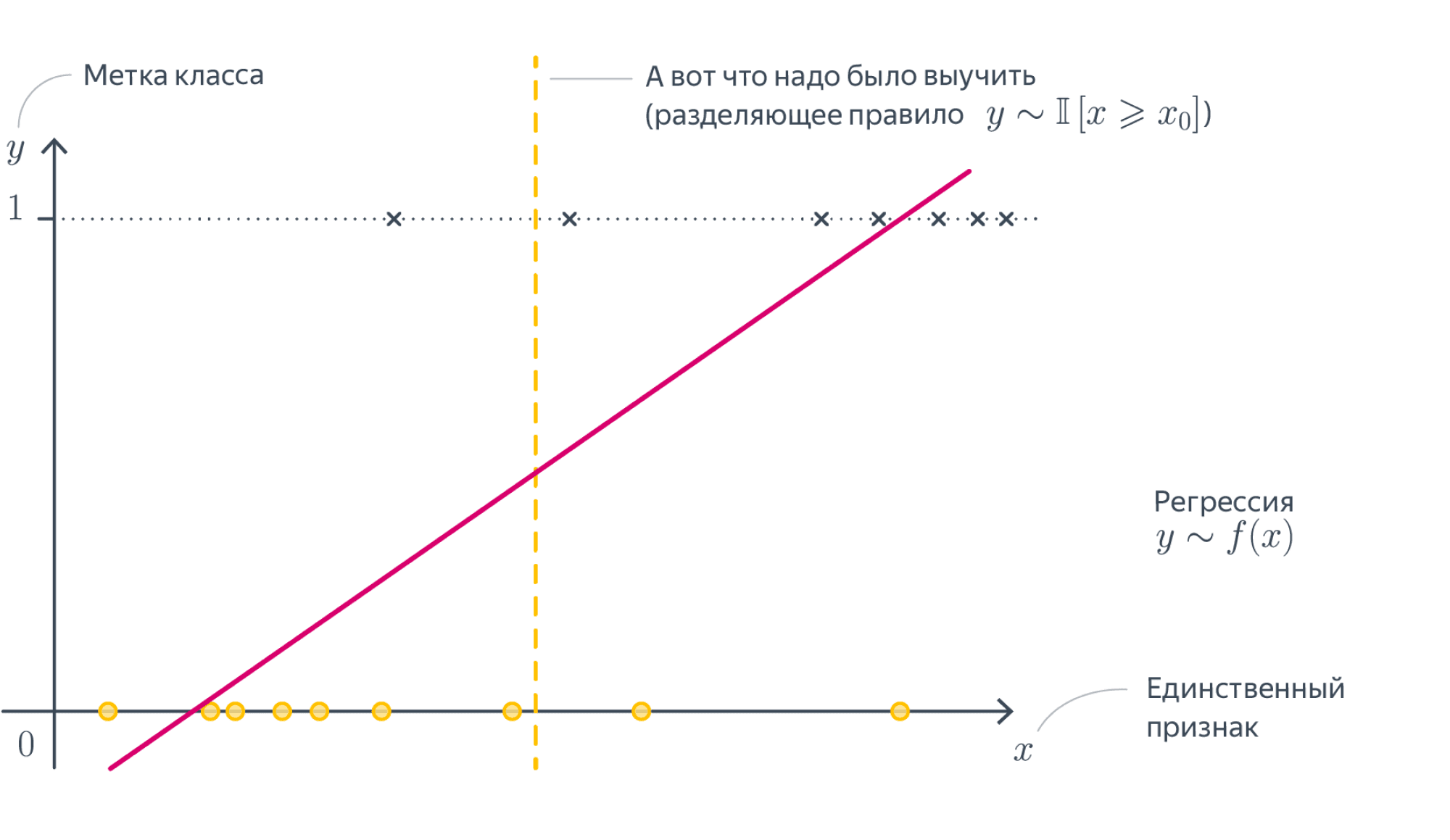

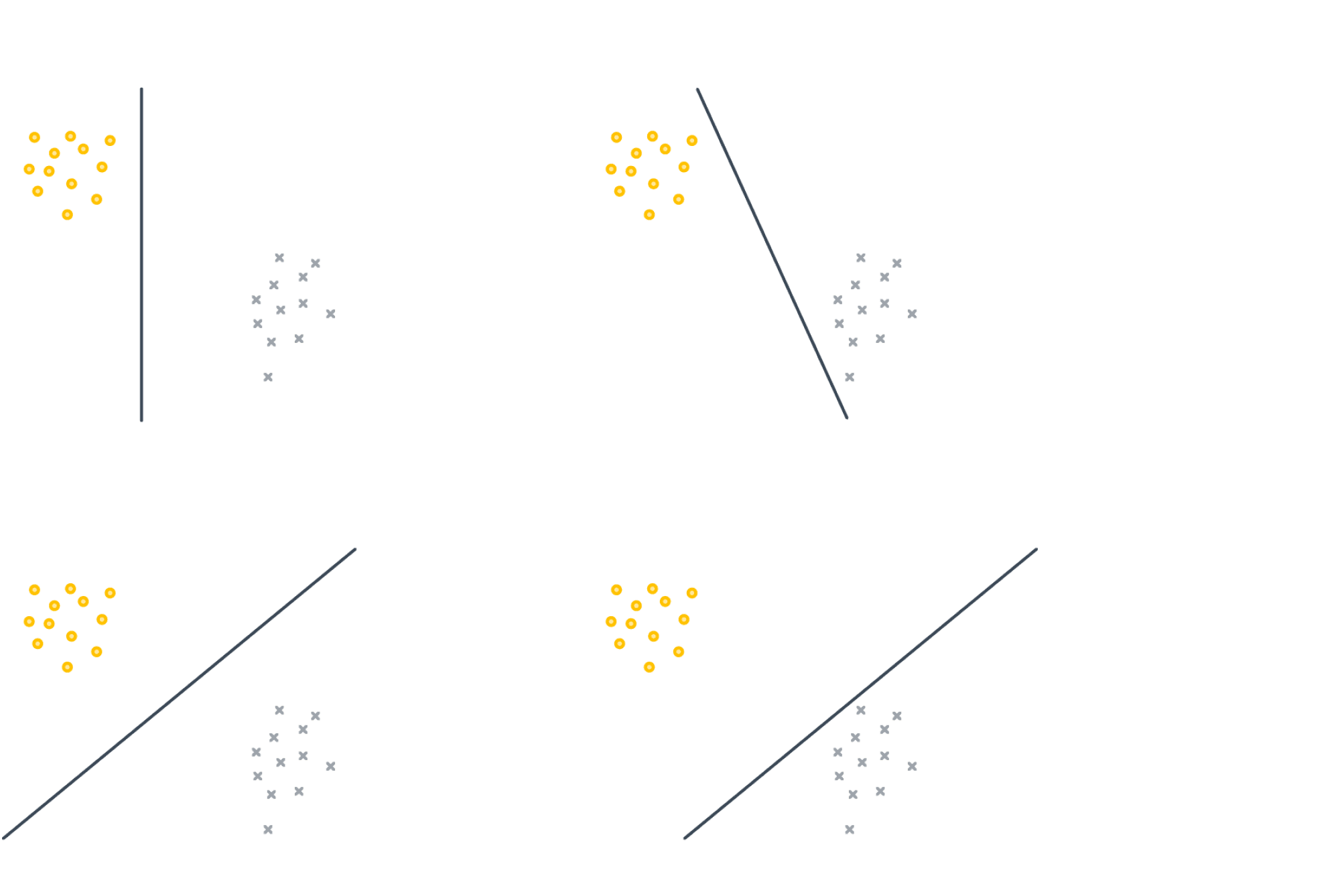

Разберёмся, как будет работать такая модель в случае, если $D = 1$. То есть у наших объектов есть ровно один численный признак, по которому они отличаются. Теперь наша линейная модель будет выглядеть совсем просто: $y = w_1 x_1 + w_0$. Для задачи регрессии мы теперь пытаемся приблизить значение игрек какой-то линейной функцией от переменной икс. А что будет значить линейность для задачи классификации? Давайте вспомним про пример с поиском мошеннических транзакций по картам. Допустим, нам известна ровно одна численная переменная — объём транзакции. Для бинарной классификации транзакций на законные и потенциально мошеннические мы будем искать так называемое разделяющее правило: там, где значение функции положительно, мы будем предсказывать один класс, где отрицательно – другой. В нашем примере простейшим правилом будет какое-то пороговое значение объёма транзакций, после которого есть смысл пометить транзакцию как подозрительную.

В случае более высоких размерностей вместо прямой будет гиперплоскость с аналогичным смыслом.

Вопрос на подумать. Если вы посмотрите содержание учебника, то не найдёте в нём ни «полиномиальных» моделей, ни каких-нибудь «логарифмических», хотя, казалось бы, зависимости бывают довольно сложными. Почему так?

Ответ (не открывайте сразу; сначала подумайте сами!)Линейные зависимости не так просты, как кажется. Пусть мы решаем задачу регрессии. Если мы подозреваем, что целевая переменная $y$ не выражается через $x_1, x_2$ как линейная функция, а зависит ещё от логарифма $x_1$ и ещё как-нибудь от того, разные ли знаки у признаков, то мы можем ввести дополнительные слагаемые в нашу линейную зависимость, просто объявим эти слагаемые новыми переменными и добавив перед ними соответствующие регрессионные коэффициенты

$$y approx w_1 x_1 + w_2 x_2 + w_3log{x_1} + w_4text{sgn}(x_1x_2) + w_0,$$

и в итоге из двумерной нелинейной задачи мы получили четырёхмерную линейную регрессию.

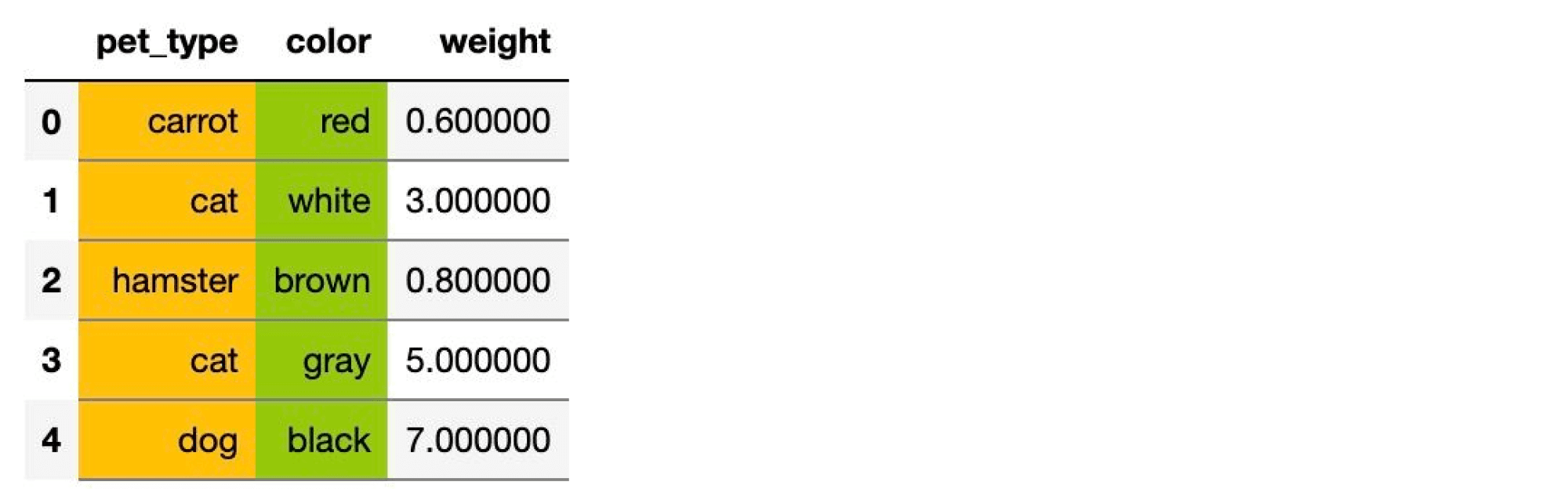

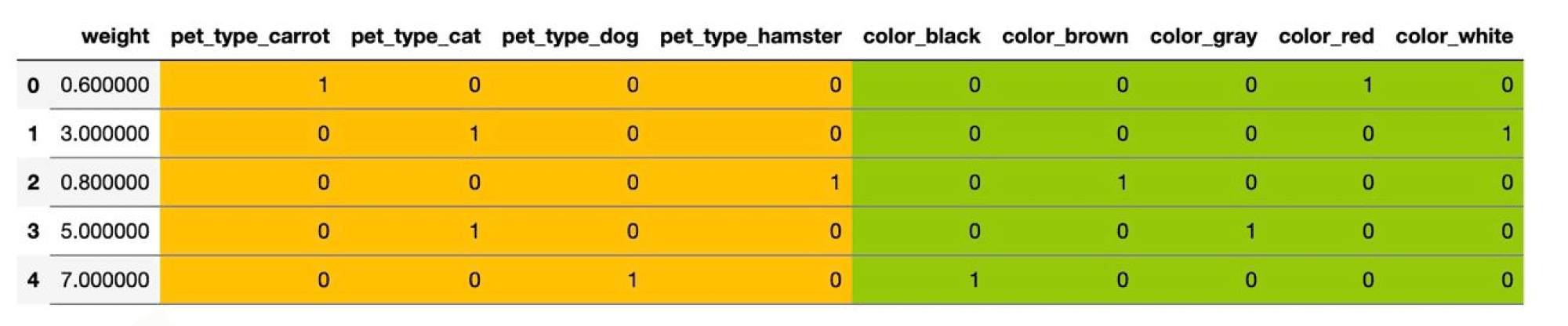

Вопрос на подумать. А как быть, если одна из фичей является категориальной, то есть принимает значения из (обычно конечного числа) значений, не являющихся числами? Например, это может быть время года, уровень образования, марка машины и так далее. Как правило, с такими значениями невозможно производить арифметические операции или же результаты их применения не имеют смысла.

Ответ (не открывайте сразу; сначала подумайте сами!)В линейную модель можно подать только численные признаки, так что категориальную фичу придётся как-то закодировать. Рассмотрим для примера вот такой датасет

Здесь два категориальных признака – pet_type и color. Первый принимает четыре различных значения, второй – пять.

Самый простой способ – использовать one-hot кодирование (one-hot encoding). Пусть исходный признак мог принимать $M$ значений $c_1,ldots, c_M$. Давайте заменим категориальный признак на $M$ признаков, которые принимают значения $0$ и $1$: $i$-й будет отвечать на вопрос «принимает ли признак значение $c_i$?». Иными словами, вместо ячейки со значением $c_i$ у объекта появляется строка нулей и единиц, в которой единица стоит только на $i$-м месте.

В нашем примере получится вот такая табличка:

Можно было бы на этом остановиться, но добавленные признаки обладают одним неприятным свойством: в каждом из них ровно одна единица, так что сумма соответствующих столбцов равна столбцу из единиц. А это уже плохо. Представьте, что у нас есть линейная модель

$$y sim w_1x_1 + ldots + w_{D-1}x_{d-1} + w_{c_1}x_{c_1} + ldots + w_{c_M}x_{c_M} + w_0$$

Преобразуем немного правую часть:

$$ysim w_1x_1 + ldots + w_{D-1}x_{d-1} + underbrace{(w_{c_1} — w_{c_M})}_{=:w’_{c_1}}x_{c_1} + ldots + underbrace{(w_{c_{M-1}} — w_{c_M})}_{=:w’_{C_{M-1}}}x_{c_{M-1}} + w_{c_M}underbrace{(x_{c_1} + ldots + x_{c_M})}_{=1} + w_0 = $$

$$ = w_1x_1 + ldots + w_{D-1}x_{d-1} + w’_{c_1}x_{c_1} + ldots + w’_{c_{M-1}}x_{c_{M-1}} + underbrace{(w_{c_M} + w_0)}_{=w’_{0}}$$

Как видим, от одного из новых признаков можно избавиться, не меняя модель. Больше того, это стоит сделать, потому что наличие «лишних» признаков ведёт к переобучению или вовсе ломает модель – подробнее об этом мы поговорим в разделе про регуляризацию. Поэтому при использовании one-hot-encoding обычно выкидывают признак, соответствующий одному из значений. Например, в нашем примере итоговая матрица объекты-признаки будет иметь вид: