На основании Вашего запроса эти примеры могут содержать грубую лексику.

На основании Вашего запроса эти примеры могут содержать разговорную лексику.

As a result, we got a final forecasting model that minimizes the mean absolute percentage error (MAPE) to 6% for one particular city and 10% for the entire country in general.

В итоге мы получили финальную прогнозную модель, которая обеспечила значение средней абсолютной ошибки, выраженной в процентах (mean absolute percentage error, MAPE), равное 6% для одного данного города, и 10% — для страны в целом.

The trend of modernization influence on demand for labour force is revealed and taken under consideration while developing the mathematical model, enabling to predict the demand for labour force with not more than 2% mean absolute percentage error.

Выявлены тенденции влияния модернизации на величину потребности в рабочей силе, с учетом которых разработана математическая модель, позволяющая спрогнозировать потребность региона в рабочей силе со средним значением ошибки прогноза, не превышающим 2%.

With this definition of an error, two of the most popular methods for measuring accuracy are mean absolute error (mae) and mean absolute percentage error (mape).

mean absolute percentage of errors (MAPE),

Результатов: 111. Точных совпадений: 3. Затраченное время: 118 мс

Documents

Корпоративные решения

Спряжение

Синонимы

Корректор

Справка и о нас

Индекс слова: 1-300, 301-600, 601-900

Индекс выражения: 1-400, 401-800, 801-1200

Индекс фразы: 1-400, 401-800, 801-1200

From Wikipedia, the free encyclopedia

The mean absolute percentage error (MAPE), also known as mean absolute percentage deviation (MAPD), is a measure of prediction accuracy of a forecasting method in statistics. It usually expresses the accuracy as a ratio defined by the formula:

where At is the actual value and Ft is the forecast value. Their difference is divided by the actual value At. The absolute value of this ratio is summed for every forecasted point in time and divided by the number of fitted points n.

MAPE in regression problems[edit]

Mean absolute percentage error is commonly used as a loss function for regression problems and in model evaluation, because of its very intuitive interpretation in terms of relative error.

Definition[edit]

Consider a standard regression setting in which the data are fully described by a random pair

In the classical regression setting, the closeness of

where

In practice

In practice

From a practical point of view, the use of the MAPE as a quality function for regression model is equivalent to doing weighted mean absolute error (MAE) regression, also known as quantile regression. This property is trivial since

As a consequence, the use of the MAPE is very easy in practice, for example using existing libraries for quantile regression allowing weights.

Consistency[edit]

The use of the MAPE as a loss function for regression analysis is feasible both on a practical point of view and on a theoretical one, since the existence of an optimal model and the consistency of the empirical risk minimization can be proved.[1]

WMAPE[edit]

WMAPE (sometimes spelled wMAPE) stands for weighted mean absolute percentage error.[2] It is a measure used to evaluate the performance of regression or forecasting models. It is a variant of MAPE in which the mean absolute percent errors is treated as a weighted arithmetic mean. Most commonly the absolute percent errors are weighted by the actuals (e.g. in case of sales forecasting, errors are weighted by sales volume).[3]. Effectively, this overcomes the ‘infinite error’ issue.[4]

Its formula is:[4]

Where

However, this effectively simplifies to a much simpler formula:

Confusingly, sometimes when people refer to wMAPE they are talking about a different model in which the numerator and denominator of the wMAPE formula above are weighted again by another set of custom weights

Issues[edit]

Although the concept of MAPE sounds very simple and convincing, it has major drawbacks in practical application,[5] and there are many studies on shortcomings and misleading results from MAPE.[6][7]

To overcome these issues with MAPE, there are some other measures proposed in literature:

- Mean Absolute Scaled Error (MASE)

- Symmetric Mean Absolute Percentage Error (sMAPE)

- Mean Directional Accuracy (MDA)

- Mean Arctangent Absolute Percentage Error (MAAPE): MAAPE can be considered a slope as an angle, while MAPE is a slope as a ratio.[7]

See also[edit]

- Least absolute deviations

- Mean absolute error

- Mean percentage error

- Symmetric mean absolute percentage error

External links[edit]

- Mean Absolute Percentage Error for Regression Models

- Mean Absolute Percentage Error (MAPE)

- Errors on percentage errors — variants of MAPE

- Mean Arctangent Absolute Percentage Error (MAAPE)

References[edit]

- ^ a b de Myttenaere, B Golden, B Le Grand, F Rossi (2015). «Mean absolute percentage error for regression models», Neurocomputing 2016 arXiv:1605.02541

- ^ Forecast Accuracy: MAPE, WAPE, WMAPE https://www.baeldung.com/cs/mape-vs-wape-vs-wmape%7Ctitle=Understanding Forecast Accuracy: MAPE, WAPE, WMAPE. ;

- ^ Weighted Mean Absolute Percentage Error https://ibf.org/knowledge/glossary/weighted-mean-absolute-percentage-error-wmape-299%7Ctitle=WMAPE: Weighted Mean Absolute Percentage Error. ;

- ^ a b «Statistical Forecast Errors».

- ^ a b Tofallis (2015). «A Better Measure of Relative Prediction Accuracy for Model Selection and Model Estimation», Journal of the Operational Research Society, 66(8):1352-1362. archived preprint

- ^ Hyndman, Rob J., and Anne B. Koehler (2006). «Another look at measures of forecast accuracy.» International Journal of Forecasting, 22(4):679-688 doi:10.1016/j.ijforecast.2006.03.001.

- ^ a b Kim, Sungil and Heeyoung Kim (2016). «A new metric of absolute percentage error for intermittent demand forecasts.» International Journal of Forecasting, 32(3):669-679 doi:10.1016/j.ijforecast.2015.12.003.

- ^ Kim, Sungil; Kim, Heeyoung (1 July 2016). «A new metric of absolute percentage error for intermittent demand forecasts». International Journal of Forecasting. 32 (3): 669–679. doi:10.1016/j.ijforecast.2015.12.003.

- ^ Makridakis, Spyros (1993) «Accuracy measures: theoretical and practical concerns.» International Journal of Forecasting, 9(4):527-529 doi:10.1016/0169-2070(93)90079-3

From Wikipedia, the free encyclopedia

The mean absolute percentage error (MAPE), also known as mean absolute percentage deviation (MAPD), is a measure of prediction accuracy of a forecasting method in statistics. It usually expresses the accuracy as a ratio defined by the formula:

where At is the actual value and Ft is the forecast value. Their difference is divided by the actual value At. The absolute value of this ratio is summed for every forecasted point in time and divided by the number of fitted points n.

MAPE in regression problems[edit]

Mean absolute percentage error is commonly used as a loss function for regression problems and in model evaluation, because of its very intuitive interpretation in terms of relative error.

Definition[edit]

Consider a standard regression setting in which the data are fully described by a random pair

In the classical regression setting, the closeness of

where

In practice

In practice

From a practical point of view, the use of the MAPE as a quality function for regression model is equivalent to doing weighted mean absolute error (MAE) regression, also known as quantile regression. This property is trivial since

As a consequence, the use of the MAPE is very easy in practice, for example using existing libraries for quantile regression allowing weights.

Consistency[edit]

The use of the MAPE as a loss function for regression analysis is feasible both on a practical point of view and on a theoretical one, since the existence of an optimal model and the consistency of the empirical risk minimization can be proved.[1]

WMAPE[edit]

WMAPE (sometimes spelled wMAPE) stands for weighted mean absolute percentage error.[2] It is a measure used to evaluate the performance of regression or forecasting models. It is a variant of MAPE in which the mean absolute percent errors is treated as a weighted arithmetic mean. Most commonly the absolute percent errors are weighted by the actuals (e.g. in case of sales forecasting, errors are weighted by sales volume).[3]. Effectively, this overcomes the ‘infinite error’ issue.[4]

Its formula is:[4]

Where

However, this effectively simplifies to a much simpler formula:

Confusingly, sometimes when people refer to wMAPE they are talking about a different model in which the numerator and denominator of the wMAPE formula above are weighted again by another set of custom weights

Issues[edit]

Although the concept of MAPE sounds very simple and convincing, it has major drawbacks in practical application,[5] and there are many studies on shortcomings and misleading results from MAPE.[6][7]

To overcome these issues with MAPE, there are some other measures proposed in literature:

- Mean Absolute Scaled Error (MASE)

- Symmetric Mean Absolute Percentage Error (sMAPE)

- Mean Directional Accuracy (MDA)

- Mean Arctangent Absolute Percentage Error (MAAPE): MAAPE can be considered a slope as an angle, while MAPE is a slope as a ratio.[7]

See also[edit]

- Least absolute deviations

- Mean absolute error

- Mean percentage error

- Symmetric mean absolute percentage error

External links[edit]

- Mean Absolute Percentage Error for Regression Models

- Mean Absolute Percentage Error (MAPE)

- Errors on percentage errors — variants of MAPE

- Mean Arctangent Absolute Percentage Error (MAAPE)

References[edit]

- ^ a b de Myttenaere, B Golden, B Le Grand, F Rossi (2015). «Mean absolute percentage error for regression models», Neurocomputing 2016 arXiv:1605.02541

- ^ Forecast Accuracy: MAPE, WAPE, WMAPE https://www.baeldung.com/cs/mape-vs-wape-vs-wmape%7Ctitle=Understanding Forecast Accuracy: MAPE, WAPE, WMAPE. ;

- ^ Weighted Mean Absolute Percentage Error https://ibf.org/knowledge/glossary/weighted-mean-absolute-percentage-error-wmape-299%7Ctitle=WMAPE: Weighted Mean Absolute Percentage Error. ;

- ^ a b «Statistical Forecast Errors».

- ^ a b Tofallis (2015). «A Better Measure of Relative Prediction Accuracy for Model Selection and Model Estimation», Journal of the Operational Research Society, 66(8):1352-1362. archived preprint

- ^ Hyndman, Rob J., and Anne B. Koehler (2006). «Another look at measures of forecast accuracy.» International Journal of Forecasting, 22(4):679-688 doi:10.1016/j.ijforecast.2006.03.001.

- ^ a b Kim, Sungil and Heeyoung Kim (2016). «A new metric of absolute percentage error for intermittent demand forecasts.» International Journal of Forecasting, 32(3):669-679 doi:10.1016/j.ijforecast.2015.12.003.

- ^ Kim, Sungil; Kim, Heeyoung (1 July 2016). «A new metric of absolute percentage error for intermittent demand forecasts». International Journal of Forecasting. 32 (3): 669–679. doi:10.1016/j.ijforecast.2015.12.003.

- ^ Makridakis, Spyros (1993) «Accuracy measures: theoretical and practical concerns.» International Journal of Forecasting, 9(4):527-529 doi:10.1016/0169-2070(93)90079-3

-

1

mean absolute percentage error

Универсальный англо-русский словарь > mean absolute percentage error

-

2

mean absolute percentage error

English-Russian electronics dictionary > mean absolute percentage error

-

3

mean absolute percentage error

The New English-Russian Dictionary of Radio-electronics > mean absolute percentage error

-

4

error

English-Russian electronics dictionary > error

-

5

error

The New English-Russian Dictionary of Radio-electronics > error

-

6

error

[ˈerə]

absolute error абсолютная ошибка accidental error случайная ошибка accounting error ошибка бухгалтерского учета accuracy error постоянная ошибка addressing error вчт. ошибка адресации alignment error погрешность юстировки altering error нерегулярная ошибка analytic truncation error ошибка аналитического усечения average error средняя ошибка bad call format error вчт. ошибка из-за неправильного вызова bad command error вчт. ошибка из-за неправильной команды balancing error сбалансированная ошибка error ошибка, заблуждение; to make an error совершить ошибку, ошибиться; in error по ошибке, ошибочно; to be in error заблуждаться bias error постоянная ошибка biased error постоянная ошибка biased error систематическая ошибка burst error вчт. пакет ошибок calculating error погрешность расчета call error вчт. ошибка вызова chance error случайная ошибка checksum error вчт. ошибка в контрольной сумме code error вчт. ошибка в коде coincidence error вчт. ошибка совпадения common error вчт. обычная ошибка compensating error вчт. компенсирующая ошибка compensating error компенсирующая ошибка compile-time error вчт. ошибка при трансляции completeness error вчт. ошибка завершения configuration error вчт. ошибка компоновки configuration error вчт. ошибка конфигурации connection error вчт. ошибка монтажа consistency error вчт. ошибка из-за несовместимости constant error постоянная ошибка constant error систематическая ошибка constructional error вчт. ошибка монтажа contributory error вчт. внесенная ошибка control error вчт. ошибка регулирования critical error вчт. неустранимая ошибка crude error вчт. грубая ошибка cumulative error накопленная ошибка data error вчт. ошибка в данных data-bit error вчт. ошибка в битах данных deletion error вчт. ложное исключение design error ошибка проектирования detectable error вчт. обнаруживаемая ошибка detectable error вчт. обнаружимая ошибка difficult-to-locate error вчт. труднообнаружимая ошибка displacement error вчт. ошибка из-за смещения documentation error ошибка в документации double-bit error вчт. двухбитовая ошибка dropout error вчт. ошибка из-за выпадения error поэт. блуждание error грех error заблуждение error ложное представление error отклонение, уклонение, погрешность error отклонение от номинала error ошибка, заблуждение; to make an error совершить ошибку, ошибиться; in error по ошибке, ошибочно; to be in error заблуждаться error вчт. ошибка error ошибка error вчт. погрешность error погрешность error потеря точности error «приказ об ошибке» (т.е. о передаче материалов по делу в апелляционный суд для пересмотра вынесенного судебного решения на основании ошибки, допущенной при рассмотрении дела) error радио рассогласование error рассогласование error due to sampling вчт. ошибка выборки error frequency limit вчт. максимальная частота однобитовых ошибок error in addition мат. ошибка сложения error in standard deviation ошибка среднего квадратического отклонения error in subtraction мат. ошибка вычитания error of estimation ошибка оценивания error of judgment неверное суждение error of judgment ошибочная оценка error of posting ошибка бухгалтерской проводки error status flag вчт. флаг состояния ошибки estimated error оцениваемая ошибка estimation error ошибка оценивания estimation error ошибка оценки execution error вчт. ошибка выполнения experimental error погрешность эксперемента factual error фактическая ошибка fatal error вчт. неисправимая ошибка fatal hard error вчт. неисправимая аппаратная ошибка file error вчт. ошибка при работе с файлом fixed error постоянная ошибка fixed error систематическая ошибка following error ошибка слежения formal error формальная ошибка framing error ошибка кадровой синхронизации frequency error погрешность частоты general error вчт. ошибка общего характера gross error грубая ошибка hardware error вчт. аппаратная ошибка human error вчт. ошибка оператора error ошибка, заблуждение; to make an error совершить ошибку, ошибиться; in error по ошибке, ошибочно; to be in error заблуждаться in-process error ошибка изготовления inherent error вчт. унаследованная ошибка inherited error вчт. предвнесенная ошибка inherited error вчт. унаследованная ошибка initial error вчт. начальная ошибка input error вчт. ошибка на входе insertion error вчт. ошибка ложного восприятия instantaneous error вчт. текущее значение ошибки intentional error вчт. умышленная ошибка intermediate error вчт. нерегулярная ошибка intermittent error случайная ошибка interpolation error ошибка интерполяции intrinsic error вчт. исходная ошибка introduced error вчт. внесенная ошибка introduced error вчт. допущенная ошибка irrecoverable error непоправимая ошибка isolated error вчт. локализованная ошибка isolated error вчт. одиночная ошибка judicial error судебная ошибка limiting error предел точности literal error полигр. опечатка literal: error буквенный; literal error опечатка error ошибка, заблуждение; to make an error совершить ошибку, ошибиться; in error по ошибке, ошибочно; to be in error заблуждаться marginal error вчт. краевая ошибка matching error вчт. ошибка неточного согласования material error существенная ошибка maximum error максимальная ошибка maximum error предельная ошибка maximum permissible error максимальная допустимая ошибка mean error средняя ошибка mean probable error средняя вероятная ошибка metering error ошибка измерения missing error вчт. ошибка из-за отсутствия данных nautical error навигационная ошибка no-paper error вчт. ошибка из-за отсутствия бумаги nonsampling error постоянная ошибка nonsampling error систематическая ошибка observation error ошибка наблюдения observational error ошибка наблюдения offsetting error компенсирующая ошибка operating error ошибка в процессе работы operating error ошибка из-за нарушения правил эксплуатации operation error ошибка в работе operational error ошибка из-за нарушения правил эксплуатации operator error вчт. ошибка оператора output error вчт. ошибка выхода parity error ошибка, выявленная контролем по четности parity error вчт. ошибка четности pattern-sensitive error вчт. кодочувствительная ошибка percentage error ошибка в процентах permissible error допустимая ошибка posting error ошибка при переносе в бухгалтерскую книгу precautionary error подозреваемая ошибка predictable error предсказуемая ошибка probable error вероятная ошибка probable error стат. вероятная ошибка procedural error процедурная ошибка procedural error процеждурная ошибка professional error профессиональная ошибка program error вчт. ошибка в программе program error вчт. программная ошибка propagated error накапливаемая ошибка propagated error вчт. распространяющаяся ошибка propagation error вчт. накапливающаяся ошибка pure error вчт. истинная ошибка quantitative error количественная ошибка quantization error вчт. ошибка дискретизации quiet error вчт. исправимая ошибка quite error вчт. исправимая ошибка random error случайная ошибка random sampling error ошибка случайной выборки read fault error вчт. сбой при чтении reasonable error допустимая ошибка recoverable error вчт. исправимая ошибка recoverable error исправимая ошибка recurrent error вчт. повторяющаяся ошибка reduced error приведенная погрешность relative error относительная ошибка remediable error поправимая ошибка residual error остаточная ошибка responce error вчт. ошибка ответной реакции resultant error суммарная ошибка return an error code вчт. выдавать код ошибки root-mean-square error среднеквадратичная ошибка round error вчт. ошибка округления round-off error вчт. ошибка округления rounding error вчт. ошибка округления rounding error ошибка округления run-time error вчт. ошибка при выполнении runtime error вчт. ошибка при выполнении sample error вчт. ошибка выборки sampling error вчт. ошибка выборки sampling error stat. ошибка выборки sampling error stat. ошибка выборочного обследования sampling error вчт. ошибка квантования seek error вчт. ошибка при поиске дорожки select error вчт. ошибка выборки select error вчт. ошибка отсутствия связи semantic error вчт. семантическая ошибка sequence error вчт. неправильный порядок setup error вчт. ошибка настройки severe error серьезная ошибка size error вчт. переполнение размера сетки smoothing error ошибка сглаживания soft error нерегулярная ошибка soft error вчт. случайный сбой software error comp. ошибка в системе программного обеспечения software error вчт. программная ошибка solid burst error вчт. плотный пакет ошибок solid error вчт. постоянная ошибка spelling error орфографическая ошибка srecification error ошибка в описании standard error среднеквадратическая ошибка standard error (SE) stat. среднеквадратическая ошибка steady-state error статическая ошибка stored error вчт. накопленная ошибка substantial error существенная ошибка substitution error вчт. ошибка замещения subtle error неявная ошибка syntactical error синтаксическая ошибка syntax error вчт. синтаксическая ошибка system error вчт. ошибка системы systematic error stat. систематическая ошибка tabulation error вчт. неправильная классификация technical error формальная ошибка technical error формально-юридическая ошибка time-base error вчт. ошибка синхронизации timing error вчт. ошибка синхронизации total error накопленная ошибка total error общая ошибка transient error вчт. перемежающая ошибка translation error ошибка в переводе transmission error вчт. ошибка передачи true error вчт. истинная ошибка truncation error вчт. ошибка отбрасывания членов ряда truncation error вчт. ошибка усечения typing error опечатка unbiased error случайная ошибка uncompensated error нескомпенсированная ошибка underflow error вчт. ошибка обнаружения undetectable error вчт. необнаруживаемая ошибка undetectable error вчт. необнаружимая ошибка unexpected error occured вчт. произошла непредвиденная ошибка unrecoverable error вчт. неисправимая ошибка wiring error ошибка монтажа write fault error вчт. сбой при записи write protect error вчт. ошибка в связи с защитой от записи zero error сдвиг нуля

English-Russian short dictionary > error

-

7

error

1) ошибка, погрешность

2) промах; просчёт; недосмотр

5) отклонение; расхождение; рассогласование

•

error due to — ошибка, обусловленная ; ошибка, связанная с

English-Russian scientific dictionary > error

-

8

error

ˈerə сущ.

1) заблуждение, оплошность, ошибка( во взглядах, расчетах и т. д.) in error, by error, through error ≈ по ошибке, ошибочно through a clerical error ≈ из-за канцелярской ошибки to admit to (making) an error ≈ признать ошибку to commit an error, make an error ≈ совершить ошибку, ошибиться to correct an error, rectify an error ≈ устранять ошибку, исправлять ошибку to compound an error ≈ сглаживать ошибку cardinal error ≈ главная, кардинальная ошибка costly error ≈ дорого обошедшаяся ошибка egregious error, flagrant error, glaring error ≈ грубая, вопиющая ошибка grievous error ≈ прискорбная ошибка grammatical error ≈ грамматическая ошибка printer’s error, typographical error ≈ типографская ошибка procedural error ≈ процессуальная ошибка tactical error ≈ тактическая ошибка typing error ≈ опечатка through a typing error ≈ из-за ошибки машинистки, по вине машинистки to be in error ≈ заблуждаться Syn: mistake, fault

2) проступок, грех Syn: transgression, wrong-doing

3) поэт. блуждание

4) тех. изменение, ответвление, отклонение, погрешность, уклонение Syn: deviation, digression;

swerve

5) радио рассогласование

ошибка, заблуждение, ложное представление — human * ошибка, свойственная человеку — *s of taste плохой вкус в одежде — an * of judgement неверное суждение, ошибочный расчет, ошибочная оценка — in * ошибочно, по ошибке — to do smth. in * ошибиться, сделать что-либо по ошибке — to make an * сделать ошибку;

впасть в заблуждение — to be in * ошибаться, заблуждаться — to dispossess smb. of an * (книжное) выводить кого-либо из заблуждения — to lead smb. into * вводить кого-либо в заблуждение — to fall into a serious * впасть в серьезную ошибку — he has seen the * of his ways он понял, что поступал неправильно ошибка, погрешность — spelling * ошибка в правописании — printers’ * опечатка — noise * (специальное) искажение, вызванное шумами — permissible * (техническое) допуск — actual( специальное) истинная ошибка, истинная величина ошибки — appreciable * существенная ошибка — inappreciable * незначительная погрешность — * code (компьютерное) код ошибки — * log (компьютерное) файл регистрации ошибок — * of omission упущение, недосмотр — * in reading( специальное) ошибка отсчета — to eliminate the *s устранять ошибки проступок, грех — cardinal * смертный грех — *s of youth грехи молодости — to repent one’s *s покаяться в грехах (техническое) отклонение (от номинала) ;

потеря точности — station * уклонение отвеса (радиотехника) рассогласование (юридическое) фактическая или юридическая ошибка, допущенная судом в судебном процессе — * in fact фактическая ошибка — * in procedure процессуальная ошибка — writ of * ходатайство об отмене приговора суда вследствие допущенной им при рассмотрении дела ошибки;

аппеляционная жалоба

absolute ~ абсолютная ошибка

accidental ~ случайная ошибка

accounting ~ ошибка бухгалтерского учета

accuracy ~ постоянная ошибка

addressing ~ вчт. ошибка адресации

alignment ~ погрешность юстировки

altering ~ нерегулярная ошибка

analytic truncation ~ ошибка аналитического усечения

average ~ средняя ошибка

bad call format ~ вчт. ошибка из-за неправильного вызова

bad command ~ вчт. ошибка из-за неправильной команды

balancing ~ сбалансированная ошибка

~ ошибка, заблуждение;

to make an error совершить ошибку, ошибиться;

in error по ошибке, ошибочно;

to be in error заблуждаться

bias ~ постоянная ошибка

biased ~ постоянная ошибка biased ~ систематическая ошибка

burst ~ вчт. пакет ошибок

calculating ~ погрешность расчета

call ~ вчт. ошибка вызова

chance ~ случайная ошибка

checksum ~ вчт. ошибка в контрольной сумме

code ~ вчт. ошибка в коде

coincidence ~ вчт. ошибка совпадения

common ~ вчт. обычная ошибка

compensating ~ вчт. компенсирующая ошибка compensating ~ компенсирующая ошибка

compile-time ~ вчт. ошибка при трансляции

completeness ~ вчт. ошибка завершения

configuration ~ вчт. ошибка компоновки configuration ~ вчт. ошибка конфигурации

connection ~ вчт. ошибка монтажа

consistency ~ вчт. ошибка из-за несовместимости

constant ~ постоянная ошибка constant ~ систематическая ошибка

constructional ~ вчт. ошибка монтажа

contributory ~ вчт. внесенная ошибка

control ~ вчт. ошибка регулирования

critical ~ вчт. неустранимая ошибка

crude ~ вчт. грубая ошибка

cumulative ~ накопленная ошибка

data ~ вчт. ошибка в данных

data-bit ~ вчт. ошибка в битах данных

deletion ~ вчт. ложное исключение

design ~ ошибка проектирования

detectable ~ вчт. обнаруживаемая ошибка detectable ~ вчт. обнаружимая ошибка

difficult-to-locate ~ вчт. труднообнаружимая ошибка

displacement ~ вчт. ошибка из-за смещения

documentation ~ ошибка в документации

double-bit ~ вчт. двухбитовая ошибка

dropout ~ вчт. ошибка из-за выпадения

error поэт. блуждание ~ грех ~ заблуждение ~ ложное представление ~ отклонение, уклонение, погрешность ~ отклонение от номинала ~ ошибка, заблуждение;

to make an error совершить ошибку, ошибиться;

in error по ошибке, ошибочно;

to be in error заблуждаться ~ вчт. ошибка ~ ошибка ~ вчт. погрешность ~ погрешность ~ потеря точности ~ «приказ об ошибке» (т.е. о передаче материалов по делу в апелляционный суд для пересмотра вынесенного судебного решения на основании ошибки, допущенной при рассмотрении дела) ~ радио рассогласование ~ рассогласование

~ due to sampling вчт. ошибка выборки

~ frequency limit вчт. максимальная частота однобитовых ошибок

~ in addition мат. ошибка сложения

~ in standard deviation ошибка среднего квадратического отклонения

~ in subtraction мат. ошибка вычитания

~ of estimation ошибка оценивания

~ of judgment неверное суждение ~ of judgment ошибочная оценка

~ of posting ошибка бухгалтерской проводки

~ status flag вчт. флаг состояния ошибки

estimated ~ оцениваемая ошибка

estimation ~ ошибка оценивания estimation ~ ошибка оценки

execution ~ вчт. ошибка выполнения

experimental ~ погрешность эксперемента

factual ~ фактическая ошибка

fatal ~ вчт. неисправимая ошибка

fatal hard ~ вчт. неисправимая аппаратная ошибка

file ~ вчт. ошибка при работе с файлом

fixed ~ постоянная ошибка fixed ~ систематическая ошибка

following ~ ошибка слежения

formal ~ формальная ошибка

framing ~ ошибка кадровой синхронизации

frequency ~ погрешность частоты

general ~ вчт. ошибка общего характера

gross ~ грубая ошибка

hardware ~ вчт. аппаратная ошибка

human ~ вчт. ошибка оператора

~ ошибка, заблуждение;

to make an error совершить ошибку, ошибиться;

in error по ошибке, ошибочно;

to be in error заблуждаться

in-process ~ ошибка изготовления

inherent ~ вчт. унаследованная ошибка

inherited ~ вчт. предвнесенная ошибка inherited ~ вчт. унаследованная ошибка

initial ~ вчт. начальная ошибка

input ~ вчт. ошибка на входе

insertion ~ вчт. ошибка ложного восприятия

instantaneous ~ вчт. текущее значение ошибки

intentional ~ вчт. умышленная ошибка

intermediate ~ вчт. нерегулярная ошибка

intermittent ~ случайная ошибка

interpolation ~ ошибка интерполяции

intrinsic ~ вчт. исходная ошибка

introduced ~ вчт. внесенная ошибка introduced ~ вчт. допущенная ошибка

irrecoverable ~ непоправимая ошибка

isolated ~ вчт. локализованная ошибка isolated ~ вчт. одиночная ошибка

judicial ~ судебная ошибка

limiting ~ предел точности

literal ~ полигр. опечатка literal: ~ буквенный;

literal error опечатка

~ ошибка, заблуждение;

to make an error совершить ошибку, ошибиться;

in error по ошибке, ошибочно;

to be in error заблуждаться

marginal ~ вчт. краевая ошибка

matching ~ вчт. ошибка неточного согласования

material ~ существенная ошибка

maximum ~ максимальная ошибка maximum ~ предельная ошибка

maximum permissible ~ максимальная допустимая ошибка

mean ~ средняя ошибка

mean probable ~ средняя вероятная ошибка

metering ~ ошибка измерения

missing ~ вчт. ошибка из-за отсутствия данных

nautical ~ навигационная ошибка

no-paper ~ вчт. ошибка из-за отсутствия бумаги

nonsampling ~ постоянная ошибка nonsampling ~ систематическая ошибка

observation ~ ошибка наблюдения

observational ~ ошибка наблюдения

offsetting ~ компенсирующая ошибка

operating ~ ошибка в процессе работы operating ~ ошибка из-за нарушения правил эксплуатации

operation ~ ошибка в работе

operational ~ ошибка из-за нарушения правил эксплуатации

operator ~ вчт. ошибка оператора

output ~ вчт. ошибка выхода

parity ~ ошибка, выявленная контролем по четности parity ~ вчт. ошибка четности

pattern-sensitive ~ вчт. кодочувствительная ошибка

percentage ~ ошибка в процентах

permissible ~ допустимая ошибка

posting ~ ошибка при переносе в бухгалтерскую книгу

precautionary ~ подозреваемая ошибка

predictable ~ предсказуемая ошибка

probable ~ вероятная ошибка probable ~ стат. вероятная ошибка

procedural ~ процедурная ошибка procedural ~ процеждурная ошибка

professional ~ профессиональная ошибка

program ~ вчт. ошибка в программе program ~ вчт. программная ошибка

propagated ~ накапливаемая ошибка propagated ~ вчт. распространяющаяся ошибка

propagation ~ вчт. накапливающаяся ошибка

pure ~ вчт. истинная ошибка

quantitative ~ количественная ошибка

quantization ~ вчт. ошибка дискретизации

quiet ~ вчт. исправимая ошибка

quite ~ вчт. исправимая ошибка

random ~ случайная ошибка

random sampling ~ ошибка случайной выборки

read fault ~ вчт. сбой при чтении

reasonable ~ допустимая ошибка

recoverable ~ вчт. исправимая ошибка recoverable ~ исправимая ошибка

recurrent ~ вчт. повторяющаяся ошибка

reduced ~ приведенная погрешность

relative ~ относительная ошибка

remediable ~ поправимая ошибка

residual ~ остаточная ошибка

responce ~ вчт. ошибка ответной реакции

resultant ~ суммарная ошибка

return an ~ code вчт. выдавать код ошибки

root-mean-square ~ среднеквадратичная ошибка

round ~ вчт. ошибка округления

round-off ~ вчт. ошибка округления

rounding ~ вчт. ошибка округления rounding ~ ошибка округления

run-time ~ вчт. ошибка при выполнении

runtime ~ вчт. ошибка при выполнении

sample ~ вчт. ошибка выборки

sampling ~ вчт. ошибка выборки sampling ~ stat. ошибка выборки sampling ~ stat. ошибка выборочного обследования sampling ~ вчт. ошибка квантования

seek ~ вчт. ошибка при поиске дорожки

select ~ вчт. ошибка выборки select ~ вчт. ошибка отсутствия связи

semantic ~ вчт. семантическая ошибка

sequence ~ вчт. неправильный порядок

setup ~ вчт. ошибка настройки

severe ~ серьезная ошибка

size ~ вчт. переполнение размера сетки

smoothing ~ ошибка сглаживания

soft ~ нерегулярная ошибка soft ~ вчт. случайный сбой

software ~ comp. ошибка в системе программного обеспечения software ~ вчт. программная ошибка

solid burst ~ вчт. плотный пакет ошибок

solid ~ вчт. постоянная ошибка

spelling ~ орфографическая ошибка

srecification ~ ошибка в описании

standard ~ среднеквадратическая ошибка standard ~ (SE) stat. среднеквадратическая ошибка

steady-state ~ статическая ошибка

stored ~ вчт. накопленная ошибка

substantial ~ существенная ошибка

substitution ~ вчт. ошибка замещения

subtle ~ неявная ошибка

syntactical ~ синтаксическая ошибка

syntax ~ вчт. синтаксическая ошибка

system ~ вчт. ошибка системы

systematic ~ stat. систематическая ошибка

tabulation ~ вчт. неправильная классификация

technical ~ формальная ошибка technical ~ формально-юридическая ошибка

time-base ~ вчт. ошибка синхронизации

timing ~ вчт. ошибка синхронизации

total ~ накопленная ошибка total ~ общая ошибка

transient ~ вчт. перемежающая ошибка

translation ~ ошибка в переводе

transmission ~ вчт. ошибка передачи

true ~ вчт. истинная ошибка

truncation ~ вчт. ошибка отбрасывания членов ряда truncation ~ вчт. ошибка усечения

typing ~ опечатка

unbiased ~ случайная ошибка

uncompensated ~ нескомпенсированная ошибка

underflow ~ вчт. ошибка обнаружения

undetectable ~ вчт. необнаруживаемая ошибка undetectable ~ вчт. необнаружимая ошибка

unexpected ~ occured вчт. произошла непредвиденная ошибка

unrecoverable ~ вчт. неисправимая ошибка

wiring ~ ошибка монтажа

write fault ~ вчт. сбой при записи

write protect ~ вчт. ошибка в связи с защитой от записи

zero ~ сдвиг нуляБольшой англо-русский и русско-английский словарь > error

-

9

variation of the mean error

- дополнительная погрешность электрического реле

Англо-русский словарь нормативно-технической терминологии > variation of the mean error

-

10

MAPE

English-Russian electronics dictionary > MAPE

-

11

MAPE

Универсальный англо-русский словарь > MAPE

-

12

MAPE

mean absolute percentage error

The New English-Russian Dictionary of Radio-electronics > MAPE

См. также в других словарях:

-

Mean absolute percentage error — (MAPE) is measure of accuracy in a fitted time series value in statistics, specifically trending. It usually expresses accuracy as a percentage, and is defined by the formula: where At is the actual value and Ft is the forecast value. The… … Wikipedia

-

Mean absolute scaled error — In statistics, the mean absolute scaled error (MASE) is a measure of the accuracy of forecasts . It was proposed in 2006 by Australian statistician Rob Hyndman, who described it as a generally applicable measurement of forecast accuracy without… … Wikipedia

-

Mean squared error — In statistics, the mean squared error (MSE) of an estimator is one of many ways to quantify the difference between values implied by a kernel density estimator and the true values of the quantity being estimated. MSE is a risk function,… … Wikipedia

-

Mean — This article is about the statistical concept. For other uses, see Mean (disambiguation). In statistics, mean has two related meanings: the arithmetic mean (and is distinguished from the geometric mean or harmonic mean). the expected value of a… … Wikipedia

-

MAPE — mean absolute percentage error … Medical dictionary

-

MAPE — • mean absolute percentage error … Dictionary of medical acronyms & abbreviations

-

Margin of error — This article is about the statistical precision of estimates from sample surveys. For safety margins in engineering, see Factor of safety. For tolerance in engineering, see Tolerance (engineering). Not to be confused with Margin for Error. The… … Wikipedia

-

List of statistics topics — Please add any Wikipedia articles related to statistics that are not already on this list.The Related changes link in the margin of this page (below search) leads to a list of the most recent changes to the articles listed below. To see the most… … Wikipedia

-

List of mathematics articles (M) — NOTOC M M estimator M group M matrix M separation M set M. C. Escher s legacy M. Riesz extension theorem M/M/1 model Maass wave form Mac Lane s planarity criterion Macaulay brackets Macbeath surface MacCormack method Macdonald polynomial Machin… … Wikipedia

-

Forecasting — is the process of estimation in unknown situations. Prediction is a similar, but more general term. Both can refer to estimation of time series, cross sectional or longitudinal data. Usage can differ between areas of application: for example in… … Wikipedia

-

Forecast — Die Prognose (griechisch, πρóγνωσις – wörtlich „das Vorwissen“, die „Voraus Kenntnis“), deutsch Vorhersage oder Voraussage, selten auch: Prädiktion (lat. praedicare „ im Voraus“ und „sagen“) bezeichnet die Aussagen über Ereignisse, Zustände oder… … Deutsch Wikipedia

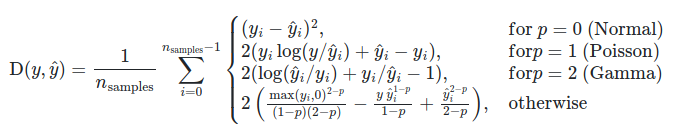

Для того чтобы модель линейной регрессии можно было применять на практике необходимо сначала оценить её качество. Для этих целей предложен ряд показателей, каждый из которых предназначен для использования в различных ситуациях и имеет свои особенности применения (линейные и нелинейные, устойчивые к аномалиям, абсолютные и относительные, и т.д.). Корректный выбор меры для оценки качества модели является одним из важных факторов успеха в решении задач анализа данных.

- Среднеквадратичная ошибка (Mean Squared Error)

- Корень из среднеквадратичной ошибки (Root Mean Squared Error)

- Среднеквадратичная ошибка в процентах (Mean Squared Percentage Error)

- Cредняя абсолютная ошибка (Mean Absolute Error)

- Средняя абсолютная процентная ошибка (Mean Absolute Percentage Error)

- Cимметричная средняя абсолютная процентная ошибка (Symmetric Mean Absolute Percentage Error)

- Средняя абсолютная масштабированная ошибка (Mean absolute scaled error)

- Средняя относительная ошибка (Mean Relative Error)

- Среднеквадратичная логарифмическая ошибка (Root Mean Squared Logarithmic Error

- R-квадрат

- Скорректированный R-квадрат

- Сравнение метрик

«Хорошая» аналитическая модель должна удовлетворять двум, зачастую противоречивым, требованиям — как можно лучше соответствовать данным и при этом быть удобной для интерпретации пользователем. Действительно, повышение соответствия модели данным как правило связано с её усложнением (в случае регрессии — увеличением числа входных переменных модели). А чем сложнее модель, тем ниже её интерпретируемость.

Поэтому при выборе между простой и сложной моделью последняя должна значимо увеличивать соответствие модели данным чтобы оправдать рост сложности и соответствующее снижение интерпретируемости. Если это условие не выполняется, то следует выбрать более простую модель.

Таким образом, чтобы оценить, насколько повышение сложности модели значимо увеличивает её точность, необходимо использовать аппарат оценки качества регрессионных моделей. Он включает в себя следующие меры:

- Среднеквадратичная ошибка (MSE).

- Корень из среднеквадратичной ошибки (RMSE).

- Среднеквадратичная ошибка в процентах (MSPE).

- Средняя абсолютная ошибка (MAE).

- Средняя абсолютная ошибка в процентах (MAPE).

- Cимметричная средняя абсолютная процентная ошибка (SMAPE).

- Средняя абсолютная масштабированная ошибка (MASE)

- Средняя относительная ошибка (MRE).

- Среднеквадратичная логарифмическая ошибка (RMSLE).

- Коэффициент детерминации R-квадрат.

- Скорректированный коэффициент детеминации.

Прежде чем перейти к изучению метрик качества, введём некоторые базовые понятия, которые нам в этом помогут. Для этого рассмотрим рисунок.

Рисунок 1. Линейная регрессия

Наклонная прямая представляет собой линию регрессии с переменной, на которой расположены точки, соответствующие предсказанным значениям выходной переменной widehat{y} (кружки синего цвета). Оранжевые кружки представляют фактические (наблюдаемые) значения y . Расстояния между ними и линией регрессии — это ошибка предсказания модели y-widehat{y} (невязка, остатки). Именно с её использованием вычисляются все приведённые в статье меры качества.

Горизонтальная линия представляет собой модель простого среднего, где коэффициент при независимой переменной x равен нулю, и остаётся только свободный член b, который становится равным среднему арифметическому фактических значений выходной переменной, т.е. b=overline{y}. Очевидно, что такая модель для любого значения входной переменной будет выдавать одно и то же значение выходной — overline{y}.

В линейной регрессии такая модель рассматривается как «бесполезная», хуже которой работает только «случайный угадыватель». Однако, она используется для оценки, насколько дисперсия фактических значений y относительно линии среднего, больше, чем относительно линии регрессии с переменной, т.е. насколько модель с переменной лучше «бесполезной».

MSE

Среднеквадратичная ошибка (Mean Squared Error) применяется в случаях, когда требуется подчеркнуть большие ошибки и выбрать модель, которая дает меньше именно больших ошибок. Большие значения ошибок становятся заметнее за счет квадратичной зависимости.

Действительно, допустим модель допустила на двух примерах ошибки 5 и 10. В абсолютном выражении они отличаются в два раза, но если их возвести в квадрат, получив 25 и 100 соответственно, то отличие будет уже в четыре раза. Таким образом модель, которая обеспечивает меньшее значение MSE допускает меньше именно больших ошибок.

MSE рассчитывается по формуле:

MSE=frac{1}{n}sumlimits_{i=1}^{n}(y_{i}-widehat{y}_{i})^{2},

где n — количество наблюдений по которым строится модель и количество прогнозов, y_{i} — фактические значение зависимой переменной для i-го наблюдения, widehat{y}_{i} — значение зависимой переменной, предсказанное моделью.

Таким образом, можно сделать вывод, что MSE настроена на отражение влияния именно больших ошибок на качество модели.

Недостатком использования MSE является то, что если на одном или нескольких неудачных примерах, возможно, содержащих аномальные значения будет допущена значительная ошибка, то возведение в квадрат приведёт к ложному выводу, что вся модель работает плохо. С другой стороны, если модель даст небольшие ошибки на большом числе примеров, то может возникнуть обратный эффект — недооценка слабости модели.

RMSE

Корень из среднеквадратичной ошибки (Root Mean Squared Error) вычисляется просто как квадратный корень из MSE:

RMSE=sqrt{frac{1}{n}sumlimits_{i=1}^{n}(y_{i}-widehat{y_{i}})^{2}}

MSE и RMSE могут минимизироваться с помощью одного и того же функционала, поскольку квадратный корень является неубывающей функцией. Например, если у нас есть два набора результатов работы модели, A и B, и MSE для A больше, чем MSE для B, то мы можем быть уверены, что RMSE для A больше RMSE для B. Справедливо и обратное: если MSE(A)<MSE(B), то и RMSE(A)<RMSE(B).

Следовательно, сравнение моделей с помощью RMSE даст такой же результат, что и для MSE. Однако с MSE работать несколько проще, поэтому она более популярна у аналитиков. Кроме этого, имеется небольшая разница между этими двумя ошибками при оптимизации с использованием градиента:

frac{partial RMSE}{partial widehat{y}_{i}}=frac{1}{2sqrt{MSE}}frac{partial MSE}{partial widehat{y}_{i}}

Это означает, что перемещение по градиенту MSE эквивалентно перемещению по градиенту RMSE, но с другой скоростью, и скорость зависит от самой оценки MSE. Таким образом, хотя RMSE и MSE близки с точки зрения оценки моделей, они не являются взаимозаменяемыми при использовании градиента для оптимизации.

Влияние каждой ошибки на RMSE пропорционально величине квадрата ошибки. Поэтому большие ошибки оказывают непропорционально большое влияние на RMSE. Следовательно, RMSE можно считать чувствительной к аномальным значениям.

MSPE

Среднеквадратичная ошибка в процентах (Mean Squared Percentage Error) представляет собой относительную ошибку, где разность между наблюдаемым и фактическим значениями делится на наблюдаемое значение и выражается в процентах:

MSPE=frac{100}{n}sumlimits_{i=1}^{n}left ( frac{y_{i}-widehat{y}_{i}}{y_{i}} right )^{2}

Проблемой при использовании MSPE является то, что, если наблюдаемое значение выходной переменной равно 0, значение ошибки становится неопределённым.

MSPE можно рассматривать как взвешенную версию MSE, где вес обратно пропорционален квадрату наблюдаемого значения. Таким образом, при возрастании наблюдаемых значений ошибка имеет тенденцию уменьшаться.

MAE

Cредняя абсолютная ошибка (Mean Absolute Error) вычисляется следующим образом:

MAE=frac{1}{n}sumlimits_{i=1}^{n}left | y_{i}-widehat{y}_{i} right |

Т.е. MAE рассчитывается как среднее абсолютных разностей между наблюдаемым и предсказанным значениями. В отличие от MSE и RMSE она является линейной оценкой, а это значит, что все ошибки в среднем взвешены одинаково. Например, разница между 0 и 10 будет вдвое больше разницы между 0 и 5. Для MSE и RMSE, как отмечено выше, это не так.

Поэтому MAE широко используется, например, в финансовой сфере, где ошибка в 10 долларов должна интерпретироваться как в два раза худшая, чем ошибка в 5 долларов.

MAPE

Средняя абсолютная процентная ошибка (Mean Absolute Percentage Error) вычисляется следующим образом:

MAPE=frac{100}{n}sumlimits_{i=1}^{n}frac{left | y_{i}-widehat{y_{i}} right |}{left | y_{i} right |}

Эта ошибка не имеет размерности и очень проста в интерпретации. Её можно выражать как в долях, так и в процентах. Если получилось, например, что MAPE=11.4, то это говорит о том, что ошибка составила 11.4% от фактического значения.

SMAPE

Cимметричная средняя абсолютная процентная ошибка (Symmetric Mean Absolute Percentage Error) — это мера точности, основанная на процентных (или относительных) ошибках. Обычно определяется следующим образом:

SMAPE=frac{100}{n}sumlimits_{i=1}^{n}frac{left | y_{i}-widehat{y_{i}} right |}{(left | y_{i} right |+left | widehat{y}_{i} right |)/2}

Т.е. абсолютная разность между наблюдаемым и предсказанным значениями делится на полусумму их модулей. В отличие от обычной MAPE, симметричная имеет ограничение на диапазон значений. В приведённой формуле он составляет от 0 до 200%. Однако, поскольку диапазон от 0 до 100% гораздо удобнее интерпретировать, часто используют формулу, где отсутствует деление знаменателя на 2.

Одной из возможных проблем SMAPE является неполная симметрия, поскольку в разных диапазонах ошибка вычисляется неодинаково. Это иллюстрируется следующим примером: если y_{i}=100 и widehat{y}_{i}=110, то SMAPE=4.76, а если y_{i}=100 и widehat{y}_{i}=90, то SMAPE=5.26.

Ограничение SMAPE заключается в том, что, если наблюдаемое или предсказанное значение равно 0, ошибка резко возрастет до верхнего предела (200% или 100%).

MASE

Средняя абсолютная масштабированная ошибка (Mean absolute scaled error) — это показатель, который позволяет сравнивать две модели. Если поместить MAE для новой модели в числитель, а MAE для исходной модели в знаменатель, то полученное отношение и будет равно MASE. Если значение MASE меньше 1, то новая модель работает лучше, если MASE равно 1, то модели работают одинаково, а если значение MASE больше 1, то исходная модель работает лучше, чем новая модель. Формула для расчета MASE имеет вид:

MASE=frac{MAE_{i}}{MAE_{j}}

MASE симметрична и устойчива к выбросам.

MRE

Средняя относительная ошибка (Mean Relative Error) вычисляется по формуле:

MRE=frac{1}{n}sumlimits_{i=1}^{n}frac{left | y_{i}-widehat{y}_{i}right |}{left | y_{i} right |}

Несложно увидеть, что данная мера показывает величину абсолютной ошибки относительно фактического значения выходной переменной (поэтому иногда эту ошибку называют также средней относительной абсолютной ошибкой, MRAE). Действительно, если значение абсолютной ошибки, скажем, равно 10, то сложно сказать много это или мало. Например, относительно значения выходной переменной, равного 20, это составляет 50%, что достаточно много. Однако относительно значения выходной переменной, равного 100, это будет уже 10%, что является вполне нормальным результатом.

Очевидно, что при вычислении MRE нельзя применять наблюдения, в которых y_{i}=0.

Таким образом, MRE позволяет более адекватно оценить величину ошибки, чем абсолютные ошибки. Кроме этого она является безразмерной величиной, что упрощает интерпретацию.

RMSLE

Среднеквадратичная логарифмическая ошибка (Root Mean Squared Logarithmic Error) представляет собой RMSE, вычисленную в логарифмическом масштабе:

RMSLE=sqrt{frac{1}{n}sumlimits_{i=1}^{n}(log(widehat{y}_{i}+1)-log{(y_{i}+1}))^{2}}

Константы, равные 1, добавляемые в скобках, необходимы чтобы не допустить обращения в 0 выражения под логарифмом, поскольку логарифм нуля не существует.

Известно, что логарифмирование приводит к сжатию исходного диапазона изменения значений переменной. Поэтому применение RMSLE целесообразно, если предсказанное и фактическое значения выходной переменной различаются на порядок и больше.

R-квадрат

Перечисленные выше ошибки не так просто интерпретировать. Действительно, просто зная значение средней абсолютной ошибки, скажем, равное 10, мы сразу не можем сказать хорошая это ошибка или плохая, и что нужно сделать чтобы улучшить модель.

В этой связи представляет интерес использование для оценки качества регрессионной модели не значения ошибок, а величину показывающую, насколько данная модель работает лучше, чем модель, в которой присутствует только константа, а входные переменные отсутствуют или коэффициенты регрессии при них равны нулю.

Именно такой мерой и является коэффициент детерминации (Coefficient of determination), который показывает долю дисперсии зависимой переменной, объяснённой с помощью регрессионной модели. Наиболее общей формулой для вычисления коэффициента детерминации является следующая:

R^{2}=1-frac{sumlimits_{i=1}^{n}(widehat{y}_{i}-y_{i})^{2}}{sumlimits_{i=1}^{n}({overline{y}}_{i}-y_{i})^{2}}

Практически, в числителе данного выражения стоит среднеквадратическая ошибка оцениваемой модели, а в знаменателе — модели, в которой присутствует только константа.

Главным преимуществом коэффициента детерминации перед мерами, основанными на ошибках, является его инвариантность к масштабу данных. Кроме того, он всегда изменяется в диапазоне от −∞ до 1. При этом значения близкие к 1 указывают на высокую степень соответствия модели данным. Очевидно, что это имеет место, когда отношение в формуле стремится к 0, т.е. ошибка модели с переменными намного меньше ошибки модели с константой. R^{2}=0 показывает, что между независимой и зависимой переменными модели имеет место функциональная зависимость.

Когда значение коэффициента близко к 0 (т.е. ошибка модели с переменными примерно равна ошибке модели только с константой), это указывает на низкое соответствие модели данным, когда модель с переменными работает не лучше модели с константой.

Кроме этого, бывают ситуации, когда коэффициент R^{2} принимает отрицательные значения (обычно небольшие). Это произойдёт, если ошибка модели среднего становится меньше ошибки модели с переменной. В этом случае оказывается, что добавление в модель с константой некоторой переменной только ухудшает её (т.е. регрессионная модель с переменной работает хуже, чем предсказание с помощью простой средней).

На практике используют следующую шкалу оценок. Модель, для которой R^{2}>0.5, является удовлетворительной. Если R^{2}>0.8, то модель рассматривается как очень хорошая. Значения, меньшие 0.5 говорят о том, что модель плохая.

Скорректированный R-квадрат

Основной проблемой при использовании коэффициента детерминации является то, что он увеличивается (или, по крайней мере, не уменьшается) при добавлении в модель новых переменных, даже если эти переменные никак не связаны с зависимой переменной.

В связи с этим возникают две проблемы. Первая заключается в том, что не все переменные, добавляемые в модель, могут значимо увеличивать её точность, но при этом всегда увеличивают её сложность. Вторая проблема — с помощью коэффициента детерминации нельзя сравнивать модели с разным числом переменных. Чтобы преодолеть эти проблемы используют альтернативные показатели, одним из которых является скорректированный коэффициент детерминации (Adjasted coefficient of determinftion).

Скорректированный коэффициент детерминации даёт возможность сравнивать модели с разным числом переменных так, чтобы их число не влияло на статистику R^{2}, и накладывает штраф за дополнительно включённые в модель переменные. Вычисляется по формуле:

R_{adj}^{2}=1-frac{sumlimits_{i=1}^{n}(widehat{y}_{i}-y_{i})^{2}/(n-k)}{sumlimits_{i=1}^{n}({overline{y}}_{i}-y_{i})^{2}/(n-1)}

где n — число наблюдений, на основе которых строится модель, k — количество переменных в модели.

Скорректированный коэффициент детерминации всегда меньше единицы, но теоретически может принимать значения и меньше нуля только при очень малом значении обычного коэффициента детерминации и большом количестве переменных модели.

Сравнение метрик

Резюмируем преимущества и недостатки каждой приведённой метрики в следующей таблице:

| Мера | Сильные стороны | Слабые стороны |

|---|---|---|

| MSE | Позволяет подчеркнуть большие отклонения, простота вычисления. | Имеет тенденцию занижать качество модели, чувствительна к выбросам. Сложность интерпретации из-за квадратичной зависимости. |

| RMSE | Простота интерпретации, поскольку измеряется в тех же единицах, что и целевая переменная. | Имеет тенденцию занижать качество модели, чувствительна к выбросам. |

| MSPE | Нечувствительна к выбросам. Хорошо интерпретируема, поскольку имеет линейный характер. | Поскольку вклад всех ошибок отдельных наблюдений взвешивается одинаково, не позволяет подчёркивать большие и малые ошибки. |

| MAPE | Является безразмерной величиной, поэтому её интерпретация не зависит от предметной области. | Нельзя использовать для наблюдений, в которых значения выходной переменной равны нулю. |

| SMAPE | Позволяет корректно работать с предсказанными значениями независимо от того больше они фактического, или меньше. | Приближение к нулю фактического или предсказанного значения приводит к резкому росту ошибки, поскольку в знаменателе присутствует как фактическое, так и предсказанное значения. |

| MASE | Не зависит от масштаба данных, является симметричной: положительные и отрицательные отклонения от фактического значения учитываются одинаково. Устойчива к выбросам. Позволяет сравнивать модели. | Сложность интерпретации. |

| MRE | Позволяет оценить величину ошибки относительно значения целевой переменной. | Неприменима для наблюдений с нулевым значением выходной переменной. |

| RMSLE | Логарифмирование позволяет сделать величину ошибки более устойчивой, когда разность между фактическим и предсказанным значениями различается на порядок и выше | Может быть затруднена интерпретация из-за нелинейности. |

| R-квадрат | Универсальность, простота интерпретации. | Возрастает даже при включении в модель бесполезных переменных. Плохо работает когда входные переменные зависимы. |

| R-квадрат скорр. | Корректно отражает вклад каждой переменной в модель. | Плохо работает, когда входные переменные зависимы. |

В данной статье рассмотрены наиболее популярные меры качества регрессионных моделей, которые часто используются в различных аналитических приложениях. Эти меры имеют свои особенности применения, знание которых позволит обоснованно выбирать и корректно применять их на практике.

Однако в литературе можно встретить и другие меры качества моделей регрессии, которые предлагаются различными авторами для решения конкретных задач анализа данных.

Другие материалы по теме:

Отбор переменных в моделях линейной регрессии

Репрезентативность выборочных данных

Логистическая регрессия и ROC-анализ — математический аппарат

Гораздо легче что-то измерить, чем понять, что именно вы измеряете

Джон Уильям Салливан

Задачи машинного обучения с учителем как правило состоят в восстановлении зависимости между парами (признаковое описание, целевая переменная) по данным, доступным нам для анализа. Алгоритмы машинного обучения (learning algorithm), со многими из которых вы уже успели познакомиться, позволяют построить модель, аппроксимирующую эту зависимость. Но как понять, насколько качественной получилась аппроксимация?

Почти наверняка наша модель будет ошибаться на некоторых объектах: будь она даже идеальной, шум или выбросы в тестовых данных всё испортят. При этом разные модели будут ошибаться на разных объектах и в разной степени. Задача специалиста по машинному обучению – подобрать подходящий критерий, который позволит сравнивать различные модели.

Перед чтением этой главы мы хотели бы ещё раз напомнить, что качество модели нельзя оценивать на обучающей выборке. Как минимум, это стоит делать на отложенной (тестовой) выборке, но, если вам это позволяют время и вычислительные ресурсы, стоит прибегнуть и к более надёжным способам проверки – например, кросс-валидации (о ней вы узнаете в отдельной главе).

Выбор метрик в реальных задачах

Возможно, вы уже участвовали в соревнованиях по анализу данных. На таких соревнованиях метрику (критерий качества модели) организатор выбирает за вас, и она, как правило, довольно понятным образом связана с результатами предсказаний. Но на практике всё бывает намного сложнее.

Например, мы хотим:

- решить, сколько коробок с бананами нужно завтра привезти в конкретный магазин, чтобы минимизировать количество товара, который не будет выкуплен и минимизировать ситуацию, когда покупатель к концу дня не находит желаемый продукт на полке;

- увеличить счастье пользователя от работы с нашим сервисом, чтобы он стал лояльным и обеспечивал тем самым стабильный прогнозируемый доход;

- решить, нужно ли направить человека на дополнительное обследование.

В каждом конкретном случае может возникать целая иерархия метрик. Представим, например, что речь идёт о стриминговом музыкальном сервисе, пользователей которого мы решили порадовать сгенерированными самодельной нейросетью треками – не защищёнными авторским правом, а потому совершенно бесплатными. Иерархия метрик могла бы иметь такой вид:

- Самый верхний уровень: будущий доход сервиса – невозможно измерить в моменте, сложным образом зависит от совокупности всех наших усилий;

- Медианная длина сессии, возможно, служащая оценкой радости пользователей, которая, как мы надеемся, повлияет на их желание продолжать платить за подписку – её нам придётся измерять в продакшене, ведь нас интересует реакция настоящих пользователей на новшество;

- Доля удовлетворённых качеством сгенерированной музыки асессоров, на которых мы потестируем её до того, как выставить на суд пользователей;

- Функция потерь, на которую мы будем обучать генеративную сеть.

На этом примере мы можем заметить сразу несколько общих закономерностей. Во-первых, метрики бывают offline и online (оффлайновыми и онлайновыми). Online метрики вычисляются по данным, собираемым с работающей системы (например, медианная длина сессии). Offline метрики могут быть измерены до введения модели в эксплуатацию, например, по историческим данным или с привлечением специальных людей, асессоров. Последнее часто применяется, когда метрикой является реакция живого человека: скажем, так поступают поисковые компании, которые предлагают людям оценить качество ранжирования экспериментальной системы еще до того, как рядовые пользователи увидят эти результаты в обычном порядке. На самом же нижнем этаже иерархии лежат оптимизируемые в ходе обучения функции потерь.

В данном разделе нас будут интересовать offline метрики, которые могут быть измерены без привлечения людей.

Функция потерь $neq$ метрика качества

Как мы узнали ранее, методы обучения реализуют разные подходы к обучению:

- обучение на основе прироста информации (как в деревьях решений)

- обучение на основе сходства (как в методах ближайших соседей)

- обучение на основе вероятностной модели данных (например, максимизацией правдоподобия)

- обучение на основе ошибок (минимизация эмпирического риска)

И в рамках обучения на основе минимизации ошибок мы уже отвечали на вопрос: как можно штрафовать модель за предсказание на обучающем объекте.

Во время сведения задачи о построении решающего правила к задаче численной оптимизации, мы вводили понятие функции потерь и, обычно, объявляли целевой функцией сумму потерь от предсказаний на всех объектах обучающей выборке.

Важно понимать разницу между функцией потерь и метрикой качества. Её можно сформулировать следующим образом:

-

Функция потерь возникает в тот момент, когда мы сводим задачу построения модели к задаче оптимизации. Обычно требуется, чтобы она обладала хорошими свойствами (например, дифференцируемостью).

-

Метрика – внешний, объективный критерий качества, обычно зависящий не от параметров модели, а только от предсказанных меток.

В некоторых случаях метрика может совпадать с функцией потерь. Например, в задаче регрессии MSE играет роль как функции потерь, так и метрики. Но, скажем, в задаче бинарной классификации они почти всегда различаются: в качестве функции потерь может выступать кросс-энтропия, а в качестве метрики – число верно угаданных меток (accuracy). Отметим, что в последнем примере у них различные аргументы: на вход кросс-энтропии нужно подавать логиты, а на вход accuracy – предсказанные метки (то есть по сути argmax логитов).

Бинарная классификация: метки классов

Перейдём к обзору метрик и начнём с самой простой разновидности классификации – бинарной, а затем постепенно будем наращивать сложность.

Напомним постановку задачи бинарной классификации: нам нужно по обучающей выборке ${(x_i, y_i)}_{i=1}^N$, где $y_iin{0, 1}$ построить модель, которая по объекту $x$ предсказывает метку класса $f(x)in{0, 1}$.

Первым критерием качества, который приходит в голову, является accuracy – доля объектов, для которых мы правильно предсказали класс:

$$ color{#348FEA}{text{Accuracy}(y, y^{pred}) = frac{1}{N} sum_{i=1}^N mathbb{I}[y_i = f(x_i)]} $$

Или же сопряженная ей метрика – доля ошибочных классификаций (error rate):

$$text{Error rate} = 1 — text{Accuracy}$$

Познакомившись чуть внимательнее с этой метрикой, можно заметить, что у неё есть несколько недостатков:

- она не учитывает дисбаланс классов. Например, в задаче диагностики редких заболеваний классификатор, предсказывающий всем пациентам отсутствие болезни будет иметь достаточно высокую accuracy просто потому, что больных людей в выборке намного меньше;

- она также не учитывает цену ошибки на объектах разных классов. Для примера снова можно привести задачу медицинской диагностики: если ошибочный положительный диагноз для здорового больного обернётся лишь ещё одним обследованием, то ошибочно отрицательный вердикт может повлечь роковые последствия.

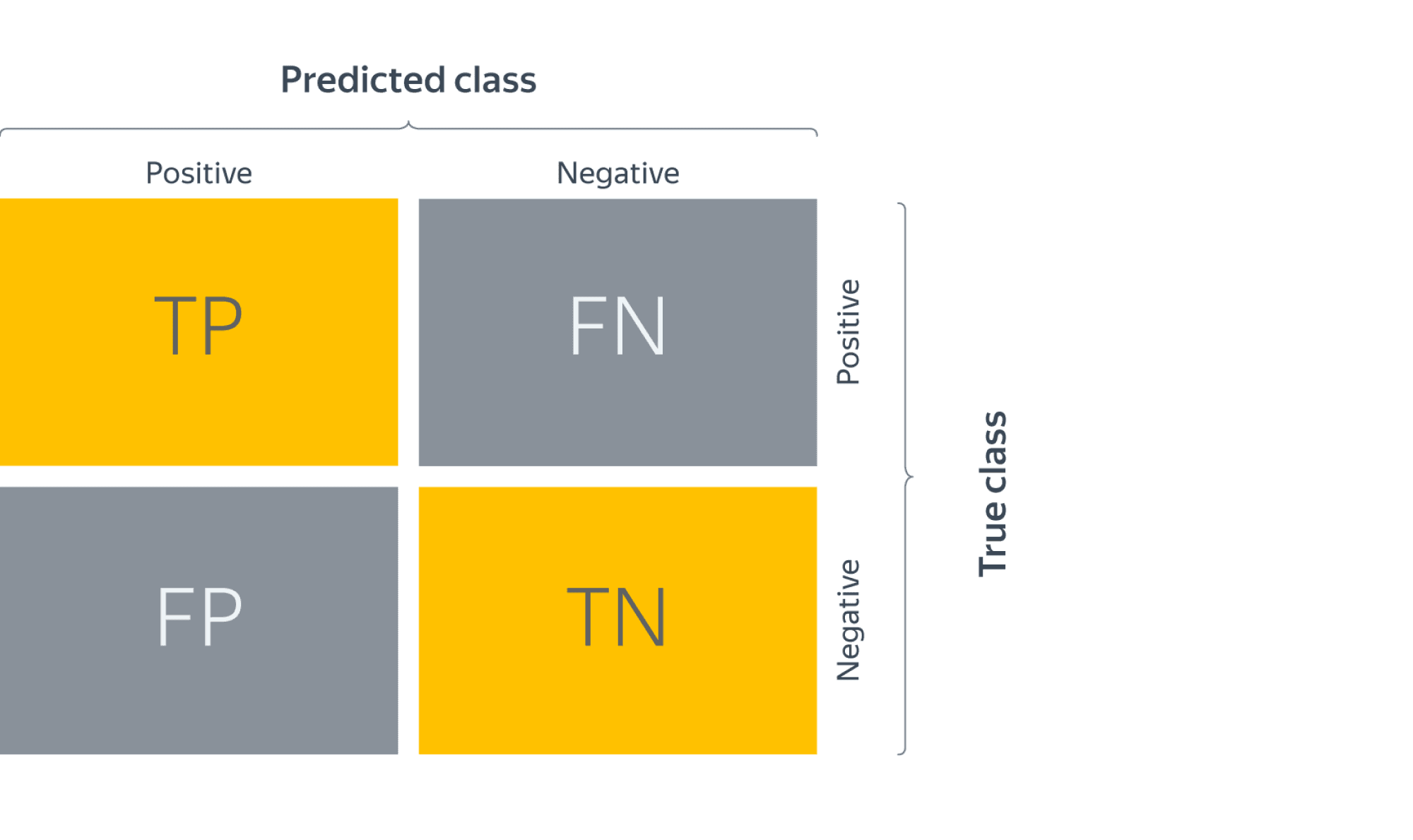

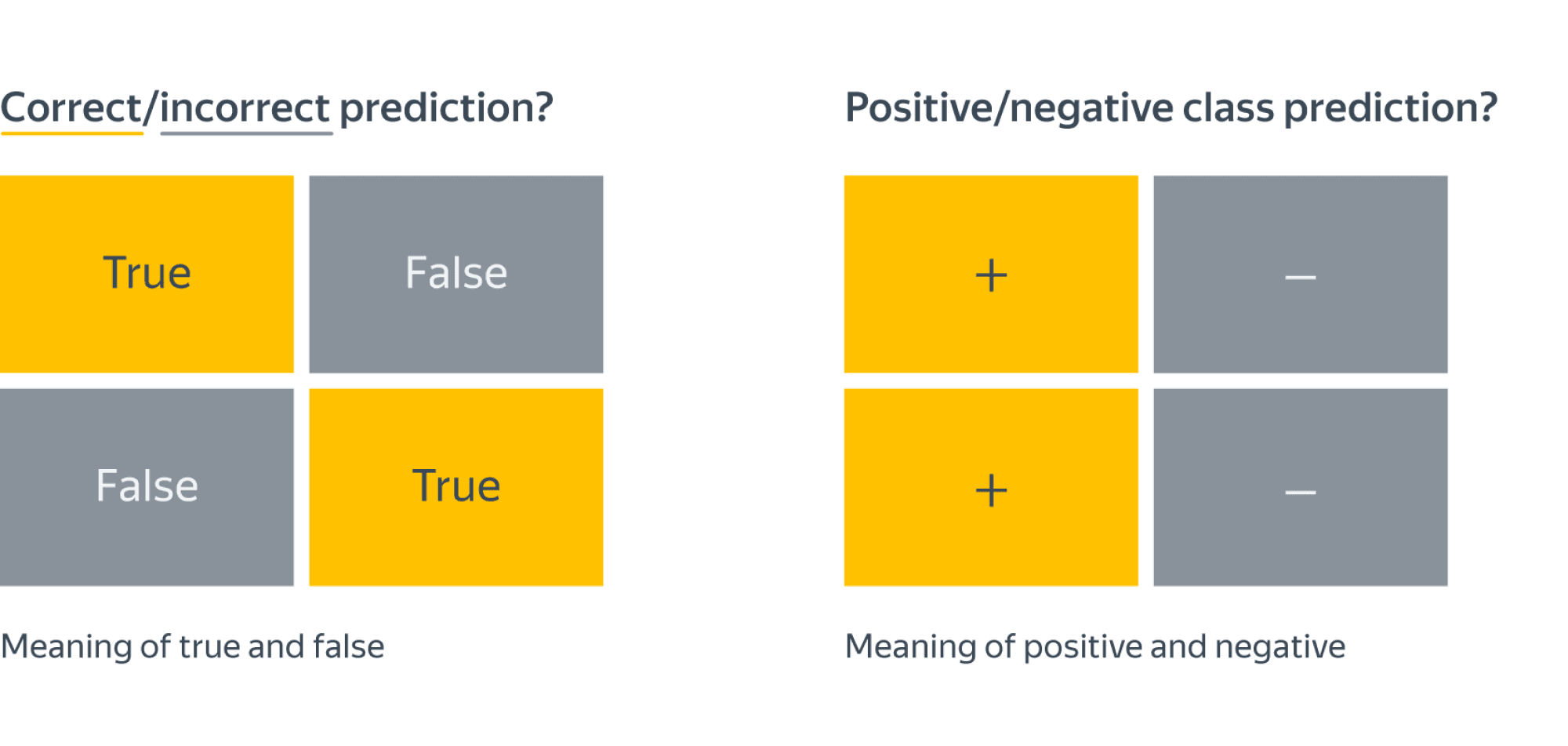

Confusion matrix (матрица ошибок)

Исторически задача бинарной классификации – это задача об обнаружении чего-то редкого в большом потоке объектов, например, поиск человека, больного туберкулёзом, по флюорографии. Или задача признания пятна на экране приёмника радиолокационной станции бомбардировщиком, представляющем угрозу охраняемому объекту (в противовес стае гусей).

Поэтому класс, который представляет для нас интерес, называется «положительным», а оставшийся – «отрицательным».

Заметим, что для каждого объекта в выборке возможно 4 ситуации:

- мы предсказали положительную метку и угадали. Будет относить такие объекты к true positive (TP) группе (true – потому что предсказали мы правильно, а positive – потому что предсказали положительную метку);

- мы предсказали положительную метку, но ошиблись в своём предсказании – false positive (FP) (false, потому что предсказание было неправильным);

- мы предсказали отрицательную метку и угадали – true negative (TN);

- и наконец, мы предсказали отрицательную метку, но ошиблись – false negative (FN). Для удобства все эти 4 числа изображают в виде таблицы, которую называют confusion matrix (матрицей ошибок):

Не волнуйтесь, если первое время эти обозначения будут сводить вас с ума (будем откровенны, даже профи со стажем в них порой путаются), однако логика за ними достаточно простая: первая часть названия группы показывает угадали ли мы с классом, а вторая – какой класс мы предсказали.

Пример

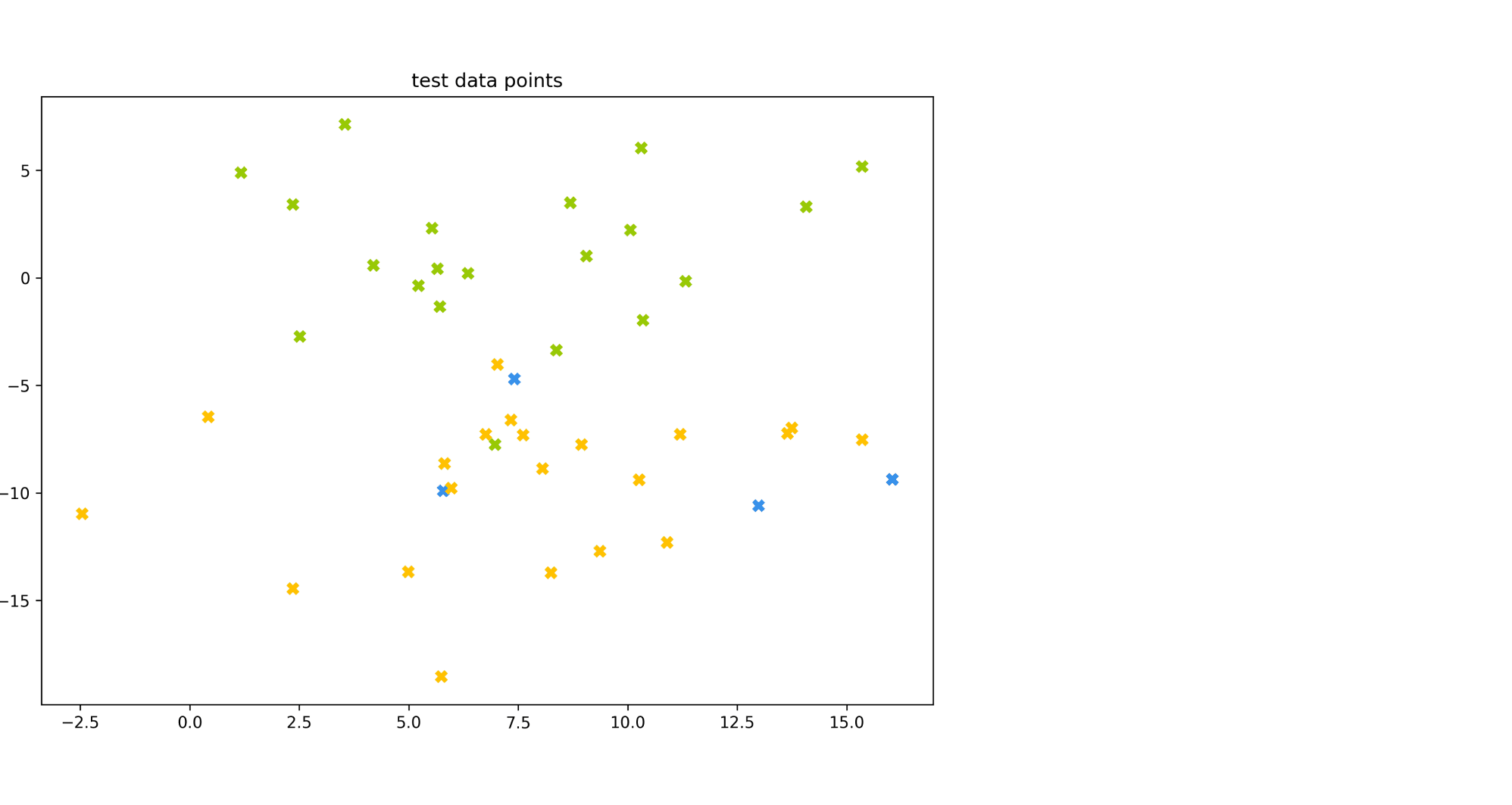

Попробуем воспользоваться введёнными метриками в боевом примере: сравним работу нескольких моделей классификации на Breast cancer wisconsin (diagnostic) dataset.

Объектами выборки являются фотографии биопсии грудных опухолей. С их помощью было сформировано признаковое описание, которое заключается в характеристиках ядер клеток (таких как радиус ядра, его текстура, симметричность). Положительным классом в такой постановке будут злокачественные опухоли, а отрицательным – доброкачественные.

Модель 1. Константное предсказание.

Решение задачи начнём с самого простого классификатора, который выдаёт на каждом объекте константное предсказание – самый часто встречающийся класс.

Зачем вообще замерять качество на такой модели?При разработке модели машинного обучения для проекта всегда желательно иметь некоторую baseline модель. Так нам будет легче проконтролировать, что наша более сложная модель действительно дает нам прирост качества.

from sklearn.datasets

import load_breast_cancer

the_data = load_breast_cancer()

# 0 – "доброкачественный"

# 1 – "злокачественный"

relabeled_target = 1 - the_data["target"]

from sklearn.model_selection import train_test_split

X = the_data["data"]

y = relabeled_target

X_train, X_test, y_train, y_test = train_test_split(X, y, random_state=0)

from sklearn.dummy import DummyClassifier

dc_mf = DummyClassifier(strategy="most_frequent")

dc_mf.fit(X_train, y_train)

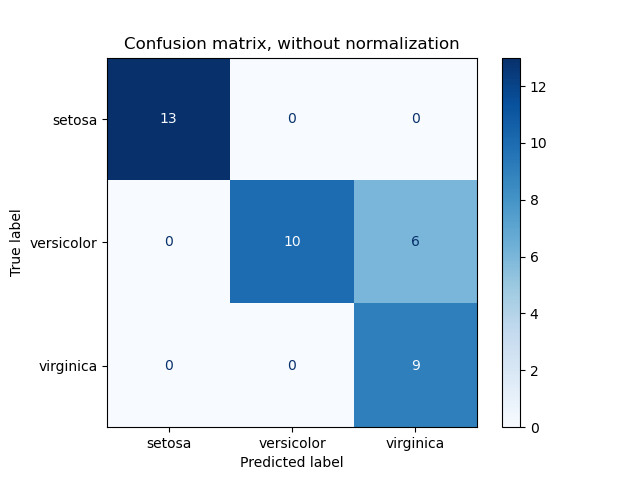

from sklearn.metrics import confusion_matrix

y_true = y_test y_pred = dc_mf.predict(X_test)

dc_mf_tn, dc_mf_fp, dc_mf_fn, dc_mf_tp = confusion_matrix(y_true, y_pred, labels = [0, 1]).ravel()

| Прогнозируемый класс + | Прогнозируемый класс — | |

|---|---|---|

| Истинный класс + | TP = 0 | FN = 53 |

| Истинный класс — | FP = 0 | TN = 90 |

Обучающие данные таковы, что наш dummy-классификатор все объекты записывает в отрицательный класс, то есть признаёт все опухоли доброкачественными. Такой наивный подход позволяет нам получить минимальный штраф за FP (действительно, нельзя ошибиться в предсказании, если положительный класс вообще не предсказывается), но и максимальный штраф за FN (в эту группу попадут все злокачественные опухоли).

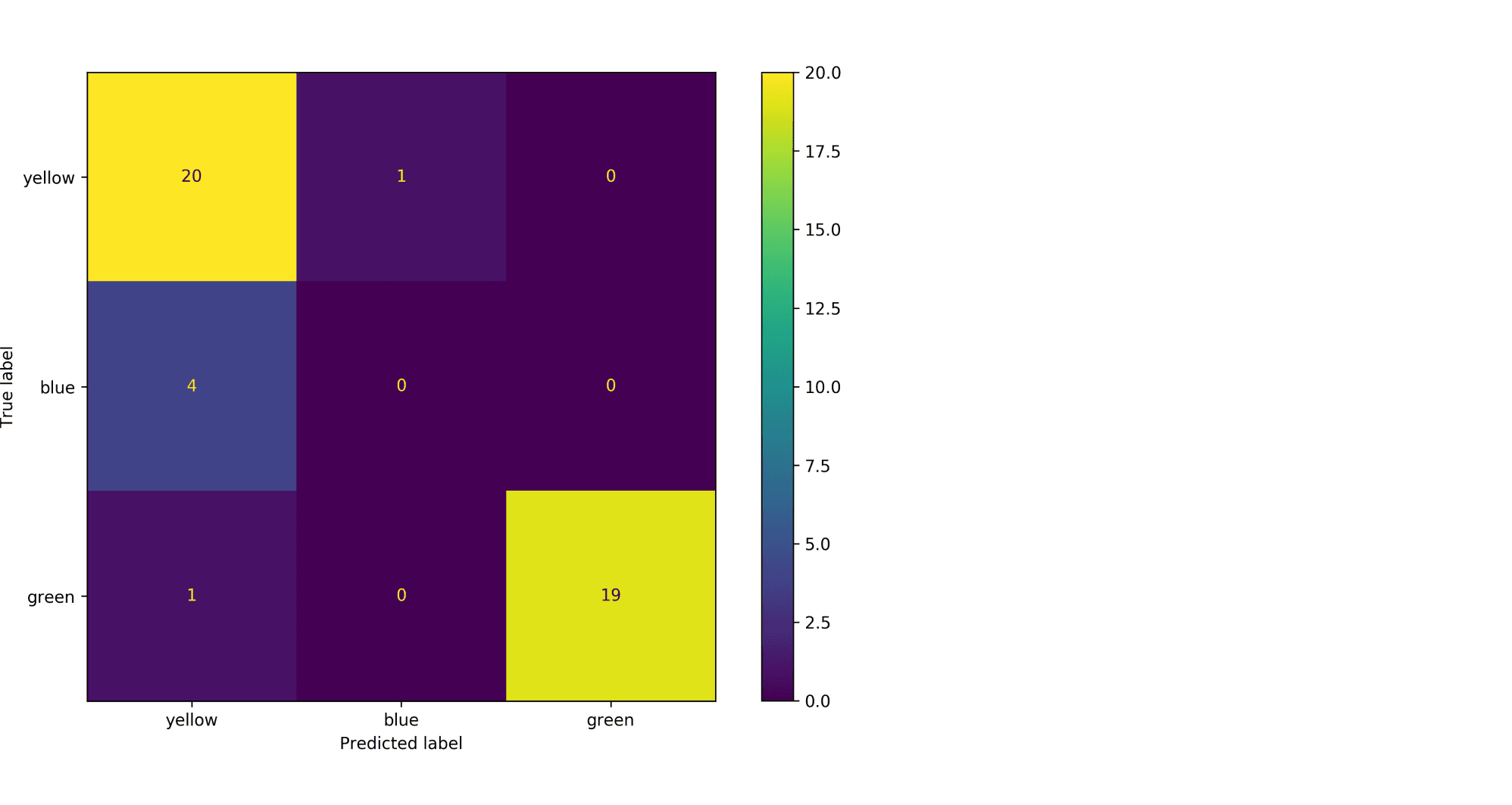

Модель 2. Случайный лес.

Настало время воспользоваться всем арсеналом моделей машинного обучения, и начнём мы со случайного леса.

from sklearn.ensemble import RandomForestClassifier

rfc = RandomForestClassifier()

rfc.fit(X_train, y_train)

y_true = y_test

y_pred = rfc.predict(X_test)

rfc_tn, rfc_fp, rfc_fn, rfc_tp = confusion_matrix(y_true, y_pred, labels = [0, 1]).ravel()

| Прогнозируемый класс + | Прогнозируемый класс — | |

|---|---|---|

| Истинный класс + | TP = 52 | FN = 1 |

| Истинный класс — | FP = 4 | TN = 86 |

Можно сказать, что этот классификатор чему-то научился, т.к. главная диагональ матрицы стала содержать все объекты из отложенной выборки, за исключением 4 + 1 = 5 объектов (сравните с 0 + 53 объектами dummy-классификатора, все опухоли объявляющего доброкачественными).

Отметим, что вычисляя долю недиагональных элементов, мы приходим к метрике error rate, о которой мы говорили в самом начале:

$$text{Error rate} = frac{FP + FN}{ TP + TN + FP + FN}$$

тогда как доля объектов, попавших на главную диагональ – это как раз таки accuracy:

$$text{Accuracy} = frac{TP + TN}{ TP + TN + FP + FN}$$

Модель 3. Метод опорных векторов.

Давайте построим еще один классификатор на основе линейного метода опорных векторов.

Не забудьте привести признаки к единому масштабу, иначе численный алгоритм не сойдется к решению и мы получим гораздо более плохо работающее решающее правило. Попробуйте проделать это упражнение.

from sklearn.svm import LinearSVC

from sklearn.preprocessing import StandardScaler

ss = StandardScaler() ss.fit(X_train)

scaled_linsvc = LinearSVC(C=0.01,random_state=42)

scaled_linsvc.fit(ss.transform(X_train), y_train)

y_true = y_test

y_pred = scaled_linsvc.predict(ss.transform(X_test))

tn, fp, fn, tp = confusion_matrix(y_true, y_pred, labels = [0, 1]).ravel()

| Прогнозируемый класс + | Прогнозируемый класс — | |

|---|---|---|

| Истинный класс + | TP = 50 | FN = 3 |

| Истинный класс — | FP = 1 | TN = 89 |

Сравним результаты

Легко заметить, что каждая из двух моделей лучше классификатора-пустышки, однако давайте попробуем сравнить их между собой. С точки зрения error rate модели практически одинаковы: 5/143 для леса против 4/143 для SVM.

Посмотрим на структуру ошибок чуть более внимательно: лес – (FP = 4, FN = 1), SVM – (FP = 1, FN = 3). Какая из моделей предпочтительнее?

Замечание: Мы сравниваем несколько классификаторов на основании их предсказаний на отложенной выборке. Насколько ошибки данных классификаторов зависят от разбиения исходного набора данных? Иногда в процессе оценки качества мы будем получать модели, чьи показатели эффективности будут статистически неразличимыми.

Пусть мы учли предыдущее замечание и эти модели действительно статистически значимо ошибаются в разную сторону. Мы встретились с очевидной вещью: на матрицах нет отношения порядка. Когда мы сравнивали dummy-классификатор и случайный лес с помощью Accuracy, мы всю сложную структуру ошибок свели к одному числу, т.к. на вещественных числах отношение порядка есть. Сводить оценку модели к одному числу очень удобно, однако не стоит забывать, что у вашей модели есть много аспектов качества.

Что же всё-таки важнее уменьшить: FP или FN? Вернёмся к задаче: FP – доля доброкачественных опухолей, которым ошибочно присваивается метка злокачественной, а FN – доля злокачественных опухолей, которые классификатор пропускает. В такой постановке становится понятно, что при сравнении выиграет модель с меньшим FN (то есть лес в нашем примере), ведь каждая не обнаруженная опухоль может стоить человеческой жизни.

Рассмотрим теперь другую задачу: по данным о погоде предсказать, будет ли успешным запуск спутника. FN в такой постановке – это ошибочное предсказание неуспеха, то есть не более, чем упущенный шанс (если вас, конечно не уволят за срыв сроков). С FP всё серьёзней: если вы предскажете удачный запуск спутника, а на деле он потерпит крушение из-за погодных условий, то ваши потери будут в разы существеннее.

Итак, из примеров мы видим, что в текущем виде введенная нами доля ошибочных классификаций не даст нам возможности учесть неравную важность FP и FN. Поэтому введем две новые метрики: точность и полноту.

Точность и полнота

Accuracy — это метрика, которая характеризует качество модели, агрегированное по всем классам. Это полезно, когда классы для нас имеют одинаковое значение. В случае, если это не так, accuracy может быть обманчивой.

Рассмотрим ситуацию, когда положительный класс это событие редкое. Возьмем в качестве примера поисковую систему — в нашем хранилище хранятся миллиарды документов, а релевантных к конкретному поисковому запросу на несколько порядков меньше.

Пусть мы хотим решить задачу бинарной классификации «документ d релевантен по запросу q». Благодаря большому дисбалансу, Accuracy dummy-классификатора, объявляющего все документы нерелевантными, будет близка к единице. Напомним, что $text{Accuracy} = frac{TP + TN}{TP + TN + FP + FN}$, и в нашем случае высокое значение метрики будет обеспечено членом TN, в то время для пользователей более важен высокий TP.

Поэтому в случае ассиметрии классов, можно использовать метрики, которые не учитывают TN и ориентируются на TP.

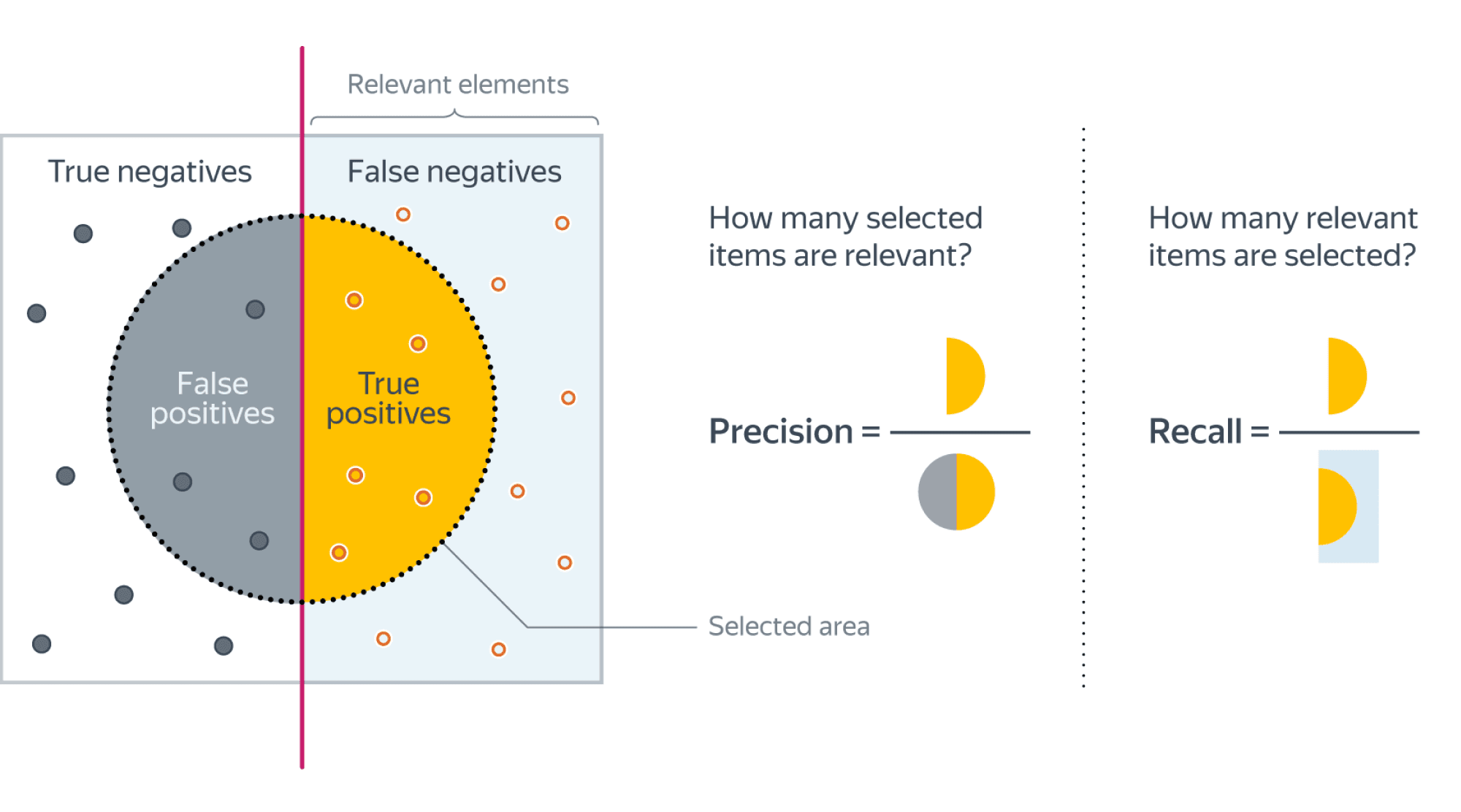

Если мы рассмотрим долю правильно предсказанных положительных объектов среди всех объектов, предсказанных положительным классом, то мы получим метрику, которая называется точностью (precision)

$$color{#348FEA}{text{Precision} = frac{TP}{TP + FP}}$$

Интуитивно метрика показывает долю релевантных документов среди всех найденных классификатором. Чем меньше ложноположительных срабатываний будет допускать модель, тем больше будет её Precision.

Если же мы рассмотрим долю правильно найденных положительных объектов среди всех объектов положительного класса, то мы получим метрику, которая называется полнотой (recall)

$$color{#348FEA}{text{Recall} = frac{TP}{TP + FN}}$$

Интуитивно метрика показывает долю найденных документов из всех релевантных. Чем меньше ложно отрицательных срабатываний, тем выше recall модели.

Например, в задаче предсказания злокачественности опухоли точность показывает, сколько из определённых нами как злокачественные опухолей действительно являются злокачественными, а полнота – какую долю злокачественных опухолей нам удалось выявить.

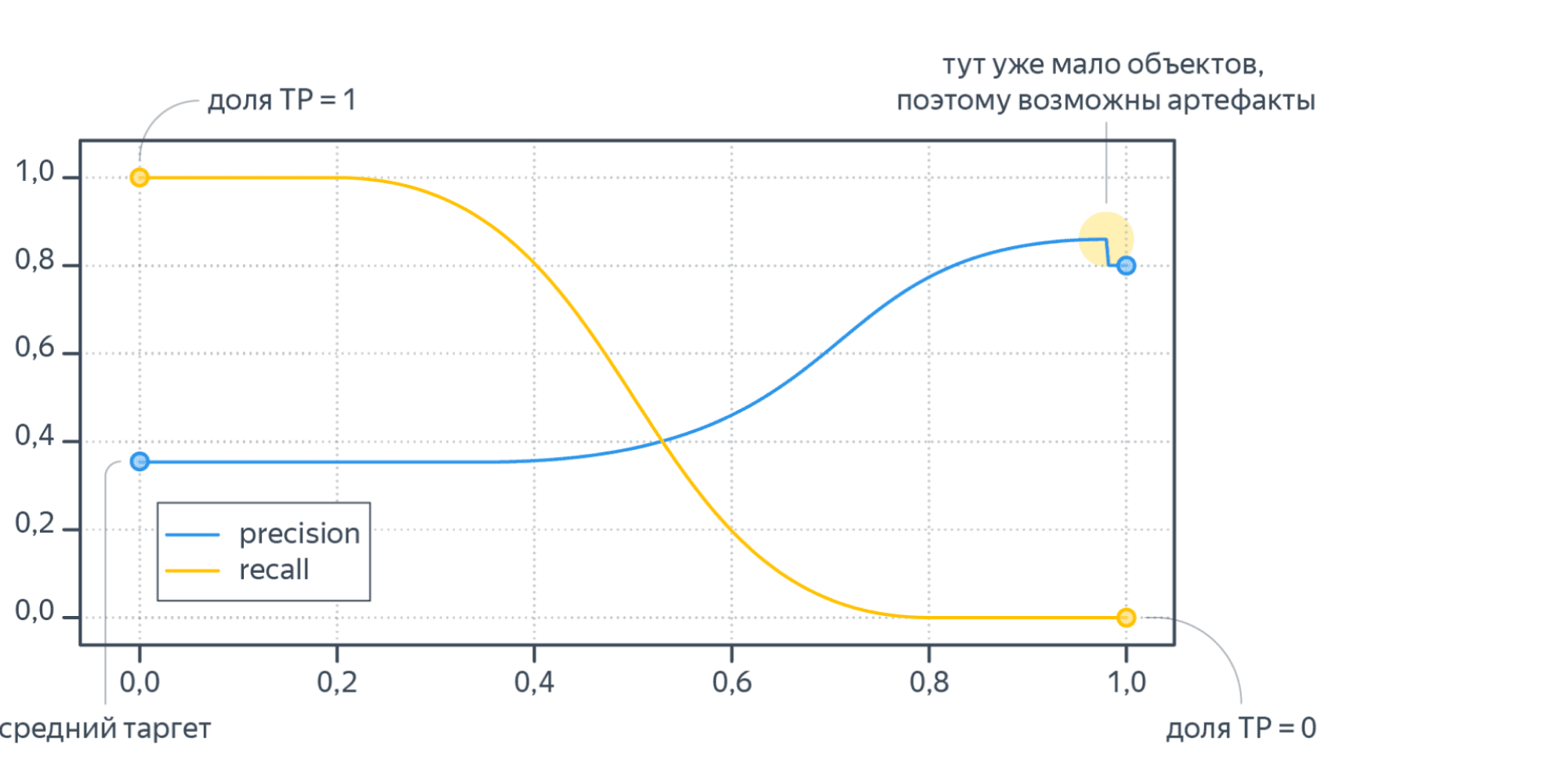

Хорошее понимание происходящего даёт следующая картинка:

Recall@k, Precision@k

Метрики Recall и Precision хорошо подходят для задачи поиска «документ d релевантен запросу q», когда из списка рекомендованных алгоритмом документов нас интересует только первый. Но не всегда алгоритм машинного обучения вынужден работать в таких жестких условиях. Может быть такое, что вполне достаточно, что релевантный документ попал в первые k рекомендованных. Например, в интерфейсе выдачи первые три подсказки видны всегда одновременно и вообще не очень понятно, какой у них порядок. Тогда более честной оценкой качества алгоритма будет «в выдаче D размера k по запросу q нашлись релевантные документы». Для расчёта метрики по всей выборке объединим все выдачи и рассчитаем precision, recall как обычно подокументно.

F1-мера

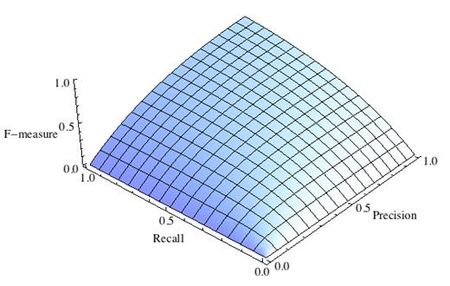

Как мы уже отмечали ранее, модели очень удобно сравнивать, когда их качество выражено одним числом. В случае пары Precision-Recall существует популярный способ скомпоновать их в одну метрику — взять их среднее гармоническое. Данный показатель эффективности исторически носит название F1-меры (F1-measure).

$$

color{#348FEA}{F_1 = frac{2}{frac{1}{Recall} + frac{1}{Precision}}} = $$

$$ = 2 frac{Recall cdot Precision }{Recall + Precision} = frac

{TP} {TP + frac{FP + FN}{2}}

$$

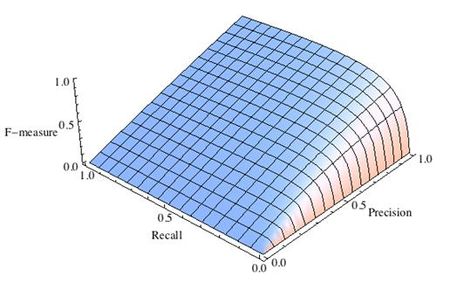

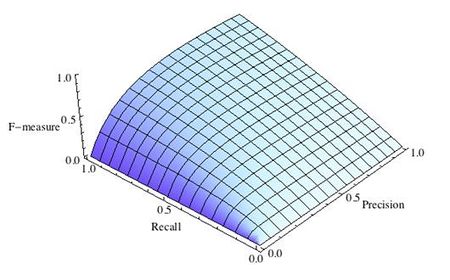

Стоит иметь в виду, что F1-мера предполагает одинаковую важность Precision и Recall, если одна из этих метрик для вас приоритетнее, то можно воспользоваться $F_{beta}$ мерой:

$$

F_{beta} = (beta^2 + 1) frac{Recall cdot Precision }{Recall + beta^2Precision}

$$

Бинарная классификация: вероятности классов

Многие модели бинарной классификации устроены так, что класс объекта получается бинаризацией выхода классификатора по некоторому фиксированному порогу:

$$fleft(x ; w, w_{0}right)=mathbb{I}left[g(x, w) > w_{0}right].$$

Например, модель логистической регрессии возвращает оценку вероятности принадлежности примера к положительному классу. Другие модели бинарной классификации обычно возвращают произвольные вещественные значения, но существуют техники, называемые калибровкой классификатора, которые позволяют преобразовать предсказания в более или менее корректную оценку вероятности принадлежности к положительному классу.

Как оценить качество предсказываемых вероятностей, если именно они являются нашей конечной целью? Общепринятой мерой является логистическая функция потерь, которую мы изучали раньше, когда говорили об устройстве некоторых методов классификации (например уже упоминавшейся логистической регрессии).

Если же нашей целью является построение прогноза в терминах метки класса, то нам нужно учесть, что в зависимости от порога мы будем получать разные предсказания и разное качество на отложенной выборке. Так, чем ниже порог отсечения, тем больше объектов модель будет относить к положительному классу. Как в этом случае оценить качество модели?

AUC

Пусть мы хотим учитывать ошибки на объектах обоих классов. При уменьшении порога отсечения мы будем находить (правильно предсказывать) всё большее число положительных объектов, но также и неправильно предсказывать положительную метку на всё большем числе отрицательных объектов. Естественным кажется ввести две метрики TPR и FPR:

TPR (true positive rate) – это полнота, доля положительных объектов, правильно предсказанных положительными:

$$ TPR = frac{TP}{P} = frac{TP}{TP + FN} $$

FPR (false positive rate) – это доля отрицательных объектов, неправильно предсказанных положительными:

$$FPR = frac{FP}{N} = frac{FP}{FP + TN}$$

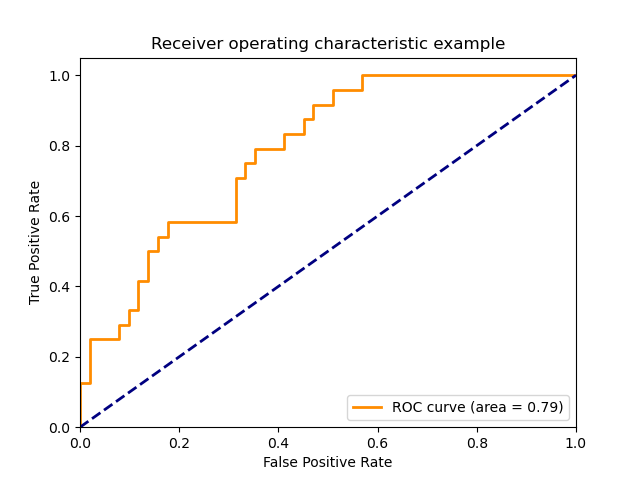

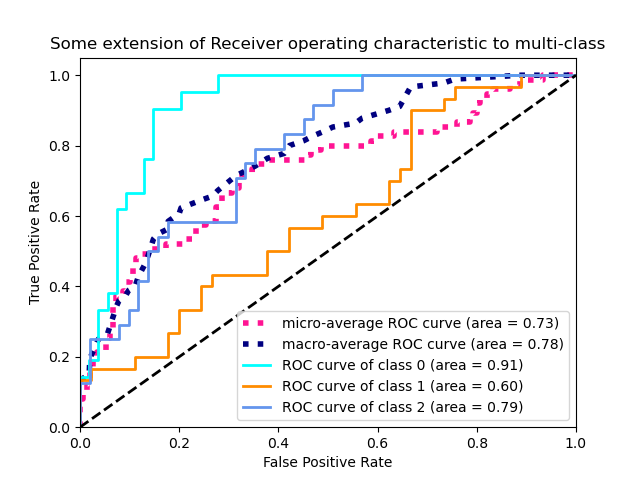

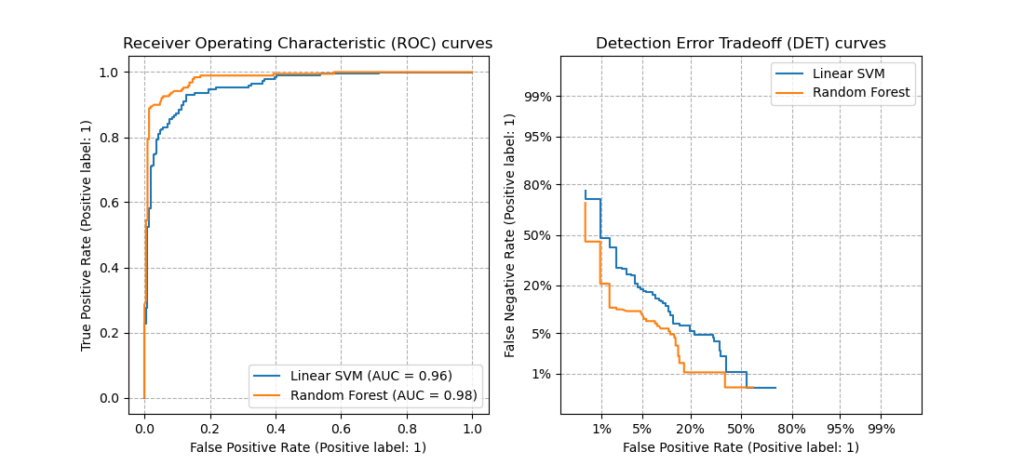

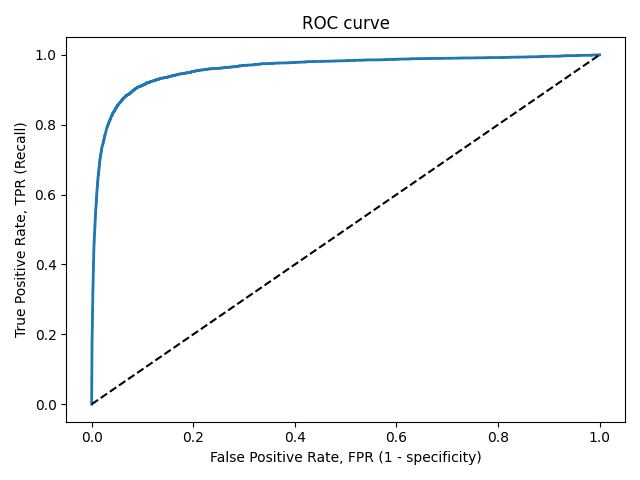

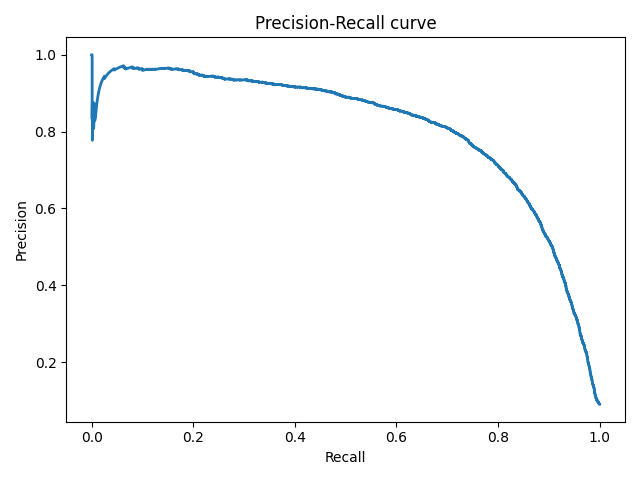

Обе эти величины растут при уменьшении порога. Кривая в осях TPR/FPR, которая получается при варьировании порога, исторически называется ROC-кривой (receiver operating characteristics curve, сокращённо ROC curve). Следующий график поможет вам понять поведение ROC-кривой.