Содержание

- How to Calculate Mean Squared Error in Python

- What is the Mean Squared Error

- Interpreting the Mean Squared Error

- Loading a Sample Pandas DataFrame

- Calculating the Mean Squared Error with Scikit-Learn

- Calculating the Mean Squared Error from Scratch using Numpy

- Conclusion

- Additional Resources

- Python | Mean Squared Error

- How To Calculate Mean Squared Error In Python

- Formula to calculate mean squared error

- Derivation of Mean Squared Error

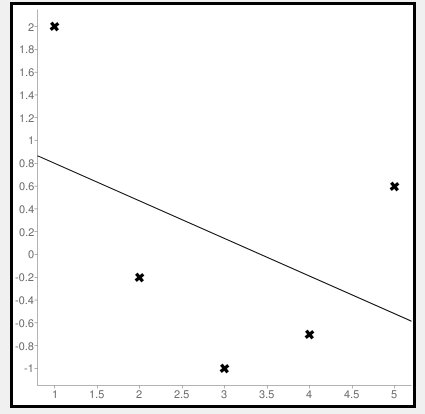

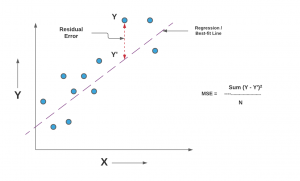

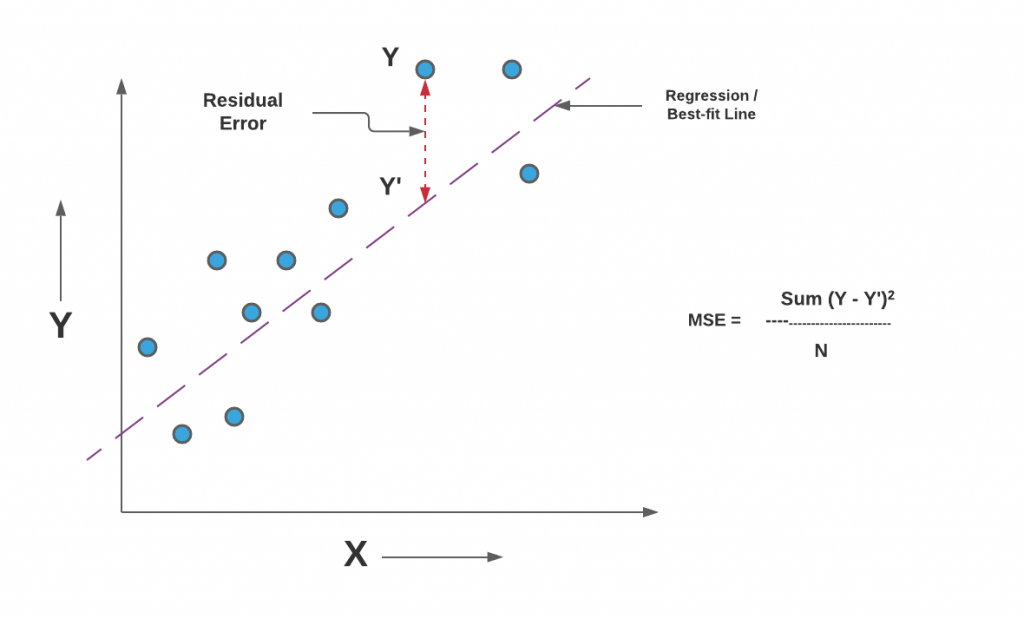

- Line regression graph

- To get the Mean Squared Error in Python using NumPy

- To get the MSE using sklearn

- Syntax

- Parameters

- Returns

- Calculating Mean Squared Error Without Using any Modules

- Calculate Mean Squared Error Using Negative Values

- Bonus: Gradient Descent

- 3.3. Метрики и оценки: количественная оценка качества прогнозов ¶

- 3.3.1. В scoring параметрах: определение правил оценки моделей

- 3.3.1.1. Общие случаи: предопределенные значения

- 3.3.1.2. Определение стратегии выигрыша от метрических функций

- 3.3.1.3. Реализация собственного скорингового объекта

- 3.3.1.4. Использование множественной метрической оценки

- 3.3.2. Метрики классификации

- 3.3.2.1. От бинарного до мультиклассового и многозначного

- 3.3.2.2. Оценка точности

- 3.3.2.3. Рейтинг точности Top-k

- 3.3.2.4. Сбалансированный показатель точности

- 3.3.2.5. Каппа Коэна

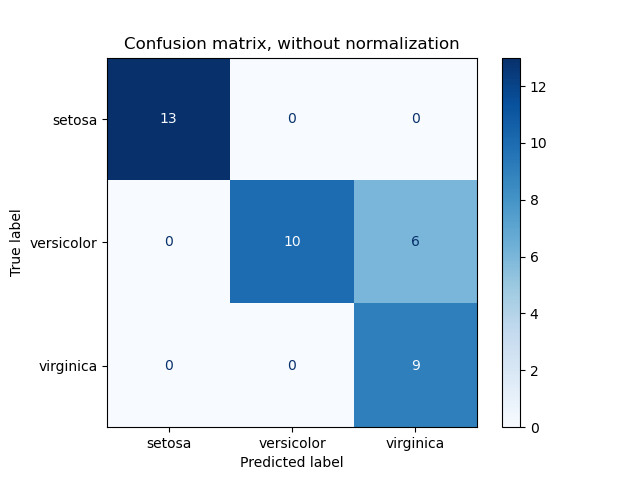

- 3.3.2.6. Матрица неточностей ¶

- 3.3.2.7. Отчет о классификации

- 3.3.2.8. Потеря Хэмминга

- 3.3.2.9. Точность, отзыв и F-меры

- 3.3.2.9.1. Бинарная классификация

- 3.3.2.9.2. Мультиклассовая и многозначная классификация

- 3.3.2.10. Оценка коэффициента сходства Жаккара

- 3.3.2.11. Петля лосс

- 3.3.2.12. Лог лосс

- 3.3.2.13. Коэффициент корреляции Мэтьюза

- 3.3.2.14. Матрица путаницы с несколькими метками

- 3.3.2.15. Рабочая характеристика приемника (ROC)

- 3.3.2.15.1. Двоичный регистр

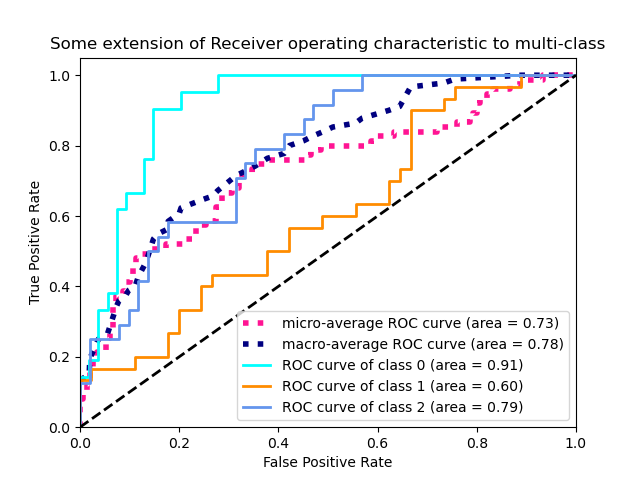

- 3.3.2.15.2. Мультиклассовый кейс

- 3.3.2.15.3. Кейс с несколькими метками

- 3.3.2.16. Компромисс при обнаружении ошибок (DET)

- 3.3.2.17. Нулевой проигрыш

- 3.3.2.18. Потеря очков по Брайеру

- 3.3.3. Метрики ранжирования с несколькими ярлыками

- 3.3.3.1. Ошибка покрытия

- 3.3.3.2. Средняя точность ранжирования метки

- 3.3.3.3. Потеря рейтинга

- 3.3.3.4. Нормализованная дисконтированная совокупная прибыль

- 3.3.4. Метрики регрессии

- 3.3.4.1. Оценка объясненной дисперсии

- 3.3.4.2. Максимальная ошибка

- 3.3.4.3. Средняя абсолютная ошибка

- 3.3.4.4. Среднеквадратичная ошибка

- 3.3.4.5. Среднеквадратичная логарифмическая ошибка

- 3.3.4.6. Средняя абсолютная ошибка в процентах

- 3.3.4.7. Средняя абсолютная ошибка

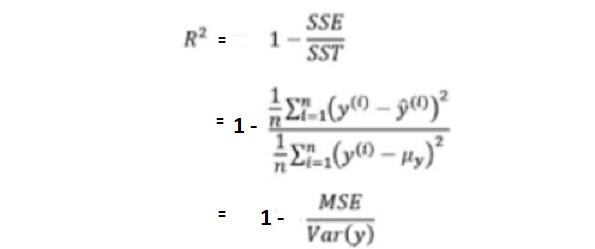

- 3.3.4.8. R² балл, коэффициент детерминации

- 3.3.4.9. Средние отклонения Пуассона, Гаммы и Твиди

- 3.3.5. Метрики кластеризации

- 3.3.6. Фиктивные оценки

How to Calculate Mean Squared Error in Python

The mean squared error is a common way to measure the prediction accuracy of a model. In this tutorial, you’ll learn how to calculate the mean squared error in Python. You’ll start off by learning what the mean squared error represents. Then you’ll learn how to do this using Scikit-Learn (sklean), Numpy, as well as from scratch.

Table of Contents

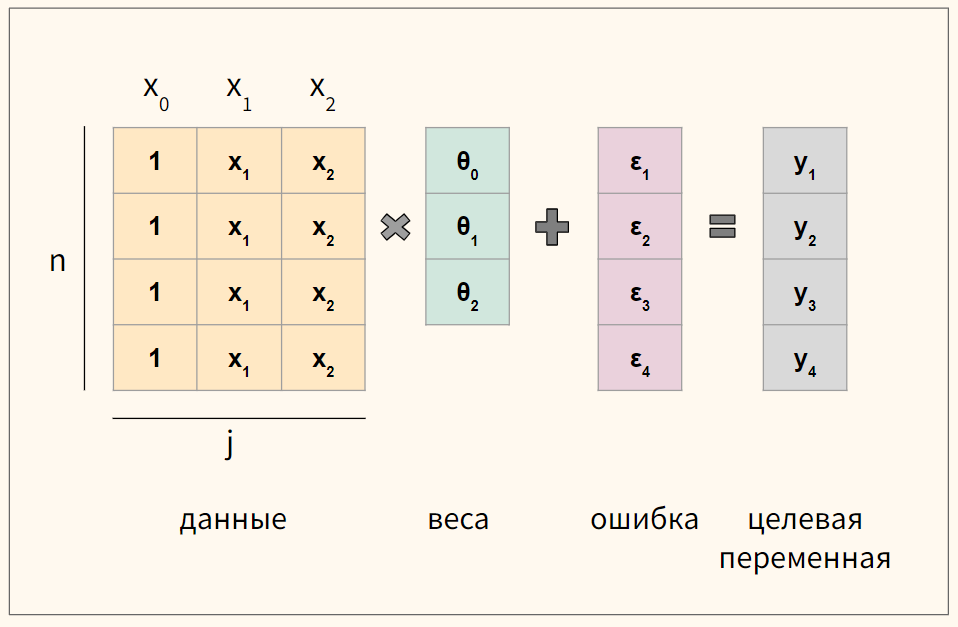

What is the Mean Squared Error

The mean squared error measures the average of the squares of the errors. What this means, is that it returns the average of the sums of the square of each difference between the estimated value and the true value.

The MSE is always positive, though it can be 0 if the predictions are completely accurate. It incorporates the variance of the estimator (how widely spread the estimates are) and its bias (how different the estimated values are from their true values).

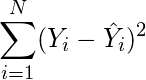

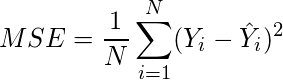

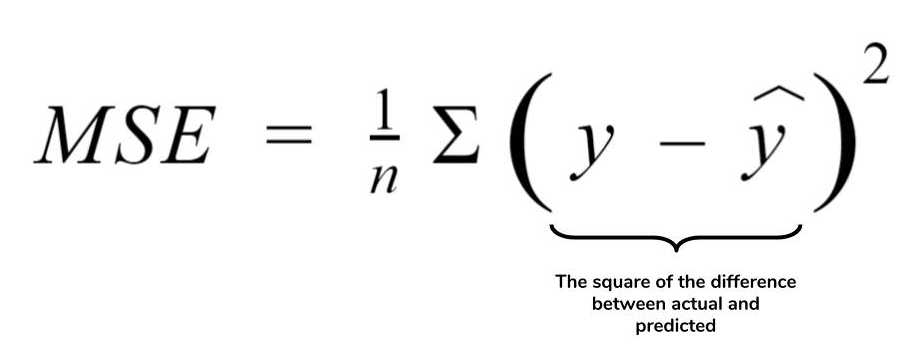

The formula looks like below:

Now that you have an understanding of how to calculate the MSE, let’s take a look at how it can be calculated using Python.

Interpreting the Mean Squared Error

The mean squared error is always 0 or positive. When a MSE is larger, this is an indication that the linear regression model doesn’t accurately predict the model.

An important piece to note is that the MSE is sensitive to outliers. This is because it calculates the average of every data point’s error. Because of this, a larger error on outliers will amplify the MSE.

There is no “target” value for the MSE. The MSE can, however, be a good indicator of how well a model fits your data. It can also give you an indicator of choosing one model over another.

Loading a Sample Pandas DataFrame

Let’s start off by loading a sample Pandas DataFrame. If you want to follow along with this tutorial line-by-line, simply copy the code below and paste it into your favorite code editor.

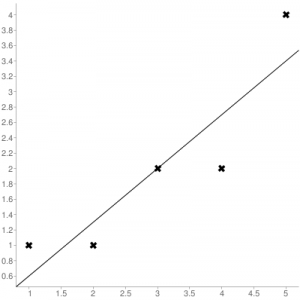

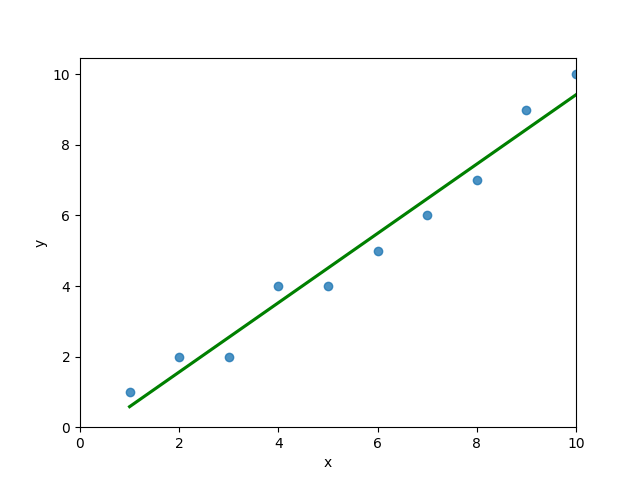

You can see that the editor has loaded a DataFrame containing values for variables x and y . We can plot this data out, including the line of best fit using Seaborn’s .regplot() function:

This returns the following visualization:

The mean squared error calculates the average of the sum of the squared differences between a data point and the line of best fit. By virtue of this, the lower a mean sqared error, the more better the line represents the relationship.

We can calculate this line of best using Scikit-Learn. You can learn about this in this in-depth tutorial on linear regression in sklearn. The code below predicts values for each x value using the linear model:

Calculating the Mean Squared Error with Scikit-Learn

The simplest way to calculate a mean squared error is to use Scikit-Learn (sklearn). The metrics module comes with a function, mean_squared_error() which allows you to pass in true and predicted values.

Let’s see how to calculate the MSE with sklearn:

This approach works very well when you’re already importing Scikit-Learn. That said, the function works easily on a Pandas DataFrame, as shown above.

In the next section, you’ll learn how to calculate the MSE with Numpy using a custom function.

Calculating the Mean Squared Error from Scratch using Numpy

Numpy itself doesn’t come with a function to calculate the mean squared error, but you can easily define a custom function to do this. We can make use of the subtract() function to subtract arrays element-wise.

The code above is a bit verbose, but it shows how the function operates. We can cut down the code significantly, as shown below:

Conclusion

In this tutorial, you learned what the mean squared error is and how it can be calculated using Python. First, you learned how to use Scikit-Learn’s mean_squared_error() function and then you built a custom function using Numpy.

The MSE is an important metric to use in evaluating the performance of your machine learning models. While Scikit-Learn abstracts the way in which the metric is calculated, understanding how it can be implemented from scratch can be a helpful tool.

Additional Resources

To learn more about related topics, check out the tutorials below:

Источник

Python | Mean Squared Error

The Mean Squared Error (MSE) or Mean Squared Deviation (MSD) of an estimator measures the average of error squares i.e. the average squared difference between the estimated values and true value. It is a risk function, corresponding to the expected value of the squared error loss. It is always non – negative and values close to zero are better. The MSE is the second moment of the error (about the origin) and thus incorporates both the variance of the estimator and its bias.

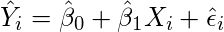

Steps to find the MSE

- Find the equation for the regression line.

(1)

Insert X values in the equation found in step 1 in order to get the respective Y values i.e.

(2)

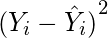

(3)

Square the errors found in step 3.

(4)

Sum up all the squares.

(5)

(6)

Example:

Consider the given data points: (1,1), (2,1), (3,2), (4,2), (5,4)

You can use this online calculator to find the regression equation / line.

Regression line equation: Y = 0.7X – 0.1

| X | Y |  |

|---|---|---|

| 1 | 1 | 0.6 |

| 2 | 1 | 1.29 |

| 3 | 2 | 1.99 |

| 4 | 2 | 2.69 |

| 5 | 4 | 3.4 |

Now, using formula found for MSE in step 6 above, we can get MSE = 0.21606

Источник

How To Calculate Mean Squared Error In Python

In this article, we are going to learn how to calculate the mean squared error in python? We are using two python libraries to calculate the mean squared error. NumPy and sklearn are the libraries we are going to use here. Also, we will learn how to calculate without using any module.

MSE is also useful for regression problems that are normally distributed. It is the mean squared error. So the squared error between the predicted values and the actual values. The summation of all the data points of the square difference between the predicted and actual values is divided by the no. of data points.

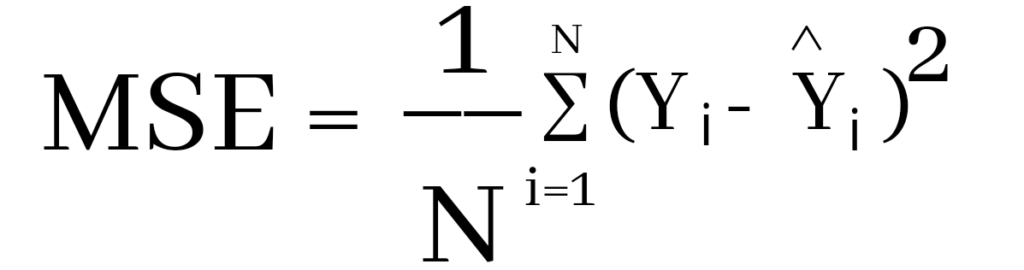

Formula to calculate mean squared error

Where Yi and Ŷi represent the actual values and the predicted values, the difference between them is squared.

Derivation of Mean Squared Error

First to find the regression line for the values (1,3), (2,2), (3,6), (4,1), (5,5). The regression value for the value is y=1.6+0.4x. Next to find the new Y values. The new values for y are tabulated below.

| Given x value | Calculating y value | New y value |

|---|---|---|

| 1 | 1.6+0.4(1) | 2 |

| 2 | 1.6+0.4(2) | 2.4 |

| 3 | 1.6+0.4(3) | 2.8 |

| 4 | 1.6+0.4(4) | 3.2 |

| 5 | 1.6+0.4(5) | 3.6 |

Now to find the error ( Yi – Ŷi )

We have to square all the errors

By adding all the errors we will get the MSE

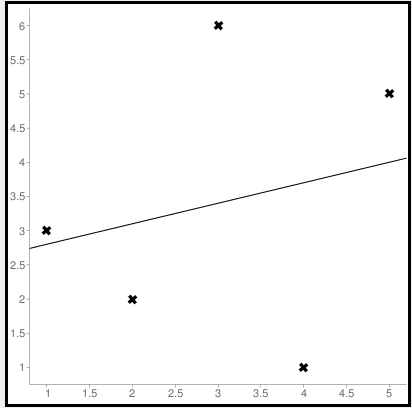

Line regression graph

Let us consider the values (1,3), (2,2), (3,6), (4,1), (5,5) to plot the graph.

The straight line represents the predicted value in this graph, and the points represent the actual data. The difference between this line and the points is squared, known as mean squared error.

To get the Mean Squared Error in Python using NumPy

Importing numpy library as np. Creating two variables. true_value_of_y holds an original value. predicted_value_of_y holds a calculated value. Next, giving the formula to calculate the mean squared error.

Output

To get the MSE using sklearn

sklearn is a library that is used for many mathematical calculations in python. Here we are going to use this library to calculate the MSE

Syntax

Parameters

- y_true – true value of y

- y_pred – predicted value of y

- sample_weight

- multioutput

- raw_values

- uniform_average

- squared

Returns

Mean squared error.

From sklearn.metrices library importing mean_squared_error. Creating two variables. true_value_of_y holds an original value. predicted_value_of_y holds a calculated value. Next, giving the formula to calculate the mean squared error.

Output

Calculating Mean Squared Error Without Using any Modules

Declaring the true values and the predicted values to two different variables. Initializing the variable summation_of_value is zero to store the values. len() function is useful to check the number of values in true_value_of_y. Creating for loop to iterate. Calculating the difference between true_value and the predicted_value. Next getting the square of the difference. Adding all the squared differences, we will get the MSE.

Output

Calculate Mean Squared Error Using Negative Values

Now let us consider some negative values to calculate MSE. The values are (1,2), (3,-1), (5,0.6), (4,-0.7), (2,-0.2). The regression line equation is y=1.13-0.33x

The line regression graph for this value is:

New y values for this will be:

| Given x value | Calculating y value | New y value |

|---|---|---|

| 1 | 1.13-033(1) | 0.9 |

| 3 | 1.13-033(3) | 0.1 |

| 5 | 1.13-033(5) | -0.4 |

| 4 | 1.13-033(4) | -0.1 |

| 2 | 1.13-033(2) | 0.6 |

First, importing a module. Declaring values to the variables. Here we are using negative value to calculate. Using the mean_squared_error module, we are calculating the MSE.

Output

Bonus: Gradient Descent

Gradient Descent is used to find the local minimum of the functions. In this case, the functions need to be differentiable. The basic idea is to move in the direction opposite from the derivate at any point.

The following code works on a set of values that are available on the Github repository.

Источник

3.3. Метрики и оценки: количественная оценка качества прогнозов ¶

Есть 3 различных API для оценки качества прогнозов модели:

- Метод оценки оценщика : у оценщиков есть score метод, обеспечивающий критерий оценки по умолчанию для проблемы, для решения которой они предназначены. Это обсуждается не на этой странице, а в документации каждого оценщика.

- Параметр оценки: инструменты оценки модели с использованием перекрестной проверки (например, model_selection.cross_val_score и model_selection.GridSearchCV ) полагаются на внутреннюю стратегию оценки . Это обсуждается в разделе Параметр оценки: определение правил оценки модели .

- Метрические функции : В sklearn.metrics модуле реализованы функции оценки ошибки прогноза для конкретных целей. Эти показатели подробно описаны в разделах по метрикам классификации , MultiLabel ранжирования показателей , показателей регрессии и показателей кластеризации .

Наконец, фиктивные оценки полезны для получения базового значения этих показателей для случайных прогнозов.

«Парные» метрики между выборками, а не оценками или прогнозами, см. В разделе « Парные метрики, сходства и ядра ».

3.3.1. В scoring параметрах: определение правил оценки моделей

Выбор и оценка модели с использованием таких инструментов, как model_selection.GridSearchCV и model_selection.cross_val_score , принимают scoring параметр, который контролирует, какую метрику они применяют к оцениваемым оценщикам.

3.3.1.1. Общие случаи: предопределенные значения

Для наиболее распространенных случаев использования вы можете назначить объект подсчета с помощью scoring параметра; в таблице ниже показаны все возможные значения. Все объекты счетчика следуют соглашению о том, что более высокие возвращаемые значения лучше, чем более низкие возвращаемые значения . Таким образом, метрики, которые измеряют расстояние между моделью и данными, например metrics.mean_squared_error , доступны как neg_mean_squared_error, которые возвращают инвертированное значение метрики.

| Подсчет очков | Функция | Комментарий |

| Классификация | ||

| ‘accuracy’ | metrics.accuracy_score | |

| ‘balanced_accuracy’ | metrics.balanced_accuracy_score | |

| ‘top_k_accuracy’ | metrics.top_k_accuracy_score | |

| ‘average_precision’ | metrics.average_precision_score | |

| ‘neg_brier_score’ | metrics.brier_score_loss | |

| ‘f1’ | metrics.f1_score | для двоичных целей |

| ‘f1_micro’ | metrics.f1_score | микро-усредненный |

| ‘f1_macro’ | metrics.f1_score | микро-усредненный |

| ‘f1_weighted’ | metrics.f1_score | средневзвешенное |

| ‘f1_samples’ | metrics.f1_score | по многопозиционному образцу |

| ‘neg_log_loss’ | metrics.log_loss | требуется predict_proba поддержка |

| ‘precision’ etc. | metrics.precision_score | суффиксы применяются как с ‘f1’ |

| ‘recall’ etc. | metrics.recall_score | суффиксы применяются как с ‘f1’ |

| ‘jaccard’ etc. | metrics.jaccard_score | суффиксы применяются как с ‘f1’ |

| ‘roc_auc’ | metrics.roc_auc_score | |

| ‘roc_auc_ovr’ | metrics.roc_auc_score | |

| ‘roc_auc_ovo’ | metrics.roc_auc_score | |

| ‘roc_auc_ovr_weighted’ | metrics.roc_auc_score | |

| ‘roc_auc_ovo_weighted’ | metrics.roc_auc_score | |

| Кластеризация | ||

| ‘adjusted_mutual_info_score’ | metrics.adjusted_mutual_info_score | |

| ‘adjusted_rand_score’ | metrics.adjusted_rand_score | |

| ‘completeness_score’ | metrics.completeness_score | |

| ‘fowlkes_mallows_score’ | metrics.fowlkes_mallows_score | |

| ‘homogeneity_score’ | metrics.homogeneity_score | |

| ‘mutual_info_score’ | metrics.mutual_info_score | |

| ‘normalized_mutual_info_score’ | metrics.normalized_mutual_info_score | |

| ‘rand_score’ | metrics.rand_score | |

| ‘v_measure_score’ | metrics.v_measure_score | |

| Регрессия | ||

| ‘explained_variance’ | metrics.explained_variance_score | |

| ‘max_error’ | metrics.max_error | |

| ‘neg_mean_absolute_error’ | metrics.mean_absolute_error | |

| ‘neg_mean_squared_error’ | metrics.mean_squared_error | |

| ‘neg_root_mean_squared_error’ | metrics.mean_squared_error | |

| ‘neg_mean_squared_log_error’ | metrics.mean_squared_log_error | |

| ‘neg_median_absolute_error’ | metrics.median_absolute_error | |

| ‘r2’ | metrics.r2_score | |

| ‘neg_mean_poisson_deviance’ | metrics.mean_poisson_deviance | |

| ‘neg_mean_gamma_deviance’ | metrics.mean_gamma_deviance | |

| ‘neg_mean_absolute_percentage_error’ | metrics.mean_absolute_percentage_error |

Значения, перечисленные в виде ValueError исключения, соответствуют функциям измерения точности прогнозирования, описанным в следующих разделах. Объекты счетчика для этих функций хранятся в словаре sklearn.metrics.SCORERS .

3.3.1.2. Определение стратегии выигрыша от метрических функций

Модуль sklearn.metrics также предоставляет набор простых функций, измеряющих ошибку предсказания с учетом истинности и предсказания:

- функции, заканчивающиеся на, _score возвращают значение для максимизации, чем выше, тем лучше.

- функции, заканчивающиеся на _error или _loss возвращающие значение, которое нужно минимизировать, чем ниже, тем лучше. При преобразовании в объект счетчика с использованием make_scorer установите для greater_is_better параметра значение False ( True по умолчанию; см. Описание параметра ниже).

Метрики, доступные для различных задач машинного обучения, подробно описаны в разделах ниже.

Многим метрикам не даются имена для использования в качестве scoring значений, иногда потому, что они требуют дополнительных параметров, например fbeta_score . В таких случаях вам необходимо создать соответствующий объект оценки. Самый простой способ создать вызываемый объект для оценки — использовать make_scorer . Эта функция преобразует метрики в вызываемые объекты, которые можно использовать для оценки модели.

Один из типичных вариантов использования — обернуть существующую метрическую функцию из библиотеки значениями, отличными от значений по умолчанию для ее параметров, такими как beta параметр для fbeta_score функции:

Второй вариант использования — создание полностью настраиваемого объекта скоринга из простой функции Python с использованием make_scorer , которая может принимать несколько параметров:

- функция Python, которую вы хотите использовать ( my_custom_loss_func в примере ниже)

- возвращает ли функция Python оценку ( greater_is_better=True , по умолчанию) или потерю ( greater_is_better=False ). В случае потери результат функции python аннулируется объектом скоринга в соответствии с соглашением о перекрестной проверке, согласно которому скоринтеры возвращают более высокие значения для лучших моделей.

- только для показателей классификации: требуется ли для предоставленной вами функции Python постоянная уверенность в принятии решений ( needs_threshold=True ). Значение по умолчанию неверно.

- любые дополнительные параметры, такие как beta или labels в f1_score .

Вот пример создания пользовательских счетчиков очков и использования greater_is_better параметра:

3.3.1.3. Реализация собственного скорингового объекта

Вы можете сгенерировать еще более гибкие модели скоринга, создав свой собственный скоринговый объект с нуля, без использования make_scorer фабрики. Чтобы вызываемый может быть бомбардиром, он должен соответствовать протоколу, указанному в следующих двух правилах:

- Его можно вызвать с параметрами (estimator, X, y), где estimator это модель, которая должна быть оценена, X это данные проверки и y основная истинная цель для (в контролируемом случае) или None (в неконтролируемом случае).

- Он возвращает число с плавающей запятой, которое количественно определяет estimator качество прогнозирования X со ссылкой на y . Опять же, по соглашению более высокие числа лучше, поэтому, если ваш секретарь сообщает о проигрыше, это значение следует отменить.

Примечание Использование пользовательских счетчиков в функциях, где n_jobs> 1

Хотя определение пользовательской функции оценки вместе с вызывающей функцией должно работать из коробки с бэкэндом joblib по умолчанию (loky), его импорт из другого модуля будет более надежным подходом и будет работать независимо от бэкэнда joblib.

Например, чтобы использовать n_jobs больше 1 в примере ниже, custom_scoring_function функция сохраняется в созданном пользователем модуле ( custom_scorer_module.py ) и импортируется:

3.3.1.4. Использование множественной метрической оценки

Scikit-learn также позволяет оценивать несколько показателей в GridSearchCV , RandomizedSearchCV и cross_validate .

Есть три способа указать несколько показателей оценки для scoring параметра:

- Как итерация строковых показателей:

- В качестве dict сопоставления имени секретаря с функцией подсчета очков:

Обратите внимание, что значения dict могут быть либо функциями счетчика, либо одной из предварительно определенных строк показателей.

- Как вызываемый объект, возвращающий словарь оценок:

3.3.2. Метрики классификации

В sklearn.metrics модуле реализованы несколько функций потерь, оценки и полезности для измерения эффективности классификации. Некоторые метрики могут потребовать оценок вероятности положительного класса, значений достоверности или значений двоичных решений. Большинство реализаций позволяют каждой выборке вносить взвешенный вклад в общую оценку с помощью sample_weight параметра.

Некоторые из них ограничены случаем двоичной классификации:

| precision_recall_curve (y_true, probas_pred, *) | Вычислите пары точности-отзыва для разных пороговых значений вероятности. |

| roc_curve (y_true, y_score, *[, pos_label, …]) | Вычислить рабочую характеристику приемника (ROC). |

| det_curve (y_true, y_score[, pos_label, …]) | Вычислите частоту ошибок для различных пороговых значений вероятности. |

Другие также работают в случае мультикласса:

| balanced_accuracy_score (y_true, y_pred, *[, …]) | Вычислите сбалансированную точность. |

| cohen_kappa_score (y1, y2, *[, labels, …]) | Каппа Коэна: статистика, измеряющая согласованность аннотаторов. |

| confusion_matrix (y_true, y_pred, *[, …]) | Вычислите матрицу неточностей, чтобы оценить точность классификации. |

| hinge_loss (y_true, pred_decision, *[, …]) | Средняя потеря петель (нерегулируемая). |

| matthews_corrcoef (y_true, y_pred, *[, …]) | Вычислите коэффициент корреляции Мэтьюза (MCC). |

| roc_auc_score (y_true, y_score, *[, average, …]) | Вычислить площадь под кривой рабочих характеристик приемника (ROC AUC) по оценкам прогнозов. |

| top_k_accuracy_score (y_true, y_score, *[, …]) | Top-k Рейтинг по классификации точности. |

Некоторые также работают в многоярусном регистре:

| accuracy_score (y_true, y_pred, *[, …]) | Классификационная оценка точности. |

| classification_report (y_true, y_pred, *[, …]) | Создайте текстовый отчет, показывающий основные показатели классификации. |

| f1_score (y_true, y_pred, *[, labels, …]) | Вычислите оценку F1, также известную как сбалансированная оценка F или F-мера. |

| fbeta_score (y_true, y_pred, *, beta[, …]) | Вычислите оценку F-beta. |

| hamming_loss (y_true, y_pred, *[, sample_weight]) | Вычислите среднюю потерю Хэмминга. |

| jaccard_score (y_true, y_pred, *[, labels, …]) | Оценка коэффициента сходства Жаккара. |

| log_loss (y_true, y_pred, *[, eps, …]) | Потеря журнала, также известная как потеря логистики или потеря кросс-энтропии. |

| multilabel_confusion_matrix (y_true, y_pred, *) | Вычислите матрицу неточностей для каждого класса или образца. |

| precision_recall_fscore_support (y_true, …) | Точность вычислений, отзыв, F-мера и поддержка для каждого класса. |

| precision_score (y_true, y_pred, *[, labels, …]) | Вычислите точность. |

| recall_score (y_true, y_pred, *[, labels, …]) | Вычислите отзыв. |

| roc_auc_score (y_true, y_score, *[, average, …]) | Вычислить площадь под кривой рабочих характеристик приемника (ROC AUC) по оценкам прогнозов. |

| zero_one_loss (y_true, y_pred, *[, …]) | Потеря классификации нулевая единица. |

А некоторые работают с двоичными и многозначными (но не мультиклассовыми) проблемами:

| average_precision_score (y_true, y_score, *) | Вычислить среднюю точность (AP) из оценок прогнозов. |

В следующих подразделах мы опишем каждую из этих функций, которым будут предшествовать некоторые примечания по общему API и определению показателей.

3.3.2.1. От бинарного до мультиклассового и многозначного

Некоторые метрики по существу определены для задач двоичной классификации (например f1_score , roc_auc_score ). В этих случаях по умолчанию оценивается только положительная метка, предполагая по умолчанию, что положительный класс помечен 1 (хотя это можно настроить с помощью pos_label параметра).

При расширении двоичной метрики на задачи с несколькими классами или метками данные обрабатываются как набор двоичных задач, по одной для каждого класса. Затем есть несколько способов усреднить вычисления двоичных показателей по набору классов, каждый из которых может быть полезен в некотором сценарии. Если возможно, вы должны выбрать одно из них с помощью average параметра.

- «macro» просто вычисляет среднее значение двоичных показателей, придавая каждому классу одинаковый вес. В задачах, где редкие занятия тем не менее важны, макро-усреднение может быть средством выделения их производительности. С другой стороны, предположение, что все классы одинаково важны, часто неверно, так что макро-усреднение будет чрезмерно подчеркивать обычно низкую производительность для нечастого класса.

- «weighted» учитывает дисбаланс классов, вычисляя среднее значение двоичных показателей, в которых оценка каждого класса взвешивается по его присутствию в истинной выборке данных.

- «micro» дает каждой паре выборка-класс равный вклад в общую метрику (за исключением результата взвешивания выборки). Вместо того, чтобы суммировать метрику для каждого класса, это суммирует дивиденды и делители, составляющие метрики для каждого класса, для расчета общего частного. Микро-усреднение может быть предпочтительным в настройках с несколькими ярлыками, включая многоклассовую классификацию, когда класс большинства следует игнорировать.

- «samples» применяется только к задачам с несколькими ярлыками. Он не вычисляет меру для каждого класса, вместо этого вычисляет метрику по истинным и прогнозируемым классам для каждой выборки в данных оценки и возвращает их ( sample_weight — взвешенное) среднее значение.

- Выбор average=None вернет массив с оценкой для каждого класса.

В то время как данные мультикласса предоставляются метрике, как двоичные цели, в виде массива меток классов, данные с несколькими метками указываются как индикаторная матрица, в которой ячейка [i, j] имеет значение 1, если у образца i есть метка j, и значение 0 в противном случае.

3.3.2.2. Оценка точности

Функция accuracy_score вычисляет точность , либо фракции ( по умолчанию) или количество (нормализует = False) правильных предсказаний.

В классификации с несколькими ярлыками функция возвращает точность подмножества. Если весь набор предсказанных меток для выборки строго соответствует истинному набору меток, то точность подмножества равна 1,0; в противном случае — 0, 0.

Если $hat_i$ прогнозируемое значение $i$-й образец и $y_i$ — соответствующее истинное значение, тогда доля правильных прогнозов по сравнению с $n_$ определяется как

$$texttt(y, hat) = frac<1>> sum_^-1> 1(hat_i = y_i)$$

В многопозиционном корпусе с бинарными индикаторами меток:

- См. В разделе Проверка с перестановками значимости классификационной оценки пример использования показателя точности с использованием перестановок набора данных.

3.3.2.3. Рейтинг точности Top-k

Функция top_k_accuracy_score представляет собой обобщение accuracy_score . Разница в том, что прогноз считается правильным, если истинная метка связана с одним из k наивысших прогнозируемых баллов. accuracy_score является частным случаем k = 1 .

Функция охватывает случаи двоичной и многоклассовой классификации, но не случай многозначной классификации.

Если $hat_$ прогнозируемый класс для $i$-й образец, соответствующий $j$-й по величине прогнозируемый результат и $y_i$ — соответствующее истинное значение, тогда доля правильных прогнозов по сравнению с $n_$ определяется как

$$texttt(y, hat) = frac<1>> sum_^-1> sum_^ 1(hat_ = y_i)$$

где k допустимое количество предположений и 1(x)- индикаторная функция.

3.3.2.4. Сбалансированный показатель точности

Функция balanced_accuracy_score вычисляет взвешенную точность , что позволяет избежать завышенных оценок производительности на несбалансированных данных. Это макросреднее количество оценок отзыва по классу или, что то же самое, грубая точность, где каждая выборка взвешивается в соответствии с обратной распространенностью ее истинного класса. Таким образом, для сбалансированных наборов данных оценка равна точности.

В двоичном случае сбалансированная точность равна среднему арифметическому чувствительности (истинно положительный показатель) и специфичности (истинно отрицательный показатель) или площади под кривой ROC с двоичными прогнозами, а не баллами:

$$texttt = frac<1><2>left( frac + fracright )$$

Если классификатор одинаково хорошо работает в любом классе, этот термин сокращается до обычной точности (т. е. Количества правильных прогнозов, деленного на общее количество прогнозов).

Напротив, если обычная точность выше вероятности только потому, что классификатор использует несбалансированный набор тестов, тогда сбалансированная точность, при необходимости, упадет до $frac<1>$.

Оценка варьируется от 0 до 1 или, когда adjusted=True используется, масштабируется до диапазона $frac<1><1 — n_classes>$ до 1 включительно, с произвольной оценкой 0.

Если yi истинная ценность $i$-й образец, и $w_i$ — соответствующий вес образца, затем мы настраиваем вес образца на:

$$hat_i = frac<sum_j<1(y_j = y_i) w_j>>$$

где $1(x)$- индикаторная функция . Учитывая предсказанный $hat_i$ для образца $i$, сбалансированная точность определяется как:

$$texttt(y, hat, w) = frac<1><sum<hat_i>> sum_i 1(hat_i = y_i) hat_i$$

С adjusted=True сбалансированной точностью сообщает об относительном увеличении от $texttt(y, mathbf<0>, w) =frac<1>$. В двоичном случае это также известно как * статистика Юдена * , или информированность .

Определение мультикласса здесь кажется наиболее разумным расширением метрики, используемой в бинарной классификации, хотя в литературе нет определенного консенсуса:

- Наше определение: [Mosley2013] , [Kelleher2015] и [Guyon2015] , где [Guyon2015] принимает скорректированную версию, чтобы гарантировать, что случайные предсказания имеют оценку а точные предсказания имеют оценку 1..

- Точность балансировки классов, как описано в [Mosley2013] : вычисляется минимум между точностью и отзывом для каждого класса. Затем эти значения усредняются по общему количеству классов для получения сбалансированной точности.

- Сбалансированная точность, как описано в [Urbanowicz2015] : среднее значение чувствительности и специфичности вычисляется для каждого класса, а затем усредняется по общему количеству классов.

3.3.2.5. Каппа Коэна

Функция cohen_kappa_score вычисляет каппа-Коэна статистику. Эта мера предназначена для сравнения меток, сделанных разными людьми-аннотаторами, а не классификатором с достоверной информацией.

Показатель каппа (см. Строку документации) представляет собой число от -1 до 1. Баллы выше 0,8 обычно считаются хорошим совпадением; ноль или ниже означает отсутствие согласия (практически случайные метки).

Оценка Каппа может быть вычислена для двоичных или многоклассовых задач, но не для задач с несколькими метками (за исключением ручного вычисления оценки для каждой метки) и не более чем для двух аннотаторов.

3.3.2.6. Матрица неточностей ¶

Точность функции confusion_matrix вычисляет классификацию пути вычисления матрицы путаницы с каждой строкой , соответствующей истинный классом (Википедия и другие ссылки могут использовать различные конвенции для осей).

По определению запись i,j в матрице неточностей — количество наблюдений в группе i, но предполагается, что он будет в группе j. Вот пример:

plot_confusion_matrix может использоваться для визуального представления матрицы неточностей, как показано в примере матрицы неточностей, который создает следующий рисунок:

Параметр normalize позволяет сообщать коэффициенты вместо подсчетов. Матрица путаница может быть нормализована в 3 различными способами: ‘pred’ , ‘true’ и ‘all’ которые будут делить счетчики на сумму каждого столбца, строки или всей матрицы, соответственно.

Для двоичных задач мы можем получить подсчет истинно отрицательных, ложноположительных, ложноотрицательных и истинно положительных результатов следующим образом:

- См. В разделе Матрица неточностей пример использования матрицы неточностей для оценки качества выходных данных классификатора.

- См. В разделе Распознавание рукописных цифр пример использования матрицы неточностей для классификации рукописных цифр.

- См. Раздел Классификация текстовых документов с использованием разреженных функций для примера использования матрицы неточностей для классификации текстовых документов.

3.3.2.7. Отчет о классификации

Функция classification_report создает текстовый отчет , показывающий основные показатели классификации. Вот небольшой пример с настраиваемыми target_names и предполагаемыми ярлыками:

- См. В разделе Распознавание рукописных цифр пример использования отчета о классификации рукописных цифр.

- См. Раздел Классификация текстовых документов с использованием разреженных функций, где приведен пример использования отчета о классификации для текстовых документов.

- См. Раздел « Оценка параметров с использованием поиска по сетке с перекрестной проверкой», где приведен пример использования отчета о классификации для поиска по сетке с вложенной перекрестной проверкой.

3.3.2.8. Потеря Хэмминга

hamming_loss вычисляет среднюю потерю Хэмминга или расстояние Хемминга между двумя наборами образцов.

Если $hat_j$ прогнозируемое значение для $j$-я этикетка данного образца, $y_j$ — соответствующее истинное значение, а $n_$ — количество классов или меток, то потеря Хэмминга $L_$ между двумя образцами определяется как:

$$L_(y, hat) = frac<1>> sum_^ — 1> 1(hat_j not= y_j)$$

В многопозиционном корпусе с бинарными индикаторами меток:

В мультиклассовой классификации потери Хэмминга соответствуют расстоянию Хэмминга между y_true и, y_pred что аналогично функции потерь нуля или единицы . Однако, в то время как потеря нуля или единицы наказывает наборы предсказаний, которые не строго соответствуют истинным наборам, потеря Хэмминга наказывает отдельные метки. Таким образом, потеря Хэмминга, ограниченная сверху потерей нуля или единицы, всегда находится между нулем и единицей включительно; и прогнозирование надлежащего подмножества или надмножества истинных меток даст исключительную потерю Хэмминга от нуля до единицы.

3.3.2.9. Точность, отзыв и F-меры

Интуитивно, точность — это способность классификатора не маркировать как положительный образец, который является отрицательным, а отзыв — это способность классификатора находить все положительные образцы.

F-мера ($F_beta$ а также $F_1$ меры) можно интерпретировать как взвешенное гармоническое среднее значение точности и полноты. А $F_beta$ мера достигает своего лучшего значения на уровне 1 и худшего результата на уровне 0. С $beta = 1$, $F_beta$ а также $F_1$ эквивалентны, а отзыв и точность одинаково важны.

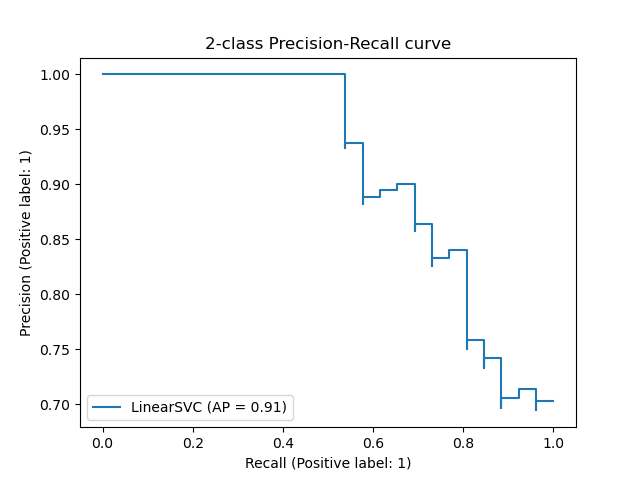

precision_recall_curve вычисляет кривую точности-отзыва на основе наземной метки истинности и оценки, полученной классификатором путем изменения порога принятия решения.

Функция average_precision_score вычисляет среднюю точность (AP) от оценки прогнозирования. Значение от 0 до 1 и выше — лучше. AP определяется как

$$text = sum_n (R_n — R_) P_n$$

где $P_n$ а также $R_n$- точность и отзыв на n-м пороге. При случайных прогнозах AP — это доля положительных образцов.

Ссылки [Manning2008] и [Everingham2010] представляют альтернативные варианты AP, которые интерполируют кривую точности-отзыва. В настоящее время average_precision_score не реализован какой-либо вариант с интерполяцией. Ссылки [Davis2006] и [Flach2015] описывают, почему линейная интерполяция точек на кривой точности-отзыва обеспечивает чрезмерно оптимистичный показатель эффективности классификатора. Эта линейная интерполяция используется при вычислении площади под кривой с помощью правила трапеции в auc .

Несколько функций позволяют анализировать точность, отзыв и оценку F-мер:

| average_precision_score (y_true, y_score, *) | Вычислить среднюю точность (AP) из оценок прогнозов. |

| f1_score (y_true, y_pred, *[, labels, …]) | Вычислите оценку F1, также известную как сбалансированная оценка F или F-мера. |

| fbeta_score (y_true, y_pred, *, beta[, …]) | Вычислите оценку F-beta. |

| precision_recall_curve (y_true, probas_pred, *) | Вычислите пары точности-отзыва для разных пороговых значений вероятности. |

| precision_recall_fscore_support (y_true, …) | Точность вычислений, отзыв, F-мера и поддержка для каждого класса. |

| precision_score (y_true, y_pred, *[, labels, …]) | Вычислите точность. |

| recall_score (y_true, y_pred, *[, labels, …]) | Вычислите рекол. |

Обратите внимание, что функция precision_recall_curve ограничена двоичным регистром. Функция average_precision_score работает только в двоичном формате классификации и MultiLabel индикатора. В функции plot_precision_recall_curve графики точности вспомнить следующим образом .

- См. Раздел Классификация текстовых документов с использованием разреженных функций для примера использования f1_score для классификации текстовых документов.

- См. Раздел « Оценка параметров с использованием поиска по сетке с перекрестной проверкой», где приведен пример precision_score и recall_score использование для оценки параметров с помощью поиска по сетке с вложенной перекрестной проверкой.

- См. В разделе Precision-Recall пример использования precision_recall_curve для оценки качества вывода классификатора.

3.3.2.9.1. Бинарная классификация

В задаче бинарной классификации термины «положительный» и «отрицательный» относятся к предсказанию классификатора, а термины «истинный» и «ложный» относятся к тому, соответствует ли этот прогноз внешнему суждению ( иногда известное как «наблюдение»). Учитывая эти определения, мы можем сформулировать следующую таблицу:

| Фактический класс (наблюдение) | ||

| Прогнозируемый класс (ожидание) | tp (истинно положительный результат) Правильный результат | fp (ложное срабатывание) Неожиданный результат |

| Прогнозируемый класс (ожидание) | fn (ложноотрицательный) Отсутствует результат | tn (истинно отрицательное) Правильное отсутствие результата |

Вот несколько небольших примеров бинарной классификации:

3.3.2.9.2. Мультиклассовая и многозначная классификация

В задаче классификации по нескольким классам и меткам понятия точности, отзыва и F-меры могут применяться к каждой метке независимо. Есть несколько способов , чтобы объединить результаты по этикеткам, указанных в average аргументе к average_precision_score (MultiLabel только) f1_score , fbeta_score , precision_recall_fscore_support , precision_score и recall_score функция, как описано выше . Обратите внимание, что если включены все метки, «микро» -усреднение в настройке мультикласса обеспечит точность, отзыв и $F$ все они идентичны по точности. Также обратите внимание, что «взвешенное» усреднение может дать оценку F, которая не находится между точностью и отзывом.

Чтобы сделать это более явным, рассмотрим следующие обозначения:

- $y$ набор предсказанных ($sample$, $label$) пары

- $hat$ набор истинных ($sample$, $label$) пары

- $L$ набор лейблов

- $S$ набор образцов

- $y_s$ подмножество $y$ с образцом $s$, т.е $y_s := left<(s’, l) in y | s’ = sright>$.

- $y_l$ подмножество $y$ с этикеткой $l$

- по аналогии, $hat_s$ а также $hat_l$ являются подмножествами $hat$

- $P(A, B) := frac<left| A cap B right|><left|Aright|>$ для некоторых наборов $A$ и $B$

- $R(A, B) := frac<left| A cap B right|><left|Bright|>$ (Условные обозначения различаются в зависимости от обращения $B = emptyset$; эта реализация использует $R(A, B):=0$, и аналогичные для $P$.)

- $$F_beta(A, B) := left(1 + beta^2right) frac<beta^2 P(A, B) + R(A, B)>$$

Тогда показатели определяются как:

| average | Точность | Отзывать | F_beta |

| «micro» | $P(y, hat)$ | $R(y, hat)$ | $F_beta(y, hat)$ |

| «samples» | $frac<1> <left|Sright|>sum_ |

$frac<1> <left|Sright|>sum_ |

$frac<1> <left|Sright|>sum_ |

| «macro» | $frac<1> <left|Lright|>sum_ P(y_l, hat_l)$ | $frac<1> <left|Lright|>sum_ R(y_l, hat_l)$ | $frac<1> <left|Lright|>sum_ F_beta(y_l, hat_l)$ |

| «weighted» | $frac<1> <sum_left|hatlright|> sum left|hat_lright| P(y_l, hat_l)$ | $frac<1> <sum_left|hatlright|> sum left|hat_lright| R(y_l, hat_l)$ | $frac<1> <sum_left|hatlright|> sum left|hatlright| Fbeta(y_l, hat_l)$ |

| None | $langle P(y_l, hat_l) | l in L rangle$ | $langle R(y_l, hat_l) | l in L rangle$ | $langle F_beta(y_l, hat_l) | l in L rangle$ |

Для мультиклассовой классификации с «отрицательным классом» можно исключить некоторые метки:

Точно так же метки, отсутствующие в выборке данных, могут учитываться при макро-усреднении.

3.3.2.10. Оценка коэффициента сходства Жаккара

Функция jaccard_score вычисляет среднее значение коэффициентов сходства Jaccard , также называемый индексом Jaccard, между парами множеств меток.

Коэффициент подобия Жаккара i-ые образцы, с набором меток наземной достоверности yi и прогнозируемый набор меток y^i, определяется как

$$J(y_i, hat_i) = frac<|y_i cap hat_i|><|y_i cup hat_i|>.$$

jaccard_score работает как precision_recall_fscore_support наивно установленная мера, применяемая изначально к бинарным целям, и расширена для применения к множественным меткам и мультиклассам за счет использования average (см. выше ).

В двоичном случае:

В многопозиционном корпусе с бинарными индикаторами меток:

Задачи с несколькими классами преобразуются в двоичную форму и обрабатываются как соответствующая задача с несколькими метками:

3.3.2.11. Петля лосс

Функция hinge_loss вычисляет среднее расстояние между моделью и данными с использованием петля лосс, односторонний показателем , который учитывает только ошибки прогнозирования. (Потери на шарнирах используются в классификаторах максимальной маржи, таких как опорные векторные машины.)

Если метки закодированы с помощью +1 и -1, $y$: истинное значение, а $w$ — прогнозируемые решения на выходе decision_function , тогда потери на шарнирах определяются как:

$$L_text(y, w) = maxleft <1 — wy, 0right>= left|1 — wyright|_+$$

Если имеется более двух ярлыков, hinge_loss используется мультиклассовый вариант, разработанный Crammer & Singer. Вот статья, описывающая это.

Если $y_w$ прогнозируемое решение для истинного лейбла и $y_t$ — это максимум предсказанных решений для всех других меток, где предсказанные решения выводятся функцией принятия решений, тогда потеря шарнира в нескольких классах определяется следующим образом:

$$L_text(y_w, y_t) = maxleft<1 + y_t — y_w, 0right>$$

Вот небольшой пример, демонстрирующий использование hinge_loss функции с классификатором svm в задаче двоичного класса:

Вот пример, демонстрирующий использование hinge_loss функции с классификатором svm в мультиклассовой задаче:

3.3.2.12. Лог лосс

Лог лосс, также называемые потерями логистической регрессии или кросс-энтропийными потерями, определяются на основе оценок вероятности. Он обычно используется в (полиномиальной) логистической регрессии и нейронных сетях, а также в некоторых вариантах максимизации ожидания и может использоваться для оценки выходов вероятности ( predict_proba ) классификатора вместо его дискретных прогнозов.

Для двоичной классификации с истинной меткой $y in <0,1>$ и оценка вероятности $p = operatorname(y = 1)$, логарифмическая потеря на выборку представляет собой отрицательную логарифмическую вероятность классификатора с истинной меткой:

$$L_<log>(y, p) = -log operatorname(y|p) = -(y log (p) + (1 — y) log (1 — p))$$

Это распространяется на случай мультикласса следующим образом. Пусть истинные метки для набора выборок будут закодированы размером 1 из K как двоичная индикаторная матрица $Y$, т.е. $y_=1$ если образец $i$ есть ярлык $k$ взят из набора $K$ этикетки. Пусть $P$ — матрица оценок вероятностей, с $p_ = operatorname(y_ = 1)$. Тогда потеря журнала всего набора равна

$$L_<log>(Y, P) = -log operatorname(Y|P) = — frac<1> sum_^ sum_^ y_ log p_$$

Чтобы увидеть, как это обобщает приведенную выше потерю двоичного журнала, обратите внимание, что в двоичном случае $p_ = 1 — p_$ и $y_ = 1 — y_$, поэтому разложив внутреннюю сумму на $y_ in <0,1>$ дает двоичную потерю журнала.

В log_loss функции вычисляет журнал потеря дана список меток приземной истины и матриц вероятностей, возвращенный оценщик predict_proba методом.

Первое [.9, .1] в y_pred означает 90% вероятность того, что первая выборка будет иметь метку 0. Лог лос неотрицательны.

3.3.2.13. Коэффициент корреляции Мэтьюза

Функция matthews_corrcoef вычисляет коэффициент корреляции Матфея (MCC) для двоичных классов. Цитата из Википедии:

«Коэффициент корреляции Мэтьюза используется в машинном обучении как мера качества двоичных (двухклассных) классификаций. Он учитывает истинные и ложные положительные и отрицательные результаты и обычно рассматривается как сбалансированная мера, которую можно использовать, даже если классы очень разных размеров. MCC — это, по сути, значение коэффициента корреляции между -1 и +1. Коэффициент +1 представляет собой идеальное предсказание, 0 — среднее случайное предсказание и -1 — обратное предсказание. Статистика также известна как коэффициент фи ».

В бинарном (двухклассовом) случае $tp$, $tn$, $fp$ а также $fn$ являются соответственно количеством истинно положительных, истинно отрицательных, ложноположительных и ложноотрицательных результатов, MCC определяется как

$$MCC = frac<sqrt<(tp + fp)(tp + fn)(tn + fp)(tn + fn)>>.$$

В случае мультикласса коэффициент корреляции Мэтьюза может быть определен в терминах confusion_matrix C для Kклассы. Чтобы упростить определение, рассмотрим следующие промежуточные переменные:

- $t_k=sum_^ C_$ количество занятий k действительно произошло,

- $p_k=sum_^ C_$ количество занятий k был предсказан,

- $c=sum_^ C_$ общее количество правильно спрогнозированных образцов,

- $s=sum_^ sum_^ C_$ общее количество образцов.

Тогда мультиклассовый MCC определяется как:

$$MCC = frac< c times s — sum_^ p_k times t_k ><sqrt< (s^2 — sum_^ p_k^2) times (s^2 — sum_^ t_k^2) >>$$

Когда имеется более двух меток, значение MCC больше не будет находиться в диапазоне от -1 до +1. Вместо этого минимальное значение будет где-то между -1 и 0 в зависимости от количества и распределения наземных истинных меток. Максимальное значение всегда +1.

Вот небольшой пример, иллюстрирующий использование matthews_corrcoef функции:

3.3.2.14. Матрица путаницы с несколькими метками

Функция multilabel_confusion_matrix вычисляет класс-накрест ( по умолчанию) или samplewise (samplewise = True) MultiLabel матрицы спутанности для оценки точности классификации. Multilabel_confusion_matrix также обрабатывает данные мультикласса, как если бы они были многоклассовыми, поскольку это преобразование, обычно применяемое для оценки проблем мультикласса с метриками двоичной классификации (такими как точность, отзыв и т. д.).

При вычислении классовой матрицы путаницы с несколькими метками $C$, количество истинных негативов для класса i является $C_$, ложноотрицательные $C_$, истинные положительные стороны $C_$ а ложные срабатывания $C_$.

Или можно построить матрицу неточностей для каждой метки образца:

Вот пример, демонстрирующий использование multilabel_confusion_matrix функции с многоклассовым вводом:

Вот несколько примеров, демонстрирующих использование multilabel_confusion_matrix функции для расчета отзыва (или чувствительности), специфичности, количества выпадений и пропусков для каждого класса в задаче с вводом многозначной индикаторной матрицы.

Расчет отзыва (также называемого истинно положительным коэффициентом или чувствительностью) для каждого класса:

Расчет специфичности (также называемой истинно отрицательной ставкой) для каждого класса:

Расчет количества выпадений (также называемый частотой ложных срабатываний) для каждого класса:

Расчет процента промахов (также называемого ложноотрицательным показателем) для каждого класса:

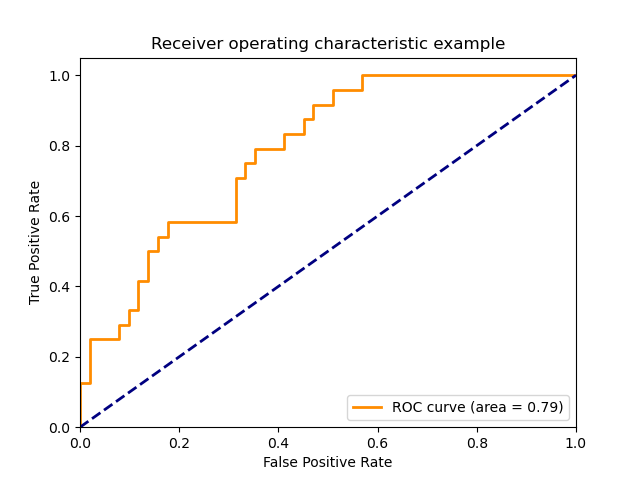

3.3.2.15. Рабочая характеристика приемника (ROC)

«Рабочая характеристика приемника (ROC), или просто кривая ROC, представляет собой графический график, который иллюстрирует работу системы двоичного классификатора при изменении ее порога дискриминации. Он создается путем построения графика доли истинных положительных результатов из положительных (TPR = частота истинных положительных результатов) по сравнению с долей ложных положительных результатов из отрицательных (FPR = частота ложных положительных результатов) при различных настройках пороговых значений. TPR также известен как чувствительность, а FPR — это единица минус специфичность или истинно отрицательный показатель ».

Для этой функции требуется истинное двоичное значение и целевые баллы, которые могут быть либо оценками вероятности положительного класса, либо значениями достоверности, либо двоичными решениями. Вот небольшой пример использования roc_curve функции:

На этом рисунке показан пример такой кривой ROC:

Функция roc_auc_score вычисляет площадь под операционной приемника характеристика (ROC) кривой, которая также обозначается через ППК или AUROC. При вычислении площади под кривой roc информация о кривой суммируется в одном номере. Для получения дополнительной информации см. Статью в Википедии о AUC.

По сравнению с такими показателями, как точность подмножества, потеря Хэмминга или оценка F1, ROC не требует оптимизации порога для каждой метки.

3.3.2.15.1. Двоичный регистр

В двоичном случае вы можете либо предоставить оценки вероятности, используя classifier.predict_proba() метод, либо значения решения без пороговых значений, заданные classifier.decision_function() методом. В случае предоставления оценок вероятности следует указать вероятность класса с «большей меткой». «Большая метка» соответствует classifier.classes_[1] и, следовательно classifier.predict_proba(X) [:, 1]. Следовательно, параметр y_score имеет размер (n_samples,).

Мы можем использовать оценки вероятностей, соответствующие clf.classes_[1] .

В противном случае мы можем использовать значения решения без порога.

3.3.2.15.2. Мультиклассовый кейс

Функция roc_auc_score также может быть использована в нескольких классах классификации . В настоящее время поддерживаются две стратегии усреднения: алгоритм «один против одного» вычисляет среднее попарных оценок AUC ROC, а алгоритм «один против остальных» вычисляет среднее значение оценок ROC AUC для каждого класса по сравнению со всеми другими классами. В обоих случаях предсказанные метки предоставляются в виде массива со значениями от 0 до n_classes , а оценки соответствуют оценкам вероятности того, что выборка принадлежит определенному классу. Алгоритмы OvO и OvR поддерживают равномерное взвешивание ( average=’macro’ ) и по распространенности ( average=’weighted’ ).

Алгоритм «один против одного» : вычисляет средний AUC всех возможных попарных комбинаций классов. [HT2001] определяет метрику AUC мультикласса, взвешенную равномерно:

$$frac<1>sum_^sum_ j>^c (text(j | k) + text(k | j))$$

где $c$ количество классов и $text(j | k)$ AUC с классом $j$ как положительный класс и класс $k$ как отрицательный класс. В общем, $text(j | k) neq text(k | j))$ в случае мультикласса. Этот алгоритм используется, установив аргумент ключевого слова , multiclass чтобы ‘ovo’ и average в ‘macro’ .

[HT2001] мультиклассируют AUC метрика может быть расширена , чтобы быть взвешены по распространенности:

$$frac<1>sum_^sum_ j>^c p(j cup k)( text(j | k) + text(k | j))$$

где cколичество классов. Этот алгоритм используется, установив аргумент ключевого слова , multiclass чтобы ‘ovo’ и average в ‘weighted’ . В ‘weighted’ опции возвращает распространенность усредненные , как описано в [FC2009] .

Алгоритм «один против остальных» : вычисляет AUC каждого класса относительно остальных [PD2000] . Алгоритм функционально такой же, как и в случае с несколькими этикетками. Чтобы включить этот алгоритм, установите для аргумента ключевого слова multiclass значение ‘ovr’ . Как и OvO, OvR поддерживает два типа усреднения: ‘macro’ [F2006] и ‘weighted’ [F2001] .

В приложениях , где высокий процент ложных срабатываний не терпимый параметр max_fpr из roc_auc_score может быть использовано , чтобы суммировать кривую ROC до заданного предела.

3.3.2.15.3. Кейс с несколькими метками

В классификации несколько меток, функция roc_auc_score распространяются путем усреднения меток , как выше . В этом случае вы должны указать y_score форму . Таким образом, при использовании оценок вероятности необходимо выбрать вероятность класса с большей меткой для каждого выхода. (n_samples, n_classes)

И значения решений не требуют такой обработки.

- См. В разделе « Рабочие характеристики приемника» (ROC) пример использования ROC для оценки качества выходных данных классификатора.

- См. В разделе « Рабочие характеристики приемника» (ROC) с перекрестной проверкой пример использования ROC для оценки качества выходных данных классификатора с помощью перекрестной проверки.

- См. В разделе Моделирование распределения видов пример использования ROC для моделирования распределения видов.

- HT2001 ( 1 , 2 ) Рука, DJ и Тилль, RJ, (2001). Простое обобщение области под кривой ROC для задач классификации нескольких классов. Машинное обучение, 45 (2), стр. 171-186.

- FC2009 Ферри, Сезар и Эрнандес-Оралло, Хосе и Модройу, Р. (2009). Экспериментальное сравнение показателей эффективности для классификации. Письма о распознавании образов. 30. 27-38.

- PD2000 Провост Ф., Домингос П. (2000). Хорошо обученные ПЭТ: Улучшение деревьев оценки вероятностей (Раздел 6.2), Рабочий документ CeDER № IS-00-04, Школа бизнеса Стерна, Нью-Йоркский университет.

- F2006 Фосетт, Т., 2006. Введение в анализ ROC. Письма о распознавании образов, 27 (8), стр. 861-874.

- F2001Фосетт, Т., 2001. Использование наборов правил для максимизации производительности ROC в интеллектуальном анализе данных, 2001. Труды Международной конференции IEEE, стр. 131-138.

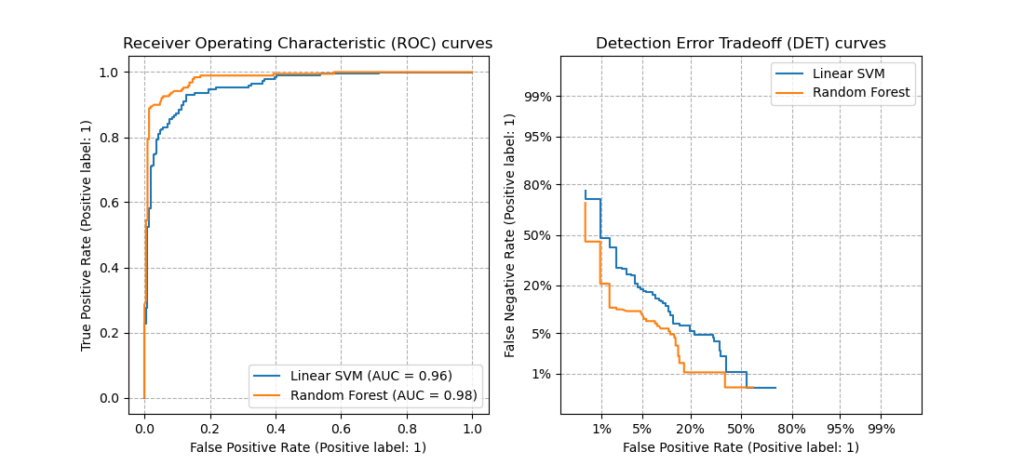

3.3.2.16. Компромисс при обнаружении ошибок (DET)

Функция det_curve вычисляет кривую компенсации ошибок обнаружения (DET) [WikipediaDET2017] . Цитата из Википедии:

«График компромисса ошибок обнаружения (DET) — это графическая диаграмма частоты ошибок для систем двоичной классификации, отображающая частоту ложных отклонений по сравнению с частотой ложных приемов. Оси x и y масштабируются нелинейно по их стандартным нормальным отклонениям (или просто с помощью логарифмического преобразования), в результате получаются более линейные кривые компромисса, чем кривые ROC, и большая часть области изображения используется для выделения важных различий в критический рабочий регион ».

Кривые DET представляют собой вариацию кривых рабочих характеристик приемника (ROC), где ложная отрицательная скорость нанесена на ось y вместо истинной положительной скорости. Кривые DET обычно строятся в масштабе нормального отклонения путем преобразования $phi^<-1>$ (с участием $phi$ — кумулятивная функция распределения). Полученные кривые производительности явно визуализируют компромисс типов ошибок для заданных алгоритмов классификации. См. [Martin1997], где приведены примеры и мотивация.

На этом рисунке сравниваются кривые ROC и DET двух примеров классификаторов для одной и той же задачи классификации:

Характеристики:

- Кривые DET образуют линейную кривую по шкале нормального отклонения, если оценки обнаружения нормально (или близки к нормальному) распределены. В [Navratil2007] было показано, что обратное не обязательно верно, и даже более общие распределения могут давать линейные кривые DET.

- При обычном преобразовании масштаба с отклонением точки распределяются таким образом, что занимает сравнительно большее пространство графика. Следовательно, кривые с аналогичными характеристиками классификации легче различить на графике DET.

- С ложноотрицательной скоростью, «обратной» истинной положительной скорости, точкой совершенства для кривых DET является начало координат (в отличие от верхнего левого угла для кривых ROC).

Приложения и ограничения:

Кривые DET интуитивно понятны для чтения и, следовательно, позволяют быстро визуально оценить работу классификатора. Кроме того, кривые DET можно использовать для анализа пороговых значений и выбора рабочей точки. Это особенно полезно, если требуется сравнение типов ошибок.

С другой стороны, кривые DET не представляют свою метрику в виде единого числа. Поэтому для автоматической оценки или сравнения с другими задачами классификации лучше подходят такие показатели, как производная площадь под кривой ROC.

- См. Кривую компенсации ошибок обнаружения (DET) для примера сравнения кривых рабочих характеристик приемника (ROC) и кривых компенсации ошибок обнаружения (DET).

- ВикипедияDET2017 Авторы Википедии. Компромисс ошибки обнаружения. Википедия, свободная энциклопедия. 4 сентября 2017 г., 23:33 UTC. Доступно по адресу: https://en.wikipedia.org/w/index.php?title=Detection_error_tradeoff&oldid=798982054 . По состоянию на 19 февраля 2018 г.

- Мартин 1997 А. Мартин, Дж. Доддингтон, Т. Камм, М. Ордовски и М. Пшибоцки, Кривая DET в оценке эффективности задач обнаружения , NIST 1997.

- Навратил2007 Дж. Наврактил и Д. Клусачек, « О линейных DET », 2007 г. Международная конференция IEEE по акустике, обработке речи и сигналов — ICASSP ’07, Гонолулу, Гавайи, 2007 г., стр. IV-229-IV-232.

3.3.2.17. Нулевой проигрыш

Функция zero_one_loss вычисляет сумму или среднее значение потери 0-1 классификации ($L_<0−1>$) над $n_$. По умолчанию функция нормализуется по выборке. Чтобы получить сумму $L_<0−1>$, установите normalize значение False .

В классификации по zero_one_loss нескольким меткам подмножество оценивается как единое целое, если его метки строго соответствуют прогнозам, и как ноль, если есть какие-либо ошибки. По умолчанию функция возвращает процент неправильно спрогнозированных подмножеств. Чтобы вместо этого получить количество таких подмножеств, установите normalize значение False

Если $hat_i$ прогнозируемое значение $i$-й образец и $y_i$ — соответствующее истинное значение, тогда потеря 0-1 $L_<0−1>$ определяется как:

$$L_<0-1>(y_i, hat_i) = 1(hat_i not= y_i)$$

В случае с несколькими метками с двоичными индикаторами меток, где первый набор меток [0,1] содержит ошибку:

- См. В разделе « Рекурсивное исключение функции с перекрестной проверкой» пример использования нулевой потери для выполнения рекурсивного исключения функции с перекрестной проверкой.

3.3.2.18. Потеря очков по Брайеру

Функция brier_score_loss вычисляет оценку Шиповник для бинарных классов [Brier1950] . Цитата из Википедии:

«Оценка Бриера — это правильная функция оценки, которая измеряет точность вероятностных прогнозов. Это применимо к задачам, в которых прогнозы должны назначать вероятности набору взаимоисключающих дискретных результатов ».

Эта функция возвращает среднеквадратичную ошибку фактического результата. y∈ <0,1>и прогнозируемая оценка вероятности $p=Pr(y=1)$ ( pred_proba ) как выведено :

$$BS = frac<1>>> sum_^> — 1>(y_i — p_i)^2$$

Потеря по шкале Бриера также составляет от 0 до 1, и чем ниже значение (средняя квадратичная разница меньше), тем точнее прогноз.

Вот небольшой пример использования этой функции:

Балл Бриера можно использовать для оценки того, насколько хорошо откалиброван классификатор. Однако меньшая потеря по шкале Бриера не всегда означает лучшую калибровку. Это связано с тем, что по аналогии с разложением среднеквадратичной ошибки на дисперсию смещения потеря оценки по Бриеру может быть разложена как сумма потерь калибровки и потерь при уточнении [Bella2012]. Потеря калибровки определяется как среднеквадратическое отклонение от эмпирических вероятностей, полученных из наклона ROC-сегментов. Потери при переработке можно определить как ожидаемые оптимальные потери, измеренные по площади под кривой оптимальных затрат. Потери при уточнении могут изменяться независимо от потерь при калибровке, таким образом, более низкие потери по шкале Бриера не обязательно означают более качественную калибровку модели. «Только когда потеря точности остается неизменной, более низкая потеря по шкале Бриера всегда означает лучшую калибровку» [Bella2012] , [Flach2008] .

- См. Раздел « Калибровка вероятности классификаторов», где приведен пример использования потерь по шкале Бриера для выполнения калибровки вероятности классификаторов.

- Brier1950 Дж. Брайер, Проверка прогнозов, выраженных в терминах вероятности , Ежемесячный обзор погоды 78.1 (1950)

- Bella2012 ( 1 , 2 ) Белла, Ферри, Эрнандес-Оралло и Рамирес-Кинтана «Калибровка моделей машинного обучения» в Хосров-Пур, М. «Машинное обучение: концепции, методологии, инструменты и приложения». Херши, Пенсильвания: Справочник по информационным наукам (2012).

- Flach2008 Флак, Питер и Эдсон Мацубара. «О классификации, ранжировании и оценке вероятности». Дагштульский семинар. Schloss Dagstuhl-Leibniz-Zentrum от Informatik (2008).

3.3.3. Метрики ранжирования с несколькими ярлыками

В многоэлементном обучении с каждой выборкой может быть связано любое количество меток истинности. Цель состоит в том, чтобы дать высокие оценки и более высокий рейтинг наземным лейблам.

3.3.3.1. Ошибка покрытия

Функция coverage_error вычисляет среднее число меток , которые должны быть включены в окончательном предсказании таким образом, что все истинные метки предсказанные. Это полезно, если вы хотите знать, сколько меток с наивысшими баллами вам нужно предсказать в среднем, не пропуская ни одной истинной. Таким образом, наилучшее значение этого показателя — среднее количество истинных ярлыков.

Оценка нашей реализации на 1 больше, чем оценка, приведенная в Tsoumakas et al., 2010. Это расширяет ее для обработки вырожденного случая, когда экземпляр имеет 0 истинных меток.

Формально, учитывая двоичную индикаторную матрицу наземных меток истинности $y in left<0, 1right>^ times n_text>$ и оценка, связанная с каждой меткой $hat in mathbb^ times n_text>$ покрытие определяется как

$$coverage(y, hat) = frac<1>>> sum_^> — 1> max_ = 1> text_$$

с участием $text = left|left geq hat_ right>right|$. Учитывая определение ранга, связи y_scores разрываются путем присвоения максимального ранга, который был бы присвоен всем связанным значениям.

Вот небольшой пример использования этой функции:

3.3.3.2. Средняя точность ранжирования метки

В label_ranking_average_precision_score функции реализует маркировать ранжирование средней точности (LRAP). Этот показатель связан с average_precision_score функцией, но основан на понятии ранжирования меток, а не на точности и отзыве.

Средняя точность ранжирования меток (LRAP) усредняет по выборкам ответ на следующий вопрос: для каждой основной метки истинности какая доля меток с более высоким рейтингом была истинной? Этот показатель эффективности будет выше, если вы сможете лучше ранжировать метки, связанные с каждым образцом. Полученная оценка всегда строго больше 0, а наилучшее значение равно 1. Если имеется ровно одна релевантная метка для каждой выборки, средняя точность ранжирования меток эквивалентна среднему обратному рангу .

Формально, учитывая двоичную индикаторную матрицу наземных меток истинности $y in left<0, 1right>^ times n_text>$ и оценка, связанная с каждой меткой $hat in mathbb^ times n_text>$, средняя точность определяется как

$$LRAP(y, hat) = frac<1>>> sum_^> — 1> frac<1> <||y_i||0>sum = 1> frac<|mathcal|><text>$$

где $mathcal = left = 1, hat geq hat right>$, $text = left|left geq hat_ right>right|$, |cdot| вычисляет мощность набора (т. е. количество элементов в наборе), и $||cdot||_0$ это $ell_0$ «Norm» (который вычисляет количество ненулевых элементов в векторе).

Вот небольшой пример использования этой функции:

3.3.3.3. Потеря рейтинга

Функция label_ranking_loss вычисляет ранжирование потери , которые в среднем более образцы числа пар меток, которые неправильно упорядочены, т.е. истинные метки имеют более низкую оценку , чем ложные метки, взвешенную по обратной величине числа упорядоченных пар ложных и истинных меток. Наименьшая возможная потеря рейтинга равна нулю.

Формально, учитывая двоичную индикаторную матрицу наземных меток истинности $y in left<0, 1right>^ times n_text>$ и оценка, связанная с каждой меткой $hat in mathbb^ times n_text>$ потеря ранжирования определяется как

$$ranking_loss(y, hat) = frac<1>>> sum_^> — 1> frac<1> <||y_i||0(ntext— ||y_i||0)> left|left<(k, l): hat leq hat, y = 1, y_ = 0 right>right|$$

где $|cdot|$ вычисляет мощность набора (т. е. количество элементов в наборе) и $||cdot||_0$ это $ell_0$ «Norm» (который вычисляет количество ненулевых элементов в векторе).

Вот небольшой пример использования этой функции:

- Цумакас, Г., Катакис, И., и Влахавас, И. (2010). Майнинг данных с несколькими метками. В справочнике по интеллектуальному анализу данных и открытию знаний (стр. 667-685). Springer США.

3.3.3.4. Нормализованная дисконтированная совокупная прибыль

Дисконтированный совокупный выигрыш (DCG) и Нормализованный дисконтированный совокупный выигрыш (NDCG) — это показатели ранжирования, реализованные в dcg_score и ndcg_score ; они сравнивают предсказанный порядок с оценками достоверности, такими как релевантность ответов на запрос.

Со страницы Википедии о дисконтированной совокупной прибыли:

«Дисконтированная совокупная прибыль (DCG) — это показатель качества ранжирования. При поиске информации он часто используется для измерения эффективности алгоритмов поисковой системы или связанных приложений. Используя шкалу градуированной релевантности документов в наборе результатов поисковой системы, DCG измеряет полезность или выгоду документа на основе его позиции в списке результатов. Прирост накапливается сверху вниз в списке результатов, причем прирост каждого результата дисконтируется на более низких уровнях »

DCG упорядочивает истинные цели (например, релевантность ответов на запросы) в предсказанном порядке, затем умножает их на логарифмическое убывание и суммирует результат. Сумма может быть усечена после первогоKрезультатов, и в этом случае мы называем это DCG @ K. NDCG или NDCG @ $K$ — это DCG, деленная на DCG, полученную с помощью точного прогноза, так что оно всегда находится между 0 и 1. Обычно NDCG предпочтительнее DCG.

По сравнению с потерей ранжирования, NDCG может принимать во внимание оценки релевантности, а не ранжирование на основе фактов. Таким образом, если основополагающая информация состоит только из упорядочивания, предпочтение следует отдавать потере ранжирования; если основополагающая информация состоит из фактических оценок полезности (например, 0 для нерелевантного, 1 для релевантного, 2 для очень актуального), можно использовать NDCG.

Для одного образца, учитывая вектор непрерывных значений истинности для каждой цели $y in R^M$, где $M$ это количество выходов, а прогноз $hat$, что индуцирует функцию ранжирования $f$, оценка DCG составляет

$$sum_^<min(K, M)>frac><log(1 + r)>$$

а оценка NDCG — это оценка DCG, деленная на оценку DCG, полученную для $y$.

- Запись в Википедии о дисконтированной совокупной прибыли

- Джарвелин, К., и Кекалайнен, Дж. (2002). Оценка IR методов на основе накопленного коэффициента усиления. Транзакции ACM в информационных системах (TOIS), 20 (4), 422-446.

- Ван, Ю., Ван, Л., Ли, Ю., Хе, Д., Чен, В., и Лю, Т. Ю. (2013, май). Теоретический анализ показателей рейтинга NDCG. В материалах 26-й ежегодной конференции по теории обучения (COLT 2013)

- МакШерри Ф. и Наджорк М. (2008, март). Эффективность вычислений при поиске информации измеряется эффективно при наличии связанных оценок. В Европейской конференции по поиску информации (стр. 414-421). Шпрингер, Берлин, Гейдельберг.

3.3.4. Метрики регрессии

В sklearn.metrics модуле реализованы несколько функций потерь, оценки и полезности для измерения эффективности регрессии. Некоторые из них были расширены , чтобы обработать случай multioutput: mean_squared_error , mean_absolute_error , explained_variance_score и r2_score .

У этих функций есть multioutput аргумент ключевого слова, который определяет способ усреднения результатов или проигрышей для каждой отдельной цели. По умолчанию используется значение ‘uniform_average’ , которое определяет равномерно взвешенное среднее значение по выходным данным. Если передается ndarray форма shape (n_outputs,) , то ее записи интерпретируются как веса, и возвращается соответствующее средневзвешенное значение. Если multioutput есть ‘raw_values’ указан, то все неизменные индивидуальные баллы или потери будут возвращены в массиве формы (n_outputs,) .

r2_score и explained_variance_score принять дополнительное значение ‘variance_weighted’ для multioutput параметра. Эта опция приводит к взвешиванию каждой индивидуальной оценки по дисперсии соответствующей целевой переменной. Этот параметр определяет количественно зафиксированную немасштабированную дисперсию на глобальном уровне. Если целевые переменные имеют разную шкалу, то этот балл придает большее значение хорошему объяснению переменных с более высокой дисперсией. multioutput=’variance_weighted’ — значение по умолчанию r2_score для обратной совместимости. В будущем это будет изменено на uniform_average .

3.3.4.1. Оценка объясненной дисперсии

Если $hat$ — расчетный целевой объем производства, y соответствующий (правильный) целевой результат, и $Var$- Дисперсия , квадрат стандартного отклонения, то объясненная дисперсия оценивается следующим образом:

$$explained_<>variance(y, hat) = 1 — frac>>>$$

Наилучшая возможная оценка — 1.0, более низкие значения — хуже.

Вот небольшой пример использования explained_variance_score функции:

3.3.4.2. Максимальная ошибка

Функция max_error вычисляет максимальную остаточную ошибку , показатель , который фиксирует худшую ошибку случае между предсказанным значением и истинным значением. В идеально подобранной модели регрессии с одним выходом он max_error будет находиться 0 в обучающем наборе, и хотя это маловероятно в реальном мире, этот показатель показывает степень ошибки, которую имела модель при подборе.

Если $hat_i$ прогнозируемое значение $i$-й образец, и $y_i$ — соответствующее истинное значение, тогда максимальная ошибка определяется как

$$text(y, hat) = max(| y_i — hat_i |)$$

Вот небольшой пример использования функции max_error :

max_error не поддерживает multioutput.

3.3.4.3. Средняя абсолютная ошибка

Функция mean_absolute_error вычисляет среднюю абсолютную погрешность , риск метрики , соответствующей ожидаемого значение абсолютной потери или ошибок $l1$-нормальная потеря.

Если $hat_i$ прогнозируемое значение $i$-й образец, и $y_i$ — соответствующее истинное значение, тогда средняя абсолютная ошибка (MAE), оцененная за $n_$ определяется как

$$text(y, hat) = frac<1>>> sum_^>-1> left| y_i — hat_i right|.$$

Вот небольшой пример использования функции mean_absolute_error :

3.3.4.4. Среднеквадратичная ошибка

Функция mean_squared_error вычисляет среднюю квадратическую ошибку , риск метрики , соответствующую ожидаемое значение квадрата (квадратичной) ошибки или потерю.

Если $hat_i$ прогнозируемое значение $i$-й образец, и $y_i$ — соответствующее истинное значение, тогда среднеквадратичная ошибка (MSE), оцененная на $n_$ определяется как

$$text(y, hat) = frac<1>> sum_^ — 1> (y_i — hat_i)^2.$$

Вот небольшой пример использования функции mean_squared_error :

- См. В разделе Регрессия повышения градиента пример использования среднеквадратичной ошибки для оценки регрессии повышения градиента.

3.3.4.5. Среднеквадратичная логарифмическая ошибка

Функция mean_squared_log_error вычисляет риск метрики , соответствующий ожидаемому значению квадрата логарифмической (квадратичной) ошибки или потери.

Если $hat_i$ прогнозируемое значение $i$-й образец, и $y_i$ — соответствующее истинное значение, тогда среднеквадратичная логарифмическая ошибка (MSLE), оцененная на $n_$ определяется как

$$text(y, hat) = frac<1>> sum_^ — 1> (log_e (1 + y_i) — log_e (1 + hat_i) )^2.$$

Где $log_e (x)$ означает натуральный логарифм $x$. Эту метрику лучше всего использовать, когда цели имеют экспоненциальный рост, например, численность населения, средние продажи товара в течение нескольких лет и т. Д. Обратите внимание, что эта метрика штрафует за заниженную оценку больше, чем за завышенную оценку.

Вот небольшой пример использования функции mean_squared_log_error :

3.3.4.6. Средняя абсолютная ошибка в процентах

mean_absolute_percentage_error (MAPE), также известный как среднее абсолютное отклонение в процентах (МАПД), является метрикой для оценки проблем регрессии. Идея этой метрики — быть чувствительной к относительным ошибкам. Например, он не изменяется глобальным масштабированием целевой переменной.

Если $hat_i$ прогнозируемое значение $i$-й образец и $y_i$ — соответствующее истинное значение, тогда средняя абсолютная процентная ошибка (MAPE), оцененная за $n_$ определяется как

$$text(y, hat) = frac<1>>> sum_^>-1> frac<<>left| y_i — hat_i right|>$$

где $epsilon$ — произвольное маленькое, но строго положительное число, чтобы избежать неопределенных результатов, когда y равно нулю.

Вот небольшой пример использования функции mean_absolute_percentage_error :

В приведенном выше примере, если бы мы использовали mean_absolute_error , он бы проигнорировал небольшие значения магнитуды и только отразил бы ошибку в предсказании максимального значения магнитуды. Но эта проблема решена в случае MAPE, потому что он вычисляет относительную процентную ошибку по отношению к фактическому выходу.

3.3.4.7. Средняя абсолютная ошибка

Это median_absolute_error особенно интересно, потому что оно устойчиво к выбросам. Убыток рассчитывается путем взятия медианы всех абсолютных различий между целью и прогнозом.

Если $hat_i$ прогнозируемое значение $i$-й образец и $y_i$ — соответствующее истинное значение, тогда средняя абсолютная ошибка (MedAE), оцененная на $n_$ определяется как

$$text(y, hat) = text(mid y_1 — hat_1 mid, ldots, mid y_n — hat_n mid).$$

median_absolute_error Не поддерживает multioutput.

Вот небольшой пример использования функции median_absolute_error :

3.3.4.8. R² балл, коэффициент детерминации

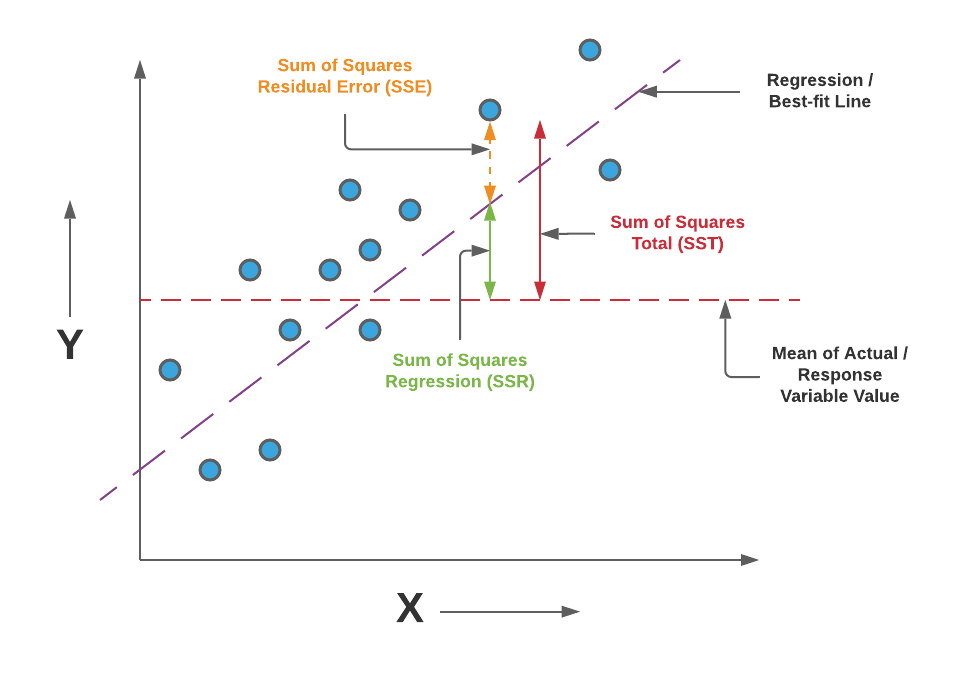

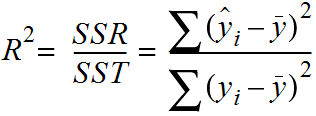

Функция r2_score вычисляет коэффициент детерминации , как правило , обозначенный как R².

Он представляет собой долю дисперсии (y), которая была объяснена независимыми переменными в модели. Он обеспечивает показатель степени соответствия и, следовательно, меру того, насколько хорошо невидимые выборки могут быть предсказаны моделью через долю объясненной дисперсии.

Поскольку такая дисперсия зависит от набора данных, R² не может быть значимо сопоставимым для разных наборов данных. Наилучшая возможная оценка — 1,0, и она может быть отрицательной (потому что модель может быть произвольно хуже). Постоянная модель, которая всегда предсказывает ожидаемое значение y, игнорируя входные характеристики, получит оценку R² 0,0.

Если $hat_i$ прогнозируемое значение $i$-й образец и $y_i$ соответствующее истинное значение для общего n образцов, расчетный R² определяется как:

$$R^2(y, hat) = 1 — frac<sum_^ (y_i — hati)^2><sum^ (y_i — bar)^2>$$

где $bar = frac<1> sum_^ y_i$ и $sum_^ (y_i — hati)^2 = sum^ epsilon_i^2$.

Обратите внимание, что r2_score вычисляется нескорректированное R² без поправки на смещение выборочной дисперсии y.

Вот небольшой пример использования функции r2_score :

- См. В разделе « Лассо и эластичная сеть для разреженных сигналов» приведен пример использования показателя R² для оценки лассо и эластичной сети для разреженных сигналов.

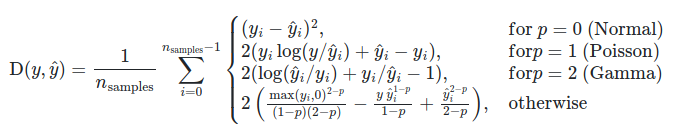

3.3.4.9. Средние отклонения Пуассона, Гаммы и Твиди

Функция mean_tweedie_deviance вычисляет среднюю ошибку Deviance Tweedie с power параметром ($p$). Это показатель, который выявляет прогнозируемые ожидаемые значения целей регрессии.

Существуют следующие особые случаи:

- когда power=0 это эквивалентно mean_squared_error .

- когда power=1 это эквивалентно mean_poisson_deviance .

- когда power=2 это эквивалентно mean_gamma_deviance .

Если $hat_i$ прогнозируемое значение $i$-й образец и $y_i$ — соответствующее истинное значение, тогда средняя ошибка отклонения Твиди (D) для мощности $p$, оценивается более $n_$ определяется как

Отклонение от твиди — однородная функция степени 2-power . Таким образом, гамма-распределение power=2 означает, что одновременно масштабируется y_true и y_pred не влияет на отклонение. Для распределения Пуассона power=1 отклонение масштабируется линейно, а для нормального распределения ( power=0 ) — квадратично. В общем, чем выше, power тем меньше веса придается крайним отклонениям между истинными и прогнозируемыми целевыми значениями.

Например, давайте сравним два прогноза 1.0 и 100, которые оба составляют 50% от их соответствующего истинного значения.

Среднеквадратичная ошибка ( power=0 ) очень чувствительна к разнице прогнозов второй точки:

Если увеличить power до 1:

разница в ошибках уменьшается. Наконец, установив power=2 :