In this article, we demonstrate 3 ways to calculate the Normalized Mean Absolute Error in R.

Although the Normalized Mean Absolute Error (NMAE), or Coefficient of Variance of the MAE, is not used very frequently, it still is a useful metric. The NMAE normalizes the Mean Absolute Error (MAE) which is especially convenient when you want to compare the MAE of models with different scales.

But, how do you calculate the Normalized Mean Absolute Error (NMAE) in R?

The easiest way to calculate the Normalized Mean Absolute Error is a two-step process. First, you calculate the Mean Absolute Error, for example with the MAE() function. Then, you use a normalization method such as the average, range, or interquartile range, to find the Normalized Mean Absolute Error (NMAE).

In this article, we discuss all 3 methods to normalize the Mean Absolute Error with R code and examples.

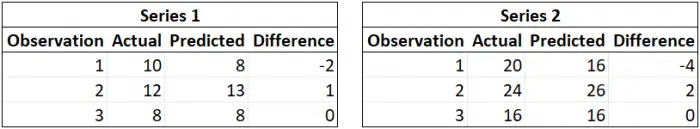

As mentioned before, the Normalized Mean Absolute Error (NMAE) is a validation metric to compare the Mean Absolute Error (MAE) of (time) series with different scales.

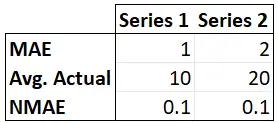

For example, in the situation below, we have 2 series with a different Mean Absolute Error. Therefore, one could conclude that the second model performs worse. However, since the scales of the series differ, the Normalized Mean Absolute Error is the same.

In the example above, we used the mean of the actual values to normalize the MAE. However, there isn’t one clear definition of the NMAE. Instead, there are 3 commonly used definitions.

1. Normalization of the Mean Absolute Error with the Mean

The most common way to normalize the Mean Absolute Error is by using the mean of the actual values as the denominator.

2. Normalization of the Mean Absolute Error with the Range

Another frequently used definition of the Normalized Mean Absolute Error is by dividing the MAE by the range of actual value.

3. Normalization of the Mean Absolute Error with the Interquartile Range

Lastly, you can also use the interquartile range to normalize the Mean Absolute Error.

It depends on your situation which definition you should use. Please, check this article for more information about how to calculate the Mean Absolute Error (MAE).

3 Easy Ways to Calculate the Normalized Mean Absolute Error

Before we show how to calculate the Normalized Mean Absolute Error using the 3 definitions, we first create two vectors with random numbers. These vectors will represent the actual values and predicted values in our examples.

We use the SAMPLE.INT() function to create these vectors of random numbers.

set.seed(123)

y <- sample.int(100, 100, replace = TRUE)

y

set.seed(321)

y_hat <- sample.int(100, 100, replace = TRUE)

y_hatIn the examples below, we will use the MAE() function from the Metrics package to find the Mean Absolute Error before any normalization. However, if your data contains missing values, we recommend using the MAE() function from the ie2misc package.

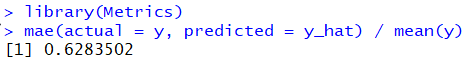

1. Calculate the Normalized Mean Absolute Error with the Mean

As mentioned before, calculating the Normalized Mean Absolute Error in R is mostly done by dividing the Mean Absolute Error by the mean. You can use the MAE() function and the MEAN() function to find the Mean Absolute Error and Mean of the actual values, respectively.

Example

library(Metrics)

mae(actual = y, predicted = y_hat) / mean(y)

2. Calculate the Normalized Mean Absolute Error with the Range

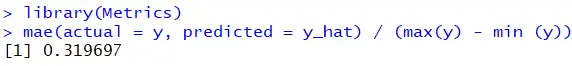

The second way to calculate the NMAE in R is by dividing the Mean Absolute Error by the range of actual values. In others, the difference between the highest and lowest actual value.

If you want to use this definition, you can find the Normalized Mean Absolute Error using the functions MAE(), MAX(), and MIN().

Example

library(Metrics)

mae(actual = y, predicted = y_hat) / (max(y) - min (y))

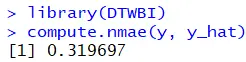

Alternatively, you could install the DTWBI package and use the COMPUTE.NMAE() function. This function requires two parameters, namely the actual values and the predicted value, and returns the Normalized Mean Absolute Error.

Example

library(DTWBI)

compute.nmae(y, y_hat)

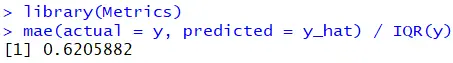

3. Calculate the Normalized Mean Absolute Error with the Interquartile Range

Lastly, you can normalize the Mean Absolute Error with the interquartile range. In other words, the difference between the 75th and 25th percentiles of your actual data. You can find the interquartile range in R with the IQR() function.

Example

library(Metrics)

mae(actual = y, predicted = y_hat) / IQR(y)

From Wikipedia, the free encyclopedia

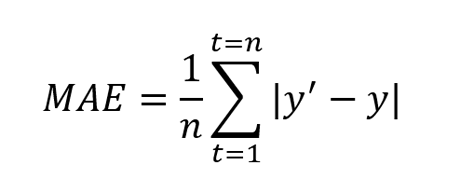

In statistics, mean absolute error (MAE) is a measure of errors between paired observations expressing the same phenomenon. Examples of Y versus X include comparisons of predicted versus observed, subsequent time versus initial time, and one technique of measurement versus an alternative technique of measurement. MAE is calculated as the sum of absolute errors divided by the sample size:[1]

It is thus an arithmetic average of the absolute errors

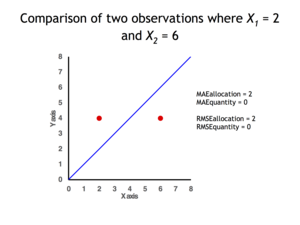

Quantity disagreement and allocation disagreement[edit]

2 data points for which Quantity Disagreement is 0 and Allocation Disagreement is 2 for both MAE and RMSE

It is possible to express MAE as the sum of two components: Quantity Disagreement and Allocation Disagreement. Quantity Disagreement is the absolute value of the Mean Error given by:[4]

Allocation Disagreement is MAE minus Quantity Disagreement.

It is also possible to identify the types of difference by looking at an

[edit]

The mean absolute error is one of a number of ways of comparing forecasts with their eventual outcomes. Well-established alternatives are the mean absolute scaled error (MASE) and the mean squared error. These all summarize performance in ways that disregard the direction of over- or under- prediction; a measure that does place emphasis on this is the mean signed difference.

Where a prediction model is to be fitted using a selected performance measure, in the sense that the least squares approach is related to the mean squared error, the equivalent for mean absolute error is least absolute deviations.

MAE is not identical to root-mean square error (RMSE), although some researchers report and interpret it that way. MAE is conceptually simpler and also easier to interpret than RMSE: it is simply the average absolute vertical or horizontal distance between each point in a scatter plot and the Y=X line. In other words, MAE is the average absolute difference between X and Y. Furthermore, each error contributes to MAE in proportion to the absolute value of the error. This is in contrast to RMSE which involves squaring the differences, so that a few large differences will increase the RMSE to a greater degree than the MAE.[4] See the example above for an illustration of these differences.

Optimality property[edit]

The mean absolute error of a real variable c with respect to the random variable X is

Provided that the probability distribution of X is such that the above expectation exists, then m is a median of X if and only if m is a minimizer of the mean absolute error with respect to X.[6] In particular, m is a sample median if and only if m minimizes the arithmetic mean of the absolute deviations.[7]

More generally, a median is defined as a minimum of

as discussed at Multivariate median (and specifically at Spatial median).

This optimization-based definition of the median is useful in statistical data-analysis, for example, in k-medians clustering.

Proof of optimality[edit]

Statement: The classifier minimising

Proof:

The Loss functions for classification is

Differentiating with respect to a gives

This means

Hence

See also[edit]

- Least absolute deviations

- Mean absolute percentage error

- Mean percentage error

- Symmetric mean absolute percentage error

References[edit]

- ^ Willmott, Cort J.; Matsuura, Kenji (December 19, 2005). «Advantages of the mean absolute error (MAE) over the root mean square error (RMSE) in assessing average model performance». Climate Research. 30: 79–82. doi:10.3354/cr030079.

- ^ «2.5 Evaluating forecast accuracy | OTexts». www.otexts.org. Retrieved 2016-05-18.

- ^ Hyndman, R. and Koehler A. (2005). «Another look at measures of forecast accuracy» [1]

- ^ a b c Pontius Jr., Robert Gilmore; Thontteh, Olufunmilayo; Chen, Hao (2008). «Components of information for multiple resolution comparison between maps that share a real variable». Environmental and Ecological Statistics. 15 (2): 111–142. doi:10.1007/s10651-007-0043-y. S2CID 21427573.

- ^ Willmott, C. J.; Matsuura, K. (January 2006). «On the use of dimensioned measures of error to evaluate the performance of spatial interpolators». International Journal of Geographical Information Science. 20: 89–102. doi:10.1080/13658810500286976. S2CID 15407960.

- ^ Stroock, Daniel (2011). Probability Theory. Cambridge University Press. pp. 43. ISBN 978-0-521-13250-3.

- ^ Nicolas, André (2012-02-25). «The Median Minimizes the Sum of Absolute Deviations (The $ {L}_{1} $ Norm)». StackExchange.

Anomaly detection

Patrick Schneider, Fatos Xhafa, in Anomaly Detection and Complex Event Processing over IoT Data Streams, 2022

Mean Absolute Error (MAE)

Mean absolute error (MAE) is a popular metric because, as with Root mean squared error (RMSE), see next subsection, the error value units match the predicted target value units. Unlike RMSE, the changes in MAE are linear and therefore intuitive. MSE and RMSE penalize larger errors more, inflating or increasing the mean error value due to the square of the error value. In MAE, different errors are not weighted more or less, but the scores increase linearly with the increase in errors. The MAE score is measured as the average of the absolute error values. The Absolute is a mathematical function that makes a number positive. Therefore, the difference between an expected value and a predicted value can be positive or negative and will necessarily be positive when calculating the MAE.

The MAE value can be calculated as follows:

(3.3)MAE=1n∑i=1n|y1−yiˆ|2

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/B9780128238189000134

Characterization of forecast errors and benchmarking of renewable energy forecasts

Stefano Alessandrini, Simone Sperati, in Renewable Energy Forecasting, 2017

9.2.2.6 Golagh test case (Fig. 9.6)

Figure 9.6. Normalized mean absolute error (NMAE) for Golagh test case by Kariniotakis et al. (2004).

The NMAE values for the Golagh wind farm are less dependent on the forecast horizon than for the other wind farms. The range of variation of NMAE for 24 h horizon is 10%–16%, being comparable for longer forecast horizons.

The main evident conclusion coming out from these test cases is the strong dependence of predictability upon the terrain complexity. The performance of the prediction models is related to the complexity of the terrain. Fig. 9.7 represents the average value of the NMAE for the 12 h forecast horizon as a function of RIX index, for each test case.

Figure 9.7. Average normalized mean absolute error (NMAE) for 12 h forecast horizon versus RIX at each test case. Qualitative comparison over six wind farms: Tunø Knob (TUN), Klim (KLI), Wusterhusen (WUS), Sotavento (SOT), Golagh (GOL), Alaiz (ALA) by Kariniotakis et al. (2004).

Higher RIX values correspond to higher values of NMAE. It is also demonstrated that offshore wind farms (Tunø Knob) do not necessarily guarantee a better predictability than wind farms on flat terrain in similar climatic conditions.

Different performances between test cases could also be attributed to the use of different prediction models. In fact, the NWP used in the test case has been provided by the meteorological services of the different countries (Germany, Spain, Denmark, and Ireland). However, some of the cases, Alaiz and Sotavento, have the NWP obtained with the same model and the increase of NMAE with RIX still appears.

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/B9780081005040000093

Validation methodologies

Ranadip Pal, in Predictive Modeling of Drug Sensitivity, 2017

4.2.1 Norm-Based Fitness Measures

MAE denotes the ratio of the 1 norm of the error vector Y−Y~ to the number of samples and is defined as

(4.1)MAE=1n∑i=1n|yi−y~i|

Mean bias error (MBE) captures the average bias in the prediction and is calculated as

(4.2)MBE=1n∑i=1n(y~i−yi)

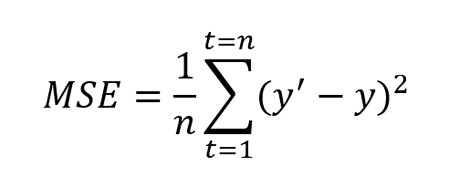

MSE denotes the ratio of the square of the two norms of the error vector to the number of samples and is defined as

(4.3)MSE=1n∑i=1n(yi−y~i)2

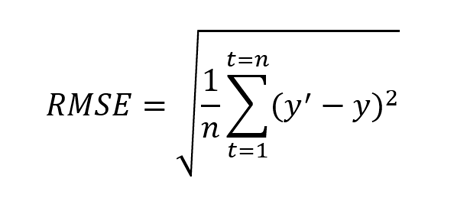

Root mean square error (RMSE) denotes the square root of the MSE.

The MBE is usually not used as a measure of the model error as high individual errors in prediction can also produce a low MBE. MBE is primarily used to estimate the average bias in the model and to decide if any steps need to be taken to correct the model bias. The MBE, MAE, and RMSE are related by the following inequalities: MBE≤MAE≤RMSE≤nMAE. If any subsequent theoretical analysis is conducted on the error measure, MSE or RMSE is often preferred, as compared to MAE due to the ease of applying derivatives and other analytical measures. However, studies [2] have pointed out that RMSE is an inappropriate measure for average model performance, as it is a function of three characteristics: the variability in the error distribution, the square root of the number of error samples, and the average error magnitude (MAE). Due to the squaring portion of RMSE, larger errors will have more impact on the MSE than smaller errors. Furthermore, the upper limit of RMSE (MAE≤RMSE≤nMAE) varies with n and can have different interpretations for different sample sizes.

Note that the above measures will have the same units as the variable to be predicted and thus cannot be compared for different variables that are scaled differently. The normalization of the error can be handled either as normalized versions described next or using measures such as correlation coefficients and R2.

NRMSE as used in [3] is defined as

(4.4)NRMSE=∑i=1n(yi−y~i)2∑i=1n(yi−y-)2

or it can be defined as ratio of the RMSE to the range of the data or mean of the data.

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/B978012805274700004X

Renewable energy system for industrial internet of things model using fusion-AI

Anand Singh Rajawat, … Ankush Ghosh, in Applications of AI and IOT in Renewable Energy, 2022

6.6 Results analysis

We evaluate different AI algorithms on different IIoT based datasets. Dissimilar assessment metrics were used to examine the goodness of the AI-based model, such as mean absolute error, mean absolute percent error, mean squared error, and root mean squared logarithmic error. We similarly selected the state-of-the-art models for the assessment through the proposed Fusion AI-based model.

6.6.1 Mean absolute error

The mean absolute error (MAE) characterizes the alteration among the original and predictable values and is mined as the dataset’s total alteration mean.

MAE=1n∑i=1n|Yi−Yiˆ|

6.6.2 Mean squared error

The mean squared error (MSE) is the alteration between the original value and the predictable value. It is mined by forming the mean formed error of the dataset.

MSE=1n∑i=1n(Yi−Yiˆ)2

6.6.3 Root mean squared logarithmic error

The root mean squared logarithmic error (RMSLE).

RMSLE=1n∑i=1n(log(yiˆ+1)−log(yi+1))2

6.6.4 Mean absolute percent error

The mean absolute percent error (MAPE) is theamount of the accuracy of a prediction. It measures the size of the error (Fig. 6.5; Table 6.1).

Figure 6.5. Comparative analysis in term of accuracy.

Table 6.1. Evaluation metrics.

| Model name | MAE | MSE | Root mean square error | RMSLE |

|---|---|---|---|---|

| Support Vector Machines(SVM) | 45.6755 | 1176.765 | 65.6675 | 0.1487659 |

| Recurrent Neural Network(RNN) | 28.9875 | 765.345 | 32.7657 | 0.701233 |

| Long Short-term Memory(LSTM) | 26.7865 | 657.765 | 30.6754 | 0.645361 |

| Fusion Artificial Intelligence | 14.564 | 352.6785 | 19.5643 | 0.023456 |

MAPE=∑|A−F|A×100N

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/B9780323916998000061

Model development and validation methodology

Yen-Hsiung Kiang, in Fuel Property Estimation and Combustion Process Characterization, 2018

2.9.1 The Use of Mean Absolute Percentage Error/Mean Bias Percentage Error and Mean Absolute Error/Mean Bias Error

In this book, the MAPE/MBPE and MAE/MPE are used selectively. The complete data population is used in the validation analyses.

For the MAE/MBE and MAPE/MBPE methods, there are basic selection criteria.

- 1.

-

If the value of data is large, e.g., higher heating values ranging from 1000 to 10,000, the use of MAPE/MBPE method is a better choice. The reason is that the value of MAE/MBE may be too big and lead to confusion. For example, for a data value of 10,000, the value for MAE is 500 and the corresponding value for MAPE is 5%, which is within good engineering tolerance. However, if the absolute value of 500 is used, it is quite large in an absolute sense and just leads to confusion.

- 2.

-

If the absolute value of data is small (e.g., the chlorine content in the fuels) ranging from 0.1% to 2%, MAPE/MBPE methods should not be used. MAE/MBE methods are to be used to avoid confusion. The reason is that when the real concentration of chlorine in the fuel is 0.3%, if the estimated value is 0.6%, in practical engineering point of view, the estimated value is good enough for the applications. However, when using MAPE method, the value of MAPE is 100%. This greatly enlarges the significance of error. Thus the MAPE/MBPE methods are not recommended in these cases.

- 3.

-

In this book, the following definitions are used. The “deviation” or “% deviation” means the percentage difference from the absolute data value. And, “difference” is the difference of absolute values. For example, for an absolute value of 50, the deviation of ±5% means the range is between 50+5% and 50–5%, or, between absolute values of 47.5 and 52.5. However, the difference of 5 means the range is between 50–5 and 50+5, or between absolute values of 45 and 55.

- 4.

-

In this book, both MAE and MBE as well as MAPE and MBPE are used for the validations of higher heating values. MAE and MBE are only used for the validations of concentrations of carbon, nitrogen, oxygen, nitrogen, sulfur, and chlorine.

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/B9780128134733000027

Forecasting of renewable generation for applications in smart grid power systems

Debesh Shankar Tripathy, B. Rajanarayan Prusty, in Advances in Smart Grid Power System, 2021

2.5 Forecast evaluation

Before utilizing forecasts for any real-life applications, they must be evaluated and analyzed based on the type of forecast. Two essential things to keep in mind are the quality of the forecasts to accurately present future realizations by proper modeling of the process, and the value of the forecast derived by using them for decision-making [14]. The quality of forecasts is assessed quantitatively by validating them over a period whose data has not been used for building (identifying and learning/training) the model.

2.5.1 Evaluating point forecasts

Point forecasts are widely assessed by calculating the forecast error via the use of different error measures. The most popular error measures are root mean square error (RMSE) and mean absolute error (MAE), which are discussed below. Apart from these, a variety of other error measures are available: mean square error, mean bias error, mean absolute percentage error, etc.

2.5.1.1 Root mean square error

The RMSE between the ith observation, Yi, and the corresponding forecast Yˆi for n forecast instants is given as

(10.2)RMSE=1n∑i=1n(Yi−Yˆi)2.

2.5.1.2 Mean absolute error

MAE is given as

(10.3)MAE=1n∑i=1n|Yi−Yˆi|.

In Eq. (10.3), the terms have the same meanings as in Eq. (10.2).

Note: RMSE and MAE are used to assess point forecasts but also can be extended to the probabilistic framework by replacing the point forecast with a quantile forecast to get the error measure for the corresponding quantile. Then the errors across different quantiles can be averaged to get a single value.

2.5.2 Evaluating probabilistic forecasts

Probabilistic forecasts, such as quantile, interval, and density forecasts, have different measures for evaluating their quality. Quantile forecasts can be assessed by the quantile score (QS) [12], which uses the PL function to differentially weigh the quantiles. Measures to evaluate the interval forecast include the Winkler score (WS) [12], prediction interval coverage probability (PICP) [15], and prediction interval normalized average width (PINAW) [15], which assess coverage and interval widths. Continuous ranked probability score (CRPS) [15] is the most widely used measure to determine the reliability and sharpness of density forecasts.

2.5.2.1 Quantile score

The QS uses the PL as a measure for the error in quantile forecasts. The PL function is defined as

(10.4)PL(Yi,Yˆi,τ,τundefined)={(1−τ)(Yˆi,τ−Yi)ifYi<Yˆi,ττ(Yi−Yˆi,τ)if Yi≥Yˆi,τ.undefined

In Eq. (10.4), Yi is the ith observation, and Yˆi,τ is the τth quantile forecast of the ith observation. The QS is the average PL across the nq predicted quantiles across the forecast horizon n and is given as

(10.5)QS=1nnq∑i=1n∑undefinedj=1nqPL(Yi,Yˆi,τ,τundefined).undefined

In Eq. (10.5), j is an index variable that represents the number of the quantile forecast. A lower score indicates a better prediction of the quantiles. The QS helps to assess both the reliability and sharpness of the quantile forecasts.

2.5.2.2 Winkler score

The WS is used to assess the accuracy of the coverage as well as the interval width for the PIs. For a PI centered at the median with (1−α)100% nominal coverage, this score is defined as the mean across the forecast horizon of

(10.6)WS={ΔiifLi≤Yi≤UiΔi+2(Li−Yi)/αifYi<LiΔi+2(Yi−Ui)/αifYi>Ui.undefined

In Eq. (10.6), Li is the lower-bound quantile, Ui is the upper-bound quantile, and Δi=Ui−Li is the interval width for the ith observation. It penalizes observations for lying outside the PI and rewards narrower interval widths. Hence, a lower WS is an indication of a better PI.

2.5.2.3 Prediction interval coverage probability

The PICP helps to ensure whether the observed probability distribution is bounded within the PI. The PICP index is calculated by counting the fraction of the number of observations lying within the forecast PI. It is mathematically represented as

(10.7)PICP=1n∑i=1nɛi,

where ɛi is defined as

(10.8)ɛi={1ifYi∈[Li,Ui]0ifYi∉[Li,Ui].

In Eqs. (10.7) and (10.8), the terms have their usual meaning as defined earlier. A higher PICP is desirable, as it indicates that more observations lie within the constructed PI. PICP quantitatively expresses reliability. A valid PICP should always be greater than the nominal confidence level.

2.5.2.4 Prediction interval normalized average width

The sole use of PICP can sometimes be misleading due to concentrating only on coverage of the PIs. The widths of PIs also play a significant role in assessing their informativeness. The quantitative expression of PI width is provided by the PINAW, which is given below:

(10.9)PINAW=1nR∑i=1nΔi.undefined

In Eq. (10.9), Δi is the interval width as in Eq. (10.6), and R is the normalizing factor given by the difference between the maximum and minimum forecast values. Hence, combined use of PICP and PINAW is required for proper evaluation of PIs.

2.5.2.5 Continuous ranked probability score

The CRPS robustly measures the reliability and sharpness of the probabilistic forecast. It is analogous to the MAE for point forecasts because it reduces to the absolute error for the point forecasts, hence allowing comparison of probabilistic and point forecasts. Since it is a measure of the absolute error of the forecast distribution, a lower CRPS is preferable. It considers the entire distribution of the forecasts contrary to QS, which uses the PL to weigh the different quantiles asymmetrically. It can be expressed as below:

(10.10)CRPS(F,y)=∫−∞∞(F(u)−I{y≤u})2du=EF|Y−y|−12EF|Y−Y’|undefined}.

In Eq. (10.10), y is the observation, F(u) is the CDF of density forecasts, I is the Heaviside step function, and Y and Y′ are two random variables with F as the distribution function.

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/B9780128243374000102

Intelligence-Based Health Recommendation System Using Big Data Analytics

Abhaya Kumar Sahoo, … Himansu Das, in Big Data Analytics for Intelligent Healthcare Management, 2019

9.4.2 Experimental Result Analysis

Here we compare the results in terms of MAE value among existing methods and the proposed HRS by analyzing the healthcare dataset. As we obtained a lower MAE value for our proposed approach, we can say that our approach is a useful healthcare recommendation system.

In Table 9.3, MAE values are shown for the healthcare dataset where 10,000 patient ratings for 500 doctors are divided among 5 parties. Here p represents a number of parties collaborating, which varies from 1 to 5 where p = 1 meaning that there is no collaboration and all parties are generating predictions individually. The p = 2 signifies that two parties are collaborating and likewise for p = 3, 4, or 5. Fig. 9.7 depicts that MAE value is lower when all parties are collaborating, that is, p = 5. The lower the MAE value, the higher the accuracy. By using a collaborative-based filtering technique on the proposed HRS, we achieve lower MAE values and high accuracy when compared to existing approaches.

Table 9.3. Comparison Among Existing Approaches and Proposed HRS

| Contribution | Average MAE Values (Patients) | Average MAE Values (Doctors) |

|---|---|---|

| Yakut and Polat | 0.724 | 0.795 |

| Kaur et al. | 0.739 | 0.807 |

| Proposed HRS | 0.649 | 0.717 |

Fig. 9.7. Shows comparison among MAE and number of parties of proposed HRS.

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/B978012818146100009X

Meta-Model Development

Bouzid Ait-Amir, … Abdelkhalak El Hami, in Embedded Mechatronic Systems 2 (Second Edition), 2020

6.5.3 Model comparison and validation

Once a model is built, the next step is validation. To choose one model or another two properties of the response surface are assessed as to their ability to match the experimental data and make predictions.

Certain mathematical criteria make it possible to test how the model results match the data. This is performed by the coefficient of determination R2, the adjusted R2 coefficient, or the study of the residues, etc.

The determination coefficient R2, which is the criterion generally used in linear regression to test how the model matches the data, is defined by:

[6.2]R2=1−∑i=1nyi−yi^2∑i=1nyi−y¯2

where y is an estimation of the average response and n is the number of points in the design of experiments.

The R2 criterion can be used to measure the percentage of the total variability of the response explained by the model. This coefficient should not be used to compare between various models, since it is highly dependent on the model used. Indeed, R2 increases when the number of terms goes up, even if all the predictors are not significant. To overcome this problem, the adjusted determination coefficient Radj2 can be used instead, defined by:

[6.3]Radj2=1−1n−p+1∑i=1nyi−yi^21n−1∑i=1nyi−yi¯2

where p represents the number of terms in the model (constant term not included). If Radj2 is expressed in terms of R2, it can be noted that Radj2 is always smaller than R2 and that the difference between these two coefficients increases with the number of predictors. Radj2 is, therefore, a compromise between a model which faithfully represents the variability of the response and a model which is not too rich in predictors.

Some methods have underlying hypotheses on the residuals ε^1,…,ε^n. For instance, for regression, the residuals are assumed to be centered. A residual analysis may be useful to compare the information provided by the determination coefficients.

Once the ability of the model to match the experimental data is checked, a second diagnosis is performed to check the ability of the adjusted surface to perform predictions. The experimental design space represents only a small domain of the possible values for the explanatory variables, whereas the adjusted model must be able to construct an approximate value of the response at any point in the field of study. It is therefore necessary to study if the proposed model can be applied to the total field of study and thus provide accurate predictions.

This method consists in comparing the predictions of the model at points which differ from those of the design of experiments. In the case where the number of feasible simulations is not constrained, it is possible to define a set of test points on which the prediction error criteria (MAE, RMSE, etc.) are evaluated. If not, it is possible to use cross-validation techniques.

In order to study the predictive qualities of the model, it is assumed that there are a reasonable number of test points. The indicators proposed below generally measure the mismatch between the prediction calculated by the adjusted model and the value of the response given by the simulator.

The determination coefficient R2 evaluated over a test process (also known as external R2) gives an indication of the prediction ability of the meta-model. The value of R2 can be negative, meaning that the model creates variability in comparison to a model providing constant prediction mismatch.

The mean square error (MSE) corresponds to the mean of the square of the prediction errors (L2– criterion method):

[6.4]MSE=1m∑i=1nyi−yi^2

where m represents the number of data from the test set. This criterion measures the mean square error of the mismatch between the predicted results and the test data. A low MSE value means that the predicted values match the real values.

The root mean square error (RMSE) criterion can also be used. It is defined by: RMSE=MSE

The RMSE depends on the order of magnitude of the observed values. It may, therefore, vary significantly from one application to the next. There are two ways to solve this problem. The first solution is to center and reduce the response (which is the solution usually taken). The second solution is to consider the criteria as being relative both in terms of mean (RRM) and standard deviation (RRE) defined as follows:

[6.5]RRM=1m∑i=1myi−yi^yi

[6.6]RRE=Varyi−yi^yi

The mean absolute error (MAE) criterion (which corresponds to standard L1) is defined by:

[6.7]MAE=1m∑i=1myi−yi^

This criterion is similar to the RMSE coefficient. Nevertheless, it is more robust since it is less sensitive to extreme values than MSE.

All distance measurements (MSE, RMSE and MAE) are equivalent and make it possible to quantify how the approximated solutions match the simulated data. A small value for these criteria means that the estimated model is able to predict the values of the response of the more complex model.

Table 6.8. Comparison of MSE and MAE criteria results for two meta-models (PLS regression and Kriging) on three responses Cmix, PdC and BPR

| Cmix | PdC | BPR | ||

|---|---|---|---|---|

| PLS regression | MSE | 1.4 × 10− 4 | 2.6 × 10− 7 | 2.7 × 10− 2 |

| MAE | 1.4 × 10− 2 | 1.6 × 10− 2 | 2.2 × 10− 2 | |

| Kriging | MSE | 2×10− 5 | 1.2 × 10− 8 | 4.3 × 10− 4 |

| MAE | 5.4 × 10− 3 | 3.6 × 10− 3 | 2.6 × 10− 3 |

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/B9781785481901500062

27th European Symposium on Computer Aided Process Engineering

Sarah E. Davis, … Mario R. Eden, in Computer Aided Chemical Engineering, 2017

5 Results and Discussion

Four performance measures, MaAE, MPE, RMSE, and MAE, were calculated for each challenge function and a “unique” surrogate model combination. A “unique” surrogate model was trained using each of the data sets, which were generated from each challenge function using LHS, Sobol and Halton sequences. The differences between the performance measures of “unique” surrogate models for each challenge function were not statistically significant. Therefore, the performance metrics of “unique” surrogate models of each challenge function were averaged for the comparisons presented in this section.

The comparisons of MaAE and MPE, and RMSE and MAE provided similar trends. Hence, the results are summarized in terms of MaAE and RMSE. Figure 1(a) portrays how the MaAE changes for challenge functions with different number of inputs for each surrogate model type in a box-plot format. For each surrogate model type and number of inputs, the central mark represents the median, the cross shows the mean, and the edges of the rectangles are the 25th and 75th percentiles. Where present, the whiskers represent the most extreme points that are not considered outliers, and the outliers are plotted as individual dots. Figure 1(b) gives a similar plot for RMSE; and Figures 1(c) and 1(d) show the box-plots for MaAE and RMSE grouped based on challenge function shapes.

Figure 1. Box plots of performance for different surrogate models. Change in (a) MaAE, (b) RMSE with the number of function inputs; and (c) MaAE and (d) RMSE with function shape.

Figure 1(a) reveals that the surrogate models developed using ALAMO yielded the lowest MaAE for functions with two and five inputs, and the ones developed using ANN and ELM the lowest MaAE for functions with four and 10 inputs. The performance of ANN, ALAMO, and ELM models are comparable for functions with three inputs. In terms of RMSE (Figure 1(b)), the models developed using ANNs consistently provided the lowest values for all functions, where the RMSEs of the models developed using ALAMO were comparable to the RMSEs of ANN models for functions with four and 10 inputs. Overall, these comparisons suggest that the models developed using ANNs and ALAMO have comparable accuracy for functions with different dimensions. However, it should be noted that the surrogate models generated by ALAMO are consistently simpler functions than ANN models.

When the performance of surrogate model types are compared based on the shape of the challenge functions, ANN models yielded the smallest RMSE for all function shapes (Figure 1(d)). However, when the models are compared based on MaAE, in general, models developed using ALAMO and ELM yielded lower MaAEs than the ANN models (Figure 1(c)). For example, ALAMO models yielded the lowest MaAE for bowl shaped functions, whereas ELM models for valley shaped functions. Nevertheless, Figures 1(c) and (d) suggest that ANN, ALAMO, and ELM models overall consistently provided more accurate representation of the input-output data sets than the surrogate model forms considered.

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/B9780444639653500787

Sky-Imaging Systems for Short-Term Forecasting

Bryan Urquhart, … Jan Kleissl, in Solar Energy Forecasting and Resource Assessment, 2013

9.5.4 Error Metrics

To evaluate the forecast, mean bias error (MBE), mean absolute error (MAE), and root mean square error (RMSE) were computed over the given period during daylight hours (SZA < 80°). The sky imager generates a forecast every 30 s, whereas the plant reports power output every 1 s, so to compare the forecast to actual power production, a 30 s average of power output data centered on the image capture time was used. These error metrics were computed for each of the 31 forecast intervals out to a 15 min forecast horizon.

While the metrics used provide a numerical evaluation of forecast accuracy, they are difficult to assess without a baseline comparison. The use of persistence as a baseline forecast is especially useful for short term forecasts. To generate a persistence forecast for comparison, the plant’s aggregate normalized power was averaged for 1 min prior to forecast issue and was then applied to the remainder of the 15 min forecast window. Adjustments were made for changing solar geometry throughout the 15 min forecast window by computing the clear-sky GI for each of the 30 s intervals.

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/B9780123971777000097

| title | titleSuffix | description | services | author | ms.author | ms.reviewer | ms.service | ms.subservice | ms.date | ms.topic | ms.custom | ms.openlocfilehash | ms.sourcegitcommit | ms.translationtype | ms.contentlocale | ms.lasthandoff | ms.locfileid |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

|

Оценка результатов экспериментов Аутомл |

Azure Machine Learning |

Узнайте, как просматривать и оценивать диаграммы и метрики для каждого из автоматических запусков экспериментов машинного обучения. |

machine-learning |

gregorybchris |

chgrego |

nibaccam |

machine-learning |

core |

12/09/2020 |

conceptual |

how-to, contperf-fy21q2, automl |

b60e5f656b675a1382b8b4776975723a437183bc |

2c1b93301174fccea00798df08e08872f53f669c |

MT |

ru-RU |

03/22/2021 |

104773119 |

Оценка результатов автоматического эксперимента машинного обучения

Из этой статьи вы узнаете, как оценивать и сравнивать модели, обученные автоматическим экспериментом машинного обучения (автоматизированное обучение). В ходе автоматического эксперимента ML создаются многие запуски, и каждый запуск создает модель. Для каждой модели автоматический ML создает метрики и диаграммы оценки, которые помогают измерять производительность модели.

Например, автоматический ML создает следующие диаграммы на основе типа эксперимента.

| Классификация | Регрессия и прогнозирования |

|---|---|

| Матрица неточностей | Гистограмма остатков |

| Кривая операционной характеристики получателя (ROC) | Предсказанные и значения true |

| Кривая точности-отзыва (PR) | |

| кривая точности прогнозов; | |

| Кривая совокупных выигрышей | |

| Кривая калибровки |

Предварительные требования

- Подписка Azure. (Если у вас нет подписки Azure, Создайте бесплатную учетную запись , прежде чем начинать работу).

- Машинное обучение Azure эксперимент, созданный с помощью:

- Машинное обучение Azure Studio (код не требуется)

- Пакет SDK для машинное обучение Azure Python

Просмотреть результаты выполнения

После завершения автоматического эксперимента ML журнал запусков можно найти через:

- Браузер с машинное обучение Azure Studio

- Записная книжка Jupyter с помощью мини-приложения Рундетаилс Jupyter

В следующих шагах и видео показано, как просмотреть показатели выполнения и метрики оценки модели и диаграммы в студии.

- Войдите в студию студии и перейдите к рабочей области.

- В меню слева выберите эксперименты.

- Выберите эксперимент из списка экспериментов.

- В таблице в нижней части страницы выберите автоматический запуск ML.

- На вкладке модели выберите имя алгоритма для модели, которую необходимо вычислить.

- На вкладке метрики используйте флажки слева, чтобы просмотреть метрики и диаграммы.

Метрики классификации

Автоматический ML вычисляет метрики производительности для каждой модели классификации, создаваемой для вашего эксперимента. Эти метрики основаны на реализации scikit.

Многие метрики классификации определены для двоичной классификации в двух классах и потребовали усреднения по классам для получения одной оценки для многоклассовой классификации. Scikit — Узнайте о нескольких усредненных методах, три из которых автоматизированный ML предоставляет: макрос, Micro и взвешенный.

- Макрос — вычисление метрики для каждого класса и получение невзвешенного среднего

- Микрорасчет метрики на глобальном уровне путем подсчета итоговых истинных положительных результатов, ложных негативов и ложных срабатываний (независимо от классов).

- Взвешенный — вычисление метрик для каждого класса и получение взвешенного среднего по числу выборок на каждый класс.

Хотя каждый метод усреднения имеет свои преимущества, одним из общих соображений при выборе соответствующего метода является дисбаланс класса. Если у классов разное количество выборок, может быть более информативным использование макроса, в среднем где доли классов имеют одинаковый вес для большинства классов. Дополнительные сведения о двоичных и многоклассовых метриках в автоматизированном ML.

В следующей таблице перечислены метрики производительности модели, которые автоматизированное средство ML вычисляет для каждой модели классификации, создаваемой для вашего эксперимента. Дополнительные сведения см. в документации по scikit-учиться, связанной в поле вычисления каждой метрики.

| Метрика | Описание | Вычисление |

|---|---|---|

| AUC | AUC — это область под кривой рабочих характеристик получателя.

Цель: Ближе к 1 лучше Поддерживаются следующие имена метрик: AUC_macro, среднее арифметическое AUC для каждого класса.AUC_micro, вычисленные путем объединения истинных положительных и ложных положительных результатов от каждого класса. AUC_weightedсреднее арифметическое значение оценки для каждого класса, взвешенное по количеству истинных экземпляров в каждом классе. |

Вычисление |

| accuracy | Точность — это отношение прогнозов, которые точно соответствуют истинным меткам классов.

Цель: Ближе к 1 лучше |

Вычисление |

| average_precision | Для вычисления средней точности используется кривая точности и полноты в качестве взвешенного среднего значения точности, полученного для каждого порогового значения, с увеличением полноты за счет предыдущего порогового значения, используемого в качестве весового коэффициента.

Цель: Ближе к 1 лучше Поддерживаются следующие имена метрик: average_precision_score_macro, среднее арифметическое среднего показателя точности каждого класса.average_precision_score_micro, вычисленные путем объединения истинных положительных и ложных срабатываний при каждой отсечки.average_precision_score_weighted, среднее арифметическое среднее значение точности для каждого класса, взвешенное по количеству истинных экземпляров в каждом классе. |

Вычисление |

| balanced_accuracy | Сбалансированная точность — это среднее арифметическое значение полноты для каждого класса.

Цель: Ближе к 1 лучше |

Вычисление |

| f1_score | Оценка F1 — это среднее гармоническое значение точности и полноты. Это хорошее сбалансированное измерение как ложных срабатываний, так и ложных отрицательных результатов. Однако он не учитывает истинные отрицательные результаты.

Цель: Ближе к 1 лучше Поддерживаются следующие имена метрик: f1_score_macro: арифметическое среднее значение оценки F1 для каждого класса. f1_score_micro: вычисляется путем подсчета общего количества истинных положительных, ложных отрицательных значений и ложных срабатываний. f1_score_weighted: взвешенное среднее значение частоты класса для оценки F1 для каждого класса. |

Вычисление |

| log_loss | Это функция потери данных, используемая в логистической регрессии (мультиноминальное) и расширениях ИТ-сетей, таких как нейронные сети, которая определяется как отрицательная вероятность журнала для истинных меток на основе прогнозов классификатора вероятностная.

Цель: Ближе к 0 лучше |

Вычисление |

| norm_macro_recall | Нормализация макроса отзыв макроса — усредненный и нормализованный, поэтому значение случайной производительности имеет оценку 0, а оптимальная производительность имеет оценку 1.

Цель: Ближе к 1 лучше |

(recall_score_macro - R) / (1 - R)

Здесь

|

| matthews_correlation | Коэффициент корреляции Matthews — это сбалансированная мера точности, которую можно использовать, даже если один класс содержит гораздо больше выборок, чем другой. Коэффициент 1 обозначает идеальный прогноз, 0 случайный прогноз и-1 Обратный прогноз.

Цель: Ближе к 1 лучше |

Вычисление |

| точность | Точность — это способность модели избежать пометки отрицательных выборок как положительных.

Цель: Ближе к 1 лучше Поддерживаются следующие имена метрик: precision_score_macro, среднее арифметическое значений точности для каждого класса. precision_score_micro, вычисляются глобально путем подсчета итоговых истинных положительных результатов и ложных положительных результатов. precision_score_weighted, арифметическое среднее значение точности для каждого класса, взвешенное по числу истинных экземпляров в каждом классе. |

Вычисление |

| полнота | Отзыв — это способность модели обнаруживать все положительные выборки.

Цель: Ближе к 1 лучше Поддерживаются следующие имена метрик: recall_score_macro: среднее арифметическое при отзыве для каждого класса. recall_score_micro. вычисляется глобально путем подсчета итоговых истинных положительных результатов, ложных отрицательных результатов и ложных срабатываний.recall_score_weighted: среднее арифметическое для каждого класса, взвешенное по числу истинных экземпляров в каждом классе. |

Вычисление |

| weighted_accuracy | Взвешенная точность — точность, в которой каждый выбор имеет взвешенное значение по общему количеству выборок, принадлежащих одному и тому же классу.

Цель: Ближе к 1 лучше |

Вычисление |

Метрики двоичной и многоклассовой классификации

Автоматизированное МАШИНное обучение не различает метрики двоичного и многоклассного языка. Одни и те же метрики проверки сообщают, имеет ли набор данных два класса или более двух. Однако некоторые метрики предназначены для многоклассовой классификации. При применении к двоичному набору данных эти метрики не будут рассматривать класс как true класс, как можно ожидать. К метрикам, которые явно предназначены для многоклассового класса, добавляется суффикс micro , macro или weighted . Примеры:,,, average_precision_score f1_score precision_score recall_score и AUC .

Например, вместо того, чтобы вычислить отзыв как, среднее арифметическое вычисление tp / (tp + fn) в нескольких классах ( micro , macro или weighted ) для обоих классов набора данных двоичной классификации. Это эквивалентно вычислению отзыва для true класса и false класса отдельно, а затем получение среднего значения этих двух значений.

Автоматический ML не вычисляет двоичные метрики, то есть метрики для наборов данных двоичной классификации. Однако эти метрики можно вычислить вручную с помощью матрицы путаницы , которую автоматически создает ml для этого конкретного запуска. Например, можно вычислить точность, tp / (tp + fp) используя истинные положительные и ложные положительные значения, показанные в матричной диаграмме с путаницой в 2×2.

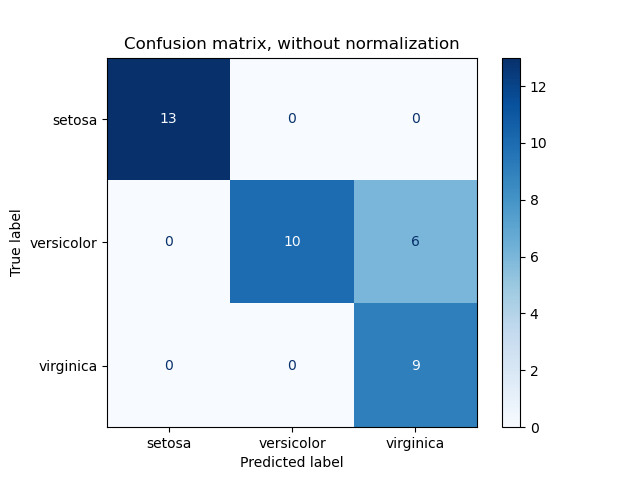

Матрица неточностей

Несогласованные матрицы предоставляют визуальный элемент того, как модель машинного обучения делает систематические ошибки в своих прогнозах для моделей классификации. Слово «путаница» в названии поступает из модели «путаницы» или с неправильной маркировкой. Ячейка в строке i и столбце j в матрице путаницы содержит количество выборок в наборе данных для оценки, принадлежащих классу C_i и классифицированных моделью как класс C_j .

В студии более темная ячейка указывает на большее число выборок. Выбор нормализованного представления в раскрывающемся списке приводит к нормализации каждой строки матрицы для отображения процента класса, C_i прогнозируемого в качестве класса C_j . Преимущество представления RAW по умолчанию состоит в том, что можно определить, является ли дисбаланс в распределении фактических классов причиной невозможности классификации выборок из класса миноритария, распространенной проблемой в несбалансированных наборах данных.

Матрица путаницы хорошей модели будет содержать большинство примеров по диагонали.

Матрица с путаницой для хорошей модели

Матрица неправильной модели

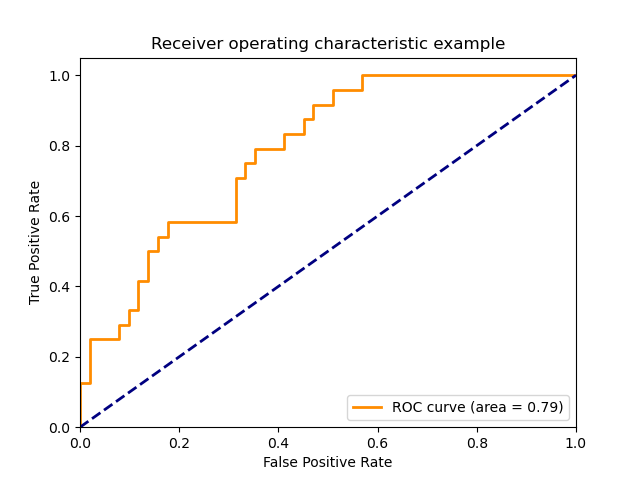

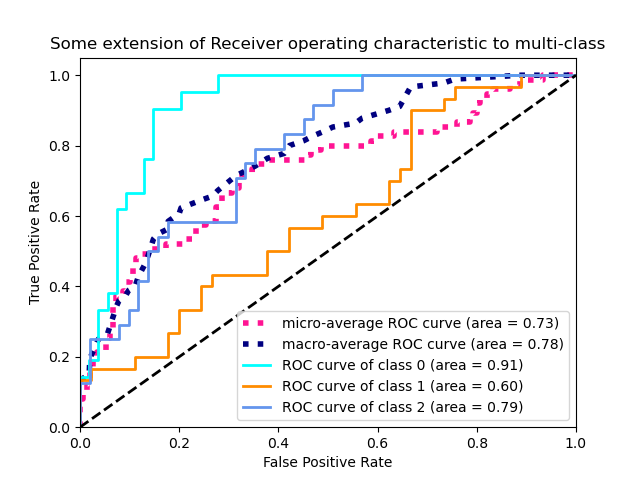

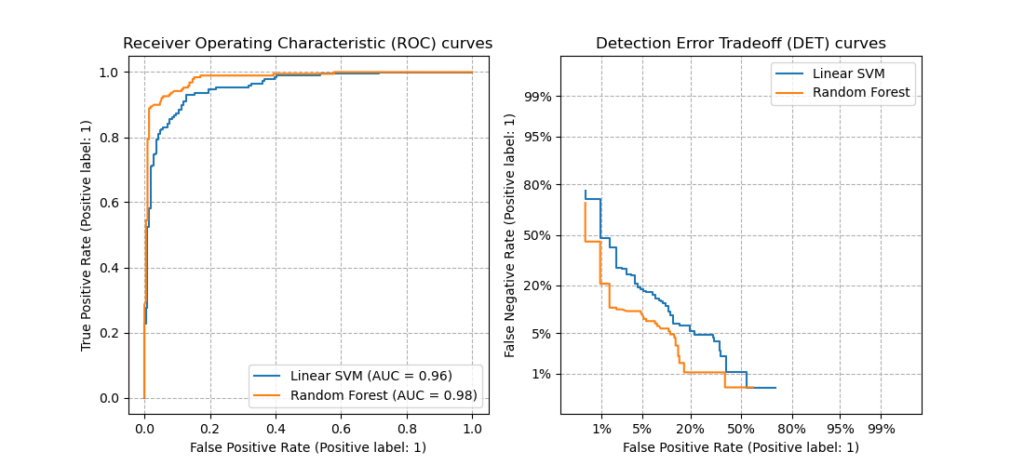

Кривая ROC.

Кривая «операционная характеристика приемника» (ROC) Отображает связь между истинным положительным числом (ТПР) и ложным положительным числом (зарегистрированном) при изменении порогового значения принятия решений. Кривая ROC может быть менее информативной при обучении моделей на наборах данных с высоким дисбалансом классов, так как класс большинства может Drown вклады из классов миноритария.

Область под кривой (AUC) может интерпретироваться как доля правильно классифицированных выборок. Точнее, AUC — вероятность того, что классификатор ранжирует случайным образом выбранный положительный пример выше, чем случайный выбор отрицательного числа. Форма кривой дает интуиция для связи между ТПР и зарегистрированном в качестве функции порога классификации или границы принятия решений.

Кривая, которая приближается к левому верхнему углу диаграммы, приближается к 100% ТПР и 0% зарегистрированном, лучшей возможной модели. Случайная модель создаст ROC кривую вдоль y = x линии из нижнего левого угла в верхнюю правую. Хуже, чем у случайной модели, ROCная кривая наследуется под y = x линией.

[!TIP]

Для экспериментов классификации каждый из графиков, созданных для автоматизированных моделей машинного обучения, можно использовать для вычисления модели по каждому классу или усреднения по всем классам. Можно переключаться между этими представлениями, щелкая метки классов в условных обозначениях справа от диаграммы.

ROCная кривая для хорошей модели

Кривая ROC для неправильной модели

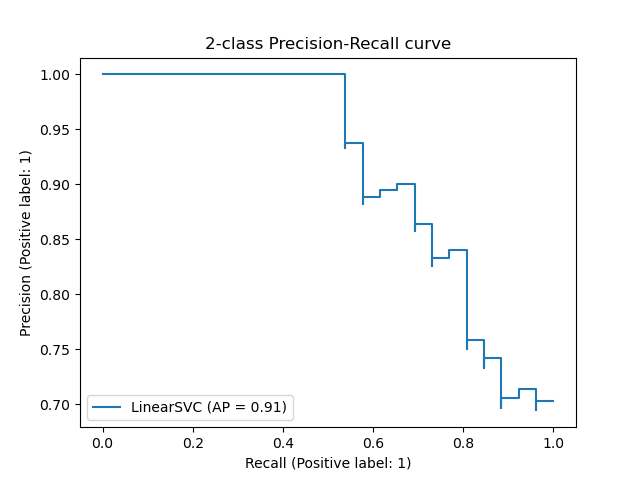

Кривая точности-отзыв

Кривая с точностью отзыва отображает связь между точностью и отзывом при изменении порогового значения решения. Отзыв — это способность модели обнаруживать все положительные выборки и точность — это способность модели избежать пометки отрицательных выборок как положительных. Некоторые бизнес-проблемы могут потребовать более высокого отзыва и некоторой большей точности в зависимости от относительной важности исключения ложных негативов и ложных срабатываний.

[!TIP]

Для экспериментов классификации каждый из графиков, созданных для автоматизированных моделей машинного обучения, можно использовать для вычисления модели по каждому классу или усреднения по всем классам. Можно переключаться между этими представлениями, щелкая метки классов в условных обозначениях справа от диаграммы.

Кривая точности-отзыв для хорошей модели

Кривая точности-отзыв для неправильной модели

Кривая совокупных выигрышей

Кривая Накопленная прибыль отображает процент положительных выборок, которые правильно классифицируются как функция процента выборок, рассматриваемых в порядке прогнозной вероятности.

Чтобы вычислить прибыль, сначала отсортируйте все выборки от самого высокого до наименьшей вероятности, прогнозируемой моделью. Затем принимаются x% максимальные прогнозы достоверности. Разделить число обнаруженных положительных выборок x% по общему количеству положительных выборок для получения прибыли. Интегральная прибыль — это процент положительных выборок, которые обнаруживаются при рассмотрении некоторого процента данных, которые, скорее всего, будут принадлежать к положительному классу.

Идеальная модель будет ранжировать все положительные выборки выше всех отрицательных выборок, предоставляя совокупную кривую выигрышей, состоящие из двух прямых сегментов. Первая — это линия с наклоном 1 / x от (0, 0) до, (x, 1) где x — доля выборок, принадлежащих положительному классу ( 1 / num_classes Если классы сбалансированы). Второй — горизонтальная линия от (x, 1) до (1, 1) . В первом сегменте все положительные выборки классифицируются правильно, а совокупное увеличение — в 100% рамках первого x% из рассматриваемых примеров.

Базовая модель «Random» будет иметь общую кривую выигрыша, y = x Если для x% образцов, которые рассматриваются только x% в общем количестве положительных выборок, были обнаружены только общие. Идеальная модель будет иметь линейную среднюю кривую, которая касается левого верхнего угла и средней строки макроса с наклоном 1 / num_classes до 100%, а затем по горизонтали до тех пор, пока процент данных не будет 100.

[!TIP]

Для экспериментов классификации каждый из графиков, созданных для автоматизированных моделей машинного обучения, можно использовать для вычисления модели по каждому классу или усреднения по всем классам. Можно переключаться между этими представлениями, щелкая метки классов в условных обозначениях справа от диаграммы.

Совокупная кривая выигрышей для хорошей модели

Совокупная кривая выигрышей для неправильной модели

Диаграмма точности прогнозов

Кривая точности показывает, сколько раз лучшая модель выполняется по сравнению с случайной моделью. Прогноз определяется как отношение совокупного увеличения к совокупному выигрышю случайной модели.

Эта относительная производительность учитывает тот факт, что классификация усложняется по мере увеличения числа классов. (Случайная модель неправильно прогнозирует большую долю выборок из набора данных с 10 классами по сравнению с набором данных с двумя классами).

Кривая с базовым прогнозом — это y = 1 линия, в которой производительность модели согласуется с моделью случайной модели. В целом, кривая точности для хорошей модели будет выше на этой диаграмме и дальше от оси x, что покажет, что когда модель наиболее надежна в своих прогнозах, она работает много раз лучше, чем случайное догадка.

[!TIP]

Для экспериментов классификации каждый из графиков, созданных для автоматизированных моделей машинного обучения, можно использовать для вычисления модели по каждому классу или усреднения по всем классам. Можно переключаться между этими представлениями, щелкая метки классов в условных обозначениях справа от диаграммы.

Кривая точности прогнозов для хорошей модели

Кривая точности прогнозов для неправильной модели

Кривая калибровки

Кривая калибровки отображает уверенность модели в своих прогнозах относительно пропорции положительных выборок на каждом уровне достоверности. Хорошо откалиброванная модель правильно классифицирует 100% прогнозов, до которых она назначает 100% достоверности, 50% от прогнозов, назначая доверие на уровне 50%, 20% прогнозов и т. д. Вполне откалиброванная модель будет иметь кривую калибровку, следующую за y = x строкой, где модель точно прогнозирует вероятность того, что выборки относятся к каждому классу.

Чрезмерно уверенная модель будет превышена до нуля, а другая — неопределенной для класса каждого примера, а Кривая калибровки будет выглядеть так же, как в обратном направлении «S». Более надежная модель привязывает меньшую вероятность среднего к классу, который он прогнозирует, и связанная Кривая калибровки будет выглядеть примерно как «S». Кривая калибровки не описывает возможность правильно классифицировать модель, а ее способность правильно назначать прогнозы. Неправильная модель по-прежнему может иметь хорошую кривую калибровку, если модель правильно назначит низкую достоверность и высокую неопределенность.

[!NOTE]

Кривая калибровки чувствительна к числу выборок, поэтому небольшой набор проверки может привести к нежелательным результатам, которые трудно интерпретировать. Это не обязательно означает, что модель не будет правильно откалибрована.

Кривая калибровки для хорошей модели

Кривая калибровки для неправильной модели

Метрики регрессии и прогнозирования

Автоматический ML вычисляет одинаковые метрики производительности для каждой создаваемой модели, независимо от того, является ли это экспериментом регрессии или прогнозирования. Эти метрики также прошли нормализацию, чтобы обеспечить сравнение моделей, обученных данными, с разными диапазонами. Дополнительные сведения см. в разделе нормализация метрик.

В следующей таблице перечислены метрики производительности модели, созданные для экспериментов и прогнозирования. Подобно метрикам классификации, эти метрики также основываются на реализации scikit. Соответствующая документация по scikitной документации связана соответствующим образом в поле вычисления .

| Метрика | Описание | Вычисление |

|---|---|---|

| explained_variance | Описанная дисперсия измеряет степень, до которой учетные записи модели для варианта в целевой переменной. Это процент уменьшения дисперсии исходных данных по отношению к дисперсии ошибок. Если среднее значение ошибки равно 0, то оно равно коэффициенту определения (см. r2_score ниже).

Цель: Ближе к 1 лучше |

Вычисление |

| mean_absolute_error | Средняя абсолютная ошибка — это ожидаемое значение абсолютного значения разности между целевым объектом и прогнозом.

Цель: Ближе к 0 лучше Типов |

Вычисление |

| mean_absolute_percentage_error | Среднее значение абсолютной ошибки в процентах (MAPE) — это мера среднего различия между прогнозируемым значением и фактическим значением.

Цель: Ближе к 0 лучше |

|

| median_absolute_error | Медиана абсолютной погрешности — это медиана всех абсолютных отклонений между целевым и прогнозируемым значениями. Такая потеря устойчива к выбросам.

Цель: Ближе к 0 лучше Типов |

Вычисление |

| r2_score; | R2 (коэффициент определения) измеряет пропорциональное уменьшение в среднем квадрате ошибок (MSE) относительно общей дисперсии наблюдаемых данных.

Цель: Ближе к 1 лучше Примечание. R2 часто имеет диапазон (-INF, 1]. Размер MSE может быть больше наблюдаемой дисперсии, поэтому R2 может иметь произвольно большие отрицательные значения в зависимости от данных и прогнозов модели. Автоматический фрагмент машинного обучения сообщил о показателях R2 в значении-1, поэтому значение-1 для R2 , скорее всего, означает, что значение true, если показатель r2 меньше-1. Рассмотрите другие значения метрик и свойства данных при интерпретации отрицательной оценки R2 . |

Вычисление |

| root_mean_squared_error | Средняя квадратная ошибка (корень СРЕДНЕКВАДРАТИЧНОЙ ПОГРЕШНОСТИ) — это квадратный корень ожидаемого квадратного различия между целевым объектом и прогнозом. Для несмещенной оценки корень СРЕДНЕКВАДРАТИЧНОЙ ПОГРЕШНОСТИ равно стандартному отклонению.

Цель: Ближе к 0 лучше Типов |

Вычисление |

| root_mean_squared_log_error | Корень среднего значения ошибки журнала — квадратный корень ожидаемой квадратной логарифмической ошибки.

Цель: Ближе к 0 лучше Типов |

Вычисление |

| spearman_correlation; | Корреляция Спирмена — это непараметрическая мера монотонности связи между двумя наборами данных. В отличие от корреляции Пирсона, для корреляции Спирмена не предполагается, что оба набора данных используют нормальное распределение. Как и другие коэффициенты корреляции, Спеарман может иметь значение от-1 до 1, и 0 не подразумевает корреляцию. Для корреляций-1 или 1 подразумевается Точная монотонная связь.

Спеарман — это метрика корреляции порядка ранжирования, которая означает, что изменения в прогнозируемых или фактических значениях не будут приводить к изменению результата Спеарман, если они не меняют порядок ранжирования или фактических значений. Цель: Ближе к 1 лучше |

Вычисление |

Нормализация метрик

Автоматический ML нормализует метрики регрессии и прогнозирования, что позволяет сравнивать модели, обученные данными, с разными диапазонами. Модель, обученная для данных с большим диапазоном, имеет более высокую ошибку, чем та же модель, обученная данными с меньшим диапазоном, если эта ошибка не нормализована.

Несмотря на то, что стандартный метод нормализации метрик ошибок не существует, автоматизированный ML принимает общий подход к разделению ошибок на диапазон данных: normalized_error = error / (y_max - y_min)

При оценке модели прогнозирования на основе данных временных рядов автоматизированное средство ML выполняет дополнительные действия, чтобы убедиться, что нормализация выполняется по ИДЕНТИФИКАТОРу временного ряда (зернистости), так как у каждого временного ряда вероятность другого распределения целевых значений.

Остатки

Остаточная диаграмма представляет собой гистограмму ошибок прогнозов (остатков), созданных для экспериментов и прогнозирования. Остатки рассчитываются как y_predicted - y_true для всех выборок, а затем отображаются в виде гистограммы для отображения смещения модели.

В этом примере обратите внимание, что обе модели немного смещены для предсказания ниже фактического значения. Это редко используется для набора данных с асимметричным распределением фактических целевых объектов, но указывает на производительность модели хуже. Хорошая модель будет иметь распределение остатков от нуля до нескольких остатков. Более серьезная модель будет иметь распределенное распределение остатков с меньшим числом выборок, равным нулю.

Диаграмма остатков для хорошей модели

Диаграмма остатков для неправильной модели

Предсказанные и значения true

Для эксперимента и прогнозирования на диаграмме прогнозная и истинная диаграммы отображает связь между целевой функцией (истинными и фактическими значениями) и прогнозами модели. Значения true Binned вдоль оси x и для каждой ячейки. среднее прогнозируемое значение отображается планами погрешностей. Это позволяет определить, является ли модель более смещенной в сторону прогнозирования определенных значений. В строке отображается средний прогноз, а затененная область — дисперсия прогнозов вокруг этого среднего.

Часто наиболее распространенное значение true будет иметь наиболее точные прогнозы с наименьшей дисперсией. Расстояние от линии тренда от идеальной y = x линии, где существует несколько истинных значений, является хорошим показателем производительности модели при выбросах. В нижней части диаграммы можно использовать гистограмму, в которой объясняется фактическое распределение данных. Включая дополнительные примеры данных, в которых распределение является разреженным, может повысить производительность модели на невидимых данных.

В этом примере обратите внимание, что лучшая модель имеет прогнозируемую и истинную строку, расположенную ближе к идеальной y = x линии.

Прогнозируемая и истинная диаграмма для хорошей модели

Прогнозируемая и истинная диаграмма для неправильной модели

Пояснения к модели и важность функций

Хотя метрики и диаграммы оценки модели хорошо подходят для измерения общего качества модели, проверка того, какой набор данных использует модель, которая используется для прогнозирования прогнозов, очень важно при тренировке ответственного ии. Именно поэтому автоматизированное ML предоставляет панель мониторинга для интерпретируемости модели, которая позволяет измерять и сообщать об относительных вкладах функций набора данных.

Чтобы просмотреть панель мониторинга интерпретируемости в студии, сделайте следующее:

- Войдите в студию студии и перейдите к рабочей области.

- В меню слева выберите эксперименты .

- Выбор эксперимента из списка экспериментов

- В таблице в нижней части страницы выберите Запуск Аутомл.

- На вкладке модели выберите имя алгоритма для модели, которую необходимо объяснить.

- На вкладке пояснения вы можете увидеть, что уже было создано, если модель лучше

- Чтобы создать новое пояснение, выберите объяснить модель и выберите удаленное вычисление, с помощью которого нужно вычислить объяснения.

Дополнительные сведения о моделях в автоматизированном ML.

[!NOTE]

В настоящее время модель Форекастткн не поддерживается автоматическими объяснениями ML, а другие модели прогнозирования могут иметь ограниченный доступ к средствам интерпретации.

Дальнейшие действия

- Попробуйте пример автоматизированной учебной записной книжки с описанием модели машинного обучения.

- Для автоматических вопросов, связанных с МАШИНным обучением, обращайтесь к askautomatedml@microsoft.com .

What is mean absolute error (MAE)?

Mean absolute error, or MAE, measures the performance of a regression model. The mean absolute error is defined as the average of the all absolute differences between true and predicted values:

$$mathrm{MAE}=frac{1}{n}sum^{n-1}_{i=0}(|y_i-hat{y}_i|)$$

Where:

-

$n$ is the number of predicted values

-

$y_i$ is the actual true value of the $i$-th data

-

$hat{y}_i$ is the predicted value of the $i$-th data

A model with a high value of MAE means that its performance is subpar, while one a MAE of zero would indicate a perfect model without any error in its predictions.

Simple example to calculate mean absolute error (MAE)

Suppose we have three data points (1,3), (2,2) and (3,2). In order to predict the y-value given the x-value, we have built a simple linear model $hat{y}=x$, as shown in the diagram below:

To get a measure of how good our model performs, we can compute the MAE like so:

$$begin{align*}

mathrm{MAE}&=frac{1}{3}left(|3-1|+|2-2|+|2-3|right)\

&=frac{1}{3}left(2+0+1right)\

&=1

end{align*}$$

This means that our predictions are off by one on average.

Why do we take the absolute value?

The reason is that the absolute value prevents positive and negative differences from cancelling each other out. As an example, consider the following example:

Suppose we computed the MAE without taking the absolute value:

$$begin{align*}

mathrm{MAE’}&=frac{1}{3}Big[(1-3)+(2-2)+(3-2)Big]\

&=frac{1}{3}left(-2+0+2right)\

&=0

end{align*}$$

As you can see, the negative and positive difference of the first and third data points have cancelled each other out. As a result, we end up with a MAE’ of 0, which is obviously misleading because we know that our model is not performing all that well. In order to avoid negative and positive differences to cancel each other out, MAE takes the absolute value of the difference.

Why isn’t mean absolute error (MAE) used as a cost function?

Most machine learning models «learn» by minimising the cost function. The mean absolute error is often not chosen as the cost function because the presence of the absolute value makes differentiation harder, which means the function is difficult to optimise. For this reason, mean squared error is typically chosen as the cost function to train machine learning models.

Computing mean absolute error (MAE) using Python’s Scikit-learn

To compute the mean absolute error given a list of true and predicted values:

from sklearn.metrics import mean_absolute_error

y_true = [2,6,5]

y_pred = [7,4,3]

mean_absolute_error(y_true, y_pred)

3.0

Setting multioutput

By default, multioutput='uniform_average', which returns a the global mean absolute error:

y_true = [[1,2],[3,4]]

y_pred = [[6,7],[9,8]]

mean_absolute_error(y_true, y_pred)

5.0

Skip to content

Error Metrics: How to Evaluate Your Forecasts

When considering the performance of any forecasting model, the prediction values it produces must be evaluated. This is done by calculating suitable error metrics. An error metric is a way to quantify the performance of a model and provides a way for the forecaster to quantitatively compare different models1. They give us a way to more objectively gauge how well the model executes its tasks.

In this blog post we will cover some commonly used metrics for time series forecasting, how to interpret them, as well as the limitations of each metric. A friendly warning: This involves some math, which is necessary to explain how these metrics work. But the interpretation and limitations are clearly marked, so you can skip directly to the marked sections below the equations for straightforward explanations.

- Mean Absolute Error (MAE)

- Mean Absolute Percentage Error (MAPE)

- Mean Squared Error (MSE)

- Root Mean Squared Error (RMSE)

- Normalized Root Mean Squared Error (NRMSE)

- Weighted Absolute Percentage Error (WAPE)

- Weighted Mean Absolute Percentage Error (WMAPE)

- Range of Errors & Accuracies

- Conclusion

Mean Absolute Error (MAE)

MAE is defined as the average of absolute difference between forecasted values and true values.

Where y’ is forecasted value and y is the true value. n is total number of values in the test set. MAE tells us how big of an error we can expect from the forecast on an average2. The error values are in the original units of forecasted values and MAE = 0 indicates that there is no error in the forecasted values.

The lower the MAE value, the better the model is; a value of zero means there is no error in the forecast. In other words, when comparing multiple models, the model with the lowest MAE is considered better.

However, MAE does not indicate the relative size of the error and it becomes difficult to differentiate big errors from small errors. It can be used with other metrics (see Root Mean Square Error below) to determine if the errors are larger. Additionally, MAE can gloss over problems to do with low data volume; see the last two metrics in this article to address that issue.

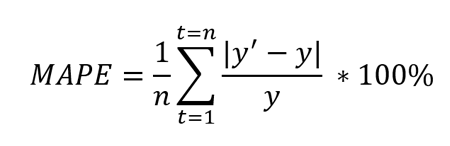

Mean Absolute Percentage Error (MAPE)

MAPE is defined as the percentage of the average of absolute difference between forecasted values and true values, divided by true value.

Where y’ is forecasted value and y is the true value. n is total number of values in the test set. Because of the in denominator, it works best with data without zeros and extreme values. If this value is extremely small or large, the MAPE value also takes an extreme value.

The lower the MAPE, the better the model is. Keep in mind that MAPE works best with data without zeros and extreme values. Like MAE, MAPE also understates the impact of large but infrequent errors due to extreme values. To deal with this problem, Mean Square Error can be used. This metric can gloss over problems to do with low data volume; see the last two metrics in this article to deal with that situation.

Mean Squared Error (MSE)

MSE is defined as the average of squares of the error3. It is also defined as the metric that assesses the quality of forecasting model or predictor. MSE also incorporates both the variance (the spread of predicted values from each other) and bias (the distance of predicted value from its true value).

Where y’ is forecasted value and y is the true value. n is total number of values in the test set. MSE is almost always positive and values closer to zero are better. Because of the square term (as seen in the formula above), this metric penalizes large errors or outliers more compared to the small errors.

The closer to zero MSE is, the better. While it solves the extreme value and zero problem of MAE and MAPE, it might be disadvantageous in some cases. This metric can overlook issues when dealing with low data volume; see Weighted Absolute Percentage Error and Weighted Mean Absolute Percentage Error to deal with that.

Root Mean Squared Error (RMSE)

This metric is an extension of MSE and is defined as the square root of mean square error.

Where y’ is forecasted value and y is the true value. n is total number of values in the test set. Like MSE, this metric also penalizes larger errors more.

This metric is also always positive and lower values are better. One advantage of this calculation is that the RMSE value is in the same unit as the forecasted value. This makes it easier to understand compared to MSE.

RMSE can also be compared to MAE to determine whether the forecast contains large but infrequent errors. The larger the difference between RMSE and MAE the more inconsistent the error size.2 This metric can gloss over problems to do with low data volume; see the last two metrics in this article to address that issue.

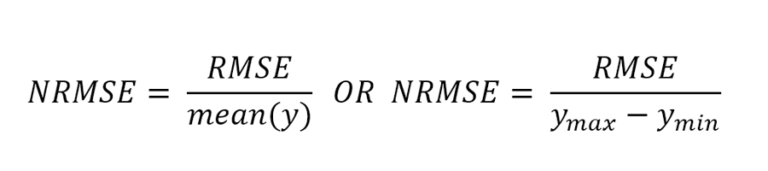

Normalized Root Mean Squared Error (NRMSE)

NRMSE is an extension of RMSE and is calculated by normalizing RMSE. There are two popular methods for normalizing RMSE: using mean or using the range of the true values (difference of minimum and maximum values).

Where ymax is the maximum true value and ymin is the minimum true value.

NRMSE is often used to compare different datasets or forecasting models that have different scales (units and gross revenue, for example). The smaller the value is, the better the performance of the model. This metric can overlook issues when dealing with low data volume; see Weighted Absolute Percentage Error and Weighted Mean Absolute Percentage Error to address this.

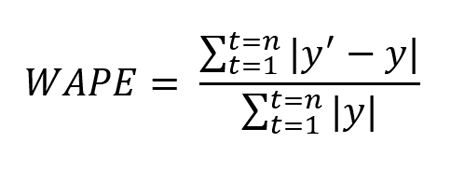

Weighted Absolute Percentage Error (WAPE)

WAPE is defined as the weighted average of the mean absolute error.

Where y’ is forecasted value and y is the true value. n is total number of values in the test set.

The error metrics mentioned above help us measure the performance of the forecasting model but can be deceiving when dealing with low volume data, for example, when the true value of some data points is very small compared to the rest of the data (e.g., intermittent demand/sales data). For such cases, WAPE can be used.

The lower the value of WAPE, the better the performance of the model. WAPE is helpful here because the “weighing” helps distinguish the smaller errors from larger errors. In other words, this metric prevents the small values from being considered as equal to or higher than larger values.4

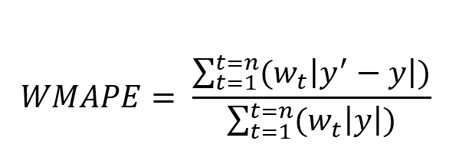

Weighted Mean Absolute Percentage Error (WMAPE)

WMAPE is an extension of WAPE and is defined as the weighted mean absolute percentage error.

Where y’ is forecasted value and y is the true value. n is total number of values in the test set.

The lower the value of WMAPE, the better the performance of the model. This metric is helpful for low volume data where each observation has different priority when evaluating forecasting models. Observations with higher priority have a higher weight value. The larger the error in high priority forecast values, the larger the WMAPE value is.

Range of Errors & Accuracies

When using the error metrics mentioned above, the actual distribution of the error values is not known. However, this distribution can give further insights into the behavior of the forecasting model and help select the most suitable metric. In the Jedox AIssisted™ Planning Wizard, besides the aforementioned metrics, error distribution is also calculated, i.e., the value of the metric for each data point of the test set. A summary of the distribution, including other relevant values such as the minimum, maximum and median error values, is also provided.

Conclusion

Even though there are multiple metrics, each one provides specific information that may or may not be suitable for your specific use case. This means a metric should be chosen based on the use case and an understanding of the data involved in making the predictions.

Overview error metrics for forecasts

- MAE is useful when absolute error needs to be measured. It is easy to understand but it is not efficient when data has extreme values.

- MAPE is also easy to understand and is used when different forecast models or datasets need to be compared because this is a percentage value. MAPE suffers from the same disadvantage as MAE, i.e., it is not efficient when data has extreme values.

- MSE is useful when spread of the forecast values is important and larger values need to be penalized. However, this metrics is often difficult to interpret because it is a squared value.

- RMSE (NRMSE) is also useful when spread is of importance and larger values need to be penalized. RMSE is easier to interpret when compared to MSE because the RMSE value is of the same scale as the forecasted values.

- WAPE is useful when dealing with low volume data as it is calculated by weighting the error over total true values.

- WMAPE is also useful when dealing with low volume data. WMAPE helps to incorporate the priority by utilizing the weight (priority value) of each observation.

Jedox provides a comprehensive overview of forecast errors and their distribution in the AIssisted™ Planning Wizard, and also an unbiased view into the future with predictive forecasting.

References

1 Error Metrics

2 Absolute Error Forecast Accuracy

3 Mean Squared Error

4 MAPE vs. WAPE (DE)

Your ultimate guide to strategic sales planning

A pillar of modern sales performance management

Jedox

Jedox is the world’s most adaptable planning and performance management platform that empowers organisations to deliver plans that outperform expectations. Over 2,500 organisations in 140 countries trust Jedox to model any scenario, integrate data from any source and simplify cross-organisational plans across all business systems. Jedox enables a culture of decisiveness and confidence so teams can plan for opportunities, react quickly to changes, and uncover what they didn’t know was possible.

Related Articles

Page load link

Go to Top

Есть 3 различных API для оценки качества прогнозов модели:

- Метод оценки оценщика : у оценщиков есть

scoreметод, обеспечивающий критерий оценки по умолчанию для проблемы, для решения которой они предназначены. Это обсуждается не на этой странице, а в документации каждого оценщика. - Параметр оценки: инструменты оценки модели с использованием перекрестной проверки (например,

model_selection.cross_val_scoreиmodel_selection.GridSearchCV) полагаются на внутреннюю стратегию оценки . Это обсуждается в разделе Параметр оценки: определение правил оценки модели . - Метрические функции : В

sklearn.metricsмодуле реализованы функции оценки ошибки прогноза для конкретных целей. Эти показатели подробно описаны в разделах по метрикам классификации , MultiLabel ранжирования показателей , показателей регрессии и показателей кластеризации .

Наконец, фиктивные оценки полезны для получения базового значения этих показателей для случайных прогнозов.

3.3.1. В scoring параметрах: определение правил оценки моделей

Выбор и оценка модели с использованием таких инструментов, как model_selection.GridSearchCV и model_selection.cross_val_score, принимают scoring параметр, который контролирует, какую метрику они применяют к оцениваемым оценщикам.

3.3.1.1. Общие случаи: предопределенные значения