From Wikipedia, the free encyclopedia

The base rate fallacy, also called base rate neglect[1] or base rate bias, is a type of fallacy in which people tend to ignore the base rate (i.e., general prevalence) in favor of the individuating information (i.e., information pertaining only to a specific case).[2]

Base rate neglect is a specific form of the more general extension neglect.

False positive paradox[edit]

An example of the base rate fallacy is the false positive paradox. This paradox describes situations where there are more false positive test results than true positives. For example, if a facial recognition camera can identify wanted criminals 99% accurately, but analyzes 10,000 people a day, the high accuracy is outweighed by the number of tests, and the program’s list of criminals will likely have far more false positives than true. The probability of a positive test result is determined not only by the accuracy of the test but also by the characteristics of the sampled population.[3] When the prevalence, the proportion of those who have a given condition, is lower than the test’s false positive rate, even tests that have a very low risk of giving a false positive in an individual case will give more false than true positives overall.[4] The paradox surprises most people.[5]

It is especially counter-intuitive when interpreting a positive result in a test on a low-prevalence population after having dealt with positive results drawn from a high-prevalence population.[4] If the false positive rate of the test is higher than the proportion of the new population with the condition, then a test administrator whose experience has been drawn from testing in a high-prevalence population may conclude from experience that a positive test result usually indicates a positive subject, when in fact a false positive is far more likely to have occurred.

Examples[edit]

Example 1: Disease[edit]

High-incidence population[edit]

| Number of people |

Infected | Uninfected | Total |

|---|---|---|---|

| Test positive |

400 (true positive) |

30 (false positive) |

430 |

| Test negative |

0 (false negative) |

570 (true negative) |

570 |

| Total | 400 | 600 | 1000 |

Imagine running an infectious disease test on a population A of 1000 persons, of which 40% are infected. The test has a false positive rate of 5% (0.05) and no false negative rate. The expected outcome of the 1000 tests on population A would be:

- Infected and test indicates disease (true positive)

- 1000 × 40/100 = 400 people would receive a true positive

- Uninfected and test indicates disease (false positive)

- 1000 × 100 – 40/100 × 0.05 = 30 people would receive a false positive

- The remaining 570 tests are correctly negative.

So, in population A, a person receiving a positive test could be over 93% confident (400/30 + 400) that it correctly indicates infection.

Low-incidence population[edit]

| Number of people |

Infected | Uninfected | Total |

|---|---|---|---|

| Test positive |

20 (true positive) |

49 (false positive) |

69 |

| Test negative |

0 (false negative) |

931 (true negative) |

931 |

| Total | 20 | 980 | 1000 |

Now consider the same test applied to population B, of which only 2% are infected. The expected outcome of 1000 tests on population B would be:

- Infected and test indicates disease (true positive)

- 1000 × 2/100 = 20 people would receive a true positive

- Uninfected and test indicates disease (false positive)

- 1000 × 100 – 2/100 × 0.05 = 49 people would receive a false positive

- The remaining 931 tests are correctly negative.

In population B, only 20 of the 69 total people with a positive test result are actually infected. So, the probability of actually being infected after one is told that one is infected is only 29% (20/20 + 49) for a test that otherwise appears to be «95% accurate».

A tester with experience of group A might find it a paradox that in group B, a result that had usually correctly indicated infection is now usually a false positive. The confusion of the posterior probability of infection with the prior probability of receiving a false positive is a natural error after receiving a health-threatening test result.

Example 2: Drunk drivers[edit]

- A group of police officers have breathalyzers displaying false drunkenness in 5% of the cases in which the driver is sober. However, the breathalyzers never fail to detect a truly drunk person. One in a thousand drivers is driving drunk. Suppose the police officers then stop a driver at random to administer a breathalyzer test. It indicates that the driver is drunk. We assume you do not know anything else about them. How high is the probability they really are drunk?

Many would answer as high as 95%, but the correct probability is about 2%.

An explanation for this is as follows: on average, for every 1,000 drivers tested,

- 1 driver is drunk, and it is 100% certain that for that driver there is a true positive test result, so there is 1 true positive test result

- 999 drivers are not drunk, and among those drivers there are 5% false positive test results, so there are 49.95 false positive test results

Therefore, the probability that one of the drivers among the 1 + 49.95 = 50.95 positive test results really is drunk is

The validity of this result does, however, hinge on the validity of the initial assumption that the police officer stopped the driver truly at random, and not because of bad driving. If that or another non-arbitrary reason for stopping the driver was present, then the calculation also involves the probability of a drunk driver driving competently and a non-drunk driver driving (in-)competently.

More formally, the same probability of roughly 0.02 can be established using Bayes’s theorem. The goal is to find the probability that the driver is drunk given that the breathalyzer indicated they are drunk, which can be represented as

where D means that the breathalyzer indicates that the driver is drunk. Bayes’s theorem tells us that

We were told the following in the first paragraph:

and

As you can see from the formula, one needs p(D) for Bayes’ theorem, which one can compute from the preceding values using the law of total probability:

which gives

Plugging these numbers into Bayes’ theorem, one finds that

Example 3: Terrorist identification[edit]

In a city of 1 million inhabitants, let there be 100 terrorists and 999,900 non-terrorists. To simplify the example, it is assumed that all people present in the city are inhabitants. Thus, the base rate probability of a randomly selected inhabitant of the city being a terrorist is 0.0001, and the base rate probability of that same inhabitant being a non-terrorist is 0.9999. In an attempt to catch the terrorists, the city installs an alarm system with a surveillance camera and automatic facial recognition software.

The software has two failure rates of 1%:

- The false negative rate: If the camera scans a terrorist, a bell will ring 99% of the time, and it will fail to ring 1% of the time.

- The false positive rate: If the camera scans a non-terrorist, a bell will not ring 99% of the time, but it will ring 1% of the time.

Suppose now that an inhabitant triggers the alarm. What is the probability that the person is a terrorist? In other words, what is P(T | B), the probability that a terrorist has been detected given the ringing of the bell? Someone making the ‘base rate fallacy’ would infer that there is a 99% probability that the detected person is a terrorist. Although the inference seems to make sense, it is actually bad reasoning, and a calculation below will show that the probability of a terrorist is actually near 1%, not near 99%.

The fallacy arises from confusing the natures of two different failure rates. The ‘number of non-bells per 100 terrorists’ and the ‘number of non-terrorists per 100 bells’ are unrelated quantities. One does not necessarily equal the other, and they don’t even have to be almost equal. To show this, consider what happens if an identical alarm system were set up in a second city with no terrorists at all. As in the first city, the alarm sounds for 1 out of every 100 non-terrorist inhabitants detected, but unlike in the first city, the alarm never sounds for a terrorist. Therefore, 100% of all occasions of the alarm sounding are for non-terrorists, but a false negative rate cannot even be calculated. The ‘number of non-terrorists per 100 bells’ in that city is 100, yet P(T | B) = 0%. There is zero chance that a terrorist has been detected given the ringing of the bell.

Imagine that the first city’s entire population of one million people pass in front of the camera. About 99 of the 100 terrorists will trigger the alarm—and so will about 9,999 of the 999,900 non-terrorists. Therefore, about 10,098 people will trigger the alarm, among which about 99 will be terrorists. The probability that a person triggering the alarm actually is a terrorist is only about 99 in 10,098, which is less than 1%, and very, very far below our initial guess of 99%.

The base rate fallacy is so misleading in this example because there are many more non-terrorists than terrorists, and the number of false positives (non-terrorists scanned as terrorists) is so much larger than the true positives (terrorists scanned as terrorists).

Multiple practitioners have argued that as the base rate of terrorism is extremely low, using data mining and predictive algorithms to identify terrorists cannot feasibly work due to the false positive paradox.[6][7][8][9] Estimates of the number of false positives for each accurate result vary from over ten thousand[9] to one billion;[7] consequently, investigating each lead would be cost and time prohibitive.[6][8] The level of accuracy required to make these models viable is likely unachievable. Foremost the low base rate of terrorism also means there is a lack of data with which to make an accurate algorithm.[8] Further, in the context of detecting terrorism false negatives are highly undesirable and thus must be minimised as much as possible, however this requires increasing sensitivity at the cost of specificity, increasing false positives.[9] It is also questionable whether the use of such models by law enforcement would meet the requisite burden of proof given that over 99% of results would be false positives.[9]

Findings in psychology[edit]

In experiments, people have been found to prefer individuating information over general information when the former is available.[10][11][12]

In some experiments, students were asked to estimate the grade point averages (GPAs) of hypothetical students. When given relevant statistics about GPA distribution, students tended to ignore them if given descriptive information about the particular student even if the new descriptive information was obviously of little or no relevance to school performance.[11] This finding has been used to argue that interviews are an unnecessary part of the college admissions process because interviewers are unable to pick successful candidates better than basic statistics.

Psychologists Daniel Kahneman and Amos Tversky attempted to explain this finding in terms of a simple rule or «heuristic» called representativeness. They argued that many judgments relating to likelihood, or to cause and effect, are based on how representative one thing is of another, or of a category.[11] Kahneman considers base rate neglect to be a specific form of extension neglect.[13] Richard Nisbett has argued that some attributional biases like the fundamental attribution error are instances of the base rate fallacy: people do not use the «consensus information» (the «base rate») about how others behaved in similar situations and instead prefer simpler dispositional attributions.[14]

There is considerable debate in psychology on the conditions under which people do or do not appreciate base rate information.[15][16] Researchers in the heuristics-and-biases program have stressed empirical findings showing that people tend to ignore base rates and make inferences that violate certain norms of probabilistic reasoning, such as Bayes’ theorem. The conclusion drawn from this line of research was that human probabilistic thinking is fundamentally flawed and error-prone.[17] Other researchers have emphasized the link between cognitive processes and information formats, arguing that such conclusions are not generally warranted.[18][19]

Consider again Example 2 from above. The required inference is to estimate the (posterior) probability that a (randomly picked) driver is drunk, given that the breathalyzer test is positive. Formally, this probability can be calculated using Bayes’ theorem, as shown above. However, there are different ways of presenting the relevant information. Consider the following, formally equivalent variant of the problem:

- 1 out of 1000 drivers are driving drunk. The breathalyzers never fail to detect a truly drunk person. For 50 out of the 999 drivers who are not drunk the breathalyzer falsely displays drunkenness. Suppose the policemen then stop a driver at random, and force them to take a breathalyzer test. It indicates that they are drunk. We assume you don’t know anything else about them. How high is the probability they really are drunk?

In this case, the relevant numerical information—p(drunk), p(D | drunk), p(D | sober)—is presented in terms of natural frequencies with respect to a certain reference class (see reference class problem). Empirical studies show that people’s inferences correspond more closely to Bayes’ rule when information is presented this way, helping to overcome base-rate neglect in laypeople[19] and experts.[20] As a consequence, organizations like the Cochrane Collaboration recommend using this kind of format for communicating health statistics.[21] Teaching people to translate these kinds of Bayesian reasoning problems into natural frequency formats is more effective than merely teaching them to plug probabilities (or percentages) into Bayes’ theorem.[22] It has also been shown that graphical representations of natural frequencies (e.g., icon arrays, hypothetical outcome plots) help people to make better inferences.[22][23][24][25]

Why are natural frequency formats helpful? One important reason is that this information format facilitates the required inference because it simplifies the necessary calculations. This can be seen when using an alternative way of computing the required probability p(drunk|D):

where N(drunk ∩ D) denotes the number of drivers that are drunk and get a positive breathalyzer result, and N(D) denotes the total number of cases with a positive breathalyzer result. The equivalence of this equation to the above one follows from the axioms of probability theory, according to which N(drunk ∩ D) = N × p (D | drunk) × p (drunk). Importantly, although this equation is formally equivalent to Bayes’ rule, it is not psychologically equivalent. Using natural frequencies simplifies the inference because the required mathematical operation can be performed on natural numbers, instead of normalized fractions (i.e., probabilities), because it makes the high number of false positives more transparent, and because natural frequencies exhibit a «nested-set structure».[26][27]

Not every frequency format facilitates Bayesian reasoning.[27][28] Natural frequencies refer to frequency information that results from natural sampling,[29] which preserves base rate information (e.g., number of drunken drivers when taking a random sample of drivers). This is different from systematic sampling, in which base rates are fixed a priori (e.g., in scientific experiments). In the latter case it is not possible to infer the posterior probability p (drunk | positive test) from comparing the number of drivers who are drunk and test positive compared to the total number of people who get a positive breathalyzer result, because base rate information is not preserved and must be explicitly re-introduced using Bayes’ theorem.

See also[edit]

- Base rate

- Bayesian probability

- Bayes’ theorem

- Data dredging

- Inductive argument

- List of cognitive biases

- List of paradoxes

- Misleading vividness

- Prevention paradox

- Prosecutor’s fallacy, a mistake in reasoning that involves ignoring a low prior probability

- Simpson’s paradox, another error in statistical reasoning dealing with comparing groups

- Stereotype

- Intuitive statistics

References[edit]

- ^ Welsh, Matthew B.; Navarro, Daniel J. (2012). «Seeing is believing: Priors, trust, and base rate neglect». Organizational Behavior and Human Decision Processes. 119 (1): 1–14. doi:10.1016/j.obhdp.2012.04.001. hdl:2440/41190. ISSN 0749-5978.

- ^ «Logical Fallacy: The Base Rate Fallacy». Fallacyfiles.org. Retrieved 2013-06-15.

- ^ Rheinfurth, M. H.; Howell, L. W. (March 1998). Probability and Statistics in Aerospace Engineering (PDF). NASA. p. 16.

MESSAGE: False positive tests are more probable than true positive tests when the overall population has a low prevalence of the disease. This is called the false-positive paradox.

- ^ a b Vacher, H. L. (May 2003). «Quantitative literacy — drug testing, cancer screening, and the identification of igneous rocks». Journal of Geoscience Education: 2.

At first glance, this seems perverse: the less the students as a whole use steroids, the more likely a student identified as a user will be a non-user. This has been called the False Positive Paradox

— Citing: Gonick, L.; Smith, W. (1993). The cartoon guide to statistics. New York: Harper Collins. p. 49. - ^ Madison, B. L. (August 2007). «Mathematical Proficiency for Citizenship». In Schoenfeld, A. H. (ed.). Assessing Mathematical Proficiency. Mathematical Sciences Research Institute Publications (New ed.). Cambridge University Press. p. 122. ISBN 978-0-521-69766-8.

The correct [probability estimate…] is surprising to many; hence, the term paradox.

- ^ a b Munk, Timme Bisgaard (1 September 2017). «100,000 false positives for every real terrorist: Why anti-terror algorithms don’t work». First Monday. 22 (9). doi:10.5210/fm.v22i9.7126.

- ^ a b Schneier, Bruce. «Why Data Mining Won’t Stop Terror». Wired. ISSN 1059-1028. Retrieved 2022-08-30.

- ^ a b c Jonas, Jeff; Harper, Jim (2006-12-11). «Effective Counterterrorism and the Limited Role of Predictive Data Mining». CATO Institute. Retrieved 2022-08-30.

- ^ a b c d Sageman, Marc (2021-02-17). «The Implication of Terrorism’s Extremely Low Base Rate». Terrorism and Political Violence. 33 (2): 302–311. doi:10.1080/09546553.2021.1880226. ISSN 0954-6553. S2CID 232341781.

- ^ Bar-Hillel, Maya (1980). «The base-rate fallacy in probability judgments» (PDF). Acta Psychologica. 44 (3): 211–233. doi:10.1016/0001-6918(80)90046-3.

- ^ a b c Kahneman, Daniel; Amos Tversky (1973). «On the psychology of prediction». Psychological Review. 80 (4): 237–251. doi:10.1037/h0034747. S2CID 17786757.

- ^ Kahneman, Daniel; Amos Tversky (1985). «Evidential impact of base rates». In Daniel Kahneman, Paul Slovic & Amos Tversky (ed.). Judgment under uncertainty: Heuristics and biases. Science. Vol. 185. pp. 153–160. Bibcode:1974Sci…185.1124T. doi:10.1126/science.185.4157.1124. PMID 17835457. S2CID 143452957.

- ^ Kahneman, Daniel (2000). «Evaluation by moments, past and future». In Daniel Kahneman and Amos Tversky (ed.). Choices, Values and Frames. ISBN 0-521-62749-4.

- ^ Nisbett, Richard E.; E. Borgida; R. Crandall; H. Reed (1976). «Popular induction: Information is not always informative». In J. S. Carroll & J. W. Payne (ed.). Cognition and social behavior. Vol. 2. pp. 227–236. ISBN 0-470-99007-4.

- ^ Koehler, J. J. (2010). «The base rate fallacy reconsidered: Descriptive, normative, and methodological challenges». Behavioral and Brain Sciences. 19: 1–17. doi:10.1017/S0140525X00041157. S2CID 53343238.

- ^ Barbey, A. K.; Sloman, S. A. (2007). «Base-rate respect: From ecological rationality to dual processes». Behavioral and Brain Sciences. 30 (3): 241–254, discussion 255–297. doi:10.1017/S0140525X07001653. PMID 17963533. S2CID 31741077.

- ^ Tversky, A.; Kahneman, D. (1974). «Judgment under Uncertainty: Heuristics and Biases». Science. 185 (4157): 1124–1131. Bibcode:1974Sci…185.1124T. doi:10.1126/science.185.4157.1124. PMID 17835457. S2CID 143452957.

- ^ Cosmides, Leda; John Tooby (1996). «Are humans good intuitive statisticians after all? Rethinking some conclusions of the literature on judgment under uncertainty». Cognition. 58: 1–73. CiteSeerX 10.1.1.131.8290. doi:10.1016/0010-0277(95)00664-8. S2CID 18631755.

- ^ a b Gigerenzer, G.; Hoffrage, U. (1995). «How to improve Bayesian reasoning without instruction: Frequency formats». Psychological Review. 102 (4): 684. CiteSeerX 10.1.1.128.3201. doi:10.1037/0033-295X.102.4.684.

- ^ Hoffrage, U.; Lindsey, S.; Hertwig, R.; Gigerenzer, G. (2000). «Medicine: Communicating Statistical Information». Science. 290 (5500): 2261–2262. doi:10.1126/science.290.5500.2261. hdl:11858/00-001M-0000-0025-9B18-3. PMID 11188724. S2CID 33050943.

- ^ Akl, E. A.; Oxman, A. D.; Herrin, J.; Vist, G. E.; Terrenato, I.; Sperati, F.; Costiniuk, C.; Blank, D.; Schünemann, H. (2011). Schünemann, Holger (ed.). «Using alternative statistical formats for presenting risks and risk reductions». The Cochrane Database of Systematic Reviews. 2011 (3): CD006776. doi:10.1002/14651858.CD006776.pub2. PMC 6464912. PMID 21412897.

- ^ a b Sedlmeier, P.; Gigerenzer, G. (2001). «Teaching Bayesian reasoning in less than two hours». Journal of Experimental Psychology: General. 130 (3): 380–400. doi:10.1037/0096-3445.130.3.380. hdl:11858/00-001M-0000-0025-9504-E. PMID 11561916.

- ^ Brase, G. L. (2009). «Pictorial representations in statistical reasoning». Applied Cognitive Psychology. 23 (3): 369–381. doi:10.1002/acp.1460. S2CID 18817707.

- ^ Edwards, A.; Elwyn, G.; Mulley, A. (2002). «Explaining risks: Turning numerical data into meaningful pictures». BMJ. 324 (7341): 827–830. doi:10.1136/bmj.324.7341.827. PMC 1122766. PMID 11934777.

- ^ Kim, Yea-Seul; Walls, Logan A.; Krafft, Peter; Hullman, Jessica (2 May 2019). «A Bayesian Cognition Approach to Improve Data Visualization». Proceedings of the 2019 CHI Conference on Human Factors in Computing Systems: 1–14. doi:10.1145/3290605.3300912. ISBN 9781450359702. S2CID 57761146.

- ^ Girotto, V.; Gonzalez, M. (2001). «Solving probabilistic and statistical problems: A matter of information structure and question form». Cognition. 78 (3): 247–276. doi:10.1016/S0010-0277(00)00133-5. PMID 11124351. S2CID 8588451.

- ^ a b Hoffrage, U.; Gigerenzer, G.; Krauss, S.; Martignon, L. (2002). «Representation facilitates reasoning: What natural frequencies are and what they are not». Cognition. 84 (3): 343–352. doi:10.1016/S0010-0277(02)00050-1. PMID 12044739. S2CID 9595672.

- ^ Gigerenzer, G.; Hoffrage, U. (1999). «Overcoming difficulties in Bayesian reasoning: A reply to Lewis and Keren (1999) and Mellers and McGraw (1999)». Psychological Review. 106 (2): 425. doi:10.1037/0033-295X.106.2.425. hdl:11858/00-001M-0000-0025-9CB4-8.

- ^ Kleiter, G. D. (1994). «Natural Sampling: Rationality without Base Rates». Contributions to Mathematical Psychology, Psychometrics, and Methodology. Recent Research in Psychology. pp. 375–388. doi:10.1007/978-1-4612-4308-3_27. ISBN 978-0-387-94169-1.

External links[edit]

- The Base Rate Fallacy The Fallacy Files

From Wikipedia, the free encyclopedia

The base rate fallacy, also called base rate neglect[1] or base rate bias, is a type of fallacy in which people tend to ignore the base rate (i.e., general prevalence) in favor of the individuating information (i.e., information pertaining only to a specific case).[2]

Base rate neglect is a specific form of the more general extension neglect.

False positive paradox[edit]

An example of the base rate fallacy is the false positive paradox. This paradox describes situations where there are more false positive test results than true positives. For example, if a facial recognition camera can identify wanted criminals 99% accurately, but analyzes 10,000 people a day, the high accuracy is outweighed by the number of tests, and the program’s list of criminals will likely have far more false positives than true. The probability of a positive test result is determined not only by the accuracy of the test but also by the characteristics of the sampled population.[3] When the prevalence, the proportion of those who have a given condition, is lower than the test’s false positive rate, even tests that have a very low risk of giving a false positive in an individual case will give more false than true positives overall.[4] The paradox surprises most people.[5]

It is especially counter-intuitive when interpreting a positive result in a test on a low-prevalence population after having dealt with positive results drawn from a high-prevalence population.[4] If the false positive rate of the test is higher than the proportion of the new population with the condition, then a test administrator whose experience has been drawn from testing in a high-prevalence population may conclude from experience that a positive test result usually indicates a positive subject, when in fact a false positive is far more likely to have occurred.

Examples[edit]

Example 1: Disease[edit]

High-incidence population[edit]

| Number of people |

Infected | Uninfected | Total |

|---|---|---|---|

| Test positive |

400 (true positive) |

30 (false positive) |

430 |

| Test negative |

0 (false negative) |

570 (true negative) |

570 |

| Total | 400 | 600 | 1000 |

Imagine running an infectious disease test on a population A of 1000 persons, of which 40% are infected. The test has a false positive rate of 5% (0.05) and no false negative rate. The expected outcome of the 1000 tests on population A would be:

- Infected and test indicates disease (true positive)

- 1000 × 40/100 = 400 people would receive a true positive

- Uninfected and test indicates disease (false positive)

- 1000 × 100 – 40/100 × 0.05 = 30 people would receive a false positive

- The remaining 570 tests are correctly negative.

So, in population A, a person receiving a positive test could be over 93% confident (400/30 + 400) that it correctly indicates infection.

Low-incidence population[edit]

| Number of people |

Infected | Uninfected | Total |

|---|---|---|---|

| Test positive |

20 (true positive) |

49 (false positive) |

69 |

| Test negative |

0 (false negative) |

931 (true negative) |

931 |

| Total | 20 | 980 | 1000 |

Now consider the same test applied to population B, of which only 2% are infected. The expected outcome of 1000 tests on population B would be:

- Infected and test indicates disease (true positive)

- 1000 × 2/100 = 20 people would receive a true positive

- Uninfected and test indicates disease (false positive)

- 1000 × 100 – 2/100 × 0.05 = 49 people would receive a false positive

- The remaining 931 tests are correctly negative.

In population B, only 20 of the 69 total people with a positive test result are actually infected. So, the probability of actually being infected after one is told that one is infected is only 29% (20/20 + 49) for a test that otherwise appears to be «95% accurate».

A tester with experience of group A might find it a paradox that in group B, a result that had usually correctly indicated infection is now usually a false positive. The confusion of the posterior probability of infection with the prior probability of receiving a false positive is a natural error after receiving a health-threatening test result.

Example 2: Drunk drivers[edit]

- A group of police officers have breathalyzers displaying false drunkenness in 5% of the cases in which the driver is sober. However, the breathalyzers never fail to detect a truly drunk person. One in a thousand drivers is driving drunk. Suppose the police officers then stop a driver at random to administer a breathalyzer test. It indicates that the driver is drunk. We assume you do not know anything else about them. How high is the probability they really are drunk?

Many would answer as high as 95%, but the correct probability is about 2%.

An explanation for this is as follows: on average, for every 1,000 drivers tested,

- 1 driver is drunk, and it is 100% certain that for that driver there is a true positive test result, so there is 1 true positive test result

- 999 drivers are not drunk, and among those drivers there are 5% false positive test results, so there are 49.95 false positive test results

Therefore, the probability that one of the drivers among the 1 + 49.95 = 50.95 positive test results really is drunk is

The validity of this result does, however, hinge on the validity of the initial assumption that the police officer stopped the driver truly at random, and not because of bad driving. If that or another non-arbitrary reason for stopping the driver was present, then the calculation also involves the probability of a drunk driver driving competently and a non-drunk driver driving (in-)competently.

More formally, the same probability of roughly 0.02 can be established using Bayes’s theorem. The goal is to find the probability that the driver is drunk given that the breathalyzer indicated they are drunk, which can be represented as

where D means that the breathalyzer indicates that the driver is drunk. Bayes’s theorem tells us that

We were told the following in the first paragraph:

and

As you can see from the formula, one needs p(D) for Bayes’ theorem, which one can compute from the preceding values using the law of total probability:

which gives

Plugging these numbers into Bayes’ theorem, one finds that

Example 3: Terrorist identification[edit]

In a city of 1 million inhabitants, let there be 100 terrorists and 999,900 non-terrorists. To simplify the example, it is assumed that all people present in the city are inhabitants. Thus, the base rate probability of a randomly selected inhabitant of the city being a terrorist is 0.0001, and the base rate probability of that same inhabitant being a non-terrorist is 0.9999. In an attempt to catch the terrorists, the city installs an alarm system with a surveillance camera and automatic facial recognition software.

The software has two failure rates of 1%:

- The false negative rate: If the camera scans a terrorist, a bell will ring 99% of the time, and it will fail to ring 1% of the time.

- The false positive rate: If the camera scans a non-terrorist, a bell will not ring 99% of the time, but it will ring 1% of the time.

Suppose now that an inhabitant triggers the alarm. What is the probability that the person is a terrorist? In other words, what is P(T | B), the probability that a terrorist has been detected given the ringing of the bell? Someone making the ‘base rate fallacy’ would infer that there is a 99% probability that the detected person is a terrorist. Although the inference seems to make sense, it is actually bad reasoning, and a calculation below will show that the probability of a terrorist is actually near 1%, not near 99%.

The fallacy arises from confusing the natures of two different failure rates. The ‘number of non-bells per 100 terrorists’ and the ‘number of non-terrorists per 100 bells’ are unrelated quantities. One does not necessarily equal the other, and they don’t even have to be almost equal. To show this, consider what happens if an identical alarm system were set up in a second city with no terrorists at all. As in the first city, the alarm sounds for 1 out of every 100 non-terrorist inhabitants detected, but unlike in the first city, the alarm never sounds for a terrorist. Therefore, 100% of all occasions of the alarm sounding are for non-terrorists, but a false negative rate cannot even be calculated. The ‘number of non-terrorists per 100 bells’ in that city is 100, yet P(T | B) = 0%. There is zero chance that a terrorist has been detected given the ringing of the bell.

Imagine that the first city’s entire population of one million people pass in front of the camera. About 99 of the 100 terrorists will trigger the alarm—and so will about 9,999 of the 999,900 non-terrorists. Therefore, about 10,098 people will trigger the alarm, among which about 99 will be terrorists. The probability that a person triggering the alarm actually is a terrorist is only about 99 in 10,098, which is less than 1%, and very, very far below our initial guess of 99%.

The base rate fallacy is so misleading in this example because there are many more non-terrorists than terrorists, and the number of false positives (non-terrorists scanned as terrorists) is so much larger than the true positives (terrorists scanned as terrorists).

Multiple practitioners have argued that as the base rate of terrorism is extremely low, using data mining and predictive algorithms to identify terrorists cannot feasibly work due to the false positive paradox.[6][7][8][9] Estimates of the number of false positives for each accurate result vary from over ten thousand[9] to one billion;[7] consequently, investigating each lead would be cost and time prohibitive.[6][8] The level of accuracy required to make these models viable is likely unachievable. Foremost the low base rate of terrorism also means there is a lack of data with which to make an accurate algorithm.[8] Further, in the context of detecting terrorism false negatives are highly undesirable and thus must be minimised as much as possible, however this requires increasing sensitivity at the cost of specificity, increasing false positives.[9] It is also questionable whether the use of such models by law enforcement would meet the requisite burden of proof given that over 99% of results would be false positives.[9]

Findings in psychology[edit]

In experiments, people have been found to prefer individuating information over general information when the former is available.[10][11][12]

In some experiments, students were asked to estimate the grade point averages (GPAs) of hypothetical students. When given relevant statistics about GPA distribution, students tended to ignore them if given descriptive information about the particular student even if the new descriptive information was obviously of little or no relevance to school performance.[11] This finding has been used to argue that interviews are an unnecessary part of the college admissions process because interviewers are unable to pick successful candidates better than basic statistics.

Psychologists Daniel Kahneman and Amos Tversky attempted to explain this finding in terms of a simple rule or «heuristic» called representativeness. They argued that many judgments relating to likelihood, or to cause and effect, are based on how representative one thing is of another, or of a category.[11] Kahneman considers base rate neglect to be a specific form of extension neglect.[13] Richard Nisbett has argued that some attributional biases like the fundamental attribution error are instances of the base rate fallacy: people do not use the «consensus information» (the «base rate») about how others behaved in similar situations and instead prefer simpler dispositional attributions.[14]

There is considerable debate in psychology on the conditions under which people do or do not appreciate base rate information.[15][16] Researchers in the heuristics-and-biases program have stressed empirical findings showing that people tend to ignore base rates and make inferences that violate certain norms of probabilistic reasoning, such as Bayes’ theorem. The conclusion drawn from this line of research was that human probabilistic thinking is fundamentally flawed and error-prone.[17] Other researchers have emphasized the link between cognitive processes and information formats, arguing that such conclusions are not generally warranted.[18][19]

Consider again Example 2 from above. The required inference is to estimate the (posterior) probability that a (randomly picked) driver is drunk, given that the breathalyzer test is positive. Formally, this probability can be calculated using Bayes’ theorem, as shown above. However, there are different ways of presenting the relevant information. Consider the following, formally equivalent variant of the problem:

- 1 out of 1000 drivers are driving drunk. The breathalyzers never fail to detect a truly drunk person. For 50 out of the 999 drivers who are not drunk the breathalyzer falsely displays drunkenness. Suppose the policemen then stop a driver at random, and force them to take a breathalyzer test. It indicates that they are drunk. We assume you don’t know anything else about them. How high is the probability they really are drunk?

In this case, the relevant numerical information—p(drunk), p(D | drunk), p(D | sober)—is presented in terms of natural frequencies with respect to a certain reference class (see reference class problem). Empirical studies show that people’s inferences correspond more closely to Bayes’ rule when information is presented this way, helping to overcome base-rate neglect in laypeople[19] and experts.[20] As a consequence, organizations like the Cochrane Collaboration recommend using this kind of format for communicating health statistics.[21] Teaching people to translate these kinds of Bayesian reasoning problems into natural frequency formats is more effective than merely teaching them to plug probabilities (or percentages) into Bayes’ theorem.[22] It has also been shown that graphical representations of natural frequencies (e.g., icon arrays, hypothetical outcome plots) help people to make better inferences.[22][23][24][25]

Why are natural frequency formats helpful? One important reason is that this information format facilitates the required inference because it simplifies the necessary calculations. This can be seen when using an alternative way of computing the required probability p(drunk|D):

where N(drunk ∩ D) denotes the number of drivers that are drunk and get a positive breathalyzer result, and N(D) denotes the total number of cases with a positive breathalyzer result. The equivalence of this equation to the above one follows from the axioms of probability theory, according to which N(drunk ∩ D) = N × p (D | drunk) × p (drunk). Importantly, although this equation is formally equivalent to Bayes’ rule, it is not psychologically equivalent. Using natural frequencies simplifies the inference because the required mathematical operation can be performed on natural numbers, instead of normalized fractions (i.e., probabilities), because it makes the high number of false positives more transparent, and because natural frequencies exhibit a «nested-set structure».[26][27]

Not every frequency format facilitates Bayesian reasoning.[27][28] Natural frequencies refer to frequency information that results from natural sampling,[29] which preserves base rate information (e.g., number of drunken drivers when taking a random sample of drivers). This is different from systematic sampling, in which base rates are fixed a priori (e.g., in scientific experiments). In the latter case it is not possible to infer the posterior probability p (drunk | positive test) from comparing the number of drivers who are drunk and test positive compared to the total number of people who get a positive breathalyzer result, because base rate information is not preserved and must be explicitly re-introduced using Bayes’ theorem.

See also[edit]

- Base rate

- Bayesian probability

- Bayes’ theorem

- Data dredging

- Inductive argument

- List of cognitive biases

- List of paradoxes

- Misleading vividness

- Prevention paradox

- Prosecutor’s fallacy, a mistake in reasoning that involves ignoring a low prior probability

- Simpson’s paradox, another error in statistical reasoning dealing with comparing groups

- Stereotype

- Intuitive statistics

References[edit]

- ^ Welsh, Matthew B.; Navarro, Daniel J. (2012). «Seeing is believing: Priors, trust, and base rate neglect». Organizational Behavior and Human Decision Processes. 119 (1): 1–14. doi:10.1016/j.obhdp.2012.04.001. hdl:2440/41190. ISSN 0749-5978.

- ^ «Logical Fallacy: The Base Rate Fallacy». Fallacyfiles.org. Retrieved 2013-06-15.

- ^ Rheinfurth, M. H.; Howell, L. W. (March 1998). Probability and Statistics in Aerospace Engineering (PDF). NASA. p. 16.

MESSAGE: False positive tests are more probable than true positive tests when the overall population has a low prevalence of the disease. This is called the false-positive paradox.

- ^ a b Vacher, H. L. (May 2003). «Quantitative literacy — drug testing, cancer screening, and the identification of igneous rocks». Journal of Geoscience Education: 2.

At first glance, this seems perverse: the less the students as a whole use steroids, the more likely a student identified as a user will be a non-user. This has been called the False Positive Paradox

— Citing: Gonick, L.; Smith, W. (1993). The cartoon guide to statistics. New York: Harper Collins. p. 49. - ^ Madison, B. L. (August 2007). «Mathematical Proficiency for Citizenship». In Schoenfeld, A. H. (ed.). Assessing Mathematical Proficiency. Mathematical Sciences Research Institute Publications (New ed.). Cambridge University Press. p. 122. ISBN 978-0-521-69766-8.

The correct [probability estimate…] is surprising to many; hence, the term paradox.

- ^ a b Munk, Timme Bisgaard (1 September 2017). «100,000 false positives for every real terrorist: Why anti-terror algorithms don’t work». First Monday. 22 (9). doi:10.5210/fm.v22i9.7126.

- ^ a b Schneier, Bruce. «Why Data Mining Won’t Stop Terror». Wired. ISSN 1059-1028. Retrieved 2022-08-30.

- ^ a b c Jonas, Jeff; Harper, Jim (2006-12-11). «Effective Counterterrorism and the Limited Role of Predictive Data Mining». CATO Institute. Retrieved 2022-08-30.

- ^ a b c d Sageman, Marc (2021-02-17). «The Implication of Terrorism’s Extremely Low Base Rate». Terrorism and Political Violence. 33 (2): 302–311. doi:10.1080/09546553.2021.1880226. ISSN 0954-6553. S2CID 232341781.

- ^ Bar-Hillel, Maya (1980). «The base-rate fallacy in probability judgments» (PDF). Acta Psychologica. 44 (3): 211–233. doi:10.1016/0001-6918(80)90046-3.

- ^ a b c Kahneman, Daniel; Amos Tversky (1973). «On the psychology of prediction». Psychological Review. 80 (4): 237–251. doi:10.1037/h0034747. S2CID 17786757.

- ^ Kahneman, Daniel; Amos Tversky (1985). «Evidential impact of base rates». In Daniel Kahneman, Paul Slovic & Amos Tversky (ed.). Judgment under uncertainty: Heuristics and biases. Science. Vol. 185. pp. 153–160. Bibcode:1974Sci…185.1124T. doi:10.1126/science.185.4157.1124. PMID 17835457. S2CID 143452957.

- ^ Kahneman, Daniel (2000). «Evaluation by moments, past and future». In Daniel Kahneman and Amos Tversky (ed.). Choices, Values and Frames. ISBN 0-521-62749-4.

- ^ Nisbett, Richard E.; E. Borgida; R. Crandall; H. Reed (1976). «Popular induction: Information is not always informative». In J. S. Carroll & J. W. Payne (ed.). Cognition and social behavior. Vol. 2. pp. 227–236. ISBN 0-470-99007-4.

- ^ Koehler, J. J. (2010). «The base rate fallacy reconsidered: Descriptive, normative, and methodological challenges». Behavioral and Brain Sciences. 19: 1–17. doi:10.1017/S0140525X00041157. S2CID 53343238.

- ^ Barbey, A. K.; Sloman, S. A. (2007). «Base-rate respect: From ecological rationality to dual processes». Behavioral and Brain Sciences. 30 (3): 241–254, discussion 255–297. doi:10.1017/S0140525X07001653. PMID 17963533. S2CID 31741077.

- ^ Tversky, A.; Kahneman, D. (1974). «Judgment under Uncertainty: Heuristics and Biases». Science. 185 (4157): 1124–1131. Bibcode:1974Sci…185.1124T. doi:10.1126/science.185.4157.1124. PMID 17835457. S2CID 143452957.

- ^ Cosmides, Leda; John Tooby (1996). «Are humans good intuitive statisticians after all? Rethinking some conclusions of the literature on judgment under uncertainty». Cognition. 58: 1–73. CiteSeerX 10.1.1.131.8290. doi:10.1016/0010-0277(95)00664-8. S2CID 18631755.

- ^ a b Gigerenzer, G.; Hoffrage, U. (1995). «How to improve Bayesian reasoning without instruction: Frequency formats». Psychological Review. 102 (4): 684. CiteSeerX 10.1.1.128.3201. doi:10.1037/0033-295X.102.4.684.

- ^ Hoffrage, U.; Lindsey, S.; Hertwig, R.; Gigerenzer, G. (2000). «Medicine: Communicating Statistical Information». Science. 290 (5500): 2261–2262. doi:10.1126/science.290.5500.2261. hdl:11858/00-001M-0000-0025-9B18-3. PMID 11188724. S2CID 33050943.

- ^ Akl, E. A.; Oxman, A. D.; Herrin, J.; Vist, G. E.; Terrenato, I.; Sperati, F.; Costiniuk, C.; Blank, D.; Schünemann, H. (2011). Schünemann, Holger (ed.). «Using alternative statistical formats for presenting risks and risk reductions». The Cochrane Database of Systematic Reviews. 2011 (3): CD006776. doi:10.1002/14651858.CD006776.pub2. PMC 6464912. PMID 21412897.

- ^ a b Sedlmeier, P.; Gigerenzer, G. (2001). «Teaching Bayesian reasoning in less than two hours». Journal of Experimental Psychology: General. 130 (3): 380–400. doi:10.1037/0096-3445.130.3.380. hdl:11858/00-001M-0000-0025-9504-E. PMID 11561916.

- ^ Brase, G. L. (2009). «Pictorial representations in statistical reasoning». Applied Cognitive Psychology. 23 (3): 369–381. doi:10.1002/acp.1460. S2CID 18817707.

- ^ Edwards, A.; Elwyn, G.; Mulley, A. (2002). «Explaining risks: Turning numerical data into meaningful pictures». BMJ. 324 (7341): 827–830. doi:10.1136/bmj.324.7341.827. PMC 1122766. PMID 11934777.

- ^ Kim, Yea-Seul; Walls, Logan A.; Krafft, Peter; Hullman, Jessica (2 May 2019). «A Bayesian Cognition Approach to Improve Data Visualization». Proceedings of the 2019 CHI Conference on Human Factors in Computing Systems: 1–14. doi:10.1145/3290605.3300912. ISBN 9781450359702. S2CID 57761146.

- ^ Girotto, V.; Gonzalez, M. (2001). «Solving probabilistic and statistical problems: A matter of information structure and question form». Cognition. 78 (3): 247–276. doi:10.1016/S0010-0277(00)00133-5. PMID 11124351. S2CID 8588451.

- ^ a b Hoffrage, U.; Gigerenzer, G.; Krauss, S.; Martignon, L. (2002). «Representation facilitates reasoning: What natural frequencies are and what they are not». Cognition. 84 (3): 343–352. doi:10.1016/S0010-0277(02)00050-1. PMID 12044739. S2CID 9595672.

- ^ Gigerenzer, G.; Hoffrage, U. (1999). «Overcoming difficulties in Bayesian reasoning: A reply to Lewis and Keren (1999) and Mellers and McGraw (1999)». Psychological Review. 106 (2): 425. doi:10.1037/0033-295X.106.2.425. hdl:11858/00-001M-0000-0025-9CB4-8.

- ^ Kleiter, G. D. (1994). «Natural Sampling: Rationality without Base Rates». Contributions to Mathematical Psychology, Psychometrics, and Methodology. Recent Research in Psychology. pp. 375–388. doi:10.1007/978-1-4612-4308-3_27. ISBN 978-0-387-94169-1.

External links[edit]

- The Base Rate Fallacy The Fallacy Files

Когнитивные искажения (от лат. cognitiо «познание») – это то, что касается каждого человека вне зависимости от уровня его образования и социального положения.

Наш мозг – это главный орган центральной нервной системы, загадка которого не разгадана учеными до сих пор. Он содержит около 86 миллиардов нейронов, которые регулируют всю деятельность человека.

Наверное, и неудивительно, что мозг иногда обманывает нас, так что порой кажется, что он живет отдельной жизнью.

Так это или нет – мы, возможно, узнаем в будущем, а пока давайте рассмотрим наиболее частые когнитивные искажения, или ошибки мышления, которые встречаются в жизни каждого.

Это поможет вам не только осознать причины тех или иных своих действий, но и даст понимание некоторых поступков окружающих вас людей.

Ошибки мышления

Данная статья будет интересна не только любителям психологии, но и всем, кому интересно саморазвитие.

-

Ошибка базового процента

Довольно часто мы игнорируем реальную статистику, отдавая предпочтение собственному опыту. Например, вы обратились в автосервис, который, в конечном счете, не смог починить вашу машину.

После этого ваш мозг будет считать данный сервис плохим даже несмотря на то, что вам достоверно известно о сотнях машин, которые были там полностью отремонтированы. Ничего не поделаешь, личный опыт для мозга важнее статистики.

-

Отклонение внимания

Мозгу свойственно замечать только то, что вам нравится, или что вас интересует. Например, если вы парикмахер, то новая прическа вашего коллеги будет тут же детально изучена, в то время как другие даже не обратят на нее внимание.

Если вы любите модные бренды, то любая новая сумка знакомого вызовет у вас интерес. То же самое касается и праздников. Так что если вас кто-то не поздравил, не спешите обижаться, – наверняка это было сделано не намеренно. Все дело в когнитивном искажении под названием «Отклонение внимания».

-

Феномен «Дверь в лицо»

Известный американский психолог Роберт Чалдини рассказывал, как однажды на улице к нему подошёл мальчик и предложил купить билеты на какое-то мероприятие. Один билет стоил 5 долларов.

Чалдини вежливо отказался. Тогда мальчик предложил ему купить плитки шоколада всего лишь по доллару за штуку. После того как Чалдини купил пару плиток, он осознал, что им манипулировали, так как:

- он не любит шоколад и ему нужны деньги;

- он остался с двумя ненужными ему шоколадками и без денег.

Чалдини отправился на встречу с коллегами, с которыми обсудил произошедшее. В результате совещания была разработана серия экспериментов, позже ставшая классической.

Итак, «Дверь в лицо» – это социально-психологический феномен, который заключается в том, что люди склонны идти на уступку и соглашаться с малопривлекательным предложением в том случае, если оно им предлагается сразу после их отказа от другой более тяжелой просьбы.

-

Иллюзия частоты

Мозг не замечает многие вещи, которые нас окружают до тех пор, пока они нас не заинтересуют. Например, вам нужно купить детскую коляску, и вы остановились на каком-то бренде.

Внезапно вы обнаруживаете, что колясок этого бренда начало встречаться очень много. Это иллюзия. На самом деле просто вы начали обращать на них внимание, а не они резко распространились. Таковы результаты когнитивного искажения.

-

Эффект мнимой правды

Это один из самых популярных инструментов пропаганды во всем мире. Давно известно, что если повторять ложь достаточно долго, достаточно громко и достаточно часто – люди начнут верить лжи.

Если человеку 100 раз сказать, что он свинья, то на 101раз он захрюкает.

Умельцы весьма эффективно применяют этот феномен. Приведем безобидный пример. Некто хочет, чтобы его считали умным, поэтому он, цитирует, допустим, древнегреческого философа:

– Как говорил Протагор – «Человек есть мера всех вещей».

В следующий раз он повторяет это несколько иначе:

– Как я говорил в прошлый раз, – «Человек есть мера всех вещей».

И, наконец, в третий раз он заявляет:

– Как я обычно говорю, – «Человек есть мера всех вещей».

Вроде бы все правильно, но используя это когнитивное искажение, вам навязали ложную мысль, будто автором фразы является этот Некто, который хочет, чтобы его считали умным.

-

Эффект знакомства с объектом

Пожалуй, вся реклама, существующая в мире, работает на этот эффект мышления. Дело в том, что из нескольких незнакомых объектов мы обязательно отдадим предпочтение тому, о котором знаем хотя бы что-то.

Например, вам нужен крем для рук. Придя в магазин, вы почти наверняка возьмете тот крем, о котором хотя бы раз где-то слышали (например, в рекламе), чем тот, о котором вы вообще ничего не знаете.

-

Эвристика доступности

Наверняка у многих бывали такие случаи, когда знакомый уезжал в столицу и умело там пристраивался, вследствие чего у вас формировалось убеждение, что все жители столицы – это хорошо обеспеченные люди, работающие в крутых компаниях.

Так вот эта ошибка мышления возникает потому, что наш мозг оценивает частоту или возможность события по легкости, с которой примеры или случаи приходят на ум, т. е. легче вспоминаются.

Или, например, человек оценивает степень риска возникновения инфаркта у людей среднего возраста, припоминая подобные случаи среди своих знакомых.

-

Эффект контекста

Эффект контекста используется маркетологами для того, чтобы спровоцировать вас на покупку чего-то, что вам вовсе не нужно. Именно поэтому выкладка товара в магазине делается не просто для удобства, а с обязательным использованием эффекта контекста.

Одна дама сумела чрезвычайно выгодно продать свою квартиру потому, что перед приездом покупателя она готовила ароматные сдобные булочки. Входя в свою потенциальную квартиру, клиент ощущал тепло и такой приятный домашний аромат, что мозг просто не мог не попасть в ловушку контекста.

Таким образом, при помощи этого нехитрого когнитивного искажения ловкая барышня сумела провернуть выгодную сделку.

-

Склонность к негативу

Мы подсознательно переоцениваем значение отрицательных вещей. Собственно именно по этой причине плохие новости всегда будут иметь гораздо бо́льшую аудиторию, чем хорошие.

Не случайно слова журналистки известной новостной службы «Редакция требует крови!» стали мемом и вовсе не так далеки от действительности. Редакции действительно нужно «больше крови», так как это гарантирует кратное увеличение просмотров.

-

Эффект якоря

Эффект якоря – это особенность оценки числовых значений, которая смещает оценку в сторону начального приближения.

Например, вам нужно купить пальто. Вы заходите в магазин, находите подходящую вам модель, а после примерки узнаете, что она стоит 500$. Для вас это дорого, и вы уже собираетесь уходить, как вдруг к вам подбегает консультант.

Уточнив, подошло ли вам пальто, консультант говорит, что это уникальная серия, состоящая из всего 80 экземпляров. Более того, на эту модель сегодня действует скидка «Минус 50%».

Именно здесь и срабатывает эффект якоря, роль которого в данном случае играет число 500. С большой долей вероятности клиент в такой ситуации совершит покупку, даже не задумываясь о том, что для такого пальто даже 250$ – большая цена.

Интересен факт, что эффект якоря работает вне зависимости от того, знаете вы о нем, или нет. То же самое наблюдается и с правилом взаимного обмена.

-

Эффект фрейминга

Эффект фрейминга (от англ. frame рамка, обрамление) – это когнитивное искажение, при котором форма подачи информации влияет на ее восприятие человеком.

В качестве классического примера данного эффекта нередко приводят выражение: «Стакан наполовину пуст или наполовину полон». Речь идет об одном и том же явлении, но отношение к нему из-за подачи информации меняется.

В одном из экспериментов участникам показывали видеозаписи с автомобильными авариями. После этого им задавали вопрос: «С какой скоростью ехали машины, когда столкнулись друг с другом?».

В каждой группе вопросы немного отличались: глагол «столкнулись» заменялся на «врезались», «налетели», «задели», «ударились».

В результате было установлено, что изменения в постановке вопроса оказывали влияние на оценку скорости автомобилей, несмотря на то, что всем респондентам показывали один и тот же ролик.

-

Восприятие выбора

Замечено, что сначала мы делаем выбор, а потом мозг пытается его оправдать. Причем чем бессмысленнее выбор, тем больше мы его защищаем.

В качестве примера можно привести попытки найти неявные плюсы в покупке и тем самым её оправдать при наличии другого, более подходящего товара, который по каким-то причинам не был приобретён.

К слову сказать, именно по этому принципу работают деструктивные секты и различные финансовые пирамиды. В какой-то степени этот эффект похож на стокгольмский синдром, когда жертва оправдывает агрессора. Кстати, мы уже рассказывали про 10 необычных психических синдромов в отдельной статье.

-

Предпочтение нулевого риска

Это предпочтение контролируемой, но потенциально более вредоносной (вследствие более частого её возникновения) ситуации перед обратной.

Происходит это по причине переоценки возможности контроля. То есть человек со своей стороны считает, что он полностью избавляется от риска (на самом деле не имея полного контроля), в то время как со стороны статистики это является снижением до нуля лишь одного, причем не самого большого риска.

Например, большинство людей предпочли бы уменьшить вероятность терактов до нуля вместо снижения аварийности на дорогах, даже несмотря на то, что второй эффект давал бы гораздо больше сохранённых жизней.

Или другой пример – ятрофобия (боязнь врачей). Многие люди боятся осложнений медицинских вмешательств больше, чем заболевания и смерти в результате самих этих заболеваний, которые возникают из-за отсутствия лечения.

-

Эффект морального доверия

Человек, относительно которого известно, что у него нет предубеждений, имеет в будущем большие шансы проявить эти предубеждения.

Иными словами, если все (в том числе и он сам) считают человека безгрешным, то возникает иллюзия, что любое его действие также будет безгрешным.

-

Селективное восприятие

Селективное восприятие (лат. selectio «выбирать») – это склонность людей уделять внимание тем элементам окружения, которые согласуются с их ожиданиями, и игнорировать остальные.

В классическом эксперименте зрители просматривали видео особо ожесточённого матча по американскому футболу между Принстонским университетом и Дартмутским колледжем.

Зрители из Принстона заметили почти в два раза больше нарушений, совершённых дартмутской командой, чем зрители из Дартмута. Один зритель из Дартмута вовсе не заметил ни одного нарушения со стороны «своей» команды.

Это когнитивное искажение также играет огромную роль в психологии рекламы.

-

Слепое пятно в отношении искажений

Последняя ошибка мышления, или когнитивное искажение, которое мы рассмотрим, – это слепое пятно в отношении искажений.

Это не что иное, как более лёгкое обнаружение недостатков у других людей, нежели у себя. То есть, все перечисленные когнитивные искажения присутствуют у каждого человека, однако мы «в чужом глазу видим соринку, а в своём и бревна не замечаем».

Наверняка и после прочтения этой статьи у большинства зрителей появится ощущение, что я, дескать, знаю все это и так, и, конечно же, меня все эти когнитивные искажения не касаются. На самом же деле они касаются всех.

Но теперь возникает закономерный вопрос: что же делать со всеми этими ошибками? Ответ прост: перечитывайте статью и вникайте в суть перечисленных когнитивных искажений или ошибок мышления.

Чем больше вы будете осознавать факт существования когнитивных искажений, тем больше вероятность, что вы будете принимать правильные решения и делать верный выбор.

Теперь вы знаете, что такое когнитивные искажения и как они влияют на нашу жизнь. Если вам понравилась статья, – поделитесь ею с друзьями и подписывайтесь на сайт interesnyefakty.org. С нами всегда интересно!

Понравился пост? Нажми любую кнопку:

Содержание

Введение. О чем эта статья

Цели и дисклеймеры

Часть 1. Хороший продукт

Часть 2. Пользовательский опыт (UX). Что это?

Часть 3. Архитектура выбора

Часть 4. Архитектор выбора

Часть 5. Когнитивные искажения и Пользовательский опыт

Ссылка на полную версию UX CORE (105 примеров использования когнитивных искажений в менеджменте команд и продуктов)

Часть 6. Наши дни

Часть 7. Не только искажения

Часть 8. Эпилог

Часть 9. Материал, качественно дополняющий эту статью

Введение. О чем эта статья

В этой статье мы поговорим о когнитивной психологии, поведенческой экономике и об ошибках (искажениях) нашего мозга. Мы посмотрим как понимание ошибок мозга и моделей человеческого поведения может помочь нам обеспечить высококачественный пользовательский опыт (UX) в цифровых продуктах. В основном, мы поговорим о программном обеспечении для мобайл и десктоп платформ. Внимательный же читатель сможет применить эти знания широко за рамками как этих платформ, так и программного обеспечения вообще.

Последние десять лет моим основным хобби было изучение того, как люди принимают решения. Этот путь привел меня к изучению широкого спектра когнитивных наук, в частности, когнитивной психологии и неврологии.

В какой-то момент своей жизни я перепрофилировался из технического специалиста в IT-сфере, коим я проработал около 6 лет (LAN/WAN/DevOps/InfoSec), в Product Manager-а. Моей основной деятельностью на этой должности является анализ ожиданий и принятых решений пользователей с целью создания более комфортного и желанного продукта.

Проверка и оценка практической пользы информации этой статьи заняла около пяти лет работы в разных компаниях и проектах различной степени сложности (от вебсайтов-визиток, до разработки первой в мире левитирующей камеры, экосистемы для киберспортивных дисциплин, тотализатор для киберспорта, ПО для гражданской авиации и крупнейшей в мире платформы цифрового издательства). В сумме я проработал более чем с сотней специалистов различного профессионального уровня, что принесло колоссальную пользу в виде ряда подтвержденных и опровергнутых концептов; лишь полезная часть которых будет описана далее.

Цели и дисклеймеры

Изложенный здесь материал лучше всего будет понятен опытным специалистам в IT-сфере, занимающимися разработкой и дизайном ПО на регулярной основе. Тем не менее, пользу от этого материала почерпнет любой читатель вне зависимости от рода деятельности.

Цели, которыми я задаюсь в этой статье выглядят так:

- показать четкие доказательства важности глубоких знаний в психологии для работы в качестве менеджера по продукту;

- дать определение понятию UX (Пользовательский опыт) с позиции психологии и поделиться наиважнейшим источником знаний для создания качественного UX;

- показать механизм оценки «грамотности» продакт менеджеров (и не только);

- побудить инвесторов больше инвестировать в продукты, в основе которых лежит когнитивная психология и поведенческая экономика;

- предоставить продакт менеджерам дополнительные аргументы в поддержку их идей, которые, часто являясь верными, увы, блокируются техническими специалистами из-за непонимания полной картины и «технического» склада ума;

- показать с другого угла «скучные» исследования, которые «пылятся» на полках библиотек, акцентируя чрезвычайную важность этих материалов для будущего разработки ПО;

- побудить психологов и экономистов взглянуть в сторону продакт менеджмента как возможной опции смены карьерного направления. Мир IT нуждается в вас гораздо больше, чем в диванных аналитиках и псведо-менеджерах с MBA и PMP.

Я намеренно опускаю такие бизнес вопросы как «целесообразность создания продукта», «анализ рынка», «анализ конкурентов» и прочие, так как они имеют мало общего с UX. Продукт может быть качественным вне зависимости от спроса, от целесообразности его выпуска на рынок и силы конкурентов.

Я с глубоким уважением отношусь ко всем, чьи имена появляются в этой статье. Я бесконечно рад возможности ознакомиться с трудами, мыслями и идеями этих людей.

Размер статьи выдался куда больше, чем я ожидал. Тем не менее, вы получите доступ к синопсисам наиважнейших исследований в неврологии и когнитивных науках, проведенных за последние 70 с лишним лет. Детальное изучение этих исследований и сопоставление их с условиями «реального мира» заняло бы у вас, по меньшей мере, два года регулярного обучения.

Часть 1. Хороший продукт

Мы не будем вдаваться в абстрактные рассуждения о том, что такое продукт, а-ля «это то, что приносит пользу его владельцу, рынку и конечным потребителям». Много людей будут не согласны с идеей, что качественный продукт может оставаться качественным даже провалившись на рынке, поэтому я отдельно скажу пару слов об этом.

Итак, чуть выше я убрал вопросы про рынки, конкурентов и целесообразность продукта, потому что я исхожу из того, что качественный продукт – это, прежде всего, продукт без внутренних противоречий. Такой продукт идеально связан как «идеологическими» его составляющими (история создания, его миссия, все использованные изображения, текстовые и печатные материалы используемые для его разработки и продвижения и прочее), так и техническими (back end, пользовательский интерфейс, элементы взаимодействия и дизайн, бизнес цвета, инструкции для работы службы поддержки клиентов, tone of voice of the company и много другого).

При всем при этом важно понимать, что качественный продукт может выйти на рынок, оказаться никому не нужным, стать историей и тем не менее быть качественным продуктом.

Причин неудачи может быть широкое множество, например:

- неудачный тайминг (изменилась коньюнктура на рынке, люди еще не осознали всю серьезность проблемы, решаемой продуктом и т.п.);

- человеческий фактор (утечки внутри компании, уборщица, опрокинувшая ведро рядом с серверами в день релиза и т.п.);

- слабые управленческие навыки руководства (основатели компании слишком поздно начали обсуждать распределение прибыли, что создало конфликты; чрезмерный нажим на команду разработчиков повлек массовые увольнения и сорвал переговоры об инвестировании и пр.)

- банальное невезение, важность которого повально игнорируется как новичками, так и экспертами в бизнесе (Черные Лебеди Н. Нассима Талеба).

Поэтому, для того, чтобы не вдаваться в унылые философские спекуляции по бизнес вопросам, в этой статье мы будем о них помнить, временами будем к ним «прикасаться», но не будем на них фокусироваться.

Часть 2. Пользовательский Опыт (UX). Что это?

Так как на данный момент понятие UX гораздо чаще относят к UI дизайну, моим «оппонентом» в обсуждении данного вопроса будет Джо Натоли. Джо — ветеран-дизайнер с опытом работы более 30 лет, один из самых популярных в мире IT экспертов по UXD (User Experience Design), автор ряда книг, а также самых популярных видео-курсов по UX на Udemy. Натоли провел более тридцати лет консультируя по вопросам дизайна пользовательского опыта (UXD) компании из списка Fortune 100, 500 и правительственные организации. На своем вебсайте он называет себя «User Experience Evangelist», значит, я могу ссылаться на его утверждения, высказанные публично в его книгах и видеоуроках.

В одном из своих уроков, где господин Натоли объясняет понятие User Experience, он ссылается на Питера Мерхольца:

«Питер Мерхольц, который является деловым партнером Джесси Джеймса Гарретта (автора термина «Пользовательский опыт» и книги «Элементы пользовательского опыта — Библии UX всех времен»), говорит, что пользовательский интерфейс (UI) является компонентом пользовательского опыта. Но есть гораздо больше, и это гораздо большее включает в себя вещи, которые имеют отношение к когнитивной науке. Это связано с людьми: что они хотят, что им нужно, что они хотят использовать и почему они реагируют на вещи так, как они реагируют.»

Другой UXD эксперт – Билл ДэРушэ (Старший продакт менеджер / Workflow Experience Lead at Zendesk). В обсуждении UXD говорит следующее: «Для UXD… даже не нужен экран. UXD — это любое взаимодействие с любым продуктом, любым элементом, любой системой ».

Просмотрев все доступные материалы выше упомянутых, а также ряда других UXD специалистов, я заметил одну важную закономерность — они постоянно используют научные достижения когнитивных психологов, неврологов и поведенческих экономистов. Практически вся идеологическая часть, весь “back end” их речей основывается на когнитивных науках, однако, на это редко делается акцент. Чаще всего они не хотят «усложнять» материал для слушателя и слишком часто используют фразы, типа «мы используем те вещи, которые понимаем», что ставит грубые рамки, не позволяющие учитывать множество важных факторов.

К примеру, даже, если у нас есть доступ к приложению, мы практически никогда не будем его использовать, если ожидаемые от нас действия идут в разрез с ценностями социально-культурной среды, с которой мы себя отождествляем. Другой же UXD специалист может тонко заметить это, сказав: «Чтобы быть приемлемым, визуальный дизайн должен соответствовать социально-культурным ценностям», что звучит красиво, однако, не показывает всей картины, которую нужно учитывать в принятии решений по продукту.

Прошу заметить, я ни в коем случае не говорю, что книги и видеоуроки бесполезны. На данный момент, для того, чтобы человек понял что такое UX и как с ним работать, ему необходимо пройти через множество разбросанных материалов в книгах и видеоуроках. Я же в этой статье хочу показать научные истоки, на основе которых все эти книги и уроки создаются.

Итак, практически все UXD эксперты сходятся во мнении, что UX — это понятие, выходящее широко за рамки интерфейсов. Их общее мнение сводится к тому, что UX — это фактический опыт, получаемый пользователем при его интеракции с продуктом/компанией.

В силу же того, что опыт- это результат интерпретации чувств, возникающих у человека при интеракции с продуктом/компанией,

создание пользовательского опыта – это психологическая игра с целью подталкивания пользователя к определенной мысли, эмоции, действию или выбору. И здесь мы вплотную подходим к такому понятию как “архитектура выбора”.

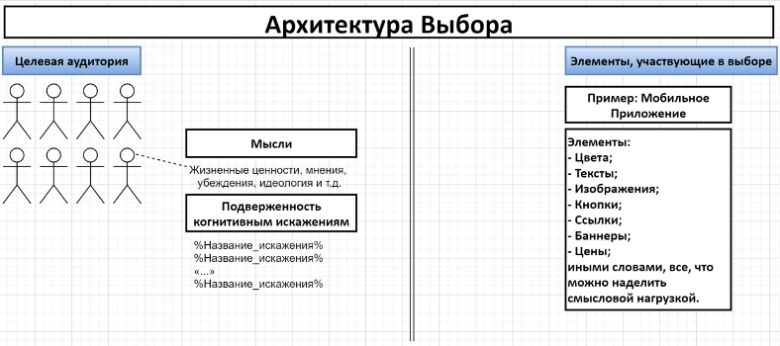

Часть 3. Архитектура Выбора

Понятие «архитектура выбора» популяризировалось после совместного труда Ричарда Талера и Касса Санстейна над Теорией Подталкивания. Вместе они написали книгу «Подталкивание» (англ. Nudge Theory), которая позволила множеству разных специалистов, ответственных за «создание выбора» для пользователей, взглянуть на свою работу под новым углом. Чтобы читатель понимал значимость вышеуказанных персон, приведу здесь их краткое описание:

Касс Санстейн – со-автор теории подталкивания. После выхода книги ≪Подталкивание≫ президент Обама предложил Санстейну место в Отделе информации и регуляторной политики. Это дало исследователю широкие возможности внедрять идеи психологии и поведенческой экономики в работу правительственных учреждений. 10 сентября 2009 года Санстейн был назначен на пост главы OIRA, которое является частью Административно-бюджетного управления Администрации президента. OIRA осуществляет надзор за реализацией государственной политики и рассматривает проекты нормативных актов. Пост главы OIRA считается одним из наиболее влиятельных, учитывая его возможность влиять на тексты принимаемых законов. СМИ неофициально называют этот пост regulatory czar. OIRA Санстейн возглавлял до 21 августа 2012 года.

В августе 2013 года Санстейн вошел в состав комиссии по надзору за АНБ (англ. Review Group on Intelligence and Communications Technology). Кроме него в комиссии еще два бывших работника Белого Дома: крупейший специалист по контртерроризму и кибервойнам Ричард Алан Кларк и бывший заместитель директора ЦРУ.

Ричард Талер — автор «Теории Подталкивания», лауреат премии по экономике памяти Альфреда Нобеля 2017 года за вклад в область поведенческой экономики. При правительстве Великобритании было создано новое подразделение, чья цель применять принципы поведенческой науки к решению государственных задач. Официальное название подразделения — ≪Группа поведенческого инсайта≫, но чаще и в правительстве, и за его пределами ее называют ≪Группа подталкивания≫. Талер является одним из советников этой группы.

Итак, эти господа много лет работали над теорией, в которой тщательно описали как можно «подтолкнуть» человека к определенному выбору, используя когнитивные искажения (о них мы поговорим совсем скоро). Идея и описанные методы настолько понравились руководствам разных стран (не только США и Англии), что были созданы специальные гос.подразделения с целью редактирования законопроектов для подталкивания граждан к более здоровому образу жизни и более здоровой пище не ограничивая их в выборе.

Даже сейчас тысячи ученых ежедневно работают на правительства, изучая работу человеческого мозга и свойственные ему ошибки с целью оптимизировать наш выбор, дать нам возможность выбирать «лучшее» там, где это возможно и при этом не ограничивать наш выбор.

Фактически, архитектура выбора – это

описание мыслей и когнитивных искажений, которым подвержена целевая аудитория

– с одной стороны, и

решения по расстановке элементов участвующих в выборе

– с другой.

При грамотном понимании обеих частей этого уравнения, архитектор выбора может плавно подтолкнуть пользователя/потребителя в нужном для компании направлении.

Часть 4. Архитектор Выбора

Понятие «Архитектор выбора» ввели Санстейн и Талер, описав его следующим образом:

«Архитектор выбора — это тот, кто отвечает за организацию контекста, в котором человек принимает решения».

Талер и Санстейн доказывали эффективность «подталкивания» на примере принятия решений при разработке законопроектов. В таком контексте, работа архитектора выбора крайне сложна, так как на него налагаются колоссальные юридические и моральные ограничения.

Нас же с вами интересует IT сфера, в частности, разработка разного рода приложений. В этой сфере тоже имеются определенные ограничения, однако, их гораздо меньше, что дает возможность архитектору выбора реализовать весь свой научный потенциал.

В такой компании несложно понять, кто является архитектором выбора. Это тот, кто занимается «организацией контекста, в котором человек (пользователь) принимает решения в приложении», либо просто Product Manager.

Организация контекста, в котором пользователи принимают решения – это ключевая обязанность Product Manager-а. Для создания лучших условий для выбора и подталкивания пользователей к выбору выгодному бизнесу, Product Manager обязан знать модели человеческого поведения и, что наиболее важно, отклонения в этом поведении. Именно такие систематические отклонения в восприятии, мышлении и поведении человека называются «когнитивными искажениями». Их можно считать «bug-ами», потому что бОльшая часть этих искажений описывает сбои в обработке и анализе информации.

Часть 5. Когнитивные Искажения и Пользовательский Опыт

Итак, мы дошли до основного материала статьи.

Далее я выложу ряд известных науке когнитивных искажений, которые были научно выведенны и задокументированны. Отдельной ссылкой я выложил онлайн инструмент, который я назвал «UX CORE». В нем вы сможете найти 105 когнитивных искажений с примерами их использования в менеджменте и в разработке приложений.

Для структурирования материала я использовал «Кодекс когнитивных искажений», категоризированный и структурированный Бастером Бэнсоном в 2016м году (по ссылке выше дизайн Джона Манукяна III). Помимо новой формы презентации искажений, к каждому из них я добавил пример использования в разработке программного обеспечения, а в некоторых случаях- в управлении командой. Были учтены самые современные практики по управлению командами и компаниями (PMP, PMI ACP), а также разработке продукта.

Многие примеры, которые я описал далее, довольно радикальны. Это было сделано намеренно, т.к. в соответствии с эффектом контраста, такие примеры запоминаются лучше. Основная цель примеров – дать пищу для размышлений. Я не стремился добиться их абсолютной точности, т.к. для такого примера необходимо тщательное описание рабочей ситуации и поставленной задачи, а это заняло бы десятки страниц материала. Я глубоко убежден, что данная работа поможет читателям узнать для себя много нового и сделать определенные выводы.

Клики на названия искажений в таблице открывают поп-апы. Все ссылки в поп-апах открываются в новых вкладках браузера, поэтому можете серфить контент спокойно, не беспокоясь случайно что-то закрыть.

Итак, как верно заметил Бастер Бенсон, суть изложенных когнитивных искажений в том, чтобы помочь нам решить 4 проблемы:

- Работа с большим объемом данных. Когда много информации;

- Расплывчатость, недостаточность данных. Когда не хватает смысла;

- Недостаточно времени. Когда быстро реагируем;

- Разные приоритеты по информации. Когда запоминаем и вспоминаем.

Каждое когнитивное искажение существует по определенной причине — в основном, чтобы мозг сохранял энергию и тратил меньше времени на раздумья. Когда смотришь на искажения с точки зрения проблемы, которую они помогают решить, становится легче понять почему они существуют, чем они полезны и на какие компромиссы в связи с этим нам приходится соглашаться.

#1 Эвристика доступности [P]

Процесс, при котором человек оценивает частоту или вероятность события по легкости, с которой примеры или случаи приходят на ум, т.е. легче вспоминаются.

В разработке приложений понимание этого искажения необходимо для последовательного проектирования интерфейсов, дизайна контента и коммуникации с пользователем. Если действие, которое нам нужно, чтобы пользователь совершил, ассоциируется у него с чем-либо негативным (особенно, если это освещается или освещалось в СМИ не так давно), вероятность того, что действие будет совершено сильно снижается. Понимание этого позволяет проектировать контент (текст, изображения и т.д.), так, чтобы он ассоциировался у человека только с тем, что нам нужно. Это же искажение позволяет нам задуматься над текущей коньюнктурой в мире и на рынке, чтобы выбрать наиболее удобную «тональность» наших сообщений.

Другой пример: биткоины и разного рода ICO. Тема криптовалют так часто негативно форсировалась в СМИ, что в какой-то момент инвесторы просто решили избегать всего, что с этим связано, не вдаваясь в детали. Простые же пользователи поняли, что их ослепленность повышенной волатилностью этих рынков не привела ни к чему хорошему. Хайп по этой теме сошел на нет, а множество действительно качественных блокчейн-проектов столкнулись с серъезными сложностями в развитии из-за сильно искаженной репутации всего, что ассоциируется с блокчейном, биткоином и крипто в целом.

Последний пример — это то, что я выбрал тему проектирования ПО и блокчейн технологий для описания эвристики доступности. Первая тема очевидна для меня в силу моей профессии (product manager), вторая же тема просто с легкостью пришла мне на ум, когда я задал себе вопрос: «Какое направление в IT было полно хайпа, а потом быстро сошло на нет?».

#4 Эффект знакомства с объектом [P]