Точность измерений

Никакое

измерение не может быть выполнено

абсолютно точно, всегда содержится та

или иная погрешность. Чем точнее метод

измерения и измерительный прибор тем

меньше величина погрешности. Принято

различать несколько видов погрешностей:

основная и дополнительная, абсолютная

и относительная, систематическая и

случайная, которые необходимо учитывать

при измерении в спорте.

Основная

погрешность

связана с методом измерения или

измерительного прибора, которая имеет

место в нормальных условиях их применения.

Например, точность измерения прыжка в

длину с помощью метра или рулетки;

точность измерения времени пробегания

короткой дистанции с помощью разных

(механического или электронного)

секундомеров будет не одинаковой и

определяется точностью самого средства

измерения. Эта погрешность, как правило,

указана в инструкции измерительного

прибора.

Дополнительная

погрешность

вызвана отклонением условий работы

измерительной системы от нормальных.

Например, при существенных колебаниях

(выше нормы) электрического напряжения

в сети может возникать погрешность

измерения. Другой пример — прибор,

предназначенный для работы при комнатной

температуре, будет давать неточные

показания, если пользоваться им в

условиях низких или высоких внешних

температур. К дополнительным погрешностям

относятся и так называемая динамическая

погрешность, обусловленная инерционностью

измерительного прибора и возникающая

в тех случаях, когда измеряемая величина

колеблется выше технических возможностей

регистрирующего устройства. Например,

некоторые пульсотахометры рассчитаны

на измерение средних величин ЧСС и не

способны улавливать непродолжительные

отклонения частоты от среднего уровня.

Величины

основной и дополнительной погрешности

могут быть представлены в абсолютных

и относительных единицах.

Абсолютная

погрешность равна

разности между показанием измерительного

пробора (А) и истинным значением измеряемой

величины

Она

измеряется в тех же единицах, что и

измеряемая величина.

Относительной

погрешностью называется

отношение абсолютной погрешности к

истинному значению измеряемой величины:

Поскольку

относительная погрешность измеряется

в процентах, то знак абсолютной погрешности

не учитывается.

Систематическая

погрешность

– это величина, которая не меняется от

измерения к измерению. Поэтому она часто

может быть предсказана заранее или, в

крайнем случае обнаружена и устранена

по окончании процесса измерения.

Определение систематической погрешности

измерения возможно способами: тарировки,

калибровки измерительной аппаратуры

или рандомизации.

Тарированием

называется

проверка показаний измерительных

приборов путем сравнения с показаниями

образцовых значений мер (эталонов) во

всем диапазоне измеряемой величины.

Калибровкой

называется

определение погрешностей или поправка

для совокупности мер. И при тарировке

и при калибровке к входу измерительной

системы подключается источник эталонного

сигнала известной величины. Например,

процедура проверки чувствительности

усилителя, заключающаяся в записи и

регулировке амплитуды ответов каналов

на подаваемое на вход напряжение,

сопоставляемое впоследствии с амплитудой

регистрируемых физиологических

параметров. Другой пример, – процедура

проверки скорости движения бумаги на

регистрирующем приборе с помощью

счетчика времени.

Рандомизацией

(от англ.

random – случайный) называется превращение

систематической погрешности в случайную.

По методу рандомизации измерение

изучаемой величины производится

несколько раз (например, многократные

исследования физической работоспособности

разными способами дозирования нагрузки).

По окончании всех измерений их результаты

усредняются по правилам математической

статистики.

Случайные

погрешности неустранимы

и возникают

под действием разнообразных факторов,

которые сложно заранее предсказать и

учесть. Единственно, с помощь методов

математической статистики можно оценить

величину случайной погрешности и учесть

ее при интерпретации результатов

измерения.

|

1 |

|

|

2 |

|

|

3 |

|

|

4 |

|

|

5 |

|

|

6 |

|

СТАТИСТИЧЕСКИЕ

ХАРАКТЕРИСТИКИ

Без

статистической обработки результаты

измерений не могут считаться достоверными.

Средняя

арифметическая характеризует

групповые свойства признака, занимает

центральное положение в общей массе

варьирующих признаков. Представляет

собой частное от деления суммы всех

вариант совокупности на их общее число.

Средняя арифметическая – величина

именованная, она выражается теми же

единицами измерения, что и характеризуемый

ею признак. Средняя арифметическая –

важнейшая статистическая характеристика,

но она ничего не говорит о величине

варьирования изучаемого признака.

Стандартное

или среднее квадратическое отклонение

(s) характеризует

вариации, или колеблемости признака.

Стандартное отклонение – величина

именованная, и выражается в тех же

единицах измерения, что и исследуемый

признак, т.е. характеризует степень

отклонения результатов от среднего

значения в абсолютных единицах. Этот

показатель не зависит от числа наблюдений,

и потому может использоваться для оценки

варьирования однородных признаков.

Однако для сравнения вариации двух и

более признаков, имеющих различные

единицы измерения (например, результаты

в беге на 100 м, прыжках в высоту, метаниях

гранаты и т.п.), эта характеристика не

пригодна. Для этого используется

коэффициент вариации.

Коэффициент

вариации (CV)

определяется как отношение стандартного

отклонения к среднему арифметическому,

выраженное в процентах. Коэффициент

вариации, будучи величиной относительной,

позволяет сравнивать между собой

колеблемость результатов измерений,

имеющих различные единицы измерения.

При нормальных распределениях CV обычно

не превышает 45-50%. В случаях асимметричных

распределений он может быть довольно

высоким (до 100% и выше). На практике

внутренняя вариабельность признака

считается небольшой при CV= 0-10%, средней

– 11-20% и большой – больше 20%.

Ошибка

средней арифметической (m) величина

не техническая, а статистическая, и

характеризует закономерные колебания

(вариации) средней арифметической

величины. Выборочная ошибка показывает

варьирование выборочных показателей

вокруг их генеральных параметров. Она

обладает теми же свойствами, что и

среднее квадратическое отклонение. Чем

больше объем выборки, тем точнее средний

результат, тем меньше выборочная средняя

будет отличаться от средней генеральной

совокупности. Следовательно, при

увеличении числа испытаний ошибка

выборочной средней будет уменьшаться.

Отсюда становится яснее значение

выборочной ошибки: она указывает на

точность, с какой определена сопровождаемая

ею средняя величина.

Оценка

по критерию Т-Стьюдента. В

спорте часто на одних и тех же спортсменах

проводится измерение через некоторое

время (например, в начале и в конце этапа

подготовки) или сравнение результатов

одной группы (контрольной) с другой

(экспериментальной). Во всех этих и

подобных случаях ставится, практически,

одна задача – достоверно или нет одни

результаты исследования отличаются от

других? Для этих целей используется

метод сравнения

двух выборочных средних арифметических

по критерию Т-Стьюдента. Принципиально

важным является то, что применение

указанного метода возможно лишь для

однородных признаков.

Ответом

на вопрос о достоверности различий

между признаками служит уровень

значимости (Р),

определяемый по таблице (стандартные

значения критерия Т-Стьюдента). При

уровне значимости Р<0,05 (что соответствует

95% вероятности события) можно говорить

о наличие достоверных различий между

сравниваемыми средними, при Р<0,01 и

особенно при Р<0,001 (когда 99,9% случаев

подлежат общей закономерности) можно

утверждать, что средние значения

отличаются друг от друга с высокой

вероятностью, или закономерностью.

Свидетельством отсутствия достоверных

(статистических) различий между средними

является Р>0,05 (т.е. менее 95% случаев

подлежат общей закономерности).

Корреляционный

анализ сводится

к измерению тесноты или степени

сопряженности между разнородными

признаками, а также к определению формы

и направления существующей между ними

связи. Критерием связи служит коэффициент

корреляции,

который имеет значения от 0 до 1. Чем

больше коэффициент корреляции приближается

к 1, тем теснее связь между признаками

и наоборот. Знак плюс или минус говорят

о направленности связи — положительной

(прямой) или отрицательной (обратной).

Коэффициент корреляции служит мерилом

только качественной связи между

изучаемыми признаками. С помощью

специальных расчетных процедур, в каждом

конкретном случае, устанавливается

форма (линейная, нелинейная) связи.

Существуют методы: парной и множественной

корреляции; для определения связи между

количесвенными и качественными признаками

(ранговая корреляция).

Регрессионный

анализ есть

продолжение корреляционного анализа,

где с помощью выведенного уравнения

регрессии можно показать количественную

степень связи (или взаимовлияния одного

признака на другой). Например, насколько

повысится результат в прыжках в длину

с разбега, если скорость бега на 30 м

увеличится на 2 м/с.

Дисперсионный

анализ позволяет

оценить влияние разнообразных факторов

на результат исследования. Например,

какие из факторов физической

подготовленности в большей мере влияют

на спортивный результат. Дисперсионный

анализ проводится как на малых, так и

на больших выборках, на однородных и

неоднородных признаках, на количественных

и качественных характеристиках. В основе

дисперсионного анализа лежит сравнение

выборочных дисперсий, или их отношений

с критическими значениями критерия

F-Фишера.

Более

подробно с методами математической

статистики можно ознакомиться в следующей

литературе.

1.

Ашмарин Б.А. Теория и методика педагогических

исследований в физическом воспитании.-

М.: ФиС, 1978.

2.

Бейл Н. Статистические методы в биологии.-

М.: Мир, 1964.

3.

Гласс Дж., Стэнли Дж. Статистические

методы в педагогике и психологии.- М.:

Прогресс, 1976.

4.

Друзь В.А. Моделирование процесса

спортивной тренировки.- Киев: Здоровье,

1976.

5.

Лакин Г.Ф. Биометрия: Учебник для

университетов и педагогических

институтов.- М.: Высшая школа, 1973.

6.

Основы общей и прикладной акмеологии.-

М.: ФиС, 1995. Плохинский Н.А. Биометрия.-

М.: МГУ, 1970.

7.

Рокицкий П.Ф. Биологическая статистика.-

Минск: Высшая школа, 1973.

8.Садовский

Л.Е., Садовский А.Л. Математика и спорт.-

М.: Наука, 1985.

9.

Фишер Р.А. Статистические методы для

исследователей / Перевод с англ. В.Н.

Перегудова – М.: Госстатиздат, 1958.

|

1 |

|

|

2 |

|

|

3 |

|

|

4 |

|

|

5 |

|

|

6 |

|

|

7 |

|

|

8 |

|

|

9 |

|

Соседние файлы в предмете [НЕСОРТИРОВАННОЕ]

- #

- #

- #

- #

- #

- #

- #

- #

- #

- #

- #

Ошибка калибровки датчика

Калибровка датчика – определение его индивидуальныхкоэффициентов общей формы передаточной функции.

Производится еслипроизводственные допуски на датчик превышают требуемую точность измерения.Например, требуется измерить температуру с точностью ±0.5°С датчиком, посправочным данным обладающим погрешностью ±1?С. Это можно сделать только послепроведения калибровки этого конкретного датчика, т.е. после нахождения егоиндивидуальной передаточной функции.

Математическое описание передаточнойфункции необходимо знать до начала проведения калибровки. Если выражение дляпередаточной функции является линейным, в процессе калибровки определяюткоэффициенты а и b, если экспоненциальным — токоэффициенты а и к т.д.

Пример для линейной передаточнойфункции. Поскольку для определения коэффициентов, описывающих прямую линию,необходимо иметь два уравнения, придется проводить калибровку, как минимум, вдвух точках.

Передаточная функция:

Для определения а и b датчик необходимо поместить в две среды: одну стемпературой t1, другую с температурой t2 и измерить значения двух соответствующих напряжений: v1, и v2 После чего надо подставить эти величиныв выражение передаточной функции:

и найти значения констант:

Дляполучения температуры из выходного напряжения, значение измеренного напряжениянеобходимо подставить в инверсное выражение передаточной функции:

В некоторых случаях одна из констант может быть заранее определена с достаточнойстепенью точности, тогда калибровка проводится в одной точке. Например длядатчика температуры с р-n переходом наклон передаточной функции b дляопределенного типа полупроводников обычно является хорошо воспроизводимойвеличиной.

Длянелинейных функций калибровку требуется проводить более чем в двух точках.Количество необходимых калибровок диктуется видом математического выражения.Если передаточная функция моделируется полиноминальной зависимостью, числокалибровочных точек выбирается в зависимости от требуемой точности. Поскольку,как правило, процесс калибровки занимает довольно много времени, для снижениястоимости изготовления датчиков на производстве количество калибровочных точекзадается минимальным.

Другойподход к калибровке нелинейных датчиков — применение кусочно-линейной аппроксимации:любую кривую в пределах достаточно небольшого интервала всегда можно заменитьлинейной функцией. Поэтому нелинейную передаточную функцию можно представить ввиде комбинации линейных отрезков, каждый из которых обладает своимисобственными коэффициентами а и b.

Дляпроведения калибровки датчиков важно иметь точные физические эталоны,позволяющие моделировать соответствующие внешние воздействия. Например, прикалибровке контактного датчика температуры его необходимо помещать либо врезервуар с водой, либо в «сухой колодец», в которых есть возможность точнорегулировать температуру. При калибровке инфракрасных датчиков требуетсяналичие черного тела, а для калибровки гигрометров — набор насыщенных растворовсолей, используемых для поддержания постоянной относительной влажности взакрытом контейнере и т.д.

Следовательноточность последующих измерений напрямую связана с точностью проведения калибровкии ошибка калибровочных эталонов должна включаться в полную ошибку измерений.

Ошибка калибровки — это погрешность, допущеннаяпроизводителем при проведениикалибровки датчика на заводе. Эта погрешность является систематический и добавляется ко всем реальнымпередаточным функциям.

This article is about assessing the accuracy of a measurement device, like a scale or a ruler. For the statistical concept, see Calibration (statistics).

In measurement technology and metrology, calibration is the comparison of measurement values delivered by a device under test with those of a calibration standard of known accuracy. Such a standard could be another measurement device of known accuracy, a device generating the quantity to be measured such as a voltage, a sound tone, or a physical artifact, such as a meter ruler.

The outcome of the comparison can result in one of the following:

- no significant error being noted on the device under test

- a significant error being noted but no adjustment made

- an adjustment made to correct the error to an acceptable level

Strictly speaking, the term «calibration» means just the act of comparison and does not include any subsequent adjustment.

The calibration standard is normally traceable to a national or international standard held by a metrology body.

BIPM Definition[edit]

The formal definition of calibration by the International Bureau of Weights and Measures (BIPM) is the following: «Operation that, under specified conditions, in a first step, establishes a relation between the quantity values with measurement uncertainties provided by measurement standards and corresponding indications with associated measurement uncertainties (of the calibrated instrument or secondary standard) and, in a second step, uses this information to establish a relation for obtaining a measurement result from an indication.»[1]

This definition states that the calibration process is purely a comparison, but introduces the concept of measurement uncertainty in relating the accuracies of the device under test and the standard.

Modern calibration processes[edit]

The increasing need for known accuracy and uncertainty and the need to have consistent and comparable standards internationally has led to the establishment of national laboratories. In many countries a National Metrology Institute (NMI) will exist which will maintain primary standards of measurement (the main SI units plus a number of derived units) which will be used to provide traceability to customer’s instruments by calibration.

The NMI supports the metrological infrastructure in that country (and often others) by establishing an unbroken chain, from the top level of standards to an instrument used for measurement. Examples of National Metrology Institutes are NPL in the UK, NIST in the United States, PTB in Germany and many others. Since the Mutual Recognition Agreement was signed it is now straightforward to take traceability from any participating NMI and it is no longer necessary for a company to obtain traceability for measurements from the NMI of the country in which it is situated, such as the National Physical Laboratory in the UK.

Quality[edit]

To improve the quality of the calibration and have the results accepted by outside organizations it is desirable for the calibration and subsequent measurements to be «traceable» to the internationally defined measurement units. Establishing traceability is accomplished by a formal comparison to a standard which is directly or indirectly related to national standards (such as NIST in the USA), international standards, or certified reference materials. This may be done by national standards laboratories operated by the government or by private firms offering metrology services.

Quality management systems call for an effective metrology system which includes formal, periodic, and documented calibration of all measuring instruments. ISO 9000[2] and ISO 17025[3] standards require that these traceable actions are to a high level and set out how they can be quantified.

To communicate the quality of a calibration the calibration value is often accompanied by a traceable uncertainty statement to a stated confidence level. This is evaluated through careful uncertainty analysis.

Some times a DFS (Departure From Spec) is required to operate machinery in a degraded state. Whenever this does happen, it must be in writing and authorized by a manager with the technical assistance of a calibration technician.

Measuring devices and instruments are categorized according to the physical quantities they are designed to measure. These vary internationally, e.g., NIST 150-2G in the U.S.[4] and NABL-141 in India.[5] Together, these standards cover instruments that measure various physical quantities such as electromagnetic radiation (RF probes), sound (sound level meter or noise dosimeter), time and frequency (intervalometer), ionizing radiation (Geiger counter), light (light meter), mechanical quantities (limit switch, pressure gauge, pressure switch), and, thermodynamic or thermal properties (thermometer, temperature controller). The standard instrument for each test device varies accordingly, e.g., a dead weight tester for pressure gauge calibration and a dry block temperature tester for temperature gauge calibration.

Instrument calibration prompts[edit]

Calibration may be required for the following reasons:

- a new instrument

- after an instrument has been repaired or modified

- moving from one location to another location

- when a specified time period has elapsed

- when a specified usage (operating hours) has elapsed

- before and/or after a critical measurement

- after an event, for example

- after an instrument has been exposed to a shock, vibration, or physical damage, which might potentially have compromised the integrity of its calibration

- sudden changes in weather

- whenever observations appear questionable or instrument indications do not match the output of surrogate instruments

- as specified by a requirement, e.g., customer specification, instrument manufacturer recommendation.

In general use, calibration is often regarded as including the process of adjusting the output or indication on a measurement instrument to agree with value of the applied standard, within a specified accuracy. For example, a thermometer could be calibrated so the error of indication or the correction is determined, and adjusted (e.g. via calibration constants) so that it shows the true temperature in Celsius at specific points on the scale. This is the perception of the instrument’s end-user. However, very few instruments can be adjusted to exactly match the standards they are compared to. For the vast majority of calibrations, the calibration process is actually the comparison of an unknown to a known and recording the results.

Basic calibration process[edit]

Purpose and scope[edit]

The calibration process begins with the design of the measuring instrument that needs to be calibrated. The design has to be able to «hold a calibration» through its calibration interval. In other words, the design has to be capable of measurements that are «within engineering tolerance» when used within the stated environmental conditions over some reasonable period of time.[6] Having a design with these characteristics increases the likelihood of the actual measuring instruments performing as expected.

Basically, the purpose of calibration is for maintaining the quality of measurement as well as to ensure the proper working of particular instrument.

Frequency[edit]

The exact mechanism for assigning tolerance values varies by country and as per the industry type. The measuring of equipment is manufacturer generally assigns the measurement tolerance, suggests a calibration interval (CI) and specifies the environmental range of use and storage. The using organization generally assigns the actual calibration interval, which is dependent on this specific measuring equipment’s likely usage level. The assignment of calibration intervals can be a formal process based on the results of previous calibrations. The standards themselves are not clear on recommended CI values:[7]

- ISO 17025[3]

- «A calibration certificate (or calibration label) shall not contain any recommendation on the calibration interval except where this has been agreed with the customer. This requirement may be superseded by legal regulations.”

- ANSI/NCSL Z540[8]

- «…shall be calibrated or verified at periodic intervals established and maintained to assure acceptable reliability…»

- ISO-9001[2]

- «Where necessary to ensure valid results, measuring equipment shall…be calibrated or verified at specified intervals, or prior to use…”

- MIL-STD-45662A[9]

- «… shall be calibrated at periodic intervals established and maintained to assure acceptable accuracy and reliability…Intervals shall be shortened or may be lengthened, by the contractor, when the results of previous calibrations indicate that such action is appropriate to maintain acceptable reliability.»

Standards required and accuracy[edit]

The next step is defining the calibration process. The selection of a standard or standards is the most visible part of the calibration process. Ideally, the standard has less than 1/4 of the measurement uncertainty of the device being calibrated. When this goal is met, the accumulated measurement uncertainty of all of the standards involved is considered to be insignificant when the final measurement is also made with the 4:1 ratio.[10] This ratio was probably first formalized in Handbook 52 that accompanied MIL-STD-45662A, an early US Department of Defense metrology program specification. It was 10:1 from its inception in the 1950s until the 1970s, when advancing technology made 10:1 impossible for most electronic measurements.[11]

Maintaining a 4:1 accuracy ratio with modern equipment is difficult. The test equipment being calibrated can be just as accurate as the working standard.[10] If the accuracy ratio is less than 4:1, then the calibration tolerance can be reduced to compensate. When 1:1 is reached, only an exact match between the standard and the device being calibrated is a completely correct calibration. Another common method for dealing with this capability mismatch is to reduce the accuracy of the device being calibrated.

For example, a gauge with 3% manufacturer-stated accuracy can be changed to 4% so that a 1% accuracy standard can be used at 4:1. If the gauge is used in an application requiring 16% accuracy, having the gauge accuracy reduced to 4% will not affect the accuracy of the final measurements. This is called a limited calibration. But if the final measurement requires 10% accuracy, then the 3% gauge never can be better than 3.3:1. Then perhaps adjusting the calibration tolerance for the gauge would be a better solution. If the calibration is performed at 100 units, the 1% standard would actually be anywhere between 99 and 101 units. The acceptable values of calibrations where the test equipment is at the 4:1 ratio would be 96 to 104 units, inclusive. Changing the acceptable range to 97 to 103 units would remove the potential contribution of all of the standards and preserve a 3.3:1 ratio. Continuing, a further change to the acceptable range to 98 to 102 restores more than a 4:1 final ratio.

This is a simplified example. The mathematics of the example can be challenged. It is important that whatever thinking guided this process in an actual calibration be recorded and accessible. Informality contributes to tolerance stacks and other difficult to diagnose post calibration problems.

Also in the example above, ideally the calibration value of 100 units would be the best point in the gauge’s range to perform a single-point calibration. It may be the manufacturer’s recommendation or it may be the way similar devices are already being calibrated. Multiple point calibrations are also used. Depending on the device, a zero unit state, the absence of the phenomenon being measured, may also be a calibration point. Or zero may be resettable by the user-there are several variations possible. Again, the points to use during calibration should be recorded.

There may be specific connection techniques between the standard and the device being calibrated that may influence the calibration. For example, in electronic calibrations involving analog phenomena, the impedance of the cable connections can directly influence the result.

Manual and automatic calibrations[edit]

Calibration methods for modern devices can be manual or automatic.

Manual calibration — US serviceman calibrating a pressure gauge. The device under test is on his left and the test standard on his right.

As an example, a manual process may be used for calibration of a pressure gauge. The procedure requires multiple steps,[12] to connect the gauge under test to a reference master gauge and an adjustable pressure source, to apply fluid pressure to both reference and test gauges at definite points over the span of the gauge, and to compare the readings of the two. The gauge under test may be adjusted to ensure its zero point and response to pressure comply as closely as possible to the intended accuracy. Each step of the process requires manual record keeping.

Automatic calibration — A U.S. serviceman using a 3666C auto pressure calibrator

An automatic pressure calibrator [13] is a device that combines an electronic control unit, a pressure intensifier used to compress a gas such as Nitrogen, a pressure transducer used to detect desired levels in a hydraulic accumulator, and accessories such as liquid traps and gauge fittings. An automatic system may also include data collection facilities to automate the gathering of data for record keeping.

Process description and documentation[edit]

All of the information above is collected in a calibration procedure, which is a specific test method. These procedures capture all of the steps needed to perform a successful calibration. The manufacturer may provide one or the organization may prepare one that also captures all of the organization’s other requirements. There are clearinghouses for calibration procedures such as the Government-Industry Data Exchange Program (GIDEP) in the United States.

This exact process is repeated for each of the standards used until transfer standards, certified reference materials and/or natural physical constants, the measurement standards with the least uncertainty in the laboratory, are reached. This establishes the traceability of the calibration.

See Metrology for other factors that are considered during calibration process development.

After all of this, individual instruments of the specific type discussed above can finally be calibrated. The process generally begins with a basic damage check. Some organizations such as nuclear power plants collect «as-found» calibration data before any routine maintenance is performed. After routine maintenance and deficiencies detected during calibration are addressed, an «as-left» calibration is performed.

More commonly, a calibration technician is entrusted with the entire process and signs the calibration certificate, which documents the completion of a successful calibration.

The basic process outlined above is a difficult and expensive challenge. The cost for ordinary equipment support is generally about 10% of the original purchase price on a yearly basis, as a commonly accepted rule-of-thumb. Exotic devices such as scanning electron microscopes, gas chromatograph systems and laser interferometer devices can be even more costly to maintain.

The ‘single measurement’ device used in the basic calibration process description above does exist. But, depending on the organization, the majority of the devices that need calibration can have several ranges and many functionalities in a single instrument. A good example is a common modern oscilloscope. There easily could be 200,000 combinations of settings to completely calibrate and limitations on how much of an all-inclusive calibration can be automated.

An instrument rack with tamper-indicating seals

To prevent unauthorized access to an instrument tamper-proof seals are usually applied after calibration. The picture of the oscilloscope rack shows these, and prove that the instrument has not been removed since it was last calibrated as they will possible unauthorized to the adjusting elements of the instrument. There also are labels showing the date of the last calibration and when the calibration interval dictates when the next one is needed. Some organizations also assign unique identification to each instrument to standardize the record keeping and keep track of accessories that are integral to a specific calibration condition.

When the instruments being calibrated are integrated with computers, the integrated computer programs and any calibration corrections are also under control.

Historical development[edit]

Origins[edit]

The words «calibrate» and «calibration» entered the English language as recently as the American Civil War,[14] in descriptions of artillery, thought to be derived from a measurement of the calibre of a gun.

Some of the earliest known systems of measurement and calibration seem to have been created between the ancient civilizations of Egypt, Mesopotamia and the Indus Valley, with excavations revealing the use of angular gradations for construction.[15] The term «calibration» was likely first associated with the precise division of linear distance and angles using a dividing engine and the measurement of gravitational mass using a weighing scale. These two forms of measurement alone and their direct derivatives supported nearly all commerce and technology development from the earliest civilizations until about AD 1800.[16]

Calibration of weights and distances (c. 1100 CE)[edit]

An example of a weighing scale with a ½ ounce calibration error at zero. This is a «zeroing error» which is inherently indicated, and can normally be adjusted by the user, but may be due to the string and rubber band in this case

Early measurement devices were direct, i.e. they had the same units as the quantity being measured. Examples include length using a yardstick and mass using a weighing scale. At the beginning of the twelfth century, during the reign of Henry I (1100-1135), it was decreed that a yard be «the distance from the tip of the King’s nose to the end of his outstretched thumb.»[17] However, it wasn’t until the reign of Richard I (1197) that we find documented evidence.[18]

- Assize of Measures

- «Throughout the realm there shall be the same yard of the same size and it should be of iron.»

Other standardization attempts followed, such as the Magna Carta (1225) for liquid measures, until the Mètre des Archives from France and the establishment of the Metric system.

The early calibration of pressure instruments[edit]

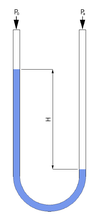

Direct reading design of a U-tube manometer

One of the earliest pressure measurement devices was the Mercury barometer, credited to Torricelli (1643),[19] which read atmospheric pressure using Mercury. Soon after, water-filled manometers were designed. All these would have linear calibrations using gravimetric principles, where the difference in levels was proportional to pressure. The normal units of measure would be the convenient inches of mercury or water.

In the direct reading hydrostatic manometer design on the right, applied pressure Pa pushes the liquid down the right side of the manometer U-tube, while a length scale next to the tube measures the difference of levels. The resulting height difference «H» is a direct measurement of the pressure or vacuum with respect to atmospheric pressure. In the absence of differential pressure both levels would be equal, and this would be used as the zero point.

The Industrial Revolution saw the adoption of «indirect» pressure measuring devices, which were more practical than the manometer.[20]

An example is in high pressure (up to 50 psi) steam engines, where mercury was used to reduce the scale length to about 60 inches, but such a manometer was expensive and prone to damage.[21] This stimulated the development of indirect reading instruments, of which the Bourdon tube invented by Eugène Bourdon is a notable example.

Indirect reading design showing a Bourdon tube from the front (left) and the rear (right).

In the front and back views of a Bourdon gauge on the right, applied pressure at the bottom fitting reduces the curl on the flattened pipe proportionally to pressure. This moves the free end of the tube which is linked to the pointer. The instrument would be calibrated against a manometer, which would be the calibration standard. For measurement of indirect quantities of pressure per unit area, the calibration uncertainty would be dependent on the density of the manometer fluid, and the means of measuring the height difference. From this other units such as pounds per square inch could be inferred and marked on the scale.

See also[edit]

Look up calibration in Wiktionary, the free dictionary.

- Calibration curve

- Calibrated geometry

- Calibration (statistics)

- Color calibration – used to calibrate a computer monitor or display.

- Deadweight tester

- EURAMET Association of European NMIs

- Measurement Microphone Calibration

- Measurement uncertainty

- Musical tuning – tuning, in music, means calibrating musical instruments into playing the right pitch.

- Precision measurement equipment laboratory

- Scale test car – a device used to calibrate weighing scales that weigh railroad cars.

- Systems of measurement

References[edit]

- ^ JCGM 200:2008 International vocabulary of metrology Archived 2019-10-31 at the Wayback Machine — Basic and general concepts and associated terms (VIM)

- ^ a b ISO 9001: «Quality management systems — Requirements» (2008), section 7.6.

- ^ a b ISO 17025: «General requirements for the competence of testing and calibration laboratories» (2005), section 5.

- ^ Faison, C. Douglas; Brickenkamp, Carroll S. (March 2004). «Calibration Laboratories: Technical Guide for Mechanical Measurements» (PDF). NIST Handbook 150-2G. NIST. Retrieved 14 June 2015.

- ^ «Metrology, Pressure, Thermal & Eletrotechnical Measurement and Calibration». Fluid Control Research Institute (FCRI), Ministry of Heavy Industries & Public Enterprises, Govt. of India. Archived from the original on 14 June 2015. Retrieved 14 June 2015.

- ^ Haider, Syed Imtiaz; Asif, Syed Erfan (16 February 2011). Quality Control Training Manual: Comprehensive Training Guide for API, Finished Pharmaceutical and Biotechnologies Laboratories. CRC Press. p. 49. ISBN 978-1-4398-4994-1.

- ^ Bare, Allen (2006). Simplified Calibration Interval Analysis (PDF). Aiken, SC: NCSL International Workshop and Symposium, under contract with the Office of Scientific and Technical Information, U.S. Department of Energy. pp. 1–2. Archived (PDF) from the original on 2007-04-18. Retrieved 28 November 2014.

- ^ «ANSI/NCSL Z540.3-2006 (R2013)». The National Conference of Standards Laboratories (NCSL) International. Archived from the original on 2014-11-20. Retrieved 28 November 2014.

- ^ «Calibration Systems Requirements (Military Standard)» (PDF). Washington, DC: U.S. Department of Defense. 1 August 1998. Archived from the original (PDF) on 2005-10-30. Retrieved 28 November 2014.

- ^ a b Ligowski, M.; Jabłoński, Ryszard; Tabe, M. (2011), Jabłoński, Ryszard; Březina, Tomaš (eds.), Procedure for Calibrating Kelvin Probe Force Microscope, Mechatronics: Recent Technological and Scientific Advances, p. 227, doi:10.1007/978-3-642-23244-2, ISBN 978-3-642-23244-2, LCCN 2011935381

- ^ Military Handbook: Evaluation of Contractor’s Calibration System (PDF). U.S. Department of Defense. 17 August 1984. p. 7. Archived (PDF) from the original on 2014-12-04. Retrieved 28 November 2014.

- ^ Procedure for calibrating pressure gauges (USBR 1040) (PDF). U.S. Department of the Interior, Bureau of Reclamation. pp. 70–73. Archived (PDF) from the original on 2013-05-12. Retrieved 28 November 2014.

- ^ «KNC Model 3666 Automatic Pressure Calibration System» (PDF). King Nutronics Corporation. Archived from the original (PDF) on 2014-12-04. Retrieved 28 November 2014.

- ^ «the definition of calibrate». Dictionary.com. Retrieved 18 March 2018.

- ^ Baber, Zaheer (1996). The Science of Empire: Scientific Knowledge, Civilization, and Colonial Rule in India. SUNY Press. pp. 23–24. ISBN 978-0-7914-2919-8.

- ^ Franceschini, Fiorenzo; Galetto, Maurizio; Maisano, Domenico; Mastrogiacomo, Luca; Pralio, Barbara (6 June 2011). Distributed Large-Scale Dimensional Metrology: New Insights. Springer Science & Business Media. pp. 117–118. ISBN 978-0-85729-543-9.

- ^ Ackroyd, Peter (16 October 2012). Foundation: The History of England from Its Earliest Beginnings to the Tudors. St. Martin’s Press. pp. 133–134. ISBN 978-1-250-01367-5.

- ^ Bland, Alfred Edward; Tawney, Richard Henry (1919). English Economic History: Select Documents. Macmillan Company. pp. 154–155.

- ^ Tilford, Charles R (1992). «Pressure and vacuum measurements» (PDF). Physical Methods of Chemistry: 106–173. Archived from the original (PDF) on 2014-12-05. Retrieved 28 November 2014.

- ^ Fridman, A. E.; Sabak, Andrew; Makinen, Paul (23 November 2011). The Quality of Measurements: A Metrological Reference. Springer Science & Business Media. pp. 10–11. ISBN 978-1-4614-1478-0.

- ^ Cuscó, Laurence (1998). Guide to the Measurement of Pressure and Vacuum. London: The Institute of Measurement and Control. p. 5. ISBN 0-904457-29-X.

Sources[edit]

- Crouch, Stanley & Skoog, Douglas A. (2007). Principles of Instrumental Analysis. Pacific Grove: Brooks Cole. ISBN 0-495-01201-7.

This article is about assessing the accuracy of a measurement device, like a scale or a ruler. For the statistical concept, see Calibration (statistics).

In measurement technology and metrology, calibration is the comparison of measurement values delivered by a device under test with those of a calibration standard of known accuracy. Such a standard could be another measurement device of known accuracy, a device generating the quantity to be measured such as a voltage, a sound tone, or a physical artifact, such as a meter ruler.

The outcome of the comparison can result in one of the following:

- no significant error being noted on the device under test

- a significant error being noted but no adjustment made

- an adjustment made to correct the error to an acceptable level

Strictly speaking, the term «calibration» means just the act of comparison and does not include any subsequent adjustment.

The calibration standard is normally traceable to a national or international standard held by a metrology body.

BIPM Definition[edit]

The formal definition of calibration by the International Bureau of Weights and Measures (BIPM) is the following: «Operation that, under specified conditions, in a first step, establishes a relation between the quantity values with measurement uncertainties provided by measurement standards and corresponding indications with associated measurement uncertainties (of the calibrated instrument or secondary standard) and, in a second step, uses this information to establish a relation for obtaining a measurement result from an indication.»[1]

This definition states that the calibration process is purely a comparison, but introduces the concept of measurement uncertainty in relating the accuracies of the device under test and the standard.

Modern calibration processes[edit]

The increasing need for known accuracy and uncertainty and the need to have consistent and comparable standards internationally has led to the establishment of national laboratories. In many countries a National Metrology Institute (NMI) will exist which will maintain primary standards of measurement (the main SI units plus a number of derived units) which will be used to provide traceability to customer’s instruments by calibration.

The NMI supports the metrological infrastructure in that country (and often others) by establishing an unbroken chain, from the top level of standards to an instrument used for measurement. Examples of National Metrology Institutes are NPL in the UK, NIST in the United States, PTB in Germany and many others. Since the Mutual Recognition Agreement was signed it is now straightforward to take traceability from any participating NMI and it is no longer necessary for a company to obtain traceability for measurements from the NMI of the country in which it is situated, such as the National Physical Laboratory in the UK.

Quality[edit]

To improve the quality of the calibration and have the results accepted by outside organizations it is desirable for the calibration and subsequent measurements to be «traceable» to the internationally defined measurement units. Establishing traceability is accomplished by a formal comparison to a standard which is directly or indirectly related to national standards (such as NIST in the USA), international standards, or certified reference materials. This may be done by national standards laboratories operated by the government or by private firms offering metrology services.

Quality management systems call for an effective metrology system which includes formal, periodic, and documented calibration of all measuring instruments. ISO 9000[2] and ISO 17025[3] standards require that these traceable actions are to a high level and set out how they can be quantified.

To communicate the quality of a calibration the calibration value is often accompanied by a traceable uncertainty statement to a stated confidence level. This is evaluated through careful uncertainty analysis.

Some times a DFS (Departure From Spec) is required to operate machinery in a degraded state. Whenever this does happen, it must be in writing and authorized by a manager with the technical assistance of a calibration technician.

Measuring devices and instruments are categorized according to the physical quantities they are designed to measure. These vary internationally, e.g., NIST 150-2G in the U.S.[4] and NABL-141 in India.[5] Together, these standards cover instruments that measure various physical quantities such as electromagnetic radiation (RF probes), sound (sound level meter or noise dosimeter), time and frequency (intervalometer), ionizing radiation (Geiger counter), light (light meter), mechanical quantities (limit switch, pressure gauge, pressure switch), and, thermodynamic or thermal properties (thermometer, temperature controller). The standard instrument for each test device varies accordingly, e.g., a dead weight tester for pressure gauge calibration and a dry block temperature tester for temperature gauge calibration.

Instrument calibration prompts[edit]

Calibration may be required for the following reasons:

- a new instrument

- after an instrument has been repaired or modified

- moving from one location to another location

- when a specified time period has elapsed

- when a specified usage (operating hours) has elapsed

- before and/or after a critical measurement

- after an event, for example

- after an instrument has been exposed to a shock, vibration, or physical damage, which might potentially have compromised the integrity of its calibration

- sudden changes in weather

- whenever observations appear questionable or instrument indications do not match the output of surrogate instruments

- as specified by a requirement, e.g., customer specification, instrument manufacturer recommendation.

In general use, calibration is often regarded as including the process of adjusting the output or indication on a measurement instrument to agree with value of the applied standard, within a specified accuracy. For example, a thermometer could be calibrated so the error of indication or the correction is determined, and adjusted (e.g. via calibration constants) so that it shows the true temperature in Celsius at specific points on the scale. This is the perception of the instrument’s end-user. However, very few instruments can be adjusted to exactly match the standards they are compared to. For the vast majority of calibrations, the calibration process is actually the comparison of an unknown to a known and recording the results.

Basic calibration process[edit]

Purpose and scope[edit]

The calibration process begins with the design of the measuring instrument that needs to be calibrated. The design has to be able to «hold a calibration» through its calibration interval. In other words, the design has to be capable of measurements that are «within engineering tolerance» when used within the stated environmental conditions over some reasonable period of time.[6] Having a design with these characteristics increases the likelihood of the actual measuring instruments performing as expected.

Basically, the purpose of calibration is for maintaining the quality of measurement as well as to ensure the proper working of particular instrument.

Frequency[edit]

The exact mechanism for assigning tolerance values varies by country and as per the industry type. The measuring of equipment is manufacturer generally assigns the measurement tolerance, suggests a calibration interval (CI) and specifies the environmental range of use and storage. The using organization generally assigns the actual calibration interval, which is dependent on this specific measuring equipment’s likely usage level. The assignment of calibration intervals can be a formal process based on the results of previous calibrations. The standards themselves are not clear on recommended CI values:[7]

- ISO 17025[3]

- «A calibration certificate (or calibration label) shall not contain any recommendation on the calibration interval except where this has been agreed with the customer. This requirement may be superseded by legal regulations.”

- ANSI/NCSL Z540[8]

- «…shall be calibrated or verified at periodic intervals established and maintained to assure acceptable reliability…»

- ISO-9001[2]

- «Where necessary to ensure valid results, measuring equipment shall…be calibrated or verified at specified intervals, or prior to use…”

- MIL-STD-45662A[9]

- «… shall be calibrated at periodic intervals established and maintained to assure acceptable accuracy and reliability…Intervals shall be shortened or may be lengthened, by the contractor, when the results of previous calibrations indicate that such action is appropriate to maintain acceptable reliability.»

Standards required and accuracy[edit]

The next step is defining the calibration process. The selection of a standard or standards is the most visible part of the calibration process. Ideally, the standard has less than 1/4 of the measurement uncertainty of the device being calibrated. When this goal is met, the accumulated measurement uncertainty of all of the standards involved is considered to be insignificant when the final measurement is also made with the 4:1 ratio.[10] This ratio was probably first formalized in Handbook 52 that accompanied MIL-STD-45662A, an early US Department of Defense metrology program specification. It was 10:1 from its inception in the 1950s until the 1970s, when advancing technology made 10:1 impossible for most electronic measurements.[11]

Maintaining a 4:1 accuracy ratio with modern equipment is difficult. The test equipment being calibrated can be just as accurate as the working standard.[10] If the accuracy ratio is less than 4:1, then the calibration tolerance can be reduced to compensate. When 1:1 is reached, only an exact match between the standard and the device being calibrated is a completely correct calibration. Another common method for dealing with this capability mismatch is to reduce the accuracy of the device being calibrated.

For example, a gauge with 3% manufacturer-stated accuracy can be changed to 4% so that a 1% accuracy standard can be used at 4:1. If the gauge is used in an application requiring 16% accuracy, having the gauge accuracy reduced to 4% will not affect the accuracy of the final measurements. This is called a limited calibration. But if the final measurement requires 10% accuracy, then the 3% gauge never can be better than 3.3:1. Then perhaps adjusting the calibration tolerance for the gauge would be a better solution. If the calibration is performed at 100 units, the 1% standard would actually be anywhere between 99 and 101 units. The acceptable values of calibrations where the test equipment is at the 4:1 ratio would be 96 to 104 units, inclusive. Changing the acceptable range to 97 to 103 units would remove the potential contribution of all of the standards and preserve a 3.3:1 ratio. Continuing, a further change to the acceptable range to 98 to 102 restores more than a 4:1 final ratio.

This is a simplified example. The mathematics of the example can be challenged. It is important that whatever thinking guided this process in an actual calibration be recorded and accessible. Informality contributes to tolerance stacks and other difficult to diagnose post calibration problems.

Also in the example above, ideally the calibration value of 100 units would be the best point in the gauge’s range to perform a single-point calibration. It may be the manufacturer’s recommendation or it may be the way similar devices are already being calibrated. Multiple point calibrations are also used. Depending on the device, a zero unit state, the absence of the phenomenon being measured, may also be a calibration point. Or zero may be resettable by the user-there are several variations possible. Again, the points to use during calibration should be recorded.

There may be specific connection techniques between the standard and the device being calibrated that may influence the calibration. For example, in electronic calibrations involving analog phenomena, the impedance of the cable connections can directly influence the result.

Manual and automatic calibrations[edit]

Calibration methods for modern devices can be manual or automatic.

Manual calibration — US serviceman calibrating a pressure gauge. The device under test is on his left and the test standard on his right.

As an example, a manual process may be used for calibration of a pressure gauge. The procedure requires multiple steps,[12] to connect the gauge under test to a reference master gauge and an adjustable pressure source, to apply fluid pressure to both reference and test gauges at definite points over the span of the gauge, and to compare the readings of the two. The gauge under test may be adjusted to ensure its zero point and response to pressure comply as closely as possible to the intended accuracy. Each step of the process requires manual record keeping.

Automatic calibration — A U.S. serviceman using a 3666C auto pressure calibrator

An automatic pressure calibrator [13] is a device that combines an electronic control unit, a pressure intensifier used to compress a gas such as Nitrogen, a pressure transducer used to detect desired levels in a hydraulic accumulator, and accessories such as liquid traps and gauge fittings. An automatic system may also include data collection facilities to automate the gathering of data for record keeping.

Process description and documentation[edit]

All of the information above is collected in a calibration procedure, which is a specific test method. These procedures capture all of the steps needed to perform a successful calibration. The manufacturer may provide one or the organization may prepare one that also captures all of the organization’s other requirements. There are clearinghouses for calibration procedures such as the Government-Industry Data Exchange Program (GIDEP) in the United States.

This exact process is repeated for each of the standards used until transfer standards, certified reference materials and/or natural physical constants, the measurement standards with the least uncertainty in the laboratory, are reached. This establishes the traceability of the calibration.

See Metrology for other factors that are considered during calibration process development.

After all of this, individual instruments of the specific type discussed above can finally be calibrated. The process generally begins with a basic damage check. Some organizations such as nuclear power plants collect «as-found» calibration data before any routine maintenance is performed. After routine maintenance and deficiencies detected during calibration are addressed, an «as-left» calibration is performed.

More commonly, a calibration technician is entrusted with the entire process and signs the calibration certificate, which documents the completion of a successful calibration.

The basic process outlined above is a difficult and expensive challenge. The cost for ordinary equipment support is generally about 10% of the original purchase price on a yearly basis, as a commonly accepted rule-of-thumb. Exotic devices such as scanning electron microscopes, gas chromatograph systems and laser interferometer devices can be even more costly to maintain.

The ‘single measurement’ device used in the basic calibration process description above does exist. But, depending on the organization, the majority of the devices that need calibration can have several ranges and many functionalities in a single instrument. A good example is a common modern oscilloscope. There easily could be 200,000 combinations of settings to completely calibrate and limitations on how much of an all-inclusive calibration can be automated.

An instrument rack with tamper-indicating seals

To prevent unauthorized access to an instrument tamper-proof seals are usually applied after calibration. The picture of the oscilloscope rack shows these, and prove that the instrument has not been removed since it was last calibrated as they will possible unauthorized to the adjusting elements of the instrument. There also are labels showing the date of the last calibration and when the calibration interval dictates when the next one is needed. Some organizations also assign unique identification to each instrument to standardize the record keeping and keep track of accessories that are integral to a specific calibration condition.

When the instruments being calibrated are integrated with computers, the integrated computer programs and any calibration corrections are also under control.

Historical development[edit]

Origins[edit]

The words «calibrate» and «calibration» entered the English language as recently as the American Civil War,[14] in descriptions of artillery, thought to be derived from a measurement of the calibre of a gun.

Some of the earliest known systems of measurement and calibration seem to have been created between the ancient civilizations of Egypt, Mesopotamia and the Indus Valley, with excavations revealing the use of angular gradations for construction.[15] The term «calibration» was likely first associated with the precise division of linear distance and angles using a dividing engine and the measurement of gravitational mass using a weighing scale. These two forms of measurement alone and their direct derivatives supported nearly all commerce and technology development from the earliest civilizations until about AD 1800.[16]

Calibration of weights and distances (c. 1100 CE)[edit]

An example of a weighing scale with a ½ ounce calibration error at zero. This is a «zeroing error» which is inherently indicated, and can normally be adjusted by the user, but may be due to the string and rubber band in this case

Early measurement devices were direct, i.e. they had the same units as the quantity being measured. Examples include length using a yardstick and mass using a weighing scale. At the beginning of the twelfth century, during the reign of Henry I (1100-1135), it was decreed that a yard be «the distance from the tip of the King’s nose to the end of his outstretched thumb.»[17] However, it wasn’t until the reign of Richard I (1197) that we find documented evidence.[18]

- Assize of Measures

- «Throughout the realm there shall be the same yard of the same size and it should be of iron.»

Other standardization attempts followed, such as the Magna Carta (1225) for liquid measures, until the Mètre des Archives from France and the establishment of the Metric system.

The early calibration of pressure instruments[edit]

Direct reading design of a U-tube manometer

One of the earliest pressure measurement devices was the Mercury barometer, credited to Torricelli (1643),[19] which read atmospheric pressure using Mercury. Soon after, water-filled manometers were designed. All these would have linear calibrations using gravimetric principles, where the difference in levels was proportional to pressure. The normal units of measure would be the convenient inches of mercury or water.

In the direct reading hydrostatic manometer design on the right, applied pressure Pa pushes the liquid down the right side of the manometer U-tube, while a length scale next to the tube measures the difference of levels. The resulting height difference «H» is a direct measurement of the pressure or vacuum with respect to atmospheric pressure. In the absence of differential pressure both levels would be equal, and this would be used as the zero point.

The Industrial Revolution saw the adoption of «indirect» pressure measuring devices, which were more practical than the manometer.[20]

An example is in high pressure (up to 50 psi) steam engines, where mercury was used to reduce the scale length to about 60 inches, but such a manometer was expensive and prone to damage.[21] This stimulated the development of indirect reading instruments, of which the Bourdon tube invented by Eugène Bourdon is a notable example.

Indirect reading design showing a Bourdon tube from the front (left) and the rear (right).

In the front and back views of a Bourdon gauge on the right, applied pressure at the bottom fitting reduces the curl on the flattened pipe proportionally to pressure. This moves the free end of the tube which is linked to the pointer. The instrument would be calibrated against a manometer, which would be the calibration standard. For measurement of indirect quantities of pressure per unit area, the calibration uncertainty would be dependent on the density of the manometer fluid, and the means of measuring the height difference. From this other units such as pounds per square inch could be inferred and marked on the scale.

See also[edit]

Look up calibration in Wiktionary, the free dictionary.

- Calibration curve

- Calibrated geometry

- Calibration (statistics)

- Color calibration – used to calibrate a computer monitor or display.

- Deadweight tester

- EURAMET Association of European NMIs

- Measurement Microphone Calibration

- Measurement uncertainty

- Musical tuning – tuning, in music, means calibrating musical instruments into playing the right pitch.

- Precision measurement equipment laboratory

- Scale test car – a device used to calibrate weighing scales that weigh railroad cars.

- Systems of measurement

References[edit]

- ^ JCGM 200:2008 International vocabulary of metrology Archived 2019-10-31 at the Wayback Machine — Basic and general concepts and associated terms (VIM)

- ^ a b ISO 9001: «Quality management systems — Requirements» (2008), section 7.6.

- ^ a b ISO 17025: «General requirements for the competence of testing and calibration laboratories» (2005), section 5.

- ^ Faison, C. Douglas; Brickenkamp, Carroll S. (March 2004). «Calibration Laboratories: Technical Guide for Mechanical Measurements» (PDF). NIST Handbook 150-2G. NIST. Retrieved 14 June 2015.

- ^ «Metrology, Pressure, Thermal & Eletrotechnical Measurement and Calibration». Fluid Control Research Institute (FCRI), Ministry of Heavy Industries & Public Enterprises, Govt. of India. Archived from the original on 14 June 2015. Retrieved 14 June 2015.

- ^ Haider, Syed Imtiaz; Asif, Syed Erfan (16 February 2011). Quality Control Training Manual: Comprehensive Training Guide for API, Finished Pharmaceutical and Biotechnologies Laboratories. CRC Press. p. 49. ISBN 978-1-4398-4994-1.

- ^ Bare, Allen (2006). Simplified Calibration Interval Analysis (PDF). Aiken, SC: NCSL International Workshop and Symposium, under contract with the Office of Scientific and Technical Information, U.S. Department of Energy. pp. 1–2. Archived (PDF) from the original on 2007-04-18. Retrieved 28 November 2014.

- ^ «ANSI/NCSL Z540.3-2006 (R2013)». The National Conference of Standards Laboratories (NCSL) International. Archived from the original on 2014-11-20. Retrieved 28 November 2014.

- ^ «Calibration Systems Requirements (Military Standard)» (PDF). Washington, DC: U.S. Department of Defense. 1 August 1998. Archived from the original (PDF) on 2005-10-30. Retrieved 28 November 2014.

- ^ a b Ligowski, M.; Jabłoński, Ryszard; Tabe, M. (2011), Jabłoński, Ryszard; Březina, Tomaš (eds.), Procedure for Calibrating Kelvin Probe Force Microscope, Mechatronics: Recent Technological and Scientific Advances, p. 227, doi:10.1007/978-3-642-23244-2, ISBN 978-3-642-23244-2, LCCN 2011935381

- ^ Military Handbook: Evaluation of Contractor’s Calibration System (PDF). U.S. Department of Defense. 17 August 1984. p. 7. Archived (PDF) from the original on 2014-12-04. Retrieved 28 November 2014.

- ^ Procedure for calibrating pressure gauges (USBR 1040) (PDF). U.S. Department of the Interior, Bureau of Reclamation. pp. 70–73. Archived (PDF) from the original on 2013-05-12. Retrieved 28 November 2014.

- ^ «KNC Model 3666 Automatic Pressure Calibration System» (PDF). King Nutronics Corporation. Archived from the original (PDF) on 2014-12-04. Retrieved 28 November 2014.

- ^ «the definition of calibrate». Dictionary.com. Retrieved 18 March 2018.

- ^ Baber, Zaheer (1996). The Science of Empire: Scientific Knowledge, Civilization, and Colonial Rule in India. SUNY Press. pp. 23–24. ISBN 978-0-7914-2919-8.

- ^ Franceschini, Fiorenzo; Galetto, Maurizio; Maisano, Domenico; Mastrogiacomo, Luca; Pralio, Barbara (6 June 2011). Distributed Large-Scale Dimensional Metrology: New Insights. Springer Science & Business Media. pp. 117–118. ISBN 978-0-85729-543-9.

- ^ Ackroyd, Peter (16 October 2012). Foundation: The History of England from Its Earliest Beginnings to the Tudors. St. Martin’s Press. pp. 133–134. ISBN 978-1-250-01367-5.

- ^ Bland, Alfred Edward; Tawney, Richard Henry (1919). English Economic History: Select Documents. Macmillan Company. pp. 154–155.

- ^ Tilford, Charles R (1992). «Pressure and vacuum measurements» (PDF). Physical Methods of Chemistry: 106–173. Archived from the original (PDF) on 2014-12-05. Retrieved 28 November 2014.

- ^ Fridman, A. E.; Sabak, Andrew; Makinen, Paul (23 November 2011). The Quality of Measurements: A Metrological Reference. Springer Science & Business Media. pp. 10–11. ISBN 978-1-4614-1478-0.

- ^ Cuscó, Laurence (1998). Guide to the Measurement of Pressure and Vacuum. London: The Institute of Measurement and Control. p. 5. ISBN 0-904457-29-X.

Sources[edit]

- Crouch, Stanley & Skoog, Douglas A. (2007). Principles of Instrumental Analysis. Pacific Grove: Brooks Cole. ISBN 0-495-01201-7.

- В данном примере термин калибровка относят к системе сбора данных, термин градуировка относят к датчику, а термин тарировка – ко всей рассматриваемой системе.

- Далее, рассмотрим подробнее технический смысл этих терминов.

- Калибровка – это устранение большей части систематической погрешности прибора путём задания коэффициентов коррекции данных для штатной операции коррекции данных, которая должна действовать в процессе работы этого прибора.

В большинстве случаев применяется линейная функция коррекции данных с двумя коэффициентами коррекции смещения нуля и коэффициента передачи, В любом случае, прибор должен сохранять калибровочные коэффициенты в энергонезависимой памяти, а сама операция коррекции данных может делаться как средствами самого прибора, так и средствами штатного ПО, поставляемого для этого прибора.

Производители приборов используют калибровку в целях уменьшения стоимости прибора, поскольку, в противном случае, пришлось бы применять высокопрецизионные компоненты и дорогостоящие технологические решения, которые сразу «от момента рождения» прибора обеспечивали бы требуемую величину систематической погрешности.

Для Средства Измерения операция калибровки делается метрологической службой в соответствии с Методикой поверки. В любом случае, важно отметить, что калибровка – это не пользовательская операция, которая, как правило, делается на предприятии изготовителе или аккредитованной организацией, для достижения заявленных производителем метрологических свойств.

Градуировка в рассматриваемом случае датчика – это заявленная производителем датчика зависимость выходной величины от входной в виде формул и таблиц. Когда речь идёт о стандартных датчиках (например, термопарах, термопреобразователях), изготовленных по стандартным технологическим параметрам, то градуировочные зависимости описываются в соответствующих ГОСТах на эти типы датчиков.

Градуировочные зависимости могут быть нелинейными, При применении такого датчика совместно с системой сбора данных на верхнем программном уровне должна быть применена соответствующая градуировочная функция этого датчика. Важно отметить, что применение градуировочной функции не устраняет полностью систематическую погрешность конкретного экземпляра датчика, а устраняет лишь большую часть этой погрешности.

Для чего нужна калибровка?

Что же такое калибровка? — Калибровка представляет собой набор действий, определяющих взаимосвязь между значениями измеряемой величины, указанной калибруемым измерительным прибором, и соответствующими значениями физических величин, осуществляемых с помощью стандартных единиц измерения и с учетом неопределенности измерения.

В простейшем случае эта процедура заключается в определении разницы между показанием стандарта и показанием калибруемого прибора с учетом неопределенности измерений. Целью калибровки является определение метрологических свойств калибруемого прибора, определение его пригодности для проведения измерений или подтверждение того, что калиброванный прибор соответствует определенным метрологическим требованиям (поверка).

Доказательством, подтверждающим метрологические свойства откалиброванного прибора, является документ, выданный лабораторией, и именуемый как сертификат о калибровке (поверке) с указанными символами аккредитации. Во время калибровки необходимо поддерживать согласованность измерений, также известную как прослеживаемость, составляющую непрерывную привязку калибруемого прибора по национальному или международному стандарту.

Что такое Тарировочная таблица?

Тарировка — что это за непонятное слово? Что подразумевается под тарировкой? Для чего нужна тарировка? Эти вопросы не дают покоя многим людям, кто впервые сталкивается с системами спутникового мониторинга транспорта и контроля топлива и впервые слышит данный термин.

- Большой толковый словарь современного русского языка Д.Н. Ушакова на эту тему сообщает: » Тарировать — проверить (проверять) показания каких-нибудь приборов путем сличения с показаниями контрольных приборов.»

- Словарь русских синонимов сообщает: » Тарировать — калибровать, градуировать»

- В Викисловаре находим: » Тарировка — градуировка измерительных приборов и регулирующих устройств», » Калибровка — проверка или измерение шкалы делений какого-нибудь измерительного прибора, сопоставление делений инструментальной шкалы со значениями измеряемой величины»

Теперь термин «тарировка» стал понятен и уже не вызывает вопросов. Осталось разобраться, какую роль играет тарировка в спутниковом мониторинге транспорта при помощи систем ГЛОНАСС и GPS. И в этом случае, оказывается, всё достаточно просто. Все датчики уровня топлива универсальны и подходят под любой топливный бак.

ДУТ различаются лишь длиной трубок. Но все баки разные по форме и объему. Два разных бака могут быть, например, одинаковой высоты, но разной длины. В связи с этим их объемы будут сильно отличаться. Так вот, чтобы диспетчер видел точное количество топлива в баках ДУТ необходимо откалибровать или тарировать,

Чтобы в итоге получить тарировочную таблицу, Тарировочная таблица — таблица, составляемая в процессе тарировки. Содержит в одной колонке данные, выдаваемые ДУТ, а во второй колонке соответствующие им значения в литрах.

Чем отличается калибровка от тарировки?

Термины: Калибровка, тарировка, градуировка В данном примере термин калибровка относят к системе сбора данных, термин градуировка относят к датчику, а термин тарировка – ко всей рассматриваемой системе.

Что такое слово калибровка?

Подстройка, проверка или измерение шкалы делений какого-нибудь измерительного прибора, сопоставление делений инструментальной шкалы со значениями измеряемой величины ◆ Калибровка термометра.

Для чего нужна тарировка?

Тарировка баков с «Ресурсконтроль» — Тарировка топливных баков в «Ресурсконтроль» осуществляется с помощью мобильных тарировочных станций. Тарировочная станция – это передвижной комплекс оборудования для тарирования, позволяющий проводить процедуру тарировки максимально быстро и в любой точке без привязки к АЗС или наличию 220В.

- Станция оборудована ёмкостью 1000 литров, генератором, насосом и мерными ёмкостями.

- С мобильной тарировочной станцией процесс тарировки максимально автоматизирован и происходит без использования дополнительного оборудования.

- Топливо из бака откачивается в ёмкость еврокуба, после чего порциями заливается обратно в бак, проходя через счётчик, который предварительно калибруется и проверяется.

тарировка производится по удобному для клиента адресу и не требует привлечения ответственных лиц со стороны клиента.

Как пользоваться Тарировочной таблицей?

Для топливомера ПТ-041 нужны следующие замеры: — 1. «Пустой бак» (при замере включать топливомер не нужно) – установите направляющую топливомера на горловину, как показано на рисунке. Упорная планка должна лежать на плоскости горловины, чтобы измерительная линейка располагалась к поверхности топлива под тем же углом, что и горловина.

Как измерить уровень топлива в баке линейкой?

16.06.2017 Как измерить количество топлива, оставшегося в баке автомобиля? Датчик на приборной панели не дает точной информации о количестве топлива. Самый простой способ узнать точную цифру – это опустить палку или линейку в топливный бак, а затем измерить значение и определить остаток по таблице.

- Специально для этого мы подготовили для вас тарировку топливного бака DAF (ДАФ).

- Если вы хотите узнать объём топливного бака DAF вам необходимо измерить линейкой топливный бак DAF и сравнить данные с таблицами указанные ниже.

- Мы разместили самые популярные размеры и объёмы топливных баков DAF (ДАФ), данные таблицы топливных баков DAF носят исключительно информативный характер.

Данные в тарировачных таблицах DAF могут иметь погрешность. Технология измерения проста. Берёте линейку и опускаете её в топливную горловину. Вытаскиваете линейку и смотрите сколько сантиметров линейки находилось в баке с топливом. Смотрите сантиметры в таблице объёмов бака и сравниваете значение с вашим топливным баком. На автомобиле были установлены 2 бака объемом 560 литров: На автомобиле установлено 2 бака объемом 850 и 430 литров, их тарировка: На автомобиле установлен бак объемом 850 литров, его тарировка: Тарировка баков 690 л, 400 л, 620 л и 750 л: На автомобиле установлены баки объемом 995 и 500 литров, их тарировка: На автомобиле установлен бак объемом 870 литров, его тарировка: На автомобиле установлен бак объемом 600 литров, его тарировка:

Что такое поверка и калибровка?

Калибровка и поверка. Разбираемся в понятиях — Специалистов белорусских лабораторий давно интересует вопрос: в чем заключается разница между калибровкой и поверкой? Эту разницу пытаются объяснить специалисты государственной метрологической службы, но для многих вопрос остается.

- И когда приходит время принять решение поверять или калибровать средства измерений, большинство специалистов задумываются и не могут однозначно ответить для себя на этот вопрос.

- Давайте попробуем разобраться.

- А разбираться начнем с понятий.

- Что же такое калибровка? А что такое поверка? На национальном уровне понятия калибровка и поверка закреплены в Законе Республики Беларусь об обеспечении единства измерений,

На международном уровне понятие калибровка закреплено в международном словаре по метрологии JCGM 200:2008,, Сравнение понятия приведено в таблице 1. Таблица 1 – Сравнение понятий «калибровка» и «поверка»

Получается понятие «поверка» включает в себя процедуры, предусмотренные при калибровке. РАЗРАБОТКА/ВАЛИДАЦИЯ МЕТОДИК Выполним работы по разработке Методик выполнения измерений ПОДРОБНЕЕ ОБ УСЛУГЕ С другой стороны, просто устанавливать характеристики без дальнейшего принятия решений бессмысленно. Измерительные устройства и эталоны, к которым может применяться процедура калибровки, предназначены для получения результатов измерений с заданной точностью.

Характеристики, которые устанавливаются при калибровке, напрямую влияют на точность и надежность получаемых результатов измерений. Поэтому на основании результатов калибровки специалист, использующий при измерении измерительные устройства или эталоны, должен принять решение: «а пригодно ли мое средство измерений (эталон, испытательное оборудование, измерительные системы) для получения надежного результата измерений (с требуемой точностью)?».2.

Что подлежит калибровке?

Средства измерений, подлежащие обязательной калибровке: — В обязательном порядке сертификация проводится для средств измерений, попадающих в одну из следующих групп:

КИП, обеспечивающие безопасный технологический процесс; приборы, применяемые в процессе совершения торговых, коммерческих и учетных операций; СИ, использование которых оказывает непосредственное влияние на качество продукции; образцовые и эталонные средства измерений. Они в обязательном порядке проходят сертификацию в государственных органах контроля, а также периодические поверки представителями этих инстанций; СИ, применение которых влияет на экологическую безопасность.