Недавно меня попросили помочь с получением данных из интернета по стоимости ЕТФ фондов.

Первое, что пришло в голову — конечно же googlefinance()

Однако ТКСных ЕТФок там не оказалось. Данную проблему можно решить двумя способами — через регулярные выражения (и о них я поговорю в следующей статье) и стандартным способом — через встроенную гугл функцию importxml(). Взвесив все за и против, я решил пойти путём наименьшего сопротивления.

Почему так? Очень просто — кастом-функция по regExp через фетч, воспринимается как скрипт и, как следствие, подлежит квотированию со стороны гугла. Вообще тема квотирования, как и кэширования, для меня (и гугла) — больная и о ней я тоже как-нибудь напишу отдельно большой «возмущения пост» 🙂

Importxml принимает в себя два текстовых аргумента:

IMPORTXML(ссылка; запрос_xpath)

- ссылка – адрес веб-страницы с указанием протокола (например, http://).

- запрос_xpath – запрос XPath для поиска данных.

И если с ссылкой все понятно, то с запросом XPath может возникнуть сложность.

Вообще, если глубоко погружаться в XPath, то рекомендую почитать здесь: https://msiter.ru/tutorials/xpath.

Однако, есть более простой способ решить проблему понимания дерева xpath для тех, кому надо всё, сразу, здесь и сейчас.

XPath в хроме

Вернёмся к задаче, потому что на практическом примере это понять намного проще

У меня был список требуемых ЕТФ:

И, как писал ранее, таких тикеров в googlefinance нет.

Хорошо, перехожу на сайт — https://www.tinkoff.ru/invest/etfs/TSPX/ — и вижу стоимость:

Мне нужно получить в гугл таблицу 0,1199$

Для этого подвожу мышь к цене 0,1199 и перехожу в «Просмотреть код«

Стоимость находится тут:

Уже здесь можно скопировать путь Xpath:

и дальше просто вставить его в пустую ячейку таблицы.

Итого: у меня есть url и есть Xpath

Самое время посмотреть что получу через importxml:

Цена есть, правда знак доллара уехал.

Те, кто был чуть повнимательнее, заметили выше   — неразрывный пробел ( в данном случае их два) который как раз и разносит содержимое.

Что делать?

Подняться на уровень (а в случае сайта тинькофф — на два уровня) выше и импортировать все содержимое span класса со всеми переносами, пробелами, спец символами и так далее и тому подобное:

Получив в результате:

Победа? Ну… почти.

Все дело в том, что результат импорта «0,1199 $» — это текст и для дальнейших вычислений он не пригоден.

Из текста в цифру

Через стандартные функции:

- Удаляю пробелы (если они там есть) — Trim: =TRIM(A4)

2. Заменяю спецсимволы на пустоту — Subsitute: =SUBSTITUTE(B4;» «;»»)

3. Заменяю знак доллара на пустоту — Subsitute: =SUBSTITUTE(C4;»$»;»»)

4. Привожу результат к числовому значению — Value: =VALUE(D4)

Так как тикеры из списка не только долларовые, но и рублёвые, необходимо так же через substitute сделать замену «₽» на пустоту. Если в итоге объединить всё в одну формулу в рамках одной ячейки, получится примерно следующий «вложенный монстр»:

=VALUE(SUBSTITUTE(SUBSTITUTE(SUBSTITUTE(TRIM(K2);» «;»»);»$»;»»);»₽»;»»))

Далее, дело за малым — распространить importxml и формулу выше на все тикеры.

Что же, первую часть задачи я решил. У меня есть цена на каждый указанный тикер.

Но это только пол дела. Цену надо ещё и обновлять.

И вот тут в дело вступают google apps scripts.

Переключатель ссылки (или просто Switcher)

Все дело в том, что гугл кэширует результаты выполнения importxml и обновляет их по одним гуглу известным алгоритмам. Я перерыл тонны вариантов решения этой проблемы где только можно и нельзя и самым «изящным» и приемлемым стал следующий: при обновлении ссылки (как аргумента importxml) гугл воспринимает ее как новую и заново перевыполняет функцию importxml.

То есть мне надо обновлять первый аргумент функции, при неизменном втором — xpath. Вот тут в действие и вступает так называемый «свитчер».

Это «условный» переключатель, который будет меняться с 1 на 0 скриптом.

Что все это значит? Написанный далее скрипт будет менять значение ячейки B1 c единицы на ноль (и обратно) и далее в зависимости от значения ячейки «свитчера» (1 или 0), будет меняться ссылка в importxml.

Чтобы она менялась на новую, но вела на тот же сайт за теми же значениями, я добавляю несуществующий параметр сайта ?Param=1

Скрипт

Перехожу в Apps script

и пишу следующий скрипт:

const ss = SpreadsheetApp.getActiveSpreadsheet() // обращаюсь к книге

const paramsWs = ss.getSheetByName("Params")

const SWITCHER_CELL = "B1"

const switcherCell = paramsWs.getRange(SWITCHER_CELL)

const switcherValue = switcherCell.getValue()

if(switcherValue == 1){

switcherCell.setValue(0)

} else {

switcherCell.setValue(1)

}

}

Ну и под конец….

Триггер — запуск по таймеру

Перехожу в «Триггеры«

В правом нижнем углу нажимаю

Выбираю свитчер (он у меня один)

Выбираю «триггер по времени»

Тип триггера — по минутам и далее — интервал

Сохраняю 🙂

Теперь гугл по триггеру будет сам включать свитчер. Свитчер будет менять свое значение (0 или 1) и, как следствие, вызывать пересчет importxml.

Небольшой комментарий. Как показала практика, при списках — т.е. где надо импортировать не одну запись, а целую таблицу записей, промежуток времени лучше ставить либо 15, либо 30 минут.

В этой статье мы рассмотрим на примерах, как парсить содержимое сайтов с помощью Google Таблиц. В частности, рассмотрим функции importHTML и importXML. Первую функцию очень удобно использовать если данные находятся в какой-то таблице или списке, а вторая функция является универсальной и практически не имеет ограничений.

Функция importHTML

С помощью функции importHTML можно настроить импорт данных из таблицы или списка на странице сайта.

Синтаксис

=IMPORTHTML(ссылка; запрос; индекс)

- ссылка — ссылка на веб-страницу, включая протокол (http:// или https://),

- запрос — значения «table» или «list», смотря, что нужно парсить (таблицу или список),

- индекс – порядковый номер списка или таблицы (отсчет начинается с 1).

Пример:

IMPORTHTML("http://ru.wikipedia.org/wiki/Население_Индии"; "table"; 4)

Переменные можно разместить в ячейках, тогда формула изменится так:

IMPORTHTML(A2; B2; C2)

Примеры использования importHTML

Выгрузка любых табличных данных

Однажды мне понадобилось собрать список минус-слов по городам России в существительном падеже. Первые пару нагугленных файлов с минус-словами были неполными, а в других меня не устроила словоформа. Поэтому я просто решил спарсить страницу Википедии, что заняло около двух минут, включая время на открытие Гугл Таблицы, поиск нужной страницы Википедии и настройку формулы. С этого примера я и начну.

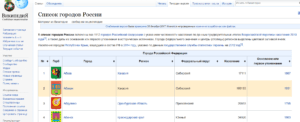

Задача: выгрузить список всех городов России со страницы https://ru.wikipedia.org/wiki/Список_городов_России

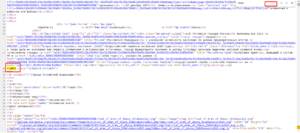

Чтобы выгрузить данные из этой таблицы нам нужно указать в формуле ее порядковый номер в коде страницы. Чтобы этот номер узнать, нужно открыть код сайта (в нормальных браузерах это сочетание Ctrl+U, либо клавиша F12, открывающая панель разработчика). А дальше поиском по коду определить порядковый номер:

В данном случае целевая таблица является первой в коде.

Составляем формулу:

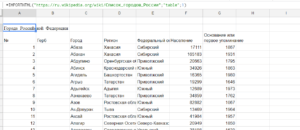

=IMPORTHTML("https://ru.wikipedia.org/wiki/Список_городов_России";"table";1)

Результат:

Выгрузка данных из списка

Как-то я работал с интернет-магазином у которого была обширная структура и очень неудобное меню. Надо было бегло оценить текущую структуру сайта, чтобы понять ассортимент и возможные очевидные проблемы, типа дублирования пунктов меню. Меню было реализовано в виде списка, чем я и воспользовался. Меньше чем через минуту полная иерархия сайта отображалась у меня в Гугл Табличке.

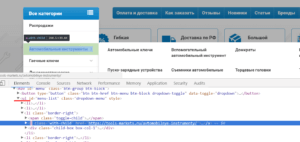

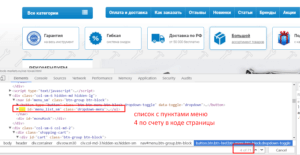

Задача: выгрузить все пункты меню, оформленного тегами <ul>…</ul>.

Как и в первом примере для формулы понадобится определить порядковый номер списка в коде сайта. В данном случае — четвертый.

Составляем формулу:

=IMPORTHTML("https://tools-markets.ru/";"list";3)

Результат:

Списки и таблицы — это хорошо, но чаще всего необходимо выдернуть с сайта информацию, оформленную другими тегами. Например, тексты, цены, заголовки и так дальше. Эти данные можно спарсить, используя формулу importXML, разберем ее подробнее.

Функция importXML

С помощью функции importXML можно настроить импорт данных из источников в формате XML, HTML, CSV, TSV, а также RSS и ATOM XML.

По сравнению с importHTML у данной функции гораздо более широкое применение. Она позволяет собирать практически любую информацию со страницы/документа, от частичных фрагментов до полного ее содержания. Ниже будут описаны примеры парсинга HTML-страниц сайта. Парсинг по файлам рассматривать не стану, т.к. такая задача возникает редко и большинство из вас с этим не столкнется никогда. Но если что, принцип работы везде одинаковый, главное понять суть.

Синтаксис

IMPORTXML(ссылка; "//XPath запрос")

- ссылка – адрес веб-страницы с указанием протокола (http:// или https://). Значение этого параметра должно быть заключено в кавычки или представлять собой ссылку на ячейку, содержащую URL страницы.

- //XPath запрос – то, что будем импортировать. Ниже мы разберем основные примеры запросов (а тут подробнее про XPath).

Пример:

IMPORTXML("https://en.wikipedia.org/wiki/Moon_landing"; "//a/@href")

Значения переменных можно хранить в ячейках, тогда формула будет такой:

IMPORTXML(A2; B2)

Примеры использования importХML

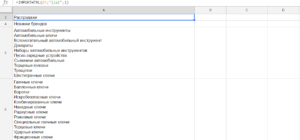

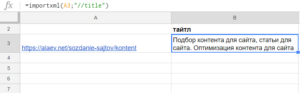

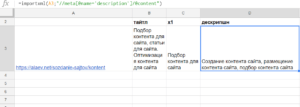

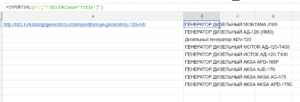

Пример 1. Импорт мета-тегов и заголовков со страниц

Самая простая и распространенная ситуация, которая может быть — узнать мета-теги или заголовки продвигаемых страниц. Для этих целей лучше подходит парсинг сайта специализированным софтом типа Comparser’a. Но бывают и исключения, например, если сайт очень большой и это сделать затруднительно, либо у вас нет под рукой программы. Или если вы собираетесь дальше использовать полученные данные в таблицах для мониторинга изменений мета-тегов и сверки целевых и фактических мета-тегов на страницах.

Формулы простые.

Получаем title страницы:

=importxml(A3;"//title")

Получаем заголовки h1:

=importxml(A3;"//h1")

Получаем description:

=importxml(A3;"//meta[@name='description']/@content")

Последняя формула получилась сложнее т.к. нас интересует значение не самого тега, а его атрибута:

- ищем тег meta //meta

- у которого есть атрибут name=’description’ [@name=’description’]

- и парсим содержимое второго атрибута content /@content

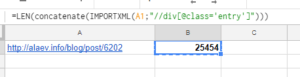

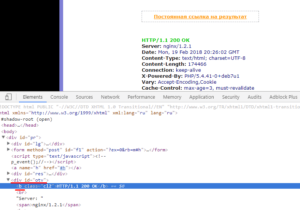

Пример 2. Определяем наличие текста на странице и его длину в символах

Этот пример мне помог при работе с проектом, тексты для которого писал и размещал сам клиент, и ему было чрезвычайно лень сообщать мне о ходе процесса. Небольшой лайфхак с Гугл таблицами позволил мне мониторить динамику его работы, а ему с чистой совестью и дальше продолжать лениться и не сообщать мне ничего.

Рассмотрим ситуацию на примере нашего блога http://alaev.info, а конкретно на странице https://alaev.info/blog/post/6202. Если заглянуть в код, то мы увидим, что контент страницы расположен в теге <div> с классом entry.

Формула:

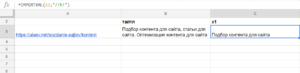

=LEN(concatenate(IMPORTXML(A1;"//div[@class='entry']")))

В ячейке А1 у нас ссылка на статью, в запросе XPath мы получаем содержимое тега div, у которого есть класс entry, то есть парсим весь текст страницы: =IMPORTXML(A1;"//div[@class='entry']")

Функция CONCATENATE (в русском варианте СЦЕПИТЬ) нужна, чтобы объединить все абзацы в один кусок контента. Без нее мы посчитаем только объем первого абзаца.

Функция LEN (в русском варианте ДЛСТР) считает количество символов.

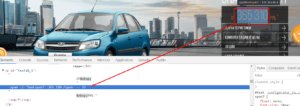

Пример 3. Выгружаем актуальные цены

Однажды потребовалось не только заниматься оптимизацией сайта, но и следить за ценами конкурентов по схожим товарным позициям. Использование специализированного софта и сервисов я практически сразу отмел, т.к. специальные сервисы по мониторингу не укладывались в бюджет, а вручную сканировать сайты конкурентов несколько раз в неделю не комильфо.

К счастью, вариант с Гугл доками оказался подходящим и уже к концу дня я все настроил так, что данные подтягивались автоматически. От меня ничего не требовалось, кроме как отправить ссылку на документ клиенту и спокойно заниматься своими делами.

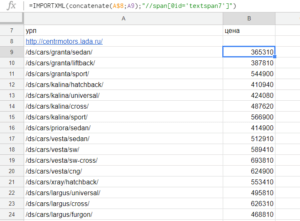

Я решил рассмотреть похожую ситуацию на случайном сайте. Итак, допустим, мы хотим мониторить цены на автомобили и, скажем, выгружать актуальные цены с сайта http://centrmotors.lada.ru/. Вот пример товарной карточки http://centrmotors.lada.ru/ds/cars/granta/sedan/.

Чтобы настроить формулу снова идем в код сайта и смотрим в каких тегах располагается цена. Примеры должны быть простыми, поэтому я буду выгружать только минимальную цену.

На данном сайте нам надо парсить содержимое тега <span> с id textspan7.

Формула:

=importxml(A2;"//span[@id='textspan7']")

В таблице ссылки на товары укажем в столбце А, а формулу вставим в столбец В.

Результат:

Поясню:

- A2 — номер ячейки из которой берется адрес страницы,

- //span[@id=’textspan7′] — блок из которого будем выводить информацию.

- Если бы у нас вместо span был div, а вместо id был бы class, то вторая часть формулы была такой:

//div[@class='textspan7']

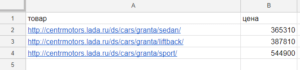

Автоматизируем дальше.

Приведенное выше решение не идеальное, ведь нам надо предварительно собрать адреса товарных страниц, а это довольно муторно. Если на сайт добавят новые модели авто, то информация по ним не будет подгружаться в таблицу т.к. адреса страниц будут отсутствовать в документе.

Подключив логику и другие формулы, можно хакнуть рутину. Ссылки на все модели присутствуют в главном меню. А если есть ссылки, то скорее всего их тоже можно спарсить.

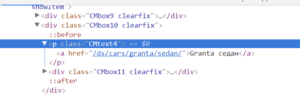

И действительно, заглянув в код, мы увидим, что ссылки на товарные страницы располагаются в теге <p> c классом CMtext4:

Формула:

=IMPORTXML(A8;"//p[@class='CMtext4']/a/@href")

- A8 – в этой ячейке ссылка на сайт,

- p[@class=’CMtext4′] – тут мы ищем содержимое тега <p> с классом CMtext4,

- /a/@href – а в этой части формулы мы уточняем, что из содержимого <p> хотим достать содержимое вложенного тега <a>, а если еще точнее, то ту часть, которая прописана в href=»».

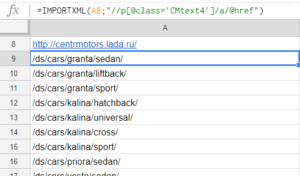

После применения формулы в документе получится такой список:

Мы получили ссылки на все товары, которые нас интересуют. Осталось настроить парсинг цен по этим адресам. Но ссылки на страницы относительные, а нам обязательно нужны абсолютные ссылки, включающие имя домена. Чтобы подставить в ссылку домен используем функцию CONCATENATE.

Формула:

=IMPORTXML(concatenate("http://centermotors.lada.ru";A9);"//span[@id='textspan7']")

Либо при условии, что у нас в ячейке А8 находится адрес домена:

=IMPORTXML(concatenate(A$8;A9);"//span[@id='textspan7']")

Размещаем мы ее справа от первой ссылки на товарную страницу и протягиваем вниз для всех ссылок или до конца листа на случай, если в будущем будет больше товаров.

Результат:

Поясню, если кто-то еще не разобрался:

- A$8 — ячейка, в которой указан домен сайта. Знаком $ фиксируем строку, чтобы это значение не изменилось, когда мы начнем протягивать формулу вниз.

- A9 — это первый URL товарной страницы, при перетаскивании формулы значение автоматически меняется, т.е. в 10 строке у нас вместо A9 будет A10, в 11 строке A11 и т.д.

Теперь если на сайте будут добавлены или удалены товары, то в нашем файле ссылки на них автоматически обновятся, и мы будем всегда видеть только актуальную информацию.

Пример универсальный и имеет применение не только в рабочих целях. Например, можно мониторить цены на товары в ожидании скидок. А если еще немного потрудиться, то и настроить оповещение на почту при изменении цены (или любого другого значения) ниже/выше определенного значения.

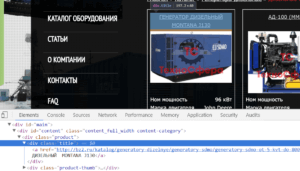

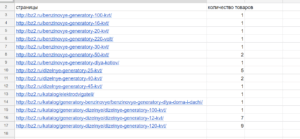

Пример 4. Узнать количество товаров в категориях

Очень полезный прием для тех, кто хоть раз продвигал интернет-магазины без товаров. Нет, это не шутка! Мне доводилось пару раз, как бы это смешно ни звучало.

Например, движок сайта не отображает те товары, которых нет на складе (или сам клиент может удалять их вручную). В этом случае есть риск возникновения ситуации, когда на складе вообще не окажется определенного типа товаров и категории будут висеть пустые, в лучшем случае на странице будет текстовое описание.

Но с помощью парсинга легко узнать на каких страницах есть беда с ассортиментом.

Для примера возьмем сайт http://bz2.ru. Категории с товарами выглядят вот так http://bz2.ru/katalog/generatory-dizelnye/dizelnye-generatory-100-kvt/.

Чтобы посчитать количество товаров идем в код сайта и смотрим какими тегами оформлены товары.

Товар оформлен в теге <div> с классом product, заголовок товара оформлен в теге <div> с классом title. Я решил посчитать заголовки:

Формула:

=COUNTA(IMPORTXML(A3;"//div[@class='title']"))

Результат:

COUNTA нужна, чтобы подсчитать число значений, если бы мы не использовали эту функцию, то результат был бы таким:

Как и в примере выше, можно автоматизировать процесс, чтобы ссылки на все категории парсились автоматически и их не приходилось добавлять вручную.

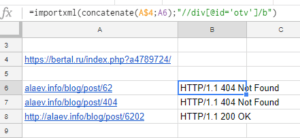

Пример 5. Парсим код ответа сервера

Я очень редко встречаю сайты, где что-то постоянно отваливается, но все же бывает. В случае необходимости можно быстро проверить все продвигаемые страницы на доступность и корректный ответ сервера.

Обычно я такие вещи мониторю с помощью скриптов без использования формул, но с помощью рассматриваемой функции это можно реализовать. Данный способ, пожалуй, единственное исключение из общего списка примеров, потому что я к нему не прибегал ни разу, но уверен, что кому-то из вас он пригодится.

В сети много сервисов, которые проверяют страницы на код ответа сервера. Суть идеи в том, чтобы парсить данные с такого сервиса. Для примера я решил взять самый популярный — http://www.bertal.ru/ — если мы проверим в нем страницу, то он отобразит результат по URL вида https://bertal.ru/index.php?a4789763/alaev.info/blog/post/6202#h.

Я не знаю, что означают символы a4789763, но на результат они не влияют. Смотрим:

Формула:

=importxml(concatenate(A$4;A6);"//div[@id='otv']/b")

Результат:

- A$4 — адрес ячейки с неизменяемой частью URL,

- A6 — ячейка с адресом страницы, код ответа, которой хотим проверить.

Функцией CONCATENATE склеиваем наши куски в один URL с которого и парсим данные.

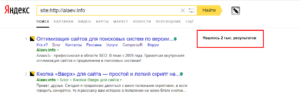

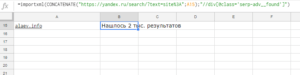

Пример 6. Узнаем количество страниц в индексе ПС

Если мы введем в поисковик запрос типа [site:http://alaev.info], то узнаем сколько всего страниц данного сайта находится в выдаче.

Результаты будут выведены на странице типа https://yandex.ru/search/?text=site%3Ahttp%3A%2F%2Falaev.info&lr=213, где после [https://yandex.ru/search/?text=site%3A] следует адрес сайта и необязательный параметр региона поиска [&lr=213].

Все, что нам нужно — это сформировать URL, по которому поисковик отдаст нам ответ, и определить из каких тегов парсить эту инфу.

В данном случае данные лежат в теге <div> с классом serp-adv__found.

Если мы поместим ссылку на сайт в ячейку A15, то формула будет такая:

=importxml(CONCATENATE("<a href="https://yandex.ru/search/?text=site%3A%22;A15">https://yandex.ru/search/?text=site%3A";</a>A15);"//div[@class='serp-adv__found']")

Результат:

В таком виде результат не особо ценен, т.к. желательно не только узнать количество страниц, но и провести какие-то дальнейшие вычисления или сравнения. Для этого модернизируем формулу и приведем текстовое значение в числовое.

Для этих целей будем использовать функцию SUBSTITUTE (в русском варианте ПОДСТАВИТЬ). Суть идеи в том, чтобы убрать слово [Нашлось: ] и заменить надпись [тыс. результатов] на [000], чтобы в итоге надпись выглядела как просто число 2000.

Но есть нюанс. Окончание меняется в зависимости от результата, например, может выглядеть как [Нашёлся 1 результат], поэтому такие вариации тоже надо будет заменить.

Не буду вас утомлять, поэтому ближе к делу: сначала заменим надпись [Нашлось: ] на пустоту вот так:

=SUBSTITUTE(ссылка;"Нашлось ";"")

Дальше заменим [тыс. результатов] на [000] для этого добавим еще одну аналогичную функцию, и формула будет выглядеть так:

=SUBSTITUTE(SUBSTITUTE(ссылка;"Нашлось ";"");"тыс.";"000")

Проделаем тоже самое для остальных вариантов и вместо слова [ссылка] пропишем функцию импорта. Конечная формула будет следующей:

=SUBSTITUTE(SUBSTITUTE(SUBSTITUTE(SUBSTITUTE(SUBSTITUTE(SUBSTITUTE(SUBSTITUTE(SUBSTITUTE(importxml(CONCATENATE("https://yandex.ru/search/?text=site%3A";A10);"//div[@class='serp-adv__found']");"Нашлось ";"");" результатов";"");" результата";"");" ";"");"Нашлась";"");"результат";"");"Нашёлся";"");"тыс.";"000")

Немного пугающе, правда? Возможно, есть более элегантные решения, но так как данный вариант универсальный и полностью рабочий, то я остановился на нем. Если вы найдете более красивое решение, то поделитесь в комментариях, мне будет интересно увидеть другие возможные построения формулы.

Ограничения

Минусом использования данных функций является то, что большие объемы данных обработать не получится. Существуют ограничение на число исходящих запросов, и если вам нужно, например, послать 1000 запросов, то вы столкнетесь с ситуацией, когда в большинстве ячеек у вас будет находиться надпись «Loading». Точных цифр Google не приводит, но по личному наблюдению — за один раз можно отправить около 100 запросов, после чего происходит таймаут примерно на 1 час до отправки следующей партии запросов. Поэтому вам подойдет этот функционал только в том случае, если не планируется обработка больших объемов данных.

На этом я закончу с примерами, на которых, конечно, возможности рассматриваемых функций не кончаются, однако, смысл статьи в том, чтобы познакомить вас с базовыми приемами и общими принципами работы.

Для меня возможности данных функций незаменимы для выполнения простых задач. Надеюсь, что и для вас эта информация оказалась полезной и позволит победить рутину в повседневных задачах.

Если у вас есть на заметке интересные примеры, обязательно делитесь в комментариях!

Спасибо за внимание. И до связи!

В этом руководстве мы покажем вам, как решить проблему, когда IMPORTXML и IMPORTHTML не работают в Google Таблицах. Это предложение электронных таблиц от гиганта Силиконовой долины имеет довольно много отличных функций. Одним из них является возможность напрямую получать общедоступные структурированные данные из Интернета. В зависимости от типа данных вы можете использовать IMPORTXML, IMPORTHTML, IMPORTDATA или IMPORTFEED.

Если мы возьмем первые два, то вы можете использовать формулу XML для импорта данных из каналов XML, HTML, CSV, TSV, RSS и ATOM XML с использованием синтаксиса IMPORTXML(url, xpath_query). Аналогичным образом, используя формулу IMPORTHTML(url, query, index), вы можете импортировать данные из таблицы или списка на странице HTML. Однако обе эти формулы работают не так, как ожидалось.

Многие пользователи выразили обеспокоенность тем, что IMPORTXML и IMPORTHTML не работают в Google Sheets. Всякий раз, когда пользователи пытаются использовать любую из этих двух формул, вместо этого они застревают на экране загрузки данных. Если у вас также возникают проблемы с тем же, то это руководство поможет вам. Следуйте инструкциям.

На данный момент единственный способ исправить эту проблему — создать новый лист, а затем использовать формулу на этом новом листе. Если ваши данные уже присутствовали на старом листе, вам придется перенести их на этот новый лист и соответствующим образом изменить его структуру. В конечном итоге это займет значительное количество времени и никоим образом не является наиболее осуществимым подходом. Но на данный момент это единственный способ решить проблему, когда IMPORTXML и IMPORTHTML не работают в Google Таблицах.

Что касается официальной позиции по этому вопросу, Google выкатить патч 8 марта, чтобы устранить эту ошибку. Однако, похоже, ему не удалось исправить основную проблему. Итак, 10 марта они уведомил пользователей чтобы опробовать вышеупомянутый обходной путь и сказал, что исправление будет выпущен на этой неделе, но это еще впереди. Когда это произойдет, мы соответствующим образом обновим это руководство. А пока у вас нет другого выбора, кроме как придерживаться вышеупомянутого метода.

Содержание

- IMPORTXML и IMPORTHTML не работают в Google Sheets [Fixed]

- Исправьте IMPORTXML и IMPORTHTML, которые не работают в Google Таблицах.

- В чем ошибка при запросе данных при помощи importxml в Google Docs?

- Функции Google Таблиц IMPORTXML или IMPORTHTML не работают, проблема передана на рассмотрение

- Published by IT Info on March 5, 2022

- Google Таблицы IMPORTXML или IMPORTHTML не работают

- Проблема уже передана на рассмотрение, исправление в работе

- Использование функций importHTML и importXML в Google Docs для парсинга и других SEO целей

- Функция importHTML

- Синтаксис

- Примеры использования importHTML

- Выгрузка любых табличных данных

- Выгрузка данных из списка

- Функция importXML

- Синтаксис

- Примеры использования importХML

- Пример 1. Импорт мета-тегов и заголовков со страниц

- Пример 2. Определяем наличие текста на странице и его длину в символах

- Пример 3. Выгружаем актуальные цены

- Пример 4. Узнать количество товаров в категориях

- Пример 5. Парсим код ответа сервера

- Пример 6. Узнаем количество страниц в индексе ПС

- Ограничения

IMPORTXML и IMPORTHTML не работают в Google Sheets [Fixed]

В этом руководстве мы покажем вам, как решить проблему, когда IMPORTXML и IMPORTHTML не работают в Google Таблицах. Это предложение электронных таблиц от гиганта Силиконовой долины имеет довольно много отличных функций. Одним из них является возможность напрямую получать общедоступные структурированные данные из Интернета. В зависимости от типа данных вы можете использовать IMPORTXML, IMPORTHTML, IMPORTDATA или IMPORTFEED.

Если мы возьмем первые два, то вы можете использовать формулу XML для импорта данных из каналов XML, HTML, CSV, TSV, RSS и ATOM XML с использованием синтаксиса IMPORTXML(url, xpath_query). Аналогичным образом, используя формулу IMPORTHTML(url, query, index), вы можете импортировать данные из таблицы или списка на странице HTML. Однако обе эти формулы работают не так, как ожидалось.

Многие пользователи выразили обеспокоенность тем, что IMPORTXML и IMPORTHTML не работают в Google Sheets. Всякий раз, когда пользователи пытаются использовать любую из этих двух формул, вместо этого они застревают на экране загрузки данных. Если у вас также возникают проблемы с тем же, то это руководство поможет вам. Следуйте инструкциям.

Исправьте IMPORTXML и IMPORTHTML, которые не работают в Google Таблицах.

На данный момент единственный способ исправить эту проблему — создать новый лист, а затем использовать формулу на этом новом листе. Если ваши данные уже присутствовали на старом листе, вам придется перенести их на этот новый лист и соответствующим образом изменить его структуру. В конечном итоге это займет значительное количество времени и никоим образом не является наиболее осуществимым подходом. Но на данный момент это единственный способ решить проблему, когда IMPORTXML и IMPORTHTML не работают в Google Таблицах.

Что касается официальной позиции по этому вопросу, Google выкатить патч 8 марта, чтобы устранить эту ошибку. Однако, похоже, ему не удалось исправить основную проблему. Итак, 10 марта они уведомил пользователей чтобы опробовать вышеупомянутый обходной путь и сказал, что исправление будет выпущен на этой неделе, но это еще впереди. Когда это произойдет, мы соответствующим образом обновим это руководство. А пока у вас нет другого выбора, кроме как придерживаться вышеупомянутого метода.

Источник

В чем ошибка при запросе данных при помощи importxml в Google Docs?

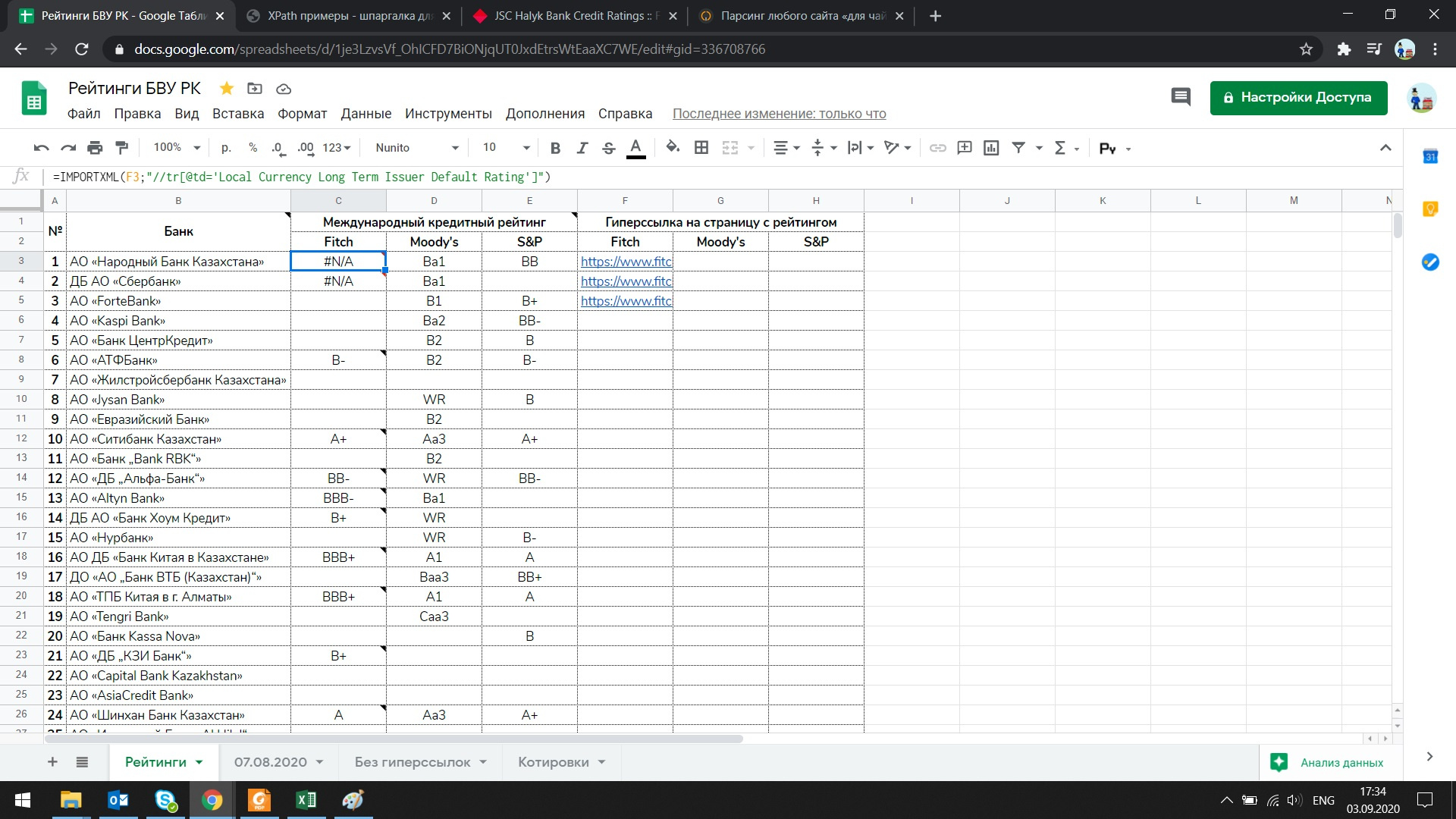

Ввиду рабочей необходимости часто требуется обращаться к кредитным рейтингам, что весьма утомительно и продолжительно по времени из-за слабого интернет-соединения и маломощного компьютера. В связи с этим решил собрать таблицу в Google Docs вместе с необходимыми данными, всегда доступными для использования.

С сайта Fitch Ratings мне необходимо вытащить следуюший рейтинг:

Используя ассистент Google Docs, желаемого результата не достиг:

Попытался также использовать Full XPath в запросе, ничего не вышло:

Пытался иначе, начитавшись материалов в сети, также не вышло:

Подскажите, пожалуйста, где именно и в чем я допустил ошибку при составлении запроса?

P. S. Также, если не сложно, можете подсказать, возможно ли вытащить данные о рейтингах с сайтов, где необходима авторизация для доступа к данным (сайты рейтинговых агентств S&P и Moody’s Investors Service)?

Источник

Функции Google Таблиц IMPORTXML или IMPORTHTML не работают, проблема передана на рассмотрение

Published by IT Info on March 5, 2022

Google Таблицы — один из самых полезных инструментов, предлагаемых пакетом Google Workspace. Это альтернатива Google другому программному обеспечению для работы с электронными таблицами, такому как Microsoft Excel.

Вы можете работать с Google Sheets в облаке, что означает, что вся ваша работа будет сохраняться и синхронизироваться между всеми вашими совместимыми устройствами.

Google Таблицы имеют множество функций, повышающих производительность пользователей. Например, вы можете использовать функции IMPORTXML и IMPORTHTML для интеграции различных типов структурированных данных в электронную таблицу из других источников.

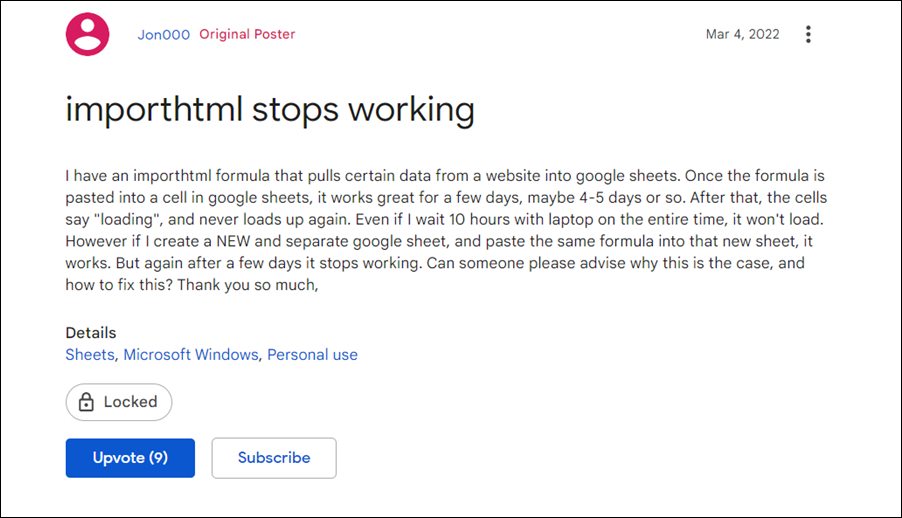

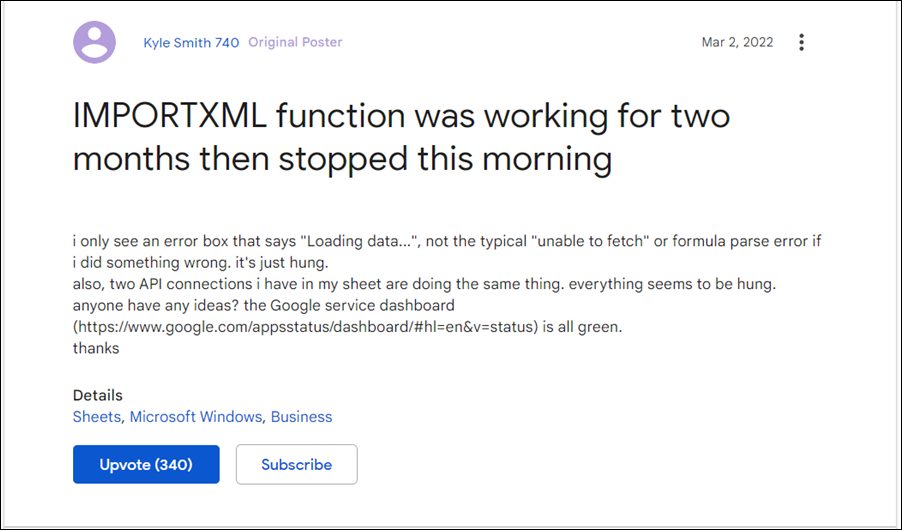

Однако многие пользователи сталкиваются с проблемами при попытке использовать эти функции. Согласно отчетам (1, 2, 3).

Google Таблицы IMPORTXML или IMPORTHTML не работают

Многие Пользователи Google Таблиц, которые ежедневно использовали функции IMPORTXML или IMPORTHTML, обнаружили, что они больше не работают без видимой причины.

Функция IMPORTXML работала f или два месяца, а затем остановился сегодня утром

я вижу только окно с сообщением об ошибке «Загрузка данных…», а не типичное «невозможно получить» или ошибку синтаксического анализа формулы, если я сделал что-то не так. он просто завис.

Кроме того, два API-соединения, которые есть у меня на листе, делают одно и то же. вроде все зависло. у кого-нибудь есть идеи?

Источник

У меня есть формула importhtml, которая извлекает определенные данные из веб-сайт в таблицы Google. После того, как формула вставлена в ячейку в Google Sheets, она отлично работает в течение нескольких дней, может быть, 4-5 дней или около того. После этого ячейки говорят «загружается» и больше никогда не загружаются. Даже если я буду ждать 10 часов с ноутбуком все время, он не загрузится. Однако, если я создам НОВЫЙ и отдельный лист Google и вставлю ту же формулу в этот новый лист, это сработает. Но снова через несколько дней он перестает работать.

Источник

Проблема уже передана на рассмотрение, исправление в работе

Несколько сообщений о проблеме поступили к эксперту по продукту на форумах поддержки Google, который передал ее в команда разработчиков.

Сегодня об этой проблеме сообщалось несколько раз. Я поднял этот вопрос, и мы свяжемся с вами, когда у нас будет дополнительная информация.

Источник

Сотрудник Google также подтвердил, что они работают над исправлением, но до сих пор нет предполагаемой даты его появления.

Мы будем следить за новыми подробностями, которые появиться по этому поводу, чтобы обновить эту историю.

Источник

Использование функций importHTML и importXML в Google Docs для парсинга и других SEO целей

В этой статье мы рассмотрим на примерах, как парсить содержимое сайтов с помощью Google Таблиц. В частности, рассмотрим функции importHTML и importXML. Первую функцию очень удобно использовать если данные находятся в какой-то таблице или списке, а вторая функция является универсальной и практически не имеет ограничений.

Функция importHTML

С помощью функции importHTML можно настроить импорт данных из таблицы или списка на странице сайта.

Синтаксис

=IMPORTHTML(ссылка; запрос; индекс)

- ссылка — ссылка на веб-страницу, включая протокол (http:// или https://),

- запрос — значения «table» или «list», смотря, что нужно парсить (таблицу или список),

- индекс – порядковый номер списка или таблицы (отсчет начинается с 1).

IMPORTHTML(«http://ru.wikipedia.org/wiki/Население_Индии»; «table»; 4)

Переменные можно разместить в ячейках, тогда формула изменится так:

IMPORTHTML(A2; B2; C2)

Примеры использования importHTML

Выгрузка любых табличных данных

Однажды мне понадобилось собрать список минус-слов по городам России в существительном падеже. Первые пару нагугленных файлов с минус-словами были неполными, а в других меня не устроила словоформа. Поэтому я просто решил спарсить страницу Википедии, что заняло около двух минут, включая время на открытие Гугл Таблицы, поиск нужной страницы Википедии и настройку формулы. С этого примера я и начну.

Задача: выгрузить список всех городов России со страницы https://ru.wikipedia.org/wiki/Список_городов_России

Чтобы выгрузить данные из этой таблицы нам нужно указать в формуле ее порядковый номер в коде страницы. Чтобы этот номер узнать, нужно открыть код сайта (в нормальных браузерах это сочетание Ctrl+U, либо клавиша F12, открывающая панель разработчика). А дальше поиском по коду определить порядковый номер:

В данном случае целевая таблица является первой в коде.

Составляем формулу:

Результат:

Выгрузка данных из списка

Как-то я работал с интернет-магазином у которого была обширная структура и очень неудобное меню. Надо было бегло оценить текущую структуру сайта, чтобы понять ассортимент и возможные очевидные проблемы, типа дублирования пунктов меню. Меню было реализовано в виде списка, чем я и воспользовался. Меньше чем через минуту полная иерархия сайта отображалась у меня в Гугл Табличке.

Задача: выгрузить все пункты меню, оформленного тегами

- .

.

Как и в первом примере для формулы понадобится определить порядковый номер списка в коде сайта. В данном случае — четвертый.

Составляем формулу:

Результат:

Списки и таблицы — это хорошо, но чаще всего необходимо выдернуть с сайта информацию, оформленную другими тегами. Например, тексты, цены, заголовки и так дальше. Эти данные можно спарсить, используя формулу importXML, разберем ее подробнее.

Функция importXML

С помощью функции importXML можно настроить импорт данных из источников в формате XML, HTML, CSV, TSV, а также RSS и ATOM XML.

По сравнению с importHTML у данной функции гораздо более широкое применение. Она позволяет собирать практически любую информацию со страницы/документа, от частичных фрагментов до полного ее содержания. Ниже будут описаны примеры парсинга HTML-страниц сайта. Парсинг по файлам рассматривать не стану, т.к. такая задача возникает редко и большинство из вас с этим не столкнется никогда. Но если что, принцип работы везде одинаковый, главное понять суть.

Синтаксис

IMPORTXML(ссылка; «//XPath запрос»)

- ссылка – адрес веб-страницы с указанием протокола (http:// или https://). Значение этого параметра должно быть заключено в кавычки или представлять собой ссылку на ячейку, содержащую URL страницы.

- //XPath запрос – то, что будем импортировать. Ниже мы разберем основные примеры запросов (а тут подробнее про XPath).

Значения переменных можно хранить в ячейках, тогда формула будет такой:

Примеры использования importХML

Пример 1. Импорт мета-тегов и заголовков со страниц

Самая простая и распространенная ситуация, которая может быть — узнать мета-теги или заголовки продвигаемых страниц. Для этих целей лучше подходит парсинг сайта специализированным софтом типа Comparser’a. Но бывают и исключения, например, если сайт очень большой и это сделать затруднительно, либо у вас нет под рукой программы. Или если вы собираетесь дальше использовать полученные данные в таблицах для мониторинга изменений мета-тегов и сверки целевых и фактических мета-тегов на страницах.

Получаем title страницы:

Получаем заголовки h1:

Получаем description:

Последняя формула получилась сложнее т.к. нас интересует значение не самого тега, а его атрибута:

- ищем тег meta //meta

- у которого есть атрибут name=’description’ [@name=’description’]

- и парсим содержимое второго атрибута content /@content

Пример 2. Определяем наличие текста на странице и его длину в символах

Этот пример мне помог при работе с проектом, тексты для которого писал и размещал сам клиент, и ему было чрезвычайно лень сообщать мне о ходе процесса. Небольшой лайфхак с Гугл таблицами позволил мне мониторить динамику его работы, а ему с чистой совестью и дальше продолжать лениться и не сообщать мне ничего.

Рассмотрим ситуацию на примере нашего блога http://alaev.info, а конкретно на странице https://alaev.info/blog/post/6202. Если заглянуть в код, то мы увидим, что контент страницы расположен в теге

Формула:

В ячейке А1 у нас ссылка на статью, в запросе XPath мы получаем содержимое тега div, у которого есть класс entry, то есть парсим весь текст страницы: =IMPORTXML(A1;»//div[@class=’entry’]»)

Функция CONCATENATE (в русском варианте СЦЕПИТЬ) нужна, чтобы объединить все абзацы в один кусок контента. Без нее мы посчитаем только объем первого абзаца.

Функция LEN (в русском варианте ДЛСТР) считает количество символов.

Пример 3. Выгружаем актуальные цены

Однажды потребовалось не только заниматься оптимизацией сайта, но и следить за ценами конкурентов по схожим товарным позициям. Использование специализированного софта и сервисов я практически сразу отмел, т.к. специальные сервисы по мониторингу не укладывались в бюджет, а вручную сканировать сайты конкурентов несколько раз в неделю не комильфо.

К счастью, вариант с Гугл доками оказался подходящим и уже к концу дня я все настроил так, что данные подтягивались автоматически. От меня ничего не требовалось, кроме как отправить ссылку на документ клиенту и спокойно заниматься своими делами.

Я решил рассмотреть похожую ситуацию на случайном сайте. Итак, допустим, мы хотим мониторить цены на автомобили и, скажем, выгружать актуальные цены с сайта http://centrmotors.lada.ru/. Вот пример товарной карточки http://centrmotors.lada.ru/ds/cars/granta/sedan/.

Чтобы настроить формулу снова идем в код сайта и смотрим в каких тегах располагается цена. Примеры должны быть простыми, поэтому я буду выгружать только минимальную цену.

На данном сайте нам надо парсить содержимое тега с id textspan7.

Формула:

В таблице ссылки на товары укажем в столбце А, а формулу вставим в столбец В.

Результат:

- A2 — номер ячейки из которой берется адрес страницы,

- //span[@id=’textspan7′] — блок из которого будем выводить информацию.

- Если бы у нас вместо span был div, а вместо id был бы class, то вторая часть формулы была такой: //div[@class=’textspan7′]

Автоматизируем дальше.

Приведенное выше решение не идеальное, ведь нам надо предварительно собрать адреса товарных страниц, а это довольно муторно. Если на сайт добавят новые модели авто, то информация по ним не будет подгружаться в таблицу т.к. адреса страниц будут отсутствовать в документе.

Подключив логику и другие формулы, можно хакнуть рутину. Ссылки на все модели присутствуют в главном меню. А если есть ссылки, то скорее всего их тоже можно спарсить.

И действительно, заглянув в код, мы увидим, что ссылки на товарные страницы располагаются в теге

c классом CMtext4:

Формула:

- A8 – в этой ячейке ссылка на сайт,

- p[@class=’CMtext4′] – тут мы ищем содержимое тега

с классом CMtext4,

/a/@href – а в этой части формулы мы уточняем, что из содержимого

После применения формулы в документе получится такой список:

Мы получили ссылки на все товары, которые нас интересуют. Осталось настроить парсинг цен по этим адресам. Но ссылки на страницы относительные, а нам обязательно нужны абсолютные ссылки, включающие имя домена. Чтобы подставить в ссылку домен используем функцию CONCATENATE.

Формула:

Либо при условии, что у нас в ячейке А8 находится адрес домена:

Размещаем мы ее справа от первой ссылки на товарную страницу и протягиваем вниз для всех ссылок или до конца листа на случай, если в будущем будет больше товаров.

Результат:

Поясню, если кто-то еще не разобрался:

- A$8 — ячейка, в которой указан домен сайта. Знаком $ фиксируем строку, чтобы это значение не изменилось, когда мы начнем протягивать формулу вниз.

- A9 — это первый URL товарной страницы, при перетаскивании формулы значение автоматически меняется, т.е. в 10 строке у нас вместо A9 будет A10, в 11 строке A11 и т.д.

Теперь если на сайте будут добавлены или удалены товары, то в нашем файле ссылки на них автоматически обновятся, и мы будем всегда видеть только актуальную информацию.

Пример универсальный и имеет применение не только в рабочих целях. Например, можно мониторить цены на товары в ожидании скидок. А если еще немного потрудиться, то и настроить оповещение на почту при изменении цены (или любого другого значения) ниже/выше определенного значения.

Пример 4. Узнать количество товаров в категориях

Очень полезный прием для тех, кто хоть раз продвигал интернет-магазины без товаров. Нет, это не шутка! Мне доводилось пару раз, как бы это смешно ни звучало.

Например, движок сайта не отображает те товары, которых нет на складе (или сам клиент может удалять их вручную). В этом случае есть риск возникновения ситуации, когда на складе вообще не окажется определенного типа товаров и категории будут висеть пустые, в лучшем случае на странице будет текстовое описание.

Но с помощью парсинга легко узнать на каких страницах есть беда с ассортиментом.

Для примера возьмем сайт http://bz2.ru. Категории с товарами выглядят вот так http://bz2.ru/katalog/generatory-dizelnye/dizelnye-generatory-100-kvt/.

Чтобы посчитать количество товаров идем в код сайта и смотрим какими тегами оформлены товары.

Товар оформлен в теге

Формула:

Результат:

COUNTA нужна, чтобы подсчитать число значений, если бы мы не использовали эту функцию, то результат был бы таким:

Как и в примере выше, можно автоматизировать процесс, чтобы ссылки на все категории парсились автоматически и их не приходилось добавлять вручную.

Пример 5. Парсим код ответа сервера

Я очень редко встречаю сайты, где что-то постоянно отваливается, но все же бывает. В случае необходимости можно быстро проверить все продвигаемые страницы на доступность и корректный ответ сервера.

Обычно я такие вещи мониторю с помощью скриптов без использования формул, но с помощью рассматриваемой функции это можно реализовать. Данный способ, пожалуй, единственное исключение из общего списка примеров, потому что я к нему не прибегал ни разу, но уверен, что кому-то из вас он пригодится.

В сети много сервисов, которые проверяют страницы на код ответа сервера. Суть идеи в том, чтобы парсить данные с такого сервиса. Для примера я решил взять самый популярный — http://www.bertal.ru/ — если мы проверим в нем страницу, то он отобразит результат по URL вида https://bertal.ru/index.php?a4789763/alaev.info/blog/post/6202#h.

Я не знаю, что означают символы a4789763, но на результат они не влияют. Смотрим:

Формула:

Результат:

- A$4 — адрес ячейки с неизменяемой частью URL,

- A6 — ячейка с адресом страницы, код ответа, которой хотим проверить.

Функцией CONCATENATE склеиваем наши куски в один URL с которого и парсим данные.

Пример 6. Узнаем количество страниц в индексе ПС

Если мы введем в поисковик запрос типа [site:http://alaev.info], то узнаем сколько всего страниц данного сайта находится в выдаче.

Результаты будут выведены на странице типа https://yandex.ru/search/?text=site%3Ahttp%3A%2F%2Falaev.info&lr=213, где после [https://yandex.ru/search/?text=site%3A] следует адрес сайта и необязательный параметр региона поиска [&lr=213].

Все, что нам нужно — это сформировать URL, по которому поисковик отдаст нам ответ, и определить из каких тегов парсить эту инфу.

В данном случае данные лежат в теге

Если мы поместим ссылку на сайт в ячейку A15, то формула будет такая:

Результат:

В таком виде результат не особо ценен, т.к. желательно не только узнать количество страниц, но и провести какие-то дальнейшие вычисления или сравнения. Для этого модернизируем формулу и приведем текстовое значение в числовое.

Для этих целей будем использовать функцию SUBSTITUTE (в русском варианте ПОДСТАВИТЬ). Суть идеи в том, чтобы убрать слово [Нашлось: ] и заменить надпись [тыс. результатов] на [000], чтобы в итоге надпись выглядела как просто число 2000.

Но есть нюанс. Окончание меняется в зависимости от результата, например, может выглядеть как [Нашёлся 1 результат], поэтому такие вариации тоже надо будет заменить.

Не буду вас утомлять, поэтому ближе к делу: сначала заменим надпись [Нашлось: ] на пустоту вот так:

Дальше заменим [тыс. результатов] на [000] для этого добавим еще одну аналогичную функцию, и формула будет выглядеть так:

Проделаем тоже самое для остальных вариантов и вместо слова [ссылка] пропишем функцию импорта. Конечная формула будет следующей:

=SUBSTITUTE(SUBSTITUTE(SUBSTITUTE(SUBSTITUTE(SUBSTITUTE(SUBSTITUTE(SUBSTITUTE(SUBSTITUTE(importxml(CONCATENATE(«https://yandex.ru/search/?text=site%3A»;A10);»//div[@class=’serp-adv__found’]»);»Нашлось «;»»);» результатов»;»»);» результата»;»»);» «;»»);»Нашлась»;»»);»результат»;»»);»Нашёлся»;»»);»тыс.»;»000″)

Немного пугающе, правда? Возможно, есть более элегантные решения, но так как данный вариант универсальный и полностью рабочий, то я остановился на нем. Если вы найдете более красивое решение, то поделитесь в комментариях, мне будет интересно увидеть другие возможные построения формулы.

Ограничения

Минусом использования данных функций является то, что большие объемы данных обработать не получится. Существуют ограничение на число исходящих запросов, и если вам нужно, например, послать 1000 запросов, то вы столкнетесь с ситуацией, когда в большинстве ячеек у вас будет находиться надпись «Loading». Точных цифр Google не приводит, но по личному наблюдению — за один раз можно отправить около 100 запросов, после чего происходит таймаут примерно на 1 час до отправки следующей партии запросов. Поэтому вам подойдет этот функционал только в том случае, если не планируется обработка больших объемов данных.

На этом я закончу с примерами, на которых, конечно, возможности рассматриваемых функций не кончаются, однако, смысл статьи в том, чтобы познакомить вас с базовыми приемами и общими принципами работы.

Для меня возможности данных функций незаменимы для выполнения простых задач. Надеюсь, что и для вас эта информация оказалась полезной и позволит победить рутину в повседневных задачах.

Если у вас есть на заметке интересные примеры, обязательно делитесь в комментариях!

Спасибо за внимание. И до связи!

Вот уже 18 лет я профессионально занимаюсь созданием и продвижением сайтов и 13 лет с удовольствием пишу в любимый блог. Создал заслужившие доверие в seo-сообществе программы FastTrust и ComparseR и известный сервис для проверки траста сайтов CheckTrust.ru.

В 2014 основал веб-студию «АлаичЪ и Ко» в Краснодаре: 1 место в рейтинге агентств интернет-маркетинга (Рейтинг Рунета), 2 место в рейтинге SEO-компаний (CMSmagazine), 12 место в рейтинге известность бренда SEO-компаний в России (SeoNews).

Выступаю на профильных конференциях (All In Top, SEO Conference, SEMPRO, Baltic Digital Days). Веду канал в telegram про seo и бизнес. SEO-специалист года 2019 и 2020 (Sape).

Источник