From Wikipedia, the free encyclopedia

In statistical hypothesis testing, there are various notions of so-called type III errors (or errors of the third kind), and sometimes type IV errors or higher, by analogy with the type I and type II errors of Jerzy Neyman and Egon Pearson. Fundamentally, type III errors occur when researchers provide the right answer to the wrong question, i.e. when the correct hypothesis is rejected but for the wrong reason.

Since the paired notions of type I errors (or «false positives») and type II errors (or «false negatives») that were introduced by Neyman and Pearson are now widely used, their choice of terminology («errors of the first kind» and «errors of the second kind»), has led others to suppose that certain sorts of mistakes that they have identified might be an «error of the third kind», «fourth kind», etc.[a]

None of these proposed categories have been widely accepted. The following is a brief account of some of these proposals.

Systems theory[edit]

In systems theory an additional type III error is often defined: type III (δ): asking the wrong question and using the wrong null hypothesis.[2]

David[edit]

Florence Nightingale David[3] a sometime colleague of both Neyman and Pearson at the University College London, making a humorous aside at the end of her 1947 paper, suggested that, in the case of her own research, perhaps Neyman and Pearson’s «two sources of error» could be extended to a third:

I have been concerned here with trying to explain what I believe to be the basic ideas [of my «theory of the conditional power functions»], and to forestall possible criticism that I am falling into error (of the third kind) and am choosing the test falsely to suit the significance of the sample.

— 1947, p.339

Mosteller[edit]

In 1948, Frederick Mosteller [b] argued that a «third kind of error» was required to describe circumstances he had observed, namely:

- Type I error: «rejecting the null hypothesis when it is true».

- Type II error: «failing to reject the null hypothesis when it is false».

- Type III error: «correctly rejecting the null hypothesis for the wrong reason». (1948, p. 61)[c]

Kaiser[edit]

According to Henry F. Kaiser, in his 1966 paper extended Mosteller’s classification such that an error of the third kind entailed an incorrect decision of direction following a rejected two-tailed test of hypothesis. In his discussion (1966, pp. 162–163), Kaiser also speaks of α errors, β errors, and γ errors for type I, type II and type III errors respectively (C.O. Dellomos).

Kimball[edit]

In 1957, Allyn W. Kimball, a statistician with the Oak Ridge National Laboratory, proposed a different kind of error to stand beside «the first and second types of error in the theory of testing hypotheses». Kimball defined this new «error of the third kind» as being «the error committed by giving the right answer to the wrong problem» (1957, p. 134).

Mathematician Richard Hamming expressed his view that «It is better to solve the right problem the wrong way than to solve the wrong problem the right way».

Harvard economist Howard Raiffa describes an occasion when he, too, «fell into the trap of working on the wrong problem» (1968, pp. 264–265).[d]

Mitroff and Featheringham[edit]

In 1974, Ian Mitroff and Tom Featheringham extended Kimball’s category, arguing that «one of the most important determinants of a problem’s solution is how that problem has been represented or formulated in the first place».

They defined type III errors as either «the error … of having solved the wrong problem … when one should have solved the right problem» or «the error … [of] choosing the wrong problem representation … when one should have … chosen the right problem representation» (1974), p. 383.

In the 2009 book Dirty rotten strategies by Ian I. Mitroff and Abraham Silvers described type III and type IV errors providing many examples of both developing good answers to the wrong questions (III) and deliberately selecting the wrong questions for intensive and skilled investigation (IV). Most of the examples have nothing to do with statistics, many being problems of public policy or business decisions.[4]

Raiffa[edit]

In 1969, the Harvard economist Howard Raiffa jokingly suggested «a candidate for the error of the fourth kind: solving the right problem too late» (1968, p. 264).

Marascuilo and Levin[edit]

In 1970, L. A. Marascuilo and J. R. Levin proposed a «fourth kind of error» – a «type IV error» – which they defined in a Mosteller-like manner as being the mistake of «the incorrect interpretation of a correctly rejected hypothesis»; which, they suggested, was the equivalent of «a physician’s correct diagnosis of an ailment followed by the prescription of a wrong medicine» (1970, p. 398).

See also[edit]

- Ethics in mathematics

- Type I and type II errors

- Mathematical fallacy § Howlers

Notes[edit]

- ^ For example, Onwuegbuzie & Daniel claim to have identified an additional eight kinds of error.[1]

- ^ The 1981 President of the American Association for the Advancement of Science

- ^ Compare with Kantian ethics, where it is not enough to do the right thing, but it must be done for the right reason, and Gettier problems, where «justified true belief» is not equated with knowledge.

- ^ Note that Raiffa, from his imperfect recollection, incorrectly attributed this «error of the third kind» to John Tukey (1915–2000).

References[edit]

- ^ Onwuegbuzie, A.J.; Daniel, L. G. (19 February 2003). «Typology of analytical and interpretational errors in quantitative and qualitative educational research». Current Issues in Education. 6 (2).

- ^ P.J. Boxer (1994). «Notes on Checkland’s Soft Systems Methodology» (PDF). Archived from the original (PDF) on 2009-12-29.

- ^ «Florence Nightingale David».

- ^ Ian I. Mitroff and Abraham Silvers, Dirty rotten strategies: How We Trick Ourselves and Others into Solving the Wrong Problems Precisely, Stanford Business Press (2009), hardcover, 210 pages, ISBN 978-0-8047-5996-0

From Wikipedia, the free encyclopedia

In statistical hypothesis testing, there are various notions of so-called type III errors (or errors of the third kind), and sometimes type IV errors or higher, by analogy with the type I and type II errors of Jerzy Neyman and Egon Pearson. Fundamentally, type III errors occur when researchers provide the right answer to the wrong question, i.e. when the correct hypothesis is rejected but for the wrong reason.

Since the paired notions of type I errors (or «false positives») and type II errors (or «false negatives») that were introduced by Neyman and Pearson are now widely used, their choice of terminology («errors of the first kind» and «errors of the second kind»), has led others to suppose that certain sorts of mistakes that they have identified might be an «error of the third kind», «fourth kind», etc.[a]

None of these proposed categories have been widely accepted. The following is a brief account of some of these proposals.

Systems theory[edit]

In systems theory an additional type III error is often defined: type III (δ): asking the wrong question and using the wrong null hypothesis.[2]

David[edit]

Florence Nightingale David[3] a sometime colleague of both Neyman and Pearson at the University College London, making a humorous aside at the end of her 1947 paper, suggested that, in the case of her own research, perhaps Neyman and Pearson’s «two sources of error» could be extended to a third:

I have been concerned here with trying to explain what I believe to be the basic ideas [of my «theory of the conditional power functions»], and to forestall possible criticism that I am falling into error (of the third kind) and am choosing the test falsely to suit the significance of the sample.

— 1947, p.339

Mosteller[edit]

In 1948, Frederick Mosteller [b] argued that a «third kind of error» was required to describe circumstances he had observed, namely:

- Type I error: «rejecting the null hypothesis when it is true».

- Type II error: «failing to reject the null hypothesis when it is false».

- Type III error: «correctly rejecting the null hypothesis for the wrong reason». (1948, p. 61)[c]

Kaiser[edit]

According to Henry F. Kaiser, in his 1966 paper extended Mosteller’s classification such that an error of the third kind entailed an incorrect decision of direction following a rejected two-tailed test of hypothesis. In his discussion (1966, pp. 162–163), Kaiser also speaks of α errors, β errors, and γ errors for type I, type II and type III errors respectively (C.O. Dellomos).

Kimball[edit]

In 1957, Allyn W. Kimball, a statistician with the Oak Ridge National Laboratory, proposed a different kind of error to stand beside «the first and second types of error in the theory of testing hypotheses». Kimball defined this new «error of the third kind» as being «the error committed by giving the right answer to the wrong problem» (1957, p. 134).

Mathematician Richard Hamming expressed his view that «It is better to solve the right problem the wrong way than to solve the wrong problem the right way».

Harvard economist Howard Raiffa describes an occasion when he, too, «fell into the trap of working on the wrong problem» (1968, pp. 264–265).[d]

Mitroff and Featheringham[edit]

In 1974, Ian Mitroff and Tom Featheringham extended Kimball’s category, arguing that «one of the most important determinants of a problem’s solution is how that problem has been represented or formulated in the first place».

They defined type III errors as either «the error … of having solved the wrong problem … when one should have solved the right problem» or «the error … [of] choosing the wrong problem representation … when one should have … chosen the right problem representation» (1974), p. 383.

In the 2009 book Dirty rotten strategies by Ian I. Mitroff and Abraham Silvers described type III and type IV errors providing many examples of both developing good answers to the wrong questions (III) and deliberately selecting the wrong questions for intensive and skilled investigation (IV). Most of the examples have nothing to do with statistics, many being problems of public policy or business decisions.[4]

Raiffa[edit]

In 1969, the Harvard economist Howard Raiffa jokingly suggested «a candidate for the error of the fourth kind: solving the right problem too late» (1968, p. 264).

Marascuilo and Levin[edit]

In 1970, L. A. Marascuilo and J. R. Levin proposed a «fourth kind of error» – a «type IV error» – which they defined in a Mosteller-like manner as being the mistake of «the incorrect interpretation of a correctly rejected hypothesis»; which, they suggested, was the equivalent of «a physician’s correct diagnosis of an ailment followed by the prescription of a wrong medicine» (1970, p. 398).

See also[edit]

- Ethics in mathematics

- Type I and type II errors

- Mathematical fallacy § Howlers

Notes[edit]

- ^ For example, Onwuegbuzie & Daniel claim to have identified an additional eight kinds of error.[1]

- ^ The 1981 President of the American Association for the Advancement of Science

- ^ Compare with Kantian ethics, where it is not enough to do the right thing, but it must be done for the right reason, and Gettier problems, where «justified true belief» is not equated with knowledge.

- ^ Note that Raiffa, from his imperfect recollection, incorrectly attributed this «error of the third kind» to John Tukey (1915–2000).

References[edit]

- ^ Onwuegbuzie, A.J.; Daniel, L. G. (19 February 2003). «Typology of analytical and interpretational errors in quantitative and qualitative educational research». Current Issues in Education. 6 (2).

- ^ P.J. Boxer (1994). «Notes on Checkland’s Soft Systems Methodology» (PDF). Archived from the original (PDF) on 2009-12-29.

- ^ «Florence Nightingale David».

- ^ Ian I. Mitroff and Abraham Silvers, Dirty rotten strategies: How We Trick Ourselves and Others into Solving the Wrong Problems Precisely, Stanford Business Press (2009), hardcover, 210 pages, ISBN 978-0-8047-5996-0

⇡#Что за проблемы с ДНК?

Среди двух десятков криминалистических дисциплин ДНК-экспертиза по праву занимает совершенно исключительное место. Она играет здесь роль своеобразного эталона научности – по вполне объяснимым причинам. Этот базовый метод сравнения появился у криминалистов позже всех, на рубеже 1980-90-х годов, когда в науке уже были полностью сформированы каноны и стандарты для экспериментальной проверки гипотез с требующимся уровнем достоверности.

Иначе говоря, криминалисты получили от ученых ДНК-экспертизу не только с заранее обсчитанными вероятностями ошибок, но и с вполне четкими представлениями о том, как и откуда эти ошибки могут появляться. И как их, соответственно, можно было бы минимизировать. До значений, скажем, один шанс на миллиард…

Но вся эта красота, правда, справедлива лишь для условий стерильных лабораторных сравнений. Когда оба сопоставляемых образца взяты у людей по их согласию, то есть в качестве и количестве, достаточном для выстраивания полноценного ДНК-профиля человека. Однако реальная жизнь обычно не похожа на лабораторию, а образцы ДНК для криминалистического анализа чаще всего добываются на месте преступления. И вот тут-то начинаются большие проблемы.

Среди основных проблем специалисты выделяют две: (1) частичный профиль ДНК из-за недостаточного количества образца; и (2) смеси ДНК, которые с необходимой определенностью сложно не только разделить, но и установить, сколько вообще людей тут внесли свой вклад.

Опытные эксперты-криминалисты, конечно же, обычно со всеми подобными задачами успешно справляются. Но как показывают независимые проверки, это именно те моменты, где решающую роль играет уже не наука, а субъективное мнение криминалиста, от которого следователи ждут вполне конкретный результат. А вероятности ошибок здесь составляют уже далеко не 1 на миллиард, а, скажем, один к тридцати. То есть ясно обозначился принципиально иной уровень (не)надежности, который поначалу для ДНК-анализа даже предположить не могли…

Тем не менее аналитические исследования ученых показывают, что подобные ситуации появляются у криминалистов постоянно. Генетическая группа в составе NIST, Национального института стандартов и технологий США, недавно делала обзор 5000 образцов ДНК из 14 криминалистических лабораторий США и установила, что смешивание ДНК – это в действительности весьма частое явление. Выяснилось, что 34 процента образцов были смесями от двух человек, и еще 11 процентов – смеси от трех или четырех человек. В общей сложности – почти половина всего материала.

И при этом весьма непростой задачей оказывается даже определение того, как много людей присутствует на самом деле в конкретном образце смешанной ДНК. В 2004 году заметным событием стала работа исследователей из университета Райта, штат Огайо, где ученые взяли 959 полных профилей ДНК и смоделировали на их основе всевозможные смеси с участием 3-4 человек. Стандартный анализ показал, что в 3 процентах случаев тройные смеси выглядели как смеси ДНК двух человек. А более чем 70 процентов четверных смесей с очень высокой вероятностью можно было ошибочно принять за смеси ДНК двух или трех человек.

Конечно же, столь неожиданные результаты были затем перепроверены и подтверждены в других лабораториях. Ну а вывод в итоге сформулирован вполне определенный:

«Если вы не можете надежно установить даже то, как много людей внесло свой вклад, то просто смехотворно предполагать, будто вы можете разделить и установить по смеси, кем именно были эти вкладчики или что конкретно представляют собой их ДНК-профили»…

⇡#Как это исправлять?

Фактически все результаты проверок, анализирующих положение дел в криминалистике, свидетельствуют, что решение вопроса о заключении или свободе для великого множества людей нередко может зависеть от субъективного мнения экспертов из криминалистической лаборатории. Но так, конечно же, быть не должно. Просто по той причине, что настоящая наука подобным образом не работает.

Известна, правда, одна нехорошая разновидность околонаучной деятельности – в английском языке именуемая Junk Science, что на русский обычно переводят как псевдонаука или лженаука. Однако в конкретном приложении к криминалистике при её нынешнем состоянии наиболее адекватным переводом для выражения выглядит дословный – «мусорная наука».

Но из этой обидной констатации вовсе не следует, впрочем, что ситуация тут неизлечима и никто не знает, как ее исправлять. Совсем наоборот. Рецепты лечения давно известны, вполне четко сформулированы, и, более того, имеется множество криминалистов, которые считают, что для превращения их занятия в науку эти перемены не только желательны, но и необходимы.

Главнейшей бедой «мусорной науки» является очень мощный человеческий фактор. Система правосудия устроена так, что криминалисты практически всегда выступают на стороне обвинения. По этой причине эксперты заранее, как правило, знают не только общий контекст появления улики, но и то, какого рода заключение от них ожидается.

В настоящей науке эксперименты так не проводятся: давно и точно известно, что субъективно смещенное мнение испытателя всегда оказывает эффект на итоговый результат – независимо от того, осознает это эксперт или делает бессознательно. А потому разработаны и применяются эффективные способы для удаления субъективности – под названием «двойной слепой метод». Когда заранее не только нет информации, кого или что проверяют, но и те, кто проверяет, не имеют ни малейшего представления о том, какой ожидается результат.

Применительно конкретно к криминалистике это означает, что если сравнением образцов занимаются люди, то (а) эксперты должны получать образцы для анализа в полностью обезличенном виде и (б) та сторона, которая предоставляет в лабораторию образцы для анализа, не имеет никакой информации, кто именно из экспертов делает сопоставление.

Понятно, что в нынешних условиях, когда криминалистические лаборатории находятся либо под прямым контролем прокуратуры или полиции, либо в сильнейшей экономической зависимости от их заказов, подобные условия работы обеспечить практически невозможно. Именно поэтому все чаще раздаются призывы полностью отделить лаборатории от стороны обвинения, сделав криминалистическую науку нейтральной и независимой.

Другой важный аспект лечения – это максимальная автоматизация всех аналитических процедур, применяемых для сравнения образцов. Понятно, что в условиях машинных алгоритмов гораздо легче обеспечить двойное слепое тестирование. А очень существенный прогресс компьютерной науки, достигнутый за последние годы в делах глубокого обучения программ и распознавания образов, среди прочего позволяет надеяться и на полное удаление человеческой субъективности из криминалистики.

В конечном же итоге – если нейтрализация человеческого фактора правильно сочетается с научным обоснованием методов и аккуратным расчетом ошибок первого и второго рода – у криминалистики в потенциале есть все, чтобы стать подлинной наукой. Ну а если здесь еще и освоят эффективную борьбу с так называемыми ошибками третьего рода, то тогда у криминалистики появляются перспективы занять в науке совершенно исключительное по важности место.

⇡#Что за ошибка третьего рода?

Стандартные процедуры, применяемые в науке для анализа данных, по традиции подразумевают лишь два базовых исхода – гипотеза принята и гипотеза отвергнута. Отчего и базовых ошибок обычно только две – принять гипотезу, хотя данные на самом деле ей не соответствуют, и отвергнуть гипотезу, хотя данные ее поддерживают.

Однако в высшей степени изобретательная деятельность людей – многие из которых склонны к нечестному поведению – постоянно порождает ситуации, когда вполне подлинные данные могут быть оформлены и предъявлены так, чтобы искусственно порождать ложные выводы. На обычном языке из повседневной жизни подобные вещи обычно называют обманом, подлогом и жульничеством. На языке науки это могут именовать более изощренно — например, «рассогласованность параметров» анализируемого объекта.

Дабы не уходить далеко от криминалистики, в качестве наглядной иллюстрации можно привести такую ситуацию. Из музея похищают ценнейшую картину, а, чтобы вывезти её из страны, нанятый преступниками нечистоплотный художник малюет поверх шедевра какую-нибудь собственную картинку – причем даже с личной подписью. Иначе говоря, на таможне предъявлена действительно подлинная работа, однако на самом деле это вопиющий обман и преступление.

Но чтобы выявить его, потребуется анализ по расширенному набору параметров, включая, скажем, возраст холста и наличие скрытых слоев в картине. И если эксперт выявит здесь «рассогласованность в параметрах», то преступников разоблачат. Ну а если поверхностную авторскую мазню так и классифицируют как подлинник, то произойдет криминалистическая «ошибка третьего рода». Причем в жизни искусства таких ошибок известно достаточно.

И хотя пример этот может показаться редким и экзотичным, на самом деле в области защиты информации нечто подобное становится уже вполне обычным делом – особенно вместе с широким распространением компьютеров и автоматизированного контроля доступа. Здесь наверняка все наслышаны о датчиках отпечатков пальцев или сканирования радужки глаза и с системами распознавания лица или голоса, а многие регулярно сталкиваются с ними и лично.

Куда меньше людей знает, что практически для всех из этих систем контроля доступа у умельцев-хакеров имеются весьма эффективные средства преодоления. Причем все они работают, как правило, на основе ошибки третьего рода – через предъявление сенсорам подлинных биометрических данных владельцев, но только похищенных и используемых с целью обмана. Без проблем можно сделать латексные накладки с чужими отпечатками пальцев, предъявлять датчикам заранее сделанные записи голосов, снимки лиц или радужки глаза.

Более того, хотя контроль доступа по ДНК еще никем пока что не применяется, уже давно разработаны и продемонстрированы недорогие методы обмана и для этого. То есть не только для размножения и подсовывания чужой ДНК на проверку, но и для «опрыскивания», так сказать, ею места преступления – дабы эффективно скрыть собственные ДНК-следы преступника.

Понятно, наверное, что не только уменьшать вероятность ошибок подобного рода, но и просто их выявлять – задача в высшей степени нетривиальная. Но и над ней, конечно же, криминалистам приходится работать. Тем более что тут их интересы сильно пересекаются с исследованиями весьма многочисленных и изобретательных «хакеров в законе», работающих над усилением систем биометрического контроля доступа.

Пока что никто не берется прогнозировать, когда и как вероятности ошибок третьего рода удастся систематически минимизировать до нужных пороговых уровней – как это принято в науке с ошибками первого и второго рода. Но вот если сделать это все-таки удалось бы, тогда научная звезда криминалистики могла бы засиять в свою полную силу.

Потому что не только в повседневной жизни, искусстве или бизнесе, но и во множестве областей самой науки, как все, вероятно, наслышаны, ныне уже регулярно выявляются случаи умышленного обмана. Нечестные ученые во множестве плодят липовые «авторские» статьи и липовые эксперименты, защищают липовые диссертации и так далее. Честные ученые, как могут, пытаются с этим бороться и разоблачать лженауку. Однако на систематической основе лечить эту напасть совсем непросто. А вот криминалистическая наука в своем обновленном виде – и с ее отработанными методами для выявления преступлений и обманов – могла бы оказать здесь поистине неоценимую помощь, став не только лекарем, но и, по сути дела, царицей науки…

Дополнительное чтение в тему:

- О больших проблемах с научным обоснованием методов криминалистики: «Улики под сомнением».

- Об обмане любых биометрических систем опознания: «Забавные игрушки, или Мифы биометрии».

- Об ошибках третьего рода в высокой науке: «Подгнило что-то в королевстве», «Престранный для науки год».

Если Вы заметили ошибку — выделите ее мышью и нажмите CTRL+ENTER.

Андрей, саму статью вышлю позже, у меня опубликованного варианта нет.

Но к одной проблеме, которую я поднял, хотелось бы привлечь внимание кафедрального сообщества.

Это понятие о компьютерных ошибках, которые я делю на ошибки первого, второго и третьего рода.

Ошибки первого рода — это обычные хардверные, т.е. железа или кремния.

Ошибки второго рода — это программные ошибки. Ну это известно. Не туда перенаправилась программа, не ту операцию записали и т.д. шибки первого и второго рода существуют и у процессора целых чисел.

А вот ошибки третьего рода — это вроде новое. Это ошибки вычислений с процессором действительных чисел, чисел с плавающей точкой. В целочисленных вычислениях их нет.

На процессоре нецелых чисел вычисляют теоретические модели, определенные на множестве действительных чисел, т.е. на континууме. Решают уравнения алгебраические, трансцендентные, дифференциальные, иписывают различные функции и т.д., которые в теортической математике определены на множесмтве действительных чисел, на множестве континуума.

Но компьютер не может изобразить континуум. Поэтому вычисления идут не на континууме, а на некотором подмножестве континуума, компьютерно-представимом подмножестве множества действительных чисел.

Ясно, что вычисления на континууме и подмножестве могут оличаться. И это все знают. Это хорошо известные вычислительны ошибки. Но молчаливо предполагается, что эти отличия невелики, и они не существенны для тех практических задач, для которых они мспользуются.

Это главный центральный постулат, суперпостулат ВСЕЙ компьютерной техники. Без этого предположения, принимаемого молчаливо или даже неосознанно всем мировым сообщенством, использующим компьютеры, их использование было бы невозможно, либо резко ограничено и существенно затруднено. ЭТОТ ПОСТУЛАТ НЕВЕРЕН.

КАК правило, ошибки действительно несущественны.. так и есть. Но бывают исключения, когда решения различаются существенно и даже вообще абсолютно. Ну простейший пример. Пусть имеется выражение, представляющее отношение двух подвыражений. Сами подвыражения могут быть достаточно сложными и не допускающими анализа некомпьютерными средствами. Аргументы подвыражений меняются или от входных данных, либо от других вычислений. И может случайно произойти, что числитель и знаменатель на множестве действительных чисел обращаются в нуль.

В математике это неопределенность и раскрытие ее есть любимое занятие студентов по матанализу. Но компьютер этого делать не умеет, так что просто получаем невычислимое выражение.

Но на подмножестве действительных чисел могут получиться подвыражения как «компьютерные нули» и тогда компьютер легко, не заметив никеакой проблемы, вычислит это выражение. Только вот что он получит — неизвестно. Фактически, получит случайное число. Ошибка имеет структурный характер и связана с самим характером представления нецелых чисел в компьютере. Это и есть структурная ошибка, ошибка третьего рода.Все исправно, и техника, и программа, а компьютер врет.

Важно, что вероятность иметь ошибку третьего рода прогрессивно возрастает по мере роста компьютерных мощностей.

И что может при такой ошибке произойти в реале — бог знает. По крайней мере, если что-то случится, то обнаружить ее будет очень сложно и вероятней всего все спишут на «человеческий фактор».

Конечно не я первый на это обращаю внимание, хотя большинство компютерщиков эту проблему либо не видят, либо отрицают. Я привел один источник ошибки третьего рода. Но есть и другие. Грамотные специалисты по компьютерным вычислениям знают таких немало. Поэтому только приведу цитату из книги по интервальному исчислению.

«Постепенно у критически настроенных исследователей все чаще стал возникать вопрос, вынесенный в заголовок обобщающей статьи немецкого математика проф. К. Никеля: «Can we trust the results of our computing?» («Можем ли мы доверять результатам наших вычислений?») [5]. Действительно, беспристрастный анализ традиционного подхода к численным вычислениям и соответствующего инструментария (алгоритмов, языков программирования и аппаратного обеспечения), проведенный специалистами в области вычислительной математики, привел к неутешительному выводу о том, что алгоритм, сформулированный в столь привычных нам терминах, попросту недоопределен и потому обладает, вообще говоря, непредсказуемыми свойствами. (На одной из крупных научных конференций ректор Технического университета Вены проф. П. Скалички наполовину с юмором, а наполовину всерьез заявил, что с тех пор, как подробнее узнал о принятых способах выполнения машинных вычислений, очень опасается ходить по мостам и оказываться внутри других сложных инженерных сооружений…)

В классическом анализе погрешностей принято оценивать погрешности, возникающие при каждой отдельной операции численных алгоритмов. Конечно, для такого алгоритма, в котором за час выполняется 1015 операций с плавающей точкой, это уже практически неосуществимо. Поэтому реалистичный анализ погрешностей

обычно и не производится. В действительности, сам факт, что вычисленный результат может вообще не иметь верных цифр, редко принимается во внимание. [6]».

Если кто-то сможет высказаться по этому вопросу, как он борется с ошибками третьего рода был бы рад. Или может не признает их?

[c.298]

Третий способ ускорения сходимости состоит в использовании своего рода верхней релаксации. Этот способ следует применять только при однократном решении уравнения Пуассона на каждой итерации, как было описано выше. Этот способ был разработан в ходе детального изучения процесса сходимости при использовании двух предьщущих способов ускорения. На рис. 14.13 показана сходимость потенциала и квазиуровня Ферми в некотором узле, расположенном в области канала МОП-транзистора в режиме насыщения. Изображен график зависимости ошибки от числа внешних итераций, так что каждая итерация на рисунке представляет собой два матричных решения. Поскольку приращения потенциала почти постоянны на каждой итерации, оказывается, что быструю сходимость можно получить простым увеличением приращений. Это в какой-то степени аналогично верхней релаксации в методах итерационного решения матричных уравнений. Если вектор приращений потенциала, полученный из уравнения Пуассона, перед сложением его с предыдущим значением потенциала умножить на некоторый множитель, больший единицы, то в результате скорость сходимости увеличивается.

[c.376]

Райфа (1968) называет ошибки третьего рода (по аналогии со статистическими ошибками первого и второго рода) — когда индивид ставит ложную задачу принятия решения. Но и такая ложная постановка задачи может быть интерпретирована как прагматическая ошибка в оценке информации. Только теперь она возникает на более общем уровне, охватывающем как текущие данные, так и базовую информацию, используемую tipn самой постановке задачи принятия решения.

[c.70]

Третьим ограничением при получении данных о кинетике реакций является выбор температуры. С целью быстрого получения данных имеется тенденция использовать более высокие температуры. Это может привести, как и в других работах по диффузии, к ошибкам при экстраполяции на низкие температуры. Определены источники некоторых ошибок такого рода изменение с температурой стехиометрии продуктов реакции (Кляйн и др. [20]), застворение одного из продуктов реакции в другом (Шмитц и. еткалф [39]), прекращение одного из двух процессов, лимитирующих скорость реакции, вследствие растворения одного из продуктов (Шмитц и др. [40]).

[c.102]

Поскольку ошибки делительного колеса и червяка (вернее суммарные ошибки самого червяка, его положения относительно колеса и ошибки зацепления червячной пары) являются ошибками периодическими, повторяюш,имися за каждый оборот исследуемого элемента, то, как показывает метод обработки подобного рода ошибок, всегда можно подобрать такое число зубьев нарезаемого колеса, которое позволит вскрыть как ошибки колеса, так и ошибки червяка. Этим удовлетворяется третье из перечисленных требований.

[c.99]

Только что представленная оценка имеет несколько существенных недостатков. Во-первых, естественно, что ошибки в оценке V могли быть большими, поскольку она основывается на записях наблюдений за 75 лет, которые содержат только два относящихся к рассматриваемому вопросу результата. Во-вторых, допущение, что интенсивность прихода ураганов является равномерно распределенной величиной по длине береговой линии Техаса, переоценивает вероятность того, что ураган обрушится на участок береговой линии, примыкающий к границе Мексики (примерно на 25%), и недооценивает такую вероятность (примерно на 25%) вблизи границы штата Луизиана (рис. 3.6 и 3.7). В-третьих, трудно установить надежность оценки у -. В самом деле, согласно рис. 3.7, л т- 1,6/(100 10) число приходов/год/морская миля побережья X 0,53 урагана/приход X 330 морских милей побе-реж1 я 2,28 урагана/год против 0,43 урагана/год, полученных на осиоис, 1анных рис. 3.5. Это расхождение, возможно, появилось вследствие уюта некоторых тропических циклонов как ураганов в [3.15]. В-ч( пи ) Г1,1х, оценки в значительной мере субъективны, так как никакие измерения такого рода не проводились следовательно, вдобавок может возникнуть существенная ошибка при получении оценки .

[c.81]

Сопоставление с аналогичным случаем в газовой динамике указывает на возможность ошибки при использовании найденного решения за разрывом, т. е. в данном случае справа от него. Такого рода ошибки представляют собой в газовой динамике эффекты третьего порядка малости, и ими часто можно пренебречь при рассмотрении слабых ударных волн однако для сильных ударных волн они могут приводить к неправильным выводам. Поэтому не должна упускаться из виду возможность того, что потребуется Л10дифицир0вать решение за скачком, а вместе с ним и расположение самого скачка.

[c.218]

-

Типы улучшающих вмешательств.

4

типа улучшающих вмешательств:

-

absolution

(действие священника, который отпускает

грехи кающемуся прихожанину) —

невмешательство;

Это означает, что существуют такие

проблемные ситуации, в которые лучше

не вмешиваться.

-

resolution

– частичное, неполное решение проблемы,

смягчение остроты недовольства, которое

не до конца и не полностью снимает это

недовольство;

Возникают в тех случаях, когда для

решения проблемы необходимо что-то

сделать, потратить ресурсы. Однако

ресурсов недостаточно.

-

solution

– это наилучшее решение при заданных

условиях (не просто решение, а самое

лучшее решение);

Ω Оптимальный

– это наилучший при заданных ограничениях.

Проблемы в системном анализе делятся

на 2 вида:

-

проблемные

ситуации, позволяющие количественное

описание (hard problems)

– решение проблемы заключается в

осуществлении оптимизации; -

проблемные

ситуации, не позволяющие количественное

описание (soft problems)

– решение проблемы происходит с помощью

специальной методологии (soft

methodology).

-

dissolution

(растворение) – это

такое вмешательство, в результате

которого проблема исчезает, растворяется.

Н. Винер “Сказка про обезьянью лапку”

Решение

проблемы осуществляет системный

аналитик. Системный аналитик и не может

решать проблемы, потому что, для того,

чтобы решить проблему, нам нужно понять

природу этой проблемы.

Решение проблемы осуществляется самими

участниками проблемной ситуации.

В процедуру прикладного системного

анализа встроено обучение прикладному

системному анализу.

Т ема 2. Понятие системы (что такое реальность).

-

Мир

материален. -

Появилось

понятие вещества (материи). -

Мир

неоднороден. -

Появились

понятия об объектах, предметах,

расстояниях, т.е. появилось понятие

пространства; -

Появились

понятия движения, силы, энергии. -

Появились

понятия силы, физических полей. -

Взаимодействуя,

объекты обмениваются ресурсами:

веществом, энергией и информацией.

Весь

мир не хаотичен, а организован. Существуют

законы реализации, развития. Появилось

понятие системы. Мир является совокупностью

различных систем. И вмешиваясь в этот

мир, мы должны учитывать его системность

в полной мере в случае, если мы хотим

добиваться успехов.

Существенные свойства системы являются

таковыми, если они отвечают двум

свойствам:

-

эти свойства

должны принадлежать всем системам,

независимо от их природы; -

из множества

свойств систем каждой систем интересуют

те свойства, информация которых нам

обязательно потребуется в процессе

решения проблемы.

Существенные

свойства системы:

-

статические

свойства системы:

Если мы в какой-то момент

зафиксируем систему (напр., сфотографируем)

и начнём рассматривать её, то такие

свойства мы и будем называть статические.

Они принадлежат любому моменту времени

в системе, но сами по себе в динамике

меняются.

-

целостность;

-

открытость

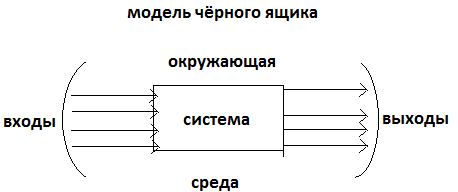

Модель

черного ящика должна отвечать определённым

требованиям:

-

не

всякий набор входов и выходов оказывается

рабочей моделью (пример про телевизор

и эротический фильм); в модели должна

быть вся нужная для достижения цели

информация; -

модель

чёрного ящика – это конечный список

входов и выходов;

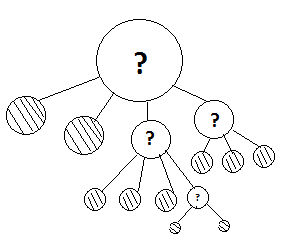

Существует 4 рода ошибок:

-

ошибка

первого рода совершается тогда, когда

принимаешь решение, что данная связь

существенна, и включаешь её в модель,

а на самом деле она не существенна (без

этой информации можно успешно достичь

цель); -

ошибка

второго рода совершается тогда, когда

принимаешь решение, что данная связь

не существенна, и не включаешь её в

модель, а на самом деле она существенна

(без этой информации нельзя успешно

достичь цель); -

ошибка

третьего рода: для того, чтобы решить

включать или не включать в модель

какую-то связь, нужно знать, что эта

модель существует; -

ошибка

четвёртого рода: если вы определяете,

что есть связь и она существенна, нужно

не ошибиться, на вход или на выход её

направить.

Типы

связи системы с окружающей средой:

-

необходимая

и достаточная связь (HиD)

= причинно следственная связь;

понятие причинно-следственной связи

является абстракцией

-

необходимая,

но достаточная связь (H

D) = основная причина

(продуцент–продукт); -

достаточен,

но не необходим (H D)

= многопричинная связь;

когда один и тот же результат может быть

получен разными способами.

-

существенная

связь, но не необходимая и не достаточная

(H D)

= ассоциативная, (вероятностная/стохастическая).

Ω

Ω Простым

следствием открытости всех систем

является закон о всеобщей взаимосвязи

и взаимозависимости в природе: всё в

мире взаимосвязано.

-

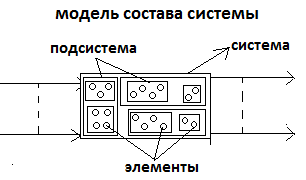

внутренняя

неоднородность (различимость частей);

Перечень частей – новая

модель чёрного ящика, это модель

состава системы.

Модель состава системы

– это перечень существенных частей

системы.

Модель состава – вторая из трёх базовых

частей системы.

Трудности построения модели

состава:

-

целое

делить на части можно делить по-разному; -

что является

элементарным для нас; -

наша система

является частью другой системы;

-

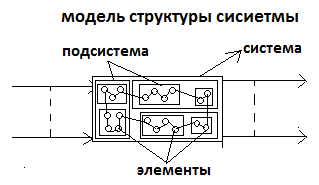

структурированность;

Модель структуры системы

– перечень существенных связей между

частями.

Для

одной и той же системы можно предлагать

разные модели структуры.

Трудности построения модели

состава:

-

из

бесконечного множества связей нужно

выделить существенные; -

модель

структуры – это совокупность входов

и выходов элементов; а элементы – это

маленькие чёрные ящички, а при построении

модели чёрного ящика можно допустить

четыре ошибки;

-

динамические

свойства системы;

Свойства, связанные с движением. То, что

мы увидим в кинофильме, снятом про

систему.

Модели изменений, которые

происходят в системах:

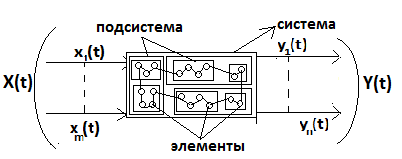

-

функциональность;

Все системы обладают каким-либо

функциями. Системы нам нужны ради тех

функций, которые они осуществляют.

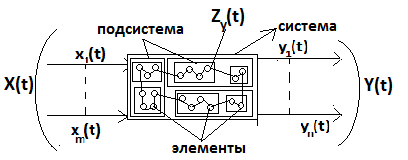

Y(t) – совокупность

всех выходов

Процессы на каждом выходе

носят название функция

(Y).

Замечания к функциональности:

-

все системы

многофункциональны; -

все функции

разные; -

оценивание

функций;

-

стимулируемость;

На любую систему можно оказать воздействие

через подачу процесса на один из её

входов. Система поддаётся влиянию из

вне.

X(t) – совокупность

всех входов.

Процессы на каждом входе

носят название стимул

(X).

Замечания

стимулирования:

-

стимулов

много; -

стимулы

разные; -

стимулы

можно оценивать субъекту.

Входы можно разделить на управляемый

и на неуправляемые.

-

изменчивость;

Любая система меняется со

временем, функционирует.

2 типа изменений в системе:

-

рост –

количественное изменение системы;

За счёт присоединения к

системе материальных ресурсов из

окружающей среды. Рост подчинён внешним

ограничениям.

-

развитие

– качественное изменение системы,

происходит за счёт восприятия информации

из внешней среды и использования этой

информации для своего развития.

Изменения в системе могут носить

качественный характер.

Рост

и развитие могут происходить как

одновременно, так и независимо друг от

друга. Происходит за счёт потребления

и использования информации.

Развитие

есть результат обучения. Развитие

возможно только как саморазвитие.

Кроме роста и развития есть и обратные

процессы: спад (количественное убывание)

и деградация (утеря полезных качеств).

Модель

“Жизненный

цикл системы”

Жизненный цикл – это описание (модель)

непрерывного процесса. Потому что жизнь

любой системы течёт во времени.

Жизненный цикл системы бывает двух

видов:

-

описание

системы, которая до этого была в прошлом

(история); -

описание

системы, которая ещё не воспроизведена

(проектирование).

Идеальное требование заключается в

том, что жизненный цикл должен быть

непрерывным.

-

существование

в изменяющейся среде;

Изменения внутри системе могут

происходить:

-

медленнее,

чем изменения в окружающей среде; -

синхронно

(зрачки человека); -

быстрее,

чем реальность вокруг (системы

управления).

-

синтетические

свойства системы:

-

эмерджентность

(emergence – возникновение,

внезапное появление чего-то);

У системы есть свойства, которые не

свойственны её частям, а свойственны

только системе в целом.

У системы обязательно есть эмерджентные

свойства, но есть и неэмерджентные

свойства

13.04.2012

Цель

– это достигаемое в будущем состояние.

Цель

как образ желаемого будущего и цель

достигаемого в будущем состояния – это

не одно и то же. Цель как образ желаемого

будущего – это субъективная

цель. Цель как достигаемое

в будущем состояние – это объективная

цель.

Разница

между субъективными и объективными

целями состоит в том, что субъективные

цели являются порождением

нашего разума, воображения, фантазии;

это образ желаемого будущего; а объективные

цели являются результатом

законов природы.

Почему

не все субъективные цели достижимы?

Дело в том, что субъективные цели

достижимы только в том случае, если они

одновременно являются объективными,

т.е. не противоречат объективным законам

природы.

Человек

может сделать всё, только если это не

будет противоречить законам природы.

Тема 3. Модели и моделирование.

Как

мы познаём и как мы описываем реальность?

Под моделью мы понимаем любой носитель

информации о чём-то.

Утверждение

1. Типов моделей, несмотря

на их огромное разнообразие, всего 3

(черный ящик, состав, структура).

Как

строить модель?

Способов построения моделей только 2

(анализ и синтез).

-

Анализ и синтез как методы

построения моделей.

Анализ

– сбор из частей целого. Анализ состоит

из 3х

операций:

-

разбиение

целого на фрагменты; -

попытка

объяснить каждый фрагмент; -

объединение

объяснений частей в объяснение целого.

А

нализ

даёт нам знание. А знание существует

только в виде моделей (1-ый продукт

анализа – модель состава, 2-ой продукт

анализа – модель структуры; 3-ий продукт

анализа – модели черного ящика для

каждого элемента).

Синтетическое объяснение непонятного

– это рассмотрение непонятного как

части большей системы

Синтез

– это выделение из системы части.

Синтез состоит из 3х операций:

-

выделение

большей системы, в которой наша система

является частью (метасистема); -

анализ

матасистемы (выделяем состав, связываем

структуру); -

рассмотрение

всех связей нашей системы с остальными

частями системы.

Синтез

даёт нам знания. А знания существуют

только в виде моделей. Нужно модель

состава и структуры местасистемы, чтобы

найти модель чёрного ящика объясняемой

системы.

Пирамида

познания по А. Коффу:

5 уровней познания:

Что

такое модель?

Синтетическая

характеристика модели.

В модели отображается только та

информация, которая нам нужна для нашей

цели.

Модель

– есть целевое отображение; приблизительное,

адекватное и ингерентное культуре.

Модели бывают познавательные и

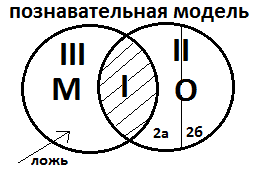

прагматические.

Модель и оригинал – это разные вещи,

это не одно и то же.

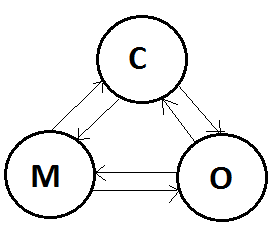

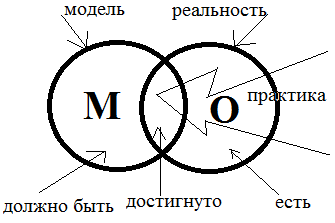

С

– субъект

М

– модель

О

– отображение

I

(истина) – правда, содержащаяся в модели

об оригинале.

II – в

модели не вся информация об оригинале

2а

– известная информация, которая для

нашей цели не нужна

2б

– не известная нам информация

III –

в любой модели есть такая информация,

которая не имеет к модели никакого

отношения

П

рагматическая

модель –

то, чего нет, но я хочу,

чтобы это было (цель).

Ω

Адекватность.

Модель адекватна, если с её помощью мы

успешно достигаем цель. Модель неадекватна,

если с её помощью невозможно достичь

цель.

Модель

– это системное отображение реальности.

Это означает, что модель обладает всеми

свойствами, которые учитываются при

работе любой

Модель работает лишь в том случае, если

она согласована с другими моделями.

Модель ингерентна культуре.

Соседние файлы в предмете [НЕСОРТИРОВАННОЕ]

- #

- #

- #

- #

- #

- #

- #

- #

- #

- #

- #