Время прочтения

13 мин

Просмотры 35K

Часто вижу, что помимо обработки исключений, люди мучаются кое с чем еще, а именно с логированием.

Большинство людей не знают, что писать в логи, поэтому решают логировать все, что угодно, думая, что все подряд – это в любом случае лучше, чем ничего, и, в конечном итоге, просто создают шум. А шум – это информация, которая никак не помогает вашей команде понять, в чем дело и как решить проблему.

Более того, я не думаю, что эти люди могут уверенно пользоваться уровнями логирования, поэтому используют по умолчанию logger.info везде (если не пишут print).

Наконец, люди, похоже, не знают, как сконфигурировать логирование в Python, понятия не имеют, что такое обработчики, фильтры, методы форматирования (форматтеры) и т.д.

Цель этой статьи – разъяснить, что такое логирование и как вы должны его реализовывать. Я постараюсь привести содержательные примеры и обеспечить вас гибкими эмпирическими приемами, которые следует использовать при логировании в любом приложении, которое вы когда-либо будете создавать.

Введение

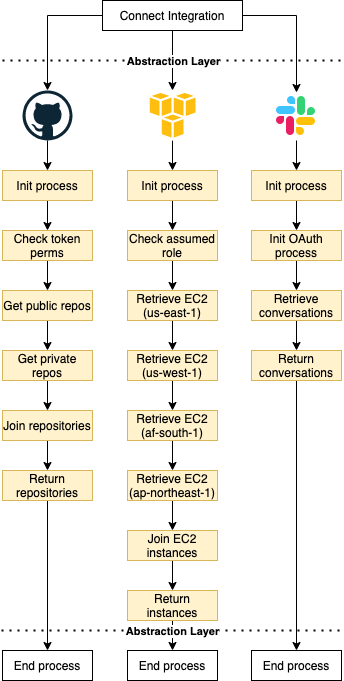

Примеры облегчают визуальное восприятие, поэтому мы будем рассматривать следующую систему:

-

Пользователи могут подключать несколько интеграций к ресурсам (например, GitHub, Slack, AWS и т.д.)

-

Ресурсы уникальны в зависимости от интеграции (например, репозитории списков с GitHub, диалоги из Slack, экземпляры списков EC2 из AWS и т.д.)

-

Каждая интеграция уникальна, имеет свой набор сложностей, конечных точек, шагов и т.д.

-

Каждая интеграция может привести к различным ошибкам, которые могут возникнуть в любое время (например, неверная аутентификация, ресурс не существует и т.д.)

Я не буду сосредотачиваться на проблемах поддержки таких интеграций, просто пронаблюдаем за тем, как это работает.

Природа логирования: хорошее логирование имеет значение

Для начала давайте проанализируем характеристики логов.

Логи должны быть:

-

Наглядными;

-

Контекстными;

-

Реактивными.

«Наглядными» мы их называем потому, что они предоставляют вам какую-то информацию, «контекстными», потому что они дают вам общее представление о том, как обстоят дела на данный момент времени. И наконец, «реактивными» они являются потому, что они позволяют вам предпринимать действия только после того, как что-то произошло (даже если ваши логи отправляются/получаются в режиме реального времени, на самом деле вы не можете изменить то, что произошло только что).

Если вы не будете учитывать природу логов, то будете производить только шум, что снизит вашу производительность.

Дальше я приведу несколько примеров, основанных на системе, которую мы определили выше:

Если вы зададите описание, к примеру «operation connect failed», но не добавите контекст, трудно будет понять, какая из интеграций не отработала, кто пострадал, на каком этапе подключения произошел сбой, поэтому и среагировать вы не можете. В конечном итоге вы будете копаться в тонне логов без малейшего представления о том, где может быть проблема.

О, а еще не стоит недооценивать способность разработчика испортить описание. Сделать это легко, просто отправив поверхностные сообщения без какого-либо контекста, например «An error happened» или «An unexpected exception was raised». Если я прочту такое, то даже не пойму, на что повлияла ошибка, потому что не буду знать, ЧТО конкретно произошло. Так что да, можно сломать даже основной смысл логов.

Логи – это конфиденциальная информация из вашего программного обеспечения, нужная чтобы вы оставались в курсе происходящего и могли реагировать на ситуации. Любые логи, которые не дают вам такой информации – это шум.

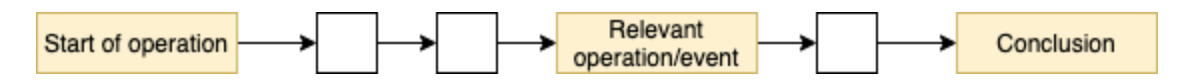

Когда нужно логировать?

Чтобы логи оставались реактивными, вам нужно логировать «события». Сделайте их такими же понятными и удобными для чтения, как эта статья. Возможно, вы не прочитали каждую строку, которую я написал выше, но вы все равно можете продолжить дальше, пропустить ненужные разделы и сосредоточиться на том, что привлекло ваше внимание. Логи должны быть такими же.

Есть эмпирическое правило построение логов:

-

В начале соответствующих операций или потоков (например, при подключении к сторонним сервисам и т.д.);

-

При любом достигнутом прогрессе (например, успешная аутентификация, получен валидный код ответа и т.д.);

-

При завершении операции (успешном или неудачном).

Логи должны рассказывать вам историю, у каждой истории есть начало, середина и конец.

Будьте осторожны с релевантностью, добавлять логи проще, чем удалять их, ведь все, что нерелевантно – шум.

Что логировать?

Чтобы логи были наглядными и контекстными, нужно предоставлять правильный набор информации, и я не могу сказать, какая информация будет являться таковой, не зная вашего случая. Давайте вместо этого воспользуемся нашим примером.

Рассмотрим интеграцию с AWS в качестве примера. Было бы круто иметь следующие сообщения:

Хороший пример логов

|

Сообщение |

Понимание картины |

Контекст |

|

|

Началась операция с AWS |

Атрибуты лога должны позволить мне выяснить, кто его вызвал |

|

|

Был достигнут существенный прогресс |

— |

|

|

Операция с AWS завершилась |

Атрибуты лога должны позволить мне найти сущности, на которые операция произвела положительный эффект |

Пример логов об ошибках

Допустим, что извлечь экземпляры из региона af-south-1 не удалось из-за какой-то внезапной ошибки в этом регионе.

|

Сообщение |

Понимание картины |

Контекст |

|

|

Началась операция с AWS |

Атрибуты лога должны позволить мне выяснить, кто его вызвал |

|

|

Операция AWS не завершена, произошел сбой в регионе af-south-1, пострадал пользователь X |

Я должен иметь возможность увидеть трассировку стека ошибки, чтобы понять, почему извлечение не удалось |

В обоих случаях, я могу отследить, когда произошло какое-то событие (в логах есть отметки о времени), что именно произошло и кто от этого пострадал.

Я решил не указывать пользователя при начале и успешном завершении операции, потому что это не имеет значения (ведь это шум), поскольку:

-

Если я знаю, что что-то запустилось, но не знаю результата выполнения, то что я могу сделать?

-

Если все хорошо, то зачем беспокоиться?

Добавление таких данных делает логи шумными, потому что на них невозможно реагировать, делать-то с этим ничего не надо! Но я все еще должен быть в состоянии собрать детальную информацию из атрибутов (кто, когда, почему и т.д.). Если вы хотите что-то измерить, вам следует воспользоваться метриками, а не логами.

С другой стороны, логи об ошибках кажутся более подробными, и так и должно быть! Чтение таких логов дает достаточно уверенности, чтобы немедленно перейти к действиям:

-

Попросите разработчика проверить статус AWS в регионе

af-south-1, и по возможности сделайте sanity check. -

Свяжитесь с пользователем Х и сообщите ему, что вам известно о проблеме в этом регионе.

Ключевой момент следующий: вы можете отреагировать сразу и для этого вам не требуется более глубокого изучения ситуации. Вы знаете все, что вам нужно, и можете немедленно принять меры для уменьшения ущерба. Разработчикам, возможно, потребуется углубиться в трассировку стека, чтобы собрать больше контекста (в случае с ошибкой), но общая картина уже становится ясна.

Любое сообщение об ошибке, в котором отсутствует эта минимальная информация, становится шумом, поскольку у вас появляется беспокойство, но вы все еще не можете действовать. Сначала нужно углубиться в ситуацию, чтобы понять, насколько проблема серьезна.

Если вы все еще не поняли, как писать полезные сообщения, я поделюсь с вами очень простым лайфхаком:

Всегда спрашивайте себя: Что я хочу уяснить для себя, после получения такого лога?

Предоставление контекста с помощью Python

В Python атрибуты логов можно добавить с помощью дополнительного поля, например:

# Do that

logger.info("Connecting to AWS", extra={"user": "X"})

...

logger.info("Connection to AWS has been successful", extra={"user": "X"})Контекст не отменяет необходимости в содержательных сообщениях! Поэтому я бы так не делал:

# Don't do that

logger.info("Connecting to third-party", extra={"user": "X", "third-party": "AWS"})Сообщения должны быть четкими и не оставлять места вопросам о том, что же вообще происходит. Контекст должен обогащать ваш опыт, предоставив информацию о более глубоких деталях, и давать вам понимание, по какой причине что-то произошло.

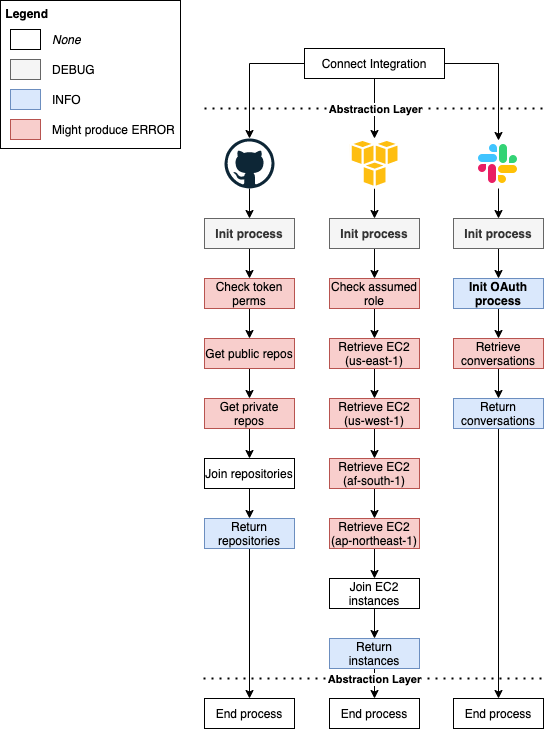

Нечто большее, чем logger.info и logger.error

Не так-то просто понять, что происходит, когда тысячи клиентов выдают логи «Connecting to Slack». Поскольку вы выдаете логи, а вашим приложением пользуются несколько клиентов, нужно иметь возможность фильтровать информацию по релевантности.

В логах бывает много уровней (т.е. уровней релевантности). В Python у вас есть DEBUG, INFO, WARNING, ERROR, CRITICAL. Я рекомендую использовать их все.

Чтобы упростить ситуацию, вот вам новое эмпирическое правило (будьте гибкими):

|

Уровень |

Когда используется |

|

|

Для какой-то действительно повторяющейся информации. Возможно, было бы полезно выдавать весь контекст информации, но порой этого не нужно. |

|

|

Когда происходит что-то важное, достойное того, чтобы о нем было известно большую часть времени. |

|

|

Случилось что-то странное (но не прервало поток/операцию). Если проблема возникнет на более поздних этапах, такой лог может дать вам подсказку. |

|

|

Произошла ошибка, ее следует устранить как можно быстрее. |

|

|

Произошла очень серьезная ошибка, она требует немедленного вмешательства. Если не уверены в критичности ошибки, применяйте |

Для описанной системы/потоков, я бы использовал уровни логов, как определено:

Что делать с logger.critical и logger.warning?

Для примера хочу осветить случаи, когда я бы рассмотрел возможность использования WARNING и CRITICAL.

-

WARNING– недостаточно веская причина для остановки потока, однако это предупреждение на будущее, если возникнет какая-то проблема. -

CRITICAL– самый тревожный предупреждающий лог, который вы когда-либо получите. По сути, он должен быть той самой причиной встать в три часа ночи и пойти что-то чинить.

Для этих случаев мы рассмотрим:

-

Для AWS: если какой-то регион AWS недоступен, мы можем предположить, что у пользователя там нет никаких ресурсов, поэтому можно двигаться дальше.

-

Для Slack: если OAuth завершится неудачно из-за невалидного id клиента, значит остальные пользователи столкнутся с той же проблемой, интеграция не отработает, пока мы вручную не сгенерируем новый id. Это дело кажется достаточно критичным.

Непопулярное мнение: использование DEBUG-уровня на продакшене

Да, я считаю, что логи DEBUG нужно использовать на продакшене.

Другой вариант – включить дебаг после того, как странная ошибка потребует более детального разбирательства.

Простите, но для меня такой вариант недопустим.

В реальном мире клиентам нужна быстрая реакция, командам нужно выполнять свою работу и постоянно поддерживать системы в рабочем состоянии. У меня нет времени и пропускной способности для нового деплоя или включения флага и ожидания повторения проблемы. Я должен реагировать на неожиданные проблемы в считанные секунды, а не минуты.

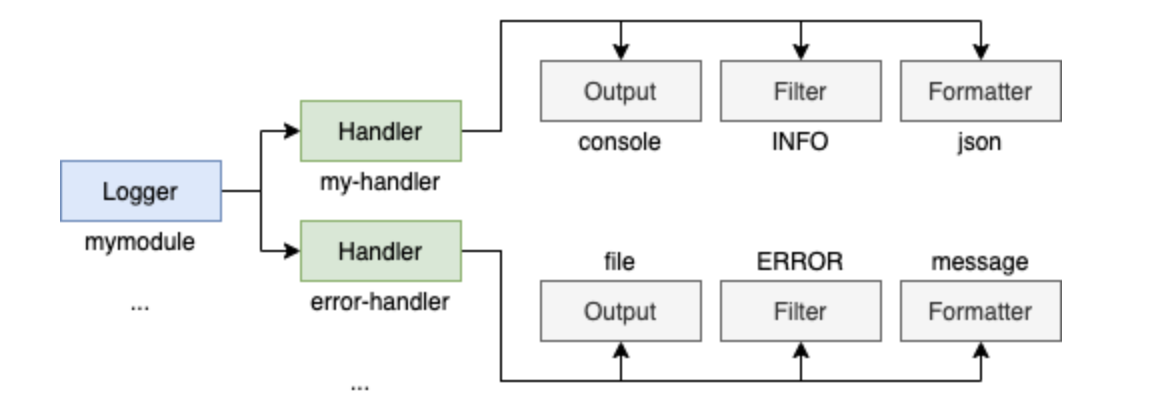

Правильно настройте логгер

Еще я замечаю, что люди испытывают трудности при настройке логгера (или вообще его не настраивают). Конечно, документация в Python не очень дружелюбная, но это не оправдание, чтобы вообще ее не трогать.

Есть несколько способов настроить логгер. Вы можете использовать logging.config.dictConfig, logging.config.fileConfig или вообще сделать все вручную, вызывая такие команды как setLevel, AddHandler, addFilter.

По моему опыту:

-

Использование ручных команд непросто поддерживать и понимать;

-

fileConfig– негибкая история, у вас не бывает динамических значений (без дополнительных фокусов); -

dictConfig– простая история в запуске и настройке.

Поэтому в качестве примера мы будем придерживаться dictConfig. Еще можно запустить basicConfig, но не думаю, что он вам понадобится, если вы все настроили правильно.

Я поделюсь несколькими советами и определениями, которые вам надо знать, а затем мы создадим окончательную конфигурацию на реальных примерах из проектов, над которыми я работаю.

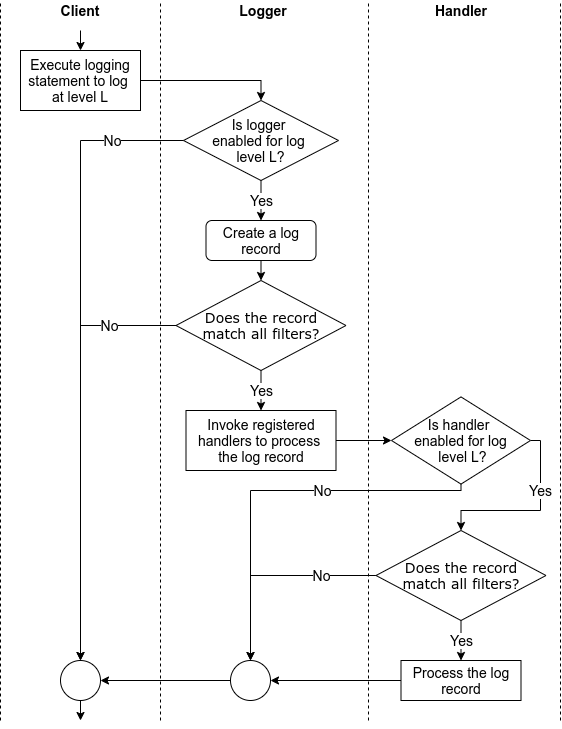

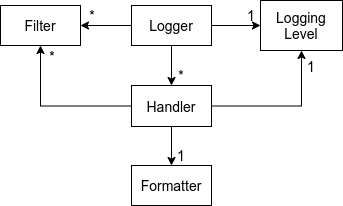

Вот кусочек того, о чем мы будем говорить дальше:

Что такое логгеры?

Логгеры – это объекты, которые вы создаете с помощью logging.getLogger, они позволяют выдавать сообщения. Каждый отдельный логгер может быть привязан к конфигурации со своим собственным набором форматтеров, фильтров, обработчиков и т.д.

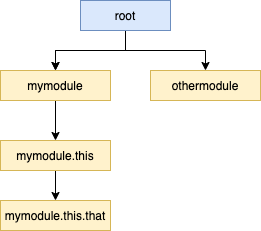

Самое интересное, что логгеры образуют иерархию и все наследуются от root-логгера. Дальнейшее наследование определяется «.» (точками), например mymodule.this.that будет наследником mymodule.this.

Посмотрите:

Из-за этого в документации Python есть рекомендация по использованию logger.getLogger(name), поскольку name, вернет лишь пространство имен текущего пакета.

В любом случае, придерживайтесь:

import logging

logger = logging.getLogger(__name__)

def myfunc():

...

logger.info("Something relevant happened")

...Внимание: Вы можете обратиться к корневому логгеру по имени root, пустой строке “” или вообще ни по чему. Да, это сбивает с толку, поэтому используйте root для многословности и ясности.

Форматируйте логи

Форматтеры вызываются для вывода конечного сообщения и отвечают за него преобразование в конечную строку.

Когда я работал в Zak (бывшем Mimic), и даже сегодня в Lumos мы форматировали логи как JSON. Он является хорошим стандартом для систем, работающих на продакшене, поскольку содержит множество атрибутов. Проще визуализировать JSON, чем обычную длинную строку, и для этого вам не нужно создавать свой собственный форматтер (ознакомьтесь с python-json-logger).

Для локальной разработки я рекомендую использовать форматирование по умолчанию для простоты.

Ваше решение будет зависеть от вида проекта. Для Tryceratops я решил использовать обычный форматтер, поскольку он проще и работает локально, там нет нужды в JSON.

Фильтруйте логи

Фильтры можно использовать либо для фильтрации логов (внезапно), либо для добавления дополнительного контекста в запись лога. Рассматривайте фильтры, как хуки, вызываемые до обработки итогового лога.

Их можно определить следующим образом:

class ContextFilter(logging.Filter):

USERS = ['jim', 'fred', 'sheila']

IPS = ['123.231.231.123', '127.0.0.1', '192.168.0.1']

def filter(self, record): # Add random values to the log record

record.ip = choice(ContextFilter.IPS)

record.user = choice(ContextFilter.USERS)

return TrueАдаптировано из https://docs.python.org/3/howto/logging-cookbook.html#using-filters-to-impart-contextual-information

Или их можно добавить прямо в логгер или обработчик для упрощения фильтрации по уровням (скоро будут примеры).

Обрабатывайте логи и то, как все связано

Обработчики представляют из себя комбинации форматтеров, выходных данных (потоков) и фильтров.

С ними вы можете создавать следующие комбинации:

-

Выводить все логи из

info(фильтр), а потом выводитьJSONв консоль. -

Выводить все логи, начиная с

error(фильтр) в файл, содержащий только сообщение и трассировку стека (форматтер).

Наконец логгеры указывают обработчикам.

Пример logging.dictConfig

Теперь, когда вы понимаете, что делают все эти объекты, давайте писать собственные! Как всегда, я постараюсь показать вам примеры из реальной жизни. Я буду использовать конфигурацию Tryceratops. Вы можете открыть ссылку и посмотреть самостоятельно окончательную конфигурацию.

Шаблон конфигурации логирования

Начнем с такого каркаса, создадим константу LOGGING_CONFIG:

import logging.config

LOGGING_CONFIG = {

"version": 1,

"disable_existing_loggers": False,

"formatters": { },

"handlers": { },

"loggers": { },

"root": { },

}

logging.config.dictConfig(LOGGING_CONFIG)Несколько заметок:

-

Versionвсегда будет 1. Это плейсхолдер для возможных следующих релизов. На данный момент версия всего одна. -

Я рекомендую оставить значение

disable_existing_loggersв False, чтобы ваша система не поглощала другие неожиданные проблемы, которые могут возникнуть. Если вы хотите изменить другие логгеры, я бы порекомендовал их явно переписать (хоть это и скучно). -

Внешний ключ

root, как вы могли догадаться, определяет логгер верхнего уровня, от которого может наследоваться текущий.

Корневой логгер можно определить тремя разными способами, что сбивает с толку:

LOGGING_CONFIG = {

"version": 1,

...

"loggers": {

"root": ... # Defines root logger

"": ... # Defines root logger

},

"root": { }, # Define root logger

}Выбирайте любой! Мне нравится оставлять его снаружи, поскольку так он выглядит очевиднее и подробнее говорит о том, чего я хочу, ведь корневой логгер влияет на все другие определенные логгеры.

Конфигурация логирования: форматтеры

Я дополню пример из Tryceratops примером с JSON из Lumos.

Обратите внимание, что любая конструкция %([name])[type], как %(message) или %(created), говорит форматтеру, что и как отображать.

LOGGING_CONFIG = {

...,

"formatters": {

"default": { # The formatter name, it can be anything that I wish

"format": "%(asctime)s:%(name)s:%(process)d:%(lineno)d " "%(levelname)s %(message)s", # What to add in the message

"datefmt": "%Y-%m-%d %H:%M:%S", # How to display dates

},

"simple": { # The formatter name

"format": "%(message)s", # As simple as possible!

},

"json": { # The formatter name

"()": "pythonjsonlogger.jsonlogger.JsonFormatter", # The class to instantiate!

# Json is more complex, but easier to read, display all attributes!

"format": """

asctime: %(asctime)s

created: %(created)f

filename: %(filename)s

funcName: %(funcName)s

levelname: %(levelname)s

levelno: %(levelno)s

lineno: %(lineno)d

message: %(message)s

module: %(module)s

msec: %(msecs)d

name: %(name)s

pathname: %(pathname)s

process: %(process)d

processName: %(processName)s

relativeCreated: %(relativeCreated)d

thread: %(thread)d

threadName: %(threadName)s

exc_info: %(exc_info)s

""",

"datefmt": "%Y-%m-%d %H:%M:%S", # How to display dates

},

},

...

}Обратите внимание, что имена, которые мы задаем (default, simple и JSON), — произвольные, но актуальные. Вскоре мы к ним обратимся.

Конфигурация логирования: обработчики

ERROR_LOG_FILENAME = ".tryceratops-errors.log"

LOGGING_CONFIG = {

...,

"formatters": {

"default": { ... },

"simple": { ... },

"json": { ... },

},

"handlers": {

"logfile": { # The handler name

"formatter": "default", # Refer to the formatter defined above

"level": "ERROR", # FILTER: Only ERROR and CRITICAL logs

"class": "logging.handlers.RotatingFileHandler", # OUTPUT: Which class to use

"filename": ERROR_LOG_FILENAME, # Param for class above. Defines filename to use, load it from constant

"backupCount": 2, # Param for class above. Defines how many log files to keep as it grows

},

"verbose_output": { # The handler name

"formatter": "simple", # Refer to the formatter defined above

"level": "DEBUG", # FILTER: All logs

"class": "logging.StreamHandler", # OUTPUT: Which class to use

"stream": "ext://sys.stdout", # Param for class above. It means stream to console

},

"json": { # The handler name

"formatter": "json", # Refer to the formatter defined above

"class": "logging.StreamHandler", # OUTPUT: Same as above, stream to console

"stream": "ext://sys.stdout",

},

},

...

}Обратите внимание, что если вы используете logging.fileConfig, иметь хорошую константу, такую как ERROR_LOG_FILENAME, невозможно. Эту же информацию можно прочитать из переменных среды, если хотите.

Также обратите внимание, что классы/параметры, которые я использую для обработчиков, создавал не я. Они из библиотеки logging, и там есть не только они!

Конфигурация логирования: логгеры и root

LOGGING_CONFIG = {

...,

"formatters": {

"default": { ... },

"simple": { ... },

"json": { ... },

},

"handlers": {

"logfile": { ... },

"verbose_output": { ... },

"json": { ... },

},

"loggers": {

"tryceratops": { # The name of the logger, this SHOULD match your module!

"level": "INFO", # FILTER: only INFO logs onwards from "tryceratops" logger

"handlers": [

"verbose_output", # Refer the handler defined above

],

},

},

"root": { # All loggers (including tryceratops)

"level": "INFO", # FILTER: only INFO logs onwards

"handlers": [

"logfile", # Refer the handler defined above

"json" # Refer the handler defined above

]

}Давайте разберемся, что происходит:

-

В

rootмы определяем все логи, кромеDEBUG, которые будут обрабатыватьсяlogfileи обработчикамиJSON. -

Обработчик

logfileотфильтровывает только логиERRORиCRITICAL, и выводит их в файл с форматтером по умолчанию. -

JSONпринимает все входящие логи (без фильтра) и выводит их в консоль сJSON-форматтером. -

Tryceratopsпереопределяет некоторые конфигурации, унаследованные отroot, такие какlevel(несмотря на то, что это то же самое), иhandlersдля использования толькоverbose_output. -

verbose_outputпринимает все входящие логи (фильтр поDEBUG) и выводит их в консоль, используя форматтерsimple.

Имя логгера tryceratops – это очень важная часть, и оно должно соответствовать логгерам, которые я создам позже. Для нашего примера, когда я пишу: logger.getLogger(name) внутри модуля, я получаю такие имена как tryceratops.main, tryceratops.runners или tryceratops.files.discovery, и все они соответствуют созданному нами правилу.

Я определил новый набор обработчиков для tryceratops, но все другие логгеры (в том числе из сторонних библиотек) будут использовать те, которые находятся в корне.

Кроме того, обратите внимание, что я могу переписать правила по умолчанию. Через настройки или позже динамически. Например, каждый раз, когда triceratops получает подобный флаг от CLI, он обновляет конфигурацию logging чтобы включить дебаг.

Логирование – это важно, но наличие хорошо структурированных исключений и блоков try/except также важно, поэтому вы можете также прочитать, как профессионально обрабатывать и структурировать исключения в Python.

Материал подготовлен в рамках курса «Python Developer. Basic».

Всех желающих приглашаем на demo-занятие «Основы ООП». Цели занятия: научиться работать с классами и познакомиться с наследованием.

Краткое содержание:

— мутабельность экземпляров класса

— передача аргументов в инициализатор

— наследование

— переопределение методов

— обращение к методам суперкласса

>> РЕГИСТРАЦИЯ

В стандартной библиотеке Python есть замечательный пакет для логирования — logging. В сети бытует мнение, что он сложный и настраивать его сплошная боль. В этой статье я попробую убедить вас в обратном. Мы разберём что из себя представляет этот пакет, изучим основные компоненты и закрепим материал практическим примером.

Зачем нужны логи?

Логи это рентген снимок выполнения вашей программы. Чем детальнее лог, тем проще разобраться в нестандартных ситуациях, которые могут приключиться с вашим скриптом. Наиболее популярным примером логов служат access логи веб-сервера, например, Apache httpd или nginx. Пример куска access лога моего блога:

92.63.107.227 - - [04/Nov/2020:06:30:48 +0000] "GET /ru/hosted-open-vpn-server/ HTTP/1.1" 301 169 "-" "python-requests/2.11.1" "-"

92.63.107.227 - - [04/Nov/2020:06:30:49 +0000] "GET /ru/data-engineering-course/ HTTP/1.1" 301 169 "-" "python-requests/2.11.1" "-"

213.180.203.50 - - [04/Nov/2020:06:36:07 +0000] "GET / HTTP/1.1" 301 169 "-" "Mozilla/5.0 (compatible; YandexMetrika/2.0; +http://yandex.com/bots yabs01)" "-"

114.119.160.75 - - [04/Nov/2020:06:36:41 +0000] "GET /robots.txt HTTP/1.1" 301 169 "-" "(compatible;PetalBot;+https://aspiegel.com/petalbot)" "10.179.80.67"

90.180.35.207 - - [04/Nov/2020:06:47:11 +0000] "GET / HTTP/1.0" 301 169 "-" "-" "-"

46.246.122.77 - - [04/Nov/2020:06:53:22 +0000] "GET / HTTP/1.1" 301 169 "<http://khashtamov.com>" "Mozilla/5.0 (Macintosh; Intel Mac OS X 10_12_4) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/66.0.3359.181 Safari/537.36" "-"

66.249.76.16 - - [04/Nov/2020:06:53:30 +0000] "GET / HTTP/1.1" 301 169 "-" "Mozilla/5.0 (compatible; Googlebot/2.1; +http://www.google.com/bot.html)" "-"

66.102.9.118 - - [04/Nov/2020:07:11:19 +0000] "GET / HTTP/1.1" 301 169 "-" "Mozilla/5.0 (X11; Linux x86_64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/49.0.2623.75 Safari/537.36 Google Favicon" "46.159.204.234"

71.6.167.142 - - [04/Nov/2020:07:11:55 +0000] "GET / HTTP/1.1" 301 169 "-" "Mozilla/5.0 (Windows NT 6.1) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/41.0.2228.0 Safari/537.36" "-"Помимо access логов веб-сервер также пишет error лог, там хранится информация обо всех ошибках при обработке HTTP запросов. Также и в ваших скриптах, логи могут делиться на информационные — вывод текущего состояния выполнения, отладочной информации, и на логи с ошибками — вывод исключений, ошибок с дополнительной информацией для отладки, содержащей контекст).

logging и Python

Точкой входа в работу с логированием в Python является библиотека logging. На первый взгляд может показаться, что библиотека сложная и запутанная, но потратив некоторое время на её изучение, можно убедиться в обратном. Для меня logging это классический пример дизайна ООП, где композиция преобладает над наследованием, поэтому в исходном коде библиотеки можно встретить множество функциональных классов. Цель этого туториала разобрать по косточкам каждый класс и воссоединить их в единый механизм логирования в Python. Начнём-с.

Logger

Чтобы начать работу с logging необходимо в импортировать библиотеку logging и вызвать функцию getLogger, передав ей имя будущего логера. Функция вернёт инстанс объекта Logger. Логер это рычаг за который мы дёргаем каждый раз, когда нам нужно записать информацию в лог.

import logging

logger = logging.getLogger('logger')

Заметьте, что функция getLogger принимает на вход параметр — имя логера. Можно назначать любое имя или __name__. Вызов getLogger с одинаковым названием вернёт один и тот же инстанс логера.

Я рекомендую использовать в качестве аргумента __name__, в этом случае не нужно беспокоиться, что разные модули могут ссылаться на один и тот же логер.

Класс Logger предоставляет наружу несколько методов для записи сообщений разного уровня. Уровни необходимы для понимания контекста сообщения/лога, который мы пишем. В logging существует несколько уровней:

- DEBUG — уровень отладочной информации, зачастую помогает при разработке приложения на машине программиста.

- INFO — уровень вспомогательной информации о ходе работы приложения/скрипта.

- WARNING — уровень предупреждения. Например, мы можем предупреждать о том, что та или иная функция будет удалена в будущих версиях вашего приложения.

- ERROR — с таким уровнем разработчики пишут логи с ошибками, например, о том, что внешний сервис недоступен.

- CRITICAL — уровень сообщений после которых работа приложения продолжаться не может.

По умолчанию в logging задан уровень WARNING, это означает, что сообщения уровня DEBUG и INFOбудут игнорироваться при записи в лог. Разработчик может самостоятельно задать необходимый ему уровень логирования через метод setLevel у инстанса Logger:

logger.setLevel(logging.DEBUG)

Методы для записи сообщений с разными уровнями именуются по тому же принципу:

logger.debug('debug info')

logger.info('info')

logger.warning('warning')

logger.error('debug info')

logger.critical('debug info')

Также есть ещё один метод — exception. Его желательно вызывать в блоке except при обработке исключения. В это случае он сможет уловить контекст исключения и записать его в лог:

try:

1/0

except :

logger.exception('exception')Handler

Задача класса Handler и его потомков обрабатывать запись сообщений/логов. Т.е. Handler отвечает за то куда будут записаны сообщения. В базовом наборе logging предоставляет ряд готовых классов-обработчиков:

- SteamHandler — запись в поток, например, stdout или stderr.

- FileHandler — запись в файл, класс имеет множество производных классов с различной функциональностью (ротация файлов логов по размеру, времени и т.д.)

- SocketHandler — запись сообщений в сокет по TCP

- DatagramHandler — запись сообщений в сокет по UDP

- SysLogHandler — запись в syslog

- HTTPHandler — запись по HTTP

Это далеко не полный список. Чтобы посмотреть все, перейдите по ссылке выше. Для указания Handler, необходимо у инстанса Logger вызвать метод addHandler и передать туда инстанс класса Handler. У одного Logger инстанса может быть множество обработчиков.

Пример записи лога в stdout:

import sys

import logging

from logging import StreamHandler

logger = logging.getLogger(__name__)

logger.setLevel(logging.DEBUG)

handler = StreamHandler(stream=sys.stdout)

logger.addHandler(handler)

logger.debug('debug information')

Если запустить этот скрипт, то можно увидеть сообщение:

debug information

Мы видим сообщение уровня DEBUG потому что задачи этот уровень в настройках. Если поменять его на INFO, то сообщение пропадёт:

logger.setLevel(logging.INFO)

Наверняка вы обратили внимание, что лог содержит всего лишь переданную строку. Как сделать так, чтобы в логе была информация об уровне лога, времени записи?

Formatter

Formatter это ёщё один класс в семействе logging, отвечающий за отображение лога. Если класс Handler ответственный за то куда будет происходить запись, то класс Formatter отвечает на вопрос как будет записано сообщение. По умолчанию в лог пишется голая строка, которую мы передаём через методы debug, info и т.д. Давайте обогатим наш лог дополнительной метаинформация, например, о времени записи и уровне сообщения. Formatter передаётся инстансу Handler через метод .setFormatter

import sys

import logging

from logging import StreamHandler, Formatter

logger = logging.getLogger(__name__)

logger.setLevel(logging.DEBUG)

handler = StreamHandler(stream=sys.stdout)

handler.setFormatter(Formatter(fmt='[%(asctime)s: %(levelname)s] %(message)s'))

logger.addHandler(handler)

logger.debug('debug information')

Запуск скрипта выведет на экран следующее сообщение:

[2020-11-22 13:00:08,751: DEBUG] debug information

Обратите внимание на строку, которую я передал при инициализации инстанса Formatter:

[%(asctime)s: %(levelname)s] %(message)s

Это шаблон, который будет заполнен при записи сообщения в лог. Набор таких готовых шаблонов можно посмотреть в разделе LogRecord attributes.

Filter

Задача класса фильтровать сообщения по заданной разработчиком логике. Предположим, что я хочу записывать в лог сообщения, содержащие слово python. Чтобы задать фильтр необходимо вызвать метод addFilter у инстанса Logger. Передать можно либо инстанс класса, реализующий метод filter либо callable объект (например, функцию). На вход прилетит инстанс класса LogRecord, это и есть 1 сообщение лога:

import sys

import logging

from logging import StreamHandler, Formatter, LogRecord

def filter_python(record: LogRecord) -> bool:

return record.getMessage().find('python') != -1

logger = logging.getLogger(__name__)

logger.setLevel(logging.DEBUG)

handler = StreamHandler(stream=sys.stdout)

handler.setFormatter(Formatter(fmt='[%(asctime)s: %(levelname)s] %(message)s'))

logger.addHandler(handler)

logger.addFilter(filter_python)

logger.debug('python debug information')

Наглядно и понятно, разве logging может быть сложным? 😎

LoggerAdapter

Адаптер нужен для передачи дополнительной контекстной информации при каждой записи лога через Logger. Например, вы написали веб-приложение и вам необходимо в логи дополнительно передавать username пользователя:

class CustomLoggerAdapter(LoggerAdapter):

def process(self, msg, kwargs):

return f'{msg} from {self.extra["username"]}', kwargs

logger2 = logging.getLogger('adapter')

logger2.setLevel(logging.DEBUG)

handler = StreamHandler(stream=sys.stdout)

handler.setFormatter(Formatter(fmt='[%(asctime)s: %(levelname)s] %(message)s'))

adapter = CustomLoggerAdapter(logger2, {'username': 'adilkhash'})

logger2.addHandler(handler)

adapter.error('failed to save')

extra и не только

Строки в логах это хорошо, а что если я хочу помимо строки дополнительно передавать ответ от веб-сервера? Для этого можно использовать аргумент extra при вызове методов debug, info и т.д. Давайте напишем пример вывода

logger.debug('debug info', extra={"response": response.text})Теперь вывод значения ключа response можно указать через Formatter (при условии, что response передаётся всегда):

Formatter(fmt='[%(asctime)s: %(levelname)s] %(message)s, response: %(response)s')

Аргумент extra удобен при написании своих кастомных обработчиков логов (например, отсылка логов в телеграм). Далее я покажу пример кастомного Handler класса для отправки логов в Telegram через бота.

Конфигурация logging

Официальная документация рекомендует конфигурировать logging через python-словарь. Для этого необходимо вызвать функцию logging.config.dictConfig и передать ей специальный словарь. Схема словаря описана здесь. Я лишь вкратце пробегусь по основным ключам:

- version — ключ указывает версию конфига, рекомендуется наличие этого ключа со значением 1, нужно для обратной совместимости в случае, если в будущем появятся новые версии конфигов.

- disable_existing_loggers — запрещает или разрешает настройки для существующих логеров (на момент запуска), по умолчанию равен True

- formatters — настройки форматов логов

- handlers — настройки для обработчиков логов

- loggers — настройки существующих логеров

Ранее все настройки я задавал кодом через вызов методов. Это может быть удобно, если у вас 1 модуль, но когда таких модулей становится множество, то в каждом из них задавать общие настройки кажется излишним занятием. Давайте попробуем все настройки задать в одном месте:

import logging.config

LOGGING_CONFIG = {

'version': 1,

'disable_existing_loggers': False,

'formatters': {

'default_formatter': {

'format': '[%(levelname)s:%(asctime)s] %(message)s'

},

},

'handlers': {

'stream_handler': {

'class': 'logging.StreamHandler',

'formatter': 'default_formatter',

},

},

'loggers': {

'my_logger': {

'handlers': ['stream_handler'],

'level': 'DEBUG',

'propagate': True

}

}

}

logging.config.dictConfig(LOGGING_CONFIG)

logger = logging.getLogger('my_logger')

logger.debug('debug log')

Неправда ли удобно? В реальных приложениях настройки выносят в отдельный модуль, который обязательно импортируется на старте, например, модуль в settings.py как в Django. Именно в нём задаются глобальные настройки для всех логеров приложения.

Наследование в logging

Ещё одним удобным механизмом в logging является «наследование» настроек корневого логера его потомками. Наследование задаётся через символ . в названии логера. То есть логер с названием my_package.logger1 унаследует все настройки, заданные для my_package. Давайте обновим пример выше, добавив в LOGGING_CONFIG настройку для my_package

LOGGING_CONFIG['loggers'].update({

'my_package': {

'handlers': ['stream_handler'],

'level': 'DEBUG',

'propagate': False

}

})

Если у вас есть настройка для конкретного логера и вы не хотите, чтобы он был дополнительно обработан родительскими Handler классами, то ключу propagate нужно присвоить значение False. В этом случае передача управления «вверх» до родителя будет запрещена.

Отправляем логи в Telegram

А теперь давайте напишем свой кастомный Handler для отправки логов через бота в телеграм. Если вы никогда не работали с телеграм-ботами, то почитайте мою статью про создание телеграм-ботов. Я предполагаю, что вы уже создали бота, получили его токен и знаете свой user-id/chat-id, чтобы бот смог посылать сообщения лично вам. Для работы с телеграмом я использую библиотеку pyTelegramBotAPI.

Чтобы создать свой обработчик, необходимо наследоваться от класса Handler и перезаписать метод emit:

import telebot

from logging import Handler, LogRecord

class TelegramBotHandler(Handler):

def __init__(self, token: str, chat_id: str):

super().__init__()

self.token = token

self.chat_id = chat_id

def emit(self, record: LogRecord):

bot = telebot.TeleBot(self.token)

bot.send_message(

self.chat_id,

self.format(record)

)

При инициализации инстанса класса TelegramBotHandler ему необходимо будет передать токен бота и chat_id. Замечу, что эти настройки можно задать через конфигурирование:

'handlers': {

'telegram_handler': {

'class': 'handlers.TelegramBotHandler',

'chat_id': '<CHAT_ID>',

'token': '<BOT_TOKEN>',

'formatter': 'default_formatter',

}

},

Чтобы обработчик начал свою работу, достаточно в настройках вашего логера прописать новый обработчик:

LOGGING_CONFIG['loggers'].update({

'my_package': {

'handlers': ['stream_handler', 'telegram_handler'],

'level': 'DEBUG',

'propagate': False

}

})Всё готово! 😎

Заключение

В этой статье я постарался вкратце рассказать и показать основные сущности библиотеки logging, а также продемонстрировать гибкий механизм логирования в python. Надеюсь мне это удалось, и статья оказалась для вас полезной.

💌 Присоединяйтесь к рассылке

Понравился контент? Пожалуйста, подпишись на рассылку.

Logging is used to track events that happen when an application runs. Logging calls are added to application code to record or log the events and errors that occur during program execution. In Python, the logging module is used to log such events and errors.

An event can be described by a message and can optionally contain data specific to the event. Events also have a level or severity assigned by the developer.

Logging is very useful for debugging and for tracking any required information.

How to Use Logging in Python

The Logging Module

The Python standard library contains a logging module that provides a flexible framework for writing log messages from Python code. This module is widely used and is the starting point for most Python developers to use logging.

The logging module provides ways for applications to configure different log handlers and to route log messages to these handlers. This enables a highly flexible configuration that helps to handle many different use cases.

To write a log message, a caller requests a named logger. This logger can be used to write formatted messages using a log level (DEBUG, INFO, ERROR etc). Here’s an example:

import logging

log = logging.getLogger("mylogger")

log.info("Hello World")Logging Levels

The standard logging levels in Python (in increasing order of severity) and their applicability are:

- DEBUG — Detailed information, typically of interest when diagnosing problems.

- INFO — Confirmation of things working as expected.

- WARNING — Indication of something unexpected or a problem in the near future e.g. ‘disk space low’.

- ERROR — A more serious problem due to which the program was unable to perform a function.

- CRITICAL — A serious error, indicating that the program itself may not be able to continue executing.

The default log level is WARNING, which means that only events of this level and above are logged by default.

Configuring Logging

In general, a configuration consists of adding a Formatter and a Handler to the root logger. The Python logging module provides a number of ways to configure logging:

- Creating loggers, handlers and formatters programmatically that call the configuration methods.

- Creating a logging configuration file and reading it.

- Creating a dictionary of config information and passing it to the

dictConfig()function.

The official Python documentation recommends configuring the error logger via Python dictionary. To do this logging.config.dictConfig needs to be called which accepts the dictionary as an argument. Its schema is:

version— Should be 1 for backwards compatibilitydisable_existing_loggers— Disables the configuration for existing loggers. This isTrueby default.formatters— Formatter settingshandlers— Handler settingsloggers— Logger settings

It is best practice to configure this by creating a new module e.g. settings.py or conf.py. Here’s an example:

import logging.config

MY_LOGGING_CONFIG = {

'version': 1,

'disable_existing_loggers': False,

'formatters': {

'default_formatter': {

'format': '[%(levelname)s:%(asctime)s] %(message)s'

},

},

'handlers': {

'stream_handler': {

'class': 'logging.StreamHandler',

'formatter': 'default_formatter',

},

},

'loggers': {

'mylogger': {

'handlers': ['stream_handler'],

'level': 'INFO',

'propagate': True

}

}

}

logging.config.dictConfig(MY_LOGGING_CONFIG)

logger = logging.getLogger('mylogger')

logger.info('info log')How to Use Logging for Debugging

Besides the logging levels described earlier, exceptions can also be logged with associated traceback information. With logger.exception, traceback information can be included along with the message in case of any errors. This can be highly useful for debugging issues. Here’s an example:

import logging

logger = logging.getLogger(“mylogger”)

logger.setLevel(logging.INFO)

def add(a, b):

try:

result = a + b

except TypeError:

logger.exception("TypeError occurred")

else:

return result

c = add(10, 'Bob')Running the above code produces the following output:

TypeError occurred

Traceback (most recent call last):

File "test.py", line 8, in add

result = a + b

TypeError: unsupported operand type(s) for +: 'int' and 'str'The output includes the message as well as the traceback info, which can be used to debug the issue.

Python Logging Examples

Basic Logging

Here’s a very simple example of logging using the root logger with basic config:

import logging

logging.basicConfig(level=logging.INFO)

logging.info('Hello World')Here, the basic Python error logging configuration was set up using logging.basicConfig(). The log level was set to logging.INFO, which means that messages with a level of INFO and above will be logged. Running the above code produces the following output:

INFO:root:Hello WorldThe message is printed to the console, which is the default output destination. The printed message includes the level and the description of the event provided in the logging call.

Logging to a File

A very common use case is logging events to a file. Here’s an example:

import logging

logging.basicConfig(level=logging.INFO, filename='sample.log', encoding='utf-8')

logging.info('Hello World')Running the above code should create a log file sample.log in the current working directory (if it doesn’t exist already). All subsequent log messages will go straight to this file. The file should contain the following log message after the above code is executed:

INFO:root:Hello WorldLog Message Formatting

The log message format can be specified using the format argument of logging.basicConfig(). Here’s an example:

import logging

logging.basicConfig(level=logging.INFO, format='%(asctime)s:%(levelname)s:%(message)s')

logging.info('Hello World')Running the above code changes the log message format to show the time, level and message and produces the following output:

2021-12-09 16:28:25,008:INFO:Hello WorldPython Error Logging Using Handler and Formatter

Handlers and formatters are used to set up the output location and the message format for loggers. The FileHandler() class can be used to setup the output file for logs:

import logging

logger = logging.getLogger(__name__)

logger.setLevel(logging.INFO)

file_handler = logging.FileHandler('sample.log')

formatter = logging.Formatter('%(asctime)s:%(levelname)s:%(message)s')

file_handler.setFormatter(formatter)

logger.addHandler(file_handler)

logger.info('Hello World')Running the above code will create the log file sample.log if it doesn’t exist already and write the following log message to the file:

2021-12-10 15:49:46,494:INFO:Hello WorldFrequently Asked Questions

What is logging in Python?

Logging in Python allows the tracking of events during program execution. Logs are added to application code to indicate the occurrence of certain events. An event is described by a message and optional variable data specific to the event. In Python, the built-in logging module can be used to log events.

Log messages can have 5 levels — DEBUG, INGO, WARNING, ERROR and CRITICAL. They can also include traceback information for exceptions. Logs can be especially useful in case of errors to help identify their cause.

What is logging getLogger Python?

To start logging using the Python logging module, the factory function logging.getLogger(name) is typically executed. The getLogger() function accepts a single argument — the logger’s name. It returns a reference to a logger instance with the specified name if provided, or root if not. Multiple calls to getLogger() with the same name will return a reference to the same logger object.

Any logger name can be provided, but the convention is to use the __name__ variable as the argument, which holds the name of the current module. The names are separated by periods(.) and are hierarchical structures. Loggers further down the list are children of loggers higher up the list. For example, given a logger foo, loggers further down such as foo.bar are descendants of foo.

Track, Analyze and Manage Errors With Rollbar

The requests library is the most popular python library for sending HTTP requests. As a normal part of RESTful application development you’ll often want to see exactly what you’re sending to the server including request headers and payload. In fact, this is especially true when you’ll be communicating with an API endpoints that:

- May be out of your control and sensitive to specific header values, and

- Are only available over HTTPS which makes side-channel observation unavailable

Further, you’ll often want to log these details in your normal application log file to be able to sift through after and find the specific request you are working with.

Unfortunately the method to turn on such debugging is a bit awkward since the requests library relies on the http.client.HTTPConnection class which do not use python’s standard logging library.

This article covers the steps necessary to turn on HTTPConnection debug logging and redirect the output to your application’s log file.

Step 1: Set up environment

$ python3 -m venv venv $ . venv/bin/activate (venv) $ pip3 install Flask requests

Step 2: Setting up the dummy test server

In order to test our app, we’ll use flask to spin up a small HTTP server to accept both GET and POST requests and simply respond with 200 OK.

# test_server.py

from flask import Flask

app = Flask(__name__)

@app.route('/test', methods=['GET', 'POST'])

def test():

return 'OK', 200

Start up the test server:

$ env FLASK_APP=test_server flask run * Serving Flask app "test_server" * Environment: production WARNING: This is a development server. Do not use it in a production deployment. Use a production WSGI server instead. * Debug mode: off * Running on http://127.0.0.1:5000/ (Press CTRL+C to quit)

Step 3: Initial App

Here is our minimal app that we’ll add onto later:

import requests

import logging

# Set up logging to a file

logging.basicConfig(filename="app.log", level=logging.DEBUG)

logger = logging.getLogger(__name__)

url = "http://localhost:5000/test"

logger.info("Sending HTTP GET")

resp = requests.get(url)

logger.info("Sending HTTP POST")

resp = requests.post(url, data='My Test Data')

Step 4: Enabling Low-Level HTTPConnection Debugging

As mentioned above, the requests library relies on the low-level http.client.HTTPConnection class, so the first step is to enable that class’s debugging functionality.

Adding the following turns on global debugging in the HTTPConnection class:

http.client.HTTPConnection.debuglevel = 1

These debug messages will be printed to the console, in order to save them to the log we will need to redirect them.

Step 5: Redirecting Console Debug Messages To A File

The next step is to monkey patch the http.client’s print() function with our own that redirects the messages to a pre-defined logger instance.

def print_to_log(*args):

logger.debug(" ".join(args))

http.client.print = print_to_log

Putting It All Together

import http

import logging

import requests

# Set up logging to a file

logging.basicConfig(filename="app.log", level=logging.DEBUG)

logger = logging.getLogger(__name__)

# Turn on global debugging for the HTTPConnection class, doing so will

# cause debug messages to be printed to STDOUT

http.client.HTTPConnection.debuglevel = 1

# Monkey patch the print() function and redirect it to a

# logger.debug() call

def print_to_log(*args):

logger.debug(" ".join(args))

http.client.print = print_to_log

# Test HTTP GET and POST

url = "http://localhost:5000/test"

logger.info("Sending HTTP GET")

resp = requests.get(url)

logger.info("Sending HTTP POST")

resp = requests.post(url, data='My Test Data')

Demo Output (app.log)

INFO:__main__:Sending HTTP GET DEBUG:urllib3.connectionpool:Starting new HTTP connection (1): localhost:5000 DEBUG:__main__:send: b'GET /test HTTP/1.1rnHost: localhost:5000rnUser-Agent: python-requests/2.25.1rnAccept-Encoding: gzip, deflaternAccept: */*rnConnection: keep-alivernrn' DEBUG:__main__:reply: 'HTTP/1.0 200 OKrn' DEBUG:__main__:header: Content-Type: text/html; charset=utf-8 DEBUG:__main__:header: Content-Length: 2 DEBUG:__main__:header: Server: Werkzeug/1.0.1 Python/3.7.3 DEBUG:__main__:header: Date: Sun, 21 Feb 2021 19:35:24 GMT DEBUG:urllib3.connectionpool:http://localhost:5000 "GET /test HTTP/1.1" 200 2

INFO:__main__:Sending HTTP POST DEBUG:urllib3.connectionpool:Starting new HTTP connection (1): localhost:5000 DEBUG:__main__:send: b'POST /test HTTP/1.1rnHost: localhost:5000rnUser-Agent: python-requests/2.25.1rnAccept-Encoding: gzip, deflaternAccept: */*rnConnection: keep-alivernContent-Length: 12rnrn' DEBUG:__main__:send: b'My Test Data' DEBUG:__main__:reply: 'HTTP/1.0 200 OKrn' DEBUG:__main__:header: Content-Type: text/html; charset=utf-8 DEBUG:__main__:header: Content-Length: 2 DEBUG:__main__:header: Server: Werkzeug/1.0.1 Python/3.7.3 DEBUG:__main__:header: Date: Sun, 21 Feb 2021 19:35:24 GMT DEBUG:urllib3.connectionpool:http://localhost:5000 "POST /test HTTP/1.1" 200 2

Python’s built-in logging module is designed to give you critical visibility into your applications with minimal setup. Whether you’re just getting started or already using Python’s logging module, this guide will show you how to configure this module to log all the data you need, route it to your desired destinations, and centralize your logs to get deeper insights into your Python applications. In this post, we will show you how to:

- Customize the priority level and destination of your logs

- Configure a custom setup that involves multiple loggers and destinations

- Incorporate exception handling and tracebacks in your logs

- Format your logs in JSON and centralize them for more effective troubleshooting

Python’s logging module basics

The logging module is included in Python’s standard library, which means that you can start using it without installing anything. The logging module’s basicConfig() method is the quickest way to configure the desired behavior of your logger. However, the Python documentation recommends creating a logger for each module in your application—and it can be difficult to configure a logger-per-module setup using basicConfig() alone. Therefore, most applications (including web frameworks like Django) automatically use file-based or dictionary-based logging configuration instead. If you’d like to get started with one of those methods, we recommend skipping directly to that section.

Three of the main parameters of basicConfig() are:

- level: the minimum priority level of messages to log. In order of increasing severity, the available log levels are: DEBUG, INFO, WARNING, ERROR, and CRITICAL. By default, the level is set to WARNING, meaning that Python’s logging module will filter out any DEBUG or INFO messages.

- handler: determines where to route your logs. Unless you specify otherwise, the logging library will use a

StreamHandlerto direct log messages tosys.stderr(usually the console). - format: by default, the logging library will log messages in the following format:

<LEVEL>:<LOGGER_NAME>:<MESSAGE>. In the following section, we’ll show you how to customize this to include timestamps and other information that is useful for troubleshooting.

Since the logging module only captures WARNING and higher-level logs by default, you may be lacking visibility into lower-priority logs that can be useful for conducting a root cause analysis. The logging module also streams logs to the console instead of appending them to a file. Rather than using a StreamHandler or a SocketHandler to stream logs directly to the console or to an external service over the network, you should use a FileHandler to log to one or more files on disk.

One main advantage of logging to a file is that your application does not need to account for the possibility of encountering network-related errors while streaming logs to an external destination. If it runs into any issues with streaming logs over the network, you won’t lose access to those logs, since they’ll be stored locally on each server. Logging to a file also allows you to create a more customized logging setup, where you can route different types of logs to separate files, and tail and centralize those files with a log monitoring service.

In the next section, we’ll show you how easy it is to customize basicConfig() to log lower-priority messages and direct them to a file on disk.

An example of basicConfig()

The following example uses basicConfig() to configure an application to log DEBUG and higher-level messages to a file on disk (myapp.log). It also indicates that logs should follow a format that includes the timestamp and log severity level:

import logging

def word_count(myfile):

logging.basicConfig(level=logging.DEBUG, filename='myapp.log', format='%(asctime)s %(levelname)s:%(message)s')

try:

# count the number of words in a file and log the result

with open(myfile, 'r') as f:

file_data = f.read()

words = file_data.split(" ")

num_words = len(words)

logging.debug("this file has %d words", num_words)

return num_words

except OSError as e:

logging.error("error reading the file")

[...]

If you run the code on an accessible file (e.g., myfile.txt) followed by an inaccessible file (e.g., nonexistentfile.txt), it will append the following logs to the myapp.log file:

2019-03-27 10:49:00,979 DEBUG:this file has 44 words

2019-03-27 10:49:00,979 ERROR:error reading the file

Thanks to the new basicConfig() configuration, DEBUG-level logs are no longer being filtered out, and logs follow a custom format that includes the following attributes:

%(asctime)s: displays the date and time of the log, in local time%(levelname)s: the logging level of the message%(message)s: the message

See the documentation for information about the attributes you can include in the format of each log record. In the example above, an error message was logged, but it did not include any exception traceback information, making it difficult to determine the source of the issue. In a later section of this post, we’ll show you how to log the full traceback when an exception occurs.

Digging deeper into Python’s logging library

We’ve covered the basics of basicConfig(), but as mentioned earlier, most applications will benefit from implementing a logger-per-module setup. As your application scales, you’ll need a more robust, scalable way to configure each module-specific logger—and to make sure you’re capturing the logger name as part of each log. In this section, we’ll explore how to:

- configure multiple loggers and automatically capture the logger name

- use

fileConfig()to implement custom formatting and routing options - capture tracebacks and uncaught exceptions

Configure multiple loggers and capture the logger name

To follow the best practice of creating a new logger for each module in your application, use the logging library’s built-in getLogger() method to dynamically set the logger name to match the name of your module:

logger = logging.getLogger(__name__)

This getLogger() method sets the logger name to __name__, which corresponds to the fully qualified name of the module from which this method is called. This allows you to see exactly which module in your application generated each log message, so you can interpret your logs more clearly.

For example, if your application includes a lowermodule.py module that gets called from another module, uppermodule.py, the getLogger() method will set the logger name to match the associated module. Once you modify your log format to include the logger name (%(name)s), you’ll see this information in every log message. You can define the logger within each module like this:

# lowermodule.py

import logging

logging.basicConfig(level=logging.DEBUG, format='%(asctime)s %(name)s %(levelname)s:%(message)s')

logger = logging.getLogger(__name__)

def word_count(myfile):

try:

with open(myfile, 'r') as f:

file_data = f.read()

words = file_data.split(" ")

final_word_count = len(words)

logger.info("this file has %d words", final_word_count)

return final_word_count

except OSError as e:

logger.error("error reading the file")

[...]

# uppermodule.py

import logging

import lowermodule

logging.basicConfig(level=logging.DEBUG, format='%(asctime)s %(name)s %(levelname)s:%(message)s')

logger = logging.getLogger(__name__)

def record_word_count(myfile):

logger.info("starting the function")

try:

word_count = lowermodule.word_count(myfile)

with open('wordcountarchive.csv', 'a') as file:

row = str(myfile) + ',' + str(word_count)

file.write(row + 'n')

except:

logger.warning("could not write file %s to destination", myfile)

finally:

logger.debug("the function is done for the file %s", myfile)

If we run uppermodule.py on an accessible file (myfile.txt) followed by an inaccessible file (nonexistentfile.txt), the logging module will generate the following output:

2019-03-27 21:16:41,200 __main__ INFO:starting the function

2019-03-27 21:16:41,200 lowermodule INFO:this file has 44 words

2019-03-27 21:16:41,201 __main__ DEBUG:the function is done for the file myfile.txt

2019-03-27 21:16:41,201 __main__ INFO:starting the function

2019-03-27 21:16:41,202 lowermodule ERROR:[Errno 2] No such file or directory: 'nonexistentfile.txt'

2019-03-27 21:16:41,202 __main__ DEBUG:the function is done for the file nonexistentfile.txt

The logger name is included right after the timestamp, so you can see exactly which module generated each message. If you do not define the logger with getLogger(), each logger name will show up as root, making it difficult to discern which messages were logged by the uppermodule as opposed to the lowermodule. Messages that were logged from uppermodule.py list the __main__ module as the logger name, because uppermodule.py was executed as the top-level script.

Although we are now automatically capturing the logger name as part of the log format, both of these loggers are configured with the same basicConfig() line. In the next section, we’ll show you how to streamline your logging configuration by using fileConfig() to apply logging configuration across multiple loggers.

Use fileConfig() to output logs to multiple destinations

Although basicConfig() makes it quick and easy to get started with logging, using file-based (fileConfig()) or dictionary-based (dictConfig()) configuration allows you to implement more custom formatting and routing options for each logger in your application, and route logs to multiple destinations. This is also the model that popular frameworks like Django and Flask use for configuring application logging. In this section, we’ll take a closer look at setting up file-based logging configuration. A logging configuration file needs to contain three sections:

- [loggers]: the names of the loggers you’ll configure.

- [handlers]: the handler(s) these

loggersshould use (e.g.,consoleHandler,fileHandler). - [formatters]: the format(s) you want each logger to follow when generating a log.

Each section should include a comma-separated list of one or more keys: keys=handler1,handler2,[...]. The keys determine the names of the other sections you’ll need to configure, formatted as [<SECTION_NAME>_<KEY_NAME>], where the section name is logger, handler, or formatter. A sample logging configuration file (logging.ini) is shown below.

[loggers]

keys=root

[handlers]

keys=fileHandler

[formatters]

keys=simpleFormatter

[logger_root]

level=DEBUG

handlers=fileHandler

[handler_fileHandler]

class=FileHandler

level=DEBUG

formatter=simpleFormatter

args=("/path/to/log/file.log",)

[formatter_simpleFormatter]

format=%(asctime)s %(name)s - %(levelname)s:%(message)s

Python’s logging documentation recommends that you should only attach each handler to one logger and rely on propagation to apply handlers to the appropriate child loggers. This means that if you have a default logging configuration that you want all of your loggers to pick up, you should add it to a parent logger (such as the root logger), rather than applying it to each lower-level logger. See the documentation for more details about propagation. In this example, we configured a root logger and let it propagate to both of the modules in our application (lowermodule and uppermodule). Both loggers will output DEBUG and higher-priority logs, in the specified format (formatter_simpleFormatter), and append them to a log file (file.log). This removes the need to include logging.basicConfig(level=logging.DEBUG, format='%(asctime)s %(name)s %(levelname)s:%(message)s') in both modules.

Instead, once you’ve created this logging configuration file, you can add logging.config.fileConfig() to your code like so:

import logging.config

logging.config.fileConfig('/path/to/logging.ini', disable_existing_loggers=False)

logger = logging.getLogger(__name__)

Make sure to import logging.config so that you’ll have access to the fileConfig() function. In this example, disable_existing_loggers is set to False, indicating that the logging module should not disable pre-existing non-root loggers. This setting defaults to True, which will disable any non-root loggers that existed prior to fileConfig() unless you configure them afterward.

Your application should now start logging based on the configuration you set up in your logging.ini file. You also have the option to configure logging in the form of a Python dictionary (via dictConfig()), rather than in a file. See the documentation for more details about using fileConfig() and dictConfig().

Python exception handling and tracebacks

Logging the traceback in your exception logs can be very helpful for troubleshooting issues. As we saw earlier, logging.error() does not include any traceback information by default—it will simply log the exception as an error, without providing any additional context. To make sure that logging.error() captures the traceback, set the sys.exc_info parameter to True. To illustrate, let’s try logging an exception with and without exc_info:

# lowermodule.py

logging.config.fileConfig('/path/to/logging.ini', disable_existing_loggers=False)

logger = logging.getLogger(__name__)

def word_count(myfile):

try:

# count the number of words in a file, myfile, and log the result

[...]

except OSError as e:

logger.error(e)

logger.error(e, exc_info=True)

[...]

If you run the code with an inaccessible file (e.g., nonexistentfile.txt) as the input, it will generate the following output:

2019-03-27 21:01:58,191 lowermodule - ERROR:[Errno 2] No such file or directory: 'nonexistentfile.txt'

2019-03-27 21:01:58,191 lowermodule - ERROR:[Errno 2] No such file or directory: 'nonexistentfile.txt'

Traceback (most recent call last):

File "/home/emily/logstest/lowermodule.py", line 14, in word_count

with open(myfile, 'r') as f:

FileNotFoundError: [Errno 2] No such file or directory: 'nonexistentfile.txt'

The first line, logged by logger.error(), doesn’t provide much context beyond the error message (“No such file or directory”). The second line shows how adding exc_info=True to logger.error() allows you to capture the exception type (FileNotFoundError) and the traceback, which includes information about the function and line number where this exception was raised.

Alternatively, you can also use logger.exception() to log the exception from an exception handler (such as in an except clause). This automatically captures the same traceback information shown above and sets ERROR as the priority level of the log, without requiring you to explicitly set exc_info to True. Regardless of which method you use to capture the traceback, having the full exception information available in your logs is critical for monitoring and troubleshooting the performance of your applications.

Capturing unhandled exceptions

You’ll never be able to anticipate and handle every possible exception, but you can make sure that you log uncaught exceptions so you can investigate them later on. An unhandled exception occurs outside of a try...except block, or when you don’t include the correct exception type in your except statement. For instance, if your application encounters a TypeError exception, and your except clause only handles a NameError, it will get passed to any remaining try clauses until it encounters the correct exception type.

If it does not, it becomes an unhandled exception, in which case, the interpreter will invoke sys.excepthook(), with three arguments: the exception class, the exception instance, and the traceback. This information usually appears in sys.stderr but if you’ve configured your logger to output to a file, the traceback information won’t get logged there.

You can use Python’s standard traceback library to format the traceback and include it in the log message. Let’s revise our word_count() function so that it tries writing the word count to the file. Since we’ve provided the wrong number of arguments in the write() function, it will raise an exception:

# lowermodule.py

import logging.config

import traceback

logging.config.fileConfig('logging.ini', disable_existing_loggers=False)

logger = logging.getLogger(__name__)

def word_count(myfile):

try:

# count the number of words in a file, myfile, and log the result

with open(myfile, 'r+') as f:

file_data = f.read()

words = file_data.split(" ")

final_word_count = len(words)

logger.info("this file has %d words", final_word_count)

f.write("this file has %d words", final_word_count)

return final_word_count

except OSError as e:

logger.error(e, exc_info=True)

except:

logger.error("uncaught exception: %s", traceback.format_exc())

return False

if __name__ == '__main__':

word_count('myfile.txt')

Running this code will encounter a TypeError exception that doesn’t get handled in the try-except logic. However, since we added the traceback code, it will get logged, thanks to the traceback code included in the second except clause:

# exception doesn't get handled but still gets logged, thanks to our traceback code

2019-03-28 15:22:31,121 lowermodule - ERROR:uncaught exception: Traceback (most recent call last):

File "/home/emily/logstest/lowermodule.py", line 23, in word_count

f.write("this file has %d words", final_word_count)

TypeError: write() takes exactly one argument (2 given)

Logging the full traceback within each handled and unhandled exception provides critical visibility into errors as they occur in real time, so that you can investigate when and why they occurred. Although multi-line exceptions are easy to read, if you are aggregating your logs with an external logging service, you’ll want to convert your logs into JSON to ensure that your multi-line logs get parsed correctly. Next, we’ll show you how to use a library like python-json-logger to log in JSON format.

Unify all your Python logs

So far, we’ve shown you how to configure Python’s built-in logging library, customize the format and severity level of your logs, and capture useful information like the logger name and exception tracebacks. We’ve also used file-based configuration to implement more dynamic log formatting and routing options. Now we can turn our attention to interpreting and analyzing all the data we’re collecting. In this section, we’ll show you how to format logs in JSON, add custom attributes, and centralize and analyze that data with a log management solution to get deeper visibility into application performance, errors, and more.

Streamline your Python log collection and analysis with Datadog.

Log in JSON format

As your systems generate more logs over time, it can quickly become challenging to locate the logs that can help you troubleshoot specific issues—especially when those logs are distributed across multiple servers, services, and files. If you centralize your logs with a log management solution, you’ll always know where to look whenever you need to search and analyze your logs, rather than manually logging into each application server.

Logging in JSON is a best practice when centralizing your logs with a log management service, because machines can easily parse and analyze this standard, structured format. JSON format is also easily customizable to include any attributes you decide to add to each log format, so you won’t need to update your log processing pipelines every time you add or remove an attribute from your log format.

The Python community has developed various libraries that can help you convert your logs into JSON format. For this example, we’ll be using python-json-logger to convert log records into JSON.

First, install it in your environment:

pip install python-json-logger

Now update the logging configuration file (e.g., logging.ini) to customize an existing formatter or add a new formatter that will format logs in JSON ([formatter_json] in the example below). The JSON formatter needs to use the pythonjsonlogger.jsonlogger.JsonFormatter class. In the formatter’s format key, you can specify the attributes you’d like to include in each log record’s JSON object:

[loggers]

keys=root,lowermodule

[handlers]

keys=consoleHandler,fileHandler

[formatters]

keys=simpleFormatter,json

[logger_root]

level=DEBUG

handlers=consoleHandler

[logger_lowermodule]

level=DEBUG

handlers=fileHandler

qualname=lowermodule

[handler_consoleHandler]

class=StreamHandler

level=DEBUG

formatter=simpleFormatter

args=(sys.stdout,)

[handler_fileHandler]

class=FileHandler

level=DEBUG

formatter=json

args=("/home/emily/myapp.log",)

[formatter_json]

class=pythonjsonlogger.jsonlogger.JsonFormatter

format=%(asctime)s %(name)s %(levelname)s %(message)s

[formatter_simpleFormatter]

format=%(asctime)s %(name)s - %(levelname)s:%(message)s

Logs that get sent to the console (with the consoleHandler) will still follow the simpleFormatter format for readability, but logs produced by the lowermodule logger will get written to the myapp.log file in JSON format.

Once you’ve included the pythonjsonlogger.jsonlogger.JsonFormatter class in your logging configuration file, the fileConfig() function should be able to create the JsonFormatter as long as you run the code from an environment where it can import pythonjsonlogger.

If you’re not using file-based configuration, you will need to import the python-json-logger library in your application code, and define a handler and formatter, as described in the documentation:

from pythonjsonlogger import jsonlogger

logger = logging.getLogger()

logHandler = logging.StreamHandler()

formatter = jsonlogger.JsonFormatter()

logHandler.setFormatter(formatter)

logger.addHandler(logHandler)

To see why JSON format is preferable, particularly when it comes to more complex or detailed log records, let’s return to the example of the multi-line exception traceback we logged earlier. It looked something like this:

2019-03-27 21:01:58,191 lowermodule - ERROR:[Errno 2] No such file or directory: 'nonexistentfile.txt'

Traceback (most recent call last):

File "/home/emily/logstest/lowermodule.py", line 14, in word_count

with open(myfile, 'r') as f:

FileNotFoundError: [Errno 2] No such file or directory: 'nonexistentfile.txt'

Although this exception traceback log is easy to read in a file or in the console, if it gets processed by a log management platform, each line may show up as a separate log (unless you configure multiline aggregation rules), which can make it difficult to reconstruct exactly what happened.

Now that we’re logging this exception traceback in JSON, the application will generate a single log that looks like this:

{"asctime": "2019-03-28 17:44:40,202", "name": "lowermodule", "levelname": "ERROR", "message": "[Errno 2] No such file or directory: 'nonexistentfile.txt'", "exc_info": "Traceback (most recent call last):n File "/home/emily/logstest/lowermodule.py", line 19, in word_countn with open(myfile, 'r') as f:nFileNotFoundError: [Errno 2] No such file or directory: 'nonexistentfile.txt'"}

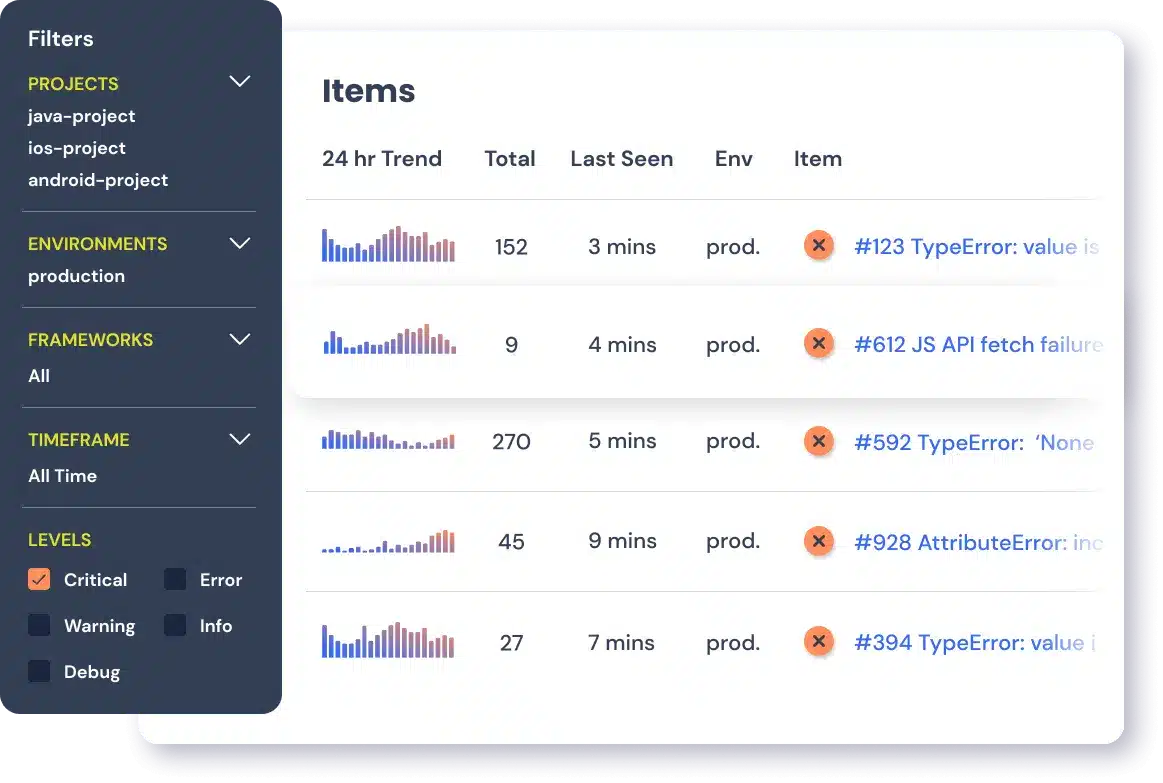

A logging service can easily interpret this JSON log and display the full traceback information (including the exc_info attribute) in an easy-to-read format:

Add custom attributes to your JSON logs

Another benefit of logging in JSON is that you can add attributes that an external log management service can parse and analyze automatically. Earlier we configured the format to include standard attributes like %(asctime)s, %(name)s, %(levelname)s, and %(message)s. You can also log custom attributes by using the python-json-logs “extra” field. Below, we created a new attribute that tracks the duration of this operation:

# lowermodule.py

import logging.config

import traceback

import time

def word_count(myfile):

logger = logging.getLogger(__name__)

logging.fileConfig('logging.ini', disable_existing_loggers=False)

try:

starttime = time.time()

with open(myfile, 'r') as f:

file_data = f.read()

words = file_data.split(" ")

final_word_count = len(words)

endtime = time.time()

duration = endtime - starttime

logger.info("this file has %d words", final_word_count, extra={"run_duration":duration})

return final_word_count

except OSError as e:

[...]

This custom attribute, run_duration, measures the duration of the operation in seconds:

{"asctime": "2019-03-28 18:13:05,061", "name": "lowermodule", "levelname": "INFO", "message": "this file has 44 words", "run_duration": 6.389617919921875e-05}

In a log management solution, this JSON log’s attributes would get parsed into something that looks like the following:

If you’re using a log monitoring platform, you can graph and alert on the run_duration of your application over time. You can also export this graph to a dashboard if you want to visualize it side-by-side with application performance or infrastructure metrics.

Whether you’re using python-json-logger or another library to format your Python logs in JSON, it’s easy to customize your logs to include information that you can analyze with an external log management platform.

Correlate logs with other sources of monitoring data

Once you’re centralizing your Python logs with a monitoring service, you can start exploring them alongside distributed request traces and infrastructure metrics to get deeper visibility into your applications. A service like Datadog can connect logs with metrics and application performance monitoring data to help you see the full picture.