Installation of prerequisite packages

RHEL/CentOS

yum install httpd gcc perl kernel-devel sg3_utils iotop sysstat lsscsi Ensure that the kernel-devel package version matches the installed kernel version To get the kernel-devel package version rpm -qa | grep kernel-devel To get the running kernel version uname -r If the kernel-devel version is ahead of the installed kernel then do the following additional steps yum upgrade kernel reboot yum upgrade kernel-devel

Secure Boot

Secure boot systems are not supported yet. The VTL service will fail to start since the compiled modules are not signed. To check if secure boot is enabled,

grep "Secure boot enabled" /var/log/messages

Secure boot needs to be disabled for the quadstor service to start

QLogic Firmware

The FC target-mode driver has issues with the 8.06 firmware installed by linux-firmware-20170606-56.gitc990aae.el7.noarch on RHEL/CentOS Linux release 7.3.1611 (Core)

The recent 8.07 firmware is recommended which can be got from https://git.kernel.org/pub/scm/linux/kernel/git/firmware/linux-firmware…. .

Firmware can also be updated using the following links

http://www.quadstor.com/vtlnext/firmware.tgz

http://www.quadstor.com/vtlnext/firmware2400.tgz

FIRMWARE UPGRADE PROCEDURE

On the VTL system as root user

1. tar xvzf firmware.tgz (For the qla/qle24xx cards use tar xvzf firmware2400.tgz)

2. sh firmware/copyfirmware.sh

3. Reboot

4. grep «fw=» /var/log/dmesg This should be fw=8.07.00 or greater

SLES 11 SP2 and above

zypper install apache2 gcc perl kernel-default-devel sg3_utils sysstat iotop

Debian 9/10/11

apt-get install uuid-runtime build-essential sg3-utils iotop sysstat lsscsi apache2 psmisc sysstat iotop firmware-qlogic linux-headers-`uname -r` a2enmod cgi (if running cgi-scripts need to be manually enabled)

Run the following chkconfig commands to start httpd/apache2 on system startup

/sbin/chkconfig --add httpd (RHEL/CentOS) /sbin/chkconfig --add apache2 (SLES 11) CentOS 7/8, Debian 9/10/11, SLES 12/15 systemctl enable httpd

Installation/Upgrading of QUADStor on RHEL/CentOS 5.6/5.7, SLES 11 SP1 and Debian squeeze 6.04

- Login to the target system as root

- Uninstall any previous versions of the software

On RHEL/CentOS/SLES sh# rpm -e quadstor.xxxx - where the version can be got by sh# rpm -qa | grep quadstor On Debian systems sh# dpkg -r quadstor-virt (Older versions would require dpkg -r quadstor-itf followed by dpkg -r quadstor-core)

/quadstor/pgdata contains the configuration database of the software. This data is maintained even after an uninstall of the software and is required during upgrades. If this data were to manually removed all previous configuration such as configured storage, VDisk information etc is lost. Refer to http://www.quadstor.com/support/131-recovering-from-a-lost-or-damaged-database.html to recover from a lost or damage database

- Install the packages by running the following commands (in the same order listed)

On RHEL/CentOS/SLES sh# rpm -i quadstor-virt-xxxx.rpm On Debian Systems sh# dpkg -i quadstor-virt-xxxx.deb Older packages would require the following steps instead On RHEL/CentOS/SLES sh# rpm -ivh quadstor-core-xxx.rpm sh# rpm -ivh quadstor-itf-xxx.rpm On Debian Systems sh# dpkg -i quadstor-core-xxx.deb sh# dpkg -i quadstor-itf-xxx.deb

quadstor package installation might fail if the required /lib/modules/<kernel version>/build symlink is missing or is invalid. Usually a kernel upgrade might not create the symlink until a reboot. For example you might get the following error when installing the quadstor-itf package

make -C /lib/modules/2.6.32-279.el6.x86_64/build SUBDIRS=/quadstor/src/export modules make: *** /lib/modules/2.6.32-279.el6.x86_64/build: No such file or directory. Stop. make: *** [default] Error 2 ERROR: Building kernel modules failed!

In such a case reboot the system and try installing the quadstor-itf package again.

cd /lib/modules/2.6.32-279.el6.x86_64/ ln -s ../../../usr/src/kernels/2.6.32-279.el6.x86_64/ build ls -l build (to ensure that you have correctly linked)

In the above example the kernel version is 2.6.32-279.el6.x86_64 which can be got by `uname -r`

Some RHEL/CentOS installs (CentOS 6.3) might not create the build symlink correctly. In such a cases do the following steps

yum ugrade reboot Install quadstor-core if not installed Install quadstor-itf

By default quadstor services are automatically started during system startup.If you wish to start the service manually then run the following command

sh# /sbin/chkconfig --del quadstor

To start the service manually

sh# /etc/rc.d/init.d/quadstor start (On RHEL/CentOS) sh# /etc/init.d/quadstor start (On SLES, Debian)

To stop the service

sh# /etc/rc.d/init.d/quadstor stop (On RHEL/CentOS) sh# /etc/init.d/quadstor stop (On SLES, Debian)

If the system already has other iscsi target software services running, ensure that they are not started on system startup and while starting the quadstor service

After an install and if a reboot was not initiated you will need to manually start the quadstor service. However if after the install the system was rebooted quadstor service would have started automatically

SELinux Considerations

While the package installation and quadstor start script takes care of on SELinux enabled environment the following need to be done if you have SELinux enabled

/usr/sbin/setsebool -P httpd_enable_cgi 1 /usr/sbin/semanage permissive -a httpd_t

On RHEL/CentOS 6.x you need to install policycoreutils-python package (yum install policycoreutils-python) to install semanage utility

Fibre Channel driver installation

A reboot is required to load the new FC driver if LUNs are to be accessed via the FC interface

On SLES 15 «allow_unsupported_modules» needs to be changed from «0» to «1» in /etc/modprobe.d/10-unsupported-modules.conf

Содержание

- Arch Linux

- #1 2018-01-27 13:34:02

- [SOLVED] Boot failure: Failed to start Load Kernel Modules

- #2 2018-01-27 14:50:36

- Re: [SOLVED] Boot failure: Failed to start Load Kernel Modules

- #3 2018-01-27 15:05:49

- Re: [SOLVED] Boot failure: Failed to start Load Kernel Modules

- #4 2018-01-28 09:09:57

- Re: [SOLVED] Boot failure: Failed to start Load Kernel Modules

- #5 2018-01-28 09:15:42

- Re: [SOLVED] Boot failure: Failed to start Load Kernel Modules

- #6 2018-01-28 12:56:52

- Re: [SOLVED] Boot failure: Failed to start Load Kernel Modules

- #7 2018-01-28 16:46:24

- Re: [SOLVED] Boot failure: Failed to start Load Kernel Modules

- Ошибка загрузки службы QUADStor Storage Virtualization после обновления ядра Linux — quadstor.init: Starting quadstor: Failed to insert core module

- После обновления — Failed to Start Load Kernel Modules

- 19 комментариев

- Quadstor error building kernel modules failed

- Дедупликация хранилища резервных копий виртуальных машин oVirt с помощью QUADStor Storage Virtualization на CentOS Linux 7.2

Arch Linux

You are not logged in.

#1 2018-01-27 13:34:02

[SOLVED] Boot failure: Failed to start Load Kernel Modules

I can’t boot my Arch system anymore:

And a bit further:

Then I get a message saying I am in emergency mode and asking for my root password.

Here is the result of the commands suggested:

I tried restarting with systemctl status systemd-modules-load.service but it says the control process exited. For boot-efi.mount, it just says mount failed. I notice that many modules must be missing. For example I don’t even see my wireless interface.

The only thing I can think of that could have caused this is that I created a package, and then installed it with pacman -U —force. I did this because I had previously installed that software from source without creating a package and wanted a «cleaner» install of it. I guess I was wrong, or I screwed up the package creation part.

Can anyone help me troubleshoot this?

Last edited by eichan (2018-01-28 17:58:38)

#2 2018-01-27 14:50:36

Re: [SOLVED] Boot failure: Failed to start Load Kernel Modules

Which package was it you created and forced the install? Post the package build please.

All men have stood for freedom.

For freedom is the man that will turn the world upside down.

Gerrard Winstanley.

#3 2018-01-27 15:05:49

Re: [SOLVED] Boot failure: Failed to start Load Kernel Modules

What you’re seeing usually happens when you’re booting the wrong kernel, such as when /boot wasn’t mounted when you updated the system. Check uname -r vs pacman -Q

#4 2018-01-28 09:09:57

Re: [SOLVED] Boot failure: Failed to start Load Kernel Modules

The package I was trying to build is libindi_3rdparty, which is a set of drivers for the INDI library (for astronomical devices such as mounts or CCD cameras). This package exists in the AUR but it’s an outdated version, and the source downloaded from the author’s Github page is missing a file (log4z.h) in the indi-qhy folder. This is the reason my PKGBUILD (see here) is pointing at a local source. That tarball on my local drive is just the exact same source as found on Github, just with the added log4z.h file in the right folder. makepkg and pacman -U pkg.tar.gz seemed happy with it. I uninstalled the package as root under the emergency environment provided by the failed boot, and it didn’t change anything.

As for uname -a vs paman -Qi linux, both commands give me the same version number (4.14.15-1). Trying the fallback kernel on the grub menu doesn’t help. Exact same problem.

#5 2018-01-28 09:15:42

Re: [SOLVED] Boot failure: Failed to start Load Kernel Modules

I’ll just add to this a photo taken of my screen as it fails its boot session. Sorry it’s an image file. The emergency environment doesn’t know anything about my wifi adapter (does not appear with ‘ip link’), so it’s a bit challenging to share some results and logs.

#6 2018-01-28 12:56:52

Re: [SOLVED] Boot failure: Failed to start Load Kernel Modules

1. What is your bootloader? Could you please post the bootloader configuration related to you Arch install?

2. Please provide the outputs of `lsblk` and `cat /etc/fstab`.

3. Does reinstalling the kernel and/or bootloader help with the issue? (of course after uninstalling libindi_3rdparty)

#7 2018-01-28 16:46:24

Re: [SOLVED] Boot failure: Failed to start Load Kernel Modules

1. I use grub. Here is grub.cfg.

EDIT: p1 is the /boot partition, p2 is some Windows obscure partition, p3 is my Windows partition and p4 the Arch one. I don’t have swap.

3. ‘pacman -S linux’ exits with an error:

I thought grub wasn’t related because it still works in the sense that it tries to run Arch and it runs Windows without a problem. And its installation is the trickiest. Do you confirm, after seeing the above, that it would be useful to try reinstalling it?

EDIT: Unsure if that’s relevant but I should inform that I’m running all those commands as root, from the emergency mode.

Last edited by eichan (2018-01-28 16:53:52)

Источник

Ошибка загрузки службы QUADStor Storage Virtualization после обновления ядра Linux — quadstor.init: Starting quadstor: Failed to insert core module

Беглый поиск по тексту ошибки во время запуска службы привёл к чек-листу по другому продукту проекта QUADStor — Virtual Tape Library (VTL) — Troubleshooting common problems , где при возникновении аналогичной проблемы предлагается использовать утилиту builditf. Несмотря на то, что речь в документе идёт о QUADStor VTL, такая утилита имеется и в составе QUADStor Storage Virtualization:

Стало очевидно, что в моём случае проблема с запуском службы связана с тем, что в загрузочном образе для initrd (Initial RAM Disk), который был обновлён в вместе с установкой нового ядра Linux не хватает модулей, необходимых для работы ПО QUADStor. И чтобы исправить эту проблему, достаточно с правами root запустить на нашем сервере ранее упомянутую утилиту:

Источник

После обновления — Failed to Start Load Kernel Modules

В VirtualBox установлен Manjaro JWM 17.1. Вчера обновил систему, в том числе были обновления ядра, обновилась нормально, сделал перезагрузку и в итоге она не запускается, доходит до надписи «Загружается начальный виртуальный диск» и далее «Во время работы виртуальной машины произошла критическая ошибка.» На этом всё и заканчивается. Как можно восстановить систему?

19 комментариев

Загрузился с образа, затем

Затем с помощью Pacli сдаунгрейдил пакеты до linux 4.14.9.1 и linux-header 4.14.9.1.

Теперь уже грузится дальше, но впадает в цикл.

Welcome to Manjaro JWM Community Edition!

>

└──┤ journalctl -D /mnt/var/log/journal -xe

Jan 13 09:22:29 lapa-pc systemd[1]: Stopping LVM2 metadata daemon…

— Subject: Unit lvm2-lvmetad.service has begun shutting down

— Defined-By: systemd

— Support: lists.freedesktop.org/mailman/listinfo/systemd-devel

—

— Unit lvm2-lvmetad.service has begun shutting down.

Jan 13 09:22:29 lapa-pc systemd[1]: Stopped LVM2 metadata daemon.

— Subject: Unit lvm2-lvmetad.service has finished shutting down

— Defined-By: systemd

— Support: lists.freedesktop.org/mailman/listinfo/systemd-devel

—

— Unit lvm2-lvmetad.service has finished shutting down.

Jan 13 09:22:29 lapa-pc systemd[1]: Shutting down.

Jan 13 09:22:29 lapa-pc kernel: systemd-shutdow: 31 output lines suppressed due

Jan 13 09:22:29 lapa-pc systemd-shutdown[1]: Syncing filesystems and block devic

Jan 13 09:22:29 lapa-pc systemd-shutdown[1]: Sending SIGTERM to remaining proces

Jan 13 09:22:29 lapa-pc systemd-journald[166]: Journal stopped

— Subject: The journal has been stopped

— Defined-By: systemd

— Support: lists.freedesktop.org/mailman/listinfo/systemd-devel

—

— The system journal process has shut down and closed all currently

— active journal files.

lines 2737-2759/2759 (END)

Jan 13 09:22:29 lapa-pc systemd[1]: Stopping LVM2 metadata daemon…

— Subject: Unit lvm2-lvmetad.service has begun shutting down

— Defined-By: systemd

— Support: lists.freedesktop.org/mailman/listinfo/systemd-devel

—

— Unit lvm2-lvmetad.service has begun shutting down.

Jan 13 09:22:29 lapa-pc systemd[1]: Stopped LVM2 metadata daemon.

— Subject: Unit lvm2-lvmetad.service has finished shutting down

— Defined-By: systemd

— Support: lists.freedesktop.org/mailman/listinfo/systemd-devel

—

— Unit lvm2-lvmetad.service has finished shutting down.

Jan 13 09:22:29 lapa-pc systemd[1]: Shutting down.

Jan 13 09:22:29 lapa-pc kernel: systemd-shutdow: 31 output lines suppressed due to ratelimiting

Jan 13 09:22:29 lapa-pc systemd-shutdown[1]: Syncing filesystems and block devices.

Jan 13 09:22:29 lapa-pc systemd-shutdown[1]: Sending SIGTERM to remaining processes…

Jan 13 09:22:29 lapa-pc systemd-journald[166]: Journal stopped

— Subject: The journal has been stopped

— Defined-By: systemd

— Support: lists.freedesktop.org/mailman/listinfo/systemd-devel

—

— The system journal process has shut down and closed all currently

— active journal files.

Хорошо. Вспоминайте, какие модули ядра ставили. Как и откуда.

сделайте.

И, да, на всякий случай: при переходе в tty приглашения нет?

Всё устанавливалось через Pacli, никаких сторонних репозиториев не подключено.

И, да, на всякий случай: при переходе в tty приглашения нет?

Если имеется ввиду Alt+F3 во время цикла, то приглашение есть, но времени набрать пароль не хватает.

Да вроде бы не в это время. А так да, пережил уже 2 подобных инцидента после обновлений, причиной которых были проблемы с glibc. Удавалось починить. А в этот раз намертво. Остаётся ждать, может следующее обновление починит сломанное.

Источник

Quadstor error building kernel modules failed

1. When accessing the HTML UI any of the following messages are displayed

«ERROR: Getting configured storage list failed»

«ERROR: Getting pool list failed»

The above errors indicate that the mdaemon server isn’t running. This indicates that the quadstorvtl service did not start or failed to start.

Check for the VTL service status

If the status is «QUADStor VTL daemon is stopped», the VTL service failed to start. Try starting the VTL service manually by the following command

Starting the quadstorvtl service fails with the error message «Cannot start database»

The above error can occur to due a failed upgrade or due to a previous system crash or due to lack of free space in the filesystem where /quadstorvtl/ resided. If due to a previous system crash then restarting the quadstorvtl service will fix this problem. If due to a failed upgrade, reboot the system and then retry the upgrade

3. On Linux starting the quadstorvtl service fails with the error message «Failed to insert core module»

The above error can occur if /quadstorvtl/bin/builditf was not run or failed to complete successfully. Possible reason could be that there is a mismatch between the kernel-devel package (CentOS/RHEL/SuSE) or the linux-headers package (Debian) and the running kernel version. Upgrading the kernel and the kernel-devel/linux-headers pacakge followed by a reboot should fix this error. If the error persists please send /quadstorvtl/tmp/build.log to vtlsupport@quadstor.com

4. On CentOS 8 if the service fails to start try with SELINUX permissive instead of enforcing in /etc/selinux/config. Restart the system after changing to SELINUX=permissive

Источник

Дедупликация хранилища резервных копий виртуальных машин oVirt с помощью QUADStor Storage Virtualization на CentOS Linux 7.2

В моём случае для хранения резервных копий виртуальных машин в oVirt на файловом сервере с CentOS Linux ранее был создан программный RAID средствами mdadm из дисковых multipath-устройств. В этой заметке поверх уже существующего программного RAID-массива /dev/md0 будет создан виртуальный диск QUADStor, поверх которого, в свою очередь, будет создан раздел ext4 и экспортирован через NFS серверу управления oVirt для дальнейшего использования в качестве ISO Domain (для хранения ISO-образов) и Export Domain (для хранения резервных копий ВМ). Для создаваемого виртуального диска QUADStor будет задействован механизм программной дедупликации, которая позволит реализовать существенную экономию дискового пространства и увеличить количество хранимых резервных копий ВМ.

Основной набор документации можно найти по ссылке Storage Virtualization Documentation . Некоторую дополнительную информацию можно найти здесь: Tech Library . Если при внедрении QUADStor вы столкнётесь с проблемами, то вопросы можно задавать в Google-группе QUADStor Storage Virtualization .

С системными требованиями можно ознакомится на странице System Requirements , где, в частности, есть такая фраза:

The recommendation is to add an additional 2 GB of memory for every 1 TB of storage configured or every 4 VDisks created or for every 2 physical disks configured

В моём случае планируется использовать дисковую ёмкость размером не более 4TB. Поэтому исходя из требования, что самой системе минимум требуется 4GB ОЗУ (8GB если планируется использовать функции NAS, то есть, если я правильно понимаю, речь идёт про iSCSI) + рекомендация добавлять по 2GB ОЗУ на каждый 1TB хранилища (в моём случае планируется 4TB), получается 12GB или 16GB ОЗУ, в зависимости от того, буду ли я использовать функционал NAS. В моём файловом сервере предустановлено 16GB ОЗУ, поэтому будем считать, что в требования я вписываюсь.

Установка QUADStor

Порядок установки QUADStor на разные дистрибутивы Linux описан в документе Installation/Upgrading on RHEL/CentOS 5.x, 6.x, SLES 11 and Debian 6.x, 7.x . Я буду предпринимать последовательность действий исходя из того что установка выполняется на CentOS Linux 7.2.

Устанавливаем предварительно требуемые пакеты:

Проверим версию установленного пакета kernel-devel:

И сравним эту версию с версией рабочего ядра системы:

Версии должны совпадать. Если версии не совпадают, то необходимо выполнить сначала обновление ядра, заем выполнить перезагрузку системы, а после выполнить обновление пакета kernel-devel:

В конечном итоге мы должны получить совпадающие версии ядра и пакета kernel-devel.

Теперь переходим к установке QUADStor Storage Virtualization. Если ранее была установлена предыдущая версия, то перед установкой новой версии потребуется удалить старую версию. При этом все метаданные, необходимые для работы уже сконфигурированных виртуальных дисков QUADStor останутся на дисках участвующих в дисковом пуле QUADStor. После установки новой версии эти метаданные должны будут автоматически интерпретированы управляемым кодом QUADStor.

Для того, чтобы корректно удалить старую версию QUADStor, отключаем службу (разумеется перед отключением службы quadstor необходимо отключить в системе все ссылки на разделы находящиеся по управлением quadstor) с последующей перезагрузкой системы:

Затем определяем текущую версию пакета и выполняем его удаление. После успешного удаления лучше ещё раз перезагрузить систему и убедиться в том, что она успешно запускается:

Теперь скачиваем и устанавливаем основной пакет QUADStor Storage Virtualization (ссылку на актуальную версию пакета берём здесь: Storage virtualization downloads ):

Установка пакета должна завершиться без ошибок.

Сразу после установки служба quadstor не будет запущена, но при этом в процессе установки эта служба должна быть автоматически прописана в автозагрузку при старте системы.

Настроим автозагрузку веб-сервера Apache, если это ещё не было сделано ранее, так как он нам понадобиться для управления QUADStor:

После этого ещё раз перезагружаем сервер и убеждаемся в том, что после загрузки системы обе службы успешно автоматически стартуют:

Если службы успешно запущены, можем переходить к дополнительной настройке веб-сервера.

Базовая настройка веб-сервера

Включим в firewalld разрешающее правило для подключения к веб-серверу, чтобы у нас была возможность подключиться к нему удалённо:

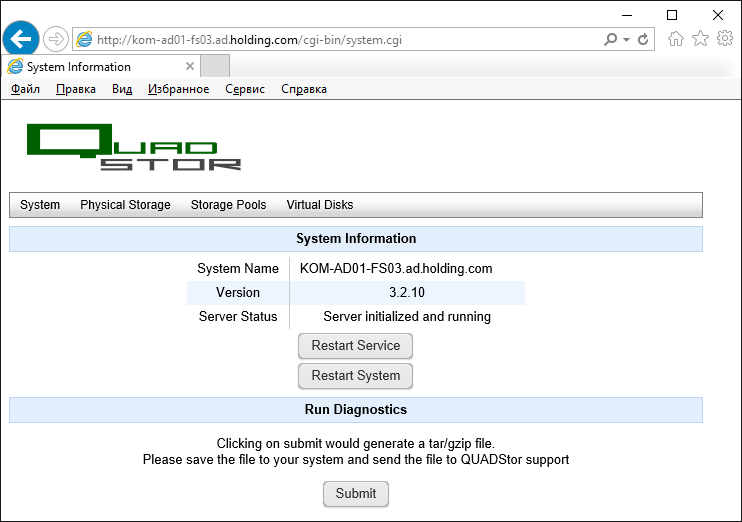

Проверяем доступ к веб-интерфейсу пройдя по ссылке http:// <сервер>. Веб-сервер должен будет перенаправить нас по ссылке http://<сервер>/cgi-bin/system.cgi

Как видим, мы без каких-либо запросов аутентификации получаем полный доступ к веб-консоли управления QUADStor, поэтому первоочередной задачей для нас станет настройка ограничения доступа к этой веб-консоли.

На данном этапе мы произведём лишь простейшее базовое ограничение доступа в соответствии с рекомендациями статьи Accessing the Web Management Interface .

Ограничим доступ к веб-интерфейсу с помощью файла .htaccess, который создадим в каталоге cgi-bin (в этом каталоге расположены исполняемые файлы QUADStor, которые используются при работе веб-консоли):

Наполним файл содержимым (включим Basic-аутентификацию и укажем пусть к файлу с учётными данными для проверки):

Сгенерируем файл .htpasswd с именем пользователя и паролем, которые мы используем для ограничения доступа к веб-сайту QUADStor:

Исправим конфигурационный файл веб-сервера /etc/httpd/conf/httpd.conf . Найдём в нём блок описания доступа к подкаталогу /var/www/cgi-bin :

Изменим этот блок, добавив параметры вызова аутентификации

Для вступления изменений в силу перезагрузим службу веб-сервера (перезапуск службы должен происходить без ошибок):

Разумеется, выполненная настройка веб-сервера не является правильной с точки зрения безопасности, а позволяет лишь базово ограничить доступ к веб-консоли QUADStor на первоначальном этапе настройки. Позже, в отдельной заметке мы изменим настройки веб-сервера таким образом, чтобы можно было использовать доменную аутентификацию в связке с SSSD и защитим HTTP соединения с веб-консолью QUADStor с помощью SSL-сертификата.

Конфигурация дисковой подсистемы QUADStor

Базово настройка дисковой подсистемы QUADStor состоит в том, чтобы создать пул хранения (Storage Pool), включить в этот пул дисковые устройства (Physical Storage), после чего пул можно будет использовать для создания виртуального диска (Virtual Disk).

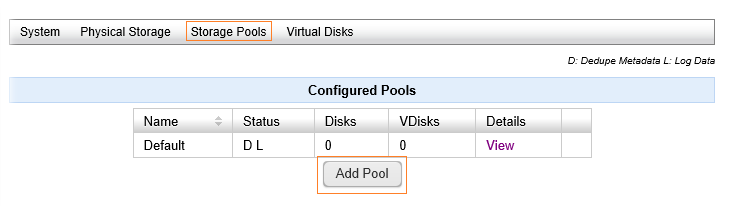

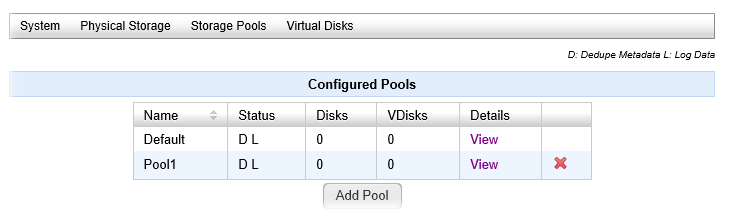

Создаём Storage Pool

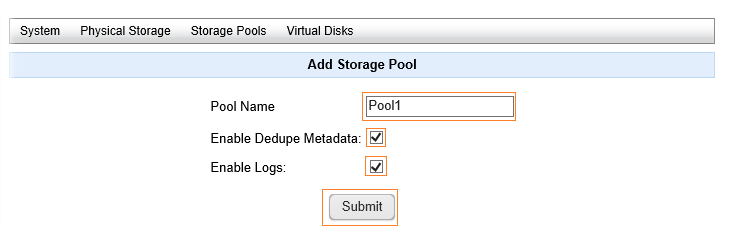

Информацию о такой сущности, как Storage Pool, можно найти в документе Configuring Storage Pools . По умолчанию в QUADStor уже создан пул Default. Это служебный пул, изменить или удалить который нельзя. Как я понял, пул выступает в качестве границы определения общности физических устройств, для которых будет использоваться единая база метаданных, используемых для механизма дедупликации. При этом пул Default способен хранить на своих дисках метаданные дедупликации из прочих пулов. То есть пул Default, на мой взгляд, можно расценивать как некий служебный пул, поэтому я не трогаю этот пул, а создаю отдельный. Для этого переходим по ссылке Storage Pools и под таблицей пулов используем кнопку Add Pool

Указываем имя пула, включаем признак того, что данный пул будет содержать собственный набор метаданных (Dedupe Metadata и Logs) и жмём Submit

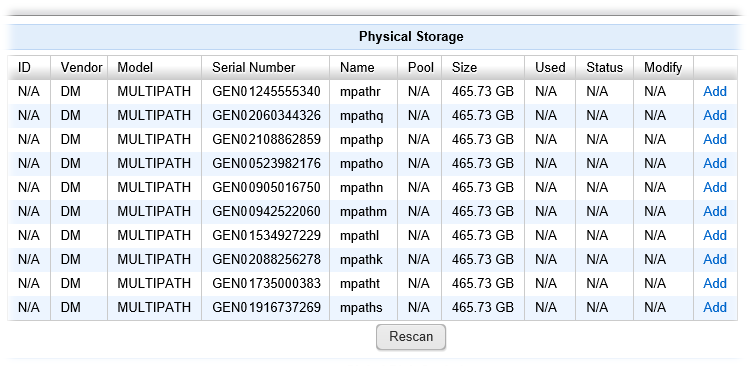

Добавляем Physical Storage в Storage Pool

Физически диски определяются путём сканирования вывода /proc/scsi/scsi , также поддерживаются виртуальные устройства software raid на базе mdadm. При этом недоступны будут диски с существующими смонтированными разделами, а также диски размером менее 4GB. Поддерживается также использование томов ZFS ZVOL (подробней об этом в документе Configuring Physical Storage ). Доступные для использования в пулах QUADStor дисковые устройства можно увидеть пройдя по ссылке Physical Storage.

В моём случае, меня не очень приятно удивил тот факт, что я увидел в списке доступных устройств диски, из которых был собран мой программный RAID. При этом диски отображаются, как отдельные multipath-устройства.

Самого же RAID устройства /dev/md0 в списке я не видел, но это вполне закономерно, так как на нём в этот момент ещё присутствовал смонтированный в системе раздел ext4. Мне стало интересно, как поведёт себя QUADStor, если я попытаюсь добавить перечисленные multipath-устройства в созданный ранее пул. В общем, не смотря на то, что на этих дисках был расположен смонтированный раздел ext4 поверх md0 , веб-консоль QUADStor «не моргнув глазом» дала включить эти диски в пул и затем даже создать виртуальный диск на базе этого пула. А на виртуальном диске я уже смог бы создать новый раздел ext4, уничтожив тем самым раздел на ext4 поверх md0 (конечно при условии что первичный раздел предварительно был бы отмонтирован). Доводить этот безобразный эксперимент до конца я конечно не стал, а просто сделал вывод о том, что нужно очень внимательно относиться к тому, что нам предлагает вкладка Physical Storage, чтобы не наделать себе проблем. Ну и разумеется, включая диски в пул, нужно понимать, что все данные, которые есть на этих дисках будут в конечном итоге потеряны.

Итак, чтобы получить возможность использования своего программного RAID диска md0 , я удалил из системы все ссылки на раздел ext4, используемый в моём случае на устройстве /dev/md0 , в частности отключил NFS шары, расположенные на этом разделе с последующим перезапуском конфигурации nfs-сервера. Затем нужно не забыть выполнить отсоединение раздела от точки монтирования:

Затем в /etc/fstab закомментировать строчку монтирования раздела /mnt/mdadm-vv1/ при загрузке. В общем нужно провести все мероприятия, необходимые для «освобождения» интересующего нас дискового устройства, которое мы хотим использовать для включения в пул QUADStor.

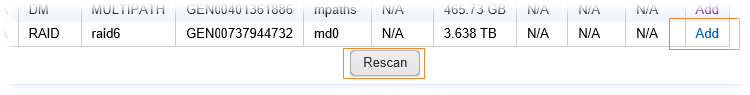

После этого возвращаемся в веб-консоль QUADStor на вкладке Physical Storage жмём Rescan и видим что RAID-устройство md0 появилось в списке доступных. Щёлкаем по ссылке Add, чтобы добавить это устройство в созданный ранее пул Pool1

Важное примечание: Перед созданием пула из нескольких физических устройств стоит подумать о том, какой диск будет добавляться в пул первым, так как именно этот диск будет в пуле будет иметь роль master-диска, то есть будет использоваться для хранения метаданных дедупликации и логирования всего пула. Более того, после создания пула из нескольких дисков, удалить из пула master-диск, то есть диск, который был добавлен первым, нельзя будет до тех пор, пока из пула не удалены все другие диски, то есть диск добавляемый первым может быть в последующем удалён из пула только последним. Исходя из этого, первый диск в пуле должен быть самым быстрым среди прочих других дисков пула, так как на него ляжет нагрузка работы с метаданными всего пула.

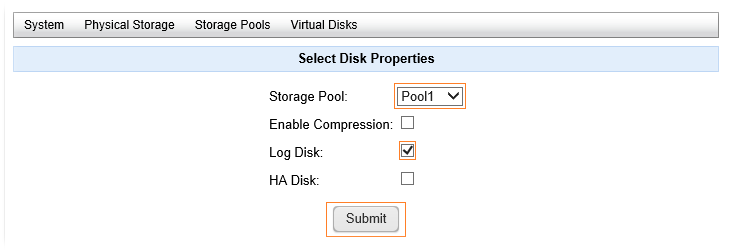

В списке пулов выбираем созданный нами ранее пул Pool1

Компрессию (онлайн компрессия при записи на диск) использовать я не буду, так как эта опция имеет смысл лишь на быстрых SSD дисках, а в моём случае mdraid построен на базе медленных дисков, и поэтому включение данной опции может привести к деградации производительности.

Опцию логирования включаем, так как в созданном мной пуле будет всего одно физическое устройство и поэтому логирование будет выполняться на этом устройстве.

Включать опцию HA Disk в моём случае тоже смысла нет, так как эта опция используется в случае если диск планируется использовать в качестве quorum-диска при построении высоко-доступных конфигураций QUADStor.

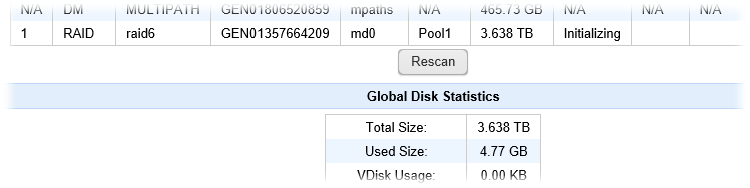

После нажатия кнопки Submit дисковое устройство изменит свой статус на Initializing

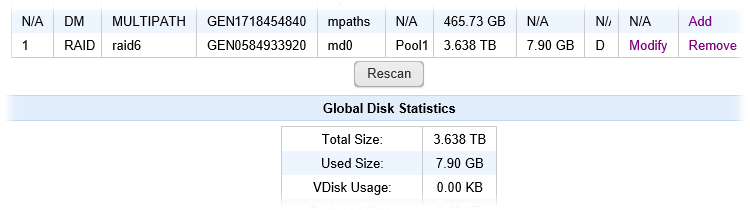

Дождёмся, завершения инициализации дискового устройства. Так как в моём случае с устройства md0 не был удалён созданный там ранее раздел ext4 c данными, то время ожидания затянулось примерно на 15 минут:

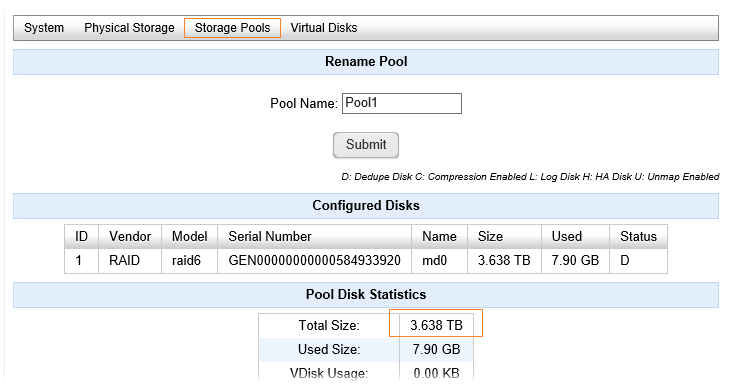

Теперь наш пул содержит физическое устройство и мы можем переходить к созданию виртуального диска с использованием этого пула.

Создаём виртуальный диск VDisk

Подробную информацию о создании и управлении виртуальными дисками можно найти в документе Creating and Managing Virtual Disks (VDisks) .

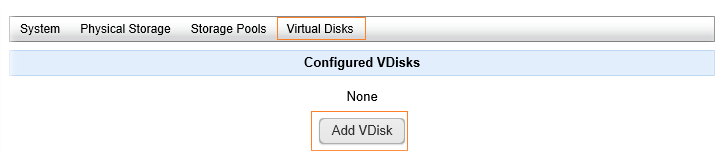

Чтобы создать виртуальный диск, переходим по ссылке Virtual Disks и жмём кнопку Add VDisk

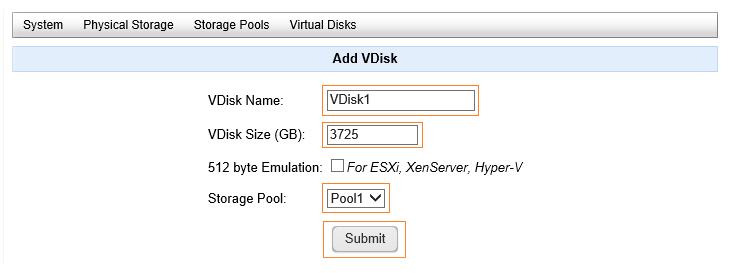

Зададим произвольное имя диска VDisk Name и укажем его размер VDisk Size в GB. Максимально допустимое значение размера виртуального диска – 64 TB (65536 GB). По своей сути виртуальный диск представляет собой динамически расширяемый Thin-диск и поэтому размер виртуального диска можно указывать больше, чем размер физических дисков пула. Не смотря на это я постараюсь указать размер виртуального диска сопоставимый с реальным размером пула, то есть в нашем случае – реальным размером дискового raid-устройства md0 . Для того, чтобы выяснить текущий размер пула можно заглянуть в свойства пула Storage Pools > выбираем в списке пул и переходим по ссылке View:

Можем взять значение, указанное в Total Size и умножить его на 1024. В моём случае получится

Кстати виртуальный диск QUADStor после создания, при необходимости, может быть как увеличен так и уменьшен (см.часть Resizing a VDisk ). Если с увеличением какое-то логическое объяснение найти можно, то вопрос о том, какие есть требования для возможности уменьшения с техническими подробностями процесса, остался открытым, так как этой информации я нигде найти не смог.

Опция 512 byte Emulation используется в том случае, если нужно чтобы размер сектора на создаваемом виртуальном диске был 512 байт вместо используемых по умолчанию 4096 байт. Как я понял из документа Creating and Managing Virtual Disks (VDisks) , эту опцию рекомендуется включать в случае если виртуальный диск будет использоваться в качестве рабочего хранилища для виртуальных машин. В нашем случае виртуальный диск будет использован под хранение резервных копий, поэтому эффективней будет использовать значение по умолчанию в 4КБ.

В списке пулов соответственно выбираем созданный ранее Storage Pool и жмём Submit

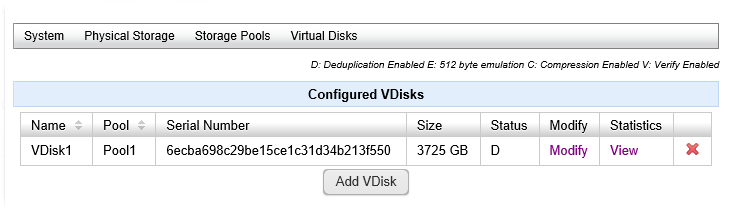

После этого в списке сконфигурированных виртуальных дисков появится новая позиция со ссылками Modify и View

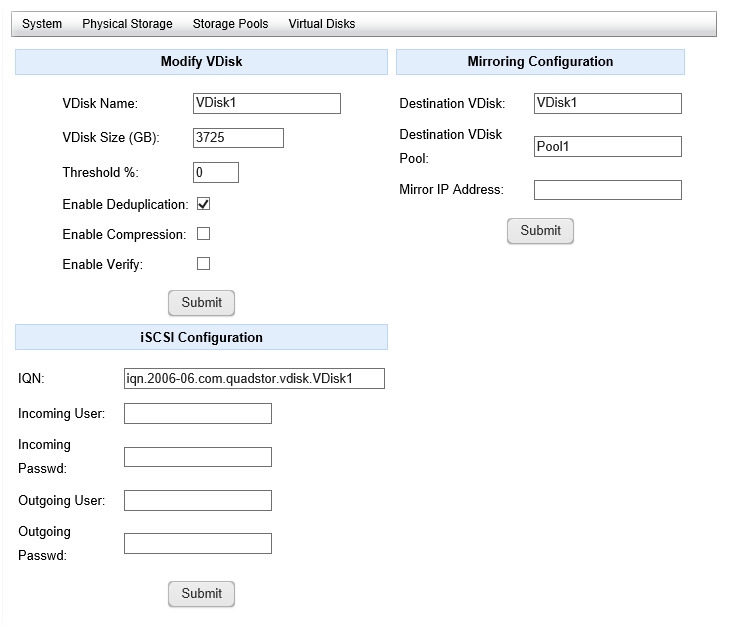

По ссылке Modify мы сможем изменять размер виртуального диска, изменять опции дедупликации и компрессии, настраивать зеркалирование диска (подробнее в документах Tutorial: Configuring high availability with synchronous mirroring и High Availability with Synchronous Mirroring ), а также настраивать конфигурацию экспорта ёмкости диска по протоколу iSCSI.

Создаём раздел на виртуальном диске VDisk

Возможные способы доступа к виртуальному диску перечислены в документе Accessing Virtual Disks (VDisks) . В рамках нашей задачи я выбираю локальный доступ к устройству, который можно получить обратившись в каталог /dev/quadstor/ :

Как видим, после создания виртуального диска в системе появилось одноимённое устройство /dev/quadstor/VDisk1 , которое является ссылкой на блочное устройство, в нашем случае это диск /dev/sdu с ранее упоминавшимся размером сектора в 4KB

Создадим файловую систему (в нашем случае это будет ext4) на виртуальном диске, затем создадим каталог, в который будем монтировать созданный раздел и, наконец, смонтируем этот раздел:

Затем пропишем в fstab информацию для автоматического монтирования раздела в точку монтирования /mnt/quadstor-vv1 в процессе загрузки системы в соответствии с рекомендациями документа Automounting a filesystem created on a VDisk . Добавим информацию о монтировании в конец файла /etc/fstab

После этого перезагружаем сервер и убеждаемся в том, что конечный результат достигнут и раздел автоматически монтируется в точку монтирования /mnt/quadstor-vv1 .

Пробуем создать новый пустой файл в смонтированном в каталог разделе, проверяя тем самым возможность записи в этот каталог:

Теперь наш раздел ext4 расположенный на виртуальном диске готов к работе. Можно запускать раздел в работу. В моём случае на данном разделе было создано несколько NFS-шар, которые были подключены к oVirt в качестве ISO Domain и Export Domain.

Проверяем результат дедупликации

Через некоторое время после начала использования раздела с дедупликацией я сравнил по логам, которые создаёт скрипт резервного копирования ВМ (в моём случае речь идёт о ежедневном резервном копировании 6 виртуальных машин) и с удивлением обнаружил, что время выполнения резервного копирования не только не увеличилось, но даже немного уменьшилось. Ниже приведены выжимки из лога. Первый блок показывает нынешнее время выполнения резервного копирования из последнего лог-файла (используется раздел ext4 поверх виртуального диска /dev/quadstor/VDisk1 , который в свою очередь работает поверх программного RAID-массива /dev/md0 ), а второй блок показывает время выполнения в один из предыдущих дней, когда файловые операции выполнялись на разделе ext4 сразу поверх /dev/md0

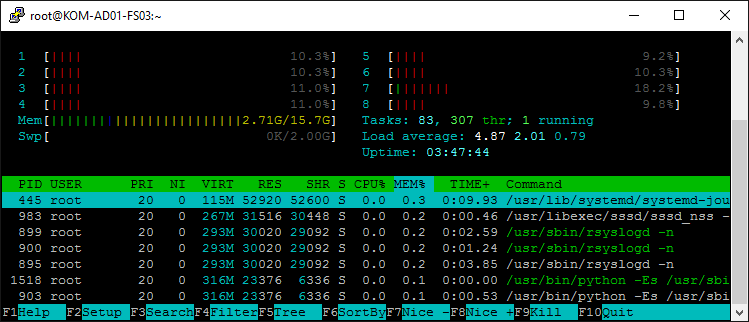

Поначалу я не поверил своим глазам и прошёлся по всем старым логам, после чего окончательно убедился в том, что с даже с учётом онлайн-дедупликации виртуальный диск QUADStor справляется с поставленной в моём случае задачей вполне достойно. И это не может не радовать. К тому же, в процессе резервного копирования, на той стадии, когда идёт переноса клонов виртуальных машин в oVirt Export Domain, то есть когда непосредственно выполняется запись на виртуальный диск QUADStor с включённой дедупликацией, я в режиме реального времени понаблюдал за нагрузкой на процессор и память на файловом сервере, и также был приятно удивлён тем, что никаких экстраординарных нагрузок при этом на систему не было обнаружено:

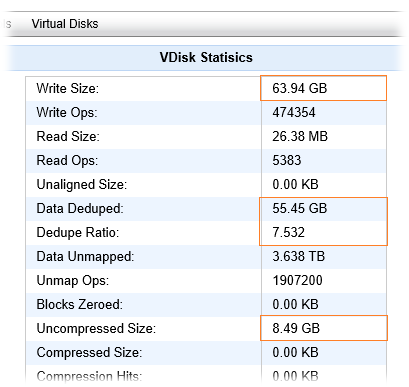

После нескольких дней с ежедневно выполняемой процедурой резервного копирования, я заглянул в статистику использования дискового пространства в свойствах виртуального диска в веб-консоли QUADStor и обнаружил такую картину:

То есть, за прошедший период времени на виртуальный диск было записано около 63.94GB данных, которые на текущий момент занимают 8.49GB физической дисковой ёмкости, а 55.45GB — это сэкономленное с помощью дедупликации место. По моему, выглядит вполне интересно. Теперь можно смело увеличивать количество дней хранения резервных копий виртуальных машин.

Если посмотреть на виртуальный диск QUADStor на уровне всевозможных утилит, которые показывают информацию о размерах разделов, то можно «словить конфуз», как было со мной :

Мы увидим то, что занятое место на разделе смонтированном на виртуальном диске, отображается примерно схожим с размером записанных на него данных, то есть как бы без учёта дедупликации. Как я понял, фактически это не так и для того, чтобы получить объективную картину по объёму занятого места на виртуальном диске QUADStor, нужно использовать только интерфейсы, которые предоставляет это ПО. Учитывая данное обстоятельство, для меня пока открытым остается вопрос автоматического мониторинга занимаемого места на диске QUADStor. Возможно к этому вопросу я вернуть позже, когда руки дойдут до развёртывания и эксплуатации какой-то из открытых систем для мониторинга Linux-серверов.

Дополнительные источники информации:

Источник

В очередной раз устанавливая обновления на сервер с ранее настроенной программной дедупликацией на базе QUADStor Storage Virtualization словил проблему со службой quadstor.service, которая отказалась стартовать после перезагрузки сервера. Подозрение сразу пало на только что установленную обновлённую версию ядра.

# systemctl status quadstor.service

● quadstor.service - QUADStor Storage Virtualization

Loaded: loaded (/usr/lib/systemd/system/quadstor.service; enabled; vendor preset: disabled)

Active: failed (Result: exit-code) since Tue 2016-11-22 22:58:20 MSK; 9h ago

Process: 22074 ExecStart=/quadstor/etc/quadstor.init start (code=exited, status=1/FAILURE)

Nov 22 22:58:13 KOM-AD01-FS03 systemd[1]: Starting QUADStor Storage Virtualization...

Nov 22 22:58:14 KOM-AD01-FS03 quadstor.init[22074]: Starting quadstor: Failed to insert core module

Nov 22 22:58:20 KOM-AD01-FS03 quadstor.init[22074]: Stopping quadstor:

Nov 22 22:58:20 KOM-AD01-FS03 systemd[1]: quadstor.service: control process exited, code=exited status=1

Nov 22 22:58:20 KOM-AD01-FS03 systemd[1]: Failed to start QUADStor Storage Virtualization.

Nov 22 22:58:20 KOM-AD01-FS03 systemd[1]: Unit quadstor.service entered failed state.

Nov 22 22:58:20 KOM-AD01-FS03 systemd[1]: quadstor.service failed.

Беглый поиск по тексту ошибки во время запуска службы привёл к чек-листу по другому продукту проекта QUADStor — Virtual Tape Library (VTL) — Troubleshooting common problems, где при возникновении аналогичной проблемы предлагается использовать утилиту builditf. Несмотря на то, что речь в документе идёт о QUADStor VTL, такая утилита имеется и в составе QUADStor Storage Virtualization:

# locate builditf

/quadstor/bin/builditf

Стало очевидно, что в моём случае проблема с запуском службы связана с тем, что в загрузочном образе для initrd (Initial RAM Disk), который был обновлён в вместе с установкой нового ядра Linux не хватает модулей, необходимых для работы ПО QUADStor. И чтобы исправить эту проблему, достаточно с правами root запустить на нашем сервере ранее упомянутую утилиту:

# /quadstor/bin/builditf

В ходе выполнения этой команды будет пересобран загрузочный образ initrd с включением в него всех модулей, необходимых для работы QUADStor. После завершения работы команды перезагружаем сервер и проверяем состояние службы quadstor.service, которая должна быть успешно запущена.

Метки :

Boot , builditf , CentOS , CentOS 7 , File Server , Free software , Init , Kernel , Linux , Open Source , QUADStor , Storage , Storage Virtualization , Update , Virtualization , VTL

Daniel Escalona

unread,

Oct 1, 2016, 5:24:17 PM10/1/16

to QUADStor VTL

Hello guys,

I just want to know if I can install QUADStor VTL on this version of Ubuntu. Everytime I install it, I get «Building kernel modules failed!!!» Let me know. Thanks!

This is a staff email account managed by Ramsey Public Schools. This email and any files transmitted with it are confidential and intended solely for the use of the individual or entity to whom they are addressed. If you have received this email in error please notify the sender.

QUADStor VTL Support

unread,

Oct 1, 2016, 5:25:49 PM10/1/16

to quadstor-vtl

The VTL software will install on Ubuntu 14.x. 16.x isn’t yet supported

> —

> You received this message because you are subscribed to the Google Groups

> «QUADStor VTL» group.

> To unsubscribe from this group and stop receiving emails from it, send an

> email to quadstor-vtl…@googlegroups.com.

> For more options, visit https://groups.google.com/d/optout.

Daniel Escalona

unread,

Oct 2, 2016, 8:45:13 PM10/2/16

to QUADStor VTL

Daniel Escalona

unread,

Oct 2, 2016, 8:45:13 PM10/2/16

to QUADStor VTL

Thank you for the reply. But when I tried it on Ubuntu Server 14.04 I get…

/var/lib/dpkg/info/quadstor-vtl-ext.postinst: 18: /var/lib/dpkg/info/quadstor-vtl-ext.postinst: systemctl: not found

Building required kernel modules

Running /quadstorvtl/bin/builditf. This may take a few minutes.

ERROR: Building kernel modules failed!!!

Let me know. Thank you guys!

On Saturday, October 1, 2016 at 10:25:49 AM UTC-4, quadstor wrote:

QUADStor VTL Support

unread,

Oct 4, 2016, 4:14:30 PM10/4/16

to quadstor-vtl

14.04 or 14.04.4 ? It seems that 14.04.4/5 uses linux kernel 4.4 or

4.2 and those are not supported yet. We tried with the base 14.04 and

the software installs fine.

The only issue seems to be that the init scripts aren’t enabled by

default. After the install you would need to manually run

update-rc.d quadstorvtl defaults

On Sun, Oct 2, 2016 at 5:10 AM, Daniel Escalona

Michael Kriese

unread,

Sep 28, 2017, 11:38:53 AM9/28/17

to QUADStor VTL

Michael Kriese

unread,

Sep 28, 2017, 11:38:53 AM9/28/17

to QUADStor VTL

Any update on kernel 4.4 from xenial?

In release note are mentioned that there are some fixed since 3.0.17.

in 3.0.21 the is a note about 4.9.

I got an error while compiling 3.0.22.

CC [M] /quadstorvtl/src/target-mode/iscsi/kernel/nthread.o

/quadstorvtl/src/target-mode/iscsi/kernel/nthread.c: In function ‘do_recv’:

/quadstorvtl/src/target-mode/iscsi/kernel/nthread.c:150:2: error: too many arguments to function ‘sock_recvmsg’

res = sock_recvmsg(conn->sock, &conn->read_msg, conn->read_size, MSG_DONTWAIT | MSG_NOSIGNAL);

^

In file included from include/linux/skbuff.h:29:0,

from include/linux/ip.h:20,

from /quadstorvtl/src/target-mode/iscsi/kernel/ietlinux.h:11,

from /quadstorvtl/src/target-mode/iscsi/kernel/iscsi_hdr.h:12,

from /quadstorvtl/src/target-mode/iscsi/kernel/iscsi.h:10,

from /quadstorvtl/src/target-mode/iscsi/kernel/nthread.c:8:

include/linux/net.h:220:5: note: declared here

int sock_recvmsg(struct socket *sock, struct msghdr *msg, int flags);

Any suggestions otherwise i hat to stick at trusty with 3.13?

Regards

Michael

Am Dienstag, 4. Oktober 2016 15:14:30 UTC+2 schrieb quadstor:

Michael Kriese

unread,

Sep 28, 2017, 12:59:12 PM9/28/17

to QUADStor VTL

My workaround is to manually remove the parameter for my local build in nthread.c and scdefs.c.

Regards

Michael

QUADStor VTL Support

unread,

Sep 29, 2017, 12:09:50 AM9/29/17

to quadstor-vtl

We had tested with Ubuntu 16.10

quadstor@ubunu1610:~$ lsb_release -a

No LSB modules are available.

Distributor ID: Ubuntu

Description: Ubuntu 16.10

Release: 16.10

Codename: yakkety

quadstor@ubunu1610:~$ uname -a

Linux ubunu1610 4.8.0-22-generic #24-Ubuntu SMP Sat Oct 8 09:15:00 UTC

2016 x86_64 x86_64 x86_64 GNU/Linux

Linux 4.4 kernels should have worked, the extra parameter to

sock_recvmsg() was removed from 4.8 onwards. So it does seem a Ubuntu

16.04 specific change and probably not worth fixing the build in the

VTL code. But we will take a look. The workaround you did should work

fine.

Ubuntu 16.10 should work but you would need version 3.0.23 from

http://www.quadstor.com/vtl-extended-edition-downloads.html

Ошибка загрузки службы QUADStor Storage Virtualization после обновления ядра Linux — quadstor.init: Starting quadstor: Failed to insert core module

Беглый поиск по тексту ошибки во время запуска службы привёл к чек-листу по другому продукту проекта QUADStor — Virtual Tape Library (VTL) — Troubleshooting common problems , где при возникновении аналогичной проблемы предлагается использовать утилиту builditf. Несмотря на то, что речь в документе идёт о QUADStor VTL, такая утилита имеется и в составе QUADStor Storage Virtualization:

Стало очевидно, что в моём случае проблема с запуском службы связана с тем, что в загрузочном образе для initrd (Initial RAM Disk), который был обновлён в вместе с установкой нового ядра Linux не хватает модулей, необходимых для работы ПО QUADStor. И чтобы исправить эту проблему, достаточно с правами root запустить на нашем сервере ранее упомянутую утилиту:

Источник

После обновления — Failed to Start Load Kernel Modules

В VirtualBox установлен Manjaro JWM 17.1. Вчера обновил систему, в том числе были обновления ядра, обновилась нормально, сделал перезагрузку и в итоге она не запускается, доходит до надписи «Загружается начальный виртуальный диск» и далее «Во время работы виртуальной машины произошла критическая ошибка.» На этом всё и заканчивается. Как можно восстановить систему?

19 комментариев

Загрузился с образа, затем

Затем с помощью Pacli сдаунгрейдил пакеты до linux 4.14.9.1 и linux-header 4.14.9.1.

Теперь уже грузится дальше, но впадает в цикл.

Welcome to Manjaro JWM Community Edition!

>

└──┤ journalctl -D /mnt/var/log/journal -xe

Jan 13 09:22:29 lapa-pc systemd[1]: Stopping LVM2 metadata daemon…

— Subject: Unit lvm2-lvmetad.service has begun shutting down

— Defined-By: systemd

— Support: lists.freedesktop.org/mailman/listinfo/systemd-devel

—

— Unit lvm2-lvmetad.service has begun shutting down.

Jan 13 09:22:29 lapa-pc systemd[1]: Stopped LVM2 metadata daemon.

— Subject: Unit lvm2-lvmetad.service has finished shutting down

— Defined-By: systemd

— Support: lists.freedesktop.org/mailman/listinfo/systemd-devel

—

— Unit lvm2-lvmetad.service has finished shutting down.

Jan 13 09:22:29 lapa-pc systemd[1]: Shutting down.

Jan 13 09:22:29 lapa-pc kernel: systemd-shutdow: 31 output lines suppressed due

Jan 13 09:22:29 lapa-pc systemd-shutdown[1]: Syncing filesystems and block devic

Jan 13 09:22:29 lapa-pc systemd-shutdown[1]: Sending SIGTERM to remaining proces

Jan 13 09:22:29 lapa-pc systemd-journald[166]: Journal stopped

— Subject: The journal has been stopped

— Defined-By: systemd

— Support: lists.freedesktop.org/mailman/listinfo/systemd-devel

—

— The system journal process has shut down and closed all currently

— active journal files.

lines 2737-2759/2759 (END)

Jan 13 09:22:29 lapa-pc systemd[1]: Stopping LVM2 metadata daemon…

— Subject: Unit lvm2-lvmetad.service has begun shutting down

— Defined-By: systemd

— Support: lists.freedesktop.org/mailman/listinfo/systemd-devel

—

— Unit lvm2-lvmetad.service has begun shutting down.

Jan 13 09:22:29 lapa-pc systemd[1]: Stopped LVM2 metadata daemon.

— Subject: Unit lvm2-lvmetad.service has finished shutting down

— Defined-By: systemd

— Support: lists.freedesktop.org/mailman/listinfo/systemd-devel

—

— Unit lvm2-lvmetad.service has finished shutting down.

Jan 13 09:22:29 lapa-pc systemd[1]: Shutting down.

Jan 13 09:22:29 lapa-pc kernel: systemd-shutdow: 31 output lines suppressed due to ratelimiting

Jan 13 09:22:29 lapa-pc systemd-shutdown[1]: Syncing filesystems and block devices.

Jan 13 09:22:29 lapa-pc systemd-shutdown[1]: Sending SIGTERM to remaining processes…

Jan 13 09:22:29 lapa-pc systemd-journald[166]: Journal stopped

— Subject: The journal has been stopped

— Defined-By: systemd

— Support: lists.freedesktop.org/mailman/listinfo/systemd-devel

—

— The system journal process has shut down and closed all currently

— active journal files.

Хорошо. Вспоминайте, какие модули ядра ставили. Как и откуда.

сделайте.

И, да, на всякий случай: при переходе в tty приглашения нет?

Всё устанавливалось через Pacli, никаких сторонних репозиториев не подключено.

И, да, на всякий случай: при переходе в tty приглашения нет?

Если имеется ввиду Alt+F3 во время цикла, то приглашение есть, но времени набрать пароль не хватает.

Да вроде бы не в это время. А так да, пережил уже 2 подобных инцидента после обновлений, причиной которых были проблемы с glibc. Удавалось починить. А в этот раз намертво. Остаётся ждать, может следующее обновление починит сломанное.

Источник

Quadstor error building kernel modules failed

Secure boot systems are not supported yet. The VTL service will fail to start since the compiled modules are not signed. To check if secure boot is enabled,

Secure boot needs to be disabled for the quadstor service to start

QLogic Firmware

The FC target-mode driver has issues with the 8.06 firmware installed by linux-firmware-20170606-56.gitc990aae.el7.noarch on RHEL/CentOS Linux release 7.3.1611 (Core)

The recent 8.07 firmware is recommended which can be got from https://git.kernel.org/pub/scm/linux/kernel/git/firmware/linux-firmware. .

FIRMWARE UPGRADE PROCEDURE

On the VTL system as root user

1. tar xvzf firmware.tgz (For the qla/qle24xx cards use tar xvzf firmware2400.tgz)

2. sh firmware/copyfirmware.sh

4. grep «fw=» /var/log/dmesg This should be fw=8.07.00 or greater

SLES 11 SP2 and above

Debian 9/10/11

Run the following chkconfig commands to start httpd/apache2 on system startup

Installation/Upgrading of QUADStor on RHEL/CentOS 5.6/5.7, SLES 11 SP1 and Debian squeeze 6.04

- Login to the target system as root

- Uninstall any previous versions of the software

- Install the packages by running the following commands (in the same order listed)

quadstor package installation might fail if the required /lib/modules/ /build symlink is missing or is invalid. Usually a kernel upgrade might not create the symlink until a reboot. For example you might get the following error when installing the quadstor-itf package

In such a case reboot the system and try installing the quadstor-itf package again.

In the above example the kernel version is 2.6.32-279.el6.x86_64 which can be got by `uname -r`

Some RHEL/CentOS installs (CentOS 6.3) might not create the build symlink correctly. In such a cases do the following steps

By default quadstor services are automatically started during system startup.If you wish to start the service manually then run the following command

To start the service manually

To stop the service

SELinux Considerations

While the package installation and quadstor start script takes care of on SELinux enabled environment the following need to be done if you have SELinux enabled

Источник

Quadstor error building kernel modules failed

1. When accessing the HTML UI any of the following messages are displayed

«ERROR: Getting configured storage list failed»

«ERROR: Getting pool list failed»

The above errors indicate that the mdaemon server isn’t running. This indicates that the quadstorvtl service did not start or failed to start.

Check for the VTL service status

If the status is «QUADStor VTL daemon is stopped», the VTL service failed to start. Try starting the VTL service manually by the following command

Starting the quadstorvtl service fails with the error message «Cannot start database»

The above error can occur to due a failed upgrade or due to a previous system crash or due to lack of free space in the filesystem where /quadstorvtl/ resided. If due to a previous system crash then restarting the quadstorvtl service will fix this problem. If due to a failed upgrade, reboot the system and then retry the upgrade

3. On Linux starting the quadstorvtl service fails with the error message «Failed to insert core module»

The above error can occur if /quadstorvtl/bin/builditf was not run or failed to complete successfully. Possible reason could be that there is a mismatch between the kernel-devel package (CentOS/RHEL/SuSE) or the linux-headers package (Debian) and the running kernel version. Upgrading the kernel and the kernel-devel/linux-headers pacakge followed by a reboot should fix this error. If the error persists please send /quadstorvtl/tmp/build.log to vtlsupport@quadstor.com

4. On CentOS 8 if the service fails to start try with SELINUX permissive instead of enforcing in /etc/selinux/config. Restart the system after changing to SELINUX=permissive

Источник

Quadstor error building kernel modules failed

If using the Fiber Channel interface after every install/upgrade reboot the system. This ensure that the new qla2xxx driver is loaded.

Check that quadstor-core and quadstor-itf packages installed are the same version. Mismatch in version can lead to configuration issues, system crashes etc.

In a clustered environment check that the quadstor-client and quadstor-itf packages are the same version and also match the quadstor-core and quadstor-itf package version on the controller node.

On a kernel upgrade, reboot the system and then run /quadstor/bin/builditf again

If the system is running other iSCSI target software ensure that those services are stopped first.

On Linux if the system had IET’s iscsi-target service running, stopping the service may not remove the iscsi_trgt kernel module. In such a case remove the iscsi_trgt manually by /sbin/rmmod iscsi_trgt

If using clustering ensure that ports 9950 9951 9952 9954 9956 are open for TCP between the controller and client nodes

If using mirroring (including synchronous mirroring) ensure that ports 9953 and 9955 are open for TCP between the two mirorring nodes

Common Problems

1. When accessing the HTML UI any of the following messages are displayed

«ERROR: Unable to retrieve license key information»

«ERROR: Getting configured storage list failed»

«ERROR: Getting pool list failed»

«ERROR: Getting VDisk list failed»

The above errors indicate that the mdaemon server isn’t running. This indicates that the quadstor service did not start or failed to start. Try starting the quadstor service manually.

2. Starting the quadstor service fails with the error message «Cannot start database»

The above error can occur to due a failed upgrade or due to a previous system crash. If due to a previous system crash then restarting the quadstor service will fix this problem. If due to a failed upgrade, reboot the system and then retry the upgrade

3. On Linux starting the quadstor service fails with the error message «Failed to insert core module»

The above error can occur if /quadstor/bin/builditf was not run or failed to complete successfully. Running /quadstor/bin/builditf might fix this problem. Recent versions of the software automatically run this command during install. Note that upgrading the kernel might not have created the necessary links for building external modules. Reboot the system first before running builditf

4. On Linux starting the quadstor service fails with the error message «iscsi_trgt kernel module conflicts with QUADStor. Exiting. «

Stop the IET iscsi-target service and manually remove iscsi_trgt kernel module

What to do next

If the problem persists then contact support with the following information

1. Run diagnostics from the «System» Page and send the tar file to support

2. If the problem is on a client node send the /var/log/messages from the client node and the diagnostics from the controller node

Источник

Рабочая среда

OS

[[email protected] ~]# cat /etc/redhat-release

CentOS Linux release 7.4.1708 (Core)

QuadStor

quadstor-virt-3.2.13-rhel.x86_64.rpmШаги

QuadStor — это продукт для хранения данных с открытым исходным кодом, который можно использовать в качестве виртуальной ленточной библиотеки и виртуализации хранения. На этот раз он будет представлен как виртуализация хранения.

Функции виртуализации хранилища следующие:

Можно на официальном сайтеhttp://www.quadstor.com/storage-virtualization-enterprise-edition-downloads.htmlЗагрузите соответствующую версию программного обеспечения.

Справочник по этапам установки и настройкиhttp://www.quadstor.com/storage-virtualization-documentation.htmlладить.

1. Установите зависимости

#yum install httpd gcc perl kernel-devel sg3_utils iotop sysstat lsscsi2. Установить квадстор

[[email protected] ~]# rpm -ivh quadstor-virt-3.2.13-rhel.x86_64.rpm

Preparing... ################################# [100%]

Updating / installing...

1:quadstor-virt-3.2.13-rhel ################################# [100%]

QUADStor Storage Virtualization commercial edition software is distributed under the following terms

THIS SOFTWARE IS PROVIDED BY THE AUTHOR ``AS IS'' AND ANY EXPRESS OR IMPLIED WARRANTIES, INCLUDING, BUT NOT LIMITED TO, THE IMPLIED WARRANTIES OF MERCHANTABILITY AND FITNESS FOR A PARTICULAR PURPOSE ARE DISCLAIMED. IN NO EVENT SHALL THE AUTHOR BE LIABLE FOR ANY DIRECT, INDIRECT, INCIDENTAL, SPECIAL, EXEMPLARY, OR CONSEQUENTIAL DAMAGES (INCLUDING, BUT NOT LIMITED TO, PROCUREMENT OF SUBSTITUTE GOODS OR SERVICES; LOSS OF USE, DATA, OR PROFITS; OR BUSINESS INTERRUPTION) HOWEVER CAUSED AND ON ANY THEORY OF LIABILITY, WHETHER IN CONTRACT, STRICT LIABILITY, OR TORT (INCLUDING NEGLIGENCE OR OTHERWISE) ARISING IN ANY WAY OUT OF THE USE OF THIS SOFTWARE, EVEN IF ADVISED OF THE POSSIBILITY OF SUCH DAMAGE.

YOU AGREE NOT TO REVERSE ENGINEER, DECOMPILE, DISASSEMBLE, CREATE ANY DERIVATIVE WORK OF THIS SOFTWARE. YOU AGREE NOT TO REDISTRIBUTE THIS SOFTWARE WITHOUT PRIOR WRITTEN PERMISSION. THIS HOWEVER DOES NOT APPLY TO THIRD PARTY/OPEN SOURCE COMPONENTS DISTRIBUTED WITH THIS SOFTWARE. FOR THIRD PARTY/OPEN SOURCE COMPONENTS THEIR RESPECTIVE LICENSING APPLIES.

Copyright (C) QUADStor Systems.

All Rights Reserved.

For any queries contact [email protected]

Performing post install. Please wait...

Created symlink from /etc/systemd/system/multi-user.target.wants/quadstor.service to /usr/lib/systemd/system/quadstor.service.

Building required kernel modules

Running /quadstor/bin/builditf. This may take a few minutes.

3. Запустите httpd и quadstor.

[[email protected] ~]# systemctl enable httpd

Created symlink from /etc/systemd/system/multi-user.target.wants/httpd.service to /usr/lib/systemd/system/httpd.service.

[[email protected] ~]# systemctl enable quadstor

[[email protected] ~]# systemctl start httpd

[[email protected] ~]# systemctl start quadstor

4. Войдите в интерфейс управления quadstor.

5. Конфигурация по умолчанию — вход на страницу управления quadstor без пароля. Следующая конфигурация требует пароля для входа в систему.

а. Создайте файл .htacess в каталоге / var / www / cgi-bin со следующим содержимым

[[email protected] cgi-bin]# vi .htaccess

AuthName "QUADStor Authentication"

AuthType Basic

AuthUserFile /var/www/cgi-bin/.htpasswd

Require valid-user

б. Создайте файл .htpasswd

[[email protected] cgi-bin]# htpasswd -s -b -c /var/www/cgi-bin/.htpasswd webadmin webadminc. Настройте часть cgi-bin в файле httpd.conf следующим образом:

<Directory "/var/www/cgi-bin">

AllowOverride AuthConfig Limit

Options None

Order allow,deny

Allow from all

</Directory>

г. Перезапустите httpd и quadstor.

[[email protected] cgi-bin]# systemctl restart httpd

[[email protected] cgi-bin]# systemctl restart quadstor

д. Войдите в интерфейс управления.

При входе в систему во всплывающем диалоговом окне необходимо ввести имя пользователя и пароль webadmin / webadmin