Ошибка «Нет используемых роботом файлов Sitemap» появляется в панели вебмастера, если Яндекс не видит карту сайта. Уточним, что карта веб-ресурса — это документ в формате xml или txt, в котором содержится актуальных список всех разделов и URL-адресов ресурса. При её отсутствии поисковик может не сразу увидеть обновление проекта, из-за чего новые страницы попадут в индекс с задержкой.

Почему робот не видит карту сайта?

Чаще всего информации об отсутствии используемых роботом файлов sitemap появляется, если:

- Документ был добавлен недавно и робот ещё не успел его проиндексировать;

- Вы не добавили документ в панель вебмастера;

- Проблема связана с настройками в robots.txt;

- Вы указали нестандартное название документа;

- На сайте отсутствует карта.

В первом случае нет повода для беспокойства. Яндекс обрабатывает документы с задержкой и, если вы загрузили корректный файл, в течение нескольких дней ошибка пропадёт. Однако, чтобы не терять время, пока он находится в очереди на обработку мы рекомендуем вам пошагово проверить другие возможные ошибки. Как это сделать мы расскажем далее.

Загрузка карты сайта

Первым делом перейдите в панель вебмастера Яндекс и откройте вкладку «Индексирование» — «Файлы Sitemap». Далее добавьте ссылку на карту ресурса в специальное поле. В течение двух недель система проверит документ и, если вы всё сделали правильно, напротив ссылки появится код ответа «ОК».

Аналогично необходимо загрузить документ в Google Search Console.

Настройка robots.txt

Иногда поисковая система может не видеть карту проекта из-за того, что её индексация запрещена в файле robots.txt. В таком случае перед ссылкой будет стоять директива «Disallow» и вам необходимо изменить её на «allow» .

Если же в robots.txt вовсе нет ссылки на документ, вы можете её добавить, прописав следующий код: «User-agent: * Allow: / Sitemap: [ссылка на документ]». Однако в таком случае вы откроете её для всех пользователей и этой информацией смогут воспользоваться злоумышленники. Поэтому мы рекомендуем предварительно посоветоваться со специалистом.

Проблемы с названием

Иногда отсутствие используемых роботом файлов с картой сайта может быть вызвано тем, что вы назвали документ нестандартным именем. Во избежание проблем лучше присваивать документу стандартное наименование «sitemap.xml» .

Как сформировать карту сайта?

В завершение рассмотрим ситуацию, когда на сервере вовсе отсутствует документ с картой ресурса.

Если у вас нет возможности нанимать специалиста в области SEO, вы можете воспользоваться автоматически генератором по созданию карты интернет-проекта. Однако этот способ платный и не всегда качественный. Поэтому некоторые большинство пользователей пытаются создать карту вручную с помощью рекомендаций Яндекс и Гугл. Однако следует иметь в виду, что они содержат не всю информацию. От себя также добавим, что при формировании файла sitemap, необходимо соблюдать следующие требования:

- Документ должен иметь формат xml или txt. Преимущество xml в том, что кроме списка адресов, в нём также можно указать дополнительные параметры страниц (частоту обновления и изменения, относительную значимость). Никто не знает улучшают ли данные сведения качество индексации, но лишним это точно не будет. Поэтому мы всё же рекомендуем использовать формат xml.

- Вы можете также создать вторую карту в формате html для пользователей. Однако поисковые системы будут её расценивать как обычную страницу. Поэтому наличие документа в формате xml или txt обязательно.

- Документ должен размещаться на одинаковом домене с сайтом, для которого он составлен, и указывать только на URL-адреса этого домена.

- В файле необходимо использовать кодировку «UTF-8».

- В документе необходимо указывать только актуальные и работающие ссылки. Например, в нём не должно быть битых ссылок и редиректов.

- Карта ресурса должна быть всегда актуальной, поэтому она должна автоматически генерироваться.

Как видите, без базовых знаний в области сайтостроения и поисковой оптимизации создать sitemap самостоятельно не так просто. Поэтому во избежание возможных ошибок и траты времени мы рекомендуем все-таки обратиться за помощью к профессионалам.

Форум

Поиск по теме

Нет используемых роботом файлов Sitemap

Здравствуйте, не могу сообразить, то ли надо ждать 14 дней, то ли что-то не так делаю. В статусе вебмастера ошибка сохраняется после проверки. Как решить вопрос? Спасибо.

Доброе день.

Нужно ждать индексации сайта. Яндекс не сразу обновляет информацию.

Добрый день. Возникли следующие вопросы:

1. обнаружила, что нет ни одной страницы сайта https://ingmar.nethouse.ru/#/ в гугле. А в Яндексе есть.

2. файл sitemap нужно как-то в гугл добавлять и в другие поисковые системы? Или достаточно того, что он есть в корневом меню сайта? (Может поэтому сайта нет в гугле)

Здравствуйте!

1. Как давно создан сайт?

2. Исправьте robots.txt на вашем сайте, инструкция http://nethouse.ru/about/instruction. koe_robots_txt

3. Без собственного домена 2 уровня файл sitemap вы не сможете добавить в поисковые системы, самостоятельно, только ждать пока его сами поисковики проиндексируют (если он сформирован на вашем сайте, инструкция http://nethouse.ru/about/instruction. avlyat_sitemap )

4. Воспользуйтесь инструкцией «Как добавить сайт в поисковые системы, если сайт работает на тарифе «Старт» http://nethouse.ru/about/instruction. a_tarife_start

1. Сайт создан 2 сентября 2016 года. Но у меня другой сайт создан в конце октября, так он и в гугле, и в яндексе есть. Я с такой ситуацией впервые столкнулась. Обычно все сайты нормально равномерно индексировались в поисковиках.

2. Не понимаю зачем исправлять robots.txt, если у меня сайт с доменом 3-го уровня, а они автоматически подключаются к ssl сертификату?

3. То есть sitemap в поисковики добавляют только в случае подтверждения прав на сайт (при домене 2- го уровня), правильно я поняла?

4. А этот пункт на практике попробую

Одна страница сайта в Гугл есть (см.скриншот)

Источник

Как добавить в WordPress robots.txt и SiteMap

Вообще любая оптимизация сайта (не важно SEO или какая-нибудь другая) начинается еще на стадии разработки.

Однако, очень часто сайт создается впопыхах, кем-попало (кого смогли найти за те деньги), без технического задания, а если оно и есть, то меняется прямо на ходу. Поэтому, ко мне часто поступают обращения с просьбой подготовить сайт на движке WordPress (поскольку популярная платформа) под SEO-оптимизацию.

Метатэги

Ок. Начнем с простого. Установим плагин «All In One SEO Pack». Делается это в админке, в разделе «Плагины», в подпункте «Добавить новый».

На открывшейся странице, в строку поиска, вводите название плагина, ищите, устанавливаете, активируете.

После этого в окне редактирования или создания поста, ниже поля куда вы вводите текст, появляются поля для тайтла, дескрипшина и кейвордсов. Если не знаете что это или зачем, то вы ни шиша не понимаете в SEO. Но у меня для вас хорошая новость, вся инфа есть в интернете. Воспользуйтесь поиском Яндекса, Гугла, поищите на ютубе. Не тупите!

Про метатэги пишу в этом посте исключительно для комплекта. Даже настроек самого плагина не буду касаться. Это та часть SEO-оптимизации, которую лучше сделать одновременно с добавлением Сайтмапа и Роботса, о которых пойдет речь дальше. Почему? Потому, что это займет всего пару минут, а в будущем точно понадобится.

Sitemap.xml

Теперь добавим карту сайта. Это тоже делается с помощью плагина. Их много, но я предпочитаю тот, что зовется «Google XML Sitemaps». Ставится ровно так же как и предыдущий.

Настраивается в разделе админки (левое вертикальное меню) «Настройки», подпункт «XML-Sitemap». Собственно, достаточно тупо снять галочку с пункта «Add sitemap URL to the virtual robots.txt file.» и сохранить (там есть кнопка сохранения, если пролистаете ниже).

Чтобы убедиться, что все работает, откройте в соседней вкладке ссылку типа http://ваш_сайт/sitemap.xml

Увидели что-то вроде этого?

Отлично. Не закрывайте вкладку. Она нам еще пригодится. А пока переходим в админку.

Robots.txt

Этот файл можно заливать без каких-либо плагинов. По FTP например. Но если нет доступа или хочется все проделать с комфортом, то… Ставим плагин. Как вы уже убедились на предыдущих примерах, это очень простое действие, но профессионалы берут за это деньги.

Итак, ставим плагин «WordPress Robots.txt File». Опять-же, можете выбрать другой, который будет работать.

Ставим плагин, активируем, переходим в «Настройки», в подпункт «Чтение».

На открывшейся странице видим поле robots.txt

Если оно чем-то заполнено — удалите. Сейчас мы его заполним новым содержимым.

Перейдите по ссылке (желательно открыть эту ссылку в новой вкладке). На открывшейся странице вы можете видеть три поля и кнопку.

Скопируйте из адресной строки браузера адрес вашего сайта и вставьте его в поле с надписью «Введите адрес сайта».

Теперь перейдите во вкладку с Сайтмапом. Помните, выше по тексту я просил ее не закрывать? Скопируйте из адресной строки путь к файлу sitemap.xml и вставьте в поле «Введите адрес вашего файла sitemap.xml».

Нажмите кнопку «Создать robots.txt».

Если все сделано правильно, в поле под кнопкой появится текст. Скопируйте его весь и вставьте в поле robots.txt, открытое в админке вашего сайта («Настройки», «Чтение»).

Нажмите кнопку «Сохранить изменения».

Перейдите по ссылке типа http://ваш_сайт/robots.txt

Если на открывшейся странице вы видите текст, который только что копировали и вставляли из поля, значит все установилось как надо.

Т.е. только что, благодаря умению читать и искать, вы сами, своими руками, установили Карту сайта и файл директив для поисковых роботов. Браво!

А с вами был Доктор Лексиум. До новых постов.

Вот в этой статье **ссылка удалена** автор утверждает о том, что если открыть uploads для всех ботов, то в индексе появляются загруженные PDF и прочие текстовые файлы. А в яндекс вебмастере, в отчете «Исключенные страницы» появляются сообщения об ошибке при индексировании картинок, мол содержимое не поддерживается. Вот и не знаю кому верить…

В приведённой статье сказано:

«Disallow: /wp-content/uploads — закрываем именно эту папку, поскольку она может содержать разного рода документы, например, PDF, DOC и т.д., которые не стоит пускать в индекс. Закрывать «wp-content» полностью чревато проблемами.»

Я бы не советовал закрывать папку uploads от индексации. Незачем хранить в ней такие текстовые файлы и PDF, появление которых в выдаче было бы нежелательным. Лучше положить такое в отдельную папку, и уже её закрыть.

Если же яндекс.вебмастер ругается на то, что содержимое не поддерживается, значит с содержимым и правда имеется проблема. Может там вместо картинки отдаётся какая-нибудь ошибка, или сервер коряво настроен и прикручивает к файлу некорректный MIME-type. Причин подобному может быть не мало.

Источник

В последнее время часто приходится отвечать на вопросы, связанные с файлами sitemap. Всплеск интереса к этому далеко не самому важному аспекту оптимизации сайтов объясняется выходом новой версии Яндекс.Вебмастера, который помечает отсутствие карты сайта как ошибку.

В разделе “Возможные проблемы” показывается следующее уведомление:

Нет используемых роботом файлов Sitemap

Робот не использует ни одного файла Sitemap. Это может негативно сказаться на скорости индексирования новых страниц сайта. Если корректные файлы Sitemap уже добавлены в очередь на обработку, сообщение автоматически исчезнет с началом их использования.

Обратите внимание на раздел «Файлы Sitemap».

Так ли страшно это предупреждение? Обязательно ли создавать sitemap и если да, то для чего? Разложим по полочкам.

Это файл, содержащий список адресов страниц сайта, сформированный по специальному (достаточно простому) стандарту. Подробно о нем можно почитать на www.sitemaps.org.

Чаще всего используется формат xml, который позволяет указывать помимо самих URL-адресов также некоторые их характеристики (частоту обновления и изменения, относительную значимость страницы). Однако можно использовать и совсем простую структуру. Это файл txt, содержащий список URL (каждый с новой строки) – и больше ничего.

Назначение списка – предоставить поисковым паукам информацию об имеющихся на сайте документах. Это помогает роботу найти все страницы ресурса и добавить их в результаты поиска. Дополнительные данные из xml – это рекомендация поисковым паукам чаще или реже посещать те или иные страницы. Кстати, не слышал ничего о том, как эти рекомендации выполняются. Очень может быть что они не учитываются вообще или являются значительно более слабым сигналом по сравнению с другими факторами.

Мифы о карте сайта

1. Достаточно сделать sitemap.xml – и об индексации можно не беспокоиться

Это самое частое заблуждение, сталкиваюсь регулярно. На самом деле для крупных сайтов (сотни тысяч страниц) полнота индекса – одна из наиболее важных проблем и простым размещением карты сайта она не решается. Карта дает роботу возможность найти все страницы, но это не значит, что а) индексации не помешает что-то другое, например, технические проблемы и б) поисковая система сочтет страницу “достойной” быть в поиске.

Для индексации всех страниц даже относительно небольшого (30 – 50 тысяч страниц) сайта нередко приходится прилагать дополнительные усилия. См. обзорную статью на эту тему а также описание автоматизированного подхода к ускорению индексации.

2. Sitemap обязателен для всех сайтов

Маленькие проекты (до тысячи страниц) с более-менее адекватной структурой, когда можно в пару кликов перейти на любую страницу, прекрасно себя чувствуют и без него. Это понятно как из общих соображений (основной механизм нахождения материалов для индексации – это переходы по внутренним ссылкам), так и из практики. Видел десятки сайтов без карты, которые полностью корректно воспринимались роботом.

Наконец, о том же говорит Гугл в своей справке:

Если страницы файла корректно связаны друг с другом, поисковые роботы могут обнаружить большую часть материалов. Тем не менее, с помощью файла Sitemap можно оптимизировать сканирование сайта, особенно в следующих случаях:

- Размер сайта очень велик. Поисковые роботы Google могут пропустить недавно созданные или измененные страницы.

- Сайт содержит большой архив страниц, которые не связаны друг с другом. Чтобы они были успешно просканированы, их можно перечислить в файле Sitemap.

- Ваш сайт создан недавно, и на него указывает мало ссылок. Робот Googlebot и другие поисковые роботы сканируют Интернет, переходя по ссылкам с одной страницы на другую. Если на ваш сайт указывает мало ссылок, его будет сложного найти.

- На сайте используется мультимедийный контент, он отображается в Новостях Google или использует другие аннотации, совместимые с файлами Sitemap. Из файлов Sitemap может получать дополнительную информацию для отображения в результатах поиска.

3. Если удалить страницу из sitemap, она выпадет из индекса

Аналогично – миф. Сталкивался с огромным количеством сайтов, где sitemap отваливался из-за технических проблем или отдавался роботам в сильно урезанном виде. Это могло вредить попаданию в поиск новых страниц, но со старыми все было в порядке.

Наоборот, нередко используется прием “удалим из карты все проиндексированное чтобы сосредоточить внимание робота на новых страницах”. Он дает определенный эффект в плане оптимизации краулинга (сканирования) сайта. Однако для большинства случаев я не рекомендую его использовать, о причинах см. ниже.

4. Обязательно нужно настраивать все доп. параметры (приоритет, частота обновления)

Нет. Как уже упоминалось, можно без проблем использовать обычный txt-файл со списком url. Разумеется, хуже от указания максимума информации в карте не будет. Однако:

- Нет достоверных данных о том, что поисковики действительно учитывают эти инструкции. Вообще-то Яндекс зачастую игнорирует даже куда более жесткую рекомендацию – заголовок сервера Last-Modified и If-Modified-Since (см. подробнее).

- Даже если сигналы учитываются строго по заявлениям поисковиков – то есть как рекомендация – то выигрыш в эффективности сканирования будет чаще всего весьма незначителен. Исключение – по-настоящему крупные проекты, где полнота индекса критична.

- Указание всех данных требует от SEO-аналитика дополнительной кропотливой работы по подбору их значений.

- Аналогично, настройка генерации файла со всеми параметрами – это дополнительные затраты на разработку.

- Пункты 3 и 4 еще серьезнее, чем кажутся. Ведь сайт меняется, должны меняться и расширенные данные, иначе рекомендации станут неактуальными.

Думаю, на этом хватит о мифах, перейдем к настоящим рекомендациям.

Как правильно работать с sitemap?

Большая часть необходимых сведений о создании файлов и предоставлении роботам доступа к ним содержится в справке поисковых систем. См. помощь Google и Яндекса. Я же расскажу о нескольких неочевидных моментах.

Во-первых, файл со списком url сайта, к которому легко получить доступ, может пригодиться не только поисковым роботам. Он крайне удобен для ряда задач SEO-аналитики.

Пара примеров.

Оценка полноты и качества индекса

Раз мы точно знаем количество доступных для поисковых систем страниц (число ссылок в карте посчитать несложно) – значит, можем быстро оценить, насколько полно он проиндексирован. Делаем грубую оценку через оператор “site:” (лучше с некоторыми ухищрениями, см. о проверке индексации в Google).

Если количество страниц в выдаче меньше, чем в карте – находим те, что ускользнули от роботов и загоняем их в поиск – правкой структуры, Твиттером (инструкция) и т.д.

Если больше – то в поиск могли попасть случайно сгенерированные, “мусорные” страницы. Их нужно найти и либо довести до ума, либо закрыть с помощью robots.txt, canonical, мета-тегов. Опять же, для поиска лишнего пригодится список нужного, чем и является sitemap.

Поиск страниц, которые не приносят трафик

Если страница есть на сайте, но не приносит нам посетителей в течение долгого времени, с ней что-то не так. Подобные url нужно найти и разобраться в причинах – зачастую это помогает здорово поднять трафик.

Как это сделать? Хотя бы так:

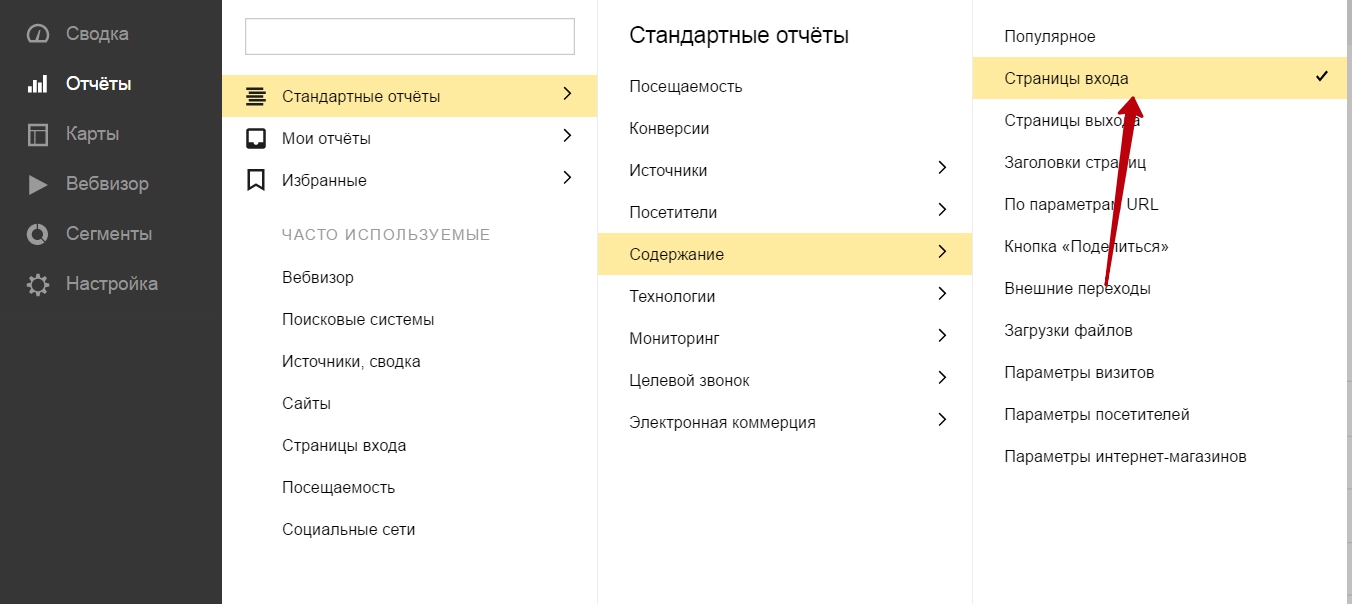

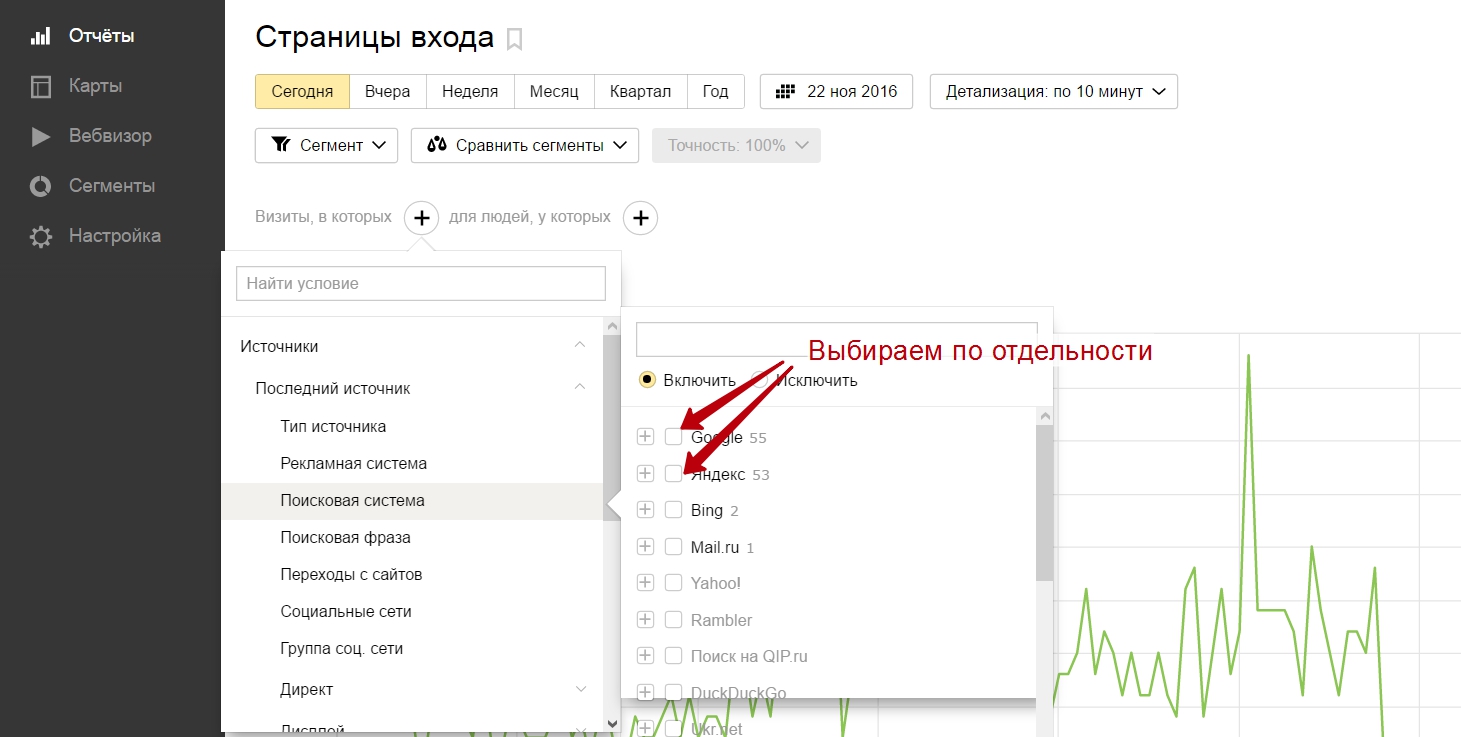

Строим в Метрике отчет по страницам входа из поиска за квартал:

Фильтруем по источнику – по одной из поисковых систем, под которую работаем:

И выгружаем список страниц (данные таблицы) в excel.

Теперь нам осталось:

а) перегнать xml-карту в excel (для этого есть море онлайн-конвертеров).

б) используя функции excel находим url, которые есть в столбце из карты, но нет в столбце из Метрики.

Алгоритм выглядит довольно громоздко, но ничего сложного в нем нет. А для ленивых ценящих свое время (таких как я) есть автоматизация процесса. Один из отчетов моего сервиса анализа сайта как раз проверяет списки из sitemap по разным параметрам. Например, вчера вышло обновление, где на основе sitemap работает поиск потенциально опасных страниц, которые загоняются в индекс ссылочным спамом от конкурентов, желающих навредить сайту.

Подобных примеров можно привести еще много. Суть не в них, а в том, что иметь под рукой актуальный перечень страниц сайта очень полезно. К нему можно быстро получить доступ с помощью разных сервисов и софта (на крайний случай – используя excel) и использовать в процессе оптимизации сайта.

Да что там говорить, даже стандартный технический аудит с применением парсеров вроде Screaming Frog делать удобнее, если подать на вход не url главной страницы, как обычно, а sitemap. Процесс делается более управляемым: можно заранее отобрать для анализа часть страниц (например, по самому проблемному разделу) и не ждать, пока будут обработаны другие.

Это был первый не очень очевидный момент.

Как лучше дать роботам доступ к карте?

В некоторых случаях лучше не указывать ссылку на stiemap в robots.txt, а отправлять вручную через Google Search Console и Яндекс.Вебмастер. Дело в том, что в robots.txt ее может увидеть кто угодно. Например, какой-нибудь злодей, который ищет где спарсить контент. Не стоит облегчать ему задачу.

Если дать SEO-паранойе разгуляться еще сильнее – то приходит мысль не использовать стандартное имя (sitemap.xml), а назвать файл как-нибудь иначе, чтобы ее не нашли, введя традиционное название.

Не скажу, что это особо критичный совет, но почему бы не подстелить соломки, если это несложно?

Резюме

- Файл sitemap помогает сайту в плане индексации, но отнюдь не является панацеей. Если есть проблемы с полнотой индекса – их нужно решать комплексно.

- Использовать необязательно, но желательно для крупных сайтов и некоторых специфичных задач (см. выше цитату из справки Google).

- Предыдущий пункт справедлив в отношении задачи “облегчить жизнь поисковым роботам”. Однако для задач анализа сайта и принятия решений в процессе оптимизации иметь под рукой карту удобно практически для всех сайтов (кроме совсем маленьких).

- Важнейшее требование к sitemap (помимо соответствия стандартам) – это полнота и актуальность. Для задач SEO-аналитики карта выступает как эталон, с которым сравнивают другие списки url-адресов (те, что в индексе; на которые есть входящие ссылки; на которые есть переходы из поиска и так далее). Поэтому при создании нужно сразу позаботиться о ее регулярном обновлении.

- Если есть необходимость управлять индексацией путем удаления уже проиндексированных страниц из sitemap, то можно иметь 2 разных файла – один отдавать роботам, а другой держать для собственных нужд по анализу.

Уф, вроде бы простой предмет, а статья почти на 1500 слов. Поздравляю себя с ее написанием и вас – с прочтением. Мы оба небывало усидчивы для эпохи социальных сетей и непрерывного отвлечения!

|

9 / 9 / 0 Регистрация: 29.03.2015 Сообщений: 287 |

|

|

1 |

|

|

20.10.2016, 09:04. Показов 3583. Ответов 11

Здравствуйте,решаю такой вопрос «Нет используемых роботом файлов Sitemap»

__________________

0 |

|

40 / 39 / 6 Регистрация: 05.10.2016 Сообщений: 131 |

|

|

20.10.2016, 10:37 |

2 |

|

Здравствуйте Ильнар86,

1 |

|

9 / 9 / 0 Регистрация: 29.03.2015 Сообщений: 287 |

|

|

20.10.2016, 15:35 [ТС] |

3 |

|

sitemap_index.xml должно быть sitemap.xml Вот так что ли? Миниатюры

0 |

|

40 / 39 / 6 Регистрация: 05.10.2016 Сообщений: 131 |

|

|

20.10.2016, 17:50 |

4 |

|

Да. З.Ы.

1 |

|

9 / 9 / 0 Регистрация: 29.03.2015 Сообщений: 287 |

|

|

22.10.2016, 22:04 [ТС] |

5 |

|

Да. Чувак,постой,не уходи Миниатюры

0 |

|

40 / 39 / 6 Регистрация: 05.10.2016 Сообщений: 131 |

|

|

23.10.2016, 20:40 |

6 |

|

Внимательно читайте условия/инструкцию загрузки файла sitemap.xml

1 |

|

9 / 9 / 0 Регистрация: 29.03.2015 Сообщений: 287 |

|

|

25.10.2016, 19:58 [ТС] |

7 |

|

Внимательно читайте условия/инструкцию загрузки файла sitemap.xml а не могли бы помочь,просто я кажется всё правильно сделал,даже проверил через google консоль Миниатюры

0 |

|

40 / 39 / 6 Регистрация: 05.10.2016 Сообщений: 131 |

|

|

25.10.2016, 20:41 |

8 |

|

Надо быть внимательным! ПРАВИЛЬНОЕ НАЗВАНИЕ ФАЙЛА — sitemap.xml

1 |

|

9 / 9 / 0 Регистрация: 29.03.2015 Сообщений: 287 |

|

|

25.10.2016, 21:09 [ТС] |

9 |

|

ПРАВИЛЬНОЕ НАЗВАНИЕ ФАЙЛА — sitemap.xml Да господи,вот добавил! Миниатюры

0 |

|

40 / 39 / 6 Регистрация: 05.10.2016 Сообщений: 131 |

|

|

25.10.2016, 21:47 |

10 |

|

https://pro-yugansk.ru/sitemap.xml должен открываться 1 файл sitemap.xml Это не страница sitemap_html, а файл sitemap.xml

1 |

|

9 / 9 / 0 Регистрация: 29.03.2015 Сообщений: 287 |

|

|

26.10.2016, 19:56 [ТС] |

11 |

|

https://pro-yugansk.ru/sitemap.xml должен открываться 1 файл sitemap.xml Это не страница sitemap_html, а файл sitemap.xml я вот что думаю,я ж пользуюсь Yoast-seo ,он создаёт эту xml-карту Миниатюры

0 |

|

9 / 9 / 0 Регистрация: 29.03.2015 Сообщений: 287 |

|

|

15.11.2016, 15:45 [ТС] |

12 |

|

должен открываться 1 файл sitemap.xml Это не страница sitemap_html, а файл sitemap.xml спасибо)от проблемы избавился)))

0 |

В последнее время участились случаи когда Google отказывается принимать сайтмап длительное время.

В данном случае попробую расписать основные причины. Их можно разделить на 2 категории: ошибки на сайте и глюки новой гугл-консоли.

Чаще всего сопровождаются сообщениями:

Не получено – не удалось получить файл Sitemap

Первые действия

- Убедитесь что сайтмап открывается в браузере и время открытия менее 10сек.

- Необходимо подождать определенное время. Если краулинговый бюджет сайта израсходован, сразу индексация сайтмапа не пройдет, ожидайте от 1 до 10 дней.

- Воспользуйтесь инструментом «Проверка URL» для анализа индексации сайтмапа и запроса на приоритетное сканирование (скрин ниже).

- Отслеживайте по логам, обращался ли GoogleBot к сайтмапу.

Проверка сайтмапа

К сожалению гугл убрал инструмент проверки сайтмапа в новой Search Console. На данный момент такую возможность дает только Яндекс.

В Google можно проверить статус URL и ускорить индексацию единственным способом:

Ошибки на сайте

Ошибки загрузки

- Сайтмап недоступен или генерируется с ошибками — Проверьте в браузере и используя сервис от Яндекс

- Проблема с зеркалами сайта WWW/HTTPS — Сам сайтмап и содержимое должны принадлежать главному зеркалу

- Сайтмап запрещен к индексации в robots.txt — Разрешите используя оператор «Allow:» в конце списка

- Сайтмап отдается слишком долго (больше 15с)

Ошибки содержимого

- Адресация в сайтмапе и на сайте отличается либо большое кол-во адресов с редиректами

- В адресах используются спецсимволы — используйте только латинские буквы (a-z), цифры и тире (-)

- Несоответствие стандарту XHTML, как правило не заменено & на &аmр;

- Имеются пробелы в начале, либо кодировка отличная от UTF-8 (без BOM)

Глюки новой Google Search Console

Иногда возникают проблемы при следующих ситуациях

-

Кириллический домен(именно доменная зона) или новая доменная зона (.top, .moscow, …) (под вопросом) как выяснилось не работает только .рф, а например .бел и .укр работают -

Использование знаков подчеркивания «_» в адресе сайтмапа — есть сообщения что замена на тире решила проблему Заголовок «content-type: application/xml» — есть сообщение что замена на «text/xml«, «text/xml; charset=UTF-8«, «application/rss+xml; charset=UTF-8«, либо полностью убранный заголовок решили проблемуИспользуется gzip-сжатие — уберите сжатие для xml, это никак не повлияет на оценки Google Page Speed, т.к. на страницах сайта xml в 99.99% не грузится- Сложная структура адреса сайтмапа — я провел эксперименты и выявил влияние, результаты ниже ↓

Прочие сайтмапы

Если ранее были отправлены иные сайтмапы, они могут задерживать обработку, отъедая краулинговый бюджет сайта. Недостаточно просто удалить сайтмап из консоли.

Цитата google:

Если вы удалите файл Sitemap, он будет удален из соответствующего отчета, но останется в Google, как и все URL, которые были в нем указаны.

Чтобы удалить файл Sitemap, выполните следующие действия:Выберите Sitemap который нужно удалить, нажав на него. Нажмите на значок «три точки». Выберите Удалить файл Sitemap. Чтобы роботы Google больше не обращались к файлу, удалите его с сайта или запретите доступ к нему с помощью файла robots.txt.

support.google.com/webmasters/answer/7451001

Личный опыт

- В 90% случаев если с самим сайтмапом всё в порядке, нужно просто подождать

- В случаях когда ожидание не помогает, нужно делать адрес максимально простым. Для 0pencart FX Sitemap есть специальный патч в разделе поддержки

Эксперименты

Разные адреса и отметки принял (✅) или не принял (✖) Google

ddd/s/rr_r ✖ ddd/s/rr ✖ ddd/s__1 ✅ ?s=ddd ✅ ?route=ggg/e/uub ✖ fx_sitemap/index.php ✅ ru/index.php?route=extension/feed/google_sitemap ✖ ru/index.php?route=extension/feed/fx_sitemap ✖ ru/index.php?route=extension/feed/fx—sitemap ✖ ru/index.php?route=extension/feed ✅ ru/index.php?route=feed/fx_sitemap ✅

почему он не видит то?

почему он не видит то?

может он что-то не так делает?Но эта проблемка осталась

может он что-то не так делает?Но эта проблемка осталась я уже начал сомневаться в правильности карты сайта своего

я уже начал сомневаться в правильности карты сайта своего а по поводу ошибок это отдельную тему открывать или тут можно поинтересоваться?

а по поводу ошибок это отдельную тему открывать или тут можно поинтересоваться?