I have the same issues.

Here is the log:

- commandLine: aliceVision_incrementalSfM --input "cache/cache/cache/cache/CameraInit/e8aec14c25db02bab43f371a3c9abc28eec32e6f/cameraInit.sfm" --featuresFolders "cache/cache/cache/cache/FeatureExtraction/7344a16d36e7fc0fbf79f8351b29c4c3b09cf39d" --matchesFolders "cache/cache/cache/cache/FeatureMatching/fd87a2abba5d7cdb94ee6704bc78b3e603930f94" --describerTypes sift --localizerEstimator acransac --lockScenePreviouslyReconstructed False --useLocalBA True --localBAGraphDistance 1 --maxNumberOfMatches 0 --minInputTrackLength 2 --minNumberOfObservationsForTriangulation 2 --minAngleForTriangulation 3.0 --minAngleForLandmark 2.0 --maxReprojectionError 4.0 --minAngleInitialPair 5.0 --maxAngleInitialPair 40.0 --useOnlyMatchesFromInputFolder False --initialPairA "" --initialPairB "" --interFileExtension .abc --verboseLevel info --output "cache/cache/cache/cache/StructureFromMotion/0af12d223cec115fb1275dc6d551587783a2a651/sfm.abc" --outputViewsAndPoses "cache/cache/cache/cache/StructureFromMotion/0af12d223cec115fb1275dc6d551587783a2a651/cameras.sfm" --extraInfoFolder "cache/cache/cache/cache/StructureFromMotion/0af12d223cec115fb1275dc6d551587783a2a651"

- logFile: ./cache/cache/cache/cache/./cache/cache/cache/cache/StructureFromMotion/0af12d223cec115fb1275dc6d551587783a2a651/log

- elapsed time: 0:00:01.139229

[2018-09-28 13:17:42,000][ERROR] Error on node computation: Error on node "StructureFromMotion_1":

Log:

Program called with the following parameters:

* describerTypes = "sift"

* extraInfoFolder = "cache/cache/cache/cache/StructureFromMotion/0af12d223cec115fb1275dc6d551587783a2a651"

* featuresFolders = = [cache/cache/cache/cache/FeatureExtraction/7344a16d36e7fc0fbf79f8351b29c4c3b09cf39d]

* initialPairA = ""

* initialPairB = ""

* input = "cache/cache/cache/cache/CameraInit/e8aec14c25db02bab43f371a3c9abc28eec32e6f/cameraInit.sfm"

* interFileExtension = ".abc"

* localBAGraphDistance = 1

* localizerEstimator = "acransac"

* lockScenePreviouslyReconstructed = 0

* matchesFolders = = [cache/cache/cache/cache/FeatureMatching/fd87a2abba5d7cdb94ee6704bc78b3e603930f94]

* maxAngleInitialPair = 40

* maxNumberOfMatches = 0

* maxReprojectionError = 4

* minAngleForLandmark = 2

* minAngleForTriangulation = 3

* minAngleInitialPair = 5

* minInputTrackLength = 2

* minNumberOfObservationsForTriangulation = 2

* output = "cache/cache/cache/cache/StructureFromMotion/0af12d223cec115fb1275dc6d551587783a2a651/sfm.abc"

* outputViewsAndPoses = "cache/cache/cache/cache/StructureFromMotion/0af12d223cec115fb1275dc6d551587783a2a651/cameras.sfm"

* refineIntrinsics = 1 (default)

* useLocalBA = 1

* useOnlyMatchesFromInputFolder = 0

* useTrackFiltering = 1 (default)

* verboseLevel = "info"

Loading features

0% 10 20 30 40 50 60 70 80 90 100%

|----|----|----|----|----|----|----|----|----|----|

[13:17:41.165173][info] Supported CUDA-Enabled GPU detected.

***************************************************

[13:17:41.212648][info] Fuse matches into tracks:

- # tracks: 3877

- # images in tracks: 57

[13:17:41.212729][info] TrackLength, Occurrence

[13:17:41.212755][info] 2 2658

[13:17:41.212766][info] 3 582

[13:17:41.212773][info] 4 249

[13:17:41.212780][info] 5 152

[13:17:41.212786][info] 6 106

[13:17:41.212792][info] 7 61

[13:17:41.212799][info] 8 26

[13:17:41.212805][info] 9 27

[13:17:41.212812][info] 10 13

[13:17:41.212819][info] 11 2

[13:17:41.212826][info] 12 1

Automatic selection of an initial pair:

0% 10 20 30 40 50 60 70 80 90 100%

|----|----|----|----|----|----|----|----|----|----|

******[13:17:41.212960][info] AutomaticInitialPairChoice, test I: 3428893, J: 467739138, nbCommonTracks: 53

[13:17:41.212979][info] AutomaticInitialPairChoice, test I: 3428893, J: 734796515, nbCommonTracks: 81

[13:17:41.212995][info] AutomaticInitialPairChoice, test I: 22306852, J: 24234808, nbCommonTracks: 69

[13:17:41.213017][info] AutomaticInitialPairChoice, test I: 22306852, J: 734796515, nbCommonTracks: 93

[13:17:41.213021][info] AutomaticInitialPairChoice, test I: 22306852, J: 269133861, nbCommonTracks: 75

[13:17:41.213055][info] AutomaticInitialPairChoice, test I: 22306852, J: 1444820303, nbCommonTracks: 202

[13:17:41.213059][info] AutomaticInitialPairChoice, test I: 22306852, J: 850726783, nbCommonTracks: 182

[13:17:41.213063][info] AutomaticInitialPairChoice, test I: 22306852, J: 1381303897, nbCommonTracks: 207

[13:17:41.221562][info] AutomaticInitialPairChoice, test I: 22306852, J: 1550435502, nbCommonTracks: 250

*[13:17:41.222007][info] AutomaticInitialPairChoice, test I: 22306852, J: 1611637874, nbCommonTracks: 82

[13:17:41.222972][info] AutomaticInitialPairChoice, test I: 22306852, J: 1772777439, nbCommonTracks: 214

*[13:17:41.223261][info] AutomaticInitialPairChoice, test I: 24234808, J: 850726783, nbCommonTracks: 87

[13:17:41.223829][info] AutomaticInitialPairChoice, test I: 24234808, J: 2004139730, nbCommonTracks: 57

*[13:17:41.226298][info] AutomaticInitialPairChoice, test I: 28372008, J: 1716423146, nbCommonTracks: 59

*[13:17:41.227709][info] AutomaticInitialPairChoice, test I: 101613049, J: 483529918, nbCommonTracks: 325

[13:17:41.228319][info] AutomaticInitialPairChoice, test I: 101613049, J: 1309055266, nbCommonTracks: 63

*[13:17:41.232796][info] AutomaticInitialPairChoice, test I: 101613049, J: 1964208076, nbCommonTracks: 136

[13:17:41.234129][info] AutomaticInitialPairChoice, test I: 101613049, J: 1979165897, nbCommonTracks: 274

*[13:17:41.235430][info] AutomaticInitialPairChoice, test I: 202229099, J: 522804020, nbCommonTracks: 52

[13:17:41.235948][info] AutomaticInitialPairChoice, test I: 241586055, J: 612472186, nbCommonTracks: 276

*[13:17:41.237493][info] AutomaticInitialPairChoice, test I: 241586055, J: 739355435, nbCommonTracks: 132

*[13:17:41.238293][info] AutomaticInitialPairChoice, test I: 241586055, J: 1309055266, nbCommonTracks: 123

[13:17:41.239312][info] AutomaticInitialPairChoice, test I: 241586055, J: 2024308882, nbCommonTracks: 56

*[13:17:41.243574][info] AutomaticInitialPairChoice, test I: 269133861, J: 467739138, nbCommonTracks: 121

[13:17:41.244426][info] AutomaticInitialPairChoice, test I: 269133861, J: 1381303897, nbCommonTracks: 86

*[13:17:41.246900][info] AutomaticInitialPairChoice, test I: 269133861, J: 1550435502, nbCommonTracks: 65

[13:17:41.247993][info] AutomaticInitialPairChoice, test I: 269133861, J: 1611637874, nbCommonTracks: 133

*[13:17:41.248698][info] AutomaticInitialPairChoice, test I: 271753040, J: 1417968613, nbCommonTracks: 246

*[13:17:41.249021][info] AutomaticInitialPairChoice, test I: 271753040, J: 1448473450, nbCommonTracks: 87

[13:17:41.250375][info] AutomaticInitialPairChoice, test I: 271753040, J: 2020359922, nbCommonTracks: 76

*[13:17:41.254063][info] AutomaticInitialPairChoice, test I: 349536301, J: 1093767916, nbCommonTracks: 80

[13:17:41.254413][info] AutomaticInitialPairChoice, test I: 412397934, J: 1633149959, nbCommonTracks: 54

*[13:17:41.256024][info] AutomaticInitialPairChoice, test I: 467739138, J: 1611637874, nbCommonTracks: 95

[13:17:41.256213][info] AutomaticInitialPairChoice, test I: 467739138, J: 1851633457, nbCommonTracks: 95

*[13:17:41.258835][info] AutomaticInitialPairChoice, test I: 483529918, J: 530639247, nbCommonTracks: 76

*[13:17:41.258982][info] AutomaticInitialPairChoice, test I: 483529918, J: 1964208076, nbCommonTracks: 183

[13:17:41.260275][info] AutomaticInitialPairChoice, test I: 483529918, J: 1979165897, nbCommonTracks: 207

*[13:17:41.263009][info] AutomaticInitialPairChoice, test I: 530639247, J: 1891749448, nbCommonTracks: 73

[13:17:41.263952][info] AutomaticInitialPairChoice, test I: 530639247, J: 1964208076, nbCommonTracks: 123

*[13:17:41.265946][info] AutomaticInitialPairChoice, test I: 583386785, J: 886063614, nbCommonTracks: 63

[13:17:41.266512][info] AutomaticInitialPairChoice, test I: 583386785, J: 1105021015, nbCommonTracks: 80

*[13:17:41.268039][info] AutomaticInitialPairChoice, test I: 583386785, J: 1442620960, nbCommonTracks: 55

[13:17:41.270098][info] AutomaticInitialPairChoice, test I: 583386785, J: 1645771870, nbCommonTracks: 134

*[13:17:41.272055][info] AutomaticInitialPairChoice, test I: 583386785, J: 1968066196, nbCommonTracks: 62

*[13:17:41.272862][info] AutomaticInitialPairChoice, test I: 612472186, J: 739355435, nbCommonTracks: 90

[13:17:41.275037][info] AutomaticInitialPairChoice, test I: 612472186, J: 1309055266, nbCommonTracks: 84

*[13:17:41.275383][info] AutomaticInitialPairChoice, test I: 633256926, J: 886063614, nbCommonTracks: 50

[13:17:41.275587][info] AutomaticInitialPairChoice, test I: 633256926, J: 928901616, nbCommonTracks: 89

*[13:17:41.277252][info] AutomaticInitialPairChoice, test I: 664399704, J: 1281752708, nbCommonTracks: 61

[13:17:41.277554][info] AutomaticInitialPairChoice, test I: 734796515, J: 1381303897, nbCommonTracks: 81

*[13:17:41.281838][info] AutomaticInitialPairChoice, test I: 734796515, J: 1444820303, nbCommonTracks: 79

*[13:17:41.282455][info] AutomaticInitialPairChoice, test I: 734796515, J: 1550435502, nbCommonTracks: 87

[13:17:41.284453][info] AutomaticInitialPairChoice, test I: 734796515, J: 1772777439, nbCommonTracks: 89

*[13:17:41.284808][info] AutomaticInitialPairChoice, test I: 739355435, J: 1309055266, nbCommonTracks: 70

[13:17:41.286648][info] AutomaticInitialPairChoice, test I: 762361131, J: 1309055266, nbCommonTracks: 93

*[13:17:41.287071][info] AutomaticInitialPairChoice, test I: 762361131, J: 1979165897, nbCommonTracks: 116

[13:17:41.287358][info] AutomaticInitialPairChoice, test I: 762361131, J: 2020359922, nbCommonTracks: 59

*[13:17:41.288239][info] AutomaticInitialPairChoice, test I: 762361131, J: 2024308882, nbCommonTracks: 145

*[13:17:41.292002][info] AutomaticInitialPairChoice, test I: 834681592, J: 1292399561, nbCommonTracks: 73

[13:17:41.293052][info] AutomaticInitialPairChoice, test I: 834681592, J: 1448473450, nbCommonTracks: 139

*[13:17:41.294144][info] AutomaticInitialPairChoice, test I: 850726783, J: 1381303897, nbCommonTracks: 118

[13:17:41.294838][info] AutomaticInitialPairChoice, test I: 850726783, J: 1444820303, nbCommonTracks: 144

*[13:17:41.296072][info] AutomaticInitialPairChoice, test I: 850726783, J: 1550435502, nbCommonTracks: 185

[13:17:41.296239][info] AutomaticInitialPairChoice, test I: 850726783, J: 1772777439, nbCommonTracks: 183

*[13:17:41.298227][info] AutomaticInitialPairChoice, test I: 886063614, J: 1627104198, nbCommonTracks: 55

*[13:17:41.300045][info] AutomaticInitialPairChoice, test I: 886063614, J: 1645771870, nbCommonTracks: 65

[13:17:41.301175][info] AutomaticInitialPairChoice, test I: 886063614, J: 1968066196, nbCommonTracks: 64

*[13:17:41.304365][info] AutomaticInitialPairChoice, test I: 929119496, J: 979414985, nbCommonTracks: 55

[13:17:41.305038][info] AutomaticInitialPairChoice, test I: 979414985, J: 1292399561, nbCommonTracks: 61

*[13:17:41.308122][info] AutomaticInitialPairChoice, test I: 1105021015, J: 1645771870, nbCommonTracks: 105

[13:17:41.308301][info] AutomaticInitialPairChoice, test I: 1170976665, J: 1442620960, nbCommonTracks: 82

*[13:17:41.310326][info] AutomaticInitialPairChoice, test I: 1309055266, J: 1979165897, nbCommonTracks: 87

*[13:17:41.310448][info] AutomaticInitialPairChoice, test I: 1309055266, J: 2024308882, nbCommonTracks: 123

[13:17:41.310964][info] AutomaticInitialPairChoice, test I: 1381303897, J: 1444820303, nbCommonTracks: 125

*[13:17:41.312325][info] AutomaticInitialPairChoice, test I: 1381303897, J: 1550435502, nbCommonTracks: 186

[13:17:41.313076][info] AutomaticInitialPairChoice, test I: 1381303897, J: 1611637874, nbCommonTracks: 104

*[13:17:41.313902][info] AutomaticInitialPairChoice, test I: 1381303897, J: 1772777439, nbCommonTracks: 161

[13:17:41.319199][info] AutomaticInitialPairChoice, test I: 1417968613, J: 2020359922, nbCommonTracks: 84

*[13:17:41.319723][info] AutomaticInitialPairChoice, test I: 1433524306, J: 1444820303, nbCommonTracks: 52

*[13:17:41.320400][info] AutomaticInitialPairChoice, test I: 1444820303, J: 1550435502, nbCommonTracks: 160

[13:17:41.322037][info] AutomaticInitialPairChoice, test I: 1444820303, J: 1772777439, nbCommonTracks: 161

*[13:17:41.323218][info] AutomaticInitialPairChoice, test I: 1448473450, J: 2020359922, nbCommonTracks: 58

*[13:17:41.326821][info] AutomaticInitialPairChoice, test I: 1550435502, J: 1611637874, nbCommonTracks: 70

[13:17:41.326905][info] AutomaticInitialPairChoice, test I: 1550435502, J: 1772777439, nbCommonTracks: 217

[13:17:41.327166][info] AutomaticInitialPairChoice, test I: 1645771870, J: 1968066196, nbCommonTracks: 66

*[13:17:41.328996][info] AutomaticInitialPairChoice, test I: 1645843344, J: 1704106311, nbCommonTracks: 62

[13:17:41.329806][info] AutomaticInitialPairChoice, test I: 1891749448, J: 1964208076, nbCommonTracks: 70

*

[13:17:41.332279][info] AutomaticInitialPairChoice, test I: 1964208076, J: 1979165897, nbCommonTracks: 125

[13:17:41.343023][info] Initial pair is:

A - view id: 1381303897 - filepath: helmets/IMG_0637.JPG

B - view id: 1772777439 - filepath: helmets/IMG_0639.JPG

[13:17:41.343181][info] 161 matches in the image pair for the initial pose estimation.

block_sparse_matrix.cc:81 Allocating values array with 42912 bytes.

detect_structure.cc:113 Schur complement static structure <2,3,6>.

detect_structure.cc:113 Schur complement static structure <2,3,6>.

[13:17:41.394729][info] Remove outliers:

- # outliers residual error: 2

- # outliers angular error: 0

block_sparse_matrix.cc:81 Allocating values array with 42624 bytes.

detect_structure.cc:113 Schur complement static structure <2,3,6>.

detect_structure.cc:113 Schur complement static structure <2,3,6>.

[13:17:41.397359][info] Remove outliers:

- # outliers residual error: 0

- # outliers angular error: 0

[13:17:41.420592][info] Initial pair is: 1381303897, 1772777439

[13:17:41.420613][info] Begin Incremental Reconstruction:

- mode: SfM augmentation

- # images in input: 60

- # images in resection: 58

- # landmarks in input: 148

- # cameras already calibrated: 2

[13:17:41.420833][info] Update Reconstruction:

- resection id: 0

- # images in the resection group: 1

- # images remaining: 58

[13:17:41.420896][info] Robust Resection of view: 22306852

[13:17:41.438519][info] Robust Resection information:

- resection status: true

- threshold (error max): 9.77288

- # points used for resection: 119

- # points validated by robust resection: 113

block_sparse_matrix.cc:81 Allocating values array with 10848 bytes.

detect_structure.cc:113 Schur complement static structure <2,6,0>.

detect_structure.cc:113 Schur complement static structure <2,6,0>.

block_sparse_matrix.cc:81 Allocating values array with 176128 bytes.

detect_structure.cc:95 Dynamic f block size because the block size changed from 6 to 7

detect_structure.cc:113 Schur complement static structure <2,3,-1>.

detect_structure.cc:95 Dynamic f block size because the block size changed from 6 to 7

detect_structure.cc:113 Schur complement static structure <2,3,-1>.

[13:17:41.516787][info] Remove outliers:

- # outliers residual error: 9

- # outliers angular error: 95

block_sparse_matrix.cc:81 Allocating values array with 124928 bytes.

detect_structure.cc:95 Dynamic f block size because the block size changed from 6 to 7

detect_structure.cc:113 Schur complement static structure <2,3,-1>.

detect_structure.cc:95 Dynamic f block size because the block size changed from 6 to 7

detect_structure.cc:113 Schur complement static structure <2,3,-1>.

[13:17:41.530648][info] Remove outliers:

- # outliers residual error: 1

- # outliers angular error: 0

[13:17:41.530673][info] Update Reconstruction complete:

- # cameras calibrated: 3

- # landmarks: 188

[13:17:41.530887][info] Update Reconstruction:

- resection id: 1

- # images in the resection group: 1

- # images remaining: 57

[13:17:41.530949][info] Robust Resection of view: 1444820303

[13:17:41.547245][info] Robust Resection information:

- resection status: true

- threshold (error max): 9.08969

- # points used for resection: 107

- # points validated by robust resection: 104

block_sparse_matrix.cc:81 Allocating values array with 9984 bytes.

detect_structure.cc:113 Schur complement static structure <2,6,0>.

detect_structure.cc:113 Schur complement static structure <2,6,0>.

block_sparse_matrix.cc:81 Allocating values array with 58624 bytes.

detect_structure.cc:95 Dynamic f block size because the block size changed from 6 to 7

detect_structure.cc:113 Schur complement static structure <2,3,-1>.

detect_structure.cc:95 Dynamic f block size because the block size changed from 6 to 7

detect_structure.cc:113 Schur complement static structure <2,3,-1>.

[13:17:41.570649][info] Remove outliers:

- # outliers residual error: 0

- # outliers angular error: 41

[13:17:41.570677][info] Poses removed from the reconstruction: {1444820303}

[13:17:41.570683][info] Update Reconstruction complete:

- # cameras calibrated: 3

- # landmarks: 44

[13:17:41.570736][info] Update Reconstruction:

- resection id: 2

- # images in the resection group: 1

- # images remaining: 56

[13:17:41.570761][info] Robust Resection of view: 1550435502

[13:17:41.576456][info] Robust Resection information:

- resection status: true

- threshold (error max): 2.98395

- # points used for resection: 25

- # points validated by robust resection: 25

block_sparse_matrix.cc:81 Allocating values array with 2400 bytes.

detect_structure.cc:113 Schur complement static structure <2,6,0>.

detect_structure.cc:113 Schur complement static structure <2,6,0>.

block_sparse_matrix.cc:81 Allocating values array with 11008 bytes.

detect_structure.cc:95 Dynamic f block size because the block size changed from 6 to 7

detect_structure.cc:113 Schur complement static structure <2,3,-1>.

detect_structure.cc:95 Dynamic f block size because the block size changed from 6 to 7

detect_structure.cc:113 Schur complement static structure <2,3,-1>.

[13:17:41.582019][info] Remove outliers:

- # outliers residual error: 0

- # outliers angular error: 9

[13:17:41.582042][info] Poses removed from the reconstruction: {22306852, 1381303897, 1550435502, 1772777439}

[13:17:41.582049][info] Update Reconstruction complete:

- # cameras calibrated: 0

- # landmarks: 0

[13:17:41.582060][info] Structure from Motion statistics:

- # input images: 60

- # cameras calibrated: 0

- # landmarks: 0

- elapsed time: 0.161

- residual RMSE: -nan

[13:17:41.582069][info] Histogram of residuals:

0 | 0

0.1 | 0

0.2 | 0

0.3 | 0

0.4 | 0

0.5 | 0

0.6 | 0

0.7 | 0

0.8 | 0

0.9 | 0

1

[13:17:41.582082][info] Histogram of tracks length:

0 | 0

0.1 | 0

0.2 | 0

0.3 | 0

0.4 | 0

0.5 | 0

0.6 | 0

0.7 | 0

0.8 | 0

0.9 | 0

1

WARNING: downgrade status on node "PrepareDenseScene_1" from Status.SUBMITTED to Status.NONE

WARNING: downgrade status on node "CameraConnection_1" from Status.SUBMITTED to Status.NONE

WARNING: downgrade status on node "DepthMap_1(0)" from Status.SUBMITTED to Status.NONE

WARNING: downgrade status on node "DepthMap_1(1)" from Status.SUBMITTED to Status.NONE

WARNING: downgrade status on node "DepthMap_1(2)" from Status.SUBMITTED to Status.NONE

WARNING: downgrade status on node "DepthMap_1(3)" from Status.SUBMITTED to Status.NONE

WARNING: downgrade status on node "DepthMap_1(4)" from Status.SUBMITTED to Status.NONE

WARNING: downgrade status on node "DepthMap_1(5)" from Status.SUBMITTED to Status.NONE

WARNING: downgrade status on node "DepthMap_1(6)" from Status.SUBMITTED to Status.NONE

WARNING: downgrade status on node "DepthMap_1(7)" from Status.SUBMITTED to Status.NONE

WARNING: downgrade status on node "DepthMap_1(8)" from Status.SUBMITTED to Status.NONE

WARNING: downgrade status on node "DepthMap_1(9)" from Status.SUBMITTED to Status.NONE

WARNING: downgrade status on node "DepthMap_1(10)" from Status.SUBMITTED to Status.NONE

WARNING: downgrade status on node "DepthMap_1(11)" from Status.SUBMITTED to Status.NONE

WARNING: downgrade status on node "DepthMap_1(12)" from Status.SUBMITTED to Status.NONE

WARNING: downgrade status on node "DepthMap_1(13)" from Status.SUBMITTED to Status.NONE

WARNING: downgrade status on node "DepthMap_1(14)" from Status.SUBMITTED to Status.NONE

WARNING: downgrade status on node "DepthMap_1(15)" from Status.SUBMITTED to Status.NONE

WARNING: downgrade status on node "DepthMap_1(16)" from Status.SUBMITTED to Status.NONE

WARNING: downgrade status on node "DepthMap_1(17)" from Status.SUBMITTED to Status.NONE

WARNING: downgrade status on node "DepthMap_1(18)" from Status.SUBMITTED to Status.NONE

WARNING: downgrade status on node "DepthMap_1(19)" from Status.SUBMITTED to Status.NONE

WARNING: downgrade status on node "DepthMapFilter_1(0)" from Status.SUBMITTED to Status.NONE

WARNING: downgrade status on node "DepthMapFilter_1(1)" from Status.SUBMITTED to Status.NONE

WARNING: downgrade status on node "DepthMapFilter_1(2)" from Status.SUBMITTED to Status.NONE

WARNING: downgrade status on node "DepthMapFilter_1(3)" from Status.SUBMITTED to Status.NONE

WARNING: downgrade status on node "DepthMapFilter_1(4)" from Status.SUBMITTED to Status.NONE

WARNING: downgrade status on node "DepthMapFilter_1(5)" from Status.SUBMITTED to Status.NONE

WARNING: downgrade status on node "Meshing_1" from Status.SUBMITTED to Status.NONE

WARNING: downgrade status on node "MeshFiltering_1" from Status.SUBMITTED to Status.NONE

WARNING: downgrade status on node "Texturing_1" from Status.SUBMITTED to Status.NONE

WARNING: downgrade status on node "Publish_1" from Status.SUBMITTED to Status.NONE

Traceback (most recent call last):

File "bin/meshroom_photogrammetry", line 64, in <module>

meshroom.core.graph.executeGraph(graph, toNodes=toNodes, forceCompute=args.forceCompute, forceStatus=args.forceStatus)

File "/home/nvidia/nico/meshroom/meshroom/core/graph.py", line 1124, in executeGraph

chunk.process(forceCompute)

File "/home/nvidia/nico/meshroom/meshroom/core/node.py", line 271, in process

self.node.nodeDesc.processChunk(self)

File "/home/nvidia/nico/meshroom/meshroom/core/desc.py", line 407, in processChunk

raise RuntimeError('Error on node "{}":nLog:n{}'.format(chunk.name, logContent))

RuntimeError: Error on node "StructureFromMotion_1":

Log:

Program called with the following parameters:

* describerTypes = "sift"

* extraInfoFolder = "cache/cache/cache/cache/StructureFromMotion/0af12d223cec115fb1275dc6d551587783a2a651"

* featuresFolders = = [cache/cache/cache/cache/FeatureExtraction/7344a16d36e7fc0fbf79f8351b29c4c3b09cf39d]

* initialPairA = ""

* initialPairB = ""

* input = "cache/cache/cache/cache/CameraInit/e8aec14c25db02bab43f371a3c9abc28eec32e6f/cameraInit.sfm"

* interFileExtension = ".abc"

* localBAGraphDistance = 1

* localizerEstimator = "acransac"

* lockScenePreviouslyReconstructed = 0

* matchesFolders = = [cache/cache/cache/cache/FeatureMatching/fd87a2abba5d7cdb94ee6704bc78b3e603930f94]

* maxAngleInitialPair = 40

* maxNumberOfMatches = 0

* maxReprojectionError = 4

* minAngleForLandmark = 2

* minAngleForTriangulation = 3

* minAngleInitialPair = 5

* minInputTrackLength = 2

* minNumberOfObservationsForTriangulation = 2

* output = "cache/cache/cache/cache/StructureFromMotion/0af12d223cec115fb1275dc6d551587783a2a651/sfm.abc"

* outputViewsAndPoses = "cache/cache/cache/cache/StructureFromMotion/0af12d223cec115fb1275dc6d551587783a2a651/cameras.sfm"

* refineIntrinsics = 1 (default)

* useLocalBA = 1

* useOnlyMatchesFromInputFolder = 0

* useTrackFiltering = 1 (default)

* verboseLevel = "info"

Loading features

0% 10 20 30 40 50 60 70 80 90 100%

|----|----|----|----|----|----|----|----|----|----|

[13:17:41.165173][info] Supported CUDA-Enabled GPU detected.

***************************************************

[13:17:41.212648][info] Fuse matches into tracks:

- # tracks: 3877

- # images in tracks: 57

[13:17:41.212729][info] TrackLength, Occurrence

[13:17:41.212755][info] 2 2658

[13:17:41.212766][info] 3 582

[13:17:41.212773][info] 4 249

[13:17:41.212780][info] 5 152

[13:17:41.212786][info] 6 106

[13:17:41.212792][info] 7 61

[13:17:41.212799][info] 8 26

[13:17:41.212805][info] 9 27

[13:17:41.212812][info] 10 13

[13:17:41.212819][info] 11 2

[13:17:41.212826][info] 12 1

Automatic selection of an initial pair:

0% 10 20 30 40 50 60 70 80 90 100%

|----|----|----|----|----|----|----|----|----|----|

******[13:17:41.212960][info] AutomaticInitialPairChoice, test I: 3428893, J: 467739138, nbCommonTracks: 53

[13:17:41.212979][info] AutomaticInitialPairChoice, test I: 3428893, J: 734796515, nbCommonTracks: 81

[13:17:41.212995][info] AutomaticInitialPairChoice, test I: 22306852, J: 24234808, nbCommonTracks: 69

[13:17:41.213017][info] AutomaticInitialPairChoice, test I: 22306852, J: 734796515, nbCommonTracks: 93

[13:17:41.213021][info] AutomaticInitialPairChoice, test I: 22306852, J: 269133861, nbCommonTracks: 75

[13:17:41.213055][info] AutomaticInitialPairChoice, test I: 22306852, J: 1444820303, nbCommonTracks: 202

[13:17:41.213059][info] AutomaticInitialPairChoice, test I: 22306852, J: 850726783, nbCommonTracks: 182

[13:17:41.213063][info] AutomaticInitialPairChoice, test I: 22306852, J: 1381303897, nbCommonTracks: 207

[13:17:41.221562][info] AutomaticInitialPairChoice, test I: 22306852, J: 1550435502, nbCommonTracks: 250

*[13:17:41.222007][info] AutomaticInitialPairChoice, test I: 22306852, J: 1611637874, nbCommonTracks: 82

[13:17:41.222972][info] AutomaticInitialPairChoice, test I: 22306852, J: 1772777439, nbCommonTracks: 214

*[13:17:41.223261][info] AutomaticInitialPairChoice, test I: 24234808, J: 850726783, nbCommonTracks: 87

[13:17:41.223829][info] AutomaticInitialPairChoice, test I: 24234808, J: 2004139730, nbCommonTracks: 57

*[13:17:41.226298][info] AutomaticInitialPairChoice, test I: 28372008, J: 1716423146, nbCommonTracks: 59

*[13:17:41.227709][info] AutomaticInitialPairChoice, test I: 101613049, J: 483529918, nbCommonTracks: 325

[13:17:41.228319][info] AutomaticInitialPairChoice, test I: 101613049, J: 1309055266, nbCommonTracks: 63

*[13:17:41.232796][info] AutomaticInitialPairChoice, test I: 101613049, J: 1964208076, nbCommonTracks: 136

[13:17:41.234129][info] AutomaticInitialPairChoice, test I: 101613049, J: 1979165897, nbCommonTracks: 274

*[13:17:41.235430][info] AutomaticInitialPairChoice, test I: 202229099, J: 522804020, nbCommonTracks: 52

[13:17:41.235948][info] AutomaticInitialPairChoice, test I: 241586055, J: 612472186, nbCommonTracks: 276

*[13:17:41.237493][info] AutomaticInitialPairChoice, test I: 241586055, J: 739355435, nbCommonTracks: 132

*[13:17:41.238293][info] AutomaticInitialPairChoice, test I: 241586055, J: 1309055266, nbCommonTracks: 123

[13:17:41.239312][info] AutomaticInitialPairChoice, test I: 241586055, J: 2024308882, nbCommonTracks: 56

*[13:17:41.243574][info] AutomaticInitialPairChoice, test I: 269133861, J: 467739138, nbCommonTracks: 121

[13:17:41.244426][info] AutomaticInitialPairChoice, test I: 269133861, J: 1381303897, nbCommonTracks: 86

*[13:17:41.246900][info] AutomaticInitialPairChoice, test I: 269133861, J: 1550435502, nbCommonTracks: 65

[13:17:41.247993][info] AutomaticInitialPairChoice, test I: 269133861, J: 1611637874, nbCommonTracks: 133

*[13:17:41.248698][info] AutomaticInitialPairChoice, test I: 271753040, J: 1417968613, nbCommonTracks: 246

*[13:17:41.249021][info] AutomaticInitialPairChoice, test I: 271753040, J: 1448473450, nbCommonTracks: 87

[13:17:41.250375][info] AutomaticInitialPairChoice, test I: 271753040, J: 2020359922, nbCommonTracks: 76

*[13:17:41.254063][info] AutomaticInitialPairChoice, test I: 349536301, J: 1093767916, nbCommonTracks: 80

[13:17:41.254413][info] AutomaticInitialPairChoice, test I: 412397934, J: 1633149959, nbCommonTracks: 54

*[13:17:41.256024][info] AutomaticInitialPairChoice, test I: 467739138, J: 1611637874, nbCommonTracks: 95

[13:17:41.256213][info] AutomaticInitialPairChoice, test I: 467739138, J: 1851633457, nbCommonTracks: 95

*[13:17:41.258835][info] AutomaticInitialPairChoice, test I: 483529918, J: 530639247, nbCommonTracks: 76

*[13:17:41.258982][info] AutomaticInitialPairChoice, test I: 483529918, J: 1964208076, nbCommonTracks: 183

[13:17:41.260275][info] AutomaticInitialPairChoice, test I: 483529918, J: 1979165897, nbCommonTracks: 207

*[13:17:41.263009][info] AutomaticInitialPairChoice, test I: 530639247, J: 1891749448, nbCommonTracks: 73

[13:17:41.263952][info] AutomaticInitialPairChoice, test I: 530639247, J: 1964208076, nbCommonTracks: 123

*[13:17:41.265946][info] AutomaticInitialPairChoice, test I: 583386785, J: 886063614, nbCommonTracks: 63

[13:17:41.266512][info] AutomaticInitialPairChoice, test I: 583386785, J: 1105021015, nbCommonTracks: 80

*[13:17:41.268039][info] AutomaticInitialPairChoice, test I: 583386785, J: 1442620960, nbCommonTracks: 55

[13:17:41.270098][info] AutomaticInitialPairChoice, test I: 583386785, J: 1645771870, nbCommonTracks: 134

*[13:17:41.272055][info] AutomaticInitialPairChoice, test I: 583386785, J: 1968066196, nbCommonTracks: 62

*[13:17:41.272862][info] AutomaticInitialPairChoice, test I: 612472186, J: 739355435, nbCommonTracks: 90

[13:17:41.275037][info] AutomaticInitialPairChoice, test I: 612472186, J: 1309055266, nbCommonTracks: 84

*[13:17:41.275383][info] AutomaticInitialPairChoice, test I: 633256926, J: 886063614, nbCommonTracks: 50

[13:17:41.275587][info] AutomaticInitialPairChoice, test I: 633256926, J: 928901616, nbCommonTracks: 89

*[13:17:41.277252][info] AutomaticInitialPairChoice, test I: 664399704, J: 1281752708, nbCommonTracks: 61

[13:17:41.277554][info] AutomaticInitialPairChoice, test I: 734796515, J: 1381303897, nbCommonTracks: 81

*[13:17:41.281838][info] AutomaticInitialPairChoice, test I: 734796515, J: 1444820303, nbCommonTracks: 79

*[13:17:41.282455][info] AutomaticInitialPairChoice, test I: 734796515, J: 1550435502, nbCommonTracks: 87

[13:17:41.284453][info] AutomaticInitialPairChoice, test I: 734796515, J: 1772777439, nbCommonTracks: 89

*[13:17:41.284808][info] AutomaticInitialPairChoice, test I: 739355435, J: 1309055266, nbCommonTracks: 70

[13:17:41.286648][info] AutomaticInitialPairChoice, test I: 762361131, J: 1309055266, nbCommonTracks: 93

*[13:17:41.287071][info] AutomaticInitialPairChoice, test I: 762361131, J: 1979165897, nbCommonTracks: 116

[13:17:41.287358][info] AutomaticInitialPairChoice, test I: 762361131, J: 2020359922, nbCommonTracks: 59

*[13:17:41.288239][info] AutomaticInitialPairChoice, test I: 762361131, J: 2024308882, nbCommonTracks: 145

*[13:17:41.292002][info] AutomaticInitialPairChoice, test I: 834681592, J: 1292399561, nbCommonTracks: 73

[13:17:41.293052][info] AutomaticInitialPairChoice, test I: 834681592, J: 1448473450, nbCommonTracks: 139

*[13:17:41.294144][info] AutomaticInitialPairChoice, test I: 850726783, J: 1381303897, nbCommonTracks: 118

[13:17:41.294838][info] AutomaticInitialPairChoice, test I: 850726783, J: 1444820303, nbCommonTracks: 144

*[13:17:41.296072][info] AutomaticInitialPairChoice, test I: 850726783, J: 1550435502, nbCommonTracks: 185

[13:17:41.296239][info] AutomaticInitialPairChoice, test I: 850726783, J: 1772777439, nbCommonTracks: 183

*[13:17:41.298227][info] AutomaticInitialPairChoice, test I: 886063614, J: 1627104198, nbCommonTracks: 55

*[13:17:41.300045][info] AutomaticInitialPairChoice, test I: 886063614, J: 1645771870, nbCommonTracks: 65

[13:17:41.301175][info] AutomaticInitialPairChoice, test I: 886063614, J: 1968066196, nbCommonTracks: 64

*[13:17:41.304365][info] AutomaticInitialPairChoice, test I: 929119496, J: 979414985, nbCommonTracks: 55

[13:17:41.305038][info] AutomaticInitialPairChoice, test I: 979414985, J: 1292399561, nbCommonTracks: 61

*[13:17:41.308122][info] AutomaticInitialPairChoice, test I: 1105021015, J: 1645771870, nbCommonTracks: 105

[13:17:41.308301][info] AutomaticInitialPairChoice, test I: 1170976665, J: 1442620960, nbCommonTracks: 82

*[13:17:41.310326][info] AutomaticInitialPairChoice, test I: 1309055266, J: 1979165897, nbCommonTracks: 87

*[13:17:41.310448][info] AutomaticInitialPairChoice, test I: 1309055266, J: 2024308882, nbCommonTracks: 123

[13:17:41.310964][info] AutomaticInitialPairChoice, test I: 1381303897, J: 1444820303, nbCommonTracks: 125

*[13:17:41.312325][info] AutomaticInitialPairChoice, test I: 1381303897, J: 1550435502, nbCommonTracks: 186

[13:17:41.313076][info] AutomaticInitialPairChoice, test I: 1381303897, J: 1611637874, nbCommonTracks: 104

*[13:17:41.313902][info] AutomaticInitialPairChoice, test I: 1381303897, J: 1772777439, nbCommonTracks: 161

[13:17:41.319199][info] AutomaticInitialPairChoice, test I: 1417968613, J: 2020359922, nbCommonTracks: 84

*[13:17:41.319723][info] AutomaticInitialPairChoice, test I: 1433524306, J: 1444820303, nbCommonTracks: 52

*[13:17:41.320400][info] AutomaticInitialPairChoice, test I: 1444820303, J: 1550435502, nbCommonTracks: 160

[13:17:41.322037][info] AutomaticInitialPairChoice, test I: 1444820303, J: 1772777439, nbCommonTracks: 161

*[13:17:41.323218][info] AutomaticInitialPairChoice, test I: 1448473450, J: 2020359922, nbCommonTracks: 58

*[13:17:41.326821][info] AutomaticInitialPairChoice, test I: 1550435502, J: 1611637874, nbCommonTracks: 70

[13:17:41.326905][info] AutomaticInitialPairChoice, test I: 1550435502, J: 1772777439, nbCommonTracks: 217

[13:17:41.327166][info] AutomaticInitialPairChoice, test I: 1645771870, J: 1968066196, nbCommonTracks: 66

*[13:17:41.328996][info] AutomaticInitialPairChoice, test I: 1645843344, J: 1704106311, nbCommonTracks: 62

[13:17:41.329806][info] AutomaticInitialPairChoice, test I: 1891749448, J: 1964208076, nbCommonTracks: 70

*

[13:17:41.332279][info] AutomaticInitialPairChoice, test I: 1964208076, J: 1979165897, nbCommonTracks: 125

[13:17:41.343023][info] Initial pair is:

A - view id: 1381303897 - filepath: helmets/IMG_0637.JPG

B - view id: 1772777439 - filepath: helmets/IMG_0639.JPG

[13:17:41.343181][info] 161 matches in the image pair for the initial pose estimation.

block_sparse_matrix.cc:81 Allocating values array with 42912 bytes.

detect_structure.cc:113 Schur complement static structure <2,3,6>.

detect_structure.cc:113 Schur complement static structure <2,3,6>.

[13:17:41.394729][info] Remove outliers:

- # outliers residual error: 2

- # outliers angular error: 0

block_sparse_matrix.cc:81 Allocating values array with 42624 bytes.

detect_structure.cc:113 Schur complement static structure <2,3,6>.

detect_structure.cc:113 Schur complement static structure <2,3,6>.

[13:17:41.397359][info] Remove outliers:

- # outliers residual error: 0

- # outliers angular error: 0

[13:17:41.420592][info] Initial pair is: 1381303897, 1772777439

[13:17:41.420613][info] Begin Incremental Reconstruction:

- mode: SfM augmentation

- # images in input: 60

- # images in resection: 58

- # landmarks in input: 148

- # cameras already calibrated: 2

[13:17:41.420833][info] Update Reconstruction:

- resection id: 0

- # images in the resection group: 1

- # images remaining: 58

[13:17:41.420896][info] Robust Resection of view: 22306852

[13:17:41.438519][info] Robust Resection information:

- resection status: true

- threshold (error max): 9.77288

- # points used for resection: 119

- # points validated by robust resection: 113

block_sparse_matrix.cc:81 Allocating values array with 10848 bytes.

detect_structure.cc:113 Schur complement static structure <2,6,0>.

detect_structure.cc:113 Schur complement static structure <2,6,0>.

block_sparse_matrix.cc:81 Allocating values array with 176128 bytes.

detect_structure.cc:95 Dynamic f block size because the block size changed from 6 to 7

detect_structure.cc:113 Schur complement static structure <2,3,-1>.

detect_structure.cc:95 Dynamic f block size because the block size changed from 6 to 7

detect_structure.cc:113 Schur complement static structure <2,3,-1>.

[13:17:41.516787][info] Remove outliers:

- # outliers residual error: 9

- # outliers angular error: 95

block_sparse_matrix.cc:81 Allocating values array with 124928 bytes.

detect_structure.cc:95 Dynamic f block size because the block size changed from 6 to 7

detect_structure.cc:113 Schur complement static structure <2,3,-1>.

detect_structure.cc:95 Dynamic f block size because the block size changed from 6 to 7

detect_structure.cc:113 Schur complement static structure <2,3,-1>.

[13:17:41.530648][info] Remove outliers:

- # outliers residual error: 1

- # outliers angular error: 0

[13:17:41.530673][info] Update Reconstruction complete:

- # cameras calibrated: 3

- # landmarks: 188

[13:17:41.530887][info] Update Reconstruction:

- resection id: 1

- # images in the resection group: 1

- # images remaining: 57

[13:17:41.530949][info] Robust Resection of view: 1444820303

[13:17:41.547245][info] Robust Resection information:

- resection status: true

- threshold (error max): 9.08969

- # points used for resection: 107

- # points validated by robust resection: 104

block_sparse_matrix.cc:81 Allocating values array with 9984 bytes.

detect_structure.cc:113 Schur complement static structure <2,6,0>.

detect_structure.cc:113 Schur complement static structure <2,6,0>.

block_sparse_matrix.cc:81 Allocating values array with 58624 bytes.

detect_structure.cc:95 Dynamic f block size because the block size changed from 6 to 7

detect_structure.cc:113 Schur complement static structure <2,3,-1>.

detect_structure.cc:95 Dynamic f block size because the block size changed from 6 to 7

detect_structure.cc:113 Schur complement static structure <2,3,-1>.

[13:17:41.570649][info] Remove outliers:

- # outliers residual error: 0

- # outliers angular error: 41

[13:17:41.570677][info] Poses removed from the reconstruction: {1444820303}

[13:17:41.570683][info] Update Reconstruction complete:

- # cameras calibrated: 3

- # landmarks: 44

[13:17:41.570736][info] Update Reconstruction:

- resection id: 2

- # images in the resection group: 1

- # images remaining: 56

[13:17:41.570761][info] Robust Resection of view: 1550435502

[13:17:41.576456][info] Robust Resection information:

- resection status: true

- threshold (error max): 2.98395

- # points used for resection: 25

- # points validated by robust resection: 25

block_sparse_matrix.cc:81 Allocating values array with 2400 bytes.

detect_structure.cc:113 Schur complement static structure <2,6,0>.

detect_structure.cc:113 Schur complement static structure <2,6,0>.

block_sparse_matrix.cc:81 Allocating values array with 11008 bytes.

detect_structure.cc:95 Dynamic f block size because the block size changed from 6 to 7

detect_structure.cc:113 Schur complement static structure <2,3,-1>.

detect_structure.cc:95 Dynamic f block size because the block size changed from 6 to 7

detect_structure.cc:113 Schur complement static structure <2,3,-1>.

[13:17:41.582019][info] Remove outliers:

- # outliers residual error: 0

- # outliers angular error: 9

[13:17:41.582042][info] Poses removed from the reconstruction: {22306852, 1381303897, 1550435502, 1772777439}

[13:17:41.582049][info] Update Reconstruction complete:

- # cameras calibrated: 0

- # landmarks: 0

[13:17:41.582060][info] Structure from Motion statistics:

- # input images: 60

- # cameras calibrated: 0

- # landmarks: 0

- elapsed time: 0.161

- residual RMSE: -nan

[13:17:41.582069][info] Histogram of residuals:

0 | 0

0.1 | 0

0.2 | 0

0.3 | 0

0.4 | 0

0.5 | 0

0.6 | 0

0.7 | 0

0.8 | 0

0.9 | 0

1

[13:17:41.582082][info] Histogram of tracks length:

0 | 0

0.1 | 0

0.2 | 0

0.3 | 0

0.4 | 0

0.5 | 0

0.6 | 0

0.7 | 0

0.8 | 0

0.9 | 0

1

Do you have an idea @fabiencastan , @fcastan ?

I’m running it Ubuntu 16.04 with python3.

Содержание

- [documentation] Structure from Motion result not visible #667

- Comments

- Structure from motion error (SFM) #501

- Comments

[documentation] Structure from Motion result not visible #667

Describe the bug

The Structure from Motion reconstruction result is not shown in a custom build of the Meshroom 2019.2 release using the 2019.2 prebuild dependencies (alicevision and qtplugins).

The problem is similar to #596, but the solution there did not solve my problem.

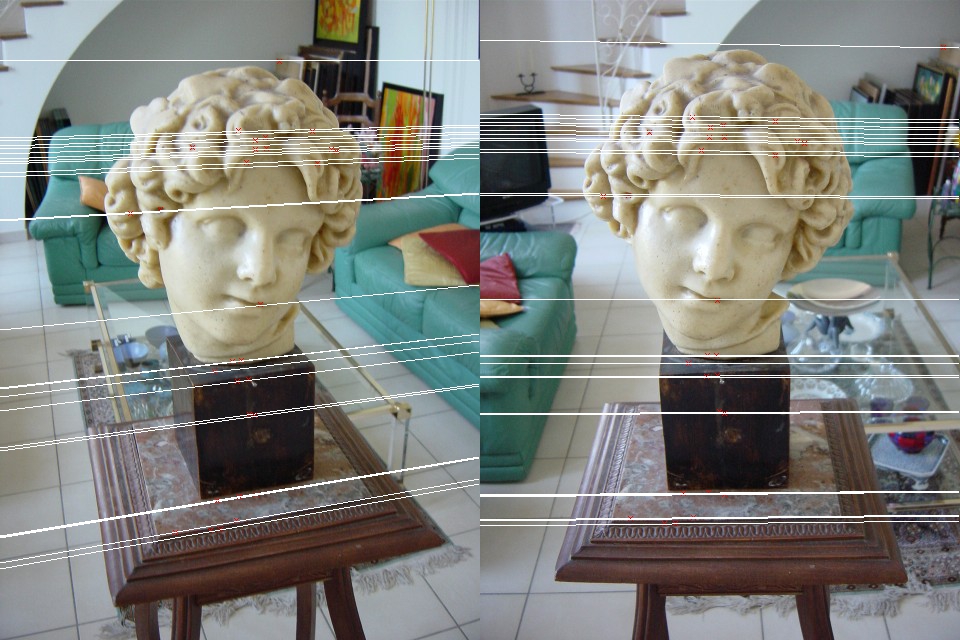

The red rectangle in the image below shows the area, where the SfM result is missing.

To Reproduce (under Linux)

- Install Miniconda for Linux

- Download the Meshroom 2019.2 Release (Prebuild) and extract it to

- Download the Meshroom 2019.2 Source Code and extract it to

- Set the alicevision paths (enter the following in the terminal)

- PATH=$PATH: /aliceVision/bin

- LD_LIBRARY_PATH=$LD_LIBRARY_PATH: /aliceVision/lib

- ALICEVISION_SENSOR_DB= /aliceVision/share/aliceVision/cameraSensors.db

- ALICEVISION_VOCTREE= /aliceVision/share/aliceVision/vlfeat_K80L3.SIFT.tree

- Set the plugin paths (enter the following in the terminal)

- QT_PLUGIN_PATH= /qtPlugins

- QML2_IMPORT_PATH= /qtPlugins/qml

- cd to

- execute PYTHONPATH=$PWD /home/ /miniconda3/bin/python meshroom/ui

- examine the right toolbar

Desktop:

- OS: Win 10 and Ubuntu 18.04

- Python version: 3.7

- PySide2 version: 5.13

- Meshroom version: Custom build using Meshroom 2019.2 source code and Meshroom 2019.2 prebuild dependencies.

Additional context

I experienced this problem under Windows 10 and Ubuntu 18.04 with the latest Meshroom version and Meshroom 2019.2. In both cases I used the Meshroom 2019.2 prebuild dependencies.

Also double clicking on the Structure from Motion node does not show the reconstruction result.

Can I verify somehow that the QmlAlembic plugin is correctly loaded?

The text was updated successfully, but these errors were encountered:

Источник

Structure from motion error (SFM) #501

I do not know why this problem is happening.

Aborted (core dumped)

[16:41:23.750140][info] Remove outliers:

— # outliers residual error: 0

— # outliers angular error: 0

[16:41:23.750155][info] Bundle adjustment iteration: 0 took 0 msec.

[16:41:23.750163][info] Bundle adjustment with 1 iterations took 0 msec.

[16:41:23.750240][info] Initial pair is:

— [A] view id: 1940125380, filepath: /home/nube7/Imágenes/Robot/IMG_20190610_121635.jpg

— [B] view id: 1982242761, filepath: /home/nube7/Imágenes/Robot/IMG_20190610_121148.jpg

[16:41:23.750392][info] 165 matches in the image pair for the initial pose estimation.

[16:41:23.791428][info] Bundle adjustment start.

[16:41:23.791480][info] Start bundle adjustment iteration: 0

block_sparse_matrix.cc:81 Allocating values array with 288 bytes.

detect_structure.cc:113 Schur complement static structure .

detect_structure.cc:113 Schur complement static structure .

[16:41:23.791783][info] Bundle Adjustment Statistics:

— local strategy enabled: no

— adjustment duration: 0.000187345 s

— poses:

— # refined: 2

— # constant: 0

— # ignored: 0

— landmarks:

— # refined: 2

— # constant: 0

— # ignored: 0

— intrinsics:

— # refined: 0

— # constant: 1

— # ignored: 1

— # residual blocks: 4

— # successful iterations: 3

— # unsuccessful iterations: 0

— initial RMSE: 1.61433

— final RMSE: 8.29304e-09

[16:41:23.791805][info] Remove outliers:

— # outliers residual error: 0

— # outliers angular error: 0

[16:41:23.791823][info] Bundle adjustment iteration: 0 took 0 msec.

[16:41:23.791830][info] Bundle adjustment with 1 iterations took 0 msec.

[16:41:23.791913][info] Initial pair is:

— [A] view id: 698926261, filepath: /home/nube7/Imágenes/Robot/IMG_20190610_121412.jpg

— [B] view id: 1982242761, filepath: /home/nube7/Imágenes/Robot/IMG_20190610_121148.jpg

[16:41:23.792100][info] 211 matches in the image pair for the initial pose estimation.

[16:41:23.838724][info] Bundle adjustment start.

[16:41:23.838767][info] Start bundle adjustment iteration: 0

[16:41:23.838866][info] Bundle Adjustment Statistics:

— local strategy enabled: no

— adjustment duration: 1.1783e-05 s

— poses:

— # refined: 2

— # constant: 0

— # ignored: 0

— landmarks:

— # refined: 0

— # constant: 0

— # ignored: 0

— intrinsics:

— # refined: 0

— # constant: 1

— # ignored: 1

— # residual blocks: 0

— # successful iterations: 18446744073709551615

— # unsuccessful iterations: 18446744073709551615

— initial RMSE: -nan

— final RMSE: -nan

[16:41:23.838894][info] Remove outliers:

— # outliers residual error: 0

— # outliers angular error: 0

[16:41:23.838910][info] Bundle adjustment iteration: 0 took 0 msec.

[16:41:23.838918][info] Bundle adjustment with 1 iterations took 0 msec.

[16:41:23.839000][info] Initial pair is:

— [A] view id: 1500024992, filepath: /home/nube7/Imágenes/Robot/IMG_20190610_121531.jpg

— [B] view id: 1886919004, filepath: /home/nube7/Imágenes/Robot/IMG_20190610_121339.jpg

[16:41:23.839152][info] 172 matches in the image pair for the initial pose estimation.

[16:41:23.880461][info] Bundle adjustment start.

[16:41:23.880507][info] Start bundle adjustment iteration: 0

[16:41:23.880611][info] Bundle Adjustment Statistics:

— local strategy enabled: no

— adjustment duration: 1.2845e-05 s

— poses:

— # refined: 2

— # constant: 0

— # ignored: 0

— landmarks:

— # refined: 0

— # constant: 0

— # ignored: 0

— intrinsics:

— # refined: 0

— # constant: 1

— # ignored: 1

— # residual blocks: 0

— # successful iterations: 18446744073709551615

— # unsuccessful iterations: 18446744073709551615

— initial RMSE: -nan

— final RMSE: -nan

[16:41:23.880630][info] Remove outliers:

— # outliers residual error: 0

— # outliers angular error: 0

[16:41:23.880646][info] Bundle adjustment iteration: 0 took 0 msec.

[16:41:23.880654][info] Bundle adjustment with 1 iterations took 0 msec.

[16:41:23.880734][info] Initial pair is:

— [A] view id: 657235584, filepath: /home/nube7/Imágenes/Robot/IMG_20190610_121230.jpg

— [B] view id: 1940125380, filepath: /home/nube7/Imágenes/Robot/IMG_20190610_121635.jpg

[16:41:23.880862][info] 139 matches in the image pair for the initial pose estimation.

[16:41:23.918820][info] Bundle adjustment start.

[16:41:23.918861][info] Start bundle adjustment iteration: 0

[16:41:23.918961][info] Bundle Adjustment Statistics:

— local strategy enabled: no

— adjustment duration: 1.1985e-05 s

— poses:

— # refined: 2

— # constant: 0

— # ignored: 0

— landmarks:

— # refined: 0

— # constant: 0

— # ignored: 0

— intrinsics:

— # refined: 0

— # constant: 1

— # ignored: 1

— # residual blocks: 0

— # successful iterations: 18446744073709551615

— # unsuccessful iterations: 18446744073709551615

— initial RMSE: -nan

— final RMSE: -nan

[16:41:23.918981][info] Remove outliers:

— # outliers residual error: 0

— # outliers angular error: 0

[16:41:23.918996][info] Bundle adjustment iteration: 0 took 0 msec.

[16:41:23.919004][info] Bundle adjustment with 1 iterations took 0 msec.

[16:41:23.919084][info] Initial pair is:

— [A] view id: 458974780, filepath: /home/nube7/Imágenes/Robot/IMG_20190610_121306.jpg

— [B] view id: 2047488158, filepath: /home/nube7/Imágenes/Robot/IMG_20190610_121509.jpg

[16:41:23.919203][info] 117 matches in the image pair for the initial pose estimation.

[16:41:23.954226][info] Bundle adjustment start.

[16:41:23.954264][info] Start bundle adjustment iteration: 0

[16:41:23.954363][info] Bundle Adjustment Statistics:

— local strategy enabled: no

— adjustment duration: 1.1679e-05 s

— poses:

— # refined: 2

— # constant: 0

— # ignored: 0

— landmarks:

— # refined: 0

— # constant: 0

— # ignored: 0

— intrinsics:

— # refined: 0

— # constant: 1

— # ignored: 1

— # residual blocks: 0

— # successful iterations: 18446744073709551615

— # unsuccessful iterations: 18446744073709551615

— initial RMSE: -nan

— final RMSE: -nan

[16:41:23.954382][info] Remove outliers:

— # outliers residual error: 0

— # outliers angular error: 0

[16:41:23.954397][info] Bundle adjustment iteration: 0 took 0 msec.

[16:41:23.954405][info] Bundle adjustment with 1 iterations took 0 msec.

[16:41:23.954496][info] Initial pair is:

— [A] view id: 698926261, filepath: /home/nube7/Imágenes/Robot/IMG_20190610_121412.jpg

— [B] view id: 1886919004, filepath: /home/nube7/Imágenes/Robot/IMG_20190610_121339.jpg

[16:41:23.954658][info] 174 matches in the image pair for the initial pose estimation.

[16:41:23.995617][info] Bundle adjustment start.

[16:41:23.995658][info] Start bundle adjustment iteration: 0

[16:41:23.995754][info] Bundle Adjustment Statistics:

— local strategy enabled: no

— adjustment duration: 1.1714e-05 s

— poses:

— # refined: 2

— # constant: 0

— # ignored: 0

— landmarks:

— # refined: 0

— # constant: 0

— # ignored: 0

— intrinsics:

— # refined: 0

— # constant: 1

— # ignored: 1

— # residual blocks: 0

— # successful iterations: 18446744073709551615

— # unsuccessful iterations: 18446744073709551615

— initial RMSE: -nan

— final RMSE: -nan

[16:41:23.995772][info] Remove outliers:

— # outliers residual error: 0

— # outliers angular error: 0

[16:41:23.995787][info] Bundle adjustment iteration: 0 took 0 msec.

[16:41:23.995795][info] Bundle adjustment with 1 iterations took 0 msec.

[16:41:23.995874][info] Initial pair is:

— [A] view id: 1886919004, filepath: /home/nube7/Imágenes/Robot/IMG_20190610_121339.jpg

— [B] view id: 2047488158, filepath: /home/nube7/Imágenes/Robot/IMG_20190610_121509.jpg

[16:41:23.996004][info] 147 matches in the image pair for the initial pose estimation.

[16:41:24.034368][info] Bundle adjustment start.

[16:41:24.034404][info] Start bundle adjustment iteration: 0

[16:41:24.034497][info] Bundle Adjustment Statistics:

— local strategy enabled: no

— adjustment duration: 1.1087e-05 s

— poses:

— # refined: 2

— # constant: 0

— # ignored: 0

— landmarks:

— # refined: 0

— # constant: 0

— # ignored: 0

— intrinsics:

— # refined: 0

— # constant: 1

— # ignored: 1

— # residual blocks: 0

— # successful iterations: 18446744073709551615

— # unsuccessful iterations: 18446744073709551615

— initial RMSE: -nan

— final RMSE: -nan

[16:41:24.034516][info] Remove outliers:

— # outliers residual error: 0

— # outliers angular error: 0

[16:41:24.034531][info] Bundle adjustment iteration: 0 took 0 msec.

[16:41:24.034539][info] Bundle adjustment with 1 iterations took 0 msec.

[16:41:24.034618][info] Initial pair is:

— [A] view id: 657235584, filepath: /home/nube7/Imágenes/Robot/IMG_20190610_121230.jpg

— [B] view id: 1982242761, filepath: /home/nube7/Imágenes/Robot/IMG_20190610_121148.jpg

[16:41:24.034764][info] 170 matches in the image pair for the initial pose estimation.

[16:41:24.075227][info] Bundle adjustment start.

[16:41:24.075267][info] Start bundle adjustment iteration: 0

[16:41:24.075372][info] Bundle Adjustment Statistics:

— local strategy enabled: no

— adjustment duration: 1.2265e-05 s

— poses:

— # refined: 2

— # constant: 0

— # ignored: 0

— landmarks:

— # refined: 0

— # constant: 0

— # ignored: 0

— intrinsics:

— # refined: 0

— # constant: 1

— # ignored: 1

— # residual blocks: 0

— # successful iterations: 18446744073709551615

— # unsuccessful iterations: 18446744073709551615

— initial RMSE: -nan

— final RMSE: -nan

[16:41:24.075391][info] Remove outliers:

— # outliers residual error: 0

— # outliers angular error: 0

[16:41:24.075407][info] Bundle adjustment iteration: 0 took 0 msec.

[16:41:24.075415][info] Bundle adjustment with 1 iterations took 0 msec.

[16:41:24.075497][info] Initial pair is:

— [A] view id: 931499951, filepath: /home/nube7/Imágenes/Robot/IMG_20190610_121604.jpg

— [B] view id: 1500024992, filepath: /home/nube7/Imágenes/Robot/IMG_20190610_121531.jpg

[16:41:24.075671][info] 207 matches in the image pair for the initial pose estimation.

[16:41:24.121893][info] Bundle adjustment start.

[16:41:24.121938][info] Start bundle adjustment iteration: 0

block_sparse_matrix.cc:81 Allocating values array with 1440 bytes.

detect_structure.cc:113 Schur complement static structure .

detect_structure.cc:113 Schur complement static structure .

[16:41:24.125030][info] Bundle Adjustment Statistics:

— local strategy enabled: no

— adjustment duration: 0.00295581 s

— poses:

— # refined: 2

— # constant: 0

— # ignored: 0

— landmarks:

— # refined: 10

— # constant: 0

— # ignored: 0

— intrinsics:

— # refined: 0

— # constant: 1

— # ignored: 1

— # residual blocks: 20

— # successful iterations: 48

— # unsuccessful iterations: 3

— initial RMSE: 1.15536

— final RMSE: 0.512205

[16:41:24.125058][info] Remove outliers:

— # outliers residual error: 0

— # outliers angular error: 0

[16:41:24.125075][info] Bundle adjustment iteration: 0 took 3 msec.

[16:41:24.125083][info] Bundle adjustment with 1 iterations took 3 msec.

[16:41:24.125171][info] Initial pair is:

— [A] view id: 458974780, filepath: /home/nube7/Imágenes/Robot/IMG_20190610_121306.jpg

— [B] view id: 931499951, filepath: /home/nube7/Imágenes/Robot/IMG_20190610_121604.jpg

[16:41:24.125308][info] 147 matches in the image pair for the initial pose estimation.

[16:41:24.163663][info] Bundle adjustment start.

[16:41:24.163704][info] Start bundle adjustment iteration: 0

[16:41:24.163810][info] Bundle Adjustment Statistics:

— local strategy enabled: no

— adjustment duration: 1.1917e-05 s

— poses:

— # refined: 2

— # constant: 0

— # ignored: 0

— landmarks:

— # refined: 0

— # constant: 0

— # ignored: 0

— intrinsics:

— # refined: 0

— # constant: 1

— # ignored: 1

— # residual blocks: 0

— # successful iterations: 18446744073709551615

— # unsuccessful iterations: 18446744073709551615

— initial RMSE: -nan

— final RMSE: -nan

[16:41:24.163829][info] Remove outliers:

— # outliers residual error: 0

— # outliers angular error: 0

[16:41:24.163845][info] Bundle adjustment iteration: 0 took 0 msec.

[16:41:24.163853][info] Bundle adjustment with 1 iterations took 0 msec.

[16:41:24.163934][info] Initial pair is:

— [A] view id: 458974780, filepath: /home/nube7/Imágenes/Robot/IMG_20190610_121306.jpg

— [B] view id: 1886919004, filepath: /home/nube7/Imágenes/Robot/IMG_20190610_121339.jpg

[16:41:24.164071][info] 152 matches in the image pair for the initial pose estimation.

[16:41:24.202841][info] Bundle adjustment start.

[16:41:24.202880][info] Start bundle adjustment iteration: 0

[16:41:24.202979][info] Bundle Adjustment Statistics:

— local strategy enabled: no

— adjustment duration: 1.2356e-05 s

— poses:

— # refined: 2

— # constant: 0

— # ignored: 0

— landmarks:

— # refined: 0

— # constant: 0

— # ignored: 0

— intrinsics:

— # refined: 0

— # constant: 1

— # ignored: 1

— # residual blocks: 0

— # successful iterations: 18446744073709551615

— # unsuccessful iterations: 18446744073709551615

— initial RMSE: -nan

— final RMSE: -nan

[16:41:24.202998][info] Remove outliers:

— # outliers residual error: 0

— # outliers angular error: 0

[16:41:24.203014][info] Bundle adjustment iteration: 0 took 0 msec.

[16:41:24.203022][info] Bundle adjustment with 1 iterations took 0 msec.

[16:41:24.203105][info] Initial pair is:

— [A] view id: 1886919004, filepath: /home/nube7/Imágenes/Robot/IMG_20190610_121339.jpg

— [B] view id: 1940125380, filepath: /home/nube7/Imágenes/Robot/IMG_20190610_121635.jpg

[16:41:24.203234][info] 140 matches in the image pair for the initial pose estimation.

[16:41:24.240227][info] Bundle adjustment start.

[16:41:24.240264][info] Start bundle adjustment iteration: 0

[16:41:24.240361][info] Bundle Adjustment Statistics:

— local strategy enabled: no

— adjustment duration: 1.206e-05 s

— poses:

— # refined: 2

— # constant: 0

— # ignored: 0

— landmarks:

— # refined: 0

— # constant: 0

— # ignored: 0

— intrinsics:

— # refined: 0

— # constant: 1

— # ignored: 1

— # residual blocks: 0

— # successful iterations: 18446744073709551615

— # unsuccessful iterations: 18446744073709551615

— initial RMSE: -nan

— final RMSE: -nan

[16:41:24.240391][info] Remove outliers:

— # outliers residual error: 0

— # outliers angular error: 0

[16:41:24.240406][info] Bundle adjustment iteration: 0 took 0 msec.

[16:41:24.240414][info] Bundle adjustment with 1 iterations took 0 msec.

[16:41:24.240496][info] Initial pair is:

— [A] view id: 1940125380, filepath: /home/nube7/Imágenes/Robot/IMG_20190610_121635.jpg

— [B] view id: 2047488158, filepath: /home/nube7/Imágenes/Robot/IMG_20190610_121509.jpg

[16:41:24.240640][info] 163 matches in the image pair for the initial pose estimation.

[16:41:24.280400][info] Bundle adjustment start.

[16:41:24.280438][info] Start bundle adjustment iteration: 0

[16:41:24.280535][info] Bundle Adjustment Statistics:

— local strategy enabled: no

— adjustment duration: 1.1726e-05 s

— poses:

— # refined: 2

— # constant: 0

— # ignored: 0

— landmarks:

— # refined: 0

— # constant: 0

— # ignored: 0

— intrinsics:

— # refined: 0

— # constant: 1

— # ignored: 1

— # residual blocks: 0

— # successful iterations: 18446744073709551615

— # unsuccessful iterations: 18446744073709551615

— initial RMSE: -nan

— final RMSE: -nan

[16:41:24.280554][info] Remove outliers:

— # outliers residual error: 0

— # outliers angular error: 0

[16:41:24.280569][info] Bundle adjustment iteration: 0 took 0 msec.

[16:41:24.280576][info] Bundle adjustment with 1 iterations took 0 msec.

terminate called after throwing an instance of ‘std::runtime_error’

what(): Initialization failed after trying all possible initial image pairs.

Aborted (core dumped)

The text was updated successfully, but these errors were encountered:

Источник

Время прочтения

10 мин

Просмотры 16K

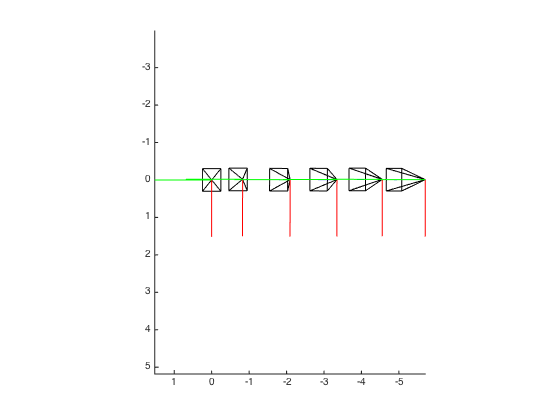

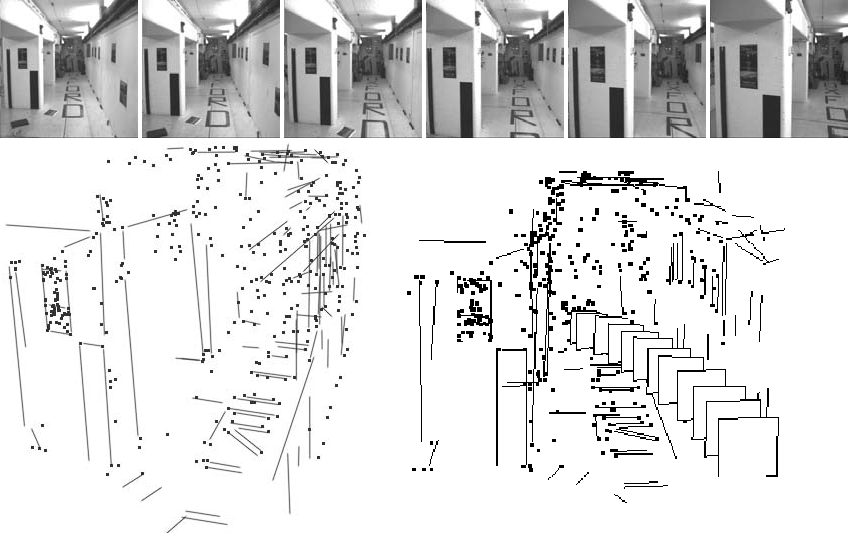

Если посмотреть на последовательность кадров, в которых движется камера, то мозг легко воспринимает геометрическую структуру содержимого. Однако, в компьютерном зрении это не тривиальная проблема. В этой статье я постараюсь описать возможное решение этой задачи.

Перед прочтением этой статьи не помешает внимательно прочитать статью «Основы стереозрения».

Итак, перед нами стоит задача превращения последовательности двумерных изображений в трехмерную структуру. Задача это не простая, и нужно ее упрощать.

Во-первых, предположим, что кадра у нас только два. Обозначим их как A и B.

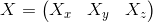

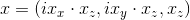

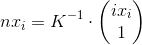

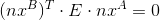

Во-вторых, будем работать с конечным множеством точек, соответствующих друг другу на кадрах A и B. Точки на изображении обозначим как

Теперь необходимо определиться как искать

А теперь мы подошли к центральному вопросу этой статьи: как из точек

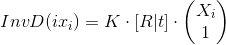

Модель проективной камеры

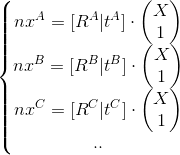

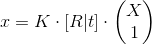

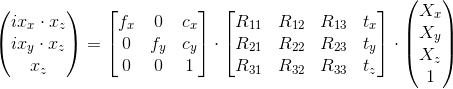

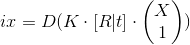

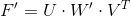

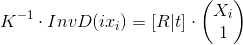

Так как вы, вероятно, уже прочитали статью «Основы стереозрения», эта формула должна быть знакома:

Или если описать более полно:

Здесь X — это трехмерная точка в пространстве.

x — это координата точки на изображении в однородных координатах, и

Процесс перевода точки в пространстве в координаты изображения можно разбить на два этапа, реализуемыми двумя матрицами в формуле:

- [R|t] — R и t представляют собой положение камеры в пространстве. На этом этапе координаты точек переводятся в локальные координаты камеры. R — матрица поворота размером 3×3, t — трехмерный вектор смещения — вместе они составляют матрицу перехода [R|t] (размером 3×4), она определяет положение камеры в кадре. [R|t] — эта то же, что и видовая матрица в трехмерной графике (если не брать в расчет, что она имеет размер не 4×4).

— это матрица поворота камеры,

— трехмерные координаты точки расположения камеры в пространстве. R и t называют внешними параметрами камеры.

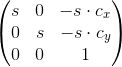

- K — матрица камеры. Локальные координаты точек переводятся в однородные координаты изображения. fx, fy — фокальное расстояние в пикселях, cx, cy — оптический центр камеры (обычно это координаты центра изображения). Эти параметры называют внутренними параметрами камеры.

Важным свойством этой модели является то, что точки лежащие на одной прямой в пространстве будут также лежать на одной прямой на изображении.

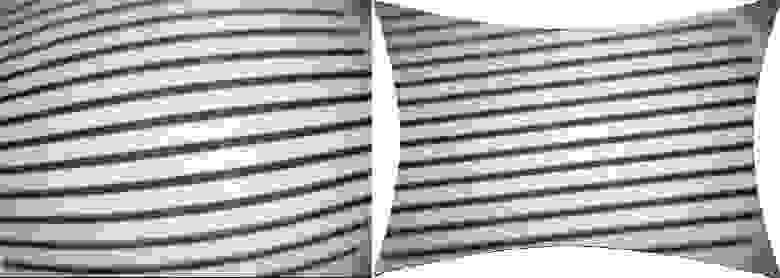

На самом деле, описываемая модель может быть очень неточной. В реальных камерах вступают в игру линзовые искажения, из-за которых прямые линии становятся кривыми. Это искажение называются дисторсией. Существуют разные модели, исправляющие эти искажения. Здесь есть некоторые их реализации. Параметры этой модели также входит в понятие внутренних параметров камеры.

С учетом дисторсии наша формула усложняется:

Внутренние параметры камеры должны быть известны заранее. Выяснение этих параметров — это отдельная тема, будем считать, что они уже есть.

Искажения дисторсии не зависит от глубины видимых точек, а только координат на изображении. А значит «исправить» изображение (получив прямые линии там, где они и должны быть) можно не зная внешних параметров камеры и координат точек в пространстве. Дальше тогда можно использовать модель камеры без функции D.

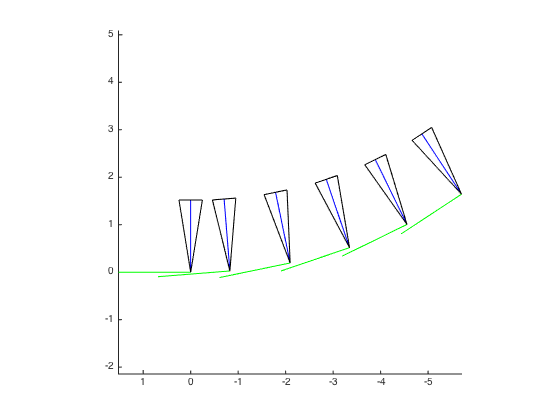

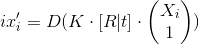

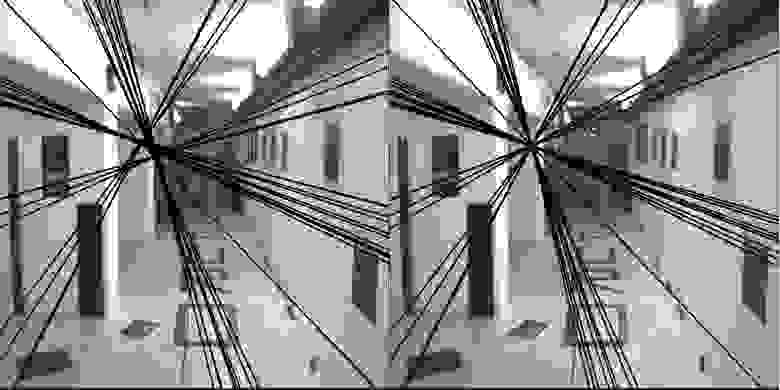

Изображение с дисторсией слева, и справа — «исправленное» от линзовых искажений изображение. Видно, что линии стали прямыми.

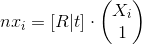

Нормализация точек

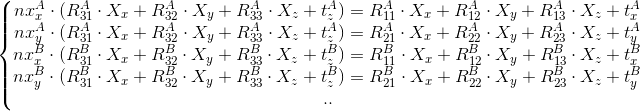

Мы договорились, что внутренние параметры нам известны, известны и координаты точек на изображении, а значит, остается найти [R|t] и Xi (положения камеры и точек в пространстве).

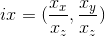

Наша формула выходит уже немного сложной, надо ее упрощать. Для начала сделаем так:

Выражение остается справедливым. Продолжим:

Обозначим

nxi — это нормализованные точки изображения.

Фундаментальная и сущностная матрицы

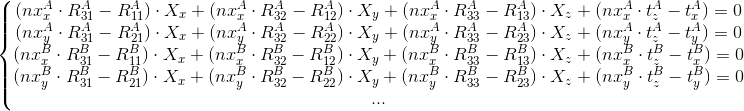

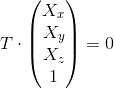

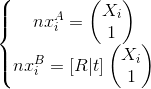

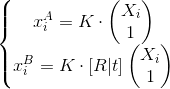

Итак, предположим, у нас есть два изображения, полученные от одной камеры. Нам неизвестны положения камер и координаты точек в пространстве. Договоримся ввести расчеты относительно первого кадра. Так получается, что RA = I (I — единичная матрица), tA = (0, 0, 0). Положение камеры в кадре B обозначим просто как R и t (т. е. RB = R, tB = t). [R|t] — это матрица координат второго кадра, и оно же — матрица смещения положения камеры от кадра A к кадру B. В итоге имеем получаем такую систему (без учета дисторсии!):

Используя фундаментальную матрицу F (fubdamental matrix), получим такое уравнение:

Также заметим, что F имеет размер 3х3 и должна иметь ранг равный 2.

Из фундаментальной матрицы F уже можно получить необходимые нам R и t. Однако дисторсия все портит, с ее учетом зависимость точек между кадрами будет нелинейная, и это уже не будет работать.

Но перейдем к нормализованным точкам и используем сущностную матрицу E (essential matrix). Все будет почти тем же, но проще:

А тут мы можем спокойно брать в расчет дисторсию.

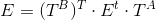

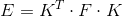

Фундаментальная и сущностная матрицы связаны таким образом:

Теперь перед нами встала задача нахождения либо фундаментальной матрицы F, либо сущностной матрицы E, из которой позже сможем получить на R и t.

Вычисление сущностной матрицы (8-ми точечный алгоритм)

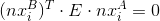

Вернемся к уравнению:

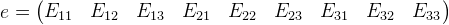

Эту же формулу можно переписать в таком виде (вспоминаем, что

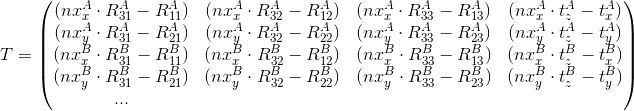

Введем вектор e и матрицу M:

Тогда всю систему уравнений можно представить в виде:

Получаем однородную систему уравнений, решив которую, получим E из е. Очевидным решением здесь является нулевой вектор, но нас явно интересует не он. Для решения необходимо минимум 8 точек.

Решение систем однородных уравнений при помощи сингулярного разложения

Сингулярное разложение — это декомпозиция матрицы, приводящее ее к такому виду:

Итак, было дано уравнение вида:

Строки VT, которым соответствует нулевой диагональный элемент W на этой же строке, являются нуль-пространствами матрицы M, т. е. в данном случае являются линейно-независимыми решениями нашей системы. А так как элементы W располагаются в порядке убывания, то смотреть нужно последний элемент матрицы W. И решением будет последняя строка

При расчете сущностной матрицы, используя 8 точек, последний элемент матрицы W должен быть равен нулю — W99=0, но на практике, в следствии ошибок, там будет какое-то ненулевое значение, и по величине этого значения можно оценить величину этой ошибки. При этом мы получим лучшее решение.

Тем не менее, найденное нами решение — не единственное, более того, решений будет бесконечно много. Если умножить найденное решение на какой-либо коэффициент, оно все-равно останется решением. Таким образом в уравнении спрятался коэффициент s (который может быть любым):

Правда, все эти решения будут линейно зависимыми, а интересовать нас будет только одно из них.

Отсюда и матрица E может также масштабироваться. Вот только расчеты ведутся в однородном пространстве и, как следствие, от масштабирования (т. е. от коэффициента s) не зависят.

Наверное, стоит масштабировать получившуюся матрицу E так, чтобы E33 = 1.

Вычисление сущностной матрицы (7-ми точечный алгоритм)

Можно обойтись и 7-ю точками.

Если мы возьмем только 7 точек, то M будет матрицей размером 7×9.

Вернемся к выражению:

W — будет также матрицей размером 9×9, как и раньше, но теперь не только W99 будет равно нулю (ну опять же без учета ошибок вычислений), но и W88. Это значит, что имеем два линейно-независимых решения уравнения

Сущностная матрица, как и фундаментальная, должна иметь ранг равный двум, а так как она имеем размер 3×3, то значит определитель матрицы равен 0 —

Расписывать решение этого уравнения я не буду (оно объемное, ну и считайте это домашним заданием). В крайнем случае можете просто посмотреть сразу реализацию в opencv.

Уточнение сущностной (фундаментальной) матрицы

Так как все в этом мире несовершенно, то мы будем постоянно получать ошибки, с которыми нам необходимо бороться. Так сущностная матрица должна иметь ранг равный 2 и следовательно

Чтобы увидеть в чем это выражается, возьмем фундаментальную матрицу. Сущностная матрица / фундаментальная матрица — разница лишь в том, с какими точками мы работаем (нормализованными или точками на изображении).

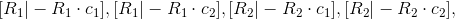

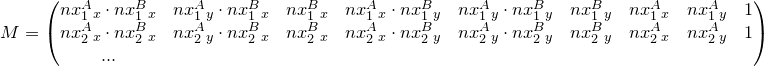

Луч, выпущенный из точки кадра A, ляжет в кадр B как прямая линия (или не совсем из-за дисторсии, но забудем про нее). Допустим матрица F — это фундаментальная матрица кадров A и B (

Тогда если выпустить луч из точки

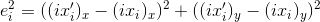

На картинке изображен пример эпиполярных линий, полученных из правильной фундаментальной матрицы (ранг которой равен 2, картинка справа) и неправильной (слева).

Чтобы получить правильную фундаментальную матрицу, воспользуемся свойством сингулярного разложения — приближать матрицу к заданному рангу:

Тогда исправленный вариант:

Ровно тот же принцип работает и для сущностной матрицы.

Нормализованная версия алгоритма

Чтобы уменьшить ошибку, получаемую при расчетах, точки трансформируют к определенному ввиду. Выбираются такие матрицы TA и TB, которые (каждый независимо и на своем кадре) смещают среднюю координату точек в точку (0, 0) и масштабируют так, чтобы средняя дистанция дистанция до центра была равна

А матрицы TA, B имеют вид:

После этого вычисляем сущностную матрицу как обычно. После необходимо ее уточнить, как было описано выше. Обозначим полученную матрицу как Et.

Итоговая сущностная матрица —

В итоге:

Опять же, если необходимо найти фундаментальную матрицу, все принципы сохраняются.

Получение положения камеры из сущностной матрицы

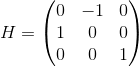

Введем матрицу H:

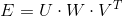

Используем сингулярное разложение на сущностной матрице:

Тогда получаем такие решения:

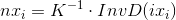

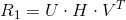

Нам же необходимо положение камеры в локальных координатах самой камеры:

Выходит четыре решения:

В случае 8-ми точечного алгоритма, выбираем из 4-ёх решений. В случае 7-ми точечного алгоритма, выйдет три сущностные матрицы, из которых получится 12 решений. Выбрать нужно только одно, то, которое будет давать меньше ошибок.

Вырожденные случаи

Снова вернемся к вычислению сущностной матрицы. У нас было уравнение:

Далее мы его решали при помощи сингулярного разложения:

Решения данного уравнения зависит от ранга матрицы W, ну или от количества нулей в диагонали этой матрицы (мы же помним, что это отражает ранг матрицы). Вот только с учетом погрешности, считаем нулем в данном случае число, достаточно близкое к нулю.

Имеем такие варианты:

- Нулей нет. Нет решений, вероятно ошибка вышла слишком большой.

- Один нуль. Одно решение, случай при котором число точек больше, либо равно восьми.

- Два нуля. Одно или три решения. Использовалось семь или более точек.

- Три нуля. Тогда должно быть верно условие

. Такое возможно, если камера не смещалась от кадра к кадру, был только поворот, т. е. t = (0, 0, 0). Либо все точки лежат на одной плоскости. Во втором случае еще есть возможность найти координаты этих точек и положение камеры, но уже другими способами.

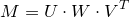

Вычисление координат точек в пространстве

Допустим сейчас у нас есть больше, чем два кадра — A, B, C, …

Необходимо найти точку

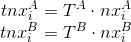

Представим эту систему так:

В матричном виде:

С помощью сингулярного разложения находим вектор

Оценочная функция

Оценочные функции (cost functions) необходимы, чтобы получив какие-то результаты, оценить насколько достоверными они являются, или сравнить их с другими.

Возьмем нашу модель:

Отсюда квадрат ошибки для i-ой точки будет:

На практике одни точки будут давать более достоверные результаты, чем другие. А некоторые вообще явно будут давать неправильные. В результате возникает необходимость выбрать из общего массива точек только те точки, которым можно доверять, а остальные просто выбросить из расчетов.

Самый простой способ выбрать “достоверные” точки — выбрать какой-то лимит (допустим, 5 пикселей), и брать только те точки, которые дают ошибку меньше этого лимита (

Таким образом, можно ввести оценочную функцию — количество достоверных точек. И при сравнении, выбирать тот результат, который дает большее количество “достоверных” точек.

А можно воспользоваться другим, более “тонкой” функцией:

Лучшим будет тот вариант, который будет давать меньшее значение. Понятно, что и здесь следует убирать “недостоверные” точки для будущих расчетов.

Метод RANSAC

- При вычислении сущностной матрицы необходимо отбрасывать “недостоверные” точки, так как они приводят в существенным ошибкам в расчетах. Определить набор подходящих точек можно при помощи алгоритма RANSAC.

Повторяем цикл заданное количество раз (например, 100, 400):- Выбираем случайным образом минимальный набор точек для расчетов (у нас это 7);

- Вычисляем сущностные матрицы из этого набора (напоминаю, может получится либо одна матрица, либо три)

- Оценочной функцией вычисляем достоверность каждой матрицы

- Из предыдущего цикла выбираем сущностную матрицу, которая дает лучший результат;

- Выбираем точки для расчетов, которые дают ошибку при полученной сущностной матрице ошибку меньше заданного порога;

- Из полученного набора точек вычисляем итоговую сущностную матрицу.

Общий алгоритм

- Находим «особенные» точки на первом кадре

- Определяем точки-соответствия между двумя изображениями.

- Находим сущностную (или все-же фундаментальную) матрицу, соответствующую этим двум изображениям при помощи RANSAC.

- У нас будет одно или три решения, из которых получим 4 или 12 возможных матриц [R|t]. Имея положение камер в обоих кадрах, рассчитываем координаты точек в пространстве для каждой возможной матрицы. Из них выбираем лучшую, используя оценочную функцию.

Что дальше?

Изначально мы исходили из предположения, что кадра у нас было всего два.

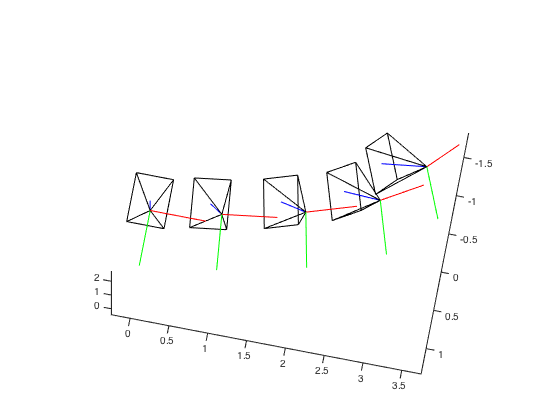

Чтобы работать с последовательностью кадров, нужно просто разбить последовательность на последовательные пары кадров. Обрабатывая пары кадров, мы получаем смещение камеры от одного кадра к другому. Из этого можно получить координаты положения камеры в остальных кадрах.

Получив главное — положения камер, можно действовать по-разному:

- По точкам-соответствиям получить трехмерные координаты точек в пространстве, выйдет облако точек, которое можно превратить в трехмерную модель

- Использовать фундаментальную матрицу для расчета карты глубины.

- При помощи двух кадров инициализировать карту для SLAM, используя рассчитанные координаты точек в пространстве, можно проще и быстрее получить координаты положения в следующих кадрах.

- ну и другое

В общем, действовать можно по-разному, применяя разные методы, в том числе и те алгоритмы, которые были описаны — не единственные.

Литература

Fundamental matrix, Essential matrix, Eight-point algorithm — больше информации в википедии

Hartley, Zisserman — Multiple View Geometry in Computer Vision — спонсор этой статьи

Meshroom: Ошибка PrepareDenseScene

в моем реальном проекте ячеистой сети у меня проблема, не знаю, как исправить. Он всегда останавливается на PrepareDenseScene с ошибкой. Самое безумное в том, что если раньше я не был в безопасности, он работает идеально. Удалял кеш, перезагрузка .

Но когда я его сохраняю, он останавливается на ошибке в том же месте.

Программа вызывается со следующими параметрами:

- input = «D: / Photogrametrie / 3D Scans / 609er / 609er außen / MeshroomCache / StructureFromMotion / a3aa525f03aa662cecda8b17531a7b52a3f53b85 / sfm.abc»

- output = «D: / Photogrametrie / 3D Scans / 609er / 609er außen / MeshroomCache / PrepareDenseScene / 1b844eef8f1e27a3c408a5ecb7d35a037414cf34»

- outputFileType = «exr»

- rangeSize = 26

- rangeStart = 0

- saveMatricesTxtFiles = 0

- saveMetadata = 1

- verboseLevel = «информация»

Экспорт неискаженных изображений сцены

0% 10 20 30 40 50 60 70 80 90100%

| —- | —- | —- | —- | —- | —- | —- | —- | —- | —- |

Все 3 Комментарий

Проблема все еще возникает, если вы удалите пробел в «609er außen»? О, и у вас есть еще один в «3D-сканировании»

Также ß может вызвать проблемы

Когда я это прочитал, я понял, что вы правы. Точно было название папки. В 3D-сканировании есть еще несколько. Так что с пространством это работает, но «ß» было слишком много.

Источник

Prepare DenseScene Fails #396

Comments

Thorngage commented Feb 12, 2019

Hi, I managed to import the images and start the process, but it stops and fails at the Prepare Dense Scene Node