Линейная регрессия используется для поиска линии, которая лучше всего «соответствует» набору данных.

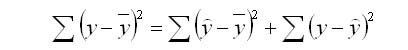

Мы часто используем три разных значения суммы квадратов , чтобы измерить, насколько хорошо линия регрессии действительно соответствует данным:

1. Общая сумма квадратов (SST) – сумма квадратов разностей между отдельными точками данных (y i ) и средним значением переменной ответа ( y ).

- SST = Σ(y i – y ) 2

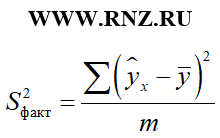

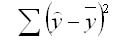

2. Регрессия суммы квадратов (SSR) – сумма квадратов разностей между прогнозируемыми точками данных (ŷ i ) и средним значением переменной ответа ( y ).

- SSR = Σ(ŷ i – y ) 2

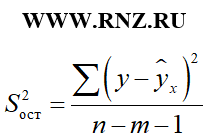

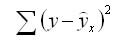

3. Ошибка суммы квадратов (SSE) – сумма квадратов разностей между предсказанными точками данных (ŷ i ) и наблюдаемыми точками данных (y i ).

- SSE = Σ(ŷ i – y i ) 2

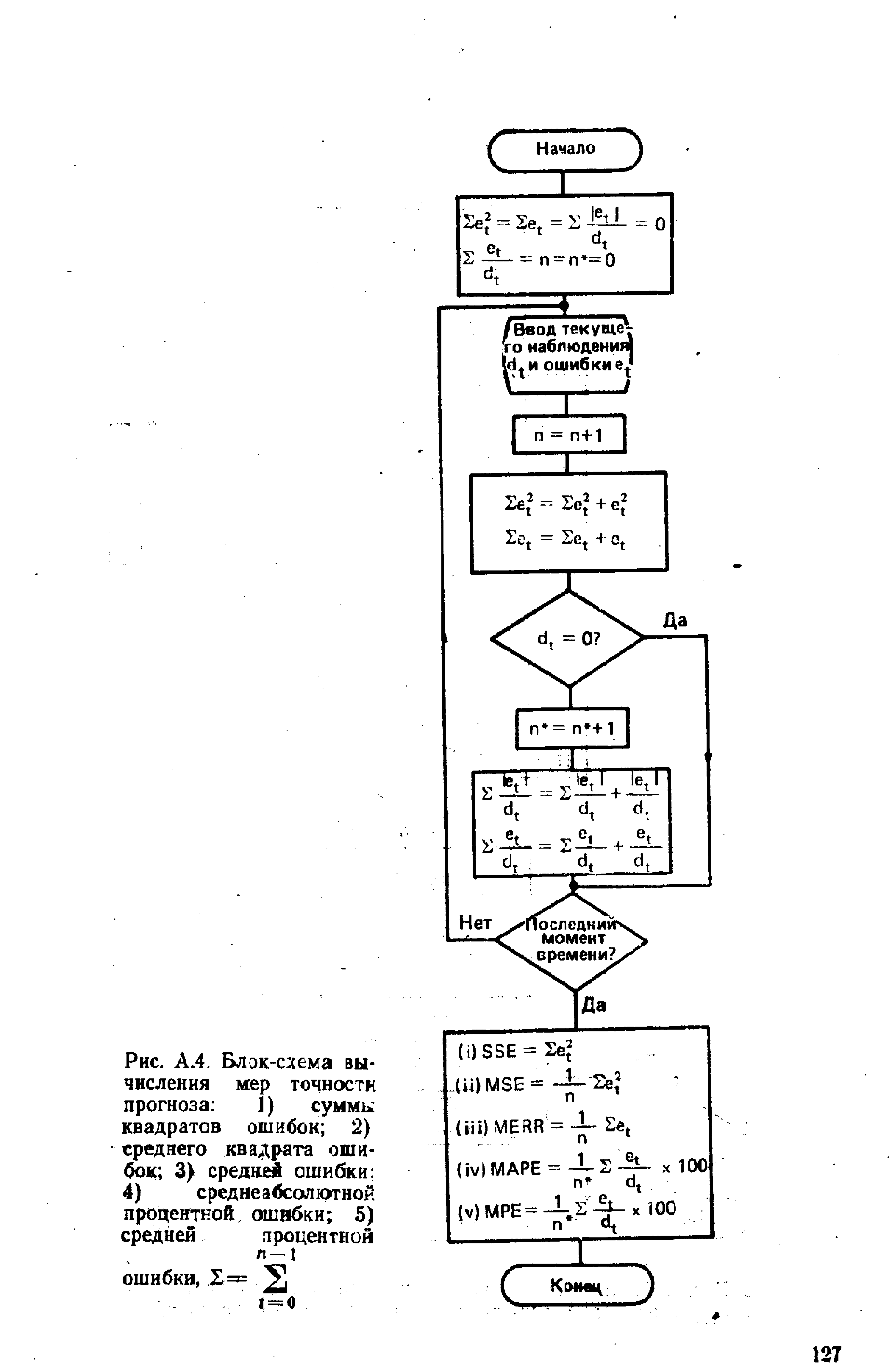

Между этими тремя показателями существует следующая зависимость:

SST = SSR + SSE

Таким образом, если мы знаем две из этих мер, мы можем использовать простую алгебру для вычисления третьей.

SSR, SST и R-квадрат

R-квадрат , иногда называемый коэффициентом детерминации, является мерой того, насколько хорошо модель линейной регрессии соответствует набору данных. Он представляет собой долю дисперсии переменной отклика , которая может быть объяснена предикторной переменной.

Значение для R-квадрата может варьироваться от 0 до 1. Значение 0 указывает, что переменная отклика вообще не может быть объяснена предикторной переменной. Значение 1 указывает, что переменная отклика может быть полностью объяснена без ошибок с помощью переменной-предиктора.

Используя SSR и SST, мы можем рассчитать R-квадрат как:

R-квадрат = SSR / SST

Например, если SSR для данной модели регрессии составляет 137,5, а SST — 156, тогда мы рассчитываем R-квадрат как:

R-квадрат = 137,5/156 = 0,8814

Это говорит нам о том, что 88,14% вариации переменной отклика можно объяснить переменной-предиктором.

Расчет SST, SSR, SSE: пошаговый пример

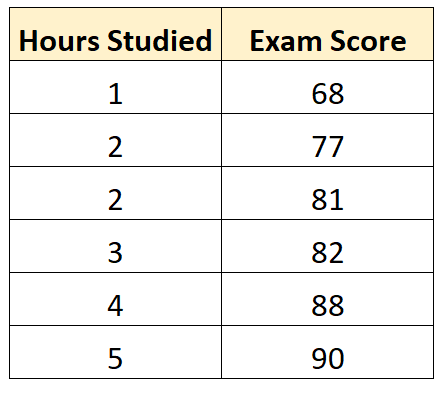

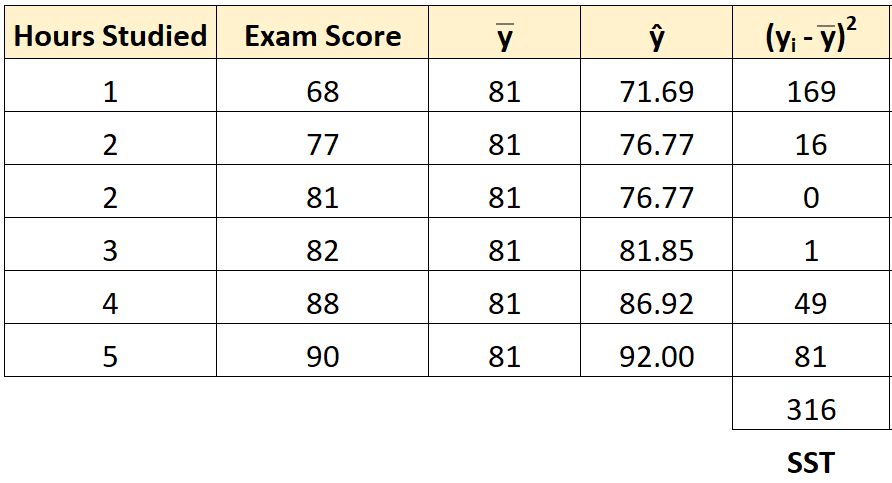

Предположим, у нас есть следующий набор данных, который показывает количество часов, отработанных шестью разными студентами, а также их итоговые оценки за экзамены:

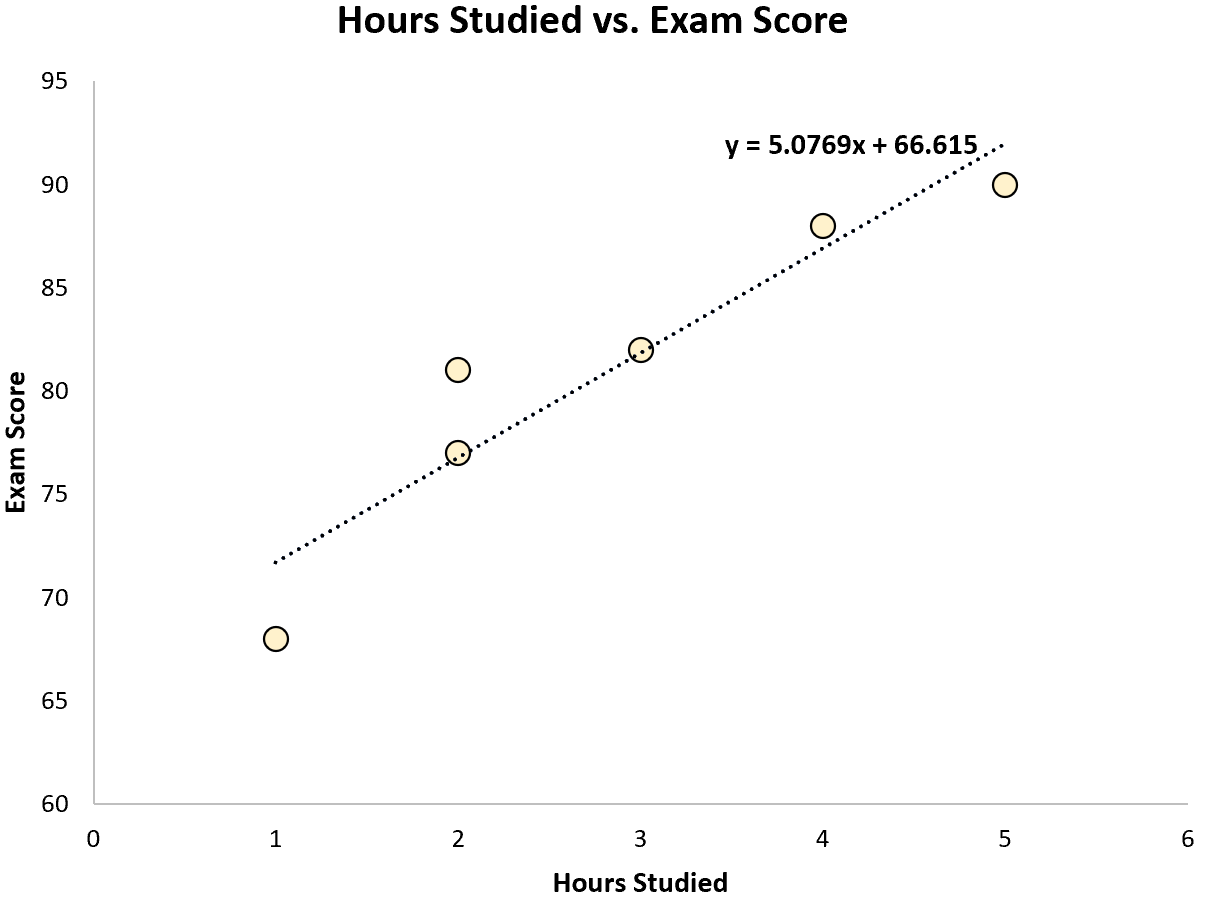

Используя некоторое статистическое программное обеспечение (например, R , Excel , Python ) или даже вручную , мы можем найти, что линия наилучшего соответствия:

Оценка = 66,615 + 5,0769 * (часы)

Как только мы узнаем строку уравнения наилучшего соответствия, мы можем использовать следующие шаги для расчета SST, SSR и SSE:

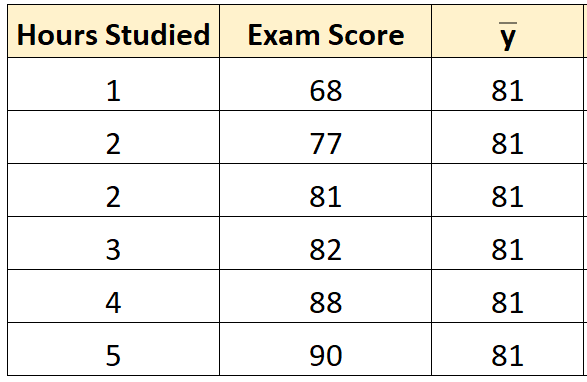

Шаг 1: Рассчитайте среднее значение переменной ответа.

Среднее значение переменной отклика ( y ) оказывается равным 81 .

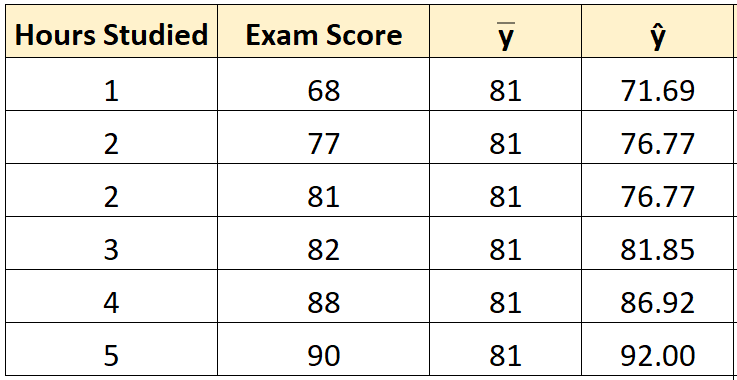

Шаг 2: Рассчитайте прогнозируемое значение для каждого наблюдения.

Затем мы можем использовать уравнение наилучшего соответствия для расчета прогнозируемого экзаменационного балла () для каждого учащегося.

Например, предполагаемая оценка экзамена для студента, который учился один час, такова:

Оценка = 66,615 + 5,0769*(1) = 71,69 .

Мы можем использовать тот же подход, чтобы найти прогнозируемый балл для каждого ученика:

Шаг 3: Рассчитайте общую сумму квадратов (SST).

Далее мы можем вычислить общую сумму квадратов.

Например, сумма квадратов для первого ученика равна:

(y i – y ) 2 = (68 – 81) 2 = 169 .

Мы можем использовать тот же подход, чтобы найти общую сумму квадратов для каждого ученика:

Сумма квадратов получается 316 .

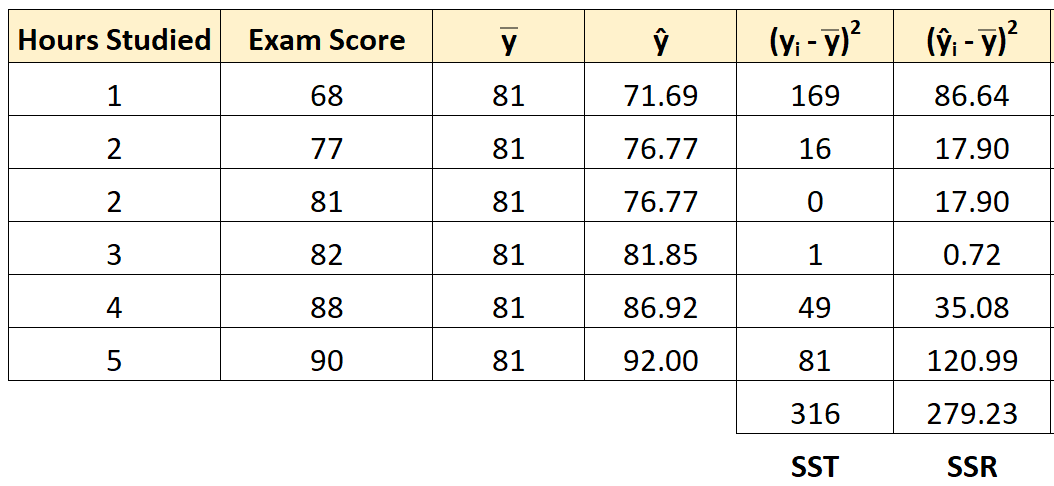

Шаг 4: Рассчитайте регрессию суммы квадратов (SSR).

Далее мы можем вычислить сумму квадратов регрессии.

Например, сумма квадратов регрессии для первого ученика равна:

(ŷ i – y ) 2 = (71,69 – 81) 2 = 86,64 .

Мы можем использовать тот же подход, чтобы найти сумму квадратов регрессии для каждого ученика:

Сумма квадратов регрессии оказывается равной 279,23 .

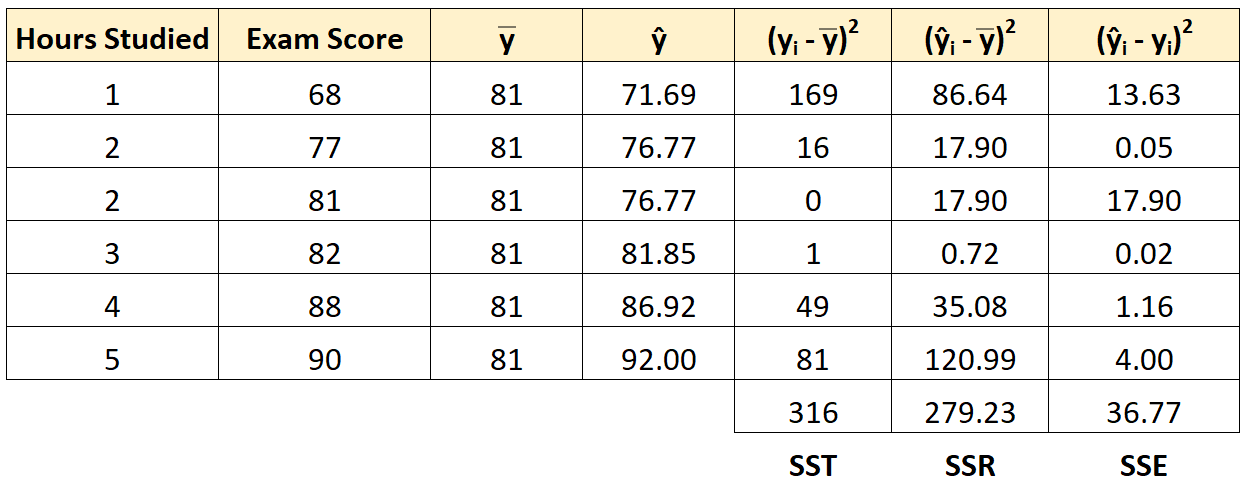

Шаг 5: Рассчитайте ошибку суммы квадратов (SSE).

Далее мы можем вычислить сумму квадратов ошибок.

Например, ошибка суммы квадратов для первого ученика:

(ŷ i – y i ) 2 = (71,69 – 68) 2 = 13,63 .

Мы можем использовать тот же подход, чтобы найти сумму ошибок квадратов для каждого ученика:

Мы можем проверить, что SST = SSR + SSE

- SST = SSR + SSE

- 316 = 279,23 + 36,77

Мы также можем рассчитать R-квадрат регрессионной модели, используя следующее уравнение:

- R-квадрат = SSR / SST

- R-квадрат = 279,23/316

- R-квадрат = 0,8836

Это говорит нам о том, что 88,36% вариаций в экзаменационных баллах можно объяснить количеством часов обучения.

Дополнительные ресурсы

Вы можете использовать следующие калькуляторы для автоматического расчета SST, SSR и SSE для любой простой линии линейной регрессии:

Калькулятор ТПН

Калькулятор ССР

Калькулятор SSE

Download Article

Download Article

The sum of squared errors, or SSE, is a preliminary statistical calculation that leads to other data values. When you have a set of data values, it is useful to be able to find how closely related those values are. You need to get your data organized in a table, and then perform some fairly simple calculations. Once you find the SSE for a data set, you can then go on to find the variance and standard deviation.

-

1

Create a three column table. The clearest way to calculate the sum of squared errors is begin with a three column table. Label the three columns as

,

, and

.[1]

-

2

Fill in the data. The first column will hold the values of your measurements. Fill in the

column with the values of your measurements. These may be the results of some experiment, a statistical study, or just data provided for a math problem.[2]

- In this case, suppose you are working with some medical data and you have a list of the body temperatures of ten patients. The normal body temperature expected is 98.6 degrees. The temperatures of ten patients are measured and give the values 99.0, 98.6, 98.5, 101.1, 98.3, 98.6, 97.9, 98.4, 99.2, and 99.1. Write these values in the first column.

Advertisement

-

3

Calculate the mean. Before you can calculate the error for each measurement, you must calculate the mean of the full data set.[3]

-

4

Calculate the individual error measurements. In the second column of your table, you need to fill in the error measurements for each data value. The error is the difference between the measurement and the mean.[4]

- For the given data set, subtract the mean, 98.87, from each measured value, and fill in the second column with the results. These ten calculations are as follows:

-

5

Calculate the squares of the errors. In the third column of the table, find the square of each of the resulting values in the middle column. These represent the squares of the deviation from the mean for each measured value of data.[5]

- For each value in the middle column, use your calculator and find the square. Record the results in the third column, as follows:

-

6

Add the squares of errors together. The final step is to find the sum of the values in the third column. The desired result is the SSE, or the sum of squared errors.[6]

- For this data set, the SSE is calculated by adding together the ten values in the third column:

Advertisement

-

1

Label the columns of the spreadsheet. You will create a three column table in Excel, with the same three headings as above.

- In cell A1, type in the heading “Value.”

- In cell B1, enter the heading “Deviation.»

- In cell C1, enter the heading “Deviation squared.”

-

2

Enter your data. In the first column, you need to type in the values of your measurements. If the set is small, you can simply type them in by hand. If you have a large data set, you may need to copy and paste the data into the column.

-

3

Find the mean of the data points. Excel has a function that will calculate the mean for you. In some vacant cell underneath your data table (it really doesn’t matter what cell you choose), enter the following:[7]

- =Average(A2:___)

- Do not actually type a blank space. Fill in that blank with the cell name of your last data point. For example, if you have 100 points of data, you will use the function:

- =Average(A2:A101)

- This function includes data from A2 through A101 because the top row contains the headings of the columns.

- When you press Enter or when you click away to any other cell on the table, the mean of your data values will automatically fill the cell that you just programmed.

-

4

Enter the function for the error measurements. In the first empty cell in the “Deviation” column, you need to enter a function to calculate the difference between each data point and the mean. To do this, you need to use the cell name where the mean resides. Let’s assume for now that you used cell A104.[8]

- The function for the error calculation, which you enter into cell B2, will be:

- =A2-$A$104. The dollar signs are necessary to make sure that you lock in cell A104 for each calculation.

- The function for the error calculation, which you enter into cell B2, will be:

-

5

Enter the function for the error squares. In the third column, you can direct Excel to calculate the square that you need.[9]

- In cell C2, enter the function

- =B2^2

- In cell C2, enter the function

-

6

Copy the functions to fill the entire table. After you have entered the functions in the top cell of each column, B2 and C2 respectively, you need to fill in the full table. You could retype the function in every line of the table, but this would take far too long. Use your mouse, highlight cells B2 and C2 together, and without letting go of the mouse button, drag down to the bottom cell of each column.

- If we are assuming that you have 100 data points in your table, you will drag your mouse down to cells B101 and C101.

- When you then release the mouse button, the formulas will be copied into all the cells of the table. The table should be automatically populated with the calculated values.

-

7

Find the SSE. Column C of your table contains all the square-error values. The final step is to have Excel calculate the sum of these values.[10]

- In a cell below the table, probably C102 for this example, enter the function:

- =Sum(C2:C101)

- When you click Enter or click away into any other cell of the table, you should have the SSE value for your data.

- In a cell below the table, probably C102 for this example, enter the function:

Advertisement

-

1

Calculate variance from SSE. Finding the SSE for a data set is generally a building block to finding other, more useful, values. The first of these is variance. The variance is a measurement that indicates how much the measured data varies from the mean. It is actually the average of the squared differences from the mean.[11]

- Because the SSE is the sum of the squared errors, you can find the average (which is the variance), just by dividing by the number of values. However, if you are calculating the variance of a sample set, rather than a full population, you will divide by (n-1) instead of n. Thus:

- Variance = SSE/n, if you are calculating the variance of a full population.

- Variance = SSE/(n-1), if you are calculating the variance of a sample set of data.

- For the sample problem of the patients’ temperatures, we can assume that 10 patients represent only a sample set. Therefore, the variance would be calculated as:

- Because the SSE is the sum of the squared errors, you can find the average (which is the variance), just by dividing by the number of values. However, if you are calculating the variance of a sample set, rather than a full population, you will divide by (n-1) instead of n. Thus:

-

2

Calculate standard deviation from SSE. The standard deviation is a commonly used value that indicates how much the values of any data set deviate from the mean. The standard deviation is the square root of the variance. Recall that the variance is the average of the square error measurements.[12]

- Therefore, after you calculate the SSE, you can find the standard deviation as follows:

- For the data sample of the temperature measurements, you can find the standard deviation as follows:

- Therefore, after you calculate the SSE, you can find the standard deviation as follows:

-

3

Use SSE to measure covariance. This article has focused on data sets that measure only a single value at a time. However, in many studies, you may be comparing two separate values. You would want to know how those two values relate to each other, not only to the mean of the data set. This value is the covariance.[13]

- The calculations for covariance are too involved to detail here, other than to note that you will use the SSE for each data type and then compare them. For a more detailed description of covariance and the calculations involved, see Calculate Covariance.

- As an example of the use of covariance, you might want to compare the ages of the patients in a medical study to the effectiveness of a drug in lowering fever temperatures. Then you would have one data set of ages and a second data set of temperatures. You would find the SSE for each data set, and then from there find the variance, standard deviations and covariance.

Advertisement

Ask a Question

200 characters left

Include your email address to get a message when this question is answered.

Submit

Advertisement

Thanks for submitting a tip for review!

References

About This Article

Article SummaryX

To calculate the sum of squares for error, start by finding the mean of the data set by adding all of the values together and dividing by the total number of values. Then, subtract the mean from each value to find the deviation for each value. Next, square the deviation for each value. Finally, add all of the squared deviations together to get the sum of squares for error. To learn how to calculate the sum of squares for error using Microsoft Excel, scroll down!

Did this summary help you?

Thanks to all authors for creating a page that has been read 489,304 times.

Did this article help you?

Download Article

Download Article

The sum of squared errors, or SSE, is a preliminary statistical calculation that leads to other data values. When you have a set of data values, it is useful to be able to find how closely related those values are. You need to get your data organized in a table, and then perform some fairly simple calculations. Once you find the SSE for a data set, you can then go on to find the variance and standard deviation.

-

1

Create a three column table. The clearest way to calculate the sum of squared errors is begin with a three column table. Label the three columns as

,

, and

.[1]

-

2

Fill in the data. The first column will hold the values of your measurements. Fill in the

column with the values of your measurements. These may be the results of some experiment, a statistical study, or just data provided for a math problem.[2]

- In this case, suppose you are working with some medical data and you have a list of the body temperatures of ten patients. The normal body temperature expected is 98.6 degrees. The temperatures of ten patients are measured and give the values 99.0, 98.6, 98.5, 101.1, 98.3, 98.6, 97.9, 98.4, 99.2, and 99.1. Write these values in the first column.

Advertisement

-

3

Calculate the mean. Before you can calculate the error for each measurement, you must calculate the mean of the full data set.[3]

-

4

Calculate the individual error measurements. In the second column of your table, you need to fill in the error measurements for each data value. The error is the difference between the measurement and the mean.[4]

- For the given data set, subtract the mean, 98.87, from each measured value, and fill in the second column with the results. These ten calculations are as follows:

-

5

Calculate the squares of the errors. In the third column of the table, find the square of each of the resulting values in the middle column. These represent the squares of the deviation from the mean for each measured value of data.[5]

- For each value in the middle column, use your calculator and find the square. Record the results in the third column, as follows:

-

6

Add the squares of errors together. The final step is to find the sum of the values in the third column. The desired result is the SSE, or the sum of squared errors.[6]

- For this data set, the SSE is calculated by adding together the ten values in the third column:

Advertisement

-

1

Label the columns of the spreadsheet. You will create a three column table in Excel, with the same three headings as above.

- In cell A1, type in the heading “Value.”

- In cell B1, enter the heading “Deviation.»

- In cell C1, enter the heading “Deviation squared.”

-

2

Enter your data. In the first column, you need to type in the values of your measurements. If the set is small, you can simply type them in by hand. If you have a large data set, you may need to copy and paste the data into the column.

-

3

Find the mean of the data points. Excel has a function that will calculate the mean for you. In some vacant cell underneath your data table (it really doesn’t matter what cell you choose), enter the following:[7]

- =Average(A2:___)

- Do not actually type a blank space. Fill in that blank with the cell name of your last data point. For example, if you have 100 points of data, you will use the function:

- =Average(A2:A101)

- This function includes data from A2 through A101 because the top row contains the headings of the columns.

- When you press Enter or when you click away to any other cell on the table, the mean of your data values will automatically fill the cell that you just programmed.

-

4

Enter the function for the error measurements. In the first empty cell in the “Deviation” column, you need to enter a function to calculate the difference between each data point and the mean. To do this, you need to use the cell name where the mean resides. Let’s assume for now that you used cell A104.[8]

- The function for the error calculation, which you enter into cell B2, will be:

- =A2-$A$104. The dollar signs are necessary to make sure that you lock in cell A104 for each calculation.

- The function for the error calculation, which you enter into cell B2, will be:

-

5

Enter the function for the error squares. In the third column, you can direct Excel to calculate the square that you need.[9]

- In cell C2, enter the function

- =B2^2

- In cell C2, enter the function

-

6

Copy the functions to fill the entire table. After you have entered the functions in the top cell of each column, B2 and C2 respectively, you need to fill in the full table. You could retype the function in every line of the table, but this would take far too long. Use your mouse, highlight cells B2 and C2 together, and without letting go of the mouse button, drag down to the bottom cell of each column.

- If we are assuming that you have 100 data points in your table, you will drag your mouse down to cells B101 and C101.

- When you then release the mouse button, the formulas will be copied into all the cells of the table. The table should be automatically populated with the calculated values.

-

7

Find the SSE. Column C of your table contains all the square-error values. The final step is to have Excel calculate the sum of these values.[10]

- In a cell below the table, probably C102 for this example, enter the function:

- =Sum(C2:C101)

- When you click Enter or click away into any other cell of the table, you should have the SSE value for your data.

- In a cell below the table, probably C102 for this example, enter the function:

Advertisement

-

1

Calculate variance from SSE. Finding the SSE for a data set is generally a building block to finding other, more useful, values. The first of these is variance. The variance is a measurement that indicates how much the measured data varies from the mean. It is actually the average of the squared differences from the mean.[11]

- Because the SSE is the sum of the squared errors, you can find the average (which is the variance), just by dividing by the number of values. However, if you are calculating the variance of a sample set, rather than a full population, you will divide by (n-1) instead of n. Thus:

- Variance = SSE/n, if you are calculating the variance of a full population.

- Variance = SSE/(n-1), if you are calculating the variance of a sample set of data.

- For the sample problem of the patients’ temperatures, we can assume that 10 patients represent only a sample set. Therefore, the variance would be calculated as:

- Because the SSE is the sum of the squared errors, you can find the average (which is the variance), just by dividing by the number of values. However, if you are calculating the variance of a sample set, rather than a full population, you will divide by (n-1) instead of n. Thus:

-

2

Calculate standard deviation from SSE. The standard deviation is a commonly used value that indicates how much the values of any data set deviate from the mean. The standard deviation is the square root of the variance. Recall that the variance is the average of the square error measurements.[12]

- Therefore, after you calculate the SSE, you can find the standard deviation as follows:

- For the data sample of the temperature measurements, you can find the standard deviation as follows:

- Therefore, after you calculate the SSE, you can find the standard deviation as follows:

-

3

Use SSE to measure covariance. This article has focused on data sets that measure only a single value at a time. However, in many studies, you may be comparing two separate values. You would want to know how those two values relate to each other, not only to the mean of the data set. This value is the covariance.[13]

- The calculations for covariance are too involved to detail here, other than to note that you will use the SSE for each data type and then compare them. For a more detailed description of covariance and the calculations involved, see Calculate Covariance.

- As an example of the use of covariance, you might want to compare the ages of the patients in a medical study to the effectiveness of a drug in lowering fever temperatures. Then you would have one data set of ages and a second data set of temperatures. You would find the SSE for each data set, and then from there find the variance, standard deviations and covariance.

Advertisement

Ask a Question

200 characters left

Include your email address to get a message when this question is answered.

Submit

Advertisement

Thanks for submitting a tip for review!

References

About This Article

Article SummaryX

To calculate the sum of squares for error, start by finding the mean of the data set by adding all of the values together and dividing by the total number of values. Then, subtract the mean from each value to find the deviation for each value. Next, square the deviation for each value. Finally, add all of the squared deviations together to get the sum of squares for error. To learn how to calculate the sum of squares for error using Microsoft Excel, scroll down!

Did this summary help you?

Thanks to all authors for creating a page that has been read 489,304 times.

Did this article help you?

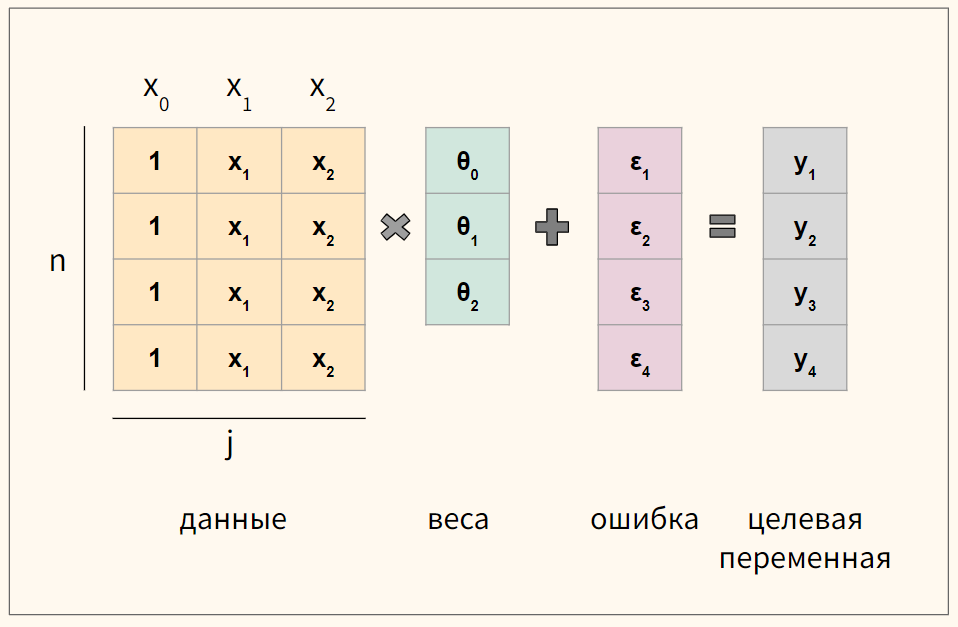

Решаем уравнение простой линейной регрессии

Время прочтения

23 мин

Просмотры 23K

В статье рассматривается несколько способов определения математического уравнения линии простой (парной) регрессии.

Все рассматриваемые здесь способы решения уравнения основаны на методе наименьших квадратов. Обозначим способы следующим образом:

- Аналитическое решение

- Градиентный спуск

- Стохастический градиентный спуск

Для каждого из способов решения уравнения прямой, в статье приведены различные функции, которые в основном делятся на те, которые написаны без использования библиотеки NumPy и те, которые для проведения расчетов применяют NumPy. Считается, что умелое использование NumPy позволит сократить затраты на вычисления.

Весь код, приведенный в статье, написан на языке python 2.7 с использованием Jupyter Notebook. Исходный код и файл с данными выборки выложен на гитхабе

Статья в большей степени ориентирована как на начинающих, так и на тех, кто уже понемногу начал осваивать изучение весьма обширного раздела в искусственном интеллекте — машинного обучения.

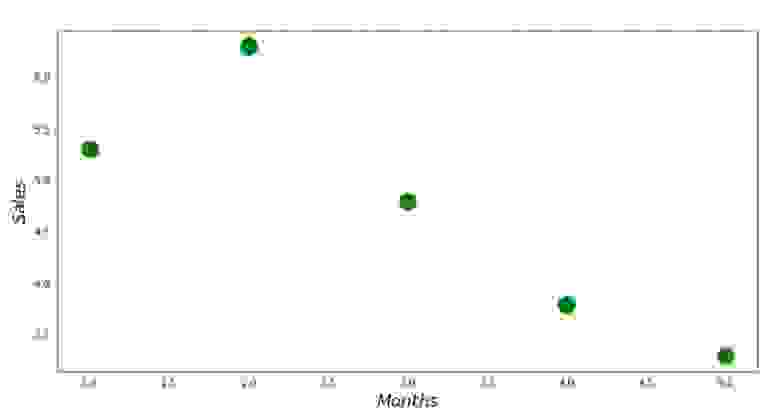

Для иллюстрации материала используем очень простой пример.

Условия примера

У нас есть пять значений, которые характеризуют зависимость Y от X (Таблица №1):

Таблица №1 «Условия примера»

Будем считать, что значения — это месяц года, а

— выручка в этом месяце. Другими словами, выручка зависит от месяца года, а

— единственный признак, от которого зависит выручка.

Пример так себе, как с точки зрения условной зависимости выручки от месяца года, так и с точки зрения количества значений — их очень мало. Однако такое упрощение позволит, что называется на пальцах, объяснить, не всегда с легкостью, усваиваемый новичками материал. А также простота чисел позволит без весомых трудозатрат, желающим, порешать пример на «бумаге».

Предположим, что приведенная в примере зависимость, может быть достаточно хорошо аппроксимирована математическим уравнением линии простой (парной) регрессии вида:

где — это месяц, в котором была получена выручка,

— выручка, соответствующая месяцу,

и

— коэффициенты регрессии оцененной линии.

Отметим, что коэффициент часто называют угловым коэффициентом или градиентом оцененной линии; представляет собой величину, на которую изменится

при изменении

.

Очевидно, что наша задача в примере — подобрать в уравнении такие коэффициенты и

, при которых отклонения наших расчетных значений выручки по месяцам от истинных ответов, т.е. значений, представленных в выборке, будут минимальны.

Метод наименьших квадратов

В соответствии с методом наименьших квадратов, отклонение стоит рассчитывать, возводя его в квадрат. Подобный прием позволяет избежать взаимного погашения отклонений, в том случае, если они имеют противоположные знаки. Например, если в одном случае, отклонение составляет +5 (плюс пять), а в другом -5 (минус пять), то сумма отклонений взаимно погасится и составит 0 (ноль). Можно и не возводить отклонение в квадрат, а воспользоваться свойством модуля и тогда у нас все отклонения будут положительными и будут накапливаться. Мы не будем останавливаться на этом моменте подробно, а просто обозначим, что для удобства расчетов, принято возводить отклонение в квадрат.

Вот так выглядит формула, с помощью которой мы определим наименьшую сумму квадратов отклонений (ошибки):

где — это функция аппроксимации истинных ответов (то есть посчитанная нами выручка),

— это истинные ответы (предоставленная в выборке выручка),

— это индекс выборки (номер месяца, в котором происходит определение отклонения)

Продифференцируем функцию, определим уравнения частных производных и будем готовы перейти к аналитическому решению. Но для начала проведем небольшой экскурс о том, что такое дифференцирование и вспомним геометрический смысл производной.

Дифференцирование

Дифференцированием называется операция по нахождению производной функции.

Для чего нужна производная? Производная функции характеризует скорость изменения функции и указывает нам ее направление. Если производная в заданной точке положительна, то функция возрастает, в обратном случае — функция убывает. И чем больше значение производной по модулю, тем выше скорость изменения значений функции, а также круче угол наклона графика функции.

Например, в условиях декартовой системы координат, значение производной в точке M(0,0) равное +25 означает, что в заданной точке, при смещении значения вправо на условную единицу, значение

возрастает на 25 условных единиц. На графике это выглядит, как достаточно крутой угол подъема значений

с заданной точки.

Другой пример. Значение производной равное -0,1 означает, что при смещении на одну условную единицу, значение

убывает всего лишь на 0,1 условную единицу. При этом, на графике функции, мы можем наблюдать едва заметный наклон вниз. Проводя аналогию с горой, то мы как будто очень медленно спускаемся по пологому склону с горы, в отличие от предыдущего примера, где нам приходилось брать очень крутые вершины:)

Таким образом, проведя дифференцирование функции по коэффициентам

и

, определим уравнения частных производных 1-го порядка. После определения уравнений, мы получим систему из двух уравнений, решив которую мы сможем подобрать такие значения коэффициентов

и

, при которых значения соответствующих производных в заданных точках изменяются на очень и очень малую величину, а в случае с аналитическим решением не изменяются вовсе. Другими словами, функция ошибки при найденных коэффициентах достигнет минимума, так как значения частных производных в этих точках будут равны нулю.

Итак, по правилам дифференцирования уравнение частной производной 1-го порядка по коэффициенту примет вид:

уравнение частной производной 1-го порядка по примет вид:

В итоге мы получили систему уравнений, которая имеет достаточно простое аналитическое решение:

begin{equation*}

begin{cases}

na + bsumlimits_{i=1}^nx_i — sumlimits_{i=1}^ny_i = 0

\

sumlimits_{i=1}^nx_i(a +bsumlimits_{i=1}^nx_i — sumlimits_{i=1}^ny_i) = 0

end{cases}

end{equation*}

Прежде чем решать уравнение, предварительно загрузим, проверим правильность загрузки и отформатируем данные.

Загрузка и форматирование данных

Необходимо отметить, что в связи с тем, что для аналитического решения, а в дальнейшем для градиентного и стохастического градиентного спуска, мы будем применять код в двух вариациях: с использованием библиотеки NumPy и без её использования, то нам потребуется соответствующее форматирование данных (см. код).

Код загрузки и обработки данных

# импортируем все нужные нам библиотеки

import pandas as pd

import numpy as np

import matplotlib.pyplot as plt

import math

import pylab as pl

import random

# графики отобразим в Jupyter

%matplotlib inline

# укажем размер графиков

from pylab import rcParams

rcParams['figure.figsize'] = 12, 6

# отключим предупреждения Anaconda

import warnings

warnings.simplefilter('ignore')

# загрузим значения

table_zero = pd.read_csv('data_example.txt', header=0, sep='t')

# посмотрим информацию о таблице и на саму таблицу

print table_zero.info()

print '********************************************'

print table_zero

print '********************************************'

# подготовим данные без использования NumPy

x_us = []

[x_us.append(float(i)) for i in table_zero['x']]

print x_us

print type(x_us)

print '********************************************'

y_us = []

[y_us.append(float(i)) for i in table_zero['y']]

print y_us

print type(y_us)

print '********************************************'

# подготовим данные с использованием NumPy

x_np = table_zero[['x']].values

print x_np

print type(x_np)

print x_np.shape

print '********************************************'

y_np = table_zero[['y']].values

print y_np

print type(y_np)

print y_np.shape

print '********************************************'

Визуализация

Теперь, после того, как мы, во-первых, загрузили данные, во-вторых, проверили правильность загрузки и наконец отформатировали данные, проведем первую визуализацию. Часто для этого используют метод pairplot библиотеки Seaborn. В нашем примере, ввиду ограниченности цифр нет смысла применять библиотеку Seaborn. Мы воспользуемся обычной библиотекой Matplotlib и посмотрим только на диаграмму рассеяния.

Код диаграммы рассеяния

print 'График №1 "Зависимость выручки от месяца года"'

plt.plot(x_us,y_us,'o',color='green',markersize=16)

plt.xlabel('$Months$', size=16)

plt.ylabel('$Sales$', size=16)

plt.show()

График №1 «Зависимость выручки от месяца года»

Аналитическое решение

Воспользуемся самыми обычными инструментами в python и решим систему уравнений:

begin{equation*}

begin{cases}

na + bsumlimits_{i=1}^nx_i — sumlimits_{i=1}^ny_i = 0

\

sumlimits_{i=1}^nx_i(a +bsumlimits_{i=1}^nx_i — sumlimits_{i=1}^ny_i) = 0

end{cases}

end{equation*}

По правилу Крамера найдем общий определитель, а также определители по и по

, после чего, разделив определитель по

на общий определитель — найдем коэффициент

, аналогично найдем коэффициент

.

Код аналитического решения

# определим функцию для расчета коэффициентов a и b по правилу Крамера

def Kramer_method (x,y):

# сумма значений (все месяца)

sx = sum(x)

# сумма истинных ответов (выручка за весь период)

sy = sum(y)

# сумма произведения значений на истинные ответы

list_xy = []

[list_xy.append(x[i]*y[i]) for i in range(len(x))]

sxy = sum(list_xy)

# сумма квадратов значений

list_x_sq = []

[list_x_sq.append(x[i]**2) for i in range(len(x))]

sx_sq = sum(list_x_sq)

# количество значений

n = len(x)

# общий определитель

det = sx_sq*n - sx*sx

# определитель по a

det_a = sx_sq*sy - sx*sxy

# искомый параметр a

a = (det_a / det)

# определитель по b

det_b = sxy*n - sy*sx

# искомый параметр b

b = (det_b / det)

# контрольные значения (прооверка)

check1 = (n*b + a*sx - sy)

check2 = (b*sx + a*sx_sq - sxy)

return [round(a,4), round(b,4)]

# запустим функцию и запишем правильные ответы

ab_us = Kramer_method(x_us,y_us)

a_us = ab_us[0]

b_us = ab_us[1]

print '33[1m' + '33[4m' + "Оптимальные значения коэффициентов a и b:" + '33[0m'

print 'a =', a_us

print 'b =', b_us

print

# определим функцию для подсчета суммы квадратов ошибок

def errors_sq_Kramer_method(answers,x,y):

list_errors_sq = []

for i in range(len(x)):

err = (answers[0] + answers[1]*x[i] - y[i])**2

list_errors_sq.append(err)

return sum(list_errors_sq)

# запустим функцию и запишем значение ошибки

error_sq = errors_sq_Kramer_method(ab_us,x_us,y_us)

print '33[1m' + '33[4m' + "Сумма квадратов отклонений" + '33[0m'

print error_sq

print

# замерим время расчета

# print '33[1m' + '33[4m' + "Время выполнения расчета суммы квадратов отклонений:" + '33[0m'

# % timeit error_sq = errors_sq_Kramer_method(ab,x_us,y_us)

Вот, что у нас получилось:

Итак, значения коэффициентов найдены, сумма квадратов отклонений установлена. Нарисуем на гистограмме рассеяния прямую линию в соответствии с найденными коэффициентами.

Код линии регрессии

# определим функцию для формирования массива рассчетных значений выручки

def sales_count(ab,x,y):

line_answers = []

[line_answers.append(ab[0]+ab[1]*x[i]) for i in range(len(x))]

return line_answers

# построим графики

print 'Грфик№2 "Правильные и расчетные ответы"'

plt.plot(x_us,y_us,'o',color='green',markersize=16, label = '$True$ $answers$')

plt.plot(x_us, sales_count(ab_us,x_us,y_us), color='red',lw=4,

label='$Function: a + bx,$ $where$ $a='+str(round(ab_us[0],2))+',$ $b='+str(round(ab_us[1],2))+'$')

plt.xlabel('$Months$', size=16)

plt.ylabel('$Sales$', size=16)

plt.legend(loc=1, prop={'size': 16})

plt.show()

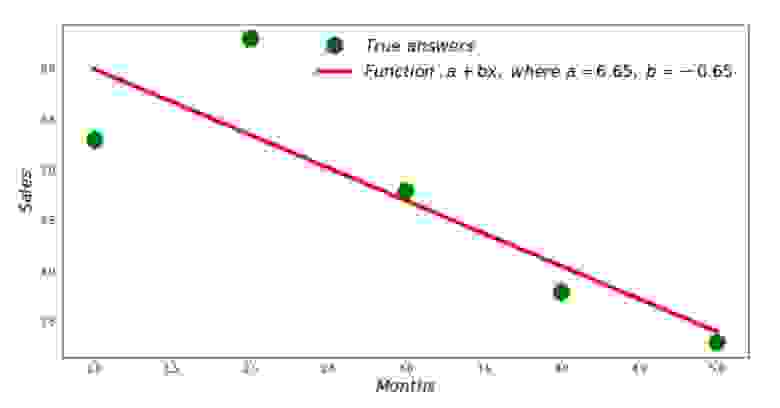

График №2 «Правильные и расчетные ответы»

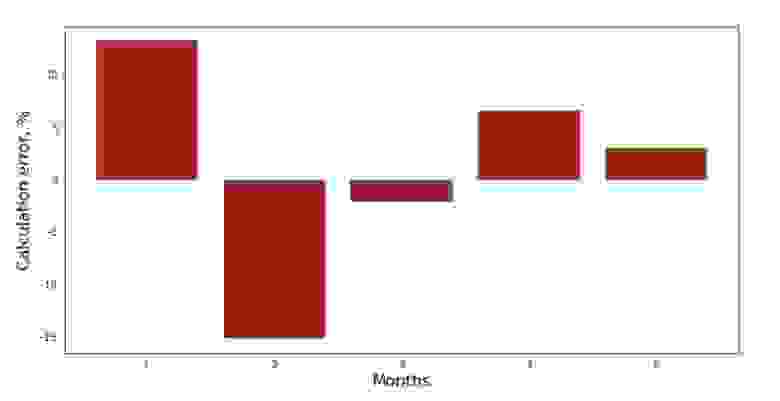

Можно посмотреть на график отклонений за каждый месяц. В нашем случае, какой-либо значимой практической ценности мы из него не вынесем, но удовлетворим любопытство в том, насколько хорошо, уравнение простой линейной регрессии характеризует зависимость выручки от месяца года.

Код графика отклонений

# определим функцию для формирования массива отклонений в процентах

def error_per_month(ab,x,y):

sales_c = sales_count(ab,x,y)

errors_percent = []

for i in range(len(x)):

errors_percent.append(100*(sales_c[i]-y[i])/y[i])

return errors_percent

# построим график

print 'График№3 "Отклонения по-месячно, %"'

plt.gca().bar(x_us, error_per_month(ab_us,x_us,y_us), color='brown')

plt.xlabel('Months', size=16)

plt.ylabel('Calculation error, %', size=16)

plt.show()

График №3 «Отклонения, %»

Не идеально, но нашу задачу мы выполнили.

Напишем функцию, которая для определения коэффициентов и

использует библиотеку NumPy, точнее — напишем две функции: одну с использованием псевдообратной матрицы (не рекомендуется на практике, так как процесс вычислительно сложный и нестабильный), другую с использованием матричного уравнения.

Код аналитического решения (NumPy)

# для начала добавим столбец с не изменяющимся значением в 1.

# Данный столбец нужен для того, чтобы не обрабатывать отдельно коэффицент a

vector_1 = np.ones((x_np.shape[0],1))

x_np = table_zero[['x']].values # на всякий случай приведем в первичный формат вектор x_np

x_np = np.hstack((vector_1,x_np))

# проверим то, что все сделали правильно

print vector_1[0:3]

print x_np[0:3]

print '***************************************'

print

# напишем функцию, которая определяет значения коэффициентов a и b с использованием псевдообратной матрицы

def pseudoinverse_matrix(X, y):

# задаем явный формат матрицы признаков

X = np.matrix(X)

# определяем транспонированную матрицу

XT = X.T

# определяем квадратную матрицу

XTX = XT*X

# определяем псевдообратную матрицу

inv = np.linalg.pinv(XTX)

# задаем явный формат матрицы ответов

y = np.matrix(y)

# находим вектор весов

return (inv*XT)*y

# запустим функцию

ab_np = pseudoinverse_matrix(x_np, y_np)

print ab_np

print '***************************************'

print

# напишем функцию, которая использует для решения матричное уравнение

def matrix_equation(X,y):

a = np.dot(X.T, X)

b = np.dot(X.T, y)

return np.linalg.solve(a, b)

# запустим функцию

ab_np = matrix_equation(x_np,y_np)

print ab_np

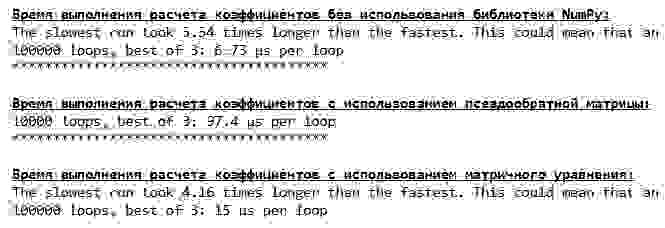

Сравним время, которое было затрачено на определение коэффициентов и

, в соответствии с 3-мя представленными способами.

Код для вычисления времени расчетов

print '33[1m' + '33[4m' + "Время выполнения расчета коэффициентов без использования библиотеки NumPy:" + '33[0m'

% timeit ab_us = Kramer_method(x_us,y_us)

print '***************************************'

print

print '33[1m' + '33[4m' + "Время выполнения расчета коэффициентов с использованием псевдообратной матрицы:" + '33[0m'

%timeit ab_np = pseudoinverse_matrix(x_np, y_np)

print '***************************************'

print

print '33[1m' + '33[4m' + "Время выполнения расчета коэффициентов с использованием матричного уравнения:" + '33[0m'

%timeit ab_np = matrix_equation(x_np, y_np)

На небольшом количестве данных, вперед выходит «самописная» функция, которая находит коэффициенты методом Крамера.

Теперь можно перейти к другим способам нахождения коэффициентов и

.

Градиентный спуск

Для начала определим, что такое градиент. По-простому, градиент — это отрезок, который указывает направление максимального роста функции. По аналогии с подъемом в гору, то куда смотрит градиент, там и есть самый крутой подъем к вершине горы. Развивая пример с горой, вспоминаем, что на самом деле нам нужен самый крутой спуск, чтобы как можно быстрее достичь низины, то есть минимума — места где функция не возрастает и не убывает. В этом месте производная будет равна нулю. Следовательно, нам нужен не градиент, а антиградиент. Для нахождения антиградиента нужно всего лишь умножить градиент на -1 (минус один).

Обратим внимание на то, что функция может иметь несколько минимумов, и опустившись в один из них по предложенному далее алгоритму, мы не сможем найти другой минимум, который возможно находится ниже найденного. Расслабимся, нам это не грозит! В нашем случае мы имеем дело с единственным минимумом, так как наша функция на графике представляет собой обычную параболу. А как мы все должны прекрасно знать из школьного курса математики — у параболы существует только один минимум.

После того, как мы выяснили для чего нам потребовался градиент, а также то, что градиент — это отрезок, то есть вектор с заданными координатами, которые как раз являются теми самыми коэффициентами и

мы можем реализовать градиентный спуск.

Перед запуском, предлагаю прочитать буквально несколько предложений об алгоритме спуска:

- Определяем псевдослучайным образом координаты коэффициентов

и

. В нашем примере, мы будем определять коэффициенты вблизи нуля. Это является распространённой практикой, однако для каждого случая может быть предусмотрена своя практика.

- От координаты

вычитаем значение частной производной 1-го порядка в точке

. Так, если производная будет положительная, то функция возрастает. Следовательно, отнимая значение производной, мы будем двигаться в обратную сторону роста, то есть в сторону спуска. Если производная отрицательна, значит функция в этой точке убывает и отнимая значение производной мы двигаемся в сторону спуска.

- Проводим аналогичную операцию с координатой

: вычитаем значение частной производной в точке

.

- Для того, чтобы не перескочить минимум и не улететь в далекий космос, необходимо установить размер шага в сторону спуска. В общем и целом, можно написать целую статью о том, как правильнее установить шаг и как его менять в процессе спуска, чтобы снизить затраты на вычисления. Но сейчас перед нами несколько иная задача, и мы научным методом «тыка» или как говорят в простонародье, эмпирическим путем, установим размер шага.

- После того, как мы из заданных координат

и

вычли значения производных, получаем новые координаты

и

. Делаем следующий шаг (вычитание), уже из рассчитанных координат. И так цикл запускается вновь и вновь, до тех пор, пока не будет достигнута требуемая сходимость.

Все! Теперь мы готовы отправиться на поиски самого глубокого ущелья Марианской впадины. Приступаем.

Код для градиентного спуска

# напишем функцию градиентного спуска без использования библиотеки NumPy.

# Функция на вход принимает диапазоны значений x,y, длину шага (по умолчанию=0,1), допустимую погрешность(tolerance)

def gradient_descent_usual(x_us,y_us,l=0.1,tolerance=0.000000000001):

# сумма значений (все месяца)

sx = sum(x_us)

# сумма истинных ответов (выручка за весь период)

sy = sum(y_us)

# сумма произведения значений на истинные ответы

list_xy = []

[list_xy.append(x_us[i]*y_us[i]) for i in range(len(x_us))]

sxy = sum(list_xy)

# сумма квадратов значений

list_x_sq = []

[list_x_sq.append(x_us[i]**2) for i in range(len(x_us))]

sx_sq = sum(list_x_sq)

# количество значений

num = len(x_us)

# начальные значения коэффициентов, определенные псевдослучайным образом

a = float(random.uniform(-0.5, 0.5))

b = float(random.uniform(-0.5, 0.5))

# создаем массив с ошибками, для старта используем значения 1 и 0

# после завершения спуска стартовые значения удалим

errors = [1,0]

# запускаем цикл спуска

# цикл работает до тех пор, пока отклонение последней ошибки суммы квадратов от предыдущей, не будет меньше tolerance

while abs(errors[-1]-errors[-2]) > tolerance:

a_step = a - l*(num*a + b*sx - sy)/num

b_step = b - l*(a*sx + b*sx_sq - sxy)/num

a = a_step

b = b_step

ab = [a,b]

errors.append(errors_sq_Kramer_method(ab,x_us,y_us))

return (ab),(errors[2:])

# запишем массив значений

list_parametres_gradient_descence = gradient_descent_usual(x_us,y_us,l=0.1,tolerance=0.000000000001)

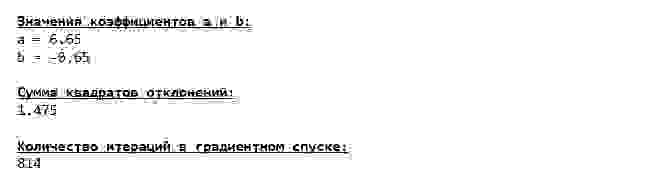

print '33[1m' + '33[4m' + "Значения коэффициентов a и b:" + '33[0m'

print 'a =', round(list_parametres_gradient_descence[0][0],3)

print 'b =', round(list_parametres_gradient_descence[0][1],3)

print

print '33[1m' + '33[4m' + "Сумма квадратов отклонений:" + '33[0m'

print round(list_parametres_gradient_descence[1][-1],3)

print

print '33[1m' + '33[4m' + "Количество итераций в градиентном спуске:" + '33[0m'

print len(list_parametres_gradient_descence[1])

print

Мы погрузились на самое дно Марианской впадины и там обнаружили все те же значения коэффициентов и

, что собственно и следовало ожидать.

Совершим еще одно погружение, только на этот раз, начинкой нашего глубоководного аппарата будут иные технологии, а именно библиотека NumPy.

Код для градиентного спуска (NumPy)

# перед тем определить функцию для градиентного спуска с использованием библиотеки NumPy,

# напишем функцию определения суммы квадратов отклонений также с использованием NumPy

def error_square_numpy(ab,x_np,y_np):

y_pred = np.dot(x_np,ab)

error = y_pred - y_np

return sum((error)**2)

# напишем функцию градиентного спуска с использованием библиотеки NumPy.

# Функция на вход принимает диапазоны значений x,y, длину шага (по умолчанию=0,1), допустимую погрешность(tolerance)

def gradient_descent_numpy(x_np,y_np,l=0.1,tolerance=0.000000000001):

# сумма значений (все месяца)

sx = float(sum(x_np[:,1]))

# сумма истинных ответов (выручка за весь период)

sy = float(sum(y_np))

# сумма произведения значений на истинные ответы

sxy = x_np*y_np

sxy = float(sum(sxy[:,1]))

# сумма квадратов значений

sx_sq = float(sum(x_np[:,1]**2))

# количество значений

num = float(x_np.shape[0])

# начальные значения коэффициентов, определенные псевдослучайным образом

a = float(random.uniform(-0.5, 0.5))

b = float(random.uniform(-0.5, 0.5))

# создаем массив с ошибками, для старта используем значения 1 и 0

# после завершения спуска стартовые значения удалим

errors = [1,0]

# запускаем цикл спуска

# цикл работает до тех пор, пока отклонение последней ошибки суммы квадратов от предыдущей, не будет меньше tolerance

while abs(errors[-1]-errors[-2]) > tolerance:

a_step = a - l*(num*a + b*sx - sy)/num

b_step = b - l*(a*sx + b*sx_sq - sxy)/num

a = a_step

b = b_step

ab = np.array([[a],[b]])

errors.append(error_square_numpy(ab,x_np,y_np))

return (ab),(errors[2:])

# запишем массив значений

list_parametres_gradient_descence = gradient_descent_numpy(x_np,y_np,l=0.1,tolerance=0.000000000001)

print '33[1m' + '33[4m' + "Значения коэффициентов a и b:" + '33[0m'

print 'a =', round(list_parametres_gradient_descence[0][0],3)

print 'b =', round(list_parametres_gradient_descence[0][1],3)

print

print '33[1m' + '33[4m' + "Сумма квадратов отклонений:" + '33[0m'

print round(list_parametres_gradient_descence[1][-1],3)

print

print '33[1m' + '33[4m' + "Количество итераций в градиентном спуске:" + '33[0m'

print len(list_parametres_gradient_descence[1])

print

Значения коэффициентов и

неизменны.

Посмотрим на то, как изменялась ошибка при градиентном спуске, то есть как изменялась сумма квадратов отклонений с каждым шагом.

Код для графика сумм квадратов отклонений

print 'График№4 "Сумма квадратов отклонений по-шагово"'

plt.plot(range(len(list_parametres_gradient_descence[1])), list_parametres_gradient_descence[1], color='red', lw=3)

plt.xlabel('Steps (Iteration)', size=16)

plt.ylabel('Sum of squared deviations', size=16)

plt.show()

График №4 «Сумма квадратов отклонений при градиентном спуске»

На графике мы видим, что с каждым шагом ошибка уменьшается, а спустя какое-то количество итераций наблюдаем практически горизонтальную линию.

Напоследок оценим разницу во времени исполнения кода:

Код для определения времени вычисления градиентного спуска

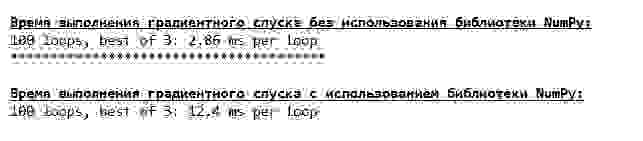

print '33[1m' + '33[4m' + "Время выполнения градиентного спуска без использования библиотеки NumPy:" + '33[0m'

%timeit list_parametres_gradient_descence = gradient_descent_usual(x_us,y_us,l=0.1,tolerance=0.000000000001)

print '***************************************'

print

print '33[1m' + '33[4m' + "Время выполнения градиентного спуска с использованием библиотеки NumPy:" + '33[0m'

%timeit list_parametres_gradient_descence = gradient_descent_numpy(x_np,y_np,l=0.1,tolerance=0.000000000001)

Возможно мы делаем что-то не то, но опять простая «самописная» функция, которая не использует библиотеку NumPy опережает по времени выполнения расчетов функцию, использующую библиотеку NumPy.

Но мы не стоим на месте, а двигаемся в сторону изучения еще одного увлекательного способа решения уравнения простой линейной регрессии. Встречайте!

Стохастический градиентный спуск

Для того, чтобы быстрее понять принцип работы стохастического градиентного спуска, лучше определить его отличия от обычного градиентного спуска. Мы, в случае с градиентным спуском, в уравнениях производных от и

использовали суммы значений всех признаков и истинных ответов, имеющихся в выборке (то есть суммы всех

и

). В стохастическом градиентном спуске мы не будем использовать все значения, имеющиеся в выборке, а вместо этого, псевдослучайным образом выберем так называемый индекс выборки и используем его значения.

Например, если индекс определился за номером 3 (три), то мы берем значения и

, далее подставляем значения в уравнения производных и определяем новые координаты. Затем, определив координаты, мы опять псевдослучайным образом определяем индекс выборки, подставляем значения, соответствующие индексу в уравнения частных производных, по новому определяем координаты

и

и т.д. до

позеленения

сходимости. На первый взгляд, может показаться, как это вообще может работать, однако работает. Правда стоит отметить, что не с каждым шагом уменьшается ошибка, но тенденция безусловно имеется.

Каковы преимущества стохастического градиентного спуска перед обычным? В случае, если у нас размер выборки очень велик и измеряется десятками тысяч значений, то значительно проще обработать, допустим случайную тысячу из них, нежели всю выборку. Вот в этом случае и запускается стохастический градиентный спуск. В нашем случае мы конечно же большой разницы не заметим.

Смотрим код.

Код для стохастического градиентного спуска

# определим функцию стох.град.шага

def stoch_grad_step_usual(vector_init, x_us, ind, y_us, l):

# выбираем значение икс, которое соответствует случайному значению параметра ind

# (см.ф-цию stoch_grad_descent_usual)

x = x_us[ind]

# рассчитывыаем значение y (выручку), которая соответствует выбранному значению x

y_pred = vector_init[0] + vector_init[1]*x_us[ind]

# вычисляем ошибку расчетной выручки относительно представленной в выборке

error = y_pred - y_us[ind]

# определяем первую координату градиента ab

grad_a = error

# определяем вторую координату ab

grad_b = x_us[ind]*error

# вычисляем новый вектор коэффициентов

vector_new = [vector_init[0]-l*grad_a, vector_init[1]-l*grad_b]

return vector_new

# определим функцию стох.град.спуска

def stoch_grad_descent_usual(x_us, y_us, l=0.1, steps = 800):

# для самого начала работы функции зададим начальные значения коэффициентов

vector_init = [float(random.uniform(-0.5, 0.5)), float(random.uniform(-0.5, 0.5))]

errors = []

# запустим цикл спуска

# цикл расчитан на определенное количество шагов (steps)

for i in range(steps):

ind = random.choice(range(len(x_us)))

new_vector = stoch_grad_step_usual(vector_init, x_us, ind, y_us, l)

vector_init = new_vector

errors.append(errors_sq_Kramer_method(vector_init,x_us,y_us))

return (vector_init),(errors)

# запишем массив значений

list_parametres_stoch_gradient_descence = stoch_grad_descent_usual(x_us, y_us, l=0.1, steps = 800)

print '33[1m' + '33[4m' + "Значения коэффициентов a и b:" + '33[0m'

print 'a =', round(list_parametres_stoch_gradient_descence[0][0],3)

print 'b =', round(list_parametres_stoch_gradient_descence[0][1],3)

print

print '33[1m' + '33[4m' + "Сумма квадратов отклонений:" + '33[0m'

print round(list_parametres_stoch_gradient_descence[1][-1],3)

print

print '33[1m' + '33[4m' + "Количество итераций в стохастическом градиентном спуске:" + '33[0m'

print len(list_parametres_stoch_gradient_descence[1])

Смотрим внимательно на коэффициенты и ловим себя на вопросе «Как же так?». У нас получились другие значения коэффициентов и

. Может быть стохастический градиентный спуск нашел более оптимальные параметры уравнения? Увы, нет. Достаточно посмотреть на сумму квадратов отклонений и увидеть, что при новых значениях коэффициентов, ошибка больше. Не спешим отчаиваться. Построим график изменения ошибки.

Код для графика суммы квадратов отклонений при стохастическом градиентном спуске

print 'График №5 "Сумма квадратов отклонений по-шагово"'

plt.plot(range(len(list_parametres_stoch_gradient_descence[1])), list_parametres_stoch_gradient_descence[1], color='red', lw=2)

plt.xlabel('Steps (Iteration)', size=16)

plt.ylabel('Sum of squared deviations', size=16)

plt.show()

График №5 «Сумма квадратов отклонений при стохастическом градиентном спуске»

Посмотрев на график, все становится на свои места и сейчас мы все исправим.

Итак, что же произошло? Произошло следующее. Когда мы выбираем случайным образом месяц, то именно для выбранного месяца наш алгоритм стремится уменьшить ошибку в расчете выручки. Затем выбираем другой месяц и повторяем расчет, но ошибку уменьшаем уже для второго выбранного месяца. А теперь вспомним, что у нас первые два месяца существенно отклоняются от линии уравнения простой линейной регрессии. Это значит, что когда выбирается любой из этих двух месяцев, то уменьшая ошибку каждого из них, наш алгоритм серьезно увеличивает ошибку по всей выборке. Так что же делать? Ответ простой: надо уменьшить шаг спуска. Ведь уменьшив шаг спуска, ошибка так же перестанет «скакать» то вверх, то вниз. Вернее, ошибка «скакать» не перестанет, но будет это делать не так прытко:) Проверим.

Код для запуска SGD с меньшим шагом

# запустим функцию, уменьшив шаг в 100 раз и увеличив количество шагов соответсвующе

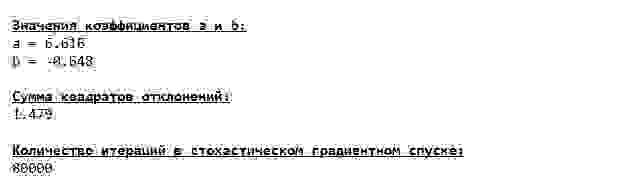

list_parametres_stoch_gradient_descence = stoch_grad_descent_usual(x_us, y_us, l=0.001, steps = 80000)

print '33[1m' + '33[4m' + "Значения коэффициентов a и b:" + '33[0m'

print 'a =', round(list_parametres_stoch_gradient_descence[0][0],3)

print 'b =', round(list_parametres_stoch_gradient_descence[0][1],3)

print

print '33[1m' + '33[4m' + "Сумма квадратов отклонений:" + '33[0m'

print round(list_parametres_stoch_gradient_descence[1][-1],3)

print

print '33[1m' + '33[4m' + "Количество итераций в стохастическом градиентном спуске:" + '33[0m'

print len(list_parametres_stoch_gradient_descence[1])

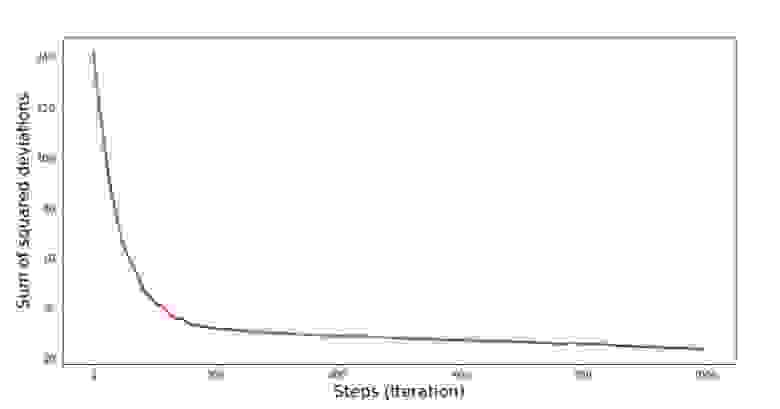

print 'График №6 "Сумма квадратов отклонений по-шагово"'

plt.plot(range(len(list_parametres_stoch_gradient_descence[1])), list_parametres_stoch_gradient_descence[1], color='red', lw=2)

plt.xlabel('Steps (Iteration)', size=16)

plt.ylabel('Sum of squared deviations', size=16)

plt.show()

График №6 «Сумма квадратов отклонений при стохастическом градиентном спуске (80 тыс. шагов)»

Значения коэффициентов улучшились, но все равно не идеальны. Гипотетически это можно поправить таким образом. Выбираем, например, на последних 1000 итерациях значения коэффициентов, с которыми была допущена минимальная ошибка. Правда нам для этого придется записывать еще и сами значения коэффициентов. Мы не будем этого делать, а лучше обратим внимание на график. Он выглядит гладким, и ошибка как будто уменьшается равномерно. На самом деле это не так. Посмотрим на первые 1000 итераций и сравним их с последними.

Код для графика SGD (первые 1000 шагов)

print 'График №7 "Сумма квадратов отклонений по-шагово. Первые 1000 итераций"'

plt.plot(range(len(list_parametres_stoch_gradient_descence[1][:1000])),

list_parametres_stoch_gradient_descence[1][:1000], color='red', lw=2)

plt.xlabel('Steps (Iteration)', size=16)

plt.ylabel('Sum of squared deviations', size=16)

plt.show()

print 'График №7 "Сумма квадратов отклонений по-шагово. Последние 1000 итераций"'

plt.plot(range(len(list_parametres_stoch_gradient_descence[1][-1000:])),

list_parametres_stoch_gradient_descence[1][-1000:], color='red', lw=2)

plt.xlabel('Steps (Iteration)', size=16)

plt.ylabel('Sum of squared deviations', size=16)

plt.show()

График №7 «Сумма квадратов отклонений SGD (первые 1000 шагов)»

График №8 «Сумма квадратов отклонений SGD (последние 1000 шагов)»

В самом начале спуска мы наблюдаем достаточно равномерное и крутое уменьшение ошибки. На последних итерациях мы видим, что ошибка ходит вокруг да около значения в 1,475 и в некоторые моменты даже равняется этому оптимальному значению, но потом все равно уходит ввысь… Повторюсь, можно записывать значения коэффициентов и

, а потом выбрать те, при которых ошибка минимальна. Однако у нас возникла проблема посерьезнее: нам пришлось сделать 80 тыс. шагов (см. код), чтобы получить значения, близкие к оптимальным. А это, уже противоречит идее об экономии времени вычислений при стохастическом градиентном спуске относительно градиентного. Что можно поправить и улучшить? Не трудно заметить, что на первых итерациях мы уверенно идем вниз и, следовательно, нам стоит оставить большой шаг на первых итерациях и по мере продвижения вперед шаг уменьшать. Мы не будем этого делать в этой статье — она и так уже затянулась. Желающие могут и сами подумать, как это сделать, это не сложно

Теперь выполним стохастический градиентный спуск, используя библиотеку NumPy (и не будем спотыкаться о камни, которые мы выявили раннее)

Код для стохастического градиентного спуска (NumPy)

# для начала напишем функцию градиентного шага

def stoch_grad_step_numpy(vector_init, X, ind, y, l):

x = X[ind]

y_pred = np.dot(x,vector_init)

err = y_pred - y[ind]

grad_a = err

grad_b = x[1]*err

return vector_init - l*np.array([grad_a, grad_b])

# определим функцию стохастического градиентного спуска

def stoch_grad_descent_numpy(X, y, l=0.1, steps = 800):

vector_init = np.array([[np.random.randint(X.shape[0])], [np.random.randint(X.shape[0])]])

errors = []

for i in range(steps):

ind = np.random.randint(X.shape[0])

new_vector = stoch_grad_step_numpy(vector_init, X, ind, y, l)

vector_init = new_vector

errors.append(error_square_numpy(vector_init,X,y))

return (vector_init), (errors)

# запишем массив значений

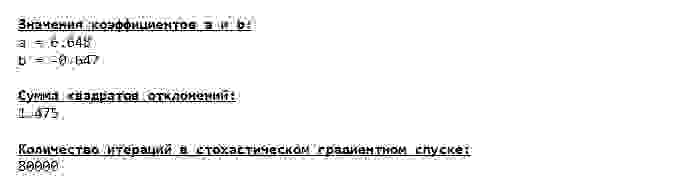

list_parametres_stoch_gradient_descence = stoch_grad_descent_numpy(x_np, y_np, l=0.001, steps = 80000)

print '33[1m' + '33[4m' + "Значения коэффициентов a и b:" + '33[0m'

print 'a =', round(list_parametres_stoch_gradient_descence[0][0],3)

print 'b =', round(list_parametres_stoch_gradient_descence[0][1],3)

print

print '33[1m' + '33[4m' + "Сумма квадратов отклонений:" + '33[0m'

print round(list_parametres_stoch_gradient_descence[1][-1],3)

print

print '33[1m' + '33[4m' + "Количество итераций в стохастическом градиентном спуске:" + '33[0m'

print len(list_parametres_stoch_gradient_descence[1])

print

Значения получились почти такими же, как и при спуске без использования NumPy. Впрочем, это логично.

Узнаем сколько же времени занимали у нас стохастические градиентные спуски.

Код для определения времени вычисления SGD (80 тыс. шагов)

print '33[1m' + '33[4m' +

"Время выполнения стохастического градиентного спуска без использования библиотеки NumPy:"

+ '33[0m'

%timeit list_parametres_stoch_gradient_descence = stoch_grad_descent_usual(x_us, y_us, l=0.001, steps = 80000)

print '***************************************'

print

print '33[1m' + '33[4m' +

"Время выполнения стохастического градиентного спуска с использованием библиотеки NumPy:"

+ '33[0m'

%timeit list_parametres_stoch_gradient_descence = stoch_grad_descent_numpy(x_np, y_np, l=0.001, steps = 80000)

Чем дальше в лес, тем темнее тучи: опять «самописная» формула показывает лучший результат. Все это наводит на мысли о том, что должны существовать еще более тонкие способы использования библиотеки NumPy, которые действительно ускоряют операции вычислений. В этой статье мы о них уже не узнаем. Будет о чем подумать на досуге:)

Резюмируем

Перед тем как резюмировать, хотелось бы ответить на вопрос, который скорее всего, возник у нашего дорогого читателя. Для чего, собственно, такие «мучения» со спусками, зачем нам ходить по горе вверх и вниз (преимущественно вниз), чтобы найти заветную низину, если в наших руках такой мощный и простой прибор, в виде аналитического решения, который мгновенно телепортирует нас в нужное место?

Ответ на этот вопрос лежит на поверхности. Сейчас мы разбирали очень простой пример, в котором истинный ответ зависит от одного признака

. В жизни такое встретишь не часто, поэтому представим, что у нас признаков 2, 30, 50 или более. Добавим к этому тысячи, а то и десятки тысяч значений для каждого признака. В этом случае аналитическое решение может не выдержать испытания и дать сбой. В свою очередь градиентный спуск и его вариации будут медленно, но верно приближать нас к цели — минимуму функции. А на счет скорости не волнуйтесь — мы наверняка еще разберем способы, которые позволят нам задавать и регулировать длину шага (то есть скорость).

А теперь собственно краткое резюме.

Во-первых, надеюсь, что изложенный в статье материал, поможет начинающим «дата сайнтистам» в понимании того, как решать уравнения простой (и не только) линейной регрессии.

Во-вторых, мы рассмотрели несколько способов решения уравнения. Теперь, в зависимости от ситуации, мы можем выбрать тот, который лучше всего подходит для решения поставленной задачи.

В-третьих, мы увидели силу дополнительных настроек, а именно длины шага градиентного спуска. Этим параметром нельзя пренебрегать. Как было подмечено выше, с целью сокращения затрат на проведение вычислений, длину шага стоит изменять по ходу спуска.

В-четвертых, в нашем случае, «самописные» функции показали лучший временной результат вычислений. Вероятно, это связано с не самым профессиональным применением возможностей библиотеки NumPy. Но как бы то ни было, вывод напрашивается следующий. С одной стороны, иногда стоит подвергать сомнению устоявшиеся мнения, а с другой — не всегда стоит все усложнять — наоборот иногда эффективнее оказывается более простой способ решения задачи. А так как цель у нас была разобрать три подхода в решении уравнения простой линейной регрессии, то использование «самописных» функций нам вполне хватило.

Предыдущая работа автора — «Исследуем утверждение центральной предельной теоремы с помощью экспоненциального распределения»

Следующая работа автора — «Приводим уравнение линейной регрессии в матричный вид»

Литература (или что-то вроде того)

1. Линейная регрессия

http://statistica.ru/theory/osnovy-lineynoy-regressii/

2. Метод наименьших квадратов

mathprofi.ru/metod_naimenshih_kvadratov.html

3. Производная

www.mathprofi.ru/chastnye_proizvodnye_primery.html

4. Градиент

mathprofi.ru/proizvodnaja_po_napravleniju_i_gradient.html

5. Градиентный спуск

habr.com/ru/post/471458

habr.com/ru/post/307312

artemarakcheev.com//2017-12-31/linear_regression

6. Библиотека NumPy

docs.scipy.org/doc/numpy-1.10.1/reference/generated/numpy.linalg.solve.html

docs.scipy.org/doc/numpy-1.10.0/reference/generated/numpy.linalg.pinv.html

pythonworld.ru/numpy/2.html

Линейная регрессия

Перевод

Ссылка на автора

Введение

Недавно я написал об оценке максимального правдоподобия в своей продолжающейся серии статей об основах машинного обучения:

Оценка максимального правдоподобия

Основы машинного обучения (часть 2)

towardsdatascience.com

В этом посте мы узнали, что значит «моделировать» данные, а затем, как использовать MLE, чтобы найти параметры нашей модели. В этом посте мы собираемся погрузиться в линейную регрессию, одну из наиболее важных моделей в статистике, и научимся формировать ее с точки зрения MLE. Решение представляет собой прекрасный математический пример, который, как и большинство моделей MLE, богат интуицией. Я предполагаю, что вы получили представление о словаре, который я рассмотрел в других сериях (плотности вероятностей, условные вероятности, функция вероятности, данные iid и т. Д.). Если вы видите здесь что-то, что вас не устраивает, проверьте Вероятность а также MLE сообщения из этой серии для ясности.

Модель

Мы используем линейную регрессию, когда наши данные имеют линейную связь между независимыми переменными (нашими функциями) и зависимой переменной (нашей целью). В посте MLE мы увидели некоторые данные, которые тоже выглядели примерно так:

Мы заметили, что между x и y существует линейная зависимость, но она не идеальна. Мы думаем об этих недостатках как о результате некоторой ошибки или шумового процесса. Представьте, что проведете линию прямо через облако точек. Ошибка для каждой точки — это расстояние от точки до нашей линии. Мы хотели бы явно включить эти ошибки в нашу модель. Один из способов сделать это — предположить, что ошибки распределены из гауссовского распределения со средним значением 0 и некоторой неизвестной дисперсией σ². Gaussian кажется хорошим выбором, потому что наши ошибки выглядят симметричными относительно линии, и маленькие ошибки более вероятны, чем большие. Мы пишем нашу линейную модель с гауссовым шумом так:

Термин ошибки взят из нашего гауссовского алгоритма, а затем вычисленный нами у вычисляется путем добавления ошибки к выходным данным линейного уравнения. Эта модель имеет три параметра: наклон и пересечение нашей линии и дисперсию распределения шума. Наша главная цель — найти наилучшие параметры для наклона и пересечения нашей линии.

Функция правдоподобия

Чтобы применить максимальное правдоподобие, нам сначала нужно вывести функцию правдоподобия. Во-первых, давайте перепишем нашу модель сверху как единое условное распределение, заданное x:

Это эквивалентно проталкиванию нашего x через уравнение линии, а затем добавлению шума от среднего гауссова 0.

Теперь мы можем записать условное распределение y для заданного x в терминах этого гауссиана. Это просто уравнение функции плотности вероятности распределения Гаусса с нашим линейным уравнением вместо среднего значения:

Точка с запятой в условном распределении действует как запятая, но это полезное обозначение для отделения наших наблюдаемых данных от параметров.

Каждая точка является независимой и одинаково распределенной (iid), поэтому мы можем записать функцию правдоподобия относительно всех наших наблюдаемых точек как произведение каждой отдельной плотности вероятности. Поскольку σ² одинаково для каждой точки данных, мы можем вычленить термин гауссианы, который не включает x или y из произведения:

Log-правдоподобие:

Следующий шаг в MLE — найти параметры, которые максимизируют эту функцию. Чтобы упростить наше уравнение, давайте возьмем журнал нашей вероятности. Напомним, что максимизация логарифмической вероятности такая же, как максимизация вероятности, поскольку логарифм является монотонным. Натуральный логарифм вычитается по экспоненте, превращает произведения в суммы бревен и делится на вычитание бревен; так что наша логарифмическая вероятность выглядит намного проще:

Сумма квадратов ошибок:

Чтобы еще кое-что прояснить, давайте запишем вывод нашей строки как одно значение:

Теперь наша логарифмическая вероятность может быть записана как:

Чтобы убрать отрицательные знаки, давайте вспомним, что максимизация числа — это то же самое, что минимизация отрицания числа. Поэтому вместо того, чтобы максимизировать вероятность, давайте минимизируем отрицательную логарифмическую вероятность:

Наша конечная цель — найти параметры нашей линии. Чтобы минимизировать отрицательное логарифмическое правдоподобие по отношению к линейным параметрам (θs), мы можем представить, что наш дисперсионный член является фиксированной константой.

Удаление любых констант, которые не включают наши θs, не изменит решение Поэтому мы можем выбросить любые постоянные термины и изящно написать то, что мы пытаемся минимизировать, как:

Оценка максимального правдоподобия для нашей линейной модели — это линия, которая минимизирует сумму квадратов ошибок! Это прекрасный результат, и вы увидите, что минимизация квадратичных ошибок повсеместно встречается в машинном обучении и статистике.

Решение для параметров

Мы пришли к выводу, что оценки максимального правдоподобия для нашего наклона и перехвата можно найти путем минимизации суммы квадратов ошибок. Давайте расширим нашу цель минимизации и используемякак наш индекс над нашимNТочки данных:

Квадрат в формуле SSE делает его квадратичным с одним минимумом. Минимум можно найти, взяв производную по каждому из параметров, установив ее равной 0 и решив для параметров по очереди.

Перехват:

Давайте начнем с решения для перехвата. Взятие частной производной по отношению к перехвату и проработка дает нам:

Горизонтальные полосы над переменными показывают среднее значение этих переменных. Мы использовали тот факт, что сумма значений переменных равна среднему значению этих значений, умноженному на количество значений, которые у нас есть. Установка производной равной 0 и решение для перехвата дает нам:

Это довольно аккуратный результат. Это уравнение линии со средствами х и у вместо этих переменных. Перехват по-прежнему зависит от наклона, поэтому нам нужно найти его дальше.

Склон:

Мы начнем с частной производной SSE относительно нашего наклона. Мы включаем наше решение для перехвата и используем алгебру, чтобы изолировать термин наклона:

Установка этого значения равным 0 и решение для наклона дает нам:

Хотя технически мы закончили, мы можем использовать некоторую причудливую алгебру, чтобы переписать это, не используяN:

Собираем все вместе:

Мы можем использовать эти производные уравнения, чтобы написать простую функцию в python для решения параметров для любой линии, заданной как минимум двумя точками:

def find_line(xs, ys):

"""Calculates the slope and intercept"""# number of points

n = len(xs) # calculate means

x_bar = sum(xs)/n

y_bar = sum(ys)/n# calculate slope

num = 0

denom = 0

for i in range(n):

num += (xs[i]-x_bar)*(ys[i]-y_bar)

denom += (xs[i]-x_bar)**2

slope = num/denom# calculate intercept

intercept = y_bar - slope*x_barreturn slope, intercept

Используя этот код, мы можем поместить строку в наши исходные данные (см. Ниже). Это максимальная оценка правдоподобия для наших данных. Линия минимизирует сумму квадратов ошибок, поэтому этот метод линейной регрессии часто называют обычными наименьшими квадратами.

Последние мысли

Я хотел написать этот пост главным образом для того, чтобы подчеркнуть связь между минимизацией суммы квадратов ошибок и подходом оценки максимального правдоподобия к линейной регрессии. Большинство людей сначала учатся решать линейную регрессию путем минимизации квадратичной ошибки, но, как правило, не понимают, что это происходит из вероятностной модели с запечатленными в допущениях (например, гауссовых распределенных ошибок).

Существует более элегантное решение для нахождения параметров этой модели, но для этого требуется линейная алгебра. Я планирую вернуться к линейной регрессии после того, как расскажу о линейной алгебре в своей серии основ, и покажу, как ее можно использовать для подбора более сложных кривых, таких как полиномы и экспоненты.

Увидимся в следующий раз!

Все курсы > Оптимизация > Занятие 4 (часть 2)

Во второй части занятия перейдем к практике.

Продолжим работать в том же ноутбуке⧉

Сквозной пример

Данные и постановка задачи

Обратимся к хорошо знакомому нам датасету недвижимости в Бостоне.

|

boston = pd.read_csv(‘/content/boston.csv’) |

При этом нам нужно будет решить две основные задачи:

Задача 1. Научиться оценивать качество модели не только с точки зрения метрики, но и исходя из рассмотренных ранее допущений модели. Эту задачу мы решим в три этапа.

- Этап 1. Построим базовую (baseline) модель линейной регрессии с помощью класса LinearRegression библиотеки sklearn и оценим, насколько выполняются рассмотренные выше допущения.

- Этап 2. Попробуем изменить данные таким образом, чтобы модель в большей степени соответствовала этим критериям.

- Этап 3. Обучим еще одну модель и посмотрим, как изменится результат.

Задача 2. С нуля построить модель множественной линейной регрессии и сравнить прогноз с результатом, полученным при решении первой задачи. При этом обучение модели мы реализуем двумя способами, а именно, через:

- Метод наименьших квадратов

- Метод градиентного спуска

Разделение выборки

Мы уже не раз говорили про важность разделения выборки на обучаущую и тестовую части. Сегодня же, с учетом того, что нам предстоит изучить много нового материала, мы опустим этот этап и будем обучать и тестировать модель на одних и тех же данных.

Исследовательский анализ данных

Теперь давайте более внимательно посмотрим на имеющиеся у нас данные. Как вы вероятно заметили, все признаки в этом датасете количественные, за исключением переменной CHAS.

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 |

<class ‘pandas.core.frame.DataFrame’> RangeIndex: 506 entries, 0 to 505 Data columns (total 14 columns): # Column Non-Null Count Dtype — —— ————— —— 0 CRIM 506 non-null float64 1 ZN 506 non-null float64 2 INDUS 506 non-null float64 3 CHAS 506 non-null float64 4 NOX 506 non-null float64 5 RM 506 non-null float64 6 AGE 506 non-null float64 7 DIS 506 non-null float64 8 RAD 506 non-null float64 9 TAX 506 non-null float64 10 PTRATIO 506 non-null float64 11 B 506 non-null float64 12 LSTAT 506 non-null float64 13 MEDV 506 non-null float64 dtypes: float64(14) memory usage: 55.5 KB |

|

# мы видим, что переменная CHAS категориальная boston.CHAS.value_counts() |

|

0.0 471 1.0 35 Name: CHAS, dtype: int64 |

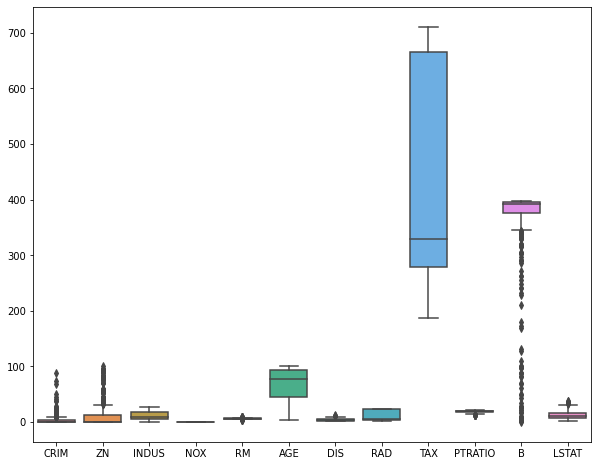

Посмотрим на распределение признаков с помощью boxplots.

|

plt.figure(figsize = (10, 8)) sns.boxplot(data = boston.drop(columns = [‘CHAS’, ‘MEDV’])) plt.show() |

Посмотрим на распределение целевой переменной.

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 |

def box_density(x): # создадим два подграфика f, (ax_box, ax_kde) = plt.subplots(nrows = 2, # из двух строк ncols = 1, # и одного столбца sharex = True, # оставим только нижние подписи к оси x gridspec_kw = {‘height_ratios’: (.15, .85)}, # зададим разную высоту строк figsize = (10,8)) # зададим размер графика # в первом подграфике построим boxplot sns.boxplot(x = x, ax = ax_box) ax_box.set(xlabel = None) # во втором — график плотности распределения sns.kdeplot(x, fill = True) # зададим заголовок и подписи к осям ax_box.set_title(‘Распределение переменной’, fontsize = 17) ax_kde.set_xlabel(‘Переменная’, fontsize = 15) ax_kde.set_ylabel(‘Плотность распределения’, fontsize = 15) plt.show() |

|

box_density(boston.iloc[:, —1]) |

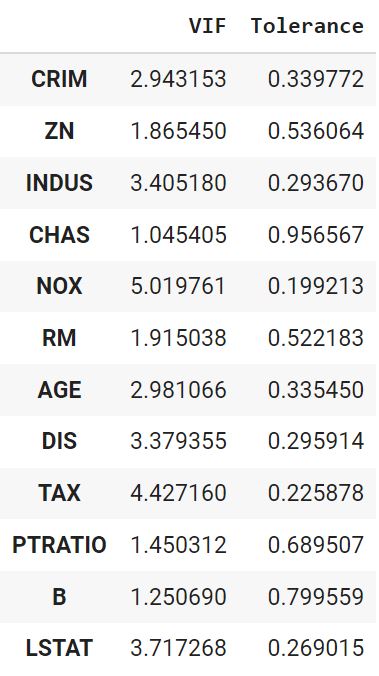

Посмотрим на корреляцию количественных признаков с целевой переменной.

|

boston.drop(columns = ‘CHAS’).corr().MEDV.to_frame().style.background_gradient() |

Используем точечно-бисериальную корреляцию для оценки взамосвязи переменной CHAS и целевой переменной.

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 |

def pbc(continuous, binary): # преобразуем количественную переменную в массив Numpy continuous_values = np.array(continuous) # классы качественной переменной превратим в нули и единицы binary_values = np.unique(binary, return_inverse = True)[1] # создадим две подгруппы количественных наблюдений # в зависимости от класса дихотомической переменной group0 = continuous_values[np.argwhere(binary_values == 0).flatten()] group1 = continuous_values[np.argwhere(binary_values == 1).flatten()] # найдем средние групп, mean0, mean1 = np.mean(group0), np.mean(group1) # а также длины групп и всего датасета n0, n1, n = len(group0), len(group1), len(continuous_values) # рассчитаем СКО количественной переменной std = continuous_values.std() # подставим значения в формулу return (mean1 — mean0) / std * np.sqrt( (n1 * n0) / (n * (n—1)) ) |

|

pbc(boston.MEDV, boston.CHAS) |

Обработка данных

Пропущенные значения

Посмотрим, есть ли пропущенные значения.

|

CRIM 0 ZN 0 INDUS 0 CHAS 0 NOX 0 RM 0 AGE 0 DIS 0 RAD 0 TAX 0 PTRATIO 0 B 0 LSTAT 0 MEDV 0 dtype: int64 |

Выбросы

Удалим выбросы.

|

from sklearn.ensemble import IsolationForest clf = IsolationForest(max_samples = 100, random_state = 42) clf.fit(boston) boston[‘anomaly’] = clf.predict(boston) boston = boston[boston.anomaly == 1] boston = boston.drop(columns = ‘anomaly’) boston.shape |

При удалении выбросов важно помнить, что полное отсутствие вариантивности в данных не позволит выявить взаимосвязи.

Масштабирование признаков

Приведем признаки к одному масштабу (целевую переменную трогать не будем).

|

boston.iloc[:, :—1] = (boston.iloc[:, :—1] — boston.iloc[:, :—1].mean()) / boston.iloc[:, :—1].std() |

Замечу, что метод наименьших квадратов не требует масштабирования признаков, градиентному спуску же напротив необходимо, чтобы все значения находились в одном диапазоне (подробнее в дополнительных материалах).

Кодирование категориальных переменных