Проверка статистических гипотез

- Понятие о статистической гипотезе

- Уровень значимости при проверке гипотезы

- Критическая область

- Простая гипотеза и критерии согласия

- Критерий согласия (X^2) Пирсона

- Примеры

п.1. Понятие о статистической гипотезе

Статистическая гипотеза – это предположение о виде распределения и свойствах случайной величины в наблюдаемой выборке данных.

Прежде всего, мы формулируем «рабочую» гипотезу. Желательно это делать не на основе полученных данных, а исходя из природы и свойств исследуемого явления.

Затем формулируется нулевая гипотеза (H_0), отвергающая нашу рабочую гипотезу.

Наша рабочая гипотеза при этом называется альтернативной гипотезой (H_1).

Получаем, что (H_0=overline{H_1}), т.е. нулевая и альтернативная гипотеза вместе составляют полную группу несовместных событий.

Основной принцип проверки гипотезы – доказательство «от противного», т.е. опровергнуть гипотезу (H_0) и тем самым доказать гипотезу (H_1).

В результате проверки гипотезы возможны 4 исхода:

| Верная гипотеза | |||

| (H_0) | (H_1) | ||

| Принятая гипотеза | (H_0) | True Negative (H_0) принята верно |

False Negative (H_0) принята неверно Ошибка 2-го рода |

| (H_1) | False Positive (H_0) отвергнута неверно (H_1) принята неверно Ошибка 1-го рода |

True Positive (H_0) отвергнута верно (H_1) принята верно |

Ошибка 1-го рода – «ложная тревога».

Ошибка 2-го рода – «пропуск события».

Например:

К врачу обращается человек с некоторой жалобой.

Гипотеза (H_1) — человек болен, гипотеза (H_0) — человек здоров.

True Negative – здорового человека признают здоровым

True Positive – больного человека признают больным

False Positive – здорового человека признают больным – «ложная тревога»

False Negative – больного человека признают здоровым – «пропуск события»

Уровень значимости при проверке гипотезы

Статистический тест (статистический критерий) – это строгое математическое правило, по которому гипотеза принимается или отвергается.

В статистике разработано множество критериев: критерии согласия, критерии нормальности, критерии сдвига, критерии выбросов и т.д.

Уровень значимости – это пороговая (критическая) вероятность ошибки 1-го рода, т.е. непринятия гипотезы (H_0), когда она верна («ложная тревога»).

Требуемый уровень значимости α задает критическое значение для статистического теста.

Например:

Уровень значимости α=0,05 означает, что допускается не более чем 5%-ая вероятность ошибки.

В результате статистического теста на конкретных данных получают эмпирический уровень значимости p. Чем меньше значение p, тем сильнее аргументы против гипотезы (H_0).

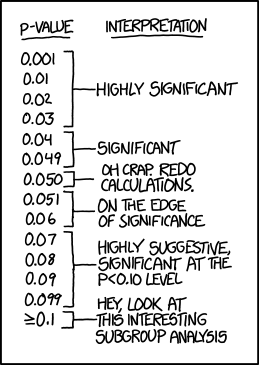

Обобщив практический опыт, можно сформулировать следующие рекомендации для оценки p и выбора критического значения α:

| Уровень значимости (p) |

Решение о гипотезе (H_0) | Вывод для гипотезы (H_1) |

| (pgt 0,1) | (H_0) не может быть отклонена | Статистически достоверные доказательства не обнаружены |

| (0,5lt pleq 0,1) | Истинность (H_0) сомнительна, неопределенность | Доказательства обнаружены на уровне статистической тенденции |

| (0,01lt pleq 0,05) | Отклонение (H_0), значимость | Обнаружены статистически достоверные (значимые) доказательства |

| (pleq 0,01) | Отклонение (H_0), высокая значимость | Доказательства обнаружены на высоком уровне значимости |

Здесь под «доказательствами» мы понимаем результаты наблюдений, свидетельствующие в пользу гипотезы (H_1).

Традиционно уровень значимости α=0,05 выбирается для небольших выборок, в которых велика вероятность ошибки 2-го рода. Для выборок с (ngeq 100) критический уровень снижают до α=0,01.

п.3. Критическая область

Критическая область – область выборочного пространства, при попадании в которую нулевая гипотеза отклоняется.

Требуемый уровень значимости α, который задается исследователем, определяет границу попадания в критическую область при верной нулевой гипотезе.

Различают 3 вида критических областей

Критическая область на чертежах заштрихована.

(K_{кр}=chi_{f(alpha)}) определяют границы критической области в зависимости от α.

Если эмпирическое значение критерия попадает в критическую область, гипотезу (H_0) отклоняют.

Пусть (K*) — эмпирическое значение критерия. Тогда:

(|K|gt K_{кр}) – гипотеза (H_0) отклоняется

(|K|leq K_{кр}) – гипотеза (H_0) не отклоняется

п.4. Простая гипотеза и критерии согласия

Пусть (x=left{x_1,x_2,…,x_nright}) – случайная выборка n объектов из множества (X), соответствующая неизвестной функции распределения (F(t)).

Простая гипотеза состоит в предположении, что неизвестная функция (F(t)) является совершенно конкретным вероятностным распределением на множестве (X).

Например:

Глядя на полученные данные эксперимента (синие точки), можно выдвинуть следующую простую гипотезу:

(H_0): данные являются выборкой из равномерного распределения на отрезке [-1;1]

Критерий согласия проверяет, согласуется ли заданная выборка с заданным распределением или с другой выборкой.

К критериям согласия относятся:

- Критерий Колмогорова-Смирнова;

- Критерий (X^2) Пирсона;

- Критерий (omega^2) Смирнова-Крамера-фон Мизеса

п.5. Критерий согласия (X^2) Пирсона

Пусть (left{t_1,t_2,…,t_nright}) — независимые случайные величины, подчиняющиеся стандартному нормальному распределению N(0;1) (см. §63 данного справочника)

Тогда сумма квадратов этих величин: $$ x=t_1^2+t_2^2+⋯+t_n^2 $$ является случайной величиной, которая имеет распределение (X^2) с n степенями свободы.

График плотности распределения (X^2) при разных n имеет вид:

С увеличением n распределение (X^2) стремится к нормальному (согласно центральной предельной теореме – см. §64 данного справочника).

Если мы:

1) выдвигаем простую гипотезу (H_0) о том, что полученные данные являются выборкой из некоторого закона распределения (f(x));

2) выбираем в качестве теста проверки гипотезы (H_0) критерий Пирсона, —

тогда определение критической области будет основано на распределении (X^2).

Заметим, что выдвижение основной гипотезы в качестве (H_0) при проведении этого теста исторически сложилось.

В этом случае критическая область правосторонняя.

Мы задаем уровень значимости α и находим критическое значение

(X_{кр}^2=X^2(alpha,k-r-1)), где k — число вариант в исследуемом ряду, r – число параметров предполагаемого распределения.

Для этого есть специальные таблицы.

Или используем функцию ХИ2ОБР(α,k-r-1) в MS Excel (она сразу считает нужный нам правый хвост). Например, при r=0 (для равномерного распределения):

Пусть нам дан вариационный ряд с экспериментальными частотами (f_i, i=overline{1,k}).

Пусть наша гипотеза (H_0) –данные являются выборкой из закона распределения с известной плотностью распределения (p(x)).

Тогда соответствующие «теоретические частоты» (m_i=Ap(x_i)), где (x_i) – значения вариант данного ряда, A – коэффициент, который в общем случае зависит от ряда (дискретный или непрерывный).

Находим значение статистического теста: $$ X_e^2=sum_{j=1}^kfrac{(f_i-m_i)^2}{m_i} $$ Если эмпирическое значение (X_e^2) окажется в критической области, гипотеза (H_0) отвергается.

(X_e^2geq X_{кр}^2) — закон распределения не подходит (гипотеза (H_0) не принимается)

(X_e^2lt X_{кр}^2) — закон распределения подходит (гипотеза (H_0) принимается)

Например:

В эксперименте 60 раз подбрасывают игральный кубик и получают следующие результаты:

| Очки, (x_i) | 1 | 2 | 3 | 4 | 5 | 6 |

| Частота, (f_i) | 8 | 12 | 13 | 7 | 12 | 8 |

Не является ли кубик фальшивым?

Если кубик не фальшивый, то справедлива гипотеза (H_0) — частота выпадений очков подчиняется равномерному распределению: $$ p_i=frac16, i=overline{1,6} $$ При N=60 экспериментах каждая сторона теоретически должна выпасть: $$ m_i=p_icdot N=frac16cdot 60=10 $$ по 10 раз.

Строим расчетную таблицу:

| (x_i) | 1 | 2 | 3 | 4 | 5 | 6 | ∑ |

| (f_i) | 8 | 12 | 13 | 7 | 12 | 8 | 60 |

| (m_i) | 10 | 10 | 10 | 10 | 10 | 10 | 60 |

| (f_i-m_i) | -2 | 2 | 3 | -3 | 2 | -2 | — |

| (frac{(f_i-m_i)^2}{m_i}) | 0,4 | 0,4 | 0,9 | 0,9 | 0,4 | 0,4 | 3,4 |

Значение теста: $$ X_e^2=3,4 $$ Для уровня значимости α=0,05, k=6 и r=0 находим критическое значение:

Значит, с вероятностью 95% кубик не фальшивый.

п.6. Примеры

Пример 1. В эксперименте 72 раза подбрасывают игральный кубик и получают следующие результаты:

| Очки, (x_i) | 1 | 2 | 3 | 4 | 5 | 6 |

| Частота, (f_i) | 8 | 12 | 13 | 7 | 10 | 22 |

Не является ли кубик фальшивым?

Если кубик не фальшивый, то справедлива гипотеза (H_0) — частота выпадений очков подчиняется равномерному распределению: $$ p_i=frac16, i=overline{1,6} $$ При N=72 экспериментах каждая сторона теоретически должна выпасть: $$ m_i=p_icdot N=frac16cdot 72=12 $$ по 12 раз.

Строим расчетную таблицу:

| (x_i) | 1 | 2 | 3 | 4 | 5 | 6 | ∑ |

| (f_i) | 8 | 12 | 13 | 7 | 10 | 22 | 72 |

| (m_i) | 12 | 12 | 12 | 12 | 12 | 12 | 72 |

| (f_i-m_i) | -4 | 0 | 1 | -5 | -2 | 10 | — |

| (frac{(f_i-m_i)^2}{m_i}) | 1,333 | 0,000 | 0,083 | 2,083 | 0,333 | 8,333 | 12,167 |

Значение теста: $$ X_e^2=12,167 $$ Для уровня значимости α=0,05, k=6 и r=0 находим критическое значение:

Значит, с вероятностью 95% кубик фальшивый.

Пример 2. Во время Второй мировой войны Лондон подвергался частым бомбардировкам. Чтобы улучшить организацию обороны, город разделили на 576 прямоугольных участков, 24 ряда по 24 прямоугольника.

В течение некоторого времени были получены следующие данные по количеству попаданий на участки:

| Число попаданий, (x_i) | 0 | 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| Количество участков, (f_i) | 229 | 211 | 93 | 35 | 7 | 0 | 0 | 1 |

Проверялась гипотеза (H_0) — стрельба случайна.

Если стрельба случайна, то попадание на участок должно иметь распределение, подчиняющееся «закону редких событий» — закону Пуассона с плотностью вероятности: $$ p(k)=frac{lambda^k}{k!}e^{-lambda} $$ где (k) — число попаданий. Чтобы получить значение (lambda), нужно посчитать математическое ожидание данного распределения.

Составим расчетную таблицу:

| (x_i) | 0 | 1 | 2 | 3 | 4 | 5 | 6 | 7 | ∑ |

| (f_i) | 229 | 211 | 93 | 35 | 7 | 0 | 0 | 1 | 576 |

| (x_if_i) | 0 | 211 | 186 | 105 | 28 | 0 | 0 | 7 | 537 |

$$ lambdaapprox M(x)=frac{sum x_if_i}{N}=frac{537}{576}approx 0,932 $$ Тогда теоретические частоты будут равны: $$ m_i=Ncdot p(k) $$ Получаем:

| (x_i) | 0 | 1 | 2 | 3 | 4 | 5 | 6 | 7 | ∑ |

| (f_i) | 229 | 211 | 93 | 35 | 7 | 0 | 0 | 1 | 576 |

| (p_i) | 0,39365 | 0,36700 | 0,17107 | 0,05316 | 0,01239 | 0,00231 | 0,00036 | 0,00005 | 0,99999 |

| (m_i) | 226,7 | 211,4 | 98,5 | 30,6 | 7,1 | 1,3 | 0,2 | 0,0 | 576,0 |

| (f_i-m_i) | 2,3 | -0,4 | -5,5 | 4,4 | -0,1 | -1,3 | -0,2 | 1,0 | — |

| (frac{(f_i-m_i)^2}{m_i}) (результат) | 0,02 | 0,00 | 0,31 | 0,63 | 0,00 | 1,33 | 0,21 | 34,34 | 36,84 |

Значение теста: (X_e^2=36,84)

Поскольку в ходе исследования мы нашли оценку для λ через подсчет выборочной средней, нужно уменьшить число степеней свободы на r=1, и критическое значение статистики искать для (X_{кр}^2=X^2(alpha,k-2)).

Для уровня значимости α=0,05 и k=8, r=1 находим:

(X_{кр}^2approx 12,59)

Получается, что: (X_e^2gt X_{кр}^2)

Гипотеза (H_0) не принимается.

Стрельба не случайна.

Пример 3. В предыдущем примере объединили события x={4;5;6;7} с редким числом попаданий:

| Число попаданий, (x_i) | 0 | 1 | 2 | 3 | 4-7 |

| Количество участков, (f_i) | 229 | 211 | 93 | 35 | 8 |

Проверялась гипотеза (H_0) — стрельба случайна.

Для последней объединенной варианты находим среднюю взвешенную: $$ x_5=frac{4cdot 7+5cdot 0+6cdot 0+7cdot 1}{7+1}=4,375 $$ Найдем оценку λ.

| (x_i) | 0 | 1 | 2 | 3 | 4,375 | ∑ |

| (f_i) | 229 | 211 | 93 | 35 | 8 | 576 |

| (x_if_i) | 0 | 211 | 186 | 105 | 35 | 537 |

$$ lambdaapprox M(x)=frac{sum x_if_i}{N}=frac{537}{576}approx 0,932 $$ Оценка не изменилась, что указывает на правильное определение средней для (x_5).

Строим расчетную таблицу для подсчета статистики:

| (x_i) | 0 | 1 | 2 | 3 | 4,375 | ∑ |

| (f_i) | 229 | 211 | 93 | 35 | 8 | 576 |

| (p_i) | 0,3937 | 0,3670 | 0,1711 | 0,0532 | 0,0121 | 0,9970 |

| (m_i) | 226,7 | 211,4 | 98,5 | 30,6 | 7,0 | 574,2 |

| (f_i-m_i) | 2,3 | -0,4 | -5,5 | 4,4 | 1,0 | — |

| (frac{(f_i-m_i)^2}{m_i}) | 0,02 | 0,00 | 0,31 | 0,63 | 0,16 | 1,12 |

Значение теста: (X_e^2=1,12)

Критическое значение статистики ищем в виде (X_{кр}^2=X^2(alpha,k-2)), где α=0,05 и k=5, r=1

(X_{кр}^2approx 7,81)

Получается, что: (X_e^2lt X_{кр}^2)

Гипотеза (H_0) принимается.

Стрельба случайна.

И какой же ответ верный? Полученный в Примере 2 или в Примере 3?

Если посмотреть в расчетную таблицу для статистики (X_e^2) в Примере 2, основной вклад внесло слагаемое для (x_i=7). Оно равно 34,34 и поэтому сумма (X_e^2=36,84) в итоге велика. А в расчетной таблице Примера 3 такого выброса нет. Для объединенной варианты (x_i=4,375) слагаемое статистики равно 0,16 и сумма (X_e^2=1,12) в итоге мала.

Правильный ответ – в Примере 3.

Стрельба случайна.

В статистике p-значения обычно используются при проверке гипотез для t-тестов, тестов хи-квадрат, регрессионного анализа, дисперсионного анализа и множества других статистических методов.

Несмотря на то, что это так распространено, люди часто неправильно интерпретируют p-значения, что может привести к ошибкам при интерпретации результатов анализа или исследования.

В этом посте объясняется, как понять и интерпретировать p-значения понятным и практичным способом.

Проверка гипотезы

Чтобы понять p-значения, нам сначала нужно понять концепцию проверки гипотез .

Проверка гипотезы — это формальный статистический тест, который мы используем, чтобы отвергнуть или не отвергнуть какую-либо гипотезу. Например, мы можем предположить, что новое лекарство, метод или процедура дает некоторые преимущества по сравнению с текущим лекарством, методом или процедурой.

Чтобы проверить это, мы можем провести проверку гипотезы, в которой мы используем нулевую и альтернативную гипотезы:

Нулевая гипотеза.Между новым и старым методом нет никакого эффекта или разницы.

Альтернативная гипотеза.Между новым и старым методом существует некоторый эффект или разница.

Значение p показывает, насколько правдоподобна нулевая гипотеза с учетом данных выборки. В частности, если предположить, что нулевая гипотеза верна, p-значение говорит нам о вероятности получения эффекта, по крайней мере, такого же большого, как тот, который мы фактически наблюдали в выборке данных.

Если p-значение проверки гипотезы достаточно низкое, мы можем отклонить нулевую гипотезу. В частности, когда мы проводим проверку гипотезы, мы должны с самого начала выбрать уровень значимости. Обычный выбор уровней значимости: 0,01, 0,05 и 0,10.

Если p-значения меньше нашего уровня значимости, мы можем отклонить нулевую гипотезу.

В противном случае, если p-значение равно или превышает наш уровень значимости, мы не можем отвергнуть нулевую гипотезу.

Как интерпретировать P-значение

Определение p-значения в учебнике:

P-значение — это вероятность наблюдения выборочной статистики, которая по крайней мере столь же экстремальна, как и ваша выборочная статистика, при условии, что нулевая гипотеза верна.

Например, предположим, что завод заявляет, что производит шины, средний вес которых составляет 200 фунтов. Аудитор выдвигает гипотезу о том, что истинный средний вес шин, произведенных на этом заводе, отличается от 200 фунтов, поэтому он проводит проверку гипотезы и обнаруживает, что p-значение теста равно 0,04. Вот как интерпретировать это p-значение:

Если фабрика действительно производит шины со средним весом 200 фунтов, то 4% всех аудитов получат эффект, наблюдаемый в выборке, или больше из-за случайной ошибки выборки. Это говорит нам о том, что получение выборочных данных, которые сделал аудитор, было бы довольно редким, если бы завод действительно производил шины, средний вес которых составлял 200 фунтов.

В зависимости от уровня значимости, используемого в этой проверке гипотезы, аудитор, скорее всего, отклонит нулевую гипотезу о том, что истинный средний вес шин, произведенных на этом заводе, действительно составляет 200 фунтов. Выборочные данные, полученные им в ходе аудита, не очень согласуются с нулевой гипотезой.

Как не следует интерпретировать P-значение

Самое большое заблуждение относительно p-значений состоит в том, что они эквивалентны вероятности совершить ошибку, отклонив истинную нулевую гипотезу (известную как ошибка типа I).

Есть две основные причины, по которым p-значения не могут быть частотой ошибок:

1. P-значения рассчитываются на основе предположения, что нулевая гипотеза верна и что разница между данными выборки и нулевой гипотезой просто вызвана случайностью. Таким образом, p-значения не могут сказать вам вероятность того, что ноль является истинным или ложным, поскольку он на 100% верен, исходя из точки зрения вычислений.

2. Хотя низкое значение p указывает на то, что ваши выборочные данные маловероятны при условии, что нулевое значение истинно, значение p по-прежнему не может сказать вам, какой из следующих случаев более вероятен:

- Нуль является ложным

- Нуль верен, но вы получили нечетную выборку

Что касается предыдущего примера, вот правильный и неправильный способ интерпретации p-значения:

- Правильная интерпретация: если предположить, что завод производит шины со средним весом 200 фунтов, вы получите наблюдаемую разницу, которую вы получили в своей выборке, или более значительную разницу в 4% аудитов из-за ошибки случайной выборки.

- Неверная интерпретация: если вы отвергаете нулевую гипотезу, существует 4%-ная вероятность того, что вы делаете ошибку.

Примеры интерпретации P-значений

Следующие примеры иллюстрируют правильные способы интерпретации p-значений в контексте проверки гипотез.

Пример 1

Телефонная компания утверждает, что 90% ее клиентов довольны их услугами. Чтобы проверить это утверждение, независимый исследователь собрал простую случайную выборку из 200 клиентов и спросил их, довольны ли они своим сервисом, на что 85% ответили утвердительно. Значение p, связанное с данными выборки, оказалось равным 0,018.

Правильная интерпретация p-значения: если предположить, что 90% клиентов действительно удовлетворены их обслуживанием, исследователь получит наблюдаемую разницу, которую он действительно получил в своей выборке, или более экстремальную разницу в 1,8% аудитов из-за ошибки случайной выборки. .

Пример 2

Компания изобретает новый аккумулятор для телефонов. Компания утверждает, что эта новая батарея будет работать как минимум на 10 минут дольше, чем старая. Чтобы проверить это утверждение, исследователь берет простую случайную выборку из 80 новых батарей и 80 старых батарей. Новые батареи работают в среднем 120 минут при стандартном отклонении 12 минут, а старые батареи работают в среднем 115 минут при стандартном отклонении 15 минут. Значение p, полученное в результате теста на разницу в средних значениях населения, равно 0,011.

Правильная интерпретация p-значения: если предположить, что новая батарея работает столько же или меньше времени, чем старая батарея, исследователь получит наблюдаемую разницу или более крайнюю разницу в 1,1% исследований из-за случайной ошибки выборки.

Уровни статистической значимости

Уровень значимости – это вероятность того, что мы сочли различия существенными, в то время как они на самом деле случайны.

Итак, уровень значимости имеет дело с вероятностью.

Уровень значимости показывает степень достоверности выявленных различий между выборками, т.е. показывает, насколько мы можем доверять тому, что различия действительно есть.

Современные научные исследования требуют обязательных расчётов уровня статистической значимости результатов.

Обычно в прикладной статистике используют 3 уровня значимости.

Уровни значимости

1. 1-й уровень значимости: р ≤ 0,05.

Это 5%-ный уровень значимости. До 5% составляет вероятность того, что мы ошибочно сделали вывод о том, что различия достоверны, в то время как они недостоверны на самом деле. Можно сказать и по-другому: мы лишь на 95% уверены в том, что различия действительно достоверны. В данном случае можно написать и так: P>0,95. Общий смысл критерия останется тем же.

2. 2-й уровень значимости: р ≤ 0,01.

Это 1%-ный уровень значимости. Вероятность ошибочного вывода о том, что различия достоверны, составляет не более 1%. Можно сказать и по-другому: мы на 99% уверены в том, что различия действительно достоверны. В данном случае можно написать и так: P>0,99. Смысл останется тем же.

3. 3-й уровень значимости: р ≤ 0,001.

Это 0,1%-ный уровень значимости. Всего 0,1% составляет вероятность того, что мы сделали ошибочный вывод о том, что различия достоверны. Это — самый надёжный вариант вывода о достоверности различий. Можно сказать и по-другому: мы на 99,9% уверены в том, что различия действительно достоверны. В данном случае можно написать и так: P>0,999. Смысл опять-таки останется тем же.

Уровень значимости – это вероятность ошибочного отклонения (отвержения) гипотезы, в то время как она на самом деле верна. Речь идёт об отклонении нулевой гипотезы Но.

Уровень значимости – это допустимая ошибка в нашем утверждении, в нашем выводе.

Ошибки

Возможны ошибки двух родов: первого рода (α ) и второго рода (β).

Ошибка I рода – мы отклонили нулевую гипотезу, в то время как она верна.

α – ошибка I рода.

р ≤ 0,05, уровень ошибки α ≤ 0,05

Вероятность того, что принято правильное решение: 1 – α = 0,95, или 95%.

Уровни значимости для ошибок I рода

1. α ≤ 0,05 – низший уровень

Низший уровень значимости – позволяет отклонять нулевую гипотезу, но еще не разрешает принять альтернативную.

2. α ≤ 0,01 – достаточный уровень

Достаточный уровень – позволяет отклонять нулевую гипотезу и принимать альтернативную.

Исключение:

G – критерий знаков

T – критерий Вилкоксона

U – критерий Манна – Уитни.

Для них обратное соотношение.

3. α ≤ 0,001 – высший уровень значимости.

На практике различия считают достоверными при р ≤ 0,05.

Для ненаправленной статистической гипотезы используется двусторонний критерий значимости. Он более строгий, так как проверяет различия в обе стороны: в сторону нулевой гипотезы и в сторону альтернативной. Поэтому для него используется критерий значимости 0,01.

Мощность критерия – его способность выявлять даже мелкие различия если они есть. Чем мощнее критерий, тем лучше он отвергает нулевую гипотезу и подтверждает альтернативную.

Здесь появляется понятие: ошибка II рода.

Ошибка II рода – это принятие нулевой гипотезы, хотя она не верна.

Мощность критерия: 1 – β

Чем мощнее критерий, тем он привлекательнее для исследователя. Он лучше отвергает нулевую гипотезу.

Чем привлекательны маломощные критерии?

Достоинства маломощных критериев

-

Простота

-

Широкий диапазон, по отношению к самым разным данным

-

Применимость к неравным по объему выборкам.

-

Большая информативность результатов.

Самый популярный статистический критерий в России — Т-критерий Стьюдента. Но всего в 30% статей его используют правильно, а в 70% — неправильно, т.к. не проверяют предварительно выборку на нормальность распределения.

Второй по популярности — критерий хи-квадрат, χ2

За рубежом:

Т-критерий Вилкоксона

U-критерий Манна – Уитни

χ2 — хи-квадрат.

Т-критерий Стьюдента – это частный случай дисперсионного анализа для более маленькой по объёму выборки.

Материал из MachineLearning.

Перейти к: навигация, поиск

Содержание

- 1 Стандартная методика проверки статистических гипотез

- 2 Вычисление пи-величины

- 3 Вычисление ROC-кривой

- 4 Литература

- 5 См. также

- 6 Ссылки

Уровень значимости статистического теста — допустимая для данной задачи вероятность ошибки первого рода (ложноположительного решения, false positive), то есть вероятность отклонить нулевую гипотезу, когда на самом деле она верна.

Другая интерпретация:

уровень значимости — это такое (достаточно малое) значение вероятности события, при котором событие уже можно считать неслучайным.

Уровень значимости обычно обозначают греческой буквой (альфа).

Стандартная методика проверки статистических гипотез

В стандартной методике проверки статистических гипотез уровень значимости фиксируется заранее, до того, как становится известной выборка

.

Чрезмерное уменьшение уровня значимости (вероятности ошибки первого рода) может привести к увеличению вероятности ошибки второго рода, то есть вероятности принять нулевую гипотезу, когда на самом деле она не верна (это называется ложноотрицательным решением, false negative).

Вероятность ошибки второго рода связана с мощностью критерия

простым соотношением

.

Выбор уровня значимости требует компромисса между значимостью и мощностью или

(что то же самое, но другими словами)

между вероятностями ошибок первого и второго рода.

Обычно рекомендуется выбирать уровень значимости из априорных соображений.

Однако на практике не вполне ясно, какими именно соображениями надо руководствоваться,

и выбор часто сводится к назначению одного из популярных вариантов

.

В докомпьютерную эпоху эта стандартизация позволяла сократить объём справочных статистических таблиц.

Теперь нет никаких специальных причин для выбора именно этих значений.

Существует две альтернативные методики, не требующие априорного назначения .

Вычисление пи-величины

Достигаемый уровень значимости или пи-величина (p-value) — это наименьшая величина уровня значимости,

при которой нулевая гипотеза отвергается для данного значения статистики критерия .

где

— критическая область критерия.

Другая интерпретация:

достигаемый уровень значимости или пи-величина — это вероятность, с которой (при условии истинности нулевой гипотезы) могла бы реализоваться наблюдаемая выборка, или любая другая выборка с ещё менее вероятным значением статистики

.

Случайная величина имеет равномерное распределение.

Фактически, функция приводит значение статистики критерия

к шкале вероятности.

Маловероятным значениям (хвостам распределения) статистики соотвествуют значения

, близкие к нулю или к единице.

Вычислив значение на заданной выборке

,

статистик имеет возможность решить,

является ли это значение достаточно малым, чтобы отвергнуть нулевую гипотезу.

Данная методика является более гибкой, чем стандартная.

В частности, она допускает «нестандартное решение» — продолжить наблюдения, увеличивая объём выборки, если оценка вероятности ошибки первого рода попадает в зону неуверенности, скажем, в отрезок .

Вычисление ROC-кривой

ROC-кривая (receiver operating characteristic) — это зависимость мощности от уровня значимости

.

Методика предполагает, что статистик укажет подходящую точку на ROC-кривой, которая соответствует компромиссу между вероятностями ошибок I и II рода.

Литература

- Кобзарь А. И. Прикладная математическая статистика. Справочник для инженеров и научных работников. — М.: Физматлит, 2006.

- Цейтлин Н. А. Из опыта аналитического статистика. — М.: Солар, 2006. — 905 с.

- Алимов Ю. И. Альтернатива методу математической статистики. — М.: Знание, 1980.

См. также

- Проверка статистических гипотез — о стандартной методике проверки статистических гипотез.

- Достигаемый уровень значимости, синонимы: пи-величина, p-Value.

Ссылки

- P-value — статья в англоязычной Википедии.

- ROC curve — статья в англоязычной Википедии.

Уровень

значимости –

это вероятность того, что мы сочли

различия существенными, в то время как

она на самом деле случайны.

Уровень

значимости показывает степень

достоверности выявленных различий

между выборками, т.е. показывает, насколько

мы можем доверять тому, что различия

действительно есть.

Уровни

значимости:1. 1-й

уровень значимости: р ≤ 0,05.

Это 5%-ный уровень

значимости. До 5% составляет вероятность

того, что мы ошибочно сделали вывод о

том, что различия достоверны, в то время

как они недостоверны на самом деле.

2. 2-й

уровень значимости: р ≤ 0,01.

Это 1%-ный уровень

значимости. Вероятность ошибочного

вывода о том, что различия достоверны,

составляет не более 1%.

3. 3-й

уровень значимости: р ≤ 0,001.

Это

0,1%-ный уровень значимости. Всего 0,1%

составляет вероятность того, что мы

сделали ошибочный вывод о том, что

различия достоверны. Это — самый надёжный

вариант вывода о достоверности различий..

Уровень

значимости –

это вероятность

ошибочного отклонения (отвержения)

гипотезы, в то время как она на самом

деле верна. Речь идёт об отклонении

нулевой гипотезы Но.

Мощность

критерия –

его способность выявлять даже мелкие

различия если они есть. Чем мощнее

критерий, тем лучше он отвергает нулевую

гипотезу.

Здесь

появляется понятие: ошибка II рода.

Ошибка II рода

– это

принятие нулевой гипотезы, хотя она не

верна.

Мощность

критерий: 1 – β

Чем

мощнее критерий, тем он привлекательнее

для исследователя. Он лучше отвергает

нулевую гипотезу.

46. Проверка статистических гипотез.

Проверка

статистических гипотез —

один из основных разделов математической

статистики,

объединяющий методы проверки соответствия

статистических данных некоторой

статистической гипотезе (гипотезе о

вероятностной природе данных). Процедуры

проверки статистических гипотез

позволяют принимать или отвергать

статистические гипотезы, возникающие

при обработке или интерпретации

результатов наблюдений по многих

практически важных разделах науки и

производства, связанных со случайным

экспериментом.

Теория

проверки статистических гипотез

позволяет с единой точки зрения трактовать

задачи математической статистики,

связанные с проверкой гипотез (оценка

различия между средними значениями,

проверка гипотезы постоянства дисперсии,

проверка гипотез независимости, проверка

гипотез о распределениях и т. п.). Идеи

последовательного статистического

анализа, применённые к проверке

статистических гипотез, указывают на

возможность связать решение о принятии

или отклонении гипотезы с результатами

последовательно проводимых наблюдений

(в этом случае число наблюдений, на

основе которых по определённому правилу

принимается решение, не фиксируется

заранее, а определяется в ходе

эксперимента). Основные задачи проверки

статистических гипотез могут быть

сформулированы в рамках теории

статистических решений.

53. Ранговая корреляция

РАНГОВАЯ

КОРРЕЛЯЦИЯ— мера зависимости

междуслучайными

величинами(наблюдаемымипризнаками,переменными),

когда эту зависимость невозможно

определить количественно с помощью

обычного коэффициента корреляции .

Процедура установления Р. к. заключается

в упорядочении изучаемых объектов в

отношении некоторого признака, т. е.

им приписываются порядковые номера

—ранги(по два номера в

соответствии с двумя наблюдаемыми

признаками, между которыми исследуется

корреляция).. Наиболее распространен

коэффициент Р. к. (коэффициент

Спирмэна):

где Di—

разница между рангами, присвоенными

каждой из переменныхi(i=

1, 2, …,n);N— размер

выборки. Этот коэффициент принимает

значения между +1 и –1, показывая тесноту

и направление связи между исследуемыми

величинами. Метод Р. к. — один из

т. н.непараметрических

методовматематической

статистики.

Соседние файлы в предмете [НЕСОРТИРОВАННОЕ]

- #

- #

- #

- #

- #

- #

- #

- #

- #

- #

- #

Что такое p-value?

P-значение (англ. P-value) — величина, используемая при тестировании статистических гипотез. Фактически это вероятность ошибки при отклонении нулевой гипотезы (ошибки первого рода). Проверка гипотез с помощью P-значения является альтернативой классической процедуре проверки через критическое значение распределения.

Обычно P-значение равно вероятности того, что случайная величина с данным распределением (распределением тестовой статистики при нулевой гипотезе) примет значение, не меньшее, чем фактическое значение тестовой статистики. Википедия.

Иначе говоря, p-значение – это наименьшее значение уровня значимости (т.е. вероятности отказа от справедливой гипотезы), для которого вычисленная проверочная статистика ведет к отказу от нулевой гипотезы. Обычно p-значение сравнивают с общепринятыми стандартными уровнями значимости 0,005 или 0,01.

Например, если вычисленное по выборке значение проверочной статистики соответствует p = 0,005, это указывает на вероятность справедливости гипотезы 0,5%. Таким образом, чем p-значение меньше, тем лучше, поскольку при этом увеличивается «сила» отклонения нулевой гипотезы и увеличивается ожидаемая значимость результата.

Интересное объяснение этого есть на Хабре.

Статистический анализ начинает напоминать черный ящик: на вход подаются данные, на выход — таблица основных результатов и значение p-уровня значимости (p-value).

О чём говорит p-value?

Предположим, мы решили выяснить, существует ли взаимосвязь между пристрастием к кровавым компьютерным играм и агрессивностью в реальной жизни. Для этого были случайным образом сформированы две группы школьников по 100 человек в каждой (1 группа — фанаты стрелялок, вторая группа — не играющие в компьютерные игры). В качестве показателя агрессивности выступает, например, число драк со сверстниками. В нашем воображаемом исследовании оказалось, что группа школьников-игроманов действительно заметно чаще конфликтует с товарищами. Но как нам выяснить, насколько статистически достоверны полученные различия? Может быть, мы получили наблюдаемую разницу совершенно случайно? Для ответа на эти вопросы и используется значение p-уровня значимости (p-value) — это вероятность получить такие или более выраженные различия при условии, что в генеральной совокупности никаких различий на самом деле нет. Иными словами, это вероятность получить такие или еще более сильные различия между нашими группами, при условии, что, на самом деле, компьютерные игры никак не влияют на агрессивность. Звучит не так уж и сложно. Однако, именно этот статистический показатель очень часто интерпретируется неправильно.

Примеры про p-value

Итак, мы сравнили две группы школьников между собой по уровню агрессивности при помощи стандартного t-теста (или непараметрического критерия Хи — квадрат более уместного в данной ситуации) и получили, что заветный p-уровень значимости меньше 0.05 (например 0.04). Но о чем в действительности говорит нам полученное значение p-уровня значимости? Итак, если p-value — это вероятность получить такие или более выраженные различия при условии, что в генеральной совокупности никаких различий на самом деле нет, то какое, на ваш взгляд, верное утверждение:

1.Компьютерные игры — причина агрессивного поведения с вероятностью 96%.

2. Вероятность того, что агрессивность и компьютерные игры не связаны, равна 0.04.

3. Если бы мы получили p-уровень значимости больше, чем 0.05, это означало бы, что агрессивность и компьютерные игры никак не связаны между собой.

4. Вероятность случайно получить такие различия равняется 0.04.

5. Все утверждения неверны.

Если вы выбрали пятый вариант, то абсолютно правы! Но, как показывают многочисленные исследования, даже люди со значительным опытом в анализе данных часто некорректно интерпретируют значение p-value.

Давайте разберём все ответы по порядку:

Первое утверждение — пример ошибки корреляции: факт значимой взаимосвязи двух переменных ничего не говорит нам о причинах и следствиях. Может быть, это более агрессивные люди предпочитают проводить время за компьютерными играми, а вовсе не компьютерные игры делают людей агрессивнее.

Это уже более интересное утверждение. Всё дело в том, что мы изначально принимаем за данное, что никаких различий на самом деле нет. И, держа это в уме как факт, рассчитываем значение p-value. Поэтому правильная интерпретация: «Если предположить, что агрессивность и компьютерные игры никак не связаны, то вероятность получить такие или еще более выраженные различия составила 0.04».

А что делать, если мы получили незначимые различия? Значит ли это, что никакой связи между исследуемыми переменными нет? Нет, это означает лишь то, что различия, может быть, и есть, но наши результаты не позволили их обнаружить.

Это напрямую связано с самим определением p-value. 0.04 — это вероятность получить такие или ещё более экстремальные различия. Оценить вероятность получить именно такие различия, как в нашем эксперименте, в принципе невозможно!

Вот такие подводные камни могут скрываться в интерпретации такого показателя, как p-value. Поэтому очень важно понимать механизмы, заложенные в основании методов анализа и расчета основных статистических показателей.

Как найти p-value?

Источник.

1. Определите ожидаемые в вашем эксперименте результаты

Обычно когда ученые проводят эксперимент, у них уже есть идея того, какие результаты считать «нормальными» или «типичными». Это может быть основано на экспериментальных результатах прошлых опытов, на достоверных наборах данных, на данных из научной литературы, либо ученый может основываться на каких-либо других источниках. Для вашего эксперимента определите ожидаемые результаты, и выразите их в виде чисел.

Пример: Например, более ранние исследования показали, что в вашей стране красные машины чаще получают штрафы за превышение скорости, чем синие машины. Например, средние результаты показывают предпочтение 2:1 красных машин перед синими. Мы хотим определить, относится ли полиция точно так же предвзято к цвету машин в вашем городе. Для этого мы будем анализировать штрафы, выданные за превышение скорости. Если мы возьмем случайный набор из 150 штрафов за превышение скорости, выданных либо красным, либо синим автомобилям, мы ожидаем, что 100 штрафов будет выписано красным автомобилям, а 50 синим, если полиция в нашем городе так же предвзято относится к цвету машин, как это наблюдается по всей стране.

2. Определите наблюдаемые результаты вашего эксперимента

Теперь, когда вы опредили ожидаемые результаты, необходимо провести эксперимент, и найти действительные (или «наблюдаемые») значения. Вам снова необходимо представить эти результаты в виде чисел. Если мы создаем экспериментальные условия, и наблюдаемые результаты отличаются от ожидаемых, то у нас есть две возможности – либо это произошло случайно, либо это вызвано именно нашим экспериментом. Цель нахождения p-значения как раз и состоит в том, чтобы определить, отличаются ли наблюдаемые результаты от ожидаемых настолько, чтобы можно было не отвергать «нулевую гипотезу» – гипотезу о том, что между экспериментальными переменными и наблюдаемыми результатами нет никакой связи.

Пример: Например, в нашем городе мы случайно выбрали 150 штрафов за превышение скорости, которые были выданы либо красным, либо синим автомобилям. Мы определили, что 90 штрафов были выписаны красным автомобилям, и 60 синим. Это отличается от ожидаемых результатов, которые равны 100 и 50, соответственно. Действительно ли наш эксперимент (в данном случае, изменение источника данных с национального на городской) привел к данному изменению в результатах, или наша городская полиция относится предвзято точно так же, как и в среднем по стране, а мы видим просто случайное отклонение? P-значение поможет нам это определить.

3. Определите число степеней свободы вашего эксперимента

Число степеней свободы — это степень изменяемости вашего эксперимента, которая определяется числом категорий, которые вы исследуете. Уравнение для числа степеней свободы – Число степеней свободы = n-1, где «n» это число категорий или переменных, которые вы анализируете в своем эксперименте.

Пример: В нашем эксперименте две категории результатов: одна категория для красных машин, и одна для синих машин. Поэтому в нашем эксперименте у нас 2-1 = 1 степень свободы. Если бы мы сравнивали красные, синие и зеленые машины, у нас было бы 2 степени свободы, и так далее.

4. Сравните ожидаемые и наблюдаемые результаты с помощью критерия хи-квадрат

Хи-квадрат (пишется «x2») это числовое значение, которое измеряет разницу между ожидаемыми и наблюдаемыми значениями эксперимента. Уравнение для хи-квадрата следующее x2 = Σ((o-e)2/e), где «o» это наблюдаемое значение, а «e» это ожидаемое значение. Суммируйте результаты данного уравнения для всех возможных результатов (смотри ниже).

Заметьте, что данное уравнение включает оператор суммирования Σ (сигма). Другими словами, вам необходимо подсчитать ((|o-e|-.05)2/e) для каждого возможного результата, и сложить полученные числа, чтобы получить значение критерия хи-квадрат. В нашем примере у нас два возможных результата – либо машина, получившая штраф красная, либо синяя. Поэтому мы должны посчитать ((o-e)2/e) дважды – один раз для красных машин, и один раз для синих машин.

Пример: Давайте подставим наши ожидаемые и наблюдаемые значения в уравнение x2 = Σ((o-e)2/e). Помните, что из-за оператора суммирования нам необходимо посчитать ((o-e)2/e) дважды – один раз для красных автомобилей, и один раз для синих автомобилей. Мы выполним эту работу следующим образом:

x2 = ((90-100)2/100) + (60-50)2/50)

x2 = ((-10)2/100) + (10)2/50)

x2 = (100/100) + (100/50) = 1 + 2 = 3.

5. Выберите уровень значимости

Теперь, когда мы знаем число степеней свободы нашего эксперимента, и узнали значение критерия хи-квадрат, нам нужно сделать еще одну вещь перед тем, как мы найдем наше p-значение. Нам нужно определить уровень значимости. Говоря простым языком, уровень значимости показывает, насколько мы уверены в наших результатах. Низкое значение для значимости соответствует низкой вероятности того, что экспериментальные результаты получились случайно, и наоборот. Уровни значимости записываются в виде десятичных дробей (таких как 0.01), что соответствует вероятности того, что экспериментальные результаты мы получили случайно (в данном случае вероятность этого 1%).

По соглашению, ученые обычно устанавливают уровень значимости своих экспериментов равным 0.05, или 5%.[2] Это означает, что экспериментальные результаты, которые соответствуют такому критерию значимости, только с вероятностью 5% могли получиться чисто случайно. Другими словами, существует 95% вероятность, что результаты были вызваны тем, как ученый манипулировал экспериментальными переменными, а не случайно. Для большинства экспериментов 95% уверенности наличия связи между двумя переменными достаточно, чтобы считать, что они «действительно» связаны друг с другом.

Пример: для нашего примера с красными и синими машинами, давайте последуем соглашению между учеными, и установим уровень значимости в 0.05.

6. Используйте таблицу с данными распределения хи-квадрат, чтобы найти ваше p-значение

Ученые и статисты используют большие таблицы для вычисления p-значения своих экспериментов. Данные таблицы обычно имеют вертикальную ось слева, соответствующую числу степеней свободы, и горизонтальную ось сверху, соответствующую p-значению. Используйте данные таблицы, чтобы сначала найти число ваших степеней свободы, затем посмотрите на ваш ряд слева направо, пока не найдете первое значение, большее вашего значения хи-квадрат. Посмотрите на соответствующее p-значение вверху вашего столбца. Ваше p-значение находится между этим числом и следующим за ним (тем, которое находится левее вашего).

Таблицы с распределением хи-квадрат можно получить из множества источников (вот по этой ссылке можно найти одну из них).

Пример: Наше значение критерия хи-квадрат было равно 3. Так как мы знаем, что в нашем эксперименте всего 1 степень свободы, выберем самую первую строку. Идем слева направо по данной строке, пока не встретим значение, большее 3, нашего значения критерия хи-квадрат. Первое, которое мы находим это 3.84. Смотрим вверх нашего столбца, и видим, что соответствующее p-значение равно 0.05. Это означает, что наше p-значение между 0.05 и 0.1 (следующее p-значение в таблице по возрастанию).

7. Решите, отклонить или оставить вашу нулевую гипотезу

Так как вы определили приблизительное p-значение для вашего эксперимента, вам необходимо решить, отклонять ли нулевую гипотезу вашего эксперимента или нет (напоминаем, это гипотеза о том, что экспериментальные переменные, которыми вы манипулировали не повлияли на наблюдаемые вами результаты). Если ваше p-значение меньше, чем ваш уровень значимости – поздравляем, вы доказали, что очень вероятна связь между переменными, которыми вы манипулировали и результатами, которые вы наблюдали. Если ваше p-значение выше, чем ваш уровень значимости, вы не можете с уверенностью сказать, были ли наблюдаемые вами результаты результатом чистой случайности или манипуляцией вашими переменными.

Пример: Наше p-значение находится между 0,05 и 0,1. Это явно не меньше, чем 0,05, поэтому, к сожалению, мы не можем отклонить нашу нулевую гипотезу. Это означает, что мы не достигли минимум 95% вероятности того, чтобы сказать, что полиция в нашем городе выдает штрафы красным и синим автомобилям с такой вероятностью, которая достаточно сильно отличается от средней по стране.

Другими словами, существует 5-10% шанс, что наблюдаемые нами результаты – это не последствия смены места (анализа города, а не всей страны), а просто случайность. Так как мы потребовали точности меньше чем 5%, мы не можем сказать что мы уверены в том, что полиция нашего города менее предвзято относится к красным автомобилям – существует небольшая (но статистически значимая) вероятность, что это не так.