Как нетрудно догадаться, ко всему этому причастны корректирующие коды. Собственно, ECC так и расшифровывается — «error-correcting code», то есть «код, исправляющий ошибки». А CRC — это один из алгоритмов, обнаруживающих ошибки в данных. Исправить он их не может, но часто это и не требуется.

Давайте же разберёмся, что это такое.

Для понимания статьи не нужны никакие специальные знания. Достаточно лишь понимать, что такое вектор и матрица, как они перемножаются и как с их помощью записать систему линейных уравнений.

Внимание! Много текста и мало картинок. Я постарался всё объяснить, но без карандаша и бумаги текст может показаться немного запутанным.

Каналы с ошибкой

Разберёмся сперва, откуда вообще берутся ошибки, которые мы собираемся исправлять. Перед нами стоит следующая задача. Нужно передать несколько блоков данных, каждый из которых кодируется цепочкой двоичных цифр. Получившаяся последовательность нулей и единиц передаётся через канал связи. Но так сложилось, что реальные каналы связи часто подвержены ошибкам. Вообще говоря, ошибки могут быть разных видов — может появиться лишняя цифра или какая-то пропасть. Но мы будем рассматривать только ситуации, когда в канале возможны лишь замены нуля на единицу и наоборот. Причём опять же для простоты будем считать такие замены равновероятными.

Ошибка — это маловероятное событие (а иначе зачем нам такой канал вообще, где одни ошибки?), а значит, вероятность двух ошибок меньше, а трёх уже совсем мала. Мы можем выбрать для себя некоторую приемлемую величину вероятности, очертив границу «это уж точно невозможно». Это позволит нам сказать, что в канале возможно не более, чем ошибок. Это будет характеристикой канала связи.

Для простоты введём следующие обозначения. Пусть данные, которые мы хотим передавать, — это двоичные последовательности фиксированной длины. Чтобы не запутаться в нулях и единицах, будем иногда обозначать их заглавными латинскими буквами (,

,

, …). Что именно передавать, в общем-то неважно, просто с буквами в первое время будет проще работать.

Кодирование и декодирование будем обозначать прямой стрелкой (), а передачу по каналу связи — волнистой стрелкой (

). Ошибки при передаче будем подчёркивать.

Например, пусть мы хотим передавать только сообщения и

. В простейшем случае их можно закодировать нулём и единицей (сюрприз!):

Передача по каналу, в котором возникла ошибка будет записана так:

Цепочки нулей и единиц, которыми мы кодируем буквы, будем называть кодовыми словами. В данном простом случае кодовые слова — это и

.

Код с утроением

Давайте попробуем построить какой-то корректирующий код. Что мы обычно делаем, когда кто-то нас не расслышал? Повторяем дважды:

Правда, это нам не очень поможет. В самом деле, рассмотрим канал с одной возможной ошибкой:

Какие выводы мы можем сделать, когда получили ? Понятно, что раз у нас не две одинаковые цифры, то была ошибка, но вот в каком разряде? Может, в первом, и была передана буква

. А может, во втором, и была передана

.

То есть, получившийся код обнаруживает, но не исправляет ошибки. Ну, тоже неплохо, в общем-то. Но мы пойдём дальше и будем теперь утраивать цифры.

Проверим в деле:

Получили . Тут у нас есть две возможности: либо это

и было две ошибки (в крайних цифрах), либо это

и была одна ошибка. Вообще, вероятность одной ошибки выше вероятности двух ошибок, так что самым правдоподобным будет предположение о том, что передавалась именно буква

. Хотя правдоподобное — не значит истинное, поэтому рядом и стоит вопросительный знак.

Если в канале связи возможна максимум одна ошибка, то первое предположение о двух ошибках становится невозможным и остаётся только один вариант — передавалась буква .

Про такой код говорят, что он исправляет одну ошибку. Две он тоже обнаружит, но исправит уже неверно.

Это, конечно, самый простой код. Кодировать легко, да и декодировать тоже. Ноликов больше — значит передавался ноль, единичек — значит единица.

Если немного подумать, то можно предложить код исправляющий две ошибки. Это будет код, в котором мы повторяем одиночный бит 5 раз.

Расстояния между кодами

Рассмотрим поподробнее код с утроением. Итак, мы получили работающий код, который исправляет одиночную ошибку. Но за всё хорошее надо платить: он кодирует один бит тремя. Не очень-то и эффективно.

И вообще, почему этот код работает? Почему нужно именно утраивать для устранения одной ошибки? Наверняка это всё неспроста.

Давайте подумаем, как этот код работает. Интуитивно всё понятно. Нолики и единички — это две непохожие последовательности. Так как они достаточно длинные, то одиночная ошибка не сильно портит их вид.

Пусть мы передавали , а получили

. Видно, что эта цепочка больше похожа на исходные

, чем на

. А так как других кодовых слов у нас нет, то и выбор очевиден.

Но что значит «больше похоже»? А всё просто! Чем больше символов у двух цепочек совпадает, тем больше их схожесть. Если почти все символы отличаются, то цепочки «далеки» друг от друга.

Можно ввести некоторую величину , равную количеству различающихся цифр в соответствующих разрядах цепочек

и

. Эту величину называют расстоянием Хэмминга. Чем больше это расстояние, тем меньше похожи две цепочки.

Например, , так как все цифры в соответствующих позициях равны, а вот

.

Расстояние Хэмминга называют расстоянием неспроста. Ведь в самом деле, что такое расстояние? Это какая-то характеристика, указывающая на близость двух точек, и для которой верны утверждения:

- Расстояние между точками неотрицательно и равно нулю только, если точки совпадают.

- Расстояние в обе стороны одинаково.

- Путь через третью точку не короче, чем прямой путь.

Достаточно разумные требования.

Математически это можно записать так (нам это не пригодится, просто ради интереса посмотрим):

.

Предлагаю читателю самому убедиться, что для расстояния Хэмминга эти свойства выполняются.

Окрестности

Таким образом, разные цепочки мы считаем точками в каком-то воображаемом пространстве, и теперь мы умеем находить расстояния между ними. Правда, если попытаться сколько нибудь длинные цепочки расставить на листе бумаги так, чтобы расстояния Хэмминга совпадали с расстояниями на плоскости, мы можем потерпеть неудачу. Но не нужно переживать. Всё же это особое пространство со своими законами. А слова вроде «расстояния» лишь помогают нам рассуждать.

Пойдём дальше. Раз мы заговорили о расстоянии, то можно ввести такое понятие как окрестность. Как известно, окрестность какой-то точки — это шар определённого радиуса с центром в ней. Шар? Какие ещё шары! Мы же о кодах говорим.

Но всё просто. Ведь что такое шар? Это множество всех точек, которые находятся от данной не дальше, чем некоторое расстояние, называемое радиусом. Точки у нас есть, расстояние у нас есть, теперь есть и шары.

Так, скажем, окрестность кодового слова радиуса 1 — это все коды, находящиеся на расстоянии не больше, чем 1 от него, то есть отличающиеся не больше, чем в одном разряде. То есть это коды:

Да, вот так странно выглядят шары в пространстве кодов.

А теперь посмотрите. Это же все возможные коды, которые мы получим в канале в одной ошибкой, если отправим ! Это следует прямо из определения окрестности. Ведь каждая ошибка заставляет цепочку измениться только в одном разряде, а значит удаляет её на расстояние 1 от исходного сообщения.

Аналогично, если в канале возможны две ошибки, то отправив некоторое сообщение , мы получим один из кодов, который принадлежит окрестности

радиусом 2.

Тогда всю нашу систему декодирования можно построить так. Мы получаем какую-то цепочку нулей и единиц (точку в нашей новой терминологии) и смотрим, в окрестность какого кодового слова она попадает.

Сколько ошибок может исправить код?

Чтобы код мог исправлять больше ошибок, окрестности должны быть как можно шире. С другой стороны, они не должны пересекаться. Иначе если точка попадёт в область пересечения, непонятно будет, к какой окрестности её отнести.

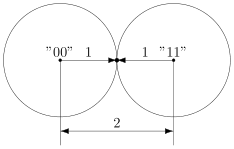

В коде с удвоением между кодовыми словами и

расстояние равно 2 (оба разряда различаются). А значит, если мы построим вокруг них шары радиуса 1, то они будут касаться. Это значит, точка касания будет принадлежать обоим шарам и непонятно будет, к какому из них её отнести.

Именно это мы и получали. Мы видели, что есть ошибка, но не могли её исправить.

Что интересно, точек касания в нашем странном пространстве у шаров две — это коды и

. Расстояния от них до центров равны единице. Конечно же, в обычно геометрии такое невозможно, поэтому рисунки — это просто условность для более удобного рассуждения.

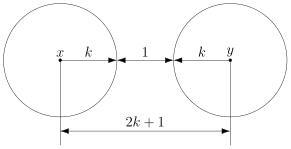

В случае кода с утроением, между шарами будет зазор.

Минимальный зазор между шарами равен 1, так как у нас расстояния всегда целые (ну не могут же две цепочки отличаться в полутора разрядах).

В общем случае получаем следующее.

Этот очевидный результат на самом деле очень важен. Он означает, что код с минимальным кодовым расстоянием будет успешно работать в канале с

ошибками, если выполняется соотношение

Полученное равенство позволяет легко определить, сколько ошибок будет исправлять тот или иной код. А сколько код ошибок может обнаружить? Рассуждения такие же. Код обнаруживает ошибок, если в результате не получится другое кодовое слово. То есть, кодовые слова не должны находиться в окрестностях радиуса

других кодовых слов. Математически это записывается так:

Рассмотрим пример. Пусть мы кодируем 4 буквы следующим образом.

Чтобы найти минимальное расстояние между различными кодовыми словами, построим таблицу попарных расстояний.

| A | B | C | D | |

|---|---|---|---|---|

| A | — | 3 | 3 | 4 |

| B | 3 | — | 4 | 3 |

| C | 3 | 4 | — | 3 |

| D | 4 | 3 | 3 | — |

Минимальное расстояние , а значит

, откуда получаем, что такой код может исправить до

ошибок. Обнаруживает же он две ошибки.

Рассмотрим пример:

Чтобы декодировать полученное сообщение, посмотрим, к какому символу оно ближе всего.

Минимальное расстояние получилось для символа , значит вероятнее всего передавался именно он:

Итак, этот код исправляет одну ошибку, как и код с утроением. Но он более эффективен, так как в отличие от кода с утроением здесь кодируется уже 4 символа.

Таким образом, основная проблема при построении такого рода кодов — так расположить кодовые слова, чтобы они были как можно дальше друг от друга, и их было побольше.

Для декодирования можно было бы использовать таблицу, в которой указывались бы все возможные принимаемые сообщения, и кодовые слова, которым они соответствуют. Но такая таблица получилась бы очень большой. Даже для нашего маленького кода, который выдаёт 5 двоичных цифр, получилось бы варианта возможных принимаемых сообщений. Для более сложных кодов таблица будет значительно больше.

Попробуем придумать способ коррекции сообщения без таблиц. Мы всегда сможем найти полезное применение освободившейся памяти.

Интерлюдия: поле GF(2)

Для изложения дальнейшего материала нам потребуются матрицы. А при умножении матриц, как известно мы складываем и перемножаем числа. И тут есть проблема. Если с умножением всё более-менее хорошо, то как быть со сложением? Из-за того, что мы работаем только с одиночными двоичными цифрами, непонятно, как сложить 1 и 1, чтобы снова получилась одна двоичная цифра. Значит вместо классического сложения нужно использовать какое-то другое.

Введём операцию сложения как сложение по модулю 2 (хорошо известный программистам XOR):

Умножение будем выполнять как обычно. Эти операции на самом деле введены не абы как, а чтобы получилась система, которая в математике называется полем. Поле — это просто множество (в нашем случае из 0 и 1), на котором так определены сложение и умножение, чтобы основные алгебраические законы сохранялись. Например, чтобы основные идеи, касающиеся матриц и систем уравнений по-прежнему были верны. А вычитание и деление мы можем ввести как обратные операции.

Множество из двух элементов с операциями, введёнными так, как мы это сделали, называется полем Галуа GF(2). GF — это Galois field, а 2 — количество элементов.

У сложения есть несколько очень полезных свойств, которыми мы будем пользоваться в дальнейшем.

Это свойство прямо следует из определения.

А в этом можно убедиться, прибавив к обеим частям равенства. Это свойство, в частности означает, что мы можем переносить в уравнении слагаемые в другую сторону без смены знака.

Проверяем корректность

Вернёмся к коду с утроением.

Для начала просто решим задачу проверки, были ли вообще ошибки при передаче. Как видно, из самого кода, принятое сообщение будет кодовым словом только тогда, когда все три цифры равны между собой.

Пусть мы приняли вектор-строку из трёх цифр. (Стрелочки над векторами рисовать не будем, так как у нас почти всё — это вектора или матрицы.)

Математически равенство всех трёх цифр можно записать как систему:

Или, если воспользоваться свойствами сложения в GF(2), получаем

Или

В матричном виде эта система будет иметь вид

где

Транспонирование здесь нужно потому, что — это вектор-строка, а не вектор-столбец. Иначе мы не могли бы умножать его справа на матрицу.

Будем называть матрицу проверочной матрицей. Если полученное сообщение — это корректное кодовое слово (то есть, ошибки при передаче не было), то произведение проверочной матрицы на это сообщение будет равно нулевому вектору.

Умножение на матрицу — это гораздо более эффективно, чем поиск в таблице, но у нас на самом деле есть ещё одна таблица — это таблица кодирования. Попробуем от неё избавиться.

Кодирование

Итак, у нас есть система для проверки

Её решения — это кодовые слова. Собственно, мы систему и строили на основе кодовых слов. Попробуем теперь решить обратную задачу. По системе (или, что то же самое, по матрице ) найдём кодовые слова.

Правда, для нашей системы мы уже знаем ответ, поэтому, чтобы было интересно, возьмём другую матрицу:

Соответствующая система имеет вид:

Чтобы найти кодовые слова соответствующего кода нужно её решить.

В силу линейности сумма двух решений системы тоже будет решением системы. Это легко доказать. Если и

— решения системы, то для их суммы верно

что означает, что она тоже — решение.

Поэтому если мы найдём все линейно независимые решения, то с их помощью можно получить вообще все решения системы. Для этого просто нужно найти их всевозможные суммы.

Выразим сперва все зависимые слагаемые. Их столько же, сколько и уравнений. Выражать надо так, чтобы справа были только независимые. Проще всего выразить .

Если бы нам не так повезло с системой, то нужно было бы складывая уравнения между собой получить такую систему, чтобы какие-то три переменные встречались по одному разу. Ну, или воспользоваться методом Гаусса. Для GF(2) он тоже работает.

Итак, получаем:

Чтобы получить все линейно независимые решения, приравниваем каждую из зависимых переменных к единице по очереди.

Всевозможные суммы этих независимых решений (а именно они и будут кодовыми векторами) можно получить так:

где равны либо нулю или единице. Так как таких коэффициентов два, то всего возможно

сочетания.

Но посмотрите! Формула, которую мы только что получили — это же снова умножение матрицы на вектор.

Строчки здесь — линейно независимые решения, которые мы получили. Матрица называется порождающей. Теперь вместо того, чтобы сами составлять таблицу кодирования, мы можем получать кодовые слова простым умножением на матрицу:

Найдём кодовые слова для этого кода. (Не забываем, что длина исходных сообщений должна быть равна 2 — это количество найденных решений.)

Итак, у нас есть готовый код, обнаруживающий ошибки. Проверим его в деле. Пусть мы хотим отправить 01 и у нас произошла ошибка при передаче. Обнаружит ли её код?

А раз в результате не нулевой вектор, значит код заподозрил неладное. Провести его не удалось. Ура, код работает!

Для кода с утроением, кстати, порождающая матрица выглядит очень просто:

Подобные коды, которые можно порождать и проверять матрицей называются линейными (бывают и нелинейные), и они очень широко применяются на практике. Реализовать их довольно легко, так как тут требуется только умножение на константную матрицу.

Ошибка по синдрому

Ну хорошо, мы построили код обнаруживающий ошибки. Но мы же хотим их исправлять!

Для начала введём такое понятие, как вектор ошибки. Это вектор, на который отличается принятое сообщение от кодового слова. Пусть мы получили сообщение , а было отправлено кодовое слово

. Тогда вектор ошибки по определению

Но в странном мире GF(2), где сложение и вычитание одинаковы, будут верны и соотношения:

В силу особенностей сложения, как читатель сам может легко убедиться, в векторе ошибки на позициях, где произошла ошибка будет единица, а на остальных ноль.

Как мы уже говорили раньше, если мы получили сообщение с ошибкой, то

. Но ведь векторов, не равных нулю много! Быть может то, какой именно ненулевой вектор мы получили, подскажет нам характер ошибки?

Назовём результат умножения на проверочную матрицу синдромом:

И заметим следующее

Это означает, что для ошибки синдром будет таким же, как и для полученного сообщения.

Разложим все возможные сообщения, которые мы можем получить из канала связи, по кучкам в зависимости от синдрома. Тогда из последнего соотношения следует, что в каждой кучке будут вектора с одной и той же ошибкой. Причём вектор этой ошибки тоже будет в кучке. Вот только как его узнать?

А очень просто! Помните, мы говорили, что у нескольких ошибок вероятность ниже, чем у одной ошибки? Руководствуясь этим соображением, наиболее правдоподобным будет считать вектором ошибки тот вектор, у которого меньше всего единиц. Будем называть его лидером.

Давайте посмотрим, какие синдромы дают всевозможные 5-элементные векторы. Сразу сгруппируем их и подчеркнём лидеров — векторы с наименьшим числом единиц.

В принципе, для корректирования ошибки достаточно было бы хранить таблицу соответствия синдрома лидеру.

Обратите внимание, что в некоторых строчках два лидера. Это значит для для данного синдрома два паттерна ошибки равновероятны. Иными словами, код обнаружил две ошибки, но исправить их не может.

Лидеры для всех возможных одиночных ошибок находятся в отдельных строках, а значит код может исправить любую одиночную ошибку. Ну, что же… Попробуем в этом убедиться.

Вектор ошибки равен , а значит ошибка в третьем разряде. Как мы и загадали.

Ура, всё работает!

Что же дальше?

Чтобы попрактиковаться, попробуйте повторить рассуждения для разных проверочных матриц. Например, для кода с утроением.

Логическим продолжением изложенного был бы рассказ о циклических кодах — чрезвычайно интересном подклассе линейных кодов, обладающим замечательными свойствами. Но тогда, боюсь, статья уж очень бы разрослась.

Если вас заинтересовали подробности, то можете почитать замечательную книжку Аршинова и Садовского «Коды и математика». Там изложено гораздо больше, чем представлено в этой статье. Если интересует математика кодирования — то поищите «Теория и практика кодов, контролирующих ошибки» Блейхута. А вообще, материалов по этой теме довольно много.

Надеюсь, когда снова будет свободное время, напишу продолжение, в котором расскажу про циклические коды и покажу пример программы для кодирования и декодирования. Если, конечно, почтенной публике это интересно.

Вектор

ош. – двоичн.

кодовое слово такой же длины как исходное,

содержащее ед-цы в тех разрядах, где

произошло искажение содержимого код.

слова. (код. слово и вектор ош. — абстракция).

Воздействие помехи на слово заменяется

слож-ем по mod2

исходн. слова с вектором ош.

Ошибки

различают на некорректируемые и

корректируемые.

Некорректир

– при которых изменение содержимого в

каком-то разряде слова не влияет на

искажение содержимого в других словах.

При

корректир – изменение содержимого под

влиянием помех влечёт искажение

содержимого некоторых других разрядах.

Различают

ош. разной кратности:

1)однократные,

2)двукратные,

3)r-кратные

(одновременное искажение содержимого

в r-

разрядах).

Однократная

ошибка вызывает искажение содержимого

только 1 разряда слова и т.д.

Вероятность

r-кратной

ошибки в n-разрядном

слове:

таких ошибок

Вероятность

такого события – вероятность сложного

события и определяется произведение

следующих множителей: вероятности, что

искажение произойдет в этом разряде p,

т.к. таких разрядов r

и события независимые, то — pr

, вероятности,

что в остальных (n-r)

разрядах искажения не будет определяется

как (1-p)(n—r)

, умноженных на количество возможных

r-кратных

ошибок. Т.о.

P=

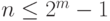

17. Формулы для определения числа избыточных разрядов и границы Хэмминга для оптимальных корректирующих кодов; их суть и связь, примеры использования.

Пусть

имеем n-разр.

слова, требуется исправлять ошибкки

вплоть до кратности S.

Определим, какое мн-во разреш-х код. слов

можно выделить на мн-ве всех n-разр-х

слов. Для каждой исправляемой ош-ки.

соотв-щее ей запрещ. код. слово. Поэтому

«вокруг» каждого разреш. слова должны

сгруппироваться те запрещ. слова, ош-ки

кот-х подлежат исправлению. Поэтому

кол-во запрещ. слов. не <, чем число

исправл-ых ошибок.

2k-1>=Q

– определяется число информационных

разрядов; 2n—k-1>=n

– определяется число разрядов

помехоустойчивого слова; n-k=m

— определяется число избыточных разрядов;

Дополнительных разрядов в кодовом слове

должно быть столько, чтобы породить

нужное число запрещенных слов или

классов смежности, а именно 2n—k-1.

Число классов смежности должно быть не

меньше, чем число исправляемых ошибок,

поэтому – 2n—k-1>=n

Пример:

Пусть для

построения кода, корректирующего все

однократные ошибки, используются

однобайтовые слова. Требуется определить

максимальное число разрешенных слов,

выбираемых из всего множества однобайтовых

слов.

Число

однократных ошибок

т.е.

Максимальное

число разрешенных слов

18. Построение группового корректирующего кода (на примере).

Пример:

тип

исправляемых ошибок — некоррелированные;

кратность

— S

= 1,

Процедура

состоит из четырех этапов.

1.

Расчет числа информационных и избыточных

разрядов:

k

= 4;

n

= 7;

n

— k

=3;

где

k

— число информационных разрядов;

n

— число

избыточных разрядов;

2.

Построение таблицы опознавателей

ошибок.

Каждой

ошибке соответствует собственный

опознаватель.

|

Векторы

а7 |

опознаватели

(данный |

|

1 |

111 |

|

0 |

110 |

|

0 |

101 |

|

0 |

100 |

|

0 |

011 |

|

0 |

010 |

|

0 |

001 |

n

= 7 n

— k

=3

3.

Определение проверочных равенств.

1

— й (младший) — а1

а3

а6

а7 ;

2

— й — а2

а5

а6

а7 ;

3

— й — а1

а2

а4

а7 ;

При

отсутствии однократных ошибок в слове

дешифратор вычислит нулевой

— опознаватель

(состоящий из одних нулей — 000). Поэтому

можно записать проверочные

равенства

дешифратора в виде следующей системы

уравнений.

уравнения, формирующие 1-ый, 2-ой и 3-ий

разряды опознавателя.

4.

Построение алгоритма кодирования.

Имея

данную систему уравнений на роль

избыточных разрядов следует выбирать

те, которые встречаются в проверочных

равенствах по одному разу, т.е.

Выделение избыточных разрядов

сопровождается определением информационных

разрядов помехоустойчивого кодового

слова. При этом для данного кода будут

помечены правила кодирования в виде:

Соседние файлы в предмете [НЕСОРТИРОВАННОЕ]

- #

- #

- #

- #

- #

- #

- #

- #

- #

- #

- #

Если комбинации кода известны и

он используется для исправления ошибок, то способ разбиения множества U на подмножества Ai

определяется статистикой ошибок, возникающих в его комбинациях. Обычно это

разбиение выполняется так, чтобы минимизировать среднюю вероятность появления

ложной комбинации на входе декодера.

В дальнейшем будем рассматривать

только двоичные коды, как получившие наибольшее распространение.

20. Понятие «вектор ошибок»

Для удобства представления

ошибок, возникающих в комбинациях двоичного корректирующего кода, используется

понятие вектор ошибок. Под вектором ошибок понимается комбинация длины N символов с 2-мя возможными значениями 0 и 1, в которой

единицы занимают позиции в комбинациях кода, на которых стоят ошибочные символы.

Все остальные позиции заняты нулями. Вес вектора ошибок ei W(ei)

= ν, где ν – кратность ошибок.

Искаженная комбинация кода V* при использовании понятия вектор ошибок

может быть представлена как результат суммы по модулю два одноименных символов

неискаженной комбинации V и вектора ошибок ei , то есть

(7)

Поскольку в комбинации кода может

быть искажено любое число символов в пределах n и эти

символы могут занимать любые позиции в комбинации, то число ненулевых векторов

ошибок:

(8)

где единица соответствует

нулевому вектору ошибок.

Если известен вектор ошибок, то

процедура исправления ошибок в принятой комбинации состоит в сложении по модулю

два принятой комбинации с вектором ошибок.

Действительно,

21. Методы определения разрядности блокового корректирующего

кода и нахождение его комбинаций.

Говоря ранее о разбиении

множества запрещенных комбинаций U на подмножества Ai, мы предполагали, что комбинации кода известны,

однако практике это не так.

Известно число комбинаций,

которые должны входить в код, и подлежащие исправлению ошибки в этих

комбинациях исходя из статистики появления ошибок. При этом задача заключается

в том, чтобы найти код, который бы содержал n комбинаций и позволял исправлять известные ошибки.

| Обноружение ошибок | ||||

| Исправление ошибок | ||||

| Коррекция ошибок | ||||

| Назад | ||||

Методы обнаружения ошибок

В обычном равномерном непомехоустойчивом коде число разрядов n в кодовых

комбинациях определяется числом сообщений и основанием кода.

Коды, у которых все кодовые комбинации разрешены, называются простыми или

равнодоступными и являются полностью безызбыточными. Безызбыточные коды обладают

большой «чувствительностью» к помехам. Внесение избыточности при использовании

помехоустойчивых кодов связано с увеличением n – числа разрядов кодовой комбинации. Таким

образом, все множество

подмножество разрешенных комбинаций, обладающих определенными признаками, и

подмножество запрещенных комбинаций, этими признаками не обладающих.

Помехоустойчивый код отличается от обычного кода тем, что в канал передаются не все

кодовые комбинации N, которые можно сформировать из имеющегося числа разрядов n, а только

их часть Nk , которая составляет подмножество разрешенных комбинаций. Если при приеме

выясняется, что кодовая комбинация принадлежит к запрещенным, то это свидетельствует о

наличии ошибок в комбинации, т.е. таким образом решается задача обнаружения ошибок. При

этом принятая комбинация не декодируется (не принимается решение о переданном

сообщении). В связи с этим помехоустойчивые коды называют корректирующими кодами.

Корректирующие свойства избыточных кодов зависят от правила их построения, определяющего

структуру кода, и параметров кода (длительности символов, числа разрядов, избыточности и т. п.).

Первые работы по корректирующим кодам принадлежат Хеммингу, который ввел понятие

минимального кодового расстояния dmin и предложил код, позволяющий однозначно указать ту

позицию в кодовой комбинации, где произошла ошибка. К информационным элементам k в коде

Хемминга добавляется m проверочных элементов для автоматического определения

местоположения ошибочного символа. Таким образом, общая длина кодовой комбинации

составляет: n = k + m.

Метричное представление n,k-кодов

В настоящее время наибольшее внимание с точки зрения технических приложений

уделяется двоичным блочным корректирующим кодам. При использовании блочных кодов

цифровая информация передается в виде отдельных кодовых комбинаций (блоков) равной

длины. Кодирование и декодирование каждого блока осуществляется независимо друг от друга.

Почти все блочные коды относятся к разделимым кодам, кодовые комбинации которых

состоят из двух частей: информационной и проверочной. При общем числе n символов в блоке

число информационных символов равно k, а число проверочных символов:

К основным характеристикам корректирующих кодов относятся:

|

— число разрешенных и запрещенных кодовых комбинаций; |

Для блочных двоичных кодов, с числом символов в блоках, равным n, общее число

возможных кодовых комбинаций определяется значением

Число разрешенных кодовых комбинаций при наличии k информационных разрядов в

первичном коде:

Очевидно, что число запрещенных комбинаций:

а с учетом отношение будет

где m – число избыточных (проверочных) разрядов в блочном коде.

Избыточностью корректирующего кода называют величину

откуда следует:

Эта величина показывает, какую часть общего числа символов кодовой комбинации

составляют информационные символы. В теории кодирования величину Bk называют

относительной скоростью кода. Если производительность источника информации равна H

символов в секунду, то скорость передачи после кодирования этой информации будет

поскольку в закодированной последовательности из каждых n символов только k символов

являются информационными.

Если число ошибок, которые нужно обнаружить или исправить, значительно, то необходимо

иметь код с большим числом проверочных символов. Чтобы при этом скорость передачи

оставалась достаточно высокой, необходимо в каждом кодовом блоке одновременно

увеличивать как общее число символов, так и число информационных символов.

При этом длительность кодовых блоков будет существенно возрастать, что приведет к

задержке информации при передаче и приеме. Чем сложнее кодирование, тем длительнее

временная задержка информации.

Минимальное кодовое расстояние – dmin. Для того чтобы можно было обнаружить и

исправлять ошибки, разрешенная комбинация должна как можно больше отличаться от

запрещенной. Если ошибки в канале связи действуют независимо, то вероятность преобразования

одной кодовой комбинации в другую будет тем меньше, чем большим числом символов они

различаются.

Если интерпретировать кодовые комбинации как точки в пространстве, то отличие

выражается в близости этих точек, т. е. в расстоянии между ними.

Количество разрядов (символов), которыми отличаются две кодовые комбинации, можно

принять за кодовое расстояние между ними. Для определения этого расстояния нужно сложить

две кодовые комбинации «по модулю 2» и подсчитать число единиц в полученной сумме.

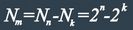

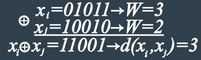

Например, две кодовые комбинации xi = 01011 и xj = 10010 имеют расстояние d(xi,xj) , равное 3,

так как:

Здесь под операцией ⊕ понимается сложение «по модулю 2».

Заметим, что кодовое расстояние d(xi,x0) между комбинацией xi и нулевой x0 = 00…0

называют весом W комбинации xi, т.е. вес xi равен числу «1» в ней.

Расстояние между различными комбинациями некоторого конкретного кода могут

существенно отличаться. Так, в частности, в безызбыточном первичном натуральном коде n = k это

расстояние для различных комбинаций может изменяться от единицы до величины n, равной

разрядности кода. Особую важность для характеристики корректирующих свойств кода имеет

минимальное кодовое расстояние dmin, определяемое при попарном сравнении всех кодовых

комбинаций, которое называют расстоянием Хемминга.

В безызбыточном коде все комбинации являются разрешенными и его минимальное

кодовое расстояние равно единице – dmin=1. Поэтому достаточно исказиться одному символу,

чтобы вместо переданной комбинации была принята другая разрешенная комбинация. Чтобы код

обладал корректирующими свойствами, необходимо ввести в него некоторую избыточность,

которая обеспечивала бы минимальное расстояние между любыми двумя разрешенными

комбинациями не менее двух – dmin ≥ 2..

Минимальное кодовое расстояние является важнейшей характеристикой помехоустойчивых

кодов, указывающей на гарантируемое число обнаруживаемых или исправляемых заданным

кодом ошибок.

Число обнаруживаемых или исправляемых ошибок

При применении двоичных кодов учитывают только дискретные искажения, при которых

единица переходит в нуль («1» → «0») или нуль переходит в единицу («0» → «1»). Переход «1» →

«0» или «0» → «1» только в одном элементе кодовой комбинации называют единичной ошибкой

(единичным искажением). В общем случае под кратностью ошибки подразумевают число

позиций кодовой комбинации, на которых под действием помехи одни символы оказались

замененными на другие. Возможны двукратные (g = 2) и многократные (g > 2) искажения

элементов в кодовой комбинации в пределах 0 ≤ g ≤ n.

Минимальное кодовое расстояние является основным параметром, характеризующим

корректирующие способности данного кода. Если код используется только для обнаружения

ошибок кратностью g0, то необходимо и достаточно, чтобы минимальное кодовое расстояние

было равно dmin ≥ g0 + 1.

В этом случае никакая комбинация из go ошибок не может перевести одну разрешенную

кодовую комбинацию в другую разрешенную. Таким образом, условие обнаружения всех ошибок

кратностью g0 можно записать

Чтобы можно было исправить все ошибки кратностью gu и менее, необходимо иметь

минимальное расстояние, удовлетворяющее условию dmin ≥ 2gu

В этом случае любая кодовая комбинация с числом ошибок gu отличается от каждой

разрешенной комбинации не менее чем в gu+1 позициях. Если условие не выполнено,

возможен случай, когда ошибки кратности g исказят переданную комбинацию так, что она станет

ближе к одной из разрешенных комбинаций, чем к переданной или даже перейдет в другую

разрешенную комбинацию. В соответствии с этим, условие исправления всех ошибок кратностью

не более gи можно записать:

Из и

следует, что если код исправляет все ошибки кратностью gu, то число

ошибок, которые он может обнаружить, равно go = 2gu. Следует отметить, что эти соотношения

устанавливают лишь гарантированное минимальное число обнаруживаемых или

исправляемых ошибок при заданном dmin и не ограничивают возможность обнаружения ошибок

большей кратности. Например, простейший код с проверкой на четность с dmin = 2 позволяет

обнаруживать не только одиночные ошибки, но и любое нечетное число ошибок в пределах go < n.

Корректирующие возможности кодов

Вопрос о минимально необходимой избыточности, при которой код обладает нужными

корректирующими свойствами, является одним из важнейших в теории кодирования. Этот вопрос

до сих пор не получил полного решения. В настоящее время получен лишь ряд верхних и нижних

оценок (границ), которые устанавливают связь между максимально возможным минимальным

расстоянием корректирующего кода и его избыточностью.

Коды Хэмминга

Построение кодов Хемминга базируется на принципе проверки на четность веса W (числа

единичных символов «1») в информационной группе кодового блока.

Поясним идею проверки на четность на примере простейшего корректирующего кода,

который так и называется кодом с проверкой на четность или кодом с проверкой по паритету

(равенству).

В таком коде к кодовым комбинациям безызбыточного первичного двоичного k-разрядного

кода добавляется один дополнительный разряд (символ проверки на четность, называемый

проверочным, или контрольным). Если число символов «1» исходной кодовой комбинации

четное, то в дополнительном разряде формируют контрольный символ «0», а если число

символов «1» нечетное, то в дополнительном разряде формируют символ «1». В результате

общее число символов «1» в любой передаваемой кодовой комбинации всегда будет четным.

Таким образом, правило формирования проверочного символа сводится к следующему:

где i – соответствующий информационный символ («0» или «1»); k – общее их число а, под

операцией ⊕ здесь и далее понимается сложение «по модулю 2». Очевидно, что добавление

дополнительного разряда увеличивает общее число возможных комбинаций вдвое по сравнению

с числом комбинаций исходного первичного кода, а условие четности разделяет все комбинации

на разрешенные и неразрешенные. Код с проверкой на четность позволяет обнаруживать

одиночную ошибку при приеме кодовой комбинации, так как такая ошибка нарушает условие

четности, переводя разрешенную комбинацию в запрещенную.

Критерием правильности принятой комбинации является равенство нулю результата S

суммирования «по модулю 2» всех n символов кода, включая проверочный символ m1. При

наличии одиночной ошибки S принимает значение 1:

— ошибок нет,

— однократная ошибка

Этот код является (k+1,k)-кодом, или (n,n–1)-кодом. Минимальное расстояние кода равно

двум (dmin = 2), и, следовательно, никакие ошибки не могут быть исправлены. Простой код с

проверкой на четность может использоваться только для обнаружения (но не исправления)

однократных ошибок.

Увеличивая число дополнительных проверочных разрядов, и формируя по определенным

правилам проверочные символы m, равные «0» или «1», можно усилить корректирующие

свойства кода так, чтобы он позволял не только обнаруживать, но и исправлять ошибки. На этом и

основано построение кодов Хемминга.

Коды Хемминга позволяют исправлять одиночную ошибку, с помощью непосредственного

описания. Для каждого числа проверочных символов m =3, 4, 5… существует классический код

Хемминга с маркировкой

т.е. (7,4), (15,11) (31,26) …

При других значениях числа информационных символов k получаются так называемые

усеченные (укороченные) коды Хемминга. Так для кода имеющего 5 информационных символов,

потребуется использование корректирующего кода (9,5), являющегося усеченным от

классического кода Хемминга (15,11), так как число символов в этом коде уменьшается

(укорачивается) на 6.

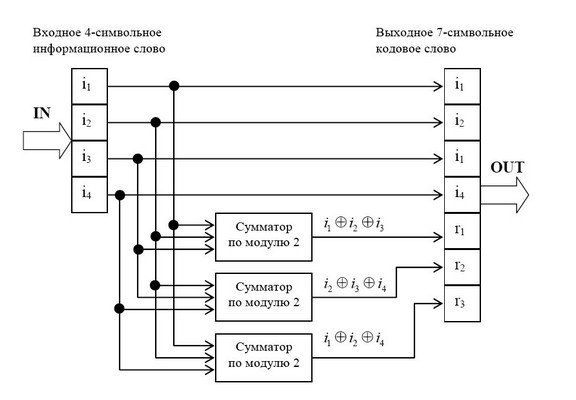

Для примера рассмотрим классический код Хемминга (7,4), который можно сформировать и

описать с помощью кодера, представленного на рис. 1 В простейшем варианте при заданных

четырех информационных символах: i1, i2, i3, i4 (k = 4), будем полагать, что они сгруппированы в

начале кодового слова, хотя это и не обязательно. Дополним эти информационные символы

тремя проверочными символами (m = 3), задавая их следующими равенствами проверки на

четность, которые определяются соответствующими алгоритмами, где знак ⊕ означает

сложение «по модулю 2»: r1 = i1 ⊕ i2 ⊕ i3, r2 = i2 ⊕ i3 ⊕ i4, r3 = i1 ⊕ i2 ⊕ i4.

В соответствии с этим алгоритмом определения значений проверочных символов mi, в табл.

1 выписаны все возможные 16 кодовых слов (7,4)-кода Хемминга.

Таблица 1 Кодовые слова (7,4)-кода Хэмминга

|

k=4 |

m=4 |

|

i1 i2 i3 i4 |

r1 r2 r3 |

|

0 0 0 0 |

0 0 0 |

|

0 0 0 1 |

0 1 1 |

|

0 0 1 0 |

1 1 0 |

|

0 0 1 1 |

1 0 1 |

|

0 1 0 0 |

1 1 1 |

|

0 1 0 1 |

1 0 0 |

|

0 1 1 0 |

0 0 1 |

|

0 1 1 1 |

0 1 0 |

|

1 0 0 0 |

1 0 1 |

|

1 0 0 1 |

1 0 0 |

|

1 0 1 0 |

0 1 1 |

|

1 0 1 1 |

0 0 0 |

|

1 1 0 0 |

0 1 0 |

|

1 1 0 1 |

0 0 1 |

|

1 1 1 0 |

1 0 0 |

|

1 1 1 1 |

1 1 1 |

На рис.1 приведена блок-схема кодера – устройства автоматически кодирующего

информационные разряды в кодовые комбинации в соответствии с табл.1

Рис. 1 Кодер для (7,4)-кода Хемминга

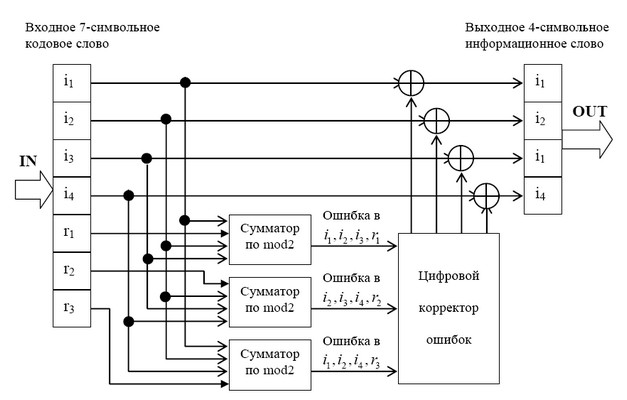

На рис. 1.4 приведена схема декодера для (7,4) – кода Хемминга, на вход которого

поступает кодовое слово

. Апостроф означает, что любой символ слова может

быть искажен помехой в телекоммуникационном канале.

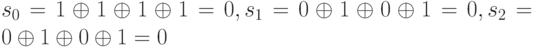

В декодере в режиме исправления ошибок строится последовательность:

Трехсимвольная последовательность (s1, s2, s3) называется синдромом. Термин «синдром»

используется и в медицине, где он обозначает сочетание признаков, характерных для

определенного заболевания. В данном случае синдром S = (s1, s2, s3) представляет собой

сочетание результатов проверки на четность соответствующих символов кодовой группы и

характеризует определенную конфигурацию ошибок (шумовой вектор).

Число возможных синдромов определяется выражением:

При числе проверочных символов m =3 имеется восемь возможных синдромов (23 =

Нулевой синдром (000) указывает на то, что ошибки при приеме отсутствуют или не обнаружены.

Всякому ненулевому синдрому соответствует определенная конфигурация ошибок, которая и

исправляется. Классические коды Хемминга имеют число синдромов, точно равное их

необходимому числу (что позволяет исправить все однократные ошибки в любом информативном

и проверочном символах) и включают один нулевой синдром. Такие коды называются

плотноупакованными.

Усеченные коды являются неплотноупакованными, так как число синдромов у них

превышает необходимое. Так, в коде (9,5) при четырех проверочных символах число синдромов

будет равно 24 =16, в то время как необходимо всего 10. Лишние 6 синдромов свидетельствуют о

неполной упаковке кода (9,5).

Рис. 2 Декодер для (7, 4)-кода Хемминга

Для рассматриваемого кода (7,4) в табл. 2 представлены ненулевые синдромы и

соответствующие конфигурации ошибок.

Таблица 2 Синдромы (7, 4)-кода Хемминга

|

Синдром |

001 |

010 |

011 |

100 |

101 |

110 |

111 |

|

Конфигурация ошибок |

0000001 |

0000010 |

0000100 |

0001000 |

0010000 |

0100000 |

1000000 |

|

Ошибка в символе |

m1 |

m2 |

i4 |

m1 |

i1 |

i3 |

i2 |

Таким образом, (7,4)-код позволяет исправить все одиночные ошибки. Простая проверка

показывает, что каждая из ошибок имеет свой единственный синдром. При этом возможно

создание такого цифрового корректора ошибок (дешифратора синдрома), который по

соответствующему синдрому исправляет соответствующий символ в принятой кодовой группе.

После внесения исправления проверочные символы ri можно на выход декодера (рис. 2) не

выводить. Две или более ошибок превышают возможности корректирующего кода Хемминга, и

декодер будет ошибаться. Это означает, что он будет вносить неправильные исправления и

выдавать искаженные информационные символы.

Идея построения подобного корректирующего кода, естественно, не меняется при

перестановке позиций символов в кодовых словах. Все такие варианты также называются (7,4)-

кодами Хемминга.

Циклические коды

Своим названием эти коды обязаны такому факту, что для них часть комбинаций, либо все

комбинации могут быть получены путем циклическою сдвига одной или нескольких базовых

комбинаций кода.

Построение такого кода основывается на использовании неприводимых многочленов в поле

двоичных чисел. Такие многочлены не могут быть представлены в виде произведения

многочленов низших степеней подобно тому, как простые числа не могут быть представлены

произведением других чисел. Они делятся без остатка только на себя или на единицу.

Для определения неприводимых многочленов раскладывают на простые множители бином

хn -1. Так, для n = 7 это разложение имеет вид:

(x7)=(x-1)(x3+x2)(x3+x-1)

Каждый из полученных множителей разложения может применяться для построения

корректирующего кода.

Неприводимый полином g(x) называют задающим, образующим или порождающим

для корректирующего кода. Длина n (число разрядов) создаваемого кода произвольна.

Кодовая последовательность (комбинация) корректирующего кода состоит из к информационных

разрядов и n — к контрольных (проверочных) разрядов. Степень порождающего полинома

r = n — к равна количеству неинформационных контрольных разрядов.

Если из сделанного выше разложения (при n = 7) взять полипом (х — 1), для которого

r=1, то k=n-r=7-1=6. Соответствующий этому полиному код используется для контроля

на чет/нечет (обнаружение ошибок). Для него минимальное кодовое расстояние D0 = 2

(одна единица от D0 — для исходного двоичного кода, вторая единица — за счет контрольного разряда).

Если же взять полином (x3+x2+1) из указанного разложения, то степень полинома

r=3, а k=n-r=7-3=4.

Контрольным разрядам в комбинации для некоторого кода могут быть четко определено место (номера разрядов).

Тогда код называют систематическим или разделимым. В противном случае код является неразделимым.

Способы построения циклических кодов по заданному полиному.

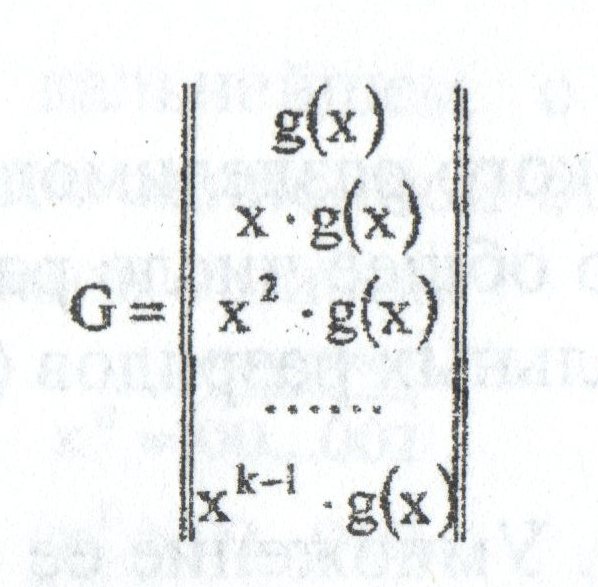

1) На основе порождающей (задающей) матрицы G, которая имеет n столбцов, k строк, то есть параметры которой

связаны с параметрами комбинаций кода. Порождающую матрицу строят, взяв в качестве ее строк порождающий

полином g(x) и (k — 1) его циклических сдвигов:

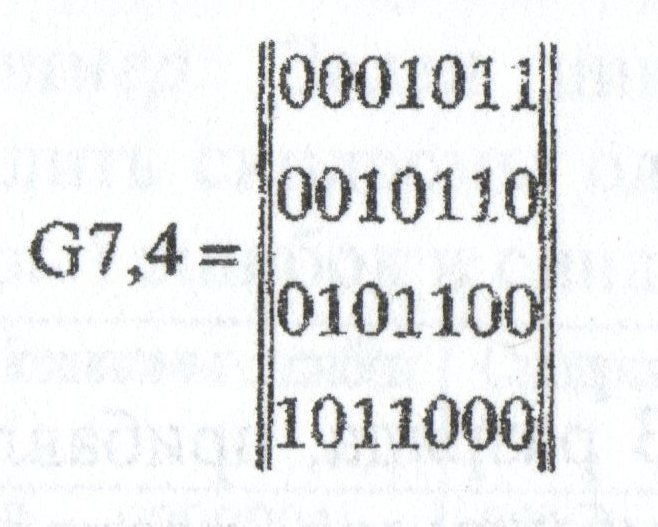

Пример; Определить порождающую матрицу, если известно, что n=7, k=4, задающий полином g(x)=x3+х+1.

Решение: Кодовая комбинация, соответствующая задающему полиному g(x)=x3+х+1, имеет вид 1011.

Тогда порождающая матрица G7,4 для кода при n=7, к=4 с учетом того, что k-1=3, имеет вид:

Порождающая матрица содержит k разрешенных кодовых комбинаций. Остальные комбинации кода,

количество которых (2k — k) можно определить суммированием по модулю 2 всевозможных сочетаний

строк матрицы Gn,k. Для матрицы, полученной в приведенном выше примере, суммирование по модулю 2

четырех строк 1-2, 1-3, 1-4, 2-3, 2-4, 3-4 дает следующие кодовые комбинации циклического кода:

001110101001111010011011101010011101110100

Другие комбинации искомого корректирующего кода могут быть получены сложением трех комбинаций, например,

из сочетания строк 1-3-4, что дает комбинацию 1111111, а также сложением четырех строк 1-2-3-4, что

дает комбинацию 1101001 и т.д.

Ряд комбинаций искомого кода может быть получено путем дальнейшего циклического сдвига комбинаций

порождающей матрицы, например, 0110001, 1100010, 1000101. Всего для образования искомого циклического

кода требуется 2k=24=16 комбинаций.

2) Умножение исходных двоичных кодовых комбинаций на задающий полином.

Исходными комбинациями являются все k-разрядные двоичные комбинации. Так, например, для исходной

комбинации 1111 (при k = 4) умножение ее на задающий полином g(x)=x3+х+1=1011 дает 1101001.

Полученные на основе двух рассмотренных способов циклические коды не являются разделимыми.

3) Деление на задающий полином.

Для получения разделимого (систематического) циклического кода необходимо разделить многочлен

xn-k*h(x), где h(x) — исходная двоичная комбинация, на задающий полином g(x) и прибавить полученный

остаток от деления к многочлену xn-k*h(x).

Заметим, что умножение исходной комбинации h(x) на xn-k эквивалентно сдвигу h(x) на (n-к) разрядов влево.

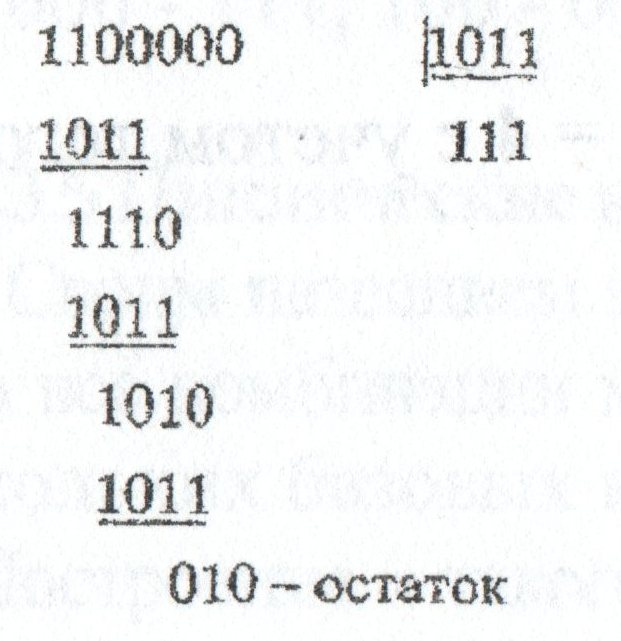

Пример: Требуется определить комбинации циклического разделимого кода, заданного полиномом g(x)=x3+х+1=1011 и

имеющего общее число разрядов 7, число информационных разрядов 4, число контрольных разрядов (n-k)=3.

Решение: Пусть исходная комбинация h(x)=1100. Умножение ее на xn-k=x3=1000 дает

x3*(x3+x2)=1100000, то есть эквивалентно

сдвигу исходной комбинации на 3 разряда влево. Деление комбинации 1100000 на комбинацию 1011, эквивалентно задающему полиному, дает:

Полученный остаток от деления, содержащий xn-k=3 разряда, прибавляем к полиному, в результате чего получаем искомую комбинацию

разделимого циклического кода: 1100010. В ней 4 старших разряда (слева) соответствуют исходной двоичной комбинации, а три младших

разряда являются контрольными.

Следует сделать ряд указаний относительно процедуры деления:

1) При делении задающий полином совмещается старшим разрядом со старшим «единичными разрядом делимого.

2) Вместо вычитания по модулю 2 выполняется эквивалентная ему процедура сложения по модулю 2.

3) Деление продолжается до тех пор, пока степень очередного остатка не будет меньше степени делителя (задающего полинома). При достижении

этого полученный остаток соответствует искомому содержанию контрольных разрядов для данной искомой двоичной комбинации.

Для проверки правильности выполнения процедуры определения комбинации циклического кода необходимо разделить полученную комб1шацию на задающий полином с

учетом сделанных выше замечаний. Получение нулевого остатка от такого деления свидетельствует о правильности определения комбинации.

Логический код 4В/5В

Логический код 4В/5В заменяет исходные символы длиной в 4 бита на символы длиной в 5 бит. Так как результирующие символы содержат избыточные биты, то

общее количество битовых комбинаций в них больше, чем в исходных. Таким образом, пяти-битовая схема дает 32 (25) двухразрядных буквенно-цифровых символа,

имеющих значение в десятичном коде от 00 до 31. В то время как исходные данные могут содержать только четыре бита или 16 (24) символов.

Поэтому в результирующем коде можно подобрать 16 таких комбинаций, которые не содержат большого количества нулей, а остальные считать запрещенными кодами

(code violation). В этом случае длинные последовательности нулей прерываются, и код становится самосинхронизирующимся для любых передаваемых данных.

Исчезает также постоянная составляющая, а значит, еще более сужается спектр сигнала. Но этот метод снижает полезную пропускную способность линии,

так как избыточные единицы пользовательской информации не несут, и только «занимают эфирное время». Избыточные коды позволяют приемнику распознавать

искаженные биты. Если приемник принимает запрещенный код, значит, на линии произошло искажение сигнала.

Итак, рассмотрим работу логического кода 4В/5В. Преобразованный сигнал имеет 16 значений для передачи информации и 16 избыточных значений. В декодере

приемника пять битов расшифровываются как информационные и служебные сигналы.

Для служебных сигналов отведены девять символов, семь символов — исключены.

Исключены комбинации, имеющие более трех нулей (01 — 00001, 02 — 00010, 03 — 00011, 08 — 01000, 16 — 10000). Такие сигналы интерпретируются символом

V и командой приемника VIOLATION — сбой. Команда означает наличие ошибки из-за высокого уровня помех или сбоя передатчика. Единственная

комбинация из пяти нулей (00 — 00000) относится к служебным сигналам, означает символ Q и имеет статус QUIET — отсутствие сигнала в линии.

Такое кодирование данных решает две задачи — синхронизации и улучшения помехоустойчивости. Синхронизация происходит за счет исключения

последовательности более трех нулей, а высокая помехоустойчивость достигается приемником данных на пяти-битовом интервале.

Цена за эти достоинства при таком способе кодирования данных — снижение скорости передачи полезной информации.

К примеру, В результате добавления одного избыточного бита на четыре информационных, эффективность использования полосы

частот в протоколах с кодом MLT-3 и кодированием данных 4B/5B уменьшается соответственно на 25%.

Схема кодирования 4В/5В представлена в таблице.

|

Двоичный код 4В |

Результирующий код 5В |

|

0 0 0 0 |

1 1 1 1 0 |

|

0 0 0 1 |

0 1 0 0 1 |

|

0 0 1 0 |

1 0 1 0 0 |

|

0 0 1 1 |

1 0 1 0 1 |

|

0 1 0 0 |

0 1 0 1 0 |

|

0 1 0 1 |

0 1 0 1 1 |

|

0 1 1 0 |

0 1 1 1 0 |

|

0 1 1 1 |

0 1 1 1 1 |

|

1 0 0 0 |

1 0 0 1 0 |

|

1 0 0 1 |

1 0 0 1 1 |

|

1 0 1 0 |

1 0 1 1 0 |

|

1 0 1 1 |

1 0 1 1 1 |

|

1 1 0 0 |

1 1 0 1 0 |

|

1 1 0 1 |

1 1 0 1 1 |

|

1 1 1 0 |

1 1 1 0 0 |

|

1 1 1 1 |

1 1 1 0 1 |

Итак, соответственно этой таблице формируется код 4В/5В, затем передается по линии с помощью физического кодирования по

одному из методов потенциального кодирования, чувствительному только к длинным последовательностям нулей — например, в помощью

цифрового кода NRZI.

Символы кода 4В/5В длиной 5 бит гарантируют, что при любом их сочетании на линии не могут встретиться более трех нулей подряд.

Буква ^ В в названии кода означает, что элементарный сигнал имеет 2 состояния — от английского binary — двоичный. Имеются

также коды и с тремя состояниями сигнала, например, в коде 8В/6Т для кодирования 8 бит исходной информации используется

код из 6 сигналов, каждый из которых имеет три состояния. Избыточность кода 8В/6Т выше, чем кода 4В/5В, так как на 256

исходных кодов приходится 36=729 результирующих символов.

Как мы говорили, логическое кодирование происходит до физического, следовательно, его осуществляют оборудование канального

уровня сети: сетевые адаптеры и интерфейсные блоки коммутаторов и маршрутизаторов. Поскольку, как вы сами убедились,

использование таблицы перекодировки является очень простой операцией, поэтому метод логического кодирования избыточными

кодами не усложняет функциональные требования к этому оборудованию.

Единственное требование — для обеспечения заданной пропускной способности линии передатчик, использующий избыточный код,

должен работать с повышенной тактовой частотой. Так, для передачи кодов 4В/5В со скоростью 100 Мб/с передатчик должен

работать с тактовой частотой 125 МГц. При этом спектр сигнала на линии расширяется по сравнению со случаем, когда по

линии передается чистый, не избыточный код. Тем не менее, спектр избыточного потенциального кода оказывается уже

спектра манчестерского кода, что оправдывает дополнительный этап логического кодирования, а также работу приемника

и передатчика на повышенной тактовой частоте.

В основном для локальных сетей проще, надежней, качественней, быстрей — использовать логическое кодирование данных

с помощью избыточных кодов, которое устранит длительные последовательности нулей и обеспечит синхронизацию

сигнала, потом на физическом уровне использовать для передачи быстрый цифровой код NRZI, нежели без предварительного

логического кодирования использовать для передачи данных медленный, но самосинхронизирующийся манчестерский код.

Например, для передачи данных по линии с пропускной способностью 100М бит/с и полосой пропускания 100 МГц,

кодом NRZI необходимы частоты 25 — 50 МГц, это без кодирования 4В/5В. А если применить для NRZI еще и

кодирование 4В/5В, то теперь полоса частот расширится от 31,25 до 62,5 МГц. Но тем не менее, этот диапазон

еще «влазит» в полосу пропускания линии. А для манчестерского кода без применения всякого дополнительного

кодирования необходимы частоты от 50 до 100 МГц, и это частоты основного сигнала, но они уже не будут пропускаться

линией на 100 МГц.

Скрэмблирование

Другой метод логического кодирования основан на предварительном «перемешивании» исходной информации таким

образом, чтобы вероятность появления единиц и нулей на линии становилась близкой.

Устройства, или блоки, выполняющие такую операцию, называются скрэмблерами (scramble — свалка, беспорядочная сборка) .

При скремблировании данные перемешиваються по определенному алгоритму и приемник, получив двоичные данные, передает

их на дескрэмблер, который восстанавливает исходную последовательность бит.

Избыточные биты при этом по линии не передаются.

Суть скремблирования заключается просто в побитном изменении проходящего через систему потока данных. Практически

единственной операцией, используемой в скремблерах является XOR — «побитное исключающее ИЛИ», или еще говорят —

сложение по модулю 2. При сложении двух единиц исключающим ИЛИ отбрасывается старшая единица и результат записывается — 0.

Метод скрэмблирования очень прост. Сначала придумывают скрэмблер. Другими словами придумывают по какому соотношению

перемешивать биты в исходной последовательности с помощью «исключающего ИЛИ». Затем согласно этому соотношению из текущей

последовательности бит выбираются значения определенных разрядов и складываются по XOR между собой. При этом все разряды

сдвигаются на 1 бит, а только что полученное значение («0» или «1») помещается в освободившийся самый младший разряд.

Значение, находившееся в самом старшем разряде до сдвига, добавляется в кодирующую последовательность, становясь очередным

ее битом. Затем эта последовательность выдается в линию, где с помощью методов физического кодирования передается к

узлу-получателю, на входе которого эта последовательность дескрэмблируется на основе обратного отношения.

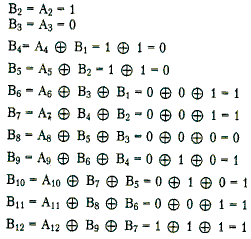

Например, скрэмблер может реализовывать следующее соотношение:

где Bi — двоичная цифра результирующего кода, полученная на i-м такте работы скрэмблера, Ai — двоичная цифра исходного

кода, поступающая на i-м такте на вход скрэмблера, Bi-3 и Bi-5 — двоичные цифры результирующего кода, полученные на

предыдущих тактах работы скрэмблера, соответственно на 3 и на 5 тактов ранее текущего такта, ⊕ — операция исключающего

ИЛИ (сложение по модулю 2).

Теперь давайте, определим закодированную последовательность, например, для такой исходной последовательности 110110000001.

Скрэмблер, определенный выше даст следующий результирующий код:

B1=А1=1 (первые три цифры результирующего кода будут совпадать с исходным, так как еще нет нужных предыдущих цифр)

Таким образом, на выходе скрэмблера появится последовательность 110001101111. В которой нет последовательности из шести нулей, п

рисутствовавшей в исходном коде.

После получения результирующей последовательности приемник передает ее дескрэмблеру, который восстанавливает исходную

последовательность на основании обратного соотношения.

Существуют другие различные алгоритмы скрэмблирования, они отличаются количеством слагаемых, дающих цифру

результирующего кода, и сдвигом между слагаемыми.

Главная проблема кодирования на основе скремблеров — синхронизация передающего (кодирующего) и принимающего

(декодирующего) устройств. При пропуске или ошибочном вставлении хотя бы одного бита вся передаваемая информация

необратимо теряется. Поэтому, в системах кодирования на основе скремблеров очень большое внимание уделяется методам синхронизации.

На практике для этих целей обычно применяется комбинация двух методов:

а) добавление в поток информации синхронизирующих битов, заранее известных приемной стороне, что позволяет ей при ненахождении

такого бита активно начать поиск синхронизации с отправителем,

б) использование высокоточных генераторов временных импульсов, что позволяет в моменты потери синхронизации производить

декодирование принимаемых битов информации «по памяти» без синхронизации.

Существуют и более простые методы борьбы с последовательностями единиц, также относимые к классу скрэмблирования.

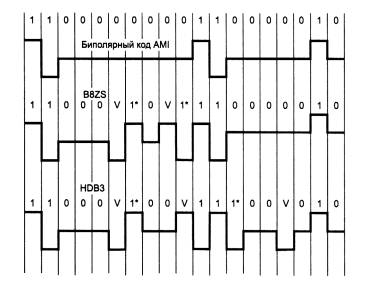

Для улучшения кода ^ Bipolar AMI используются два метода, основанные на искусственном искажении последовательности нулей запрещенными символами.

Рис. 3 Коды B8ZS и HDB3

На этом рисунке показано использование метода ^ B8ZS (Bipolar with 8-Zeros Substitution) и метода HDB3 (High-Density Bipolar 3-Zeros) для корректировки

кода AMI. Исходный код состоит из двух длинных последовательностей нулей (8- в первом случае и 5 во втором).

Код B8ZS исправляет только последовательности, состоящие из 8 нулей. Для этого он после первых трех нулей вместо оставшихся пяти нулей вставляет пять

цифр: V-1*-0-V-1*. V здесь обозначает сигнал единицы, запрещенной для данного такта полярности, то есть сигнал, не изменяющий полярность предыдущей

единицы, 1* — сигнал единицы корректной полярности, а знак звездочки отмечает тот факт, что в исходном коде в этом такте была не единица, а ноль. В

результате на 8 тактах приемник наблюдает 2 искажения — очень маловероятно, что это случилось из-за шума на линии или других сбоев передачи. Поэтому

приемник считает такие нарушения кодировкой 8 последовательных нулей и после приема заменяет их на исходные 8 нулей.

Код B8ZS построен так, что его постоянная составляющая равна нулю при любых последовательностях двоичных цифр.

Код HDB3 исправляет любые 4 подряд идущих нуля в исходной последовательности. Правила формирования кода HDB3 более сложные, чем кода B8ZS.

Каждые четыре нуля заменяются четырьмя сигналами, в которых имеется один сигнал V. Для подавления постоянной составляющей полярность сигнала

V чередуется при последовательных заменах.

Кроме того, для замены используются два образца четырехтактовых кодов. Если перед заменой исходный код содержал нечетное число единиц, то

используется последовательность 000V, а если число единиц было четным — последовательность 1*00V.

Таким образом, применение логическое кодирование совместно с потенциальным кодированием дает следующие преимущества:

Улучшенные потенциальные коды обладают достаточно узкой полосой пропускания для любых последовательностей единиц и нулей,

которые встречаются в передаваемых данных. В результате коды, полученные из потенциального путем логического кодирования,

обладают более узким спектром, чем манчестерский, даже при повышенной тактовой частоте.

Линейные блочные коды

При передаче информации по каналам связи возможны ошибки вследствие помех и искажений сигналов. Для обнаружения и

исправления возникающих ошибок используются помехоустойчивые коды. Упрощенная схема системы передачи информации

при помехоустойчивом кодировании показана на рис. 4

Кодер служит для преобразования поступающей от источника сообщений последовательности из k информационных

символов в последовательность из n cимволов кодовых комбинаций (или кодовых слов). Совокупность кодовых слов образует код.

Множество символов, из которых составляется кодовое слово, называется алфавитом кода, а число различных символов в

алфавите – основанием кода. В дальнейшем вследствие их простоты и наибольшего распространения рассматриваются главным

образом двоичные коды, алфавит которых содержит два символа: 0 и 1.

Рис. 4 Система передачи дискретных сообщений

Правило, по которому информационной последовательности сопоставляется кодовое слово, называется правилом кодирования.

Если при кодировании каждый раз формируется блок А из k информационных символов, превращаемый затем в n-символьную

кодовую комбинацию S, то код называется блочным. При другом способе кодирования информационная последовательность на

блоки не разбивается, и код называется непрерывным.

С математической точки зрения кодер осуществляет отображение множества из 2k элементов (двоичных информационных

последовательностей) в множество, состоящее из 2n элементов (двоичных последовательностей длины n). Для практики

интересны такие отображения, в результате которых получаются коды, обладающие способностью исправлять часть ошибок

и допускающие простую техническую реализацию кодирующих и декодирующих устройств.

Дискретный канал связи – это совокупность технических средств вместе со средой распространения радиосигналов, включенных

между кодером и декодером для передачи сигналов, принимающих конечное число разных видов. Для описания реальных каналов

предложено много математических моделей, с разной степенью детализации отражающих реальные процессы. Ограничимся рассмотрением

простейшей модели двоичного канала, входные и выходные сигналы которого могут принимать значения 0 и 1.

Наиболее распространено предположение о действии в канале аддитивной помехи. Пусть S=(s1,s2,…,sn)

и Y=(y1,y2,…,yn) соответственно входная и выходная последовательности двоичных символов.

Помехой или вектором ошибки называется последовательность из n символов E=(e1,e2,…,en), которую

надо поразрядно сложить с переданной последовательностью, чтобы получить принятую:

Y=S+E

Таким образом, компонента вектора ошибки ei=0 указывает на то, что 2-й символ принят правильно (yi=si),

а компонента ei=1 указывает на ошибку при приеме (yi≠si).Поэтому важной характеристикой вектора ошибки

является число q ненулевых компонентов, которое называется весом или кратностью ошибки. Кратность ошибки – дискретная случайная величина,

принимающая целочисленные значения от 0 до n.

Классификация двоичных каналов ведется по виду распределения случайного вектора E. Основные результаты теории кодирования получены в

предположении, что вероятность ошибки в одном символе не зависит ни от его номера в последовательности, ни от его значения. Такой

канал называется стационарным и симметричным. В этом канале передаваемые символы искажаются с одинаковой вероятностью

P, т.е. P(ei=1)=P, i=1,2,…,n.

Для симметричного стационарного канала распределение вероятностей векторов ошибки кратности q является биноминальным:

P(Ei)=Pq(1-P)n-q

которая показывает, что при P<0,5 вероятность β2=αj является убывающей функцией q,

т.е. в симметричном стационарном канале более вероятны ошибки меньшей кратности. Этот важный факт используется при построении

помехоустойчивых кодов, т.к. позволяет обосновать тактику обнаружения и исправления в первую очередь ошибок малой кратности.

Конечно, для других моделей канала такая тактика может и не быть оптимальной.

Декодирующее устройство (декодер) предназначено оценить по принятой последовательности Y=(y1,y2,…,yn)

значения информационных символов A‘=(a‘1,a‘2,…,a‘k,).

Из-за действия помех возможны неправильные решения. Процедура декодирования включает решение двух задач: оценивание переданного кодового

слова и формирование оценок информационных символов.

Вторая задача решается относительно просто. При наиболее часто используемых систематических кодах, кодовые слова которых содержат информационные

символы на известных позициях, все сводится к простому их стробированию. Очевидно также, что расположение информационных символов внутри кодового

слова не имеет существенного значения. Удобно считать, что они занимают первые k позиций кодового слова.

Наибольшую трудность представляет первая задача декодирования. При равновероятных информационных последовательностях ее оптимальное решение

дает метод максимального правдоподобия. Функция правдоподобия как вероятность получения данного вектора Y при передаче кодовых слов

Si, i=1,2,…,2k на основании Y=S+E определяется вероятностями появления векторов ошибок:

P(Y/Si)=P(Ei)=Pqi(1-P)n-qi

где qi – вес вектора Ei=Y+Si

Очевидно, вероятность P(Y/Si) максимальна при минимальном qi. На основании принципа максимального правдоподобия оценкой S‘ является кодовое слово,

искажение которого для превращения его в принятое слово Y имеет минимальный вес, т. е. в симметричном канале является наиболее вероятным (НВ):

S‘=Y+EHB

Если несколько векторов ошибок Ei имеют равные минимальные веса, то наивероятнейшая ошибка EHB определяется случайным выбором среди них.

В качестве расстояния между двумя кодовыми комбинациями принимают так называемое расстояние Хэмминга, которое численно равно количеству символов, в которых одна

комбинация отлична от другой, т.е. весу (числу ненулевых компонентов) разностного вектора. Расстояние Хэмминга между принятой последовательностью Y и всеми

возможными кодовыми словами 5, есть функция весов векторов ошибок Ei:

Поэтому декодирование по минимуму расстояния, когда в качестве оценки берется слово, ближайшее к принятой

последовательности, является декодированием по максимуму правдоподобия.

Таким образом, оптимальная процедура декодирования для симметричного канала может быть описана следующей последовательностью операций. По принятому

вектору Y определяется вектор ошибки с минимальным весом EHB, который затем вычитается (в двоичном канале — складывается по модулю 2) из Y:

Y→EHB→S‘=Y+EHB

Наиболее трудоемкой операцией в этой схеме является определение наи-вероятнейшего вектора ошибки, сложность которой

существенно возрастает при увеличении длины кодовых комбинаций. Правила кодирования, которые нацелены на упрощение

процедур декодирования, предполагают придание всем кодовым словам технически легко проверяемых признаков.

Широко распространены линейные коды, называемые так потому, что их кодовые слова образуют линейное

подпространство над конечным полем. Для двоичных кодов естественно использовать поле характеристики p=2.

Принадлежность принятой комбинации Y известному подпространству является тем признаком, по которому

выносится решение об отсутствии ошибок (EHB=0).

Так как по данному коду все пространство последовательностей длины n разбивается на смежные классы,

то для каждого смежного класса можно заранее определить вектор ошибки минимального веса,

называемый лидером смежного класса. Тогда задача декодера состоит в определении номера смежного класса,

которому принадлежит Y, и формировании лидера этого класса.

Минимальное расстояние между допустимыми словами кода с контролем по четности равно двум (из

рис.

14.2 видно, что никакие два кодовых слова в рамочках не соединены линиями, то есть не являются соседними). Именно по этой причине одиночная ошибка в кодовом слове превращает это слово в недопустимое.

Платой за помехоустойчивость является необходимость увеличения длины слов по сравнению с обычным кодом. В данном примере только два разряда являются информационными. Это они образуют четыре разных слова. Третий разряд является контрольным и служит только для увеличения расстояния между допустимыми словами. В передаче информации контрольный разряд не участвует, так как является линейно зависимым от информационных. Код с контролем по четности, рассмотренный в качестве примера, позволяет обнаружить одиночные ошибки в блоках данных при передаче данных. Однако он не сможет обнаружить двукратные ошибки потому, что двукратная ошибка переводит кодовое слово через промежуток между допустимыми словами и превращает его в другое допустимое слово.

Таким образом, для того чтобы код приобрел способность к обнаружению и коррекции ошибок, необходимо отказаться от его безызбыточности. Для этого и разделяют всё множество возможных комбинаций двоичных символов на два подмножества: допустимых кодовых слов и недопустимых. Разбиение осуществляется таким образом, чтобы увеличить минимальное кодовое расстояние между допустимыми словами. В этом случае любая однократная ошибка превращает допустимое кодовое слово в недопустимое, что позволяет её обнаружить.

Естественно, что введение дополнительных контрольных разрядов увеличивает затраты на хранение или передачу кодированной информации. При этом фактический объем полезной информации остается неизменным. В этом случае можно говорить об избыточности помехоустойчивого кода, которую формально можно определить как отношение числа контрольных разрядов к общему числу разрядов кодового слова.

Мы уже отмечали, что контрольные разряды не передают информацию и в этом смысле бесполезны. Относительное число контрольных разрядов называется избыточностью Q помехоустойчивого кода

где n – общее число двоичных разрядов в блоке, а k – число контрольных разрядов.

Например, избыточность рассмотренного трехразрядного кода с контролем по четности составляет:

Избыточность является важной характеристикой кода, причем чрезмерное увеличение избыточности нежелательно. Важной задачей теории информации является синтез кодов с минимальной избыточностью, обеспечивающих заданную обнаруживающую и корректирующую способность.

В качестве иллюстрирующего примера рассмотрим один из простейших кодов, позволяющих обнаруживать и исправлять однократные ошибки – код Хэмминга. Кодовое слово длиной n содержит k информационных и m контрольных разрядов. Коррекция искаженного i-го разряда заключается в сложении (по модулю 2) принятого кодового слова с вектором вида 0…010…0, содержащем единицу в i-ом разряде.

Для n-разрядного кодового слова существует n таких векторов, соответствующих однократным ошибкам, и один нулевой вектор, соответствующий случаю приема слова без ошибок. Таким образом, m контрольных разрядов должны обеспечивать формирование n + 1 вектора ошибки, то есть должно выполняться неравенство

Простейший нетривиальный случай, соответствующий m=3, образует (7,4)-код, который можно синтезировать следующим образом. Сопоставим каждому вектору ошибки порядковый номер – синдром (

таблица

14.1). При этом нулевому вектору ошибки соответствует нулевой синдром.

| a6 | a5 | a4 | a3 | a2 | a1 | a0 | s2 | s1 | s0 |

|---|---|---|---|---|---|---|---|---|---|

| 1 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 1 | 1 |

| 0 | 1 | 0 | 0 | 0 | 0 | 0 | 1 | 0 | 1 |

| 0 | 0 | 1 | 0 | 0 | 0 | 0 | 1 | 1 | 0 |

| 0 | 0 | 0 | 1 | 0 | 0 | 0 | 1 | 1 | 1 |

| 0 | 0 | 0 | 0 | 1 | 0 | 0 | 1 | 0 | 0 |

| 0 | 0 | 0 | 0 | 0 | 1 | 0 | 0 | 1 | 0 |

| 0 | 0 | 0 | 0 | 0 | 0 | 1 | 0 | 0 | 1 |

| 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 |

Рассматривая функции si как свертку по модулю 2 разрядов кодовых слов, получим:

Функции si должны обращаться в единицу при наличии ошибки в одном из образующих их разрядов, и в ноль – при отсутствии ошибок. Обеспечение этого требования возможно лишь при условии, что часть разрядов формируется специальным образом. В частности, разряды a0, a1, a2 можно рассматривать как свертку по модулю 2 остальных разрядов, участвующих в соответствующих уравнениях:

Найденные зависимости позволяют генерировать кодовые слова по заданным информационным, а также вычислять синдромы для принятых кодовых слов.

Допустим, исходное информационное слово равно 1101, то есть a6=1, a5=1, a4=1, a3=1. Для преобразования его в допустимое кодовое слово помехоустойчивого (7,4) —кода Хэмминга рассчитаем контрольные разряды по найденным выше зависимостям. В частности,

Таким образом, с учетом контрольных разрядов кодовое слово будет равно 1101001.

Если в процессе передачи или хранения слово осталось неискаженным, то его синдром s0…s2 будет соответственно равен:

Предположим, что в процессе передачи или хранения в результате воздействия внешних факторов оказался искаженным отдельный разряд кодового слова. Например, вместо слова 1101001 было принято слово 1001001. В этом случае синдром окажется отличным от нуля: s0…s2 будет соответственно равен:

Рассчитаем избыточность (7,4) —кода Хэмминга:

Это очень большое значение. На практике часто применяются существенно более сложные коды, обеспечивающие лучшие характеристики помехоустойчивости при меньшей избыточности.