Как использование случайности может помочь сделать ваш код быстрее? Лекция Михаила Вялого в Яндексе

Время прочтения

5 мин

Просмотры 28K

И сила и слабость современных компьютеров в том, насколько они точны. Сегодня в нашей серии лекций от Яндекса рассказ о том, как использование случайностей может помочь сделать вычисления более эффективными.

Вероятностные алгоритмы позволяют решать некоторые задачи теоретической информатики, для которых не работают детерминированные алгоритмы. Самый интересный вопрос — это насколько использование случайностей сокращает время работы алгоритма? Частично на этот вопрос уже можно ответить: при некоторых предположениях истинную случайность можно подменить фальшивой и детерминированно смоделировать любой вероятностный алгоритм с незначительной потерей во времени работы. Проверка этих предположений будет, по всей видимости, одной из центральных тем теоретической информатики XXI века.

Лекцию читает старший научный сотрудник Вычислительного центра им. А.А. Дородницына РАН, доцент кафедры математических основ управления МФТИ, кандидат физико-математических наук Михаил Вялый.

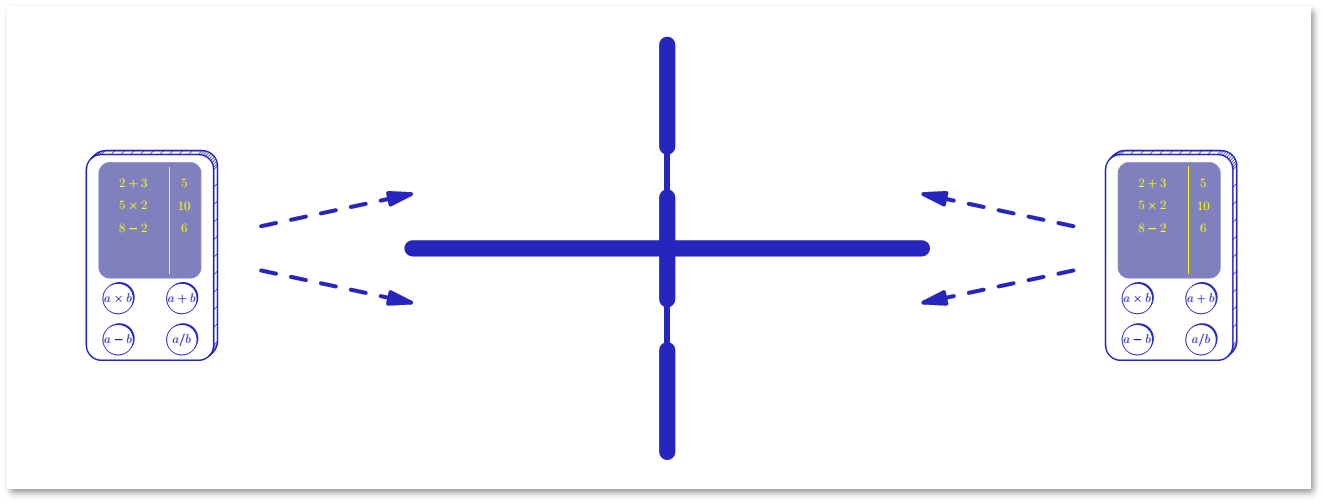

Начнём с самого простого. Представим, что у нас есть два калькулятора. Один обычный, а у второго есть дополнительная кнопка, которая при нажатии выдает дополнительный бит. Попробуем ответить на вопрос, полезна ли будет такая функция?

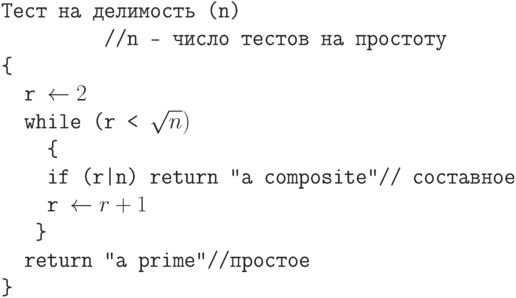

Такая постановка, конечно, слишком общая. Постараемся уточнить ее с точки зрения теоретической информатики. Для этого сначала введем понятие алгоритма. Алгоритм — настолько точно определенная инструкция, что она может быть исполнена механически. Основное свойство детерминированных алгоритмов заключается в том, что каждое следующее состояние однозначно определяется текущим состоянием. Вероятностные алгоритмы отличаются тем, что в любой момент они могут определить значение случайного бита (подбросить монету), который с равной вероятностью будет равен 0 или 1. В процессе исполнения вероятностного алгоритма это может происходить неоднократно, и разные подбрасывания будут независимы.

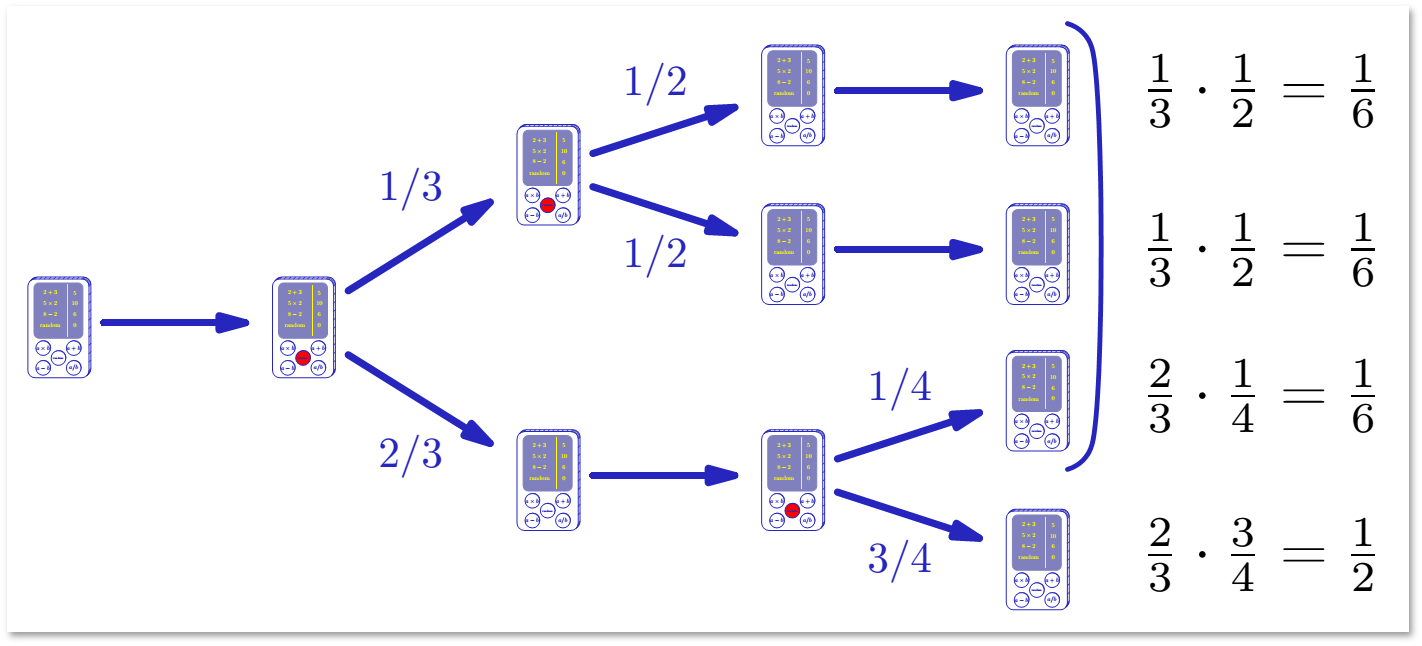

Как изображено на картинке выше, при детерминированном шаге, вычисления происходят как обычно. Однако при подбрасывании монетки вычисление разветвляется. Вместо линейной последовательности получается дерево вычисления. Каждая ветвь этого дерева называется путем вычисления. Путь характеризуется значениями случайных битов. Каждый раз, подбрасывая монетку, мы выбираем одно из двух направлений движения. Таким образом, мы допускаем некоторую вольность: разрешаем, чтобы алгоритм корректно работал не на всех путях, а только на некоторых. Прежде чем переходить к оценке возможностей ошибки вероятностных алгоритмов, оговорим некоторые технические детали.

Во-первых, у подбрасываемой монетки может быть много сторон (исходов). Во-вторых, вероятности выпадения всех возможных исходов не обязательно должны быть равны. Однако сумма всех возможных исходов всегда равна 1.

Подсчет вероятности ошибки

При подсчете вероятности ошибки вероятностного алгоритма нужно учитывать два правила:

- Вероятности независимых событий перемножаются.

- Вероятности несовместных событий складываются.

Как вообще относиться к алгоритмам, которые могут ошибаться? В конце концов, можно просто задать, какой-нибудь вопрос, требующий ответа «да»/«нет», подбросить двустороннюю монетку, и с вероятностью 1/2 получить верный ответ. Так какая же вероятность ошибки нас устроит? Например, велика ли вероятность ошибки в 9/10? Если ошибку можно обнаружить, и алгоритм допускает повторное исполнение, то не очень.

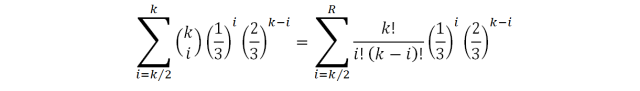

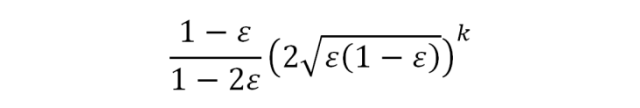

Если правильный ответ нам неизвестен, задача становится сложнее. Алгоритм дает нам ответ «да» или «нет». Если вероятность ошибки ε < 1/2, то повторения алгоритма позволяют быстро уменьшать вероятность ошибки. Т.е. нужно повторить алгоритм k раз, и выдать тот ответ, который встретился чаще. Пусть вероятность ошибки равна 1/3. Вероятность ошибки при голосовании k независимых исполнений вычисляется следующим образом:

Если вероятность ошибки также равна 1/3, при голосовании 100 независимых исполнений вероятность ошибки можно вычислить так:

С повышением значения k вероятность ошибки будет очень быстро уменьшаться:

Задача об установлении контакта

Допустим, у нас есть два игрока. Они ничего не знают друг о друге, и возможности договориться у них нет. Есть две точки, через которые они могут установить контакт. Время дискретно. В каждый момент участник выбирает место (верхнее или нижнее). Контакт установлен, если в какой-то момент времени оба участника выбрали одно и то же место.

Детерминированного способа, позволяющего установить контакт, не существует. При этом вероятностный алгоритм для установления контакта очень прост: на каждом шаге нужно выбирать место случайно, равновероятно и независимо от предыдущих шагов. Проанализируем этот алгоритм. Вероятность ошибки на каждом шаге составляет 1/2. После t шагов вероятность ошибки будет составлять 2-t, что может быть очень маленькой величиной.

Задача проверки равенства третейским судьей

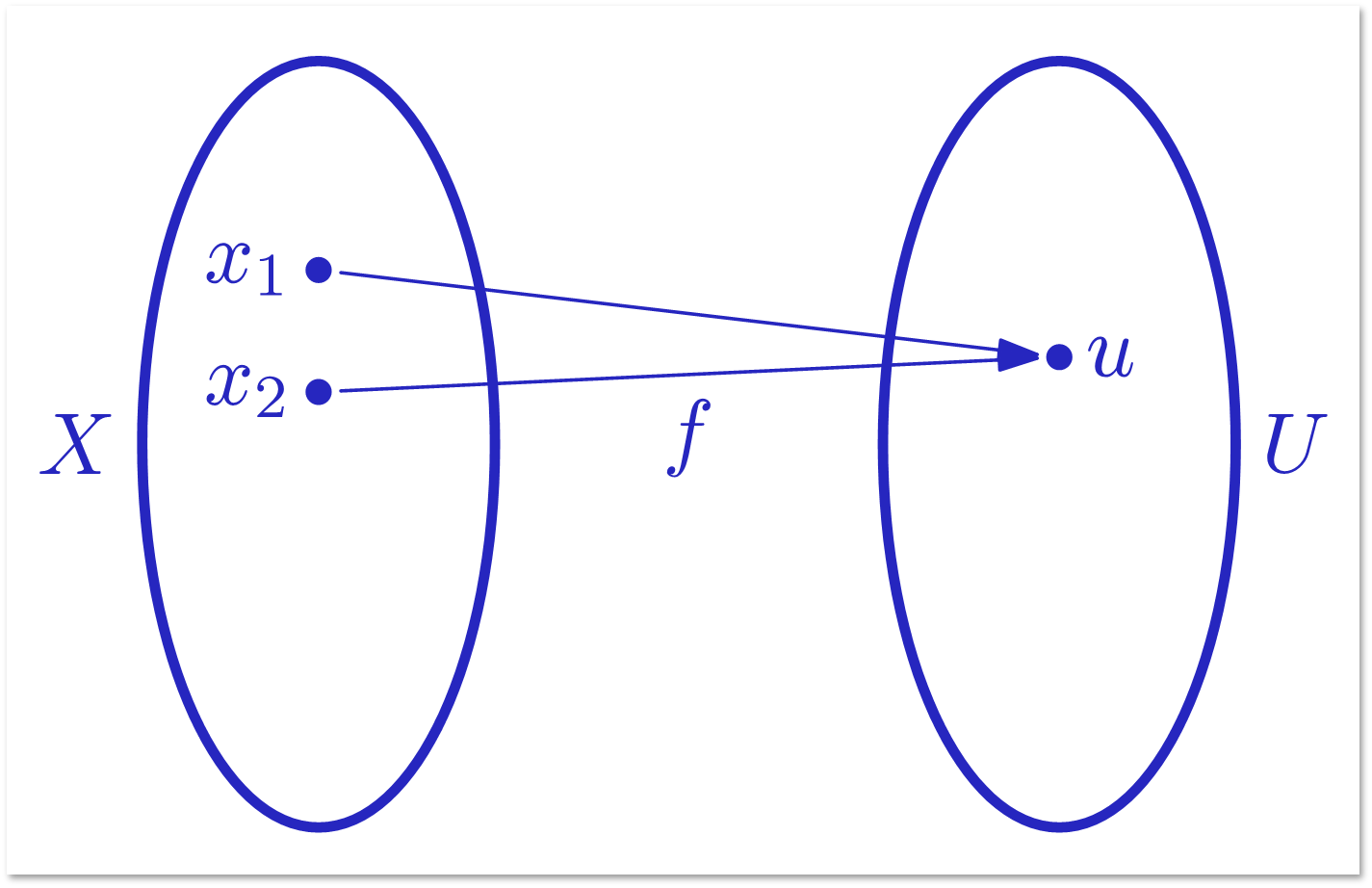

Рассмотрим задачу с более сложным условием. Алиса знает двоичное слово x длины n. Боб знает слово y той же длины. Они имеют возможность передать Чарли некоторую информацию (слова u и v), по которой Чарли должен решить, равны ли слова x и y. Цель: передать как можно меньше битов при условии, что Чарли правильно отвечает на любых x, y. Алиса с Бобом друг с другом общаться не могут.

Если u и v определяются по x и y детерминированно, т.е. u = f (x), v = g (y), то для решения задачи равенства нужно передать не меньше 2n битов. Путь длина u меньше n. Тогда возможных значений u меньше 2n, т.е. меньше количества возможных значений x.

Для Чарли x1 и x2 неразличимы.

Случайность как «канал связи»

Попробуем решить туже задачу, но теперь представим, что Алиса и Боб имеют доступ к общему источнику случайности. Скажем, к одному и тому же изданию книги «Таблица случайных чисел». Цель: передать как можно меньше битов при условии, что вероятность ошибки Чарли мала на любых x, y.

Попробуем решить эту задачу и определить, можно ли таким образом передавать меньше битов, чем с помощью детерминированного алгоритма.

Алиса и Боб выбирают случайное простое число p (одно и то же, случайность общая для них обоих) в интервале от n до 2n.

Алиса вычисляет U = X mod p, где X – число, двоичная запись которого совпадает со словом Алисы x. Боб поступает аналогично и вычисляет V = Y mod p. Затем они оба посылают двоичные записи чисел U и V Чарли. Чарли говорит, что слова x и y равны, если u = v.

Поскольку 0 ≤ U, V < p ≤ 2n, то длина сообщений ≤ 2 + log n.

В случае x = y Чарли всегда дает правильный ответ. Если x≠y вероятность ошибки Чарли не больше 3/4. Докажем это с помощью теоремы из теории чисел.

Простых чисел довольно много. Для всех достаточно больших n количество π(n) простых чисел от 1 до n удовлетворяет неравенствам:

Если X — Y ≠ 0 делится на простые n ≤ p1 <… < pk ≤ 2n, то

Уменьшение вероятности ошибки

Ошибка предложенного протокола — односторонняя. Это позволяет уменьшать вероятность ошибки путем многократного выполнения протокола. Если Алиса и Боб выбирают s простых модулей (случайно и независимо), вероятность ошибки становится меньше (3/4)s. Взяв достаточно большое s, вероятность ошибки можно сделать сколь угодно малой.

При наличии общей случайности для любого ε > 0 существует такой способ выбора сообщений, который гарантирует решение задачи равенства с вероятностью ошибки меньше ε и передает O(log n) битов. Запись g (n) = O(f(n)) означает, что есть такие числа C и n0, что для всех n > n0 выполняется g(n) < Cf(n).

Протоколы при отсутствии общей случайности

Как доказать, что есть способ выбора сообщений u, v в задаче равенства, при котором Алиса и Боб не знают случайных битов друг друга, передается O(√n log n) битов, а вероятность ошибки меньше 1/3?

Два случайных подмножества размера 2√n в n-элементном множестве пересекаются с вероятностью > 4/5 (примерно 1 − 1/e2). И оказывается, что это почти все, чего мы можем достичь. Рассмотрим частный случай теоремы Бабаи – Киммеля, из которой следует, что при любом способе вероятностного выбора сообщений в задаче равенства, гарантирующем вероятность ошибки меньше 1/3, длина переданных сообщений Ω(√n). Запись g(n) = Ω(f(n)) означает, что есть такие числа C и n0, что для всех n > n0 выполняется g(n) > Cf(n).

Посмотрев лекцию до конца, вы узнаете, как благодаря внедрению случайности можно ускорять работу алгоритма, а также о понятии фальшивой случайности.

Location Information Processing

David Munoz, … Rogerio Enriquez, in Position Location Techniques and Applications, 2009

3.5.2 Circular Error Probability

The circular error probability (CEP) [25] is a simple measure of accuracy defined as the radius of the circle that has its center at the mean and contains half the realizations of a random vector of coordinate estimates. It is a measure of uncertainty in the location estimator q^ relative to its mean E{q^}.. If the location estimator is unbiased, the CEP is a measure of the estimator uncertainty relative to the true NOI position. If the magnitude of the bias vector is bounded by B, then with a probability of one-half, a particular estimate is within a distance of B+ CEP from the true position. This concept is illustrated in Figure 3.15.

FIGURE 3.15. Geometry of the CEP definition.

From its definition, the CEP may be derived by solving the following equation:

(3.49)12=∫∫Rpq^(ζ)dζ1dζ2,

where pqˆ (ζ) is the probability density function of vector estimate qˆ, and the integration region is defined as R={ζ:|ζ−E{q^}|}⩽CEP. Most of the time, a closed-form expression of Equation (3.49) is difficult to find and numerical integration must be performed. However, the following approximation, which is accurate to within 10%, is often used [25]:

(3.50)CEP≈0.75E{(q^−E{q^})H(q^−E{q^})}=0.75λ1+λ2=0.75σ12+σ22.

Here λ1 and λ2 are the eigenvalues of the estimator covariance matrix, which is given by

(3.51)E{(q^−E{q^})H(q^−E{q^})}=[σ12σ12σ12σ12].

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/B9780123743534000090

Error Statistics

Deborah G. Mayo, Aris Spanos, in Philosophy of Statistics, 2011

1.3 The Severity Principle

A method’s error probabilities describe its performance characteristics in a hypothetical sequence of repetitions. How are we to use error probabilities in making particular inferences? This leads to the general question:

-

When do data x0 provide good evidence for, or a good test of, hypothesis H?

Our standpoint begins with the situation in which we would intuitively deny x0 is evidence for H. Data x0 fail to provide good evidence for the truth of H if the inferential procedure had very little chance of providing evidence against H, even if H is false.

-

Severity Principle (weak). Data x0 (produced by process G) do not provide good evidence for hypothesis H if x0 results from a test procedure with a very low probability or capacity of having uncovered the falsity of H, even if H is incorrect.

Such a test we would say is insufficiently stringent or severe. The onus is on the person claiming to have evidence for H to show that they are not guilty of at least so egregious a lack of severity. Formal error statistical tools are regarded as providing systematic ways to foster this goal, as well as to determine how well it has been met in any specific case. Although one might stop with this negative conception (as perhaps Fisher and Popper did), we will go on to the further, positive one, which will comprise the full severity principle:

-

Severity Principle (full). Data x0 (produced by process G) provides good evidence for hypothesis H (just) to the extent that test T severely passes H with x0.

Severity rationale vs. low long-run error-rate rationale (evidential vs. behavioral rationale)

Let us begin with a very informal example. Suppose we are testing whether and how much weight George has gained between now and the time he left for Paris, and do so by checking if any difference shows up on a series of well-calibrated and stable weighing methods, both before his leaving and upon his return. If no change on any of these scales is registered, even though, say, they easily detect a difference when he lifts a .1-pound potato, then this may be regarded as grounds for inferring that George’s weight gain is negligible within limits set by the sensitivity of the scales. The hypothesis H here might be:

-

H: George’s weight gain is no greater than δ,

where δ is an amount easily detected by these scales. H, we would say, has passed a severe test: were George to have gained δ pounds or more (i.e., were H false), then this method would almost certainly have detected this.

A behavioristic rationale might go as follows: If one always follows the rule going from failure to detect a weight gain after stringent probing to inferring weight gain no greater than δ, then one would rarely be wrong in the long run of repetitions. While true, this is not the rationale we give in making inferences about George. It is rather that this particular weighing experiment indicates something about George’s weight. The long run properties — at least when they are relevant for particular inferences — utilize error probabilities to characterize the capacity of our inferential tool for finding things out in the particular case. This is the severity rationale.

We wish to distinguish the severity rationale from a more prevalent idea for how procedures with low error probabilities become relevant to a particular application; namely, the procedure is rarely wrong, therefore, the probability it is wrong in this case is low. In this view we are justified in inferring H because it was the output of a method that rarely errs. This justification might be seen as intermediate between full-blown behavioristic justifications, and a genuine inferential justification. We may describe this as the notion that the long run error probability ‘rubs off’ on each application. This still does not get at the reasoning for the particular case at hand. The reliability of the rule used to infer H is at most a necessary and not a sufficient condition to warrant inferring H. What we wish to sustain is this kind of counterfactual statistical claim: that were George to have gained more than δ pounds, at least one of the scales would have registered an increase. This is an example of what philosophers often call an argument from coincidence: it would be a preposterous coincidence if all the scales easily registered even slight weight shifts when weighing objects of known weight, and yet were systematically misleading us when applied to an object of unknown weight. Are we to allow that tools read our minds just when we do not know the weight? To deny the warrant for H, in other words, is to follow a highly unreliable method: it would erroneously reject correct inferences with high or maximal probability (minimal severity), and thus would thwart learning. The stronger, positive side of the severity principle is tantamount to espousing the legitimacy of strong arguments from coincidence. What statistical tests enable us to do is determine when such arguments from coincidence are sustainable (e.g., by setting up null hypotheses). It requires being very specific about which inference is thereby warranted—we may, for example, argue from coincidence for a genuine, non-spurious, effect, but not be able to sustain an argument to the truth of a theory or even the reality of an entity.

Passing a Severe Test.

We can encapsulate this as follows:

-

A hypothesis H passes a severe test T with data x0 if,

-

(S-1) x0 accords with H, (for a suitable notion of accordance) and

-

(S-2) with very high probability, test T would have produced a result that accords less well with H than x0 does, if H were false or incorrect.

Equivalently, (S-2) can be stated:

-

(S-2)*: with very low probability, test T would have produced a result that accords as well as or better with H than x0 does, if H were false or incorrect.

Severity, in our conception, somewhat in contrast to how it is often used, is not a characteristic of a test in and of itself, but rather of the test T, a specific test result x0, and a specific inference H (not necessarily predesignated) being entertained. That is, the severity function has three arguments. We use the notation: SEV (T,x0,H), or even SEV (H), to abbreviate:

-

“The severity with which claim H passes test T with outcome x0”.

As we will see, the analyses may take different forms: one may provide a series of inferences that pass with high and low severity, serving essentially as benchmarks for interpretation, or one may fix the inference of interest and report the severity attained.

The formal statistical testing apparatus does not include severity assessments, but there are ways to use the error statistical properties of tests, together with the outcome x0, to evaluate a test’s severity in relation to an inference of interest. This is the key for the inferential interpretation of error statistical tests. While, at first blush, a test’s severity resembles the notion of a test’s power, the two notions are importantly different; see section 2.

The severity principle, we hold, makes sense of the underlying reasoning of tests, and addresses chronic problems and fallacies associated with frequentist testing. In developing this account, we draw upon other attempts to supply frequentist foundations, in particular by Bartlett, Barnard, Birnbaum, Cox, Efron, Fisher, Lehmann, Neyman, E. Pearson; the severity notion, or something like it, affords a rationale and unification of several threads that we have extracted and woven together. Although mixing aspects from N-P and Fisherian tests is often charged as being guilty of an inconsistent hybrid [Gigerenzer, 1993], the error statistical umbrella, linked by the notion of severity, allows for a coherent blending of elements from both approaches. The different methods can be understood as relevant for one or another type of question along the stages of a full-bodied inquiry. Within the error statistical umbrella, the different methods are part of the panoply of methods that may be used in the service of severely probing hypotheses.

A principle for interpreting statistical inference vs. the goal of science

We should emphasize at the outset that while severity is the principle on which interpretations of statistical inferences are based, we are not claiming it is the goal of science. While scientists seek to have hypotheses and theories pass severe tests, severity must be balanced with informativeness. So for example, trivially true claims would pass with maximal severity, but they would not yield informative inferences 4. Moreover, one learns quite a lot from ascertaining which aspects of theories have not yet passed severely. It is the basis for constructing rival theories which existing tests cannot distinguish, and is the impetus for developing more probative tests to discriminate them (see [Mayo, 2010a]).

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/B9780444518620500058

Supervised Learning: The Epilogue

Sergios Theodoridis, Konstantinos Koutroumbas, in Pattern Recognition (Fourth Edition), 2009

10.3 Exploiting the Finite Size of the Data Set

The estimation of the classification error probability presupposes that one has decided upon the data set to which the error counting will be applied. This is not a straightforward task. The set of samples that we have at our disposal is finite, and it has to be utilized for both training and testing. Can we use the same samples for training and testing? If not, what are the alternatives? Depending on the answer to the question, the following methods have been suggested:

- ▪

-

Resubstitution Method: The same data set is used, first for training and then for testing. One need not go into mathematical details in order to see that such a procedure is not very fair. Indeed, this is justified by the mathematical analysis. In [Fole 72] the performance of this method was analyzed using normal distributions. The analysis results show that this method provides an optimistic estimate of the true error probability. The amount of bias of the resubstitution estimate is a function of the ratio N/l, that is, the data set size and the dimension of the feature space. Furthermore, the variance of the estimate is inversely proportional to the data set size N. In words, in order to obtain a reasonably good estimate, N as well as the ratio N/l must be large enough. The results from the analysis and the related simulations show that N/l should be at least three and that an upper bound of the variance is 1/8N. Of course, if this technique is to be used in practice, where the assumptions of the analysis are not valid, experience suggests that the suggested ratio must be even larger [Kana 74]. Once more, the larger the ratio N/l, the more comfortable one feels.

- ▪

-

Holdout Method: The available data set is divided into two subsets, one for training and one for testing. The major drawback of this technique is that it reduces the size for both the training and the testing data. Another problem is to decide how many of the N available data will be allocated to the training set and how many to the test set. This is an important issue. In Section 3.5.3 of Chapter 3, we saw that designing a classifier using a finite data set introduces an excess mean error and a variance around it, as different data sets, of the same size, are used for the design. Both of these quantities depend on the size of the training set. In [Raud 91], it is shown that the classification error probability of a classifier, designed using a finite training data set, N, is always higher than the corresponding asymptotic error probability (N → ∞). This excess error decreases as N increases. On the other hand, in our discussion in the previous section we saw that the variance of the error counting depends on the size of the test set, and for small test data sets the estimates can be unreliable. Efforts made to optimize the respective sizes of the two sets have not yet led to practical results.

- ▪

-

Leave-One-Out Method: This method [Lach 68] alleviates the lack of independence between the training and test sets in the resubstitution method and at the same time frees itself from the dilemma associated with the holdout method. The training is performed using N −1 samples, and the test is carried out using the excluded sample. If this is misclassified, an error is counted. This is repeated N times, each time excluding a different sample. The total number of errors leads to the estimation of the classification error probability. Thus, training is achieved using, basically, all samples, and at the same time independence between training and test sets is maintained. The major disadvantage of the technique is its high computational complexity. For certain types of classifiers (i.e., linear or quadratic) it turns out that a simple relation exists between the leave-one-out and the resubstitution method ([Fuku 90], Problem 10.2). Thus, in such cases the former estimate is obtained using the latter method with some computationally simple modifications.

The estimates resulting from the holdout and leave-one-out methods turn out to be very similar, for comparable sizes of the test and training sets. Furthermore, it can be shown (Problem 10.3, [Fuku 90]) that the holdout error estimate, for a Bayesian classifier, is an upper bound of the true Bayesian error. In contrast, the resubstitution error estimate is a lower bound of the Bayesian error, confirming our previous comment that it is an optimistic estimate. To gain further insight into these estimates and their relation, let us make the following definitions:

- ▪

-

PeN

denotes the classification error probability for a classifier designed using a finite set of N training samples.

- ▪

-

P¯eN

denotes the average

E[PeN]

over all possible training sets of size N.

- ▪

-

Pe is the average asymptotic error as N → ∞.

It turns out that the holdout and leave-one-out methods (for statistically independent samples) provide an unbiased estimate of

P¯eN

. In contrast, the resubstitution method provides a biased (underestimated) estimate of

P¯eN

. Figure 10.1 shows the trend of a typical plot of

FIGURE 10.1. Plots indicating the general trend of the average resubstitution and leave-one-out error probabilities as functions of the number of training points.

P¯eN

and the average (over all possible sets of size N) resubstitution error as functions of N [Fole 72, Raud 91]. It is readily observed that as the data size N increases, both curves tend to approach the asymptotic Pe.

A number of variations and combinations of these basic schemes have also been suggested in the literature. For example, a variation of the leave-one-out method is to leave k > 1, instead of one, samples out. The design and test process is repeated for all distinct choices of k samples. References [Kana 74, Raud 91] are two good examples of works discussing various aspects of the topic.

In [Leis 98] a method called cross-validation with active pattern selection is proposed, with the goal of reducing the high computational burden required by the leave-one-out method. It is suggested not to leave out (one at a time) all N feature vectors, but only k < N. To this end the “good” points of the data set (expected to contribute a 0 to the error) are not tested. Only the k “worst” points are considered. The choice between “good” and “bad” is based on the respective values of the cost function after an initial training. This method exploits the fact that the outputs of the classifier, trained according to the least squares cost function, approximate posterior probabilities, as discussed in Chapter 3. Thus, those feature vectors whose outputs have a large deviation from the desired value (for the true class) are expected to be the ones that contribute to the classification error.

Another set of techniques have been developed around the bootstrap method [Efro 79, Hand 86, Jain 87]. A major incentive for the development of these techniques is the variance of the leave-one-out method estimate for small data sets [Efro 83]. According to the “bootstrap” philosophy, new data sets are artificially generated. This is a way to overcome the limited number of available data and create more data in order to better assess the statistical properties of an estimator. Let X be the set of the available data of size N. A bootstrap design sample set of size N,X*, is formed by random sampling with replacement of the set X. Replacement means that when a sample, say xi, is “copied” to the set X*, it is not removed from X but is reconsidered in the next sampling. A number of variants have been built upon the bootstrap method. A straightforward one is to design the classifier using a bootstrap sample set and count the errors using the samples from X that do not appear in this bootstrap sample set. This is repeated for different bootstrap sample sets. The error rate estimate, e0, is computed by counting all the errors and dividing the sum by the total number of test samples used. However, in [Raud 91] it is pointed out that the bootstrap techniques improve on the leave-one-out method only when the classification error is large.

Another direction is to combine estimates from different estimators. For example, in the so-called 0.632 estimator ([Efro 83]), the error estimate is taken as a convex combination of the resubstitution error, eres, and the bootstrap error e0,

It has been reported that the 0.632 estimator is particularly effective in cases of small size data sets [Brag 04]. An extension of the 0.632 rule is discussed in [Sima 06] where convex combinations of different estimators are considered and the combining weights are computed via an optimization process.

Confusion Matrix, Recall and Precision

In evaluating the performance of a classification system, the probability of error is sometimes not the only quantity that assesses its performance sufficiently. Let us take for example, an M-class classification task. An important issue is to know whether there are classes that exhibit a higher tendency for confusion. The confusion matrix A = [A(i,j)] is defined so that its element A(i,j) is the number of data points whose true class label was i and were classified to class j. From A, one can directly extract the recall and precision values for each class, along with the overall accuracy:

- ▪

-

Recall (Ri). Ri is the percentage of data points with true class label i, which were correctly classified in that class. For example, for a two-class problem, the recall of the first class is calculated as

R1=A(1,1)A(1,1)+A(1,2)

.

- ▪

-

Precision (Pi). Pi is the percentage of data points classified as class i, whose true class label is indeed i. Therefore, for the first class in a two-class problem,

P1=A(1,1)A(1,1)+A(2,1).

- ▪

-

Overall Accuracy (Ac). The overall accuracy, Ac, is the percentage of data that has been correctly classified. Given an M-class problem, Ac is computed from the confusion matrix according to the equation

Ac=1N∑i=1MA(i,i),

where N is the total number of points in the test set.

Take as an example a two-class problem where the test set consists of 130 points from class ω1 and 150 points from class ω2. The designed classifier classifies 110 points from ω1 correctly and 20 points to class ω2. Also, it classifies 120 points from class ω2 correctly and 30 points to class ω1. The confusion matrix for this case is

The recall for the first class is

R1=110130

and the precision

P1=110140

. The respective values for the second class are similarly computed. The accuracy is

Ac=110+120130+150

.

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/B9781597492720500128

Multiple Testing of Hypotheses in Biomedical Research

Hansen Bannerman-Thompson, … Ranajit Chakraborty, in Handbook of Statistics, 2012

6.3 Bonferroni procedure

RejectH01andH02ifX¯≥0.515andY¯≥0.515.RejectH01but notH02ifX¯≥0.515andY¯<0.515.RejectH02but notH01ifX¯<0.515andY¯≥0.515.Do not rejectH01andH02ifX¯<0.515andY¯<0.515.

An explicit calculation gives

FWER=Pr(V≥1∣H01,H02)=0.07<0.08;FWER=Pr(V≥1∣H01)=0.04<0.08;FWER=Pr(V≥1∣H02)=0.04<0.08.

The Bonferroni bound for FWER=Pr(V≥1∣H01,H02) is 0.08 but the actual probability is 0.07. Bonferroni paradigm declares that the above procedure controls FWER at the level 0.08. As a matter of fact, we could say that the procedure controls FWER at the level 0.07.

In this example we could calculate precisely the error probability of each type. If we want to control the error probability FWER=Pr(V≥1∣H01,H02) precisely at the level 0.08, we change the critical value from 0.515–0.5. Look at the following multiple testing procedure.

- 1.

-

Reject both the null hypotheses if X¯≥0.5andY¯≥0.5;

- 2.

-

Reject H01 but not H02 if X¯≥0.5andY¯<0.5;

- 3.

-

Reject H02 but not H01 if X¯<0.5andY¯≥0.5;

- 4.

-

Do not reject H01 and H02 if X¯<0.5andY¯<0.5.

For this test,

FWER=Pr(V≥1∣H01,H02)=0.08;FWER=Pr(V≥1∣H01)=0.0455<0.08;FWER=Pr(V≥1∣H01)=0.0455<0.08.

If the underlying test statistics of the hypotheses are statistically independent, we have a better control of the error probabilities. The following multiple test is designed towards this end.

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/B9780444518750000087

Philosophy of Econometrics

Aris Spanos, in Philosophy of Economics, 2012

5.7.4 Revisiting observed Confidence Intervals (CI)

As argued above, the post-data error probabilities associated with a CI are degenerate. In contrast, testing reasoning gives rise to well-defined error probabilities post-data because it compares what actually happened to what it is expected under different scenarios (hypothetical values of μ), since it does not involve TSN.

In view of that, it is evident that one can evaluate the probability of claims of the form given in (26) by relating μ1 to whatever values one is interested in, including x―n±cα2(s/n) for different α, using hypothetical (not factual) reasoning. Indeed, this is exactly how the severity assessment circumvents the problem facing observed CIs, whose own post-data error probabilities are zero or one, and provides an effective way to evaluate inferential claims of the form:

μ≥μ1=μ0+γ,forγ≤0,orμ≤μ1=μ0+γ,forγ≥0

, using well-defined post data error probabilities by relating γ to different values of cα2(s/n); see [Mayo and Spanos, 2006]. The reasoning underlying such severity evaluations is fundamentally different from the factual reasoning underlying a sequence of CIs; section 5.4.

The severity evaluation also elucidates the comparisons between p-values and CIs and can be used to explain why the various attempts to relate p-value and observed confidence interval curves (see [Birnbaum, 1961; Kempthorne and Folks, 1971; Poole, 1987]) were unsuccessful. In addition, it can be used to shed light on the problem of evaluating ‘effect sizes’ (see [Rosenthal et al., 1999]) sought after in some applied fields like psychology and epidemiology; see [Spanos, 2004].

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/B9780444516763500130

Beam Management

Erik Dahlman, … Johan Sköld, in 5G NR (Second Edition), 2021

12.3.1 Beam-Failure Detection

Fundamentally, a beam failure is assumed to have happened when the error probability for the downlink control channel (PDCCH) exceeds a certain value. However, similar to radio-link failure, rather than actually measuring the PDCCH error probability the device declares a beam failure based on measurements of the quality of some reference signal. This is often expressed as measuring a hypothetical error rate. More specifically, the device should declare beam failure based on measured L1-RSRP of a periodic CSI-RS or an SS block that is spatially QCL with the PDCCH.

By default, the device should declare beam failure based on measurement on the reference signal (CSI-RS or SS block) associated with the PDCCH TCI state. However, there is also a possibility to explicitly configure a different CSI-RS on which to measure for beam-failure detection.

Each time instant the measured L1-RSRP is below a configured value is defined as a beam-failure instance. If the number of consecutive beam-failure instances exceeds a configured value, the device declares a beam failure and initiates the beam-failure-recovery procedure.

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/B978012822320800012X

Classifiers Based on Bayes Decision Theory

Sergios Theodoridis, Konstantinos Koutroumbas, in Pattern Recognition (Fourth Edition), 2009

2.3 Discriminant Functions and Decision Surfaces

It is by now clear that minimizing either the risk or the error probability or the Neyman-Pearson criterion is equivalent to partitioning the feature space into M regions, for a task with M classes. If regions Ri, Rj happen to be contiguous, then they are separated by a decision surface in the multidimensional feature space. For the minimum error probability case, this is described by the equation

(2.21)P(ωi|x)−P(ωj|x)=0

From the one side of the surface this difference is positive, and from the other it is negative. Sometimes, instead of working directly with probabilities (or risk functions), it may be more convenient, from a mathematical point of view, to work with an equivalent function of them, for example, gi(x) ≡ f(P(ωi|x)), where f(·) is a monotonically increasing function. gi(x) is known as a discriminant function. The decision test (2.13) is now stated as

(2.22)classify x in ωi if gi(x)>gj(x) ∀j≠i

The decision surfaces, separating contiguous regions, are described by

(2.23)gij(x)≡gi(x)−gj(x)=0, i,j=1,2,…,M, i≠j

So far, we have approached the classification problem via Bayesian probabilistic arguments and the goal was to minimize the classification error probability or the risk. However, as we will soon see, not all problems are well suited to such approaches. For example, in many cases the involved pdfs are complicated and their estimation is not an easy task. In such cases, it may be preferable to compute decision surfaces directly by means of alternative costs, and this will be our focus in Chapters 3 and 4. Such approaches give rise to discriminant functions and decision surfaces, which are entities with no (necessary) relation to Bayesian classification, and they are, in general, suboptimal with respect to Bayesian classifiers.

In the following we will focus on a particular family of decision surfaces associated with the Bayesian classification for the specific case of Gaussian density functions.

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/B9781597492720500049

Mesh Networks: Optimal Routing and Scheduling

Anurag Kumar, … Joy Kuri, in Wireless Networking, 2008

Discussion

- 1.

-

In deriving the scheduling algorithm, we could also consider the error probability on the link. Of course, if the probability of a packet error on a link is nonzero, then the stability region and also the queue evolution equation would need to be changed. However, the MWS algorithm is only slightly different. This is explored in Problem 8.9.

- 2.

-

With a suitable choice of edge weights, the MWS routing and scheduling algorithm is applicable in considerably more general scenarios. For example, we could use the same algorithm when the topology is time varying in a manner that a time average probability for a link to exist can be defined.

- 3.

-

The link activation vectors S could be nonnegative reals. Recall that the transmission bit rate could be a function of the SINR at the receiver. This in turn depends on the transmission power used by the transmitters in the link activation vector. Thus corresponding to a transmission rate vector S, we also need to specify the transmission powers. In such cases, an obvious optimization criterion could be to minimize the energy or power consumption.

- 4.

-

The MWS algorithm is complex to implement. Further, what we have described is a centralized algorithm that requires complete knowledge of the network state. Hence this is not quite a practical algorithm. Many distributed and randomized algorithms have been proposed in the literature.

- 5.

-

The MWS algorithm is a significantly general algorithm and can be applied to a large class of problems. The most notable use is in developing maximum throughput scheduling algorithms in input queued switches.

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/B9780123742544500090

Different views of spectral efficiency*

Ana I Pérez-Neira, Marc Realp Campalans, in Cross-Layer Resource Allocation in Wireless Communications, 2009

2.3 The bit error rate (BER)

An important reference for the assessment of any modulation scheme is the bit error probability or bit error rate (BER) for the corresponding uncoded system. Unfortunately, for most non-binary modulation techniques (e.g. M-QAM and M-PSK) an exact expression for BER is hard to find.

At high SNR and using Gray mapping [2], it is commonly assumed that an erroneous detected symbol differs from the correct one in only one bit. Consequently, the BER is approximated by the symbol error rate (SER) divided by the number of bits per symbol b.

Closed-form expressions for SER of M-QAM and M-PSK as functions of the SNR can be found in [2]. For M-QAM with square constellations, i.e. b is an even integer, the BER approximation is given by

(2.3)BERMQAM(γ)=2log2M(1-1M)erfc(3γ2(M-1))

where erfc(.) is the complementary error function. For M-PSK modulations the BER approximation is

(2.4)BERMPSK(γ)={erfc(γ)forundefinedlog2M=1,21log2Merfc(γsin(πM))forundefinedlog2M>2

where BPSK and QPSK have the same BER because a QPSK signal can be seen as two independent BPSK signals.

An example is given in Figure 2.2. We observe that for modulations higher than 8-PSK it is preferable to move to QAM modulations. Note that 2-QAM and 4-QAM modulations are equivalent to BPSK and QPSK modulations, respectively. Furthermore, it can be shown that the BER performance of 8-QAM is very close to that of 16-QAM but with one bit per symbol less. Hence, it is quite usual that in commercial systems QAM modulations start at 16-QAM. For instance, 16-QAM and 64-QAM are the two QAM schemes considered by the IEEE802.11g/a standards [3].

Figure 2.2. BER curves for different modulations.

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/B9780123741417000026

Channel coding

Wenhong Chen, … Li Guo, in 5G NR and Enhancements, 2022

7.3.6.3 Length for CRC

For LDPC codes, the number of CRC bits to achieve a given undetected error probability varies with the block size and code rate. Considering the actual performance requirements, NR finally determines that when the information block size A>3824, the length of CRC added to a TB is L=24 bits, and the generating polynomial is:

(7.13)gCRC24A(D)=D24+D23+D18+D17+D14+D11+D10+D7+D6+D5+D4+D3+D+1

When the information block size A≤3824, a CRC with a length of L=16 bits is added after the TB, and the generating polynomial is:

(7.14)gCRC16(D)=D16+D12+D5+1

If code segmentation (i.e., the number of blocks C>1) is required, a 24-bit CRC is added after each CB, and the generating polynomial is:

(7.15)gCRC24B(D)=D24+D23+D6+D5+D+1

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/B9780323910606000076

Location Information Processing

David Munoz, … Rogerio Enriquez, in Position Location Techniques and Applications, 2009

3.5.2 Circular Error Probability

The circular error probability (CEP) [25] is a simple measure of accuracy defined as the radius of the circle that has its center at the mean and contains half the realizations of a random vector of coordinate estimates. It is a measure of uncertainty in the location estimator q^ relative to its mean E{q^}.. If the location estimator is unbiased, the CEP is a measure of the estimator uncertainty relative to the true NOI position. If the magnitude of the bias vector is bounded by B, then with a probability of one-half, a particular estimate is within a distance of B+ CEP from the true position. This concept is illustrated in Figure 3.15.

FIGURE 3.15. Geometry of the CEP definition.

From its definition, the CEP may be derived by solving the following equation:

(3.49)12=∫∫Rpq^(ζ)dζ1dζ2,

where pqˆ (ζ) is the probability density function of vector estimate qˆ, and the integration region is defined as R={ζ:|ζ−E{q^}|}⩽CEP. Most of the time, a closed-form expression of Equation (3.49) is difficult to find and numerical integration must be performed. However, the following approximation, which is accurate to within 10%, is often used [25]:

(3.50)CEP≈0.75E{(q^−E{q^})H(q^−E{q^})}=0.75λ1+λ2=0.75σ12+σ22.

Here λ1 and λ2 are the eigenvalues of the estimator covariance matrix, which is given by

(3.51)E{(q^−E{q^})H(q^−E{q^})}=[σ12σ12σ12σ12].

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/B9780123743534000090

Error Statistics

Deborah G. Mayo, Aris Spanos, in Philosophy of Statistics, 2011

1.3 The Severity Principle

A method’s error probabilities describe its performance characteristics in a hypothetical sequence of repetitions. How are we to use error probabilities in making particular inferences? This leads to the general question:

-

When do data x0 provide good evidence for, or a good test of, hypothesis H?

Our standpoint begins with the situation in which we would intuitively deny x0 is evidence for H. Data x0 fail to provide good evidence for the truth of H if the inferential procedure had very little chance of providing evidence against H, even if H is false.

-

Severity Principle (weak). Data x0 (produced by process G) do not provide good evidence for hypothesis H if x0 results from a test procedure with a very low probability or capacity of having uncovered the falsity of H, even if H is incorrect.

Such a test we would say is insufficiently stringent or severe. The onus is on the person claiming to have evidence for H to show that they are not guilty of at least so egregious a lack of severity. Formal error statistical tools are regarded as providing systematic ways to foster this goal, as well as to determine how well it has been met in any specific case. Although one might stop with this negative conception (as perhaps Fisher and Popper did), we will go on to the further, positive one, which will comprise the full severity principle:

-

Severity Principle (full). Data x0 (produced by process G) provides good evidence for hypothesis H (just) to the extent that test T severely passes H with x0.

Severity rationale vs. low long-run error-rate rationale (evidential vs. behavioral rationale)

Let us begin with a very informal example. Suppose we are testing whether and how much weight George has gained between now and the time he left for Paris, and do so by checking if any difference shows up on a series of well-calibrated and stable weighing methods, both before his leaving and upon his return. If no change on any of these scales is registered, even though, say, they easily detect a difference when he lifts a .1-pound potato, then this may be regarded as grounds for inferring that George’s weight gain is negligible within limits set by the sensitivity of the scales. The hypothesis H here might be:

-

H: George’s weight gain is no greater than δ,

where δ is an amount easily detected by these scales. H, we would say, has passed a severe test: were George to have gained δ pounds or more (i.e., were H false), then this method would almost certainly have detected this.

A behavioristic rationale might go as follows: If one always follows the rule going from failure to detect a weight gain after stringent probing to inferring weight gain no greater than δ, then one would rarely be wrong in the long run of repetitions. While true, this is not the rationale we give in making inferences about George. It is rather that this particular weighing experiment indicates something about George’s weight. The long run properties — at least when they are relevant for particular inferences — utilize error probabilities to characterize the capacity of our inferential tool for finding things out in the particular case. This is the severity rationale.

We wish to distinguish the severity rationale from a more prevalent idea for how procedures with low error probabilities become relevant to a particular application; namely, the procedure is rarely wrong, therefore, the probability it is wrong in this case is low. In this view we are justified in inferring H because it was the output of a method that rarely errs. This justification might be seen as intermediate between full-blown behavioristic justifications, and a genuine inferential justification. We may describe this as the notion that the long run error probability ‘rubs off’ on each application. This still does not get at the reasoning for the particular case at hand. The reliability of the rule used to infer H is at most a necessary and not a sufficient condition to warrant inferring H. What we wish to sustain is this kind of counterfactual statistical claim: that were George to have gained more than δ pounds, at least one of the scales would have registered an increase. This is an example of what philosophers often call an argument from coincidence: it would be a preposterous coincidence if all the scales easily registered even slight weight shifts when weighing objects of known weight, and yet were systematically misleading us when applied to an object of unknown weight. Are we to allow that tools read our minds just when we do not know the weight? To deny the warrant for H, in other words, is to follow a highly unreliable method: it would erroneously reject correct inferences with high or maximal probability (minimal severity), and thus would thwart learning. The stronger, positive side of the severity principle is tantamount to espousing the legitimacy of strong arguments from coincidence. What statistical tests enable us to do is determine when such arguments from coincidence are sustainable (e.g., by setting up null hypotheses). It requires being very specific about which inference is thereby warranted—we may, for example, argue from coincidence for a genuine, non-spurious, effect, but not be able to sustain an argument to the truth of a theory or even the reality of an entity.

Passing a Severe Test.

We can encapsulate this as follows:

-

A hypothesis H passes a severe test T with data x0 if,

-

(S-1) x0 accords with H, (for a suitable notion of accordance) and

-

(S-2) with very high probability, test T would have produced a result that accords less well with H than x0 does, if H were false or incorrect.

Equivalently, (S-2) can be stated:

-

(S-2)*: with very low probability, test T would have produced a result that accords as well as or better with H than x0 does, if H were false or incorrect.

Severity, in our conception, somewhat in contrast to how it is often used, is not a characteristic of a test in and of itself, but rather of the test T, a specific test result x0, and a specific inference H (not necessarily predesignated) being entertained. That is, the severity function has three arguments. We use the notation: SEV (T,x0,H), or even SEV (H), to abbreviate:

-

“The severity with which claim H passes test T with outcome x0”.

As we will see, the analyses may take different forms: one may provide a series of inferences that pass with high and low severity, serving essentially as benchmarks for interpretation, or one may fix the inference of interest and report the severity attained.

The formal statistical testing apparatus does not include severity assessments, but there are ways to use the error statistical properties of tests, together with the outcome x0, to evaluate a test’s severity in relation to an inference of interest. This is the key for the inferential interpretation of error statistical tests. While, at first blush, a test’s severity resembles the notion of a test’s power, the two notions are importantly different; see section 2.

The severity principle, we hold, makes sense of the underlying reasoning of tests, and addresses chronic problems and fallacies associated with frequentist testing. In developing this account, we draw upon other attempts to supply frequentist foundations, in particular by Bartlett, Barnard, Birnbaum, Cox, Efron, Fisher, Lehmann, Neyman, E. Pearson; the severity notion, or something like it, affords a rationale and unification of several threads that we have extracted and woven together. Although mixing aspects from N-P and Fisherian tests is often charged as being guilty of an inconsistent hybrid [Gigerenzer, 1993], the error statistical umbrella, linked by the notion of severity, allows for a coherent blending of elements from both approaches. The different methods can be understood as relevant for one or another type of question along the stages of a full-bodied inquiry. Within the error statistical umbrella, the different methods are part of the panoply of methods that may be used in the service of severely probing hypotheses.

A principle for interpreting statistical inference vs. the goal of science

We should emphasize at the outset that while severity is the principle on which interpretations of statistical inferences are based, we are not claiming it is the goal of science. While scientists seek to have hypotheses and theories pass severe tests, severity must be balanced with informativeness. So for example, trivially true claims would pass with maximal severity, but they would not yield informative inferences 4. Moreover, one learns quite a lot from ascertaining which aspects of theories have not yet passed severely. It is the basis for constructing rival theories which existing tests cannot distinguish, and is the impetus for developing more probative tests to discriminate them (see [Mayo, 2010a]).

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/B9780444518620500058

Supervised Learning: The Epilogue

Sergios Theodoridis, Konstantinos Koutroumbas, in Pattern Recognition (Fourth Edition), 2009

10.3 Exploiting the Finite Size of the Data Set

The estimation of the classification error probability presupposes that one has decided upon the data set to which the error counting will be applied. This is not a straightforward task. The set of samples that we have at our disposal is finite, and it has to be utilized for both training and testing. Can we use the same samples for training and testing? If not, what are the alternatives? Depending on the answer to the question, the following methods have been suggested:

- ▪

-

Resubstitution Method: The same data set is used, first for training and then for testing. One need not go into mathematical details in order to see that such a procedure is not very fair. Indeed, this is justified by the mathematical analysis. In [Fole 72] the performance of this method was analyzed using normal distributions. The analysis results show that this method provides an optimistic estimate of the true error probability. The amount of bias of the resubstitution estimate is a function of the ratio N/l, that is, the data set size and the dimension of the feature space. Furthermore, the variance of the estimate is inversely proportional to the data set size N. In words, in order to obtain a reasonably good estimate, N as well as the ratio N/l must be large enough. The results from the analysis and the related simulations show that N/l should be at least three and that an upper bound of the variance is 1/8N. Of course, if this technique is to be used in practice, where the assumptions of the analysis are not valid, experience suggests that the suggested ratio must be even larger [Kana 74]. Once more, the larger the ratio N/l, the more comfortable one feels.

- ▪

-

Holdout Method: The available data set is divided into two subsets, one for training and one for testing. The major drawback of this technique is that it reduces the size for both the training and the testing data. Another problem is to decide how many of the N available data will be allocated to the training set and how many to the test set. This is an important issue. In Section 3.5.3 of Chapter 3, we saw that designing a classifier using a finite data set introduces an excess mean error and a variance around it, as different data sets, of the same size, are used for the design. Both of these quantities depend on the size of the training set. In [Raud 91], it is shown that the classification error probability of a classifier, designed using a finite training data set, N, is always higher than the corresponding asymptotic error probability (N → ∞). This excess error decreases as N increases. On the other hand, in our discussion in the previous section we saw that the variance of the error counting depends on the size of the test set, and for small test data sets the estimates can be unreliable. Efforts made to optimize the respective sizes of the two sets have not yet led to practical results.

- ▪

-

Leave-One-Out Method: This method [Lach 68] alleviates the lack of independence between the training and test sets in the resubstitution method and at the same time frees itself from the dilemma associated with the holdout method. The training is performed using N −1 samples, and the test is carried out using the excluded sample. If this is misclassified, an error is counted. This is repeated N times, each time excluding a different sample. The total number of errors leads to the estimation of the classification error probability. Thus, training is achieved using, basically, all samples, and at the same time independence between training and test sets is maintained. The major disadvantage of the technique is its high computational complexity. For certain types of classifiers (i.e., linear or quadratic) it turns out that a simple relation exists between the leave-one-out and the resubstitution method ([Fuku 90], Problem 10.2). Thus, in such cases the former estimate is obtained using the latter method with some computationally simple modifications.

The estimates resulting from the holdout and leave-one-out methods turn out to be very similar, for comparable sizes of the test and training sets. Furthermore, it can be shown (Problem 10.3, [Fuku 90]) that the holdout error estimate, for a Bayesian classifier, is an upper bound of the true Bayesian error. In contrast, the resubstitution error estimate is a lower bound of the Bayesian error, confirming our previous comment that it is an optimistic estimate. To gain further insight into these estimates and their relation, let us make the following definitions:

- ▪

-

PeN

denotes the classification error probability for a classifier designed using a finite set of N training samples.

- ▪

-

P¯eN

denotes the average

E[PeN]

over all possible training sets of size N.

- ▪

-

Pe is the average asymptotic error as N → ∞.

It turns out that the holdout and leave-one-out methods (for statistically independent samples) provide an unbiased estimate of

P¯eN

. In contrast, the resubstitution method provides a biased (underestimated) estimate of

P¯eN

. Figure 10.1 shows the trend of a typical plot of

FIGURE 10.1. Plots indicating the general trend of the average resubstitution and leave-one-out error probabilities as functions of the number of training points.

P¯eN

and the average (over all possible sets of size N) resubstitution error as functions of N [Fole 72, Raud 91]. It is readily observed that as the data size N increases, both curves tend to approach the asymptotic Pe.

A number of variations and combinations of these basic schemes have also been suggested in the literature. For example, a variation of the leave-one-out method is to leave k > 1, instead of one, samples out. The design and test process is repeated for all distinct choices of k samples. References [Kana 74, Raud 91] are two good examples of works discussing various aspects of the topic.

In [Leis 98] a method called cross-validation with active pattern selection is proposed, with the goal of reducing the high computational burden required by the leave-one-out method. It is suggested not to leave out (one at a time) all N feature vectors, but only k < N. To this end the “good” points of the data set (expected to contribute a 0 to the error) are not tested. Only the k “worst” points are considered. The choice between “good” and “bad” is based on the respective values of the cost function after an initial training. This method exploits the fact that the outputs of the classifier, trained according to the least squares cost function, approximate posterior probabilities, as discussed in Chapter 3. Thus, those feature vectors whose outputs have a large deviation from the desired value (for the true class) are expected to be the ones that contribute to the classification error.

Another set of techniques have been developed around the bootstrap method [Efro 79, Hand 86, Jain 87]. A major incentive for the development of these techniques is the variance of the leave-one-out method estimate for small data sets [Efro 83]. According to the “bootstrap” philosophy, new data sets are artificially generated. This is a way to overcome the limited number of available data and create more data in order to better assess the statistical properties of an estimator. Let X be the set of the available data of size N. A bootstrap design sample set of size N,X*, is formed by random sampling with replacement of the set X. Replacement means that when a sample, say xi, is “copied” to the set X*, it is not removed from X but is reconsidered in the next sampling. A number of variants have been built upon the bootstrap method. A straightforward one is to design the classifier using a bootstrap sample set and count the errors using the samples from X that do not appear in this bootstrap sample set. This is repeated for different bootstrap sample sets. The error rate estimate, e0, is computed by counting all the errors and dividing the sum by the total number of test samples used. However, in [Raud 91] it is pointed out that the bootstrap techniques improve on the leave-one-out method only when the classification error is large.

Another direction is to combine estimates from different estimators. For example, in the so-called 0.632 estimator ([Efro 83]), the error estimate is taken as a convex combination of the resubstitution error, eres, and the bootstrap error e0,

It has been reported that the 0.632 estimator is particularly effective in cases of small size data sets [Brag 04]. An extension of the 0.632 rule is discussed in [Sima 06] where convex combinations of different estimators are considered and the combining weights are computed via an optimization process.

Confusion Matrix, Recall and Precision

In evaluating the performance of a classification system, the probability of error is sometimes not the only quantity that assesses its performance sufficiently. Let us take for example, an M-class classification task. An important issue is to know whether there are classes that exhibit a higher tendency for confusion. The confusion matrix A = [A(i,j)] is defined so that its element A(i,j) is the number of data points whose true class label was i and were classified to class j. From A, one can directly extract the recall and precision values for each class, along with the overall accuracy:

- ▪

-

Recall (Ri). Ri is the percentage of data points with true class label i, which were correctly classified in that class. For example, for a two-class problem, the recall of the first class is calculated as

R1=A(1,1)A(1,1)+A(1,2)

.

- ▪

-

Precision (Pi). Pi is the percentage of data points classified as class i, whose true class label is indeed i. Therefore, for the first class in a two-class problem,

P1=A(1,1)A(1,1)+A(2,1).

- ▪

-

Overall Accuracy (Ac). The overall accuracy, Ac, is the percentage of data that has been correctly classified. Given an M-class problem, Ac is computed from the confusion matrix according to the equation

Ac=1N∑i=1MA(i,i),

where N is the total number of points in the test set.

Take as an example a two-class problem where the test set consists of 130 points from class ω1 and 150 points from class ω2. The designed classifier classifies 110 points from ω1 correctly and 20 points to class ω2. Also, it classifies 120 points from class ω2 correctly and 30 points to class ω1. The confusion matrix for this case is

The recall for the first class is

R1=110130

and the precision

P1=110140

. The respective values for the second class are similarly computed. The accuracy is

Ac=110+120130+150

.

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/B9781597492720500128

Multiple Testing of Hypotheses in Biomedical Research

Hansen Bannerman-Thompson, … Ranajit Chakraborty, in Handbook of Statistics, 2012

6.3 Bonferroni procedure

RejectH01andH02ifX¯≥0.515andY¯≥0.515.RejectH01but notH02ifX¯≥0.515andY¯<0.515.RejectH02but notH01ifX¯<0.515andY¯≥0.515.Do not rejectH01andH02ifX¯<0.515andY¯<0.515.

An explicit calculation gives

FWER=Pr(V≥1∣H01,H02)=0.07<0.08;FWER=Pr(V≥1∣H01)=0.04<0.08;FWER=Pr(V≥1∣H02)=0.04<0.08.

The Bonferroni bound for FWER=Pr(V≥1∣H01,H02) is 0.08 but the actual probability is 0.07. Bonferroni paradigm declares that the above procedure controls FWER at the level 0.08. As a matter of fact, we could say that the procedure controls FWER at the level 0.07.

In this example we could calculate precisely the error probability of each type. If we want to control the error probability FWER=Pr(V≥1∣H01,H02) precisely at the level 0.08, we change the critical value from 0.515–0.5. Look at the following multiple testing procedure.

- 1.

-

Reject both the null hypotheses if X¯≥0.5andY¯≥0.5;

- 2.

-

Reject H01 but not H02 if X¯≥0.5andY¯<0.5;

- 3.

-

Reject H02 but not H01 if X¯<0.5andY¯≥0.5;

- 4.

-

Do not reject H01 and H02 if X¯<0.5andY¯<0.5.

For this test,

FWER=Pr(V≥1∣H01,H02)=0.08;FWER=Pr(V≥1∣H01)=0.0455<0.08;FWER=Pr(V≥1∣H01)=0.0455<0.08.

If the underlying test statistics of the hypotheses are statistically independent, we have a better control of the error probabilities. The following multiple test is designed towards this end.

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/B9780444518750000087

Philosophy of Econometrics

Aris Spanos, in Philosophy of Economics, 2012

5.7.4 Revisiting observed Confidence Intervals (CI)

As argued above, the post-data error probabilities associated with a CI are degenerate. In contrast, testing reasoning gives rise to well-defined error probabilities post-data because it compares what actually happened to what it is expected under different scenarios (hypothetical values of μ), since it does not involve TSN.

In view of that, it is evident that one can evaluate the probability of claims of the form given in (26) by relating μ1 to whatever values one is interested in, including x―n±cα2(s/n) for different α, using hypothetical (not factual) reasoning. Indeed, this is exactly how the severity assessment circumvents the problem facing observed CIs, whose own post-data error probabilities are zero or one, and provides an effective way to evaluate inferential claims of the form:

μ≥μ1=μ0+γ,forγ≤0,orμ≤μ1=μ0+γ,forγ≥0

, using well-defined post data error probabilities by relating γ to different values of cα2(s/n); see [Mayo and Spanos, 2006]. The reasoning underlying such severity evaluations is fundamentally different from the factual reasoning underlying a sequence of CIs; section 5.4.

The severity evaluation also elucidates the comparisons between p-values and CIs and can be used to explain why the various attempts to relate p-value and observed confidence interval curves (see [Birnbaum, 1961; Kempthorne and Folks, 1971; Poole, 1987]) were unsuccessful. In addition, it can be used to shed light on the problem of evaluating ‘effect sizes’ (see [Rosenthal et al., 1999]) sought after in some applied fields like psychology and epidemiology; see [Spanos, 2004].

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/B9780444516763500130

Beam Management

Erik Dahlman, … Johan Sköld, in 5G NR (Second Edition), 2021

12.3.1 Beam-Failure Detection

Fundamentally, a beam failure is assumed to have happened when the error probability for the downlink control channel (PDCCH) exceeds a certain value. However, similar to radio-link failure, rather than actually measuring the PDCCH error probability the device declares a beam failure based on measurements of the quality of some reference signal. This is often expressed as measuring a hypothetical error rate. More specifically, the device should declare beam failure based on measured L1-RSRP of a periodic CSI-RS or an SS block that is spatially QCL with the PDCCH.

By default, the device should declare beam failure based on measurement on the reference signal (CSI-RS or SS block) associated with the PDCCH TCI state. However, there is also a possibility to explicitly configure a different CSI-RS on which to measure for beam-failure detection.

Each time instant the measured L1-RSRP is below a configured value is defined as a beam-failure instance. If the number of consecutive beam-failure instances exceeds a configured value, the device declares a beam failure and initiates the beam-failure-recovery procedure.

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/B978012822320800012X

Classifiers Based on Bayes Decision Theory

Sergios Theodoridis, Konstantinos Koutroumbas, in Pattern Recognition (Fourth Edition), 2009

2.3 Discriminant Functions and Decision Surfaces

It is by now clear that minimizing either the risk or the error probability or the Neyman-Pearson criterion is equivalent to partitioning the feature space into M regions, for a task with M classes. If regions Ri, Rj happen to be contiguous, then they are separated by a decision surface in the multidimensional feature space. For the minimum error probability case, this is described by the equation

(2.21)P(ωi|x)−P(ωj|x)=0

From the one side of the surface this difference is positive, and from the other it is negative. Sometimes, instead of working directly with probabilities (or risk functions), it may be more convenient, from a mathematical point of view, to work with an equivalent function of them, for example, gi(x) ≡ f(P(ωi|x)), where f(·) is a monotonically increasing function. gi(x) is known as a discriminant function. The decision test (2.13) is now stated as

(2.22)classify x in ωi if gi(x)>gj(x) ∀j≠i

The decision surfaces, separating contiguous regions, are described by

(2.23)gij(x)≡gi(x)−gj(x)=0, i,j=1,2,…,M, i≠j

So far, we have approached the classification problem via Bayesian probabilistic arguments and the goal was to minimize the classification error probability or the risk. However, as we will soon see, not all problems are well suited to such approaches. For example, in many cases the involved pdfs are complicated and their estimation is not an easy task. In such cases, it may be preferable to compute decision surfaces directly by means of alternative costs, and this will be our focus in Chapters 3 and 4. Such approaches give rise to discriminant functions and decision surfaces, which are entities with no (necessary) relation to Bayesian classification, and they are, in general, suboptimal with respect to Bayesian classifiers.

In the following we will focus on a particular family of decision surfaces associated with the Bayesian classification for the specific case of Gaussian density functions.

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/B9781597492720500049

Mesh Networks: Optimal Routing and Scheduling

Anurag Kumar, … Joy Kuri, in Wireless Networking, 2008

Discussion

- 1.

-

In deriving the scheduling algorithm, we could also consider the error probability on the link. Of course, if the probability of a packet error on a link is nonzero, then the stability region and also the queue evolution equation would need to be changed. However, the MWS algorithm is only slightly different. This is explored in Problem 8.9.

- 2.

-

With a suitable choice of edge weights, the MWS routing and scheduling algorithm is applicable in considerably more general scenarios. For example, we could use the same algorithm when the topology is time varying in a manner that a time average probability for a link to exist can be defined.

- 3.

-

The link activation vectors S could be nonnegative reals. Recall that the transmission bit rate could be a function of the SINR at the receiver. This in turn depends on the transmission power used by the transmitters in the link activation vector. Thus corresponding to a transmission rate vector S, we also need to specify the transmission powers. In such cases, an obvious optimization criterion could be to minimize the energy or power consumption.

- 4.

-

The MWS algorithm is complex to implement. Further, what we have described is a centralized algorithm that requires complete knowledge of the network state. Hence this is not quite a practical algorithm. Many distributed and randomized algorithms have been proposed in the literature.

- 5.

-

The MWS algorithm is a significantly general algorithm and can be applied to a large class of problems. The most notable use is in developing maximum throughput scheduling algorithms in input queued switches.

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/B9780123742544500090

Different views of spectral efficiency*

Ana I Pérez-Neira, Marc Realp Campalans, in Cross-Layer Resource Allocation in Wireless Communications, 2009

2.3 The bit error rate (BER)

An important reference for the assessment of any modulation scheme is the bit error probability or bit error rate (BER) for the corresponding uncoded system. Unfortunately, for most non-binary modulation techniques (e.g. M-QAM and M-PSK) an exact expression for BER is hard to find.

At high SNR and using Gray mapping [2], it is commonly assumed that an erroneous detected symbol differs from the correct one in only one bit. Consequently, the BER is approximated by the symbol error rate (SER) divided by the number of bits per symbol b.

Closed-form expressions for SER of M-QAM and M-PSK as functions of the SNR can be found in [2]. For M-QAM with square constellations, i.e. b is an even integer, the BER approximation is given by

(2.3)BERMQAM(γ)=2log2M(1-1M)erfc(3γ2(M-1))

where erfc(.) is the complementary error function. For M-PSK modulations the BER approximation is

(2.4)BERMPSK(γ)={erfc(γ)forundefinedlog2M=1,21log2Merfc(γsin(πM))forundefinedlog2M>2

where BPSK and QPSK have the same BER because a QPSK signal can be seen as two independent BPSK signals.

An example is given in Figure 2.2. We observe that for modulations higher than 8-PSK it is preferable to move to QAM modulations. Note that 2-QAM and 4-QAM modulations are equivalent to BPSK and QPSK modulations, respectively. Furthermore, it can be shown that the BER performance of 8-QAM is very close to that of 16-QAM but with one bit per symbol less. Hence, it is quite usual that in commercial systems QAM modulations start at 16-QAM. For instance, 16-QAM and 64-QAM are the two QAM schemes considered by the IEEE802.11g/a standards [3].

Figure 2.2. BER curves for different modulations.

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/B9780123741417000026

Channel coding

Wenhong Chen, … Li Guo, in 5G NR and Enhancements, 2022

7.3.6.3 Length for CRC

For LDPC codes, the number of CRC bits to achieve a given undetected error probability varies with the block size and code rate. Considering the actual performance requirements, NR finally determines that when the information block size A>3824, the length of CRC added to a TB is L=24 bits, and the generating polynomial is:

(7.13)gCRC24A(D)=D24+D23+D18+D17+D14+D11+D10+D7+D6+D5+D4+D3+D+1

When the information block size A≤3824, a CRC with a length of L=16 bits is added after the TB, and the generating polynomial is:

(7.14)gCRC16(D)=D16+D12+D5+1

If code segmentation (i.e., the number of blocks C>1) is required, a 24-bit CRC is added after each CB, and the generating polynomial is:

(7.15)gCRC24B(D)=D24+D23+D6+D5+D+1

Read full chapter

URL:

https://www.sciencedirect.com/science/article/pii/B9780323910606000076

|

6.3. ВЕРОЯТНОСТНЫЕ ВЫЧИСЛЕНИЯ |

271 |

С другой стороны, работа над верхними оценками — построение конкретных алгоритмов, как правило, производится в терминах машин с произвольным доступом (RAM).

Упражнение 6.2.6. Покажите, что задача распознавания гамильтоновых графов (т. е. графов, содержащих гамильтонов цикл) принадлежит NP, а задача распознавания негамильтоновых графов принадлежит coNP.

Упражнение 6.2.7. Придумайте полиномиальный алгоритм для проверки, есть ли в заданном графе хотя бы один «треугольник».

Упражнение 6.2.8. Рассмотрим язык DF NT , состоящий из полиномов от нескольких переменных, имеющих целочисленные корни.

Студент утверждает, что DF NT 2 NP , т.к. если оракул-Мерлин предоставит решение v, доказываю-

?

щее принадлежность полинома p 2 DF NT , то верификатор Артур сможет легко проверить: p(v) = 0. Прав ли студент?

6.3Вероятностные вычисления

Вероятностные алгоритмы с односторонней ошибкой. Классы сложно-

сти RP и coRP и отношение к классам NP и coNP. Вероятностная

амплификация для RP и coRP. Вероятностные алгоритмы с двусторонней ошибкой. Класс сложности BPP. Вероятностная амплификация для BPP. Неамплифицируемый класс PP.

Итак, в разделе 6.1.1 мы познакомились с детерминированными машинами Тьюринга, моделями, ко-

|

272 |

Глава 6. ОСНОВЫ ТЕОРИИ СЛОЖНОСТИ ВЫЧИСЛЕНИЙ |

||||||||||||||||||||||

|

6.3. ВЕРОЯТНОСТНЫЕ ВЫЧИСЛЕНИЯ |

273 |

торые можно использовать для описания всех существующих вычислительных устройств, будь то карманный калькулятор или суперкомпьютер. В разделе 6.2.2 мы рассматривали недетерминированные машины Тьюринга — интересную, мощную модель вычислений, полезную для описания классов сложностей задач, но, увы, не соответствующую никаким реальным вычислительным устройствам. Однако оказалось, что можно частично использовать мощь «параллельного перебора», присущую НМТ, привнеся в детерминированный процесс вычисления вероятностную составляющую. Выяснилось, что такие устройства вполне можно построить физически, и что они способны эффективно решать больший класс задач, чем обыкновенные МТ.

Впрочем, по-порядку. Сначала определим ВМТ — вероятностную машину Тьюринга. Существует два подхода к определению ВМТ, приведем их оба.

Определение 6.3.1. Вероятностная машина Тьюринга аналогична недетерминированной машине Тьюринга, только вместо недетерминированного перехода в два состояния машина выбирает один из вариантов с равной вероятностью.