-

#1

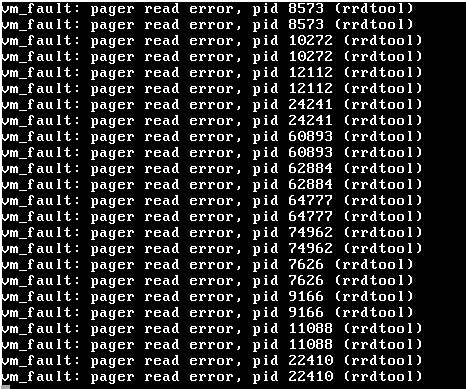

As my kernel messages were scrolling through I suddenly get this scrolling through endlessly:

Code:

vm_fault: pager read error, pid 1 (init)If I look quick enough, it seems to happen at the very end of the boot-up.

For what its worth, I am doing this very odd remote dual-boot setup where I change the /efi/BOOT/ files to boot between FreeBSD and Ubuntu. Ubuntu boots just fine, but FreeBSD produces this error and does not move forward.

I am using 12.0-CURRENT.

-

Thread Starter

-

#2

I figured it out. After numerous reboots I noticed that it happened upon mounting the file-systems. Google said this was likely a hard-disk issue. I disabled zfs_enable from rc.conf, and it booted just fine. Manually importing the pool and mounting works just fine.

This might be an issue with 12.0-CURRENT.

(I apologize, I double-posted on this, please delete the second posting)

-

#3

I am getting the same error but for the PID of /usr/libexec/getty Pc ttyv1

I am on the up-to-date 13.1. It is running in a VB VM. Got errors after leaving it overnight.

My FS is ZFS stripe of 1 drive (all installation options default, auto-partitioning used).

-

#4

I am getting the same error but for the PID of /usr/libexec/getty Pc ttyv1

Then it’s not the same error. The OP had an issue on 12.0-CURRENT. Which is an unsupported development version. I suggest you open a new thread with details about your issue instead of necroposting some old thread with a completely unrelated issue.

This topic has been deleted. Only users with topic management privileges can see it.

Всем привет. Собственно в сабже вся проблема. Система отлично работает, нареканий нет. Но в консоли постоянно валится это сообщение. Подскажите куда копать?

pfSense — это виртуальная машина на Xcp-NG (XenServer)

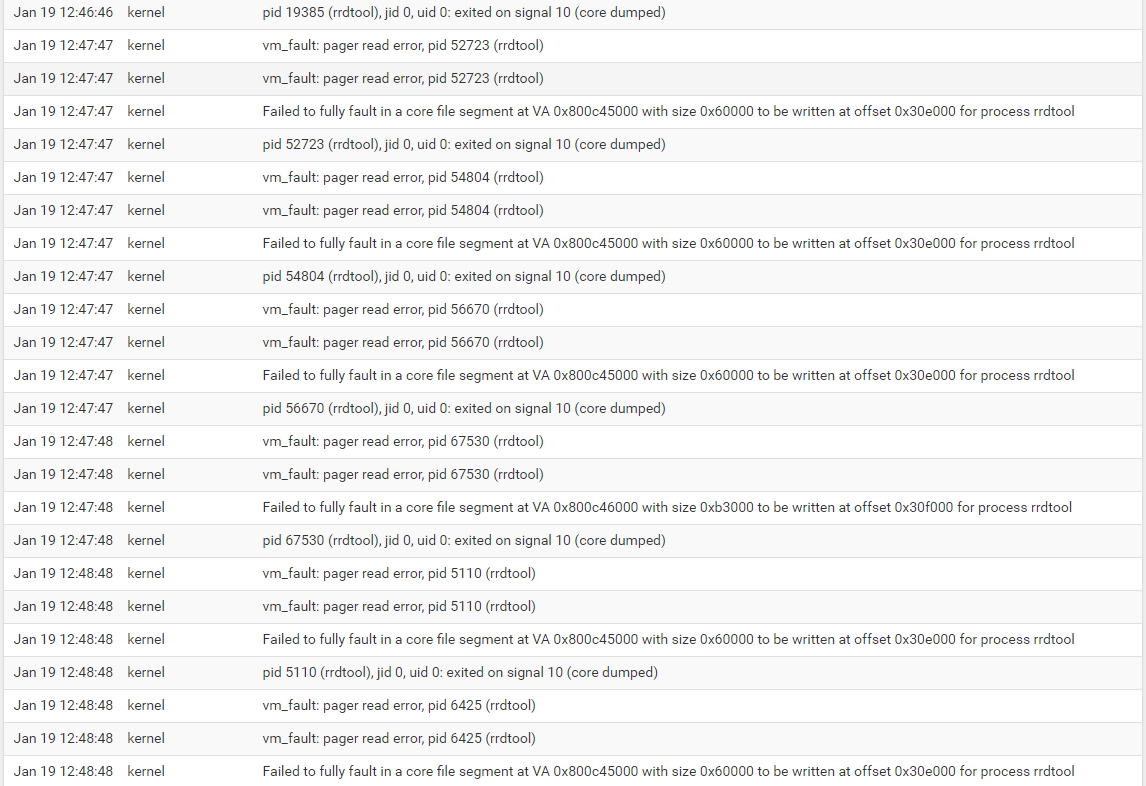

В системном логе через вебморду срет вот такими ошибками:

Добрый

@bazyak

https://forums.freebsd.org/threads/vm_fault-pager-read-error-pid-1-init.60064/

Пф на zfs или ufs?

@werter Блин, я лошара в этом. Виндузятник. Ставил pfSense по умолчанию. Самую последнюю версию. Везде Next-Next-Ok. Какая там файловая система понятия не имею по умолчанию. Какой командой это можно проверить?

@werter Что такое rrdtool? Гугл выдает рисовалку графиков. Я активировал подобные виджеты на главной странице pf. Но счас выключил и это ничего не изменило. Перезагрузки естественно пробовал. Включая со сканирование файловой системы на предмет ошибок.

Добрый

@bazyak

Какая там файловая система понятия не имею по умолчанию. Какой командой это можно проверить?

zpool list в консоле введите и покажите выхлоп здесь.

У меня пф на proxmox-е (kvm) живет и таких проблем никогда не было.

Переходите на светлую сторону — меняйте гипер (если это возможно).

@werter said in vm_fault: pager read error, pid * (rrdtool):

zpool list

NAME SIZE ALLOC FREE CKPOINT EXPANDSZ FRAG CAP DEDUP HEALTH ALTROOT

pfSense 97.5G 2.43G 95.1G — — 19% 2% 1.00x ONLINE —

@werter У меня Xen, а не гипер

@bazyak

Это тот, у к-ого, управлялка в вирт. машине (упала ВМ — до свидания управление гипером)?

Или тот, у к-го usb пробрасывается вот с ТАКИМИ танцами https://github.com/psychogun/psychogun.github.io/blob/master/docs/xcp-ng/USB-passthrough.md?

Спасибо, не надо.

@werter на вкус и цвет

Управление необязательно через XenOrchestra, можно через XenAdmin, как и в Citrix Xen Server

https://github.com/xcp-ng/xenadmin/releases

По поводу проброса USB ничего сказать не могу, т.к. нет надобности в подобном функционале.

Но всё это оффтоп

Сабж продолжает орать в логах ежесекундно. И как это пофиксить не имею понятия.

vm_fault: pager read error, pid * (rrdtool)

Добрый

@bazyak said in vm_fault: pager read error, pid * (rrdtool):

Сабж продолжает орать в логах ежесекундно. И как это пофиксить не имею понятия.

vm_fault: pager read error, pid * (rrdtool)

пф на ufs или zfs ?

Я бы сделал бэкап конфига, развернул бы пф по-новой и залил бэкап.

Управление необязательно через XenOrchestra, можно через XenAdmin, как и в Citrix Xen Server

Т.е. мне Вин-машина нужна для управления гипером? Да такого себе даже гипер-в нынче не позволяет )

Нет уж, сдох xen — туда ему и дорога. И чем раньше вы с него соскочите, тем лучше, имхо.

KVM нынче рулит. Тем более, что он «ядерный», а не как Зен — гипер в гипере (dom0domu).

Но это оффтоп )

@werter Короче пофиксил.

pfSense на zfs

в консоли:

zpool scrub pfSense

Далее ждем окончания этого процесса, периодически проверяя статус

zpool status

В конечно итоге он мне выдал, что нашел 4 проблемных файла по пути /var/db/rrd

Я удалил эти файлы и перезагрузил pfSense. После перезагрузки файлы воссоздались и проблема ушла.

Тему можно закрыть

Добрый

@bazyak

Еще бы проверил, вкл. ли trim на пуле. Иначе могут быть проблемы (

Moderator: mike

-

sidders54

- Posts: 14

- Joined: Mon Aug 16, 2021 1:01 pm

Juniper vMX issues after Pro Upgrade

Since upgrade to 5.0.1-14-PRO I have been unable to run any vMX nodes and receive the below errors once device is booted. I have also done a clean install and still get the errors. I can login as root but the ‘cli’ command doesn’t work. Am running Eve in ESXi.

g_vfs_done():md9.uzip[READ(offset=622983168, length=2048)]error = 86

md9.uzip: UZIP(zlib) inflate() failed

g_vfs_done():md9.uzip[READ(offset=622985216, length=8192)]error = 86

md9.uzip: UZIP(zlib) inflate() failed

g_vfs_done():md9.uzip[READ(offset=46307328, length=2048)]error = 86

vm_fault: pager read error, pid 6485 (cli)

md9.uzip: UZIP(zlib) inflate() failed

g_vfs_done():md9.uzip[READ(offset=46651392, length=2048)]error = 86

vm_fault: pager read error, pid 6485 (cli)

md9.uzip: UZIP(zlib) inflate() failed

g_vfs_done():md9.uzip[READ(offset=46659584, length=2048)]error = 86

vm_fault: pager read error, pid 6485 (cli)

md9.uzip: UZIP(zlib) inflate() failed

g_vfs_done():md9.uzip[READ(offset=46675968, length=2048)]error = 86

vm_fault: pager read error, pid 6485 (cli)

md9.uzip: UZIP(zlib) inflate() failed

Help please!

-

sidders54

- Posts: 14

- Joined: Mon Aug 16, 2021 1:01 pm

Re: Juniper vMX issues after Pro Upgrade

Post

by sidders54 » Sun May 29, 2022 10:29 am

and the REs of vQFXs won’t start either (Junos 17.3)

-

Uldis (UD)

- Posts: 4740

- Joined: Wed Mar 15, 2017 4:44 pm

- Location: London

- Contact:

Re: Juniper vMX issues after Pro Upgrade

Post

by Uldis (UD) » Sun May 29, 2022 11:23 am

Might be you can try,

wipe node/start

but anyway this lab before is running vQFX vers 20.3

EVE V5 Pro

but vMX I dorecommend to use Versions 18-21

tbh 18 was best

You do not have the required permissions to view the files attached to this post.

-

sidders54

- Posts: 14

- Joined: Mon Aug 16, 2021 1:01 pm

Re: Juniper vMX issues after Pro Upgrade

Post

by sidders54 » Sun May 29, 2022 11:51 am

have tried and wiping the nodes but makes no difference. I am running 18.2 and had no issues before the upgrade. vQFX is 17.3 but that was on the advise of Christian @ Juniper as newer versions boot into the line card not master when rebooted

-

sidders54

- Posts: 14

- Joined: Mon Aug 16, 2021 1:01 pm

Re: Juniper vMX issues after Pro Upgrade

Post

by sidders54 » Sun May 29, 2022 6:22 pm

it’s definitely an issue with the version 5. The nodes run without issue on version 4 so am going to stick with that

-

Uldis (UD)

- Posts: 4740

- Joined: Wed Mar 15, 2017 4:44 pm

- Location: London

-

Contact:

Re: Juniper vMX issues after Pro Upgrade

Post

by Uldis (UD) » Fri Jun 10, 2022 1:24 pm

sidders54 wrote: ↑

Sun May 29, 2022 6:22 pm

it’s definitely an issue with the version 5. The nodes run without issue on version 4 so am going to stick with that

no isssues with EVE V5 evem vMX running faster and better..

-

sidders54

- Posts: 14

- Joined: Mon Aug 16, 2021 1:01 pm

Re: Juniper vMX issues after Pro Upgrade

Post

by sidders54 » Thu Jul 07, 2022 9:24 pm

I still experiencing this issue. Seems to happen when I start a few vMXs at same time. Pain in the backside having to start them all individually and not something I had to do on previous Pro version

-

mamakos

- Posts: 43

- Joined: Thu Dec 19, 2019 4:49 pm

Re: Juniper vMX issues after Pro Upgrade

Post

by mamakos » Fri Jul 08, 2022 5:50 am

For my information, doesn’t the delay option in the node parameter help ? Even with a short 30sec delay between each node ?